Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Wos - Humanos Vs Inteligencia Artifical

Cargado por

Gonzalo lobos sepulvedaTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Wos - Humanos Vs Inteligencia Artifical

Cargado por

Gonzalo lobos sepulvedaCopyright:

Formatos disponibles

Machine Translated by Google

ANÁLISIS CONCEPTUAL publicado:

25 de marzo de 2021 doi:

10.3389/frai.2021.622364

Inteligencia humana versus inteligencia artificial

JE (Hans). Korteling *, GC van de BoerVisschedijk, RAM Blankendaal, RC

Boonekamp y AR Eikelboom

TNO Human Factors, Soesterberg, Países Bajos

La IA es uno de los temas más debatidos en la actualidad y parece haber poco entendimiento común

sobre las diferencias y similitudes entre la inteligencia humana y la artificial.

Los debates sobre muchos temas relevantes, como la confiabilidad, la explicabilidad y la ética, se

caracterizan por concepciones antropocéntricas y antropomorfistas implícitas y, por ejemplo, la

búsqueda de una inteligencia similar a la humana como estándar de oro para la Inteligencia Artificial.

Para proporcionar más acuerdo y fundamentar posibles objetivos de investigación futuros, este artículo

presenta tres nociones sobre las similitudes y diferencias entre la inteligencia humana y la artificial: 1)

las limitaciones fundamentales de la inteligencia humana (y artificial), 2) la inteligencia humana como

una de muchas formas posibles de inteligencia general, y 3) el alto impacto potencial de múltiples

formas (integradas) de aplicaciones de IA híbridas estrechas. Por el momento, los sistemas de IA

tendrán cualidades y capacidades cognitivas fundamentalmente diferentes a las de los sistemas

biológicos. Por esta razón, una de las cuestiones más importantes es cómo podemos utilizar (y

“colaborar” con) estos sistemas de la manera más eficaz posible. ¿Para qué tareas y bajo qué

Editado por: condiciones es seguro dejar las decisiones en manos de la IA y cuándo se requiere el juicio humano?

Esma Aïmeur,

¿Cómo podemos aprovechar las fortalezas específicas de la inteligencia humana y artificial?

Universidad de Montreal, Canadá

¿Cómo implementar sistemas de IA de manera efectiva para complementar y compensar las

Revisado por:

Cesar Collazos, limitaciones inherentes a la cognición humana (y viceversa)? ¿Deberíamos buscar el desarrollo de

Universidad del Cauca, Colombia “socios” de IA con inteligencia humana (de nivel) o deberíamos centrarnos más en complementar las

Ranilson Oscar Araújo Paiva,

limitaciones humanas? Para responder a estas preguntas, los seres humanos que trabajan con

Universidad Federal de Alagoas, Brasil

sistemas de IA en el lugar de trabajo o en la formulación de políticas deben desarrollar un modelo

*Correspondencia: JE

(Hans). Korteling mental adecuado de los mecanismos "psicológicos" subyacentes de la IA. Por lo tanto, para obtener

hans.korteling@tno.nl

sistemas humanosIA que funcionen bien, la conciencia de la inteligencia en los humanos debe

abordarse con más fuerza. Para ello se propone un primer marco de contenidos educativos.

Sección de especialidad:

Este artículo fue enviado a

Palabras clave: inteligencia humana, inteligencia artificial, inteligencia artificial general, inteligencia artificial a nivel humano, complejidad cognitiva, inteligencia

IA para el aprendizaje humano y artificial restringida, colaboración entre humanos e IA, sesgo cognitivo

Cambio de

comportamiento, una sección de la revista.

Fronteras de la inteligencia artificial INTRODUCCIÓN: INTELIGENCIA ARTIFICIAL Y HUMANA,

Recibido: 29 de octubre de 2020 MUNDOS DE DIFERENCIA

Aceptado: 01 de febrero de 2021

Publicado: 25 de marzo de 2021

Inteligencia artificial general a nivel humano Los avances recientes en la

Citación:

tecnología de la información y en la IA pueden permitir una mayor coordinación e integración

Korteling JE(H), van

entre los humanos y la tecnología. Por lo tanto, se ha prestado bastante atención al desarrollo de

de BoerVisschedijk GC, Blankendaal

la IA HumanAware, cuyo objetivo es que la IA se adapte como “miembro del equipo” a las

RAM, Boonekamp RC y Eikelboom AR

(2021) Inteligencia humana versus

posibilidades y limitaciones cognitivas de los miembros del equipo humano. También metáforas

inteligencia artificial. como “compañero”, “compañero”, “alter ego”, “colaborador inteligente”, “compañero” y

Frente. Artif. Intel. 4:622364. “comprensión mutua” enfatizan un alto grado de colaboración, similitud e igualdad en los “equipos

dos: 10.3389/frai.2021.622364 híbridos”. Cuando los socios de IA conscientes de las personas operan como "colaboradores humanos", debe

Fronteras de la Inteligencia Artificial | www.frontiersin.org 1 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

sentir, comprender y reaccionar ante una amplia gama de cualidades El razonamiento probablemente no esté justificado. Por estas razones

complejas del comportamiento humano, como la atención, la motivación, proponemos una definición (no antropocéntrica) de “inteligencia” como: “la

la emoción, la creatividad, la planificación o la argumentación (p. ej., capacidad de realizar objetivos complejos” (Tegmark, 2017). Estos objetivos

Krämer et al., 2012; van den Bosch y Bronkhorst, 2018; van den Bosch et pueden pertenecer a tareas estrechas y restringidas (IA estrecha) o a

al., 2019). Por lo tanto, estos “socios de IA” o “compañeros de equipo” dominios de tareas amplios (AGI). Sobre la base de esta definición y de

deben estar dotados de capacidades cognitivas similares a las humanas una definición de AGI propuesta por Bieger et al. (2014) y uno de Grind

(o humanoides) que permitan la comprensión y la colaboración mutuas (es (1997), aquí definimos AGI como: “Capacidades no biológicas para lograr

decir, la “conciencia humana”). de forma autónoma y eficiente objetivos complejos en una amplia gama de

Sin embargo, no importa cuán inteligentes y autónomos se vuelvan los entornos”. Los sistemas AGI deberían poder identificar y extraer las

agentes de IA en ciertos aspectos, al menos en el futuro previsible, características más importantes para su funcionamiento y proceso de

probablemente seguirán siendo máquinas inconscientes o dispositivos de aprendizaje de forma automática y eficiente en una amplia gama de tareas

propósito especial que apoyan a los humanos en tareas específicas y y contextos. La investigación relevante sobre AGI se diferencia de la

complejas. Como máquinas digitales, están equipadas con un sistema investigación ordinaria sobre IA al abordar la versatilidad y la totalidad de

operativo completamente diferente (digital versus biológico) y con la inteligencia y al llevar a cabo la práctica de la ingeniería de acuerdo con

cualidades y habilidades cognitivas correspondientemente diferentes a las un sistema comparable a la mente humana en cierto sentido (Bieger et al.,

de las criaturas biológicas, como los humanos y otros animales (Moravec, 2014).

1988; Klein et al., 2004; Korteling et al. , 2018a; Shneiderman, 2020a). En Será fascinante crear copias de nosotros mismos que puedan aprender

general, los agentes digitales de razonamiento y resolución de problemas de forma iterativa mediante la interacción con socios y así poder colaborar

solo se comparan muy superficialmente con sus contrapartes biológicas sobre la base de objetivos comunes y comprensión y adaptación mutuas

(por ejemplo, Boden, 2017; Shneiderman, 2020b). Teniendo esto en (por ejemplo, Bradshaw et al., 2012; Johnson et al., 2014). . Esto sería muy

cuenta, se vuelve cada vez más importante que los profesionales humanos útil, por ejemplo, cuando un alto grado de inteligencia social de la IA

que trabajan con sistemas de IA avanzados (por ejemplo, en equipos contribuya a interacciones más adecuadas con los humanos, por ejemplo

militares o de formulación de políticas) desarrollen un modelo mental en el ámbito de la atención sanitaria o con fines de entretenimiento

adecuado sobre las diferentes capacidades cognitivas de los sistemas de (Wyrobek et al., 2008). La verdadera colaboración basada en objetivos

IA en relación con la cognición humana. Esta cuestión será cada vez más comunes y comprensión mutua implica necesariamente alguna forma de

relevante cuando los sistemas de IA se vuelvan más avanzados y se inteligencia general humanoide. Por el momento, este sigue siendo un

implementen con mayores grados de autonomía. objetivo en un horizonte lejano. En el presente artículo argumentamos por

Por lo tanto, el presente artículo intenta proporcionar más claridad y qué para la mayoría de las aplicaciones también puede no ser muy práctico

comprensión sobre las características, diferencias e idiosincrasias o necesario (y probablemente un poco engañoso) apuntar vigorosamente

fundamentales de las inteligencias humana/biológica y artificial/digital. En o anticipar sistemas que poseen AGI "similares a los humanos" o

la sección final, se presenta un marco global para la construcción de habilidades o cualidades "similares a las humanas". . El hecho de que los

contenidos educativos sobre esta “Conciencia de Inteligencia”. Esto se humanos posean inteligencia general no implica que las nuevas formas

puede utilizar para el inorgánicas de inteligencia general deban cumplir con los criterios de la

desarrollo de programas de educación y capacitación para humanos que inteligencia humana. En este sentido, el presente artículo aborda la forma

tengan que utilizar o “colaborar con” sistemas avanzados de IA en un futuro en que pensamos sobre la inteligencia (natural y artificial) en relación con

cercano y lejano. los potenciales más probables (y los problemas reales por venir) de la IA

Con la aplicación de sistemas de IA con una autonomía cada vez en el futuro a corto y mediano plazo. Esto dará que pensar en anticipación

mayor, cada vez más investigadores consideran la necesidad de abordar a un futuro que es difícil de predecir para un campo tan dinámico como la

enérgicamente los problemas reales y complejos de la “inteligencia a nivel IA.

humano” y, más ampliamente, la inteligencia artificial general, o AGI, (por ejemplo,

Goertzel et al., 2014). Ya se han propuesto muchas definiciones diferentes

de A(G)I (por ejemplo, Russell y Norvig, 2014 para una descripción ¿Qué es la “inteligencia real”?

general). Muchos de ellos se reducen a: tecnología que contiene o implica Implícita en nuestra aspiración de construir sistemas AGI que posean

inteligencia (similar a la humana) (por ejemplo, Kurzweil, 1990). Esto es inteligencia humanoide está la premisa de que la inteligencia humana

problemático. La mayoría de las definiciones utilizan el término “inteligencia” (general) es la forma "real" de inteligencia. Esto incluso ya está

como elemento esencial de la definición misma, lo que hace que la implícitamente articulado en el término “Inteligencia Artificial”, como si no

definición sea tautológica. En segundo lugar, la idea de que A(G)I deba fuera del todo real, es decir, real como la inteligencia (biológica) no

parecerse a un ser humano parece injustificada. Al menos en entornos artificial. De hecho, como humanos nos conocemos como las entidades

naturales existen muchas otras formas y manifestaciones de con mayor inteligencia jamás observada en el Universo. Y como una

comportamientos inteligentes y altamente complejos que son muy diferentes extensión de esto, nos gusta vernos a nosotros mismos como seres

de las capacidades cognitivas humanas específicas (ver Grind, 1997 para una descripción

racionales general).

capaces de resolver una amplia gama de problemas complejos

Finalmente, como también se ve con frecuencia en el campo de la biología, en todo tipo de circunstancias utilizando nuestra experiencia e intuición,

estas definiciones de A(G)I utilizan la inteligencia humana como base o complementadas con las reglas de la lógica, el análisis de decisiones y la

analogía central para el razonamiento sobre el fenómeno menos familiar estadística. Por lo tanto, no es sorprendente que tengamos algunas

de A(G)I (Coley y Tanner, 2012). Debido a las muchas diferencias entre el dificultades para aceptar la idea de que podríamos ser un poco menos

sustrato subyacente y la arquitectura de la inteligencia biológica y artificial, inteligentes de lo que nos decimos a nosotros mismos, es decir, “el próximo

esta forma antropocéntrica de insulto a la humanidad” (van Belkom, 2019). Esto llega tan lejos que el

Fronteras de la Inteligencia Artificial | www.frontiersin.org 2 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

Los rápidos avances en el campo de la inteligencia artificial van acompañados de Con una enorme capacidad de aprendizaje, tenemos, con diferencia, el arsenal más

una redefinición recurrente de lo que debería considerarse “inteligencia real extenso de capacidades cognitivas2 para resolver de forma autónoma problemas

(general)”. La conceptualización de la inteligencia, es decir, la capacidad de lograr complejos y lograr objetivos complejos. De esta manera podemos resolver una

objetivos complejos de forma autónoma y eficiente, se ajusta continuamente y se enorme variedad de problemas aritméticos, conceptuales, espaciales, económicos,

restringe aún más a: “aquellas cosas que sólo los humanos pueden hacer”. En socioorganizativos, políticos, etc. Los primates, que difieren sólo ligeramente de

consonancia con esto, la IA se define entonces como “el estudio de cómo hacer que nosotros en términos genéticos, están muy por detrás de nosotros en ese sentido.

las computadoras hagan cosas en las que, en este momento, las personas son Por lo tanto, podemos calificar legítimamente a los humanos, en comparación con

mejores” (Rich y Knight, 1991; Rich et al., 2009). Esto incluye pensar en soluciones otras especies animales que conocemos, como altamente inteligentes.

creativas, utilizar de manera flexible información contextual y de fondo, el uso de la

intuición y el sentimiento, la capacidad de realmente “pensar y comprender” o la

inclusión de la emoción en una consideración (ética). Estos se citan luego como Capacidad cognitiva limitada Sin embargo, también

elementos específicos de la inteligencia real (p. ej. podemos mirar más allá de esta “perspectiva relativa entre especies” y tratar de

calificar nuestra inteligencia en términos más absolutos, es decir, utilizando una

Bergstein, 2017). Por ejemplo, el director de IA de Facebook y portavoz en el campo, escala que va desde cero hasta lo que es físicamente posible. Por ejemplo,

Yann LeCun, mencionó en una conferencia en el MIT sobre el futuro del trabajo que podríamos ver la capacidad computacional de un cerebro humano como un sistema

las máquinas aún están lejos de tener "la esencia de la inteligencia". Eso incluye la físico (Bostrom, 2014; Tegmark, 2017). La noción predominante a este respecto

capacidad de comprender el mundo físico lo suficientemente bien como para hacer entre los científicos de IA es que la inteligencia es, en última instancia, una cuestión

predicciones sobre aspectos básicos del mismo: observar una cosa y luego utilizar de información y computación y (por tanto) no de carne, sangre y átomos de

conocimientos previos para descubrir qué otras cosas también deben ser ciertas. carbono. En principio, no existe ninguna ley física que impida que los sistemas

Otra forma de decir esto es que las máquinas no tienen sentido común (Bergstein, físicos (compuestos por quarks y átomos, como nuestro cerebro) puedan construirse

2017), como los submarinos que no pueden nadar (van Belkom, 2019). Cuando las con una potencia de cálculo e inteligencia mucho mayores que el cerebro humano.

capacidades humanas exclusivas se convierten en nuestros puntos de navegación Esto implicaría que no existe una razón física insuperable por la cual las máquinas

fundamentales en el horizonte, es posible que pasemos por alto algunos problemas algún día no puedan volverse mucho más inteligentes que nosotros en todos los

importantes que tal vez requieran nuestra atención en primer lugar. aspectos posibles (Tegmark, 2017). Por lo tanto, nuestra inteligencia es relativamente

alta en comparación con la de otros animales, pero en términos absolutos puede

Para aclarar este punto, primero brindaremos una idea de la naturaleza básica estar muy limitada en su capacidad de computación física, aunque sólo sea por el

de la inteligencia humana y artificial. Esto es necesario para fundamentar una tamaño limitado de nuestro cerebro y su número máximo posible de neuronas y

conciencia adecuada de la inteligencia (Intelligence Awareness) y una investigación células de glía (por ejemplo, Kahle, 1979).

y educación adecuadas que anticipen el desarrollo y la aplicación de la A(G)I.

Por el momento, esto se basa en tres nociones esenciales que pueden (y deben) Para definir y evaluar mejor nuestra propia inteligencia (biológica), también

desarrollarse más en un futuro próximo. podemos discutir la evolución y la naturaleza de nuestras capacidades de

pensamiento biológico. Como red neuronal biológica de carne y hueso, necesaria

• En cuanto a las tareas cognitivas, probablemente seamos menos inteligentes para la supervivencia, nuestro cerebro ha pasado por un proceso de optimización

de lo que pensamos. Entonces, ¿por qué deberíamos centrarnos enérgicamente evolutiva de más de mil millones de años.

en una AGI similar a En este período prolongado, se convirtió en un sistema altamente eficaz y eficiente

la humana? • Son posibles muchas formas diferentes de inteligencia y, por lo para regular funciones biológicas esenciales y realizar tareas perceptivasmotoras y

tanto, la inteligencia general no es necesariamente la misma que la inteligencia de reconocimiento de patrones, como recolectar alimentos, luchar y volar, y

general humanoide (o “AGI a nivel humano”). • El ingreso bruto aparearse. Casi durante toda nuestra evolución, las redes neuronales de nuestro

ajustado a menudo no es necesario; Muchos problemas complejos también se cerebro se han ido optimizando aún más para estos procesos biológicos y

pueden abordar de manera efectiva utilizando múltiples IA estrechas.1 perceptivos motores básicos que también son la base de nuestras habilidades

prácticas diarias, como la cocina, la jardinería o las tareas domésticas. Posiblemente

debido a la competencia resultante para este tipo de tareas podemos olvidar que

PROBABLEMENTE NO SOMOS TAN INTELIGENTES COMO estos procesos se caracterizan por una complejidad computacional extremadamente

NOSOTROS PENSAMOS

alta (por ejemplo, Moravec, 1988). Por ejemplo, cuando nos atamos los cordones

de los zapatos, muchos millones de señales entran y salen a través de un gran

¿Qué tan inteligentes somos en realidad? La respuesta a esa pregunta está número de sistemas sensores diferentes, desde los cuerpos tendinosos y los husos

determinada en gran medida por la perspectiva desde la que se considera esta musculares de las extremidades hasta la retina, los órganos otolíticos y los canales

cuestión y, por tanto, por las medidas y criterios de inteligencia que se elijan. Por semicirculares de la cabeza. (por ejemplo , Brodal, 1981). Esta enorme cantidad de

ejemplo, podríamos comparar la naturaleza y las capacidades de la inteligencia información proveniente de muchos sistemas perceptivomotores diferentes es

humana con otras especies animales. En ese caso parecemos muy inteligentes. continua, paralela, sin esfuerzo e incluso sin

Gracias a nuestro

1

La IA estrecha puede definirse como la producción de sistemas que muestran inteligencia

2

respecto de tareas específicas y altamente restringidas, como jugar al ajedrez, el Las habilidades cognitivas implican pensamiento deliberado, conceptual o analítico (p. ej.,

reconocimiento facial, la navegación autónoma o la locomoción (Goertzel et al., 2014). cálculo, estadística, análisis, razonamiento, abstracción)

Fronteras de la Inteligencia Artificial | www.frontiersin.org 3 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

atención consciente, procesada en las redes neuronales de nuestro cerebro 2002; Kahneman, 2011; Toet et al., 2016). La literatura proporciona

(Minsky, 1986; Moravec, 1988; Grind, 1997). Para lograrlo, el cerebro descripciones y demostraciones de más de 200 sesgos. Estas tendencias

dispone de una serie de mecanismos de trabajo universales (inherentes), son en gran medida implícitas e inconscientes y se sienten de forma

como la asociación y el aprendizaje asociativo (Shatz, 1992; Bar, 2007), la bastante natural y evidente cuando somos conscientes de estas inclinaciones

potenciación y la facilitación (Katz y Miledi, 1968; Bao et al., 1997), cognitivas (Pronin et al., 2002; Risen, 2015; Korteling et al., 2018b). Por eso

saturación e inhibición lateral (Isaacson y Scanziani, 2011; Korteling et al., a menudo se les llama “intuitivos” (Kahneman y Klein, 2009) o “irracionales”

2018a). (Shafir y LeBoeuf, 2002).

Este tipo de capacidades biológicas y perceptivomotoras básicas se El razonamiento sesgado puede dar lugar a resultados bastante aceptables

han desarrollado y establecido a lo largo de muchos millones de años. en situaciones naturales o cotidianas, especialmente cuando se tiene en

Mucho más tarde en nuestra evolución (en realidad, muy recientemente), cuenta el coste de tiempo del razonamiento (Simon, 1955; Gigerenzer y

nuestras capacidades cognitivas y funciones racionales comenzaron a Gaissmaier, 2011). Sin embargo, las personas a menudo se desvían de la

desarrollarse. Estas habilidades o capacidades cognitivas tienen racionalidad y/o de los principios de la lógica, el cálculo y la probabilidad de

probablemente menos de 100 mil años, lo que puede calificarse como maneras desaconsejables (Tversky y Kahneman, 1974; Shafir y LeBoeuf,

“embrionarias” en la escala temporal de la evolución (por ejemplo, Petraglia 2002) , lo que lleva a decisiones subóptimas en términos de tiempo y

y Korisettar, 1998; McBrearty y Brooks, 2000; Henshilwood y Marean, esfuerzo (costos) invertidos. la información disponible y los beneficios

2003). ). Además, esta capa muy delgada de logros humanos se ha esperados.

construido necesariamente sobre estas inteligencias neuronales “antiguas” Los sesgos son causados en gran medida por características y

para funciones esenciales de supervivencia. Así, nuestras capacidades mecanismos inherentes (o estructurales) del cerebro como red neuronal

cognitivas “superiores” se desarrollan a partir de y con estos mecanismos (Korteling et al., 2018a; Korteling y Toet, 2020).

de regulación (neuro)biológica (Damasio, 1994; Korteling y Toet, 2020). Básicamente, estos mecanismos (como la asociación, la facilitación, la

Como resultado, no debería sorprender que las capacidades de nuestro adaptación o la inhibición lateral) dan como resultado una modificación de

cerebro para realizar estas funciones cognitivas recientes sean todavía los datos originales o disponibles y su procesamiento (por ejemplo,

bastante limitadas. Estas limitaciones se manifiestan de muchas maneras ponderación de su importancia). Por ejemplo, la inhibición lateral es un

diferentes, por ejemplo: proceso neuronal universal que resulta en la magnificación de las diferencias

en la actividad neuronal (aumento del contraste), lo cual es muy útil para las

La cantidad de información cognitiva que podemos procesar funciones perceptivomotoras, manteniendo la integridad física y la alostasis

conscientemente (nuestra memoria de trabajo, lapso o atención) es muy (es decir, funciones de supervivencia biológica). Para estas funciones

limitada (Simon, 1955). La capacidad de nuestra memoria de trabajo es nuestro sistema nervioso ha sido optimizado durante millones de años.

de aproximadamente 10 a 50 bits por segundo (Tegmark, 2017). Sin embargo, las funciones cognitivas “superiores”, como el pensamiento

La mayoría de tareas cognitivas, como leer un texto o realizar cálculos, conceptual, el razonamiento probabilístico o el cálculo, se han desarrollado

requieren toda nuestra atención y normalmente necesitamos mucho sólo muy recientemente en la evolución. Estas funciones probablemente

tiempo para ejecutarlas. Las calculadoras móviles pueden realizar tienen menos de 100 mil años y, por lo tanto, pueden calificarse como

cálculos millones de veces más complejos que nosotros (Tegmark, 2017). “embrionarias” en la escala temporal de la evolución (por ejemplo, McBrearty

Aunque podemos procesar mucha información en paralelo, no podemos y Brooks, 2000; Henshilwood y Marean, 2003; Petraglia y Korisettar, 2003).

ejecutar simultáneamente tareas cognitivas que requieran deliberación y Además, la evolución no pudo desarrollar estas nuevas funciones cognitivas

atención, es decir, “multitarea” (Korteling, 1994; Rogers y Monsell, 1995; desde cero, sino que tuvo que construir esta delgada y embrionaria capa de

Rubinstein, Meyer y Evans, 2001) . logro humano a partir de su “antigua” herencia neuronal para las funciones

biológicas esenciales de supervivencia (Moravec, 1988). Dado que las

Los conocimientos y habilidades cognitivas adquiridas por las personas funciones cognitivas suelen requerir cálculos exactos y una ponderación

(memoria) tienden a decaer con el tiempo, mucho más que las habilidades adecuada de los datos, las transformaciones de datos (como la inhibición

perceptivomotoras. Debido a esta “retención” limitada de información, lateral) pueden conducir fácilmente a distorsiones sistemáticas (es decir,

olvidamos fácilmente porciones sustanciales de lo que hemos aprendido sesgos) en el procesamiento de la información cognitiva. Ejemplos del gran

(Wingfield y Byrnes, 1981). número de sesgos causados por las propiedades inherentes de las redes

neuronales biológicas son: el sesgo de anclaje (sesgo de decisiones hacia

Sesgos cognitivos arraigados Nuestra limitada información previamente adquirida, Furnham y Boo, 2011; Tversky y

capacidad de procesamiento de tareas cognitivas no es el único factor que Kahneman, 1973, Tversky y Kahneman, 1974), el sesgo de retrospectiva (la

determina nuestra inteligencia cognitiva. Excepto por una capacidad de tendencia a percibir erróneamente los eventos como inevitables o más

procesamiento general limitada, el procesamiento de la información cognitiva probables una vez que han ocurrido, Hoffrage et al., 2000; Roese y Vohs,

humana muestra distorsiones sistemáticas. Estos se manifiestan en muchos 2012) el sesgo de disponibilidad (juzgar la frecuencia, importancia o

sesgos cognitivos (Tversky y Kahneman, 1973, Tversky y Kahneman, 1974). probabilidad de un evento por la facilidad con que Me vienen a la mente

Los sesgos cognitivos son tendencias, inclinaciones o disposiciones ejemplos relevantes, Tversky y Kahnemann, 1973; Tversky y Kahneman,

sistemáticas y universales que sesgan o distorsionan los procesos de 1974), y el sesgo de confirmación (la tendencia a seleccionar, interpretar y

información de manera que sus resultados sean inexactos, subóptimos o recordar información de una manera que confirme las propias ideas

simplemente incorrectos (por ejemplo, Lichtenstein y Slovic, 1971; Tversky preconcebidas, puntos de vista y expectativas, Nickerson, 1998). ). Además

y Kahneman, 1981). Muchos sesgos ocurren prácticamente de la misma de estas limitaciones (estructurales) inherentes a las redes neuronales

manera en muchas situaciones de decisión diferentes (Shafir y LeBoeuf, (biológicas), los sesgos también pueden

Fronteras de la Inteligencia Artificial | www.frontiersin.org 4 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

se originan a partir de principios evolutivos funcionales que promueven la con características, fortalezas y debilidades diferentes a las de los residentes

supervivencia de nuestros antepasados quienes, como cazadoresrecolectores, humanos, esto también se aplicará a las formas artificiales de inteligencia

vivían en grupos pequeños y muy unidos (Haselton et al., 2005; Tooby y (general). A continuación resumimos brevemente algunas diferencias

Cosmides, 2005). Los sesgos cognitivos pueden ser causados por un desajuste fundamentales entre la inteligencia humana y la artificial (Bostrom, 2014):

racionalizado

entre lo evolutivo (“racionalidad “heurística”

evolutiva”: Haselton et al., 2009) y el contexto o

entorno actual (Tooby y Cosmides, 2005). Desde este punto de vista, las mismas

heurísticas que optimizaron las posibilidades de supervivencia de nuestros Estructura básica: la inteligencia biológica (carbono) se basa en "wetware"

antepasados en su entorno (natural) pueden conducir a un comportamiento neuronal que es fundamentalmente diferente de la inteligencia artificial

desadaptativo (sesgado) cuando se utilizan en nuestros entornos (artificiales) (basada en silicio). A diferencia del software húmedo biológico, en el silicio o

actuales. en los sistemas digitales, el “hardware” y el “software” son independientes

Los sesgos que se han considerado como ejemplos de este tipo de desajuste entre sí (Kosslyn y Koenig, 1992). Cuando un sistema biológico ha aprendido

son el sesgo de acción (preferir la acción incluso cuando no existe una una nueva habilidad, ésta estará limitada al sistema mismo. Por el contrario,

justificación racional para hacerlo, Baron y Ritov, 2004; Patt y Zeckhauser, 2000), si un sistema de IA ha aprendido una determinada habilidad, los algoritmos

la prueba social (la tendencia a reflejar o copiar las acciones y opiniones de que lo constituyen se pueden copiar directamente a todos los demás sistemas

otros, Cialdini, 1984), la Tragedia de los comunes (priorizar los intereses digitales similares.

personales sobre el bien común de la comunidad, Hardin, 1968), y el Sesgo

Ingrupal (favorecer al propio grupo por encima del de los demás, Taylor y Doria, Velocidad: Las señales de los sistemas de IA se propagan casi a la velocidad

1981). de la luz. En los seres humanos, la velocidad de conducción de los nervios

se produce a una velocidad de como máximo 120 m/s, lo cual es

Este carácter intrínseco (neuralmente inherente y/o evolutivo arraigado) del extremadamente lento en la escala de tiempo de las computadoras (Siegel y Sapru, 2005).

pensamiento sesgado hace que sea poco probable que métodos simples y Conectividad y comunicación: Las personas no pueden comunicarse

directos como las intervenciones de capacitación o los cursos de concientización directamente entre sí. Se comunican mediante lenguaje y gestos con un

sean muy efectivos para mejorar los sesgos. Esta dificultad para mitigar el sesgo ancho de banda limitado. Esto es más lento y difícil que la comunicación de

parece respaldada por la literatura (Korteling et al., 2021). la IA.

Sistemas que se pueden conectar directamente entre sí.

Gracias a esta conexión directa, también pueden colaborar sobre la base de

algoritmos integrados.

Actualización y escalabilidad: los sistemas de IA casi no tienen restricciones

LA INTELIGENCIA GENERAL NO ES LA con respecto a mantenerlos actualizados o mejorarlos y/o reconfigurarlos, de

IGUAL QUE LA INTELIGENCIA HUMANA modo que tengan los algoritmos correctos y las capacidades de procesamiento

y almacenamiento de datos necesarios para las tareas que tienen. llevar a

Diferencias fundamentales entre la inteligencia biológica y la

cabo.

artificial A menudo pensamos y deliberamos sobre la inteligencia Esta capacidad de expansión rápida y estructural y de mejora inmediata

teniendo en mente una concepción antropocéntrica de nuestra propia inteligencia difícilmente se aplica a las personas.

como referencia obvia e inequívoca. Tendemos a utilizar esta concepción como En cambio, la biología hace mucho con poco: los cerebros orgánicos son

base para razonar sobre otros fenómenos de inteligencia menos familiares, millones de veces más eficientes en el consumo de energía que los

como otras formas de inteligencia biológica y artificial (Coley y Tanner, 2012). ordenadores. El cerebro humano consume menos energía que una bombilla,

Esto puede dar lugar a preguntas e ideas fascinantes. mientras que una supercomputadora con un rendimiento computacional

comparable usa suficiente electricidad para alimentar toda una aldea

(Fischetti, 2011).

Un ejemplo es la discusión sobre cómo y cuándo se alcanzará el punto de

“inteligencia a nivel humano”. Por ejemplo, Ackermann. (2018) escribe: “Antes Este tipo de diferencias en estructura básica, velocidad, conectividad,

de llegar a la superinteligencia, la IA general significa que una máquina tendrá capacidad de actualización, escalabilidad y consumo de energía también

las mismas capacidades cognitivas que un ser humano”. conducirán necesariamente a diferentes cualidades y limitaciones entre la

inteligencia humana y la artificial. Nuestra velocidad de respuesta a estímulos

Por lo tanto, los investigadores deliberan extensamente sobre el momento en el simples es, por ejemplo, miles de veces más lenta que la de los sistemas

que alcanzaremos la IA general (por ejemplo, Goertzel, 2007; Müller y Bostrom, artificiales. Los sistemas informáticos pueden conectarse muy fácilmente

2016). Suponemos que este tipo de preguntas no dan en el blanco. Hay (en directamente entre sí y, como tales, pueden formar parte de un sistema integrado.

principio) muchos tipos diferentes posibles de inteligencia (general) concebibles, Esto significa que los sistemas de IA no tienen que verse como entidades

de los cuales la inteligencia humana es sólo uno de ellos. Esto significa, por individuales que pueden trabajar fácilmente juntas o tener malentendidos mutuos.

ejemplo, que el desarrollo de la IA está determinado por las limitaciones de la Y si dos sistemas de IA están involucrados en una tarea, entonces corren un

física y la tecnología, y no por las de la evolución biológica. Entonces, así como riesgo mínimo de cometer un error debido a faltas de comunicación (pensemos

la inteligencia de un hipotético visitante extraterrestre de nuestro planeta Tierra en los vehículos autónomos que se acercan a un cruce). Después de todo, son

probablemente tenga una estructura (in)orgánica diferente. partes intrínsecamente conectadas del mismo sistema y del mismo algoritmo

(Gerla et al., 2014).

Fronteras de la Inteligencia Artificial | www.frontiersin.org 5 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

Complejidad y paradoja de Moravec Debido a que los La inteligencia motora es muy superior a nuestra inteligencia cognitiva.

cerebros biológicos, basados en el carbono, y las computadoras digitales, Nuestra inteligencia perceptivomotora orgánica es especialmente buena

basadas en el silicio, están optimizados para tipos de tareas completamente en el procesamiento asociativo de invariantes de orden superior

diferentes (por ejemplo, Moravec, 1988; Korteling et al., 2018b), la (“patrones”) en la información ambiental. Estos son computacionalmente

inteligencia humana y artificial muestran resultados fundamentales y más complejos y contienen más información que los elementos

probablemente diferencias muy amplias. Debido a estas diferencias, individuales simples (Gibson, 1966, Gibson, 1979). Un ejemplo de

puede resultar muy engañoso utilizar nuestra propia mente como base, nuestras capacidades perceptivomotoras superiores es el efecto de

modelo o analogía para razonar sobre la IA. Esto puede dar lugar a superioridad del objeto: percibimos e interpretamos objetos completos

concepciones erróneas, por ejemplo sobre las supuestas capacidades de más rápido y más eficazmente que los elementos individuales (más

los humanos y de la IA para realizar tareas complejas. Los fallos simples) que componen estos objetos (Weisstein y Harris, 1974;

resultantes en relación con las capacidades de procesamiento de McClelland, 1978; Williams y Weisstein, 1978; Pomerantz, 1981). Así, las

información surgen a menudo en la literatura psicológica en la que letras también se perciben con mayor precisión cuando se presentan

"complejidad" y "dificultad" de las tareas se utilizan indistintamente como parte de una palabra que cuando se presentan de forma aislada,

(véanse, por ejemplo, Wood et al., 1987; McDowd y Craik, 1988). La es decir, el efecto de superioridad de la palabra (por ejemplo, Reicher,

complejidad de la tarea se evalúa entonces de manera antropocéntrica, 1969; Wheeler, 1970). Por tanto, la dificultad de una tarea no indica

es decir, según el grado en que los humanos podemos realizarla o necesariamente su complejidad inherente. Como lo expresa Moravec

dominarla. Entonces, utilizamos la dificultad para realizar o dominar una (1988) : “Todos somos atletas olímpicos prodigiosos en las áreas perceptiva y motora, t

tarea como una medida de su complejidad, y el desempeño de la tarea El pensamiento abstracto, sin embargo, es un truco nuevo, quizás de

(velocidad, errores) como una medida de la habilidad e inteligencia de menos de 100.000 años. Aún no lo hemos dominado. No es tan

quien la realiza. Aunque esto a veces podría ser aceptable en la intrínsecamente difícil; simplemente lo parece cuando lo hacemos”.

investigación psicológica, puede resultar engañoso si nos esforzamos por

comprender la inteligencia de los sistemas de IA. Para nosotros es mucho La suposición de una AGI similar a la humana Entonces, si

más difícil multiplicar dos números aleatorios de seis cifras que reconocer existieran sistemas de IA con inteligencia general que puedan usarse

a un amigo en una fotografía. Pero cuando se trata de contar o de para una amplia gama de problemas y objetivos complejos, esas

operaciones aritméticas, los ordenadores son miles de veces más rápidos máquinas AGI probablemente tendrían un perfil de inteligencia

y mejores, mientras que los mismos sistemas han dado recientemente completamente diferente, incluidas otras cualidades cognitivas, que el los

pasos en el reconocimiento de imágenes (lo que sólo tuvo éxito cuando humanos tienen (Goertzel, 2007). Esto será así incluso si logramos

se introdujo la tecnología de aprendizaje profundo, basada en algunos construir agentes de IA que muestren un comportamiento similar al

principios de las redes neuronales biológicas). desarrollado). En general: nuestro y si se les permite adaptarse a nuestra forma de pensar y resolver

las tareas cognitivas que son relativamente difíciles para el cerebro problemas para promover la colaboración entre humanos y IA. A menos

humano (y que, por lo tanto, encontramos subjetivamente difíciles) no que decidamos degradar deliberadamente las capacidades de los

tienen por qué ser computacionalmente complejas (por ejemplo, en sistemas de IA (que no serían muy inteligentes), las capacidades y

términos de aritmética objetiva, lógica y operaciones abstractas). Y habilidades subyacentes del hombre y las máquinas con respecto a la

viceversa: las tareas que son relativamente fáciles para el cerebro recopilación y el procesamiento de información, el análisis de datos, el

(reconocer patrones, tareas perceptivomotoras, tareas bien entrenadas) razonamiento de probabilidad, la lógica, la capacidad de memoria, etc.

no tienen por qué ser computacionalmente simples. Este fenómeno, que seguirán siendo diferentes. Debido a estas diferencias, deberíamos

es fácil para la antigua “tecnología” neuronal de las personas y difícil para centrarnos en sistemas que nos complementen eficazmente y que hagan

la moderna tecnología digital de las computadoras (y viceversa), se ha que el sistema humanoIA sea más fuerte y eficaz. En lugar de perseguir

denominado la Paradoja de Moravec. Hans Moravec (1988) escribió: “Es la IA a nivel humano, sería más beneficioso centrarse en máquinas

comparativamente fácil hacer que las computadoras muestren un autónomas y sistemas (de apoyo) que llenen o amplíen las múltiples

rendimiento de nivel adulto en pruebas de inteligencia o jugando a las lagunas de la inteligencia cognitiva humana. Por ejemplo, mientras que

lasrespecta

damas, y difícil o imposible darles las habilidades de un niño de un año en lo que personasa se ven obligadas

percepción (por la lentitud

y movilidad. " y otras limitaciones de los

cerebros biológicos) a pensar heurísticamente en términos de objetivos,

virtudes, reglas y normas expresadas en un lenguaje (borroso), la IA ya

Inteligencia perceptualmotora superior humana ha establecido excelentes capacidades para procesar y calcular

La paradoja de directamente sobre la base de datos. datos muy complejos. Por lo tanto,

Moravec implica que las redes neuronales biológicas son o la ejecución de tareas cognitivas específicas (estrechas) (lógicas,

inteligentes de diferentes maneras que las redes neuronales artificiales.

analíticas, computacionales), la inteligencia digital moderna puede ser

La inteligencia no se limita a los problemas u objetivos que a nosotros, más efectiva y eficiente que la inteligencia biológica. Por lo tanto, la IA

como seres humanos, equipados con inteligencia biológica, nos resultan puede ayudar a producir mejores respuestas a problemas complejos

difíciles (Grind, 1997). La inteligencia, definida como la capacidad de utilizando grandes cantidades de datos, conjuntos consistentes de

alcanzar objetivos complejos o resolver problemas complejos, es mucho principios y objetivos éticos, y razonamiento probabilístico y lógico (por

más que eso. Según Moravec (1988), el razonamiento de alto nivel ejemplo, Korteling et al., 2018b). Por lo tanto, conjeturamos que, en última

requiere muy poca computación, pero las habilidades perceptivomotoras instancia, el desarrollo de sistemas de inteligencia artificial para apoyar la

de bajo nivel requieren enormes recursos computacionales. Si expresamos toma de decisiones humanas puede parecer la forma más eficaz de

la complejidad de un problema en términos del número de cálculos conducir a mejores decisiones o al desarrollo de mejores soluciones en

elementales necesarios para resolverlo, entonces nuestra percepción biológicacuestiones complejas. Entonces, la cooperación y división de tareas entre las personas

Fronteras de la Inteligencia Artificial | www.frontiersin.org 6 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

Los sistemas tendrán que estar determinados principalmente por sus las redes neuronales en capas de nuestro cerebro. Basándose en grandes

cualidades mutuamente específicas. Por ejemplo, las tareas o los componentes cantidades de datos, la red aprende a reconocer patrones y vínculos con un

de las tareas que apelan a capacidades en las que sobresalen los sistemas alto nivel de precisión y luego los conecta con cursos de acción sin conocer

de IA tendrán que ser menos (o menos completamente) dominados por las los vínculos causales subyacentes.

personas, por lo que probablemente se requerirá menos capacitación. Los Esto implica que es difícil proporcionar a la IA de aprendizaje profundo algún

sistemas de IA ya son mucho mejores que las personas a la hora de recopilar tipo de transparencia sobre cómo o por qué ha tomado una decisión particular,

(seleccionar) y procesar (pesar, priorizar, analizar, combinar) grandes por ejemplo, expresando un razonamiento inteligible (para los humanos)

cantidades de datos de forma lógica y aritméticamente correcta. Lo hacen de sobre su proceso de decisión, como lo hacemos nosotros ( por ejemplo ,

forma rápida, precisa y fiable. También son más estables (consistentes) que Belkom, 2019). Además, razonar sobre decisiones como lo hacen los

los humanos, no tienen estrés ni emociones y tienen una gran perseverancia humanos es un proceso muy maleable y ad hoc (al menos en los humanos).

y una retención de conocimientos y habilidades mucho mejor que las Los seres humanos generalmente desconocen sus cogniciones o actitudes

personas. Como máquinas, sirven a las personas completamente y sin implícitas y, por lo tanto, no pueden informar adecuadamente sobre ellas. Por

ningún “interés propio” o “agenda oculta propia”. Basándose en estas lo tanto, a muchos humanos les resulta bastante difícil analizar

cualidades, los sistemas de IA pueden asumir eficazmente tareas o introspectivamente sus estados mentales, en la medida en que sean

componentes de tareas de las personas. Sin embargo, sigue siendo conscientes, y asociar los resultados de este análisis a etiquetas y descripciones verbales (p

importante que las personas sigan dominando esas tareas hasta cierto punto, (2011). En primer lugar, el cerebro humano apenas revela cómo crea

para que puedan asumirlas o tomar las medidas adecuadas si falla el sistema de lapensamientos

máquina. conscientes (por ejemplo, FeldmanBarret, 2017). Lo que

En general, las personas están mejor preparadas que los sistemas de IA realmente hace es darnos la ilusión de que sus productos revelan su

para un espectro mucho más amplio de tareas cognitivas y sociales en una funcionamiento interno. En otras palabras: nuestros pensamientos conscientes

amplia variedad de circunstancias y eventos (imprevistos) (Korteling et al., no nos dicen nada sobre la forma en que surgieron esos pensamientos.

2018b). Por el momento, las personas también son mejores en la interacción Tampoco existe un marcador subjetivo que distinga los procesos de

social y psicosocial. Por ejemplo, a los sistemas de IA les resulta difícil razonamiento correctos de los erróneos (Kahneman y Klein, 2009). Por lo

interpretar el lenguaje y los simbolismos humanos. Esto requiere un marco tanto, quien toma decisiones no tiene forma de distinguir entre pensamientos

de referencia muy amplio que, al menos hasta ahora y en el futuro próximo, correctos, que emanan de conocimiento y experiencia genuinos, y

es difícil de lograr dentro de la IA. Como resultado de todas estas diferencias, pensamientos incorrectos que surgen de procesos, tendencias e intuiciones

las personas aún responden mejor (como equipo flexible) a situaciones primarias neuroevolutivas inapropiadas. Entonces aquí podríamos hacernos

inesperadas e impredecibles y diseñan creativamente posibilidades y la pregunta: ¿no es más confiable tener una caja negra real que escuchar

soluciones en tareas abiertas y mal definidas y en una amplia gama de una fabulosa? Además, según Werkhoven et al. (2018) exigir explicabilidad,

situaciones diferentes, y posiblemente inesperadas. circunstancias. Las observabilidad o transparencia (Belkom, 2019; van den Bosch et al., 2019)

personas tendrán que hacer un uso adicional de sus cualidades humanas puede hacer que los sistemas de inteligencia artificial limiten su beneficio

específicas (es decir, aquello en lo que son relativamente buenas) y potencial para la sociedad humana a lo que los humanos pueden entender.

capacitarse para mejorar las competencias pertinentes. Además, los miembros

del equipo humano tendrán que aprender a desenvolverse bien con las

limitaciones generales de las IA. Con una división de tareas tan adecuada, Por supuesto, no debemos confiar ciegamente en los resultados

aprovechando las cualidades y limitaciones específicas de los humanos y los generados por la IA. Al igual que otros campos de tecnología compleja (por

sistemas de IA, se pueden evitar los sesgos de decisión humanos y se puede ejemplo, modelado y simulación), los sistemas de IA deben verificarse

esperar un mejor desempeño. Esto significa que mejorar un equipo con (cumplir con las especificaciones) y validarse (cumplir con los objetivos de

máquinas inteligentes que tengan menos limitaciones y sesgos cognitivos los sistemas) con respecto a los objetivos para los cuales se diseñó el

puede tener más plusvalía que esforzarse por lograr la colaboración entre sistema. En general, cuando un sistema se verifica y valida adecuadamente,

humanos y IA que han desarrollado los mismos sesgos (humanos). Aunque puede considerarse seguro y adecuado para su propósito. Por tanto, merece

la cooperación en equipos con sistemas de IA puede necesitar capacitación nuestra confianza por razones (lógicamente) comprensibles y objetivas

adicional para abordar eficazmente este sesgo y desajuste, esta (aunque todavía pueden producirse errores). Del mismo modo, la gente

heterogeneidad probablemente será mejor y más segura. Esto también abre confía en el rendimiento de los aviones y de los teléfonos móviles, a pesar de

la posibilidad de una combinación de altos niveles de control humano que ignoramos casi por completo sus complejos procesos internos. Al igual

significativo Y altos niveles de automatización que probablemente produzcan que nuestros propios cerebros, las redes neuronales artificiales son

los sistemas humanosIA más efectivos y seguros (Elands et al., 2019; fundamentalmente poco transparentes (Nosek et al., 2011; FeldmanBarret,

Shneiderman, 2020a). En resumen: la inteligencia humana no es el estándar 2017). Por lo tanto, la confianza en la IA debe basarse principalmente en su

de oro para la inteligencia general; En lugar de apuntar a una AGI similar a la desempeño objetivo. Esto constituye una base más importante que brindar

humana, la búsqueda de una AGI debería centrarse en una AGI digital/de confianza a partir de impresiones, historias o imágenes subjetivas (engañables)

silicio eficaz junto con una configuración y asignación óptimas de tareas. destinadas a creer y atraer al usuario. Con base en investigaciones de

validación empírica, los desarrolladores y usuarios pueden verificar

explícitamente qué tan bien está funcionando el sistema con respecto al

conjunto de valores y objetivos para los cuales fue diseñada la máquina. En

Explicabilidad y confianza Los avances algún momento, los seres humanos pueden querer confiar en que se pueden

en relación con el aprendizaje artificial, o el aprendizaje profundo (por lograr objetivos con menos costos y mejores resultados, cuando aceptamos

refuerzo), en particular, han sido revolucionarios. El aprendizaje profundo soluciones incluso si pueden ser menos transparentes para los humanos

simula una red parecida (Werkhoven et al., 2018).

Fronteras de la Inteligencia Artificial | www.frontiersin.org 7 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

EL IMPACTO DE MÚLTIPLES IA ESTRECHAS Ejemplos: aprendizaje de uno o pocos intentos. GPT3 (desarrollado por

TECNOLOGÍA OpenAI) puede hacer esto con tareas relacionadas con el lenguaje, pero

no hay ninguna razón por la que esto no sea posible con imagen y sonido,

La AGI como Santo Grial La AGI, o con combinaciones de estos tres (Brown, 2020).

al igual que la inteligencia general humana, tendría muchas ventajas Además, la paradoja de Moravec implica que el desarrollo de “socios”

obvias, en comparación con la IA estrecha (limitada, débil y especializada). de IA con muchos tipos de cualidades humanas (de nivel) será muy difícil

Un sistema AGI sería mucho más flexible y adaptable. Sobre la base de de obtener, mientras que su valor agregado (es decir, más allá de los

procesos genéricos de formación y razonamiento, comprendería de forma límites de las capacidades humanas) será relativamente bajo. Las

autónoma cómo se pueden resolver múltiples problemas en todo tipo de aplicaciones de IA más fructíferas implicarán principalmente complementar

dominios diferentes en relación con su contexto (por ejemplo, las limitaciones y limitaciones humanas. Dados los incentivos actuales para

Kurzweil, 2005). Los sistemas AGI también requieren muchas menos el progreso tecnológico competitivo, múltiples formas de sistemas estrechos

intervenciones humanas para acomodar los diversos cabos sueltos entre de IA (conectados) serán el principal impulsor del impacto de la IA en

elementos parciales, facetas y perspectivas en situaciones complejas. nuestra sociedad a corto y mediano plazo.

AGI realmente entendería los problemas y sería capaz de verlos desde En el futuro cercano, esto puede implicar que las aplicaciones de IA

diferentes perspectivas (como las personas, idealmente, también pueden seguirán siendo muy diferentes de los agentes humanos y, en muchos

hacer). Una característica de las herramientas de IA (estrictas) actuales es aspectos, casi incomparables con ellas. Es probable que esto sea cierto

que están especializadas en una tarea muy específica, donde a menudo incluso si en el futuro se lograra a largo plazo la hipotética coincidencia de

pueden desempeñarse a niveles sobrehumanos (por ejemplo, Goertzel, la inteligencia artificial general (AGI) con la cognición humana. La

2007; Silver et al., 2017). Estas tareas específicas han sido bien definidas inteligencia es un concepto multidimensional (cuantitativo, cualitativo).

y estructuradas. Los sistemas de IA restringidos son menos adecuados, o Todas las dimensiones de la IA se desarrollan y crecen a lo largo de su

totalmente inadecuados, para tareas o entornos de tareas que ofrecen poca propio camino diferente con su propia dinámica. Por lo tanto, con el tiempo,

estructura, coherencia, reglas u orientación, en los que pueden ocurrir todo un número cada vez mayor de capacidades específicas (estrechas) de IA

tipo de eventos inesperados, raros o poco comunes (por ejemplo, pueden gradualmente igualar, superar y trascender las capacidades

emergencias). Conocer y seguir procedimientos fijos generalmente no cognitivas humanas. Dadas las enormes ventajas de la IA, por ejemplo en

conduce a soluciones adecuadas en estas circunstancias tan variables. En el campo de la disponibilidad de datos y las capacidades de procesamiento

el contexto de cambios (imprevistos) en objetivos o circunstancias, la de datos, la realización de la AGI probablemente superaría al mismo tiempo

adecuación de la IA actual se reduce considerablemente porque no puede a la inteligencia humana en muchos sentidos. Lo que implica que el

razonar desde una perspectiva general y adaptarse en consecuencia (Lake momento hipotético en el que se igualarán las capacidades cognitivas

et al., 2017; Horowitz, 2018). Al igual que con los sistemas de IA limitados, humanas y artificiales, es decir, el AGI a nivel humano, probablemente será

se necesitan personas que supervisen estas desviaciones para permitir un difícil de definir de manera significativa (Goertzel, 2007).3

rendimiento del sistema flexible y adaptable. Por lo tanto, la búsqueda de Entonces, ¿cuándo la IA realmente nos entenderá como un “ amigo”,

AGI puede considerarse como la búsqueda de una especie de santo grial. “compañero”, “alter ego” o “compañero”, como lo hacemos cuando

colaboramos con otros humanos como humanos, nos superará en muchas

¡La IA múltiple y estrecha es más relevante ahora! áreas al mismo tiempo Moravec (1998) . Tendrá un perfil de capacidades y

Sin embargo, las altas perspectivas potenciales de la AGI no implican que habilidades completamente diferente y, por lo tanto, no será fácil comprender

la AGI vaya a ser el factor más crucial en la futura I+D de IA, al menos a realmente su forma de “piensa” y toma sus decisiones. Mientras tanto, sin

corto y mediano plazo. Al reflexionar sobre los grandes beneficios embargo, a medida que las capacidades de los robots se expanden y pasan

potenciales de la inteligencia general, tendemos a considerar las de herramientas simples a sistemas más integrados, es importante calibrar

aplicaciones limitadas de IA como entidades separadas que muy bien adecuadamente nuestras expectativas y percepciones hacia los robots. Por

pueden ser superadas por una AGI más amplia que presumiblemente lo tanto, tendremos que mejorar nuestra conciencia y conocimiento sobre

puede lidiar con todo. Pero así como nuestro mundo moderno ha el desarrollo y la progresión continuos de múltiples formas de sistemas de

evolucionado rápidamente a través de una diversidad de innovaciones IA (integrados). Se trata, por ejemplo, de la naturaleza multifacética de la

tecnológicas específicas (limitadas), a nivel de sistema, la amplia y total inteligencia. Diferentes tipos de agentes pueden tener diferentes

gama de aplicaciones de IA emergentes también tendrá un impacto combinaciones de inteligencias de niveles muy diferentes. Un agente con

tecnológico y social innovador (Peeters et al., 2020). . Esto será aún más inteligencia general puede, por ejemplo, estar dotado de excelentes

relevante para el futuro mundo del big data, en el que todo estará conectado capacidades en el ámbito del reconocimiento de imágenes y la navegación,

con todo a través del Internet de las cosas. Por lo tanto, será mucho más el cálculo y el razonamiento lógico y, al mismo tiempo, ser aburrido en el

rentable y beneficioso desarrollar y construir variantes de IA (no parecidas ámbito de la interacción social y la resolución de problemas orientada a

a las humanas) que sobresalgan en áreas donde las personas son objetivos. Esta conciencia de la naturaleza multidimensional de la

inherentemente limitadas. No parece demasiado descabellado suponer que inteligencia también afecta a la forma en que tenemos que lidiar con (y

las múltiples variantes de aplicaciones estrechas de IA también se capitalizar) el antropomorfismo. Esa es la tendencia humana en la

interconecten gradualmente de manera más amplia. De esta manera, se interacción humanorobot a caracterizar artefactos no humanos que

puede esperar un desarrollo hacia un ámbito cada vez más amplio de

aplicaciones integradas de IA.

Además, ya es posible entrenar un modelo de lenguaje AI (Generative Pre

trained Transformer3, GPT3) con un conjunto de datos gigantesco y luego 3

A menos, por supuesto, que la IA sea deliberadamente limitada o degradada al funcionamiento

hacer que aprenda varias tareas basadas en un puñado de a nivel humano.

Fronteras de la Inteligencia Artificial | www.frontiersin.org 8 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

superficialmente se parecen a nosotros por poseer rasgos, emociones e estadística, cálculo de probabilidades, análisis de datos, razonamiento

intenciones humanas (por ejemplo, Kiesler y Hinds, 2004; Fink, 2012; lógico, memorización, etcétera.

Haring et al., 2018). Conocer estas cuestiones de factores humanos es En esta línea hemos defendido una visión más modesta, más humilde,

crucial para optimizar la utilidad, el rendimiento y la seguridad de los de nuestra inteligencia humana general. Lo que también implica que la

sistemas de IA humana (Peeters et al., 2020). AGI a nivel humano no debe considerarse como el “estándar de oro” de

Desde esta perspectiva, la cuestión de si se realizará o no una “AGI a la inteligencia (que debe perseguirse con máxima prioridad). Debido a las

nivel humano” no es la más relevante por el momento. Según la mayoría muchas diferencias fundamentales entre las inteligencias natural y

de los científicos de IA, esto ciertamente sucederá, y la pregunta clave no artificial, una AGI similar a la humana será muy difícil de lograr en primer

es SI esto sucederá, sino CUÁNDO (por ejemplo, Müller y Bostrom, 2016). lugar (y también con un valor agregado relativamente limitado). En caso

Sin embargo, a nivel de sistema, es probable que múltiples aplicaciones de que se logre un AGI en el futuro (lejano), probablemente tendrá un

limitadas de IA superen a la inteligencia humana en una gama cada vez perfil de capacidades y habilidades cognitivas completamente diferente al

más amplia de áreas. que tenemos nosotros, como humanos. Cuando un AGI de este tipo haya

llegado tan lejos que sea capaz de “colaborar” como un ser humano, al

mismo tiempo será probable que en muchos aspectos ya pueda funcionar

CONCLUSIONES Y MARCO a niveles muy superiores en relación con lo que nosotros podemos. Por el

momento, sin embargo, no será muy realista ni útil apuntar a un AGI que

El presente artículo se centró en proporcionar más claridad y comprensión incluya el amplio espectro de las capacidades cognitivas y perceptuales

sobre las características, diferencias e idiosincrasias fundamentales de humanas. En cambio, las aplicaciones de IA más rentables para el futuro

las inteligencias humana y artificial. Primero presentamos ideas y a corto y mediano plazo probablemente se basarán en múltiples sistemas

argumentos para ampliar y diferenciar nuestra concepción de la de IA estrechos. Estas múltiples aplicaciones limitadas de IA pueden

inteligencia, ya sea humana o artificial. Central para esta concepción más alcanzar la inteligencia humana en una gama cada vez más amplia de

amplia y multifacética de la inteligencia es la noción de que la inteligencia áreas.

en sí misma es una cuestión de información y computación, independiente

de su sustrato físico. Sin embargo, la naturaleza de este sustrato físico Desde este punto de vista, recomendamos no insistir demasiado en la

(biológico/carbono o digital/silicio), determinará sustancialmente su cuestión de la AGI, si la IA será más astuta que nosotros, si nos quitará

potencial envolvente de capacidades y limitaciones cognitivas. Las nuestros trabajos o cómo dotarla de todo tipo de capacidades humanas.

facultades cognitivas orgánicas de los humanos se han desarrollado muy Dado el estado actual de la técnica, puede ser prudente centrarse más en

recientemente durante la evolución de la humanidad. Estas facultades todo el sistema de múltiples innovaciones de IA con los humanos como

"embrionarias" se han construido sobre un aparato de red neuronal factor crucial de conexión y supervisión. Esto también implica el

biológica que ha sido optimizado para la alostasis y funciones motoras establecimiento y formalización de límites legales y objetivos adecuados

perceptuales (complejas). Por tanto, la cognición humana se caracteriza (eficaces, éticos y seguros) para los sistemas de IA (Elands et al., 2019;

por diversas limitaciones estructurales y distorsiones en su capacidad Aliman, 2020). Por tanto, este factor humano (legislador, usuario,

para procesar ciertas formas de información no biológica. “colaborador”) necesita tener un buen conocimiento de las características

y capacidades de la inteligencia biológica y artificial (bajo todo tipo de

tareas y condiciones de trabajo). Tanto en el lugar de trabajo como en la

Las redes neuronales biológicas, por ejemplo, no son muy capaces de formulación de políticas, las aplicaciones de IA más fructíferas serán

realizar cálculos aritméticos, para los cuales mi calculadora de bolsillo se complementar y compensar las limitaciones biológicas y cognitivas

adapta millones de veces mejor. Estas limitaciones inherentes y arraigadas, inherentes a los humanos. Por esta razón, las cuestiones más destacadas

que se deben al origen biológico y evolutivo de la inteligencia humana, son ¿cómo utilizarlo de forma inteligente? ¿Para qué tareas y bajo qué

pueden denominarse "integradas". condiciones es seguro dejar las decisiones en manos de la IA y cuándo

se requiere el juicio humano? ¿Cómo podemos aprovechar las fortalezas

De acuerdo con la paradoja de Moravic, sostenemos que el de la inteligencia humana y cómo implementar sistemas de IA de manera

comportamiento inteligente es más de lo que a nosotros, como homo efectiva para complementar y compensar las limitaciones inherentes a la

sapiens, nos resulta difícil. Por tanto, no deberíamos confundir la dificultad cognición humana? Consulte (Hoffman y Johnson, 2019; Shneiderman,

de la tarea (subjetiva, antropocéntrica) con la complejidad de la tarea 2020a; Shneiderman, 2020b) para obtener resúmenes recientes.

(objetiva). En lugar de ello, propugnamos una conceptualización versátil

de la inteligencia y un reconocimiento de sus muchas formas y composiciones posibles.

Esto implica una gran variedad de tipos de inteligencia biológica u otras En resumen: no importa cuán inteligentes se vuelvan los agentes

formas de alta (general) con una amplia gama de posibles perfiles de autónomos de IA en ciertos aspectos, al menos en el futuro previsible,

inteligencia y cualidades cognitivas (que pueden o no superar las nuestras seguirán siendo máquinas inconscientes. Estas máquinas tienen un

en muchos aspectos). Esto nos haría más conscientes de los potenciales sistema operativo fundamentalmente diferente (biológico versus digital)

más probables de las aplicaciones de IA en el futuro a corto y medio con capacidades y cualidades cognitivas correspondientemente diferentes

plazo. Por ejemplo, desde esta perspectiva, nuestra principal investigación a las de las personas y otros animales. Por lo tanto, antes de que pueda

debería centrarse en aquellos componentes del espectro de la inteligencia comenzar una “colaboración en equipo” adecuada, los miembros del

que son relativamente difíciles para el cerebro humano y relativamente equipo humano tendrán que comprender este tipo de diferencias, es decir,

fáciles para las máquinas. Esto implica principalmente el componente en qué se diferencia el procesamiento de la información humana y la

cognitivo que requiere cálculo, análisis aritmético, inteligencia de las muchas variantes posibles y específicas de los sistemas de IA.

Fronteras de la Inteligencia Artificial | www.frontiersin.org 9 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

Sólo cuando los humanos desarrollen una comprensión adecuada de estas Sistema operativo de IA o la “mente de IA”. A esto le pueden seguir temas como:

diferencias "entre especies" podrán capitalizar de manera efectiva los beneficios Percepción e interpretación de la información por parte de la IA, cognición de la

potenciales de la IA en (futuros) equipos humanosIA. Dada la alta flexibilidad, IA (memoria, procesamiento de información, resolución de problemas, sesgos),

versatilidad y adaptabilidad de los humanos en relación con los sistemas de IA, tratamiento de las posibilidades y limitaciones de la IA en áreas "humanas" como

el primer desafío es entonces ¿cómo garantizar la adaptación humana a las la creatividad, la adaptabilidad, la autonomía y la reflexión. y (auto)conciencia,

capacidades más rígidas de la IA?4 En otras palabras: ¿cómo podemos lograr que se ocupa de las funciones objetivo (valoración de las acciones en relación

una concepción adecuada de las diferencias entre los humanos? ¿Y la con el costobeneficio), la ética de la IA y la seguridad de la IA. Además, dicho

inteligencia artificial? plan de estudios debería incluir módulos técnicos que proporcionen información

sobre el funcionamiento del sistema operativo de IA.

Debido a la enorme velocidad con la que se desarrolla la tecnología y las

Marco para la formación en la conciencia de la inteligencia Para esta aplicaciones de la IA, el contenido de dicho plan de estudios también es muy

pregunta, es dinámico y evoluciona continuamente sobre la base del progreso tecnológico.

necesario abordar más enérgicamente la cuestión de la conciencia de la Esto implica que el plan de estudios y las ayudas y entornos de capacitación

inteligencia en los profesionales humanos. Además de las herramientas deben ser flexibles, experienciales y adaptables, lo que hace que la forma de

informáticas para la distribución de información de concientización relevante trabajo de los juegos serios sea ideal.

(Collazos et al., 2019) en sistemas hombremáquina, esto requiere una mejor A continuación, proporcionamos un marco global para el desarrollo de nuevos

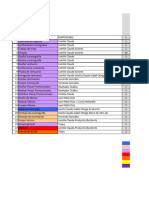

educación y capacitación sobre cómo abordar las características, idiosincrasias y planes de estudio educativos sobre concientización sobre la IA. Estos subtemas

capacidades muy nuevas y diferentes de los sistemas de IA. . Esto incluye, por van más allá de aprender a “operar”, “controlar” o interactuar de manera efectiva

ejemplo, una comprensión adecuada de las características, posibilidades y con aplicaciones específicas de IA (es decir, la interacción convencional entre

limitaciones básicas de las propiedades del sistema cognitivo de la IA sin humanos y máquinas):

conceptos erróneos antropocéntricos y/o antropomórficos. En general, esta

“Conciencia de Inteligencia” es muy relevante para comprender, investigar y Comprensión de las características subyacentes del sistema de la IA (el

abordar mejor las múltiples posibilidades y desafíos de la inteligencia artificial. "cerebro de la IA"). Comprender las cualidades y limitaciones específicas de

la IA en relación con la inteligencia humana.

Comprender la complejidad de las tareas y del entorno desde la perspectiva

Este desafío práctico de los factores humanos podría abordarse, por ejemplo, de los sistemas de IA.

mediante el desarrollo de formas de capacitación y entornos de aprendizaje Comprender el problema de los sesgos en la cognición humana, en relación

nuevos, específicos y fácilmente configurables (adaptativos) para sistemas con los sesgos en la IA.

humanosIA. Estas formas y entornos de capacitación flexibles (por ejemplo, Comprender los problemas asociados con el control de la IA, la previsibilidad

simulaciones y juegos) deberían centrarse en desarrollar conocimientos, del comportamiento de la IA (decisiones), generar confianza, mantener la

conocimientos y habilidades prácticas sobre las características, capacidades y conciencia de la situación (complacencia), asignación dinámica de tareas (por

limitaciones específicas no humanas de los sistemas de IA y cómo abordarlas en ejemplo, asumir las tareas de los demás) y responsabilidad (rendición de

situaciones prácticas. cuentas).

¿La gente tendrá que comprender los factores críticos que determinan los Cómo abordar las posibilidades y limitaciones de la IA en el campo de la

objetivos, el desempeño y las opciones de la IA? Lo que en algunos casos puede “creatividad”, adaptabilidad de la IA, “conciencia ambiental” y generalización

incluso incluir la simple noción de que las IA se entusiasman tanto con su del conocimiento.

desempeño para lograr sus objetivos como lo hace su refrigerador por mantener Aprender a afrontar las limitaciones perceptivas y cognitivas y los posibles

bien su batido. ¿Tienen que aprender cuándo y bajo qué condiciones es seguro errores de la IA que pueden resultar difíciles de comprender.

dejar las decisiones en manos de la IA y cuándo es necesario o esencial el juicio Confianza en el desempeño de la IA (posiblemente a pesar de su limitada

humano? Y más en general: ¿cómo “piensa” y decide? La relevancia de este tipo transparencia o capacidad de “explicar”) basada en verificación y validación.

de conocimientos, habilidades y prácticas solo será mayor cuando crezca el grado

de autonomía (y genérica) de los sistemas avanzados de IA. Aprender a lidiar con nuestra inclinación natural al antropocentrismo y al

antropomorfismo (“teoría de la mente”) al razonar sobre la interacción humano

robot.

¿Cómo es un plan de estudios de formación en materia de conciencia de Cómo aprovechar los poderes de la IA para hacer frente a las limitaciones

inteligencia? Debe incluir al menos un módulo sobre las características cognitivas inherentes al procesamiento de la información humana (y viceversa).

de la IA. Se trata básicamente de una materia similar a las que también se

incluyen en los planes de estudio sobre cognición humana. Comprender las características y cualidades específicas del sistema hombre

Este amplio módulo sobre la "Ciencia cognitiva de la IA" puede involucrar una máquina y ser capaz de decidir cuándo, para qué y cómo la combinación

variedad de subtemas que comienzan con una revisión del concepto de integrada de facultades humanas y de IA puede funcionar al máximo del

"Inteligencia" despojado de malentendidos antropocéntricos y antropomórficos. potencial general del sistema.

Además, este módulo debe centrarse en proporcionar conocimientos sobre la

estructura y funcionamiento del

En conclusión: debido a la enorme velocidad con la que

La tecnología y las aplicaciones de la IA evolucionan, necesitamos una

4

Además de la cuestión de la IA con conciencia humana, es decir, la adaptación de la IA al ámbito cognitivo conceptualización más versátil de la inteligencia y un reconocimiento de sus

características de los humanos. muchas formas y posibilidades posibles.

Fronteras de la Inteligencia Artificial | www.frontiersin.org 10 marzo 2021 | Volumen 4 | Artículo 622364

Machine Translated by Google

Korteling et al. Inteligencia humana versus artificial

combinaciones. Una concepción revisada de la inteligencia incluye también una CONTRIBUCIONES DE AUTOR

buena comprensión de las características básicas, posibilidades y limitaciones

de diferentes conceptos erróneos antropocéntricos y/o antropomórficos (biológicos, La búsqueda bibliográfica, el análisis, el trabajo conceptual y la redacción del

artificiales) sin propiedades cognitivas del sistema. manuscrito fueron realizados por JEK. Todos los autores enumerados han

realizado contribuciones sustanciales, directas e intelectuales al trabajo y

Esta “Conciencia de Inteligencia” es muy relevante para comprender y abordar aprobaron su publicación.

mejor las múltiples posibilidades y desafíos de la inteligencia artificial, por ejemplo,

para decidir cuándo usar o implementar la IA en relación con las tareas y su

contexto. Por lo tanto, se recomienda el desarrollo de planes de estudio educativos EXPRESIONES DE GRATITUD

con formularios de capacitación y entornos de aprendizaje nuevos, específicos y

fácilmente configurables para sistemas humanosIA. El trabajo futuro debería Los autores quieren agradecer a J. van Diggelen, LJHM Kester por sus útiles

centrarse en herramientas, métodos y contenidos de formación que sean lo aportes para este manuscrito. El presente artículo fue un resultado de 1) el

suficientemente flexibles y adaptables para poder mantenerse al día con los programa BIHUNT (Behavioral Impact of NIC Teaming, V1719) financiado por el

rápidos cambios en el campo de la IA y con la amplia variedad de grupos Ministerio de Defensa holandés y del programa Wise Policy Making financiado

destinatarios y objetivos de aprendizaje. por la Organización Holandesa para la Investigación Científica Aplicada (TNO).

Damasio, AR (1994). El error de Descartes: emoción, razón y cerebro humano. Nuevo

REFERENCIAS

York, Nueva York, Estados Unidos: GP Putnam's Sons.

Elands, P., HuizingKester, AL, Oggero, S. y Peeters, M. (2019). Gobernar el comportamiento ético

Ackermann, N. (2018). Marco de inteligencia artificial: una introducción visual al aprendizaje y eficaz de los sistemas inteligentes: un marco novedoso para un control humano significativo

automático y la IA. Obtenido de: https://towardsdatascience.com/artificialintelligenceframework en un contexto militar. Espectador militar 188 (6), 302–313.

avisualintroductiontomachinelearningandaid7e36b304f87 . (9 de septiembre de 2019). FeldmanBarret, L. (2017). Cómo se crean las emociones: la vida secreta del cerebro.

Boston, MA, Estados Unidos: Houghton Mifflin Harcourt.

Alimán, Nuevo México. (2020). Estrategias híbridas cognitivoafectivas para la seguridad de la IA. Fink, J. (2012). “Antropomorfismo y semejanza humana en el diseño de robots y

Tesis doctoral. Utrecht, Países Bajos: Universidad de Utrecht. doi:10.33540/203 la interacción humanorobot”, en Robótica social. ICSR 2012. Apuntes de

Bao, JX, Kandel, ER y Hawkins, RD (1997). Participación de mecanismos pre y postsinápticos en conferencias sobre informática. Editores SS Ge, O. Khatib, JJ Cabibihan, R.

la potenciación posttetánica en las sinapsis de Aplysia. Simmons y MA Williams (Berlín, Alemania: Springer), 7621. doi:10.1007/

Ciencia 275, 969–973. doi:10.1126/science.275.5302.969Dane 9783642341038_20

Barra, M. (2007). El cerebro proactivo: uso de analogías y asociaciones para generar predicciones. Fischetti, M. (2011). Computadoras versus cerebros. Número del 175 aniversario de Scientific

Tendencias Cogn. Ciencia. 11, 280–289. doi:10.1016/j.tics. 2007.05.005 American Obtenido de: https://www.scientificamerican.com/article/computersvsbrains/ .