Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Tema 2

Cargado por

MARTA ESTEFANÍA LÓPEZ MARRERO0 calificaciones0% encontró este documento útil (0 votos)

6 vistas23 páginasDerechos de autor

© © All Rights Reserved

Formatos disponibles

DOCX, PDF, TXT o lea en línea desde Scribd

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

© All Rights Reserved

Formatos disponibles

Descargue como DOCX, PDF, TXT o lea en línea desde Scribd

0 calificaciones0% encontró este documento útil (0 votos)

6 vistas23 páginasTema 2

Cargado por

MARTA ESTEFANÍA LÓPEZ MARREROCopyright:

© All Rights Reserved

Formatos disponibles

Descargue como DOCX, PDF, TXT o lea en línea desde Scribd

Está en la página 1de 23

TEMA 2

CRITERIOS DE BONDAD: La fiabilidad y la validez

Introducción

En este capítulo intentaremos hacer un recorrido por lo que ha

sido la metodología propia de la evaluación psicológica. Nos

centraremos para ello en las diferentes dicotomías metodológicas

usuales en nuestra disciplina: correlacional-experimental, ideográfico-

nomotético, cuantitativo-cualitativo y natural-social de la conducta.

Después de realizar algunas reflexiones pasaremos a las garantías

científicas que debemos tener presente a la hora de seleccionar y llevar

a cabo una evaluación.

3.1.- Métodos en evaluación psicológica.

La evaluación psicológica, como subdisciplina de la psicología,

utiliza el mismo método que ella: el método científico. Este método se

caracteriza por su sistematicidad y control, lo que permite la replicación

futura de los hechos observados. Esto se argumenta basándose en la

idea de que en caso contrario, no existirían soluciones comunes al

problema de la descripción, la explicación y la predicción.

La evaluación psicológica para la consecución de sus objetivos y

sin renunciar al mencionado método científico, emplea diferentes

estrategias. Esta diversidad muestra distintos planteamientos acerca

de las características diferenciadoras del objeto de estudio de la

psicología. En estas diferencias, que usualmente han sido denominadas

dicotomías entraremos en los siguientes apartados.

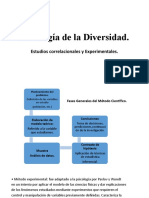

3.1.1.- Metodología correlacional frente a la experimental.

La metodología correlacional tiene en su haber una función más

descriptiva, cuya pretensión es encontrar relaciones entre las variables

y estimar su grado de covariación, todo ello sin manipular la realidad.

Éste método busca establecer relaciones de concomitancia entre los

hechos tal y como se producen naturalmente, sin la manipulación del

experimentador (Pelechano, 1988), se preocupa en encontrar diferencias

individuales consistentes que, se supone, constituyen variables

organísmicas estables en los seres humanos (Fernández-Ballesteros,

1980). Sin embargo, la supuesta ausencia de control no es tal, ya que

este se impone a posteriori mediante procedimientos estadísticos, no

físicos. Aunque no permite aislar relaciones causales, parte del

supuesto de la multicausalidad de los fenómenos objeto de estudio

(Pelechano, 1988).

Por el contrario, la metodología experimental parte de una

hipótesis en la que se establece una relación causal entre dos variables.

Se impone un fuerte control sobre las variables ajenas a la propia

hipótesis (demandas de la tarea, variables de la situación experimental,

personales...) como garantía para establecer con validez las relaciones

causales predichas. Busca establecer relaciones de causalidad que le

posibilite imputar los cambios observados en las variables dependientes

a la manipulación de las variables independientes (Cronbach, 1957). A

diferencia del método correlacional, se parte del supuesto de una

relación bivariada causa-efecto. La estrategia experimental consiste

esencialmente en provocar una modificación en una situación

determinada y observar el resultado. Esta estrategia requiere un gran

rigor en el planteamiento y una sistematización en la ejecución. Deben

estimarse las variables que inciden en cada caso y controlarlas

(Pelechano, 1988).

En cualquier experimento se intenta establecer conclusiones

válidas acerca del efecto de la manipulación efectuada sobre la variable

independiente. Si los resultados de un experimento pueden ser

atribuidos de forma inequívoca a la variable independiente, entonces se

dice que el experimento tiene validez interna. La validez interna se

refiere al grado en que se pueden descartar explicaciones alternativas

en los resultados (Buela-Casal, 1997). Una disminución de la validez

interna indica una influencia de variables contaminadoras, produciendo

una ambigüedad interpretativa de los resultados de la investigación

(Pereda, 1987). La validez externa hace referencia a la posibilidad de

generalizar los resultados. Una investigación tiene validez externa

cuando sus conclusiones pueden aplicarse en poblaciones de sujetos y

en situaciones distintas a las de la investigación original. Buela-Casal

(1997) afirma que “la validez externa es indicar en qué medida los

resultados de la investigación pueden ser aplicados en contextos más

generales”.

Según lo anterior, es fácil inferir que el método experimental tiene

validez interna, mientras que el correlacional carece casi por completo

de este tipo de validez. Sin embargo, en lo que se refiere a la validez

externa la relación es más compleja, pues a pesar de que están

apoyados en la realidad y en contextos naturales, autores como

Campbell y Stanley (1966) considera que los estudios correlacionales

tienen poca validez externa. Según estos autores, la validez interna es

un requisito previo para la validez externa, por lo que sólo cabría hablar

de validez interna de la experimentación, ya que es más importante

demostrar una relación sin ambigüedad que plantear su generalización.

Esta situación se agrava por el hecho de que a mayor validez interna

menos capacidad de generalización. Una solución es repetir los

experimentos en diferentes situaciones y con distintos sujetos, con lo

que se incrementa la validez externa de la experimentación (Alvira, Avia,

Calvo y Morales, 1979).

Pese a esta primera diferencia histórica, no se puede suponer que

la evaluación psicológica emplee exclusivamente una metodología

correlacional, desechando la experimental. Tal y como plantea

Cronbach en 1957 en su trabajo acerca de esta dicotomía, ambos

enfoques pretenden lo mismo: cómo controlar o eliminar la varianza no

deseable o varianza error y, por tanto, pone de manifiesto que la

psicología se nutre tanto de los estudios provenientes de la psicología

experimental como de los estudios que parten de la psicología

correlacional.

Pese a lo dicho, la metodología más adecuada a la evaluación

psicológica es la correlacional, incluyendo en esta la atención hacia

variables contextuales y ambientales (Pelechano, 1982, 1988; Silva,

1982, 1989; Fernández-Ballesteros, 1980) Tanto en la elaboración de

pruebas como en la aplicación de estas, no se modifica nada y se extrae

la información tal y como se encuentra en la situación natural. En la

actualidad, la evaluación psicológica ha ampliado su campo de

actuación a la evaluación de settings y contextos, gracias al impacto de

la psicología ambiental y de la psicología ecológica (Moos y Lemke,

1979; Baker, 1989). Esto ha supuesto tenerse que dirigir hacia una

evaluación de situaciones y estímulos, añadiéndose estos datos a los

datos de personas y conductas. Si tomamos estas aportaciones y se

abandona el sentido bivariado de causa-efecto de la metodología

experimental y se profundiza en el estudio multivariado del papel

predictivo de los distintos settings, contextos o ambientes, con sus

distintos niveles de consolidación y su peso aportado a la varianza

común, se estaría utilizando la metodología correlacional para estudiar

aquellos que en su concepción tradicional se consideran en el mejor de

los casos, fuente de varianza de error, y/o en el peor de ellos , como

algo que hay que relegar al olvido de la ciencia psicológica (Peñate,

1993).

La complementariedad de ambos enfoques parece un requisito

para cumplir mejor las funciones propias de la evaluación en su

vertiente básica y aplicada.

3.1.2.- Metodología ideográfica frente a la nomotética.

La visión de la psicología como una ciencia ideográfica versus una

ciencia nomotética, constituye una cuestión antigua que ha suscitado

más de un debate y que se plantea como otra de las dicotomías

importantes, especialmente en la evaluación psicológica. Uno de los

objetivos de la ciencia es ofrecer un tipo de conocimiento que sea

generalizable y, por tanto, esta dicotomía antigua en el tiempo, tiende a

superarse por considerar que la psicología en general y la evaluación

psicológica en particular, pueden beneficiarse de ambas metodologías.

Pervin (1979) acerca de los dos polos dice: “lo nomotético busca

las leyes generales de comportamiento y la categorización de las

personas mediante métodos cuantificables y objetivos; lo ideográfico

busca rasgos únicos para cada persona, cuantificando métodos

aplicables a individuos y poniendo énfasis en la búsqueda de leyes

individuales”.

Para Fernández-Ballesteros (1992) las ciencias pueden ser

divididas en dos grandes grupos: las nomotéticas y las ideográficas.

Mientras que las segundas se dedican al estudio de fenómenos

individuales, las primeras tienen como objetivo el hallazgo de los

principios generales aplicables a los fenómenos objeto de estudio.

La psicología científica es una disciplina cuyo objeto es la

búsqueda de los principios aplicables a la conducta humana y, por

tanto, una ciencia nomotética. En el caso de la evaluación psicológica

como subdisciplina de la psicología, tiene como objetivo el análisis de

los principios psicológicos básicos en una persona específica. Si se

estima el concepto ideográfico etimológicamente, la evaluación

psicológica puede ser calificada de disciplina ideográfica, pero

perfectamente compatible con una ciencia de la psicología nomotética

(Fernández-Ballesteros, 1992).

El enfoque ideográfico supone la búsqueda de las características

únicas y propias de una persona. Según este principio, los seres

humanos somos únicos e irrepetibles, por lo que recurrir a leyes

generales no tendría sentido explicativo, ni tampoco recurrir a una

persona única para identificar leyes generales. De ahí la presunción de

que los procedimientos de análisis deberían ser propios para persona.

Esta concepción cerrada, categórica y extrema del concepto ideográfico

parece propia de los acercamientos fenomenológicos y clínicos, no

siendo necesariamente correcta. Frente a esto, la propuesta nomotética

parte del supuesto de que bastaría un grupo limitado de características

psicológicas para describir, clasificar, explicar a una persona. Esto no

supone una homogeneización sino que más bien se basa en esos

elementos comunes para justificar la unicidad de cada paciente, sujeto

o cliente. Tanto es así, que no sólo no niega la psicología experimental,

sino que la apoya y le sirve de método de estudio (Pelechano, 1988). Lo

que debe hacer la evaluación psicológica es utilizar todos los

procedimientos que se consideren adecuados para el descubrimiento de

las leyes individuales que dan sentido a la vida de cada individuo

(Pelechano, 1988).

El acercamiento nomotético defiende que las diferencias entre los

seres humanos son reales, pero se dan a lo largo de unas dimensiones

que son comunes a todos ellos. Existen diferencias, precisamente

porque existen elementos comunes. Las diferencias entre dos seres

humanos se resumirían en dos tipos de análisis: o bien en cuanto a las

puntuaciones alcanzadas en las dimensiones conocidas, o bien en las

relaciones que existen entre estas dimensiones (Pelechano, 1988).

La testología asume una posición nomotética en el estudio del

caso individual, porque entiende que aún sin agotarlo, la información

recogida es suficientemente relevante. Esta información nos permite la

comparación entre personas con el fin de clasificarlos en función de las

puntuaciones obtenidas en las pruebas

Resumiendo, podemos concluir:

(i) la evaluación ideográfica pura como tal, parece que no existe.

Supone una descontextualización del paciente. Toda evaluación

conlleva el recurso a principios generales, a un grupo o criterio de

referencia;

(ii) los objetivos de la evaluación son fundamentalmente

ideográficos;

(iii) los hallazgos de nuestra disciplina se basan en un enfoque

nomotético;

(iv) los métodos de evaluación son los propios de la psicología

nomotética (Fernández-Ballesteros, 1983 y 1992).

3.1.3.- El método cualitativo frente al cuantitativo.

Esta dicotomía a la que Peñate (1993,1999) denomina “clínico

frente a laboratorio”, es posiblemente una de las más injustificadas en

nuestros días. La antinomia cualitativo versus cuantitativo se

encuentra estrechamente relacionada con la dicotomía anterior, aunque

se trata de una polémica de carácter más metodológico, que se halla

relacionada con las estrategias de recogida de la información (Arnau,

1997). Básicamente, el problema se ha centrado en dos puntos: el tipo

de datos que se utilizan y el modo de combinarlos para la predicción de

la conducta. Si tuviéramos que describirla brevemente apelando a una

serie de atributos podríamos elaborar la siguiente caracterización

partiendo de la revisión crítica de Cook y Reichard, 1986:

Cuantitativo Cualitativo

Global-positivista Global-fenomenológica

Hipotética-deductiva Inductiva

Particularista Estructuralista

Objetiva Subjetiva

Orientada a los resultados Orientada al proceso

Ciencia natural Antropología social.

Según Holt (1965, citado por Pervin, 1975), la orientación clínico-

cualitativa surge de la tradición médica, directamente relacionada con

los problemas cotidianos. En este marco, la subjetividad, la perspicacia

y libertad del evaluador (instrumentos, formas, modos,

procedimientos,...) serían claves para obtener una visión global del

paciente o de su problema. En este caso, el criterio de relevancia

prevalece frente al criterio de objetividad. La psicología debe buscar la

comprensión, buscar sentido de la acción humana, en oposición a la

búsqueda de relaciones causales propias de la explicación y de las

ciencias naturales. Esta orientación clínica-cualitativa fuertemente

arraigada con la parte más asistencial y social de la evaluación

psicológica. Las investigaciones en el ámbito cualitativo son

naturalistas, o también denominadas “de campo”, valorándose

fundamentalmente la experiencia clínica del psicólogo encargado de

llevar a cabo la investigación. En cambio, la metodología cuantitativa,

de laboratorio, experimental o psicométrica se origina en contextos

académicos, frente a la subjetividad e irreplicabilidad plantea la

sistematización y estandarización de situaciones y formas de actuar,

planteando un control exhaustivo que ayude a minimizar el error de las

mediciones.

Frente a esto, Peñate (1993,1999) afirma que la evaluación

psicológica en su evolución histórica, no sólo no ha renunciado a su

función asistencial, sino que esta se ha visto enriquecida con los tests.

Esto implica una objetivación y normalización del proceso, propias del

enfoque de laboratorio. Por esto la sitúa más próxima a la metodología

cuantitativa que a la cualitativa.

Tradicionalmente, se ha entendido que lo cualitativo caracterizaba

al mundo clínico y lo cuantitativo a un mundo más “científico”. Esta

conclusión provocó la respuesta de los “clínicos” argumentando que

esta dicotomía era engañosa, provocando la generación de algunas

estrategias del método estadístico para perfeccionar el juicio clínico (Del

Barrio, 1992): creación de criterios diagnósticos consensuados (DSM),

elaboraciones computerizadas de juicios clínicos basados en el MMPI,

entrevistas estructuradas para diagnóstico computerizado, agrupación

de los síntomas en síndromes empíricos utilizando rating scale o

listados sistemáticos de conductas.

Desde el punto de vista de Cronbach (1985), la investigación

cuantitativa queda limitada y empobrecida cuando no se combina con

la cualitativa.

A modo de resumen, Fernández–Ballesteros (1992) elabora

argumentos para justificar el actual uso de métodos cualitativos y

cuantitativos en el diagnóstico psicológico:

1.- La dicotomía entre ambos enfoques es artificial, porque tanto

los datos cuantitativos como los cualitativos son una constante en

nuestro campo. La dicotomía queda superada por la combinación de la

naturaleza de ambos datos con los elementos del proceso diagnóstico

(variables a evaluar, procedimientos de recogida de información,

elaboración e interferencias).

2.- El subjetivismo que se achacaba a la metodología cualitativa

parece no existir realmente, salvo en enfoques determinados como

pueden ser los fenomenológicos-humanistas y los psicodinámicos.

3.- Problemas con el uso de los criterios actuariales de

diagnóstico (dificultades en su uso).

4.- Las mejores metodologías en torno al estudio de caso único

favorecen un mayor rigor experimental junto con un proceso cualitativo.

Resumiendo, quizá la vía para superar estos problemas sea

el abandono de posturas radicales. Esta apertura hacia puntos de vista

metodológicos menos extremos puede resultar difícil, pero a todos

concierne el contribuir a la obtención de modelos potenciadores en el

marco del método científico, que puedan dar cuenta de estas

insuficiencias (Avero, 2000). Es evidente que la evaluación psicológica

emplea datos y métodos cualitativos y cuantitativos, y ambos deben

permitir la replicación diagnóstica por parte de los restantes

evaluadores. Como bien podemos observar, la dicotomía planteada es

más teórica que práctica.

3.1.4.- Ciencia natural frente a social.

Esta es una dicotomía que muchos autores han esbozado. Tal

como sucede con las dicotomías anteriormente planteadas, ésta no

afecta exclusivamente a la evaluación, sino al conjunto de la psicología.

En relación con nuestra disciplina, parece claro que se comporta

fundamentalmente como descriptiva-social, no ajena a una metodología

científico-natural. Esta afirmación parece requerir una explicación. Los

tests son una analogía a los reactivos experimentales del laboratorio.

Por otra parte, las necesidades sociales son responsables de una

apertura hacia elementos más contextuales, sociales, enfatizando los

elementos prácticos (frente a los teóricos) de la disciplina evaluativa.

Todo esto no supone un desinterés por la búsqueda de causas o

relaciones funcionales, pero alejada de motivaciones directamente

intervencionistas (como sucede en la evaluación conductual)

(Pelechano, 1980, 1988).

En cualquier caso, como hemos manifestado reiterativamente en

puntos anteriores, la evaluación no se puede permitir un fuerte control

experimental, no una consideración bivariada de la realidad. Esto

supondría el olvido de las influencias sociohistóricas y contextuales

que, siendo tan importantes, tanto nos ha costado admitir.

3.1.6.- Sintetización.

Concluimos este apartado, con las conclusiones de Peñate (1993,

1999) en torno al método o métodos de la evaluación psicológica.

1.- La evaluación se define mejor como un acercamiento

multimétodo. La existencia hipotética de un único método en el campo

del psicodiagnóstico, no podría explicar los conocimientos en el área, ni

cubriría suficientemente las funciones que a la evaluación se le

encomiendan.

2.- Las diferentes dicotomías descritas no funcionan como tales.

Los supuestos polos de cada dicotomía no son necesariamente

incompatibles entre sí. Se da igualmente una cierta semejanza, que no,

equivalencia, entre algunos métodos. Esto sucede con el nomotético y

correlacional y entre el clínico y el ideográfico.

3.- La evaluación utiliza cualquier procedimiento científico que le

permita obtener sus objetivos.

4.- Los métodos correlacionales y nomotéticos son especialmente

útiles en la evaluación de características estables. La estandarización de

los procedimientos diagnósticos y normativización amparan los

esfuerzos predictivos a la vez que la sitúan como una disciplina natural.

5.- Cuando los elementos a evaluar tienen un menor grado de

consolidación, son más situacionales o específicos; la evaluación con un

sentido claramente utilitario y pragmático recurre a técnicas ipsativas,

ideográficas y al análisis funcional.

6.- De todo lo anterior se concluye que la metodología diagnóstica

debería estar condicionada al grado de consolidación del

comportamiento o contexto. “Qué” y “para qué” evaluar, determina qué

metodología es más coherente utilizar.

Resumiendo, la evaluación es básicamente correlacional, persigue

objetivos ideográficos, se inserta en una ciencia nomotética y se nutre

de sus conocimientos y alternativas metodológicas.

3.2.- Criterios de bondad de los tests y técnica de medida:

fiabilidad, validez y exactitud.

A la hora de seleccionar un instrumento de evaluación concreto,

una de las primeras cuestiones planteadas es si nos sirve para el fin

que le vamos a dar. Cuando hablamos de medida psicológica nos

remitimos casi indefectiblemente a aspectos no directamente

observables (a diferencia de las variables físicas) y en la mayoría de los

casos elementos que carecen de una base física o tangible. En tal caso

el establecimiento de estos dos “simples” criterios se complica

sobremanera. Aquí desarrollaremos con cierta amplitud estos tópicos

por la importancia que poseen, si bien nos limitaremos a la fiabilidad y

la validez en el contexto de la teoría clásica de test.

3.2.1.- Fiabilidad.

Casi de forma intuitiva, se puede decir que un instrumento es

fiable si al efectuar dos mediciones temporalmente distantes con un

mismo grupo de personas, los resultados de ambos pases de pruebas

son iguales o similares (suponiendo que las características de medida

no han sufrido cambios en ese intervalo temporal). La diferencia entre

una y otra medición se debería a errores de medida. La medida real

obtenida en cada momento refleja tanto ese error como la verdadera

magnitud de lo evaluado en el sujeto. Alternativamente, un instrumento

es fiable cuando nos permite detectar, o refleja, las diferencias

individuales existentes. En ambos casos implica que las puntuaciones

que arroja son similares a las que tienen los sujetos en los atributos

medidos (puntuación verdadera).

La fiabilidad conlleva implícita tres términos: error de medida,

puntuación observada y puntuación verdadera. Cuando hablamos de

fiabilidad, el error, desde una perspectiva psicométrica, se refiere al

error aleatorio, no sistemático, no sometido a control y

consecuentemente no predecible. Bajo esta perspectiva, los errores

sistemáticos que se excluyen en el estudio psicométrico de la fiabilidad

son cambios en el atributo medido como consecuencia (Martínez, 1983):

(i) del proceso madurativo del sujeto; (ii) de la intervención o

tratamiento; (iii) las alteraciones en las condiciones del pase de

pruebas; (iv) de las circunstancias personales cambiantes (por ejemplo

el nivel de fatiga en un test de rendimiento). En todos los casos los

errores se introducen por causas ajenas al instrumento de medida. La

teoría clásica de la fiabilidad, es la teoría del error aleatorio (Pelechano,

1988).

Normalmente se habla de fiabilidad, aunque parece que sería más

correcto hablar de fiabilidades ya que no existe una única fiabilidad,

sino diferentes procedimientos para su determinación, teniendo cada

una de ellas una sensibilidad distinta para apresar distintas fuentes de

error (Pelechano, 1988). Básicamente se distingue entre fiabilidad

entendida como consistencia interna, fiabilidad por estabilidad temporal

o test-retest y formas paralelas. En los gráficos siguientes presentamos

de forma esquemática y gráfica algunas características de los tipos de

fiabilidades.

Tipos de coeficientes de fiabilidad

(citada en Pelechano, 1988)

Fiabilidad Tipo (elementos de Estadístico

entendida como comparación) utilizado

Consistencia Homogeneidad (ítem total) Correlación

Interna Equivalencia o dos Spearman-Brown

mitades (escalas

paralelas)

Inter-ítems (ítem) Kuder-Richardson

o Alfa de

Cronbach

Test-Retest Estabilidad temporal Correlación

Fiabilidad interjueces Correlación o

Kappa

Equivalencia Correlación

transtemporal

3.2.1.1.- La fiabilidad como consistencia interna.

Este planteamiento parte de la base de que todos los ítems miden

lo mismo. Los coeficientes de consistencia interna nos informan de sí

esto es verdad o no. Existen tres procedimientos alternativos: el índice

de homogeneidad, el procedimiento de dos mitades o equivalencia y los

que se basan en las comparaciones inter-ítems.

El índice de homogeneidad es el grado de relación entre una parte

(un ítem) y el todo (la escala). Dado que el criterio es la puntuación

total, parece más correcto considerarlo como un indicador de

discriminación que de fiabilidad. Pelechano (1988) comenta que esta

interpretación como fiabilidad debe limitarse a escasas ocasiones, por

ejemplo en los cuestionarios de personalidad. Esta ambigüedad se debe

a que realmente el término homogeneidad se

En el caso de la fiabilidad entendida como equivalencia (o dos

mitades), la lógica es muy similar a la que rige para las escalas

paralelas o la fiabilidad test-retest. Si aplicamos una prueba y

distribuimos sus ítems en dos escalas, la relación entre ellas debería ser

elevada. En caso contrario, las escalas miden atributos diferentes. Sin

embargo, esta lógica presentó sus problemas. La fiabilidad puede ser

distinta para cada una de las posibles escalas paralelas diferentes, no

sabiendo cuál es el estimado más eficaz. Además, las escalas pueden

distar mucho de ser realmente paralelas.

Con independencia de estas consideraciones, al reducir el número

de ítems de la prueba (hacer dos escalas) disminuye su fiabilidad por lo

que más que la correlación es recomendable la formula de Spearman-

Brown.

Al igual que todos los procedimientos de consistencia interna, la

fiabilidad de dos mitades nos informa del grado de representatividad de

la muestra de ítems seleccionados.

El tercer procedimiento, que es el habitualmente más empleado,

se recoge en el Coeficiente Alfa de Cronbach o en la fórmula de Kuder-

Richardson, dependiendo de que se trate de respuestas con más de dos

opciones o respuestas dicotómicas, respectivamente.

Conceptualmente son una estimación de la proporción de

varianza que se puede atribuir a todos los factores comunes a todos los

ítems. Esta consideración habla por sí sola de homogeneidad y justifica

la práctica de sumar la puntuación de los ítems. Pese a esto,

normalmente se confunde unidimensionalidad con alta consistencia

interna. Esta confusión no se justifica si tenemos en cuenta que la

consistencia interna no dice nada sobre cómo se relacionan las

variables entre sí, simplemente informan sobre el grado de relación, no

de su estructura.

Si relacionamos este índice con el anterior, sus ventajas son

claras. Frente al inconveniente de múltiples escalas paralelas y

fiabilidades, alfa aporta una única estimación equivalente a la fiabilidad

media que obtendríamos de dividir el test en todas sus posibles dos

mitades. Además, al basarse en un análisis inter-ítem informa tanto de

la homogeneidad como de la equivalencia. Las virtudes de este

procedimiento explican que se haya convertido en un control de calidad

cada vez más utilizado y cada vez menos cuestionado. Las críticas

recibidas, más parecen fruto de malas interpretaciones y usos que por

sus propiedades intrínsecas.

Teóricamente el valor del alfa de Cronbach depende también: (i)

de la homogeneidad de la muestra (muestras muy homogéneas

favorecen coeficientes de fiabilidad bajos); (ii) del número de ítems (a

mayor número de ítems, mayor valor de alfa); (iii) de la cuantía de las

correlaciones (a mayor cuantía, mayor fiabilidad) y (iv) del nivel de

consolidación de la conducta.

Hagamos una última reflexión con respecto a la fiabilidad

entendida como consistencia interna. Cuando nos referimos a

consistencia interna, la noción de validez cobra realidad, como si entre

ambas existieran relaciones estrechas. Por ejemplo, anteriormente

citamos el coeficiente de discriminación relacionándolo con la

homogeneidad. El coeficiente de discriminación es un criterio de validez,

de hecho nos indica en qué medida el ítem en cuestión es válido para

evaluar lo que evalúan los restantes.

No debemos terminar sin recordar que la consistencia interna

tiene sentido si, y sólo si, se supone covariación entre los elementos de

una prueba, o si una vez encontrada una alta fiabilidad la covariación

empírica tiene sentido.

3.2.1.2.- La fiabilidad por estabilidad: la fiabilidad test-retest.

La fiabilidad test-retest parte de un supuesto simple: la

estabilidad de la conducta. Asumiendo esta premisa, dos mediciones

repetidas con un mismo instrumento deben arrojar puntuaciones

similares. Se parte por tanto del concepto de estabilidad de la medida.

Esta visión es simplista pero útil cuando se cumplen los supuestos de

partida: la reiterada estabilidad comportamental. Sin embargo, no

dejamos de recordar que la psicometría y su teoría clásica de la

fiabilidad tratan del control del error aleatorio.

Pelechano (1988) incluye dentro de la fiabilidad test-retest, la

fiabilidad de los jueces calificadores o fiabilidad interjueces. Bakeman y

Guttman (1986) hablan de entenderlas como pruebas paralelas,

entendidas no exactamente como tales, sino como pruebas

equivalentes, dado que la información que nos facilitan representa el

grado de concordancia o equivalencia de los informadores. Que dos

jueces califiquen simultáneamente la conducta del sujeto (se requiere

“un solo pase de pruebas”) o que ambos calificadores pasen la misma

prueba a la misma persona, sin apenas intervalo temporal (“dos pases

de pruebas”). Esta segunda opción, en la actualidad se presenta como

sin sentido o al menos es problemática. Podemos encontrar cambios en

la conducta de la persona evaluada (motivadas por la fatiga,

motivaciones...) con variaciones en el procedimiento de administración,

variables propias del calificador, o variables de relación sujeto-

evaluador que dificulten la comparación entre ambos calificadores.

Salvo en casos muy justificados, parece más conveniente recurrir a

técnicas de grabación.

Si lo que hacemos es plantearnos la fiabilidad test-retest

entendida como estabilidad temporal, también encontramos problemas.

Desde la visión conductual, pero no exclusivamente desde ella, se ha

criticado esta forma de entender la fiabilidad ya que no parte del

supuesto de la estabilidad, sino de la especificidad. Sobre este punto,

Pelechano en su modelo deja claro que hay diferentes grados de

consolidación-estabilidad de la conducta.

Los coeficientes de estabilidad no prejuzgan la fiabilidad,

simplemente la cuantifican. En esta línea, una baja fiabilidad test-retest

no implica un instrumento no fiable sino que junto a esta alternativa

existe la posibilidad de que evaluemos una conducta inestable. Silva

(1989) plantea que es preciso diferenciar entre la estabilidad como

propiedad del instrumento de medida y estabilidad como propiedad de

la conducta. Por tanto, la puntuación más fiable no será la más

consistente y estable, sino la que refleje la consistencia y estabilidad

comportamental. Los distintos autores coinciden en que es necesario

comprobar que la baja fiabilidad test-retest se debe en efecto a la

inestabilidad conductual. Recomiendan una evaluación multimétodo

como una forma de separar la varianza error de la real y sugieren para

ello combinar procedimientos de fiabilidad test-retest con los de validez

criterial.

3.2.1.3.- Formas paralelas.

La similitud entre las formas paralelas y la fiabilidad test-retest es

evidente. Básicamente, el procedimiento, la lógica de análisis y los

requisitos de una y otra vía son la misma. Sus inconvenientes parecen

superar con mucho las ventajas de la administración de pruebas

paralelas. El propio concepto de pruebas paralelas es, en sentido

estricto, muy restrictivo, por lo que su aplicabilidad práctica es bastante

reducida. Este mismo requerimiento es el que diferenciaría a las formas

paralelas de la test-retest.

La equivalencia temporal reúne los problemas achacables a la

test-retest (estabilidad temporal) y a los propios de las pruebas

paralelas. Sin embargo, la conveniencia de disponer de este tipo de

pruebas es especialmente importante para la evaluación conductual,

donde la medición reiterada de las variables de interés es práctica

común. En el trabajo de Ahava, Iannove, Grebstein y Schirling (1998),

se recogen muy bien los problemas que se plantean por la medición

reiterada y la ausencia de pruebas paralelas. En este trabajo se observó

la disminución del 40% en la puntuación del BDI cuando se aplicó

semanalmente durante ocho semanas, en una muestra de estudiantes,

sin trastorno depresivo y sin que mediara intervención alguna. Este

resultado puede replicarse y generalizarse a otras pruebas, la validez de

éstas para medir el cambio es cuestionable.

En resumen, existen distintos procedimientos para determinar la

fiabilidad de una prueba. La correcta selección e interpretación de la

más adecuada para cada caso no es una cuestión anodina, tampoco lo

es obviar los supuestos subyacentes a cada uno de ellos. La utilidad de

una prueba no es en absoluto independiente del grado de error que

conlleva, pero no es admisible emplear una prueba de la cual no

conocemos la magnitud del error.

3.2.2.- Validez

El concepto de validez, pese a su importancia y su difusión, no es,

ni mucho menos, fácil de definir. En la literatura al respecto podemos

encontrar hasta ¡más de 40! denominaciones de distintos tipos de

validez (Brown, 1972). En los últimos 40 años la definición ha

experimentado múltiples e importantes cambios (Angoff, 1988). Como

producto de esta polémica Nunnally (1973) considera que la validez

tiene un significado excesivo y demanda una distinción clara de sus

significados. Poco después, Cronbach (1972) denuncia esta situación

con un trabajo al que titula de forma significativa: “La validez libertad

condicional”. En opinión de Cattell (1965) buena parte de la

responsabilidad de esta situación la tiene la APA (donde el presidente de

la comisión era Cronbach y también participaba Meehl), al fijar

demasiado pronto el concepto y sus “tipos”. Recuerda que la primera

versión que data de 1954, se basó más en el juicio de expertos y el

consenso que en un esquema teórico coherente.

Intentando tener una visión de conjunto adecuada del concepto

de validez, y apoyándonos en el trabajo de Morales (1988), realizaremos

una breve revisión histórica a la evolución del propio concepto. Tras

esta perspectiva, nos ocuparemos de los diferentes “tipos” de validez.

3.2.2.2.- Tipos clásicos de validez.

3.2.2.2.1.- Validez de contenido.

Se refiere al grado en que el contenido de un test supone una

muestra relevante y representativa de los elementos de un dominio o

constructo a evaluar. Esta definición según Martínez (1983) ha

cambiado en función del paradigma dominante en psicología. Así, por

ejemplo, la definición del APA en 1985 era: “por validez se entiende el

grado en que los procesos empleados por los sujetos para llegar a la

respuesta son típicos de los procesos subyacentes a las respuestas del

dominio”.

Si nos referimos al uso, la validez de contenido ha sido

especialmente importante en las pruebas racionales, en las de

rendimiento y en las conductuales. Pero este tipo de validez no está

exento de presentar problemas:

(i) No existe un dominio o constructo universalmente aceptado, lo

que supone una implicación grave para el requisito de representatividad

y el de relevancia. Por lo que se refiere a la representatividad, si el

universo no está claro, siempre será una cuestión abierta. Con respecto

a la relevancia, es difícil llevar a cabo una selección ponderada de las

características esenciales del universo de interés. Por esto hay que tener

presente el uso que se le va a dar para seleccionar-ponderar los

indicadores. En todo caso es preciso un análisis de las dimensiones,

facetas y objetos básicos.

(ii) No hay un consenso en considerar la validez de contenido

como tal. Lo que se valida a partir de procedimientos de juicios de

expertos es la representatividad-relevancia de los contenidos. Lo que es

lo mismo, no es correcto considerar el contenido de los ítems como

elemento único o de las interpretaciones o significados (Morales, 1988).

(iii) La validez de contenido de una prueba es sensible a los

cambios conceptuales en el significado del constructo.

(iv) Por último, dado que constructo y contenido son elementos

muy relacionados, resulta difícil separar la validación de contenido de la

de constructo.

3.2.2.2.2.- Validez criterial.

Hablaremos aquí indistintamente de validez concurrente y validez

predictiva puesto que procedimentalmente ambas son similares. Se

recurre a la contrastación de la covariación entre dos variables, siendo

una de ellas el criterio y otra la variable objeto de estudio. La validez

criterial puede definirse como: “el grado en que las puntuaciones en

una variable, usualmente un predictor, pueden utilizarse para inferir el

rendimiento en una variable diferente y operacionalmente

independiente llamada criterio” (Guión, 1974, citado en Silva, 1989,

pag.288).

Realicemos dos comentarios acerca de la indistinción entre

validez concurrente y validez predictiva. En primer lugar, el término

“predicción” tal y como es usado en esta definición debe entenderse en

su sentido metodológico, o sea, covariación. Se refiere, por tanto, a

predicción, paradicción o postdicción (Silva, 1989). La APA (1985, 1988)

para evitar la confusión que el concepto “predicción” implica, distingue

entre validez predictiva y validez concurrente. La diferencia

fundamental, no procedimental, entre una y otra reside en cuál es el

uso que le vamos a dar. En relación con cuestiones diagnósticas o la

conducta actual, la evidencia concurrente es la deseable, en tanto que

si la inferencia es predictiva, la validez predictiva es la alternativa a

elegir. También debemos tener en cuenta que si bien

procedimentalmente son similares, no justifica el uso de evidencias de

validez concurrente para fines predictivos o postdictivos (Nunnally y

Bernstein, 1994; Pelechano, 1988).

Este tipo de consideraciones sirve para hacer notar la necesidad

de que las evidencias criteriales tengan una base teórica sólida. Si son

fruto de un empirismo ciego, sin ningún soporte teórico, su capacidad

de generalización es cuestionable pudiendo desvanecerse en nuevas

condiciones (Anastasi, 1967). Esta reflexión sitúa de nuevo a la validez

criterial como un elemento más de validez de constructo y la enriquece.

Siguiendo el planteamiento de Pelechano (1988) y a modo de

conclusión, comentaremos brevemente los tipos de diseño y algunos

problemas relacionados con la validez criterial. Con respecto a la validez

concurrente se utilizan: grupos criterio, criterio de experto,

correlaciones con otros tests y rendimiento académico. En referencia

con los problemas podemos citar: sesgos en el criterio, empleo de

criterios únicos o múltiples, ausencia de validación de constructo de los

criterios, comportamiento diferencial del criterio frente a ciertos

grupos, y problemas en la estimación de los coeficientes de validez (falta

de fiabilidad del predictor y el criterio, restricciones en el rango,

dicotomización en el criterio, predictor o ambos).

3.2.2.2.3.- Validación de constructo.

Partimos de la idea de que el constructo es un concepto

unificador, ya que este concepto y su validez ha estado presente en todo

momento. Pero para su exposición optaremos por dos planteamientos.

Uno sintetizador, recurriendo a las conclusiones del profesor Silva

(1989) y otro más critico planteado por el profesor Pelechano (1988),

donde se cuestiona el reduccionismo implícito en el concepto de validez

de constructo. Esta dualidad no será un obstáculo para presentar

algunos aspectos ajenos a los autores anteriormente citados,

especialmente cuando hablamos de los métodos en la validez de

constructo. Como punto de partida, comencemos por definir lo que es

un constructo. Según Cronbach y Meehl (1955, citado por Pelechano,

1988), las características de un constructo psicológico son:

(i) Se trata de un atributo hipotetizado que se refleja en las

puntuaciones de un test que, supuestamente, lo evalúa.

(ii) Tiene propiedades predictivas y operacionales. Tiene en

consecuencia poder directivo sobre la conducta.

(iii) Su significación última se sitúa en la red de relaciones que

establece con otros conceptos científicos.

Partiendo de estos y otros principios nos remitimos a los

planteamientos de Silva (1989, pag.165 y 166):

(i) “El constructo es un sinónimo de concepto científico y validez

de constructo, de validez conceptual o grado de adecuación de las

inferencias conductuales o teóricas que se hacen a partir de los datos

de evaluación”. Esta posición no supone una reificación.

(ii) “Los constructos no deben ser considerados como algo

estático”. El propio proceso de interpretación-desarrollo desmiente esta

postura. El mismo constructo puede conceptualizarse como un proceso,

pese a la relación que mantiene con determinadas técnicas de análisis

(por ejemplo, el análisis factorial).

(iii) “Los constructos aparecen relacionados generalmente de

forma probabilística con indicadores observables y con otros

constructos constituyendo “redes nomológicas”. Es ahí donde un

constructo toma significado y utilidad práctica y conceptual. Sin dicha

red, el constructo es un elemento muerto o por gestar.

(iv) Una forma de explorar esta red es a través de la propuesta de

Campbell y Fiske (1959). Refiriéndonos a la determinación de la validez

convergente y discriminante a través de las matrices multirasgo-

multimétodo.

(v) “Toda validación de constructo se refiere tanto al concepto

como al método implicado. Es conveniente que un constructo sea

medido por más de un instrumento de evaluación”.

(vi) “El estatus de los constructos en el sistema científico puede

resumirse de la siguiente manera: 1.- tanto los constructos, como la

validez de constructo, están ineludiblemente ligados a la evidencia

empírica. 2.- Un constructo no se reduce a sus referentes empíricos;

conserva siempre un “excedente” de significación. 3.- El constructo

posee un estatus fundamentalmente epistemológico. Es un medio de

conocimiento: no está “detrás” de la conducta sino “delante” de ella,

entre la conducta y el científico que la estudia. 4.- Los constructos no

se proponen sólo con fines especulativos, sino para potenciar la

predicción. 5.- El valor de un constructo se juzga por su utilidad”.

(vii) La validez de constructo engloba y unifica a la criterial y de

contenido. La validez de constructo y la validez de contenido se

confunden.

(viii) “No existe límite alguno en cuanto a las estrategias,

procedimientos o instrumentos potencialmente útiles en una validez de

constructo”.

(ix) El proceso de validez de constructo es un proceso infinito que

no se expresa a través de un único coeficiente de validez. Supone una

acumulación de evidencia.

(x) “La validez de constructo consiste esencialmente en la

aplicación del proceso de formulación y contrastación de hipótesis

científicas al campo de la evaluación psicológica. No es, sin embargo,

conveniente exigirle el grado de formalización que se exige en ciencias

más desarrolladas o a la investigación básica no presionada por

requerimientos prácticos”.

Pelechano (1988, pag.257), por el contrario, no se muestra de

acuerdo con que se “haya intentado reducir todo el modelo testológico

clásico a validez de constructo y a ésta a la multiplicidad de tareas que

cumple la ciencia”. En su opinión supone un reduccionismo

metodológico y conceptual. Significa un abandono de la metodología

deductiva a favor de la deductiva-experimental. La validez de constructo

sirve fundamentalmente para atribuir significado a los rasgos, procesos

o dimensiones psicológicas. Además, el reduccionismo conceptual lo

encontramos cuando equipara constructo a rasgos, estos a su acepción

más tradicional, para acabar asumiendo la psicología como estudio de

los rasgos. Este reduccionismo parece insostenible.

3.2.2.3.- Otras consideraciones y limitaciones acerca de la validez.

Sintetizando con respecto al concepto de validez, Silva (1989)

concluye:

1.- El concepto actual de validez es fiel a su concepción

tradicional: expresa aquello que pretende medir.

2.- Se refiere a las inferencias que hacemos de las puntuaciones

de un instrumento en relación con las circunstancias en que se han

obtenido.

3.- Se validan las interpretaciones, no el instrumento.

4.- No se puede reducir a un valor numérico o a un coeficiente. Se

trata de una estimación inferida de un conjunto amplio de datos.

5.- La validación es un proceso infinito. Todo dato, procedimiento

o información aporta significación. El proceso de validación se identifica

con el proceso de construcción y depuración de hipótesis.

3.3.- Teoría de la generalizabilidad.

Esta teoría de Cronbach, Gleser, Nanda y Rajaratman (1972)

representa una nueva concepción en la naturaleza de la medida, que

supone un cambio en las formas tradicionales de entender los

problemas acerca de la fiabilidad y la validez.

La teoría de la generalizabilidad prescinde del concepto de

puntuación verdadera para sustituirlo por el de puntuación universo.

Exactamente lo mismo ocurre con el concepto de pruebas paralelas,

introduciéndose escalas aleatoriamente paralelas. Estos supuestos son

menos restrictivos que los de Spearman y permiten articular un modelo

en el que fiabilidad y validez se conceptualizan en función del grado en

que las puntuaciones obtenidas en un instrumento de medida pueden

generalizarse a distintos ámbitos o universos de generalización. Se

propone la ordenación de los diferentes tipos de fiabilidad y validez en

un continuo de generalizabilidad. En palabras de Fiske (1973, citado

por Silva, 1989, pag.172): “la fiabilidad se refiere a la generalización

más allá del test, hacia un criterio concreto o hacia un constructo”.

La cuestión básica según la teoría de la generalizabilidad, no es si una

prueba es o no fiable o válida, sino hasta qué punto las puntuaciones

obtenidas pueden generalizarse a otras observaciones o universos.

Cronbach y cols. (1972) resumen los universos de generalización

en dos:

1.- Universo de personas. Refiriéndose a la generalización de la

muestra a la población.

2.- Universo de condiciones. Se hace mención a un amplio

repertorio de condiciones tales como los ítems del test, las distintas

formas de éste, los diferentes estímulos, observadores, situaciones, etc.

Cada una de estas condiciones nos remitirá a universos de

generalización distintos.

Pero además de esta conceptualización original, también parece

importante recoger el planteamiento de Cone (1976), que propone seis

universos posibles para efectuar la generalización:

1.- Universo de generalización de las puntuaciones. Se refiere a la

pregunta: ¿en qué grado los datos obtenidos por un observador son

generalizables a los obtenidos por otros?. Parece obvio su relación con

la teoría de la fiabilidad interjueces.

2.- Universo de generalización de los elementos. Indica en qué

medida los ítems de un instrumento son una muestra representativa

del universo de interés. Se relaciona con la validez de contenido y la

consistencia interna.

3.- Universo de generalización temporal. ¿Cuál es el grado en que

los datos obtenidos en un momento determinado son inferibles a otros

momentos?. Su equivalente sería la fiabilidad test-retest.

4.- El universo de generalización situacional hace referencia a sí

las puntuaciones obtenidas en una situación son generalizables a otras

distintas ajenas a aquellas en las que fueron obtenidas. Nos

enfrentamos a la validez ecológica.

5.- Universo de generalización de los métodos. Se refiere al grado

en que las puntuaciones obtenidas con un método de evaluación, son

generalizables a las obtenidas con otros que evalúan el mismo

contenido. Su análogo en la teoría de las pruebas paralelas sería la

validez convergente.

6.- El universo de generalización de las dimensiones está

relacionado con la validez de constructo. Específicamente nos remite a

en qué medida las estimaciones de una conducta son generalizables a

otras conductas.

Partiendo del planteamiento anterior parece que no existe un

universo de generalización ideal, sino que éste depende del investigador

que debe decidir cual es el adecuado en función de sus objetivos

concretos.

El recurso estadístico que casi invariablemente utiliza este modelo

es el análisis de varianza y además en esta aproximación se distinguen

dos tipos de estudios diferentes (Martínez, 1983):

1.- Estudios G o de generalizabilidad. Pretenden analizar las

características del instrumento o condiciones de medición con las

fuentes de variabilidad de interés que pueden incidir sobre el proceso de

medida. Es adecuado en las fases de elaboración de la instrumentación.

2.- Estudios D o de decisión, cuya finalidad es la recogida de

datos para la toma de decisiones basadas en los datos del instrumento

de medida. Estos estudios utilizan las informaciones de los estudios G

para diseñar la mejor aplicación posible del instrumento de medida

para un fin determinado. Los estudios G permiten, en este caso,

determinar qué fuentes de variación controlar (atendiendo a su

magnitud y significado), lo que se traduciría en un aumento de la

fiabilidad.

La aplicación de esta teoría a la evaluación conductual (así como

a los tests orientados al criterio) es importante si tenemos en cuenta el

énfasis de ambos acercamientos en la validez de contenido.

Por lo demás, la conceptualización de la fiabilidad y la validez

dentro de un continuo de generalizabilidad afecta directamente a la

evaluación tradicional, la conductual y la criterial.

Referencias Bibliográficas

Ahava, Iannove, Grebstein y Schirling (1998). Is the BDI reliable

over time? An evaluation of multiple test-retest reliability in

nonclinical college student sample. Journal of Personality

Assessment, 70(2), 222-231.

Angoff, W.H. (1988). Validity: an envolving concept. En H. Waimer

y H. Braun (eds.): Test validity. Hillsdate, Nueva York: Lawrence

Erlbaum.

APA (1985). Standards for Educational and Psychological Tests.

Washington D.C.: APA.

APA (1988). Standards for educational and psychological tests.

Washington D.C.: APA.

Arnau, J. (1997). Model general d’investigació psicológica.

Barcelona: Universitat Oberta de Catalunya.

Avero, P. (2000). Tratamientos psicológicos: técnicas cognitivo-

conductuales. Proyecto Docente de Titularidad no publicado.

Universidad de La Laguna (La Laguna).

Baker, F.B. (1989). Computer technology in test construction and

processing. En R.L. Linn (Ed.): Educational measurement (3ªed.).

New York: American Council on Education/McMillan.

Buela-Casal, G. (1997). Método científico y evaluación psicológica.

En G. Buela-Casal y J.C. Sierra (Eds.): Manual de evaluación

psicológica. Fundamentos, técnicas y aplicaciones. Madrid: Siglo

XXI.

Campbell, D. y Fiske, D. (1959). Convergent and discriminant

validation by the multitrait-multimethod matrix. Psychological

Bulletin, 56, 81-105.

Campbell, D. y Stanley, D. (1966). Experimental and

Quasiexperimental designs for research. Chicago: Rand McNally.

Cattell, R.B. (1965). The scientific analysis of personality.

Baltimore: Md. Penguin.

Cone, J.D. (1976). Multitrait-multimethod matrices in behavioral

assessment. American Psychological Association.

Cook, T.D. y Reichard, C.S. (1986). Métodos cuantitativos y

cualitativos en investigación evaluativa. Madrid: Morata.

Cronbach, L.J. (1957). The two disciplines of scientific

psychology. American Psychology, 12, 584-671.

Cronbach, L.J. (1972). Fundamentos de la exploración psicológica.

Madrid: Biblioteca Nueva.

Cronbach, L.J. (1985). Fundamentos de la exploración psicológica

(3ª ed.). Madrid: Biblioteca Nueva.

Cronbach, l.J. y Meehl, P. (1955). Construct validity in

psichological tests. Psychological Bulletin, 52, 281-302.

Cronbach, L.J., Gleser, G., Nanda, H. y Rajaratnam, N. (1972).

The dependability of behavioral measurement: Theory of

generalizability of scores and profiles. Nueva York: Wiley.

Del Barrio, M.V. (1992). Evaluación de las características

psicopatológicas. En R. Fernández-Ballesteros (Ed.): Introducción

a la evaluación psicológica. Tomo II. Madrid: Pirámide.

Fernández-Ballesteros, R. (1980). Psicodiagnóstico. Concepto y

metodología. Madrid: Cincel-Kapelusz.

Fernández-Ballesteros, R. (1983). Psicodiagnóstico. Madrid:

UNED.

Fernández-Ballesteros, R. (1992). Introducción a la evaluación

psicológica (vol I y II). Madrid: Pirámide.

Martínez, A. (1983). Principios psicométricos en evaluación

conductual. En R. Fernández-Ballesteros y J.A.I. Carrobles (eds.):

Evaluación conductual. Madrid: Pirámide.

Morales, P. (1988). Medición de aptitudes en psicología y

educación. Navarra.

Nunnally, J.C. (1973). Introducción a la medición en Psicología.

Buenos Aires: Paidós.

Nunnally, J.C. y Bernstein, I.H. (1994). Psychometric theory

(3ªed.). New York: McGraw-Hill.

Pelechano, V. (1980). Terapia familiar comunitaria. Madrid: UNED.

Pelechano, V. (1982). Una nota sobre interacción: Cronbach a

través del espejo. En J. Seoane (Ed.): Teoría y método en

psicología experimental. Valencia: Alfaplus.

Pelechano, V. (1988). Del psicodiagnóstico clásico al análisis

ecopsicológico (vols. I y II). Valencia: Alfaplus.

Peñate, W. (1993). Memoria de oposición a titularidad. Sin

publicar. Universidad de La Laguna. Tenerife.

Peñate, W. (1999). Memoria de oposición a cátedra. Sin publicar.

Universidad de La Laguna. Tenerife.

Pereda, S. (1987). Psicología experimental I. Metodología. Madrid:

Pirámide.

Pervin, L.A. (1978). Personalidad. Bilbao: Desclée ded Brouwer.

Pervin, L.A. (1979). Personalidad. Teoría, diagnóstico e

investigación. Bilbao: Desclée de Brouwer.

Silva, F. (1982).Introducción al psicodiagnóstico. Valencia:

Promolibro.

Silva, F. (1989). Evaluación conductual y criterios psicométricos.

Madrid: Pirámide.

También podría gustarte

- Métodos de Investigación en Psicología ClínicaDocumento5 páginasMétodos de Investigación en Psicología Clínicazarias2006Aún no hay calificaciones

- Investigación Documental de Las Teorías Motivacionales.Documento4 páginasInvestigación Documental de Las Teorías Motivacionales.Jesús Rojas LaraAún no hay calificaciones

- Representaciones culturales de las sexualidadesDocumento9 páginasRepresentaciones culturales de las sexualidadesJuanainesdelacruzAún no hay calificaciones

- resumen tema 4Documento11 páginasresumen tema 4Claudia DubonAún no hay calificaciones

- Métodos de Investigación en Psicopatología N PDFDocumento8 páginasMétodos de Investigación en Psicopatología N PDFisabel mirandaAún no hay calificaciones

- Diseños de Investigación de Psicología ExperimentalDocumento22 páginasDiseños de Investigación de Psicología ExperimentalEmir MoraAún no hay calificaciones

- ENCUESTASDocumento236 páginasENCUESTASAlba TAún no hay calificaciones

- Nivel ClínicoDocumento8 páginasNivel ClínicoThalía BasanteAún no hay calificaciones

- Historia de La PsicologíaDocumento4 páginasHistoria de La PsicologíaJonathan Vera veraAún no hay calificaciones

- Resumen Cap 3Documento28 páginasResumen Cap 3Keyla Ventura AcostaAún no hay calificaciones

- Psicología DiferencialDocumento10 páginasPsicología DiferencialMARLIN MANCEBO MORETAAún no hay calificaciones

- Contenidos 1. 1. 1. 2. 2. 3. 4. 1. 2. 5. 1. 2.: 04. Métodos de Investigación en El Estudio de Diferencias IndividualesDocumento11 páginasContenidos 1. 1. 1. 2. 2. 3. 4. 1. 2. 5. 1. 2.: 04. Métodos de Investigación en El Estudio de Diferencias IndividualesjoseAún no hay calificaciones

- 2.psicometría, Algunas Teorías de La InteligenciaDocumento35 páginas2.psicometría, Algunas Teorías de La InteligenciaJuan RosadoAún no hay calificaciones

- Libro Unit 3, Psic. DiferencialDocumento26 páginasLibro Unit 3, Psic. DiferencialCheca Valdez RiveraAún no hay calificaciones

- Análisis de Aproximaciones Metodológicas Empleadas en El Campo de La Investigación en Psicología de La Salud PDFDocumento9 páginasAnálisis de Aproximaciones Metodológicas Empleadas en El Campo de La Investigación en Psicología de La Salud PDFXilenaRopainMontenegroAún no hay calificaciones

- PGeneral VImpresionDocumento25 páginasPGeneral VImpresionanaAún no hay calificaciones

- Trabajo Práctico #1Documento3 páginasTrabajo Práctico #1De Los Angeles LopezAún no hay calificaciones

- Métodos de La Psicología DiferencialDocumento10 páginasMétodos de La Psicología DiferencialKal-El Kandor100% (1)

- Unid1 - Act1.1 - Jose Manuel Ortiz VasquezDocumento4 páginasUnid1 - Act1.1 - Jose Manuel Ortiz Vasquezjose manuelAún no hay calificaciones

- Las Llamadas Técnicas ProyectivasDocumento9 páginasLas Llamadas Técnicas ProyectivasMontserrat Lopez CastroAún no hay calificaciones

- DocumentoDocumento22 páginasDocumentoMarzuq Herrera100% (2)

- DD - Ii Tema 4Documento9 páginasDD - Ii Tema 4RaquelAún no hay calificaciones

- Psicometria IDocumento11 páginasPsicometria IkiomaraAún no hay calificaciones

- Estrategias de Investigación en Psicología de La PersonalidadDocumento3 páginasEstrategias de Investigación en Psicología de La PersonalidadPsicopedagógicoFavaAún no hay calificaciones

- Pers T3Documento5 páginasPers T3PepepotamoAún no hay calificaciones

- Métodos de La Psicología DiferencialDocumento19 páginasMétodos de La Psicología DiferencialAsledy TorresAún no hay calificaciones

- Capitulo 3 ERMI MARTINEZ Ensayo Metodos de InvestigacionDocumento4 páginasCapitulo 3 ERMI MARTINEZ Ensayo Metodos de Investigacionermi.lia29Aún no hay calificaciones

- Tecnicas Proyectivas IntroDocumento6 páginasTecnicas Proyectivas Intromaria_del_carmen_eAún no hay calificaciones

- LA EVALUACIÓN PSICOLÓGICA. La Importancia Sobre EL USO DE CONCEPTOSDocumento6 páginasLA EVALUACIÓN PSICOLÓGICA. La Importancia Sobre EL USO DE CONCEPTOSMIAAún no hay calificaciones

- PD Unidad Ii Ashly DDocumento7 páginasPD Unidad Ii Ashly DAshly Duarte PayanoAún no hay calificaciones

- Metodos de Investigacion PsicopatologiaDocumento15 páginasMetodos de Investigacion PsicopatologiaGarcia SobeidaAún no hay calificaciones

- Resumen Diferencial.Documento5 páginasResumen Diferencial.CarlosStevenAún no hay calificaciones

- Metodología Empleada en PsicologíaDocumento5 páginasMetodología Empleada en PsicologíaDayana TiconaAún no hay calificaciones

- SintesisDocumento9 páginasSintesisJose David Matos GonzalezAún no hay calificaciones

- Documento (1) (2)Documento6 páginasDocumento (1) (2)Sharlin PeñaAún no hay calificaciones

- Métodos de Investigación en Psicopatología. Psicología Clínica. Universidad Autónoma de Santo Domingo.Documento2 páginasMétodos de Investigación en Psicopatología. Psicología Clínica. Universidad Autónoma de Santo Domingo.Juan BakesAún no hay calificaciones

- Metodología de La Investigación I PARCIALDocumento29 páginasMetodología de La Investigación I PARCIALNaty100% (1)

- Psicología de La Diversidad - Metodo Experimental y Correlación - 23 - 08 - 22Documento12 páginasPsicología de La Diversidad - Metodo Experimental y Correlación - 23 - 08 - 22María HernándezAún no hay calificaciones

- Bloque 2cap 4 5 y 6Documento28 páginasBloque 2cap 4 5 y 6Gustavo Alejandro Del VecchioAún no hay calificaciones

- 3 Evaluación para El DiagnósticoDocumento57 páginas3 Evaluación para El DiagnósticoMAngel Pascual AlmeidaAún no hay calificaciones

- Las Preparaciones Experimentales en Psicología: ¿Estudio de Procesos o de Procedimientos? - Jorge Borja CastañedaDocumento8 páginasLas Preparaciones Experimentales en Psicología: ¿Estudio de Procesos o de Procedimientos? - Jorge Borja CastañedaGonzalo EsquerAún no hay calificaciones

- Métodos de La Psicología Diferencial 04.06.2018Documento16 páginasMétodos de La Psicología Diferencial 04.06.2018Mario Mario Marroquin MarroquinAún no hay calificaciones

- Aspectos Generales Del Proceso DiagnosticoDocumento6 páginasAspectos Generales Del Proceso DiagnosticodanielitatriAún no hay calificaciones

- Taller de Introduccion A La PsicologiaDocumento5 páginasTaller de Introduccion A La PsicologiaMaria Alejandra ACOSTA VASQUEZAún no hay calificaciones

- Cap5 de Hernandez Fernandez y BaptistaDocumento5 páginasCap5 de Hernandez Fernandez y BaptistaFernanda Mora CasasolaAún no hay calificaciones

- Gálvez Córdova - Jorquera VillagraDocumento6 páginasGálvez Córdova - Jorquera VillagraMatias JorqueraAún no hay calificaciones

- Dos Alternativas Al Análisis Estadístico en Psicología ExperimentalDocumento8 páginasDos Alternativas Al Análisis Estadístico en Psicología ExperimentalgamerhobbistaAún no hay calificaciones

- Teorias de Los Test PsicometriaDocumento7 páginasTeorias de Los Test Psicometrialuisa fernanda lopez cordobaAún no hay calificaciones

- TEMA 4 InvestigaciónDocumento4 páginasTEMA 4 Investigaciónmts244Aún no hay calificaciones

- Metodos de Investigacion para El Estudio Del Comportamiento HumanoDocumento11 páginasMetodos de Investigacion para El Estudio Del Comportamiento HumanoIdan Mendez SotoAún no hay calificaciones

- Psicología Diferencial EnsayoDocumento8 páginasPsicología Diferencial EnsayomarisolAún no hay calificaciones

- Cualitativo Vs Cuantitativo 19 ABRIL 2023Documento2 páginasCualitativo Vs Cuantitativo 19 ABRIL 2023Rober VillesAún no hay calificaciones

- Resumen Metodologia de La Inv en PsicologiaDocumento19 páginasResumen Metodologia de La Inv en PsicologiaaixamedinaAún no hay calificaciones

- La Psicología y El Método CientíficoDocumento11 páginasLa Psicología y El Método CientíficoHenry CermeñoAún no hay calificaciones

- Métodos en psicología de la personalidadDocumento20 páginasMétodos en psicología de la personalidadLaumormar4Aún no hay calificaciones

- Supuestos filosóficos de la investigación científicaDocumento12 páginasSupuestos filosóficos de la investigación científicaSJ MeloAún no hay calificaciones

- Los Paradigmas de La Investigación CientíficaDocumento6 páginasLos Paradigmas de La Investigación CientíficaAxel AtreidesAún no hay calificaciones

- Alcance de La Investigacion - Exploratorio - Descriptivo - Correlacional o ExplicativoDocumento9 páginasAlcance de La Investigacion - Exploratorio - Descriptivo - Correlacional o ExplicativoAlex Fernandez ArenasAún no hay calificaciones

- Trabajo Estadística IIIDocumento43 páginasTrabajo Estadística IIIPedro MoralesAún no hay calificaciones

- Fundamentos I Carpeta FinalDocumento69 páginasFundamentos I Carpeta FinalFlorencia TorreAún no hay calificaciones

- Epistemología y Psicoanálisis Vol. II: Análisis del psicoanálisisDe EverandEpistemología y Psicoanálisis Vol. II: Análisis del psicoanálisisCalificación: 5 de 5 estrellas5/5 (1)

- Diseños de investigación experimental aplicados a la ciencias socialesDe EverandDiseños de investigación experimental aplicados a la ciencias socialesAún no hay calificaciones

- Examen Mix RecopilatorioDocumento21 páginasExamen Mix RecopilatorioMARTA ESTEFANÍA LÓPEZ MARREROAún no hay calificaciones

- Examen Mix RecopilatorioDocumento21 páginasExamen Mix RecopilatorioMARTA ESTEFANÍA LÓPEZ MARREROAún no hay calificaciones

- TEMA 4. Marketing en La RedDocumento35 páginasTEMA 4. Marketing en La RedMARTA ESTEFANÍA LÓPEZ MARREROAún no hay calificaciones

- TEMA 6. Difusià NDocumento38 páginasTEMA 6. Difusià NMARTA ESTEFANÍA LÓPEZ MARREROAún no hay calificaciones

- Actividad 3.2. - CÃ Mo Crear Tu Tienda On LineDocumento1 páginaActividad 3.2. - CÃ Mo Crear Tu Tienda On LineMARTA ESTEFANÍA LÓPEZ MARREROAún no hay calificaciones

- Tema 3Documento13 páginasTema 3MARTA ESTEFANÍA LÓPEZ MARREROAún no hay calificaciones

- Capitulo Iii Etica Ricardo Lucero.Documento2 páginasCapitulo Iii Etica Ricardo Lucero.Ricardo LuceroAún no hay calificaciones

- Filosofía del Arte y sus Grandes PensadoresDocumento4 páginasFilosofía del Arte y sus Grandes PensadoresJosy Chiara OncyAún no hay calificaciones

- Actividades de La Tilde DiacriticaDocumento7 páginasActividades de La Tilde DiacriticaMaribel AlejosAún no hay calificaciones

- Snna Forma 1Documento30 páginasSnna Forma 1Linda RuizAún no hay calificaciones

- EL FACILITADOR COMO COMPAÑERO EXISTENCIAL PorDocumento7 páginasEL FACILITADOR COMO COMPAÑERO EXISTENCIAL PorAlvaro OlivaresAún no hay calificaciones

- ANEXO # 18 TEST B+üSICO DE INTELIGENCIA EMOCIONALDocumento12 páginasANEXO # 18 TEST B+üSICO DE INTELIGENCIA EMOCIONALMely johanna vargas villalbaAún no hay calificaciones

- Teoría de (Henry Fayol) II-A-ECONOMÍADocumento10 páginasTeoría de (Henry Fayol) II-A-ECONOMÍARichard Karl Albino SotoAún no hay calificaciones

- Manual de Reglas Ortograficas Nico QuindtDocumento10 páginasManual de Reglas Ortograficas Nico QuindtCoach Master YLICH TARAZONAAún no hay calificaciones

- Carácter General Del Pensamiento de ProtágorasDocumento5 páginasCarácter General Del Pensamiento de ProtágorasIsrael RodríguezAún no hay calificaciones

- AtarotDocumento202 páginasAtarotElsa Villamil100% (1)

- Primer Trabajo - FilosofiaDocumento2 páginasPrimer Trabajo - FilosofiaVeronica Quispe AsueroAún no hay calificaciones

- Estudio Suplementario Cortesia MilitarDocumento5 páginasEstudio Suplementario Cortesia MilitarMartin QuerevaluAún no hay calificaciones

- Perspectivas Teóricas Sobre La Cultura EscolarDocumento10 páginasPerspectivas Teóricas Sobre La Cultura EscolarJose Guillermo Treviño100% (1)

- El Hecho JurídicoDocumento4 páginasEl Hecho JurídicoFrancisco Jose Lobato CardenasAún no hay calificaciones

- Relaciones saludables y autocentradasDocumento4 páginasRelaciones saludables y autocentradasZaira Rosario Pérez RodríguezAún no hay calificaciones

- Trabajo Libro de PoemasDocumento37 páginasTrabajo Libro de PoemasPaula Bernal SanchezAún no hay calificaciones

- Contenido Perfil de Proyecto de Investigacion Bachiller - TesisDocumento4 páginasContenido Perfil de Proyecto de Investigacion Bachiller - TesisJack EspejoAún no hay calificaciones

- El Dualismo Antropológico de PlatónDocumento14 páginasEl Dualismo Antropológico de PlatónJoaquin ColliardAún no hay calificaciones

- GUILLERMO DE OCKHAM Novella Libro 2008Documento14 páginasGUILLERMO DE OCKHAM Novella Libro 2008JOSE MARTINEZ HERNANDEZAún no hay calificaciones

- Fundamentos relativos de los derechos humanosDocumento2 páginasFundamentos relativos de los derechos humanosJazmin RamirezAún no hay calificaciones

- 08 - 3 - LECTURA - Arquetipos Segun JUNGDocumento5 páginas08 - 3 - LECTURA - Arquetipos Segun JUNGclaudia Patricia RamirezAún no hay calificaciones

- Examenes Seminario de Investigación ADEDocumento27 páginasExamenes Seminario de Investigación ADEDani El crackAún no hay calificaciones

- Propuesta de valor para empresasDocumento5 páginasPropuesta de valor para empresasJuanMa CorralesAún no hay calificaciones

- Presentación de Clase Pensamiento Filosófico de México 619 2021-2022Documento8 páginasPresentación de Clase Pensamiento Filosófico de México 619 2021-2022Zaireth Argelia Hernández GuzmánAún no hay calificaciones

- Actividad Del Módulo 1 PlataformaDocumento3 páginasActividad Del Módulo 1 PlataformaAmarielys PujolsAún no hay calificaciones

- Pedagogía de La LiteraturaDocumento4 páginasPedagogía de La LiteraturaCarmen PinedaAún no hay calificaciones

- 10907-Texto Del Artículo-23660-1-10-20190124Documento14 páginas10907-Texto Del Artículo-23660-1-10-20190124julian corzoAún no hay calificaciones

- Teorías motivacionales empresasDocumento9 páginasTeorías motivacionales empresascerlin vargasAún no hay calificaciones