Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Juicio Critico

Cargado por

Jordin Jesús Chumacero0 calificaciones0% encontró este documento útil (0 votos)

34 vistas4 páginasEste documento discute la validez y confiabilidad de los instrumentos de investigación para la recolección de datos. Explica que la validez se refiere a qué tan bien un instrumento mide lo que pretende medir, mientras que la confiabilidad se refiere a qué tan consistentemente mide. Describe varios métodos para evaluar la validez y confiabilidad como juicios de expertos, pruebas de retesteo, y coeficientes como el Alfa de Cronbach. Resalta la importancia de asegurar que los instrumentos sean válidos

Descripción original:

VALIDEZ Y CONFIABILIDAD DE LOS INSTRUMENTOS DE INVESTIGACIÓN PARA LA RECOLECCIÓN DE DATOS

Título original

Juicio critico

Derechos de autor

© © All Rights Reserved

Formatos disponibles

DOCX, PDF, TXT o lea en línea desde Scribd

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoEste documento discute la validez y confiabilidad de los instrumentos de investigación para la recolección de datos. Explica que la validez se refiere a qué tan bien un instrumento mide lo que pretende medir, mientras que la confiabilidad se refiere a qué tan consistentemente mide. Describe varios métodos para evaluar la validez y confiabilidad como juicios de expertos, pruebas de retesteo, y coeficientes como el Alfa de Cronbach. Resalta la importancia de asegurar que los instrumentos sean válidos

Copyright:

© All Rights Reserved

Formatos disponibles

Descargue como DOCX, PDF, TXT o lea en línea desde Scribd

0 calificaciones0% encontró este documento útil (0 votos)

34 vistas4 páginasJuicio Critico

Cargado por

Jordin Jesús ChumaceroEste documento discute la validez y confiabilidad de los instrumentos de investigación para la recolección de datos. Explica que la validez se refiere a qué tan bien un instrumento mide lo que pretende medir, mientras que la confiabilidad se refiere a qué tan consistentemente mide. Describe varios métodos para evaluar la validez y confiabilidad como juicios de expertos, pruebas de retesteo, y coeficientes como el Alfa de Cronbach. Resalta la importancia de asegurar que los instrumentos sean válidos

Copyright:

© All Rights Reserved

Formatos disponibles

Descargue como DOCX, PDF, TXT o lea en línea desde Scribd

Está en la página 1de 4

JUICIO CRITICO ACERCA DEL TEMA VALIDEZ YCONFIABILIDAD DE LOS

INSTRUMENTOS DE INVESTIGACIÓN PARA LA RECOLECCIÓN DE DATOS

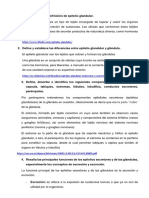

La validez

En cuanto a la validez siempre considera la pregunta ¿con qué fidelidad

corresponde el universo o población al atributo que se va a medir? Y así obtener la

variedad de instrumentos que consiste en la medición de autenticidad según,

algunos procedimientos a emplear son: Know groups (preguntar a grupos

conocidos), Predictive validity (comprobar comportamiento) y Cross-check-

questions (contrastar datos previos).

Para tener una ciencia cierta se debe conocer los rasgos o característica que se

denomina variable criterio.

El análisis del instrumento se hace en gran parte en términos de su contenido. Los

investigadores deben elaborar una serie de ítems, acordes con las variables

empleadas y sus respectivas dimensiones. Luego de la selección de los ítems más

adecuados para el proyecto,

Se debe que tener en cuenta que, la validez de contenido no puede expresarse

cuantitativamente, se estima de manera subjetiva o intersubjetiva empleando,

usualmente, el denominado Juicio de Expertos.

Método de Agregados Individuales: en este método el investigador da una

estimación directa de los ítems del instrumento, este método es mas económico

ya que no exige que se reúna a los expertos en un lugar. Puede parecer un

método limitado porque los expertos no pueden q intercambiar sus opiniones,

puntos de vista y experiencia, ya que se les requiere individualmente. Se procede

de la siguiente manera:

Seleccionar al menos tres expertos o jueces, para juzgar de manera independiente

la relevancia y congruencia

a cada experto debe recibir la información escrita suficiente sobre: el propósito

de la prueba (objetivos), conceptualización del universo de contenido, tabla de

especificaciones o de operacionalización de las variables

Se recogen y analizan los instrumentos de validación y se decide:

1) Los ítems que tienen 100% de coincidencia favorable entre los jueces

(congruentes, claros en su redacción y no tendenciosos) quedan incluidos en el

instrumento

2) Los ítems que tengan 100% de coincidencia desfavorable entre los jueces

quedan excluidos del instrumento

3) Los ítems que tengan una coincidencia parcial entre los jueces deben ser

revisados, reformulados o sustituidos, si es necesario, y nuevamente validados.

Según el Método Delphi que fue creado en 1948 se obtiene la opinión de cada una

de las tres o cuatro «vueltas» siguientes, se informa a los expertos de cuál es la

mediana del grupo y se les propone revisar su juicio anterior. La mediana de las

respuestas obtenidas en esta última vuelta es el valor que se estaba buscando. Se

emplea la mediana, porque se presupone que las puntuaciones posibles de los

expertos se distribuyen de forma asimétrica. Con este método los expertos

comparten en cierto modo sus opiniones, sin que existan discusiones ni

confrontaciones directas entre ellos.

Método del Consenso Grupal: Se reúne a los expertos en un lugar determinado,

se indica al grupo que su tarea consiste en lograr una estimación de la pertinencia

y otros aspectos relacionados con la elaboración de los ítems.

La confiabilidad

En lo concerniente a la confiabilidad para ser considerada se debe responder a la

pregunta ¿con cuánta exactitud los ítems, reactivos o tareas representan al

universo de donde fueron seleccionados? El cual designa según Ebel, la exactitud

con que un conjunto de puntajes de pruebas mide lo que tendrían que medir;

donde los métodos que estiman la confiabilidad se tratan detalladamente a

continuación considerando que ambos tienen diferentes parámetros de cálculo:

El Método Test-Retest es una forma de estimar la confiabilidad de un test o

cuestionario se trata de administrar dos veces al mismo grupo y correlacionar las

puntuaciones obtenidas con la desventaja de que los puntajes pueden verse

afectados por el recuerdo, la práctica, etc; siendo no adecuado para aplicarlo a

pruebas de conocimientos sino para la medición de aptitudes físicas y atléticas,

tests de personalidad y motores.

Obteniendo así un coeficiente de estabilidad porque denota la coherencia de las

puntuaciones en el tiempo que debe variar entre 0,80 y 0,95; para que esto

suceda se debe usar la correlación por el método de los puntajes directos

(Correlación r de Pearson).

El Método común de división por mitades o Hemitest es un método que

computa el coeficiente de correlación entre los puntajes de las dos mitades del test

o cuestionario aplicado. Esto supone que los dos test mitades son paralelos,

tienen igual longitud y varianza entre sí. Se estima a través del coeficiente de

confiabilidad de Spearman-Brown se establece la correlación entre los dos

puntajes de las dos mitades del test a través del método de los puntajes directos al

igual que el método anterior, es decir, con correlación r de Pearson.

El método de división por mitades de Rulon por lo contrario utiliza la división

del test en mitades, pero su método no supone necesariamente varianzas iguales

en los sub-test. coeficiente de consistencia interna. Tal es el caso del método de

división por mitades de Guttman que también se denomina coeficiente de

consistencia interna.

Por otro lado, el Coefiente Alfa de Cronbach consiste en evaluar la confiabilidad

o la homogeneidad de las preguntas o ítems es común emplear el coeficiente alfa

de Cronbach cuando se trata de alternativas de respuestas policotómicas, como

las escalas tipo Likert; la cual puede tomar valores entre 0 y 1, siendo 0

confiabilidad nula y 1 confiabilidad total. Esto se interpreta que cuanto mayor sea

la correlación lineal entre ítemes, mayor será el alfa de Cronbach.

Por su parte el Método de Kuder-Richarson 20, permite obtener la confiabilidad

a partir de los datos obtenidos en una sola aplicación del test. Coeficiente de

consistencia interna. Puede ser usada en cuestionarios de ítems dicotómicos y

cuando existen alternativas dicotómicas con respuestas correctas e incorrectas.

También existe el Método de Kuder-Richarson 21, el cual permite obtener la

confiabilidad a partir de los datos obtenidos en una sola aplicación del test. La

suposición básica es considerar que todos los ítems presentan igual varianza este

Coeficiente también se considera de consistencia interna.

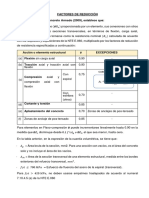

Y lo más importarte de la sesión es la interpretación del Coeficiente de

Confiabilidad el cual es un coeficiente de correlación, teóricamente significa la

correlación del test consigo mismo. Sus valores oscilan entre 0 y 1. Entre las

escalas empleadas se tienen las mostradas en los cuadros siguientes.

Cuadro 4. Escala de interpretación de la magnitud del Coeficiente de Correlación o

Asociación.

Cuadro 5. Interpretación de la magnitud del Coeficiente de Confiabilidad de un

instrumento.

Cuadro 6. Interpretación de la magnitud del Coeficiente de Confiabilidad de un

instrumento.

Cuadro 7. Resumen de los Métodos y Técnicas para estimar la confiabilidad de un

instrumento.

Como colofón, cabe destacar que, existen instrumentos para recabar datos que

por su naturaleza no ameritan el cálculo de la confiabilidad, como son: entrevistas,

escalas de estimación, listas de cotejo, guías de observación, hojas de registros,

inventarios, rúbricas, otros. A este tipo de instrumentos, sin embargo, debe

estimarse o comprobarse su validez, a través del juicio de expertos, para

establecer si los reactivos que los configuran o integran se encuentran bien

redactados y miden lo que se pretende medir.

Igualmente, instrumentos como la Historia Clínica no ameritan el cálculo de la

confiabilidad; debido a que, usualmente, ya se encuentra validada por su uso

frecuente y su confiabilidad se ha comprobado por sus aciertos, en otras palabras,

es un instrumento ya estandarizado. Al respecto, la Historia Clínica es definida por

Guzmán Mora (2006) como una de las formas de registro del acto médico y, en

esencia, son los profesionales de la salud quienes están en capacidad de practicar

una buena Historia Clínica; conceptualizada como el documento médico y clínico

por excelencia.

También podría gustarte

- Probabilidad y estadística: un enfoque teórico-prácticoDe EverandProbabilidad y estadística: un enfoque teórico-prácticoCalificación: 4 de 5 estrellas4/5 (40)

- Validación de Instrumentos (MHS)Documento132 páginasValidación de Instrumentos (MHS)Raul RojasAún no hay calificaciones

- Escala de EmpatíaDocumento12 páginasEscala de EmpatíaOscar Febre100% (3)

- Observaciones o Recomendaciones Por Bimestre y Asignatura SecundariaDocumento2 páginasObservaciones o Recomendaciones Por Bimestre y Asignatura Secundariafukumisha80% (5)

- Análisis LiterarioDocumento5 páginasAnálisis LiterarioJordin Jesús ChumaceroAún no hay calificaciones

- Compresion, Traccion y Flexion PuraDocumento25 páginasCompresion, Traccion y Flexion PuraJordin Jesús Chumacero57% (7)

- Control de Lectura No. 4 Cualidades de Los Test PsicológicosDocumento7 páginasControl de Lectura No. 4 Cualidades de Los Test PsicológicosRailing Feliz100% (2)

- Actividades ResilienciaDocumento6 páginasActividades ResilienciaNahualycanAún no hay calificaciones

- Instumento de MedicionDocumento10 páginasInstumento de MedicionMifflin Huaman OtañeAún no hay calificaciones

- Tema 6 ValidezDocumento13 páginasTema 6 ValidezPs Diego Pérez EgañaAún no hay calificaciones

- 03 Formato Programa Promoción y Prevencion de La SaludDocumento24 páginas03 Formato Programa Promoción y Prevencion de La SaludLourdes Elvira Rodriguez GuzmanAún no hay calificaciones

- Validez y ConfiabilidadDocumento38 páginasValidez y ConfiabilidadJorgeVLLAún no hay calificaciones

- Bocatomas Importantes (Peru)Documento18 páginasBocatomas Importantes (Peru)Jordin Jesús Chumacero0% (1)

- 6capitulo 06 Badyg-MDocumento28 páginas6capitulo 06 Badyg-MHaydeé SeguraAún no hay calificaciones

- Tarea IV Teoria de Los Test y Fundamento de MedicionDocumento10 páginasTarea IV Teoria de Los Test y Fundamento de Medicionmaria luisaAún no hay calificaciones

- CONTROL DE LECTURA No. 4Documento7 páginasCONTROL DE LECTURA No. 4Indhira Acosta100% (3)

- Manual Del Cuestionario Multidimensional de Celos - PresentaciónDocumento23 páginasManual Del Cuestionario Multidimensional de Celos - PresentaciónRicardo Gustavo Gambini57% (21)

- Validacion de InstrumentosDocumento27 páginasValidacion de InstrumentosHeidi HollowayAún no hay calificaciones

- Planeacion Educacion Fisica - Segundo GradoDocumento6 páginasPlaneacion Educacion Fisica - Segundo GradoDiana Cardona BelloAún no hay calificaciones

- Resumen PsicométricasDocumento28 páginasResumen PsicométricasCintia PolakAún no hay calificaciones

- Validez Yconfiabilidad de Los Instrumentos de Investigación para La Recolección de DatosDocumento3 páginasValidez Yconfiabilidad de Los Instrumentos de Investigación para La Recolección de DatosOscar Ivan Suarez GomezAún no hay calificaciones

- Lectura 4Documento6 páginasLectura 4Sebastian GabiniAún no hay calificaciones

- VALIDES Y CONFIABILIDAD DEL INSTRUMENTO para La Recolección de DatosDocumento4 páginasVALIDES Y CONFIABILIDAD DEL INSTRUMENTO para La Recolección de DatosSilvia Ruiz FernandezAún no hay calificaciones

- ValidezDocumento6 páginasValidezDionny FelizAún no hay calificaciones

- 4 - Tareas Test de AptitudesDocumento9 páginas4 - Tareas Test de AptitudesMariely MinayaAún no hay calificaciones

- Taller 4 ListoDocumento39 páginasTaller 4 Listoisidrolara25Aún no hay calificaciones

- TAREA 6 - Teoria y FundamentosDocumento6 páginasTAREA 6 - Teoria y FundamentoscristinaAún no hay calificaciones

- Confiabilidad y ValidezDocumento37 páginasConfiabilidad y ValidezLenin Aspajo SoriaAún no hay calificaciones

- Validacion EncuestaDocumento3 páginasValidacion EncuestaJader PalenciaAún no hay calificaciones

- Clase 11 - Caracteristicas Psicometricas de Las Pruebas IDocumento31 páginasClase 11 - Caracteristicas Psicometricas de Las Pruebas IDon Jopa100% (1)

- Tercer Trabajo PDFDocumento15 páginasTercer Trabajo PDFJAVIERAún no hay calificaciones

- Sesion 8 - CONFIABILIDAD Y VALIDEZ PDFDocumento43 páginasSesion 8 - CONFIABILIDAD Y VALIDEZ PDFcris100% (1)

- Criterios de Calidad y ÉticosDocumento10 páginasCriterios de Calidad y Éticosrcw5rjmd7xAún no hay calificaciones

- Ensayo Psicometria FinalDocumento6 páginasEnsayo Psicometria FinalyeiloAún no hay calificaciones

- Naturaleza y Características de Los TestDocumento5 páginasNaturaleza y Características de Los TestEmely RodriguezAún no hay calificaciones

- Control 5Documento5 páginasControl 5Lic Nayeli CrucetaAún no hay calificaciones

- Proceso de ConfiabilidadDocumento46 páginasProceso de ConfiabilidadGabriel Ponce RiveraAún no hay calificaciones

- Validez y ConfiabilidadDocumento11 páginasValidez y ConfiabilidadElis DiazAún no hay calificaciones

- Indicación y Espacio para Enviar La Tare3Documento6 páginasIndicación y Espacio para Enviar La Tare3ElaineAún no hay calificaciones

- Sesión 1. DiagnósticoDocumento55 páginasSesión 1. Diagnósticodestructor.vidaAún no hay calificaciones

- Confiablidad y ValidezDocumento33 páginasConfiablidad y ValidezclearblueflowerAún no hay calificaciones

- Recoleccion de La Información AprendizDocumento51 páginasRecoleccion de La Información AprendizCristhian MorenoAún no hay calificaciones

- Clase Unidad 3Documento19 páginasClase Unidad 3Flor Purificación Parra LopezAún no hay calificaciones

- Precisión o Exactitud de La MedidaDocumento5 páginasPrecisión o Exactitud de La MedidaAngelo Torres RamosAún no hay calificaciones

- Taller Psicometría 8 de Octubre 2021 1Documento3 páginasTaller Psicometría 8 de Octubre 2021 1Promotora Mercadeo VAún no hay calificaciones

- Confiabilidad 1Documento27 páginasConfiabilidad 1Oli MagañaAún no hay calificaciones

- Construccion y Validacion de CuestionariosDocumento35 páginasConstruccion y Validacion de CuestionariosflorAún no hay calificaciones

- Guía Unidad 3Documento10 páginasGuía Unidad 3José Contreras R.Aún no hay calificaciones

- Virtual Estadística Aplicable Al Mercadeo - Jennifer CedeñoDocumento12 páginasVirtual Estadística Aplicable Al Mercadeo - Jennifer Cedeñojennifer cedenoAún no hay calificaciones

- Validez FinalDocumento10 páginasValidez Finalcarlos Andres Rodriguez AvilaAún no hay calificaciones

- Confiabilidad y ValidezDocumento7 páginasConfiabilidad y ValidezNicolás Abad PlasencioAún no hay calificaciones

- Psicometria Confiabilidad y ValidesDocumento2 páginasPsicometria Confiabilidad y ValidesStefanie SilvaAún no hay calificaciones

- Tarea IV Teoria de Los Test y Fundamento de MedicionDocumento10 páginasTarea IV Teoria de Los Test y Fundamento de MedicionJorge Luis Amadís NuñezAún no hay calificaciones

- Confiabilidad Seminario Tesis II SEMANA SIETEDocumento22 páginasConfiabilidad Seminario Tesis II SEMANA SIETEWilder Hernan Lizano SedanoAún no hay calificaciones

- Sipro 21Documento13 páginasSipro 21Alejandro TaboraAún no hay calificaciones

- Confiabilidad y ValidezDocumento4 páginasConfiabilidad y ValidezBrenda DelgadoAún no hay calificaciones

- Análisis e Reactivos y Estandarización de PruebasDocumento4 páginasAnálisis e Reactivos y Estandarización de Pruebasariel santosAún no hay calificaciones

- Correlacion y PrediccionDocumento19 páginasCorrelacion y PrediccionceronenaAún no hay calificaciones

- CONFIABILIDADÇDocumento13 páginasCONFIABILIDADÇRomel Quijada UribarriAún no hay calificaciones

- ConfiabilidadDocumento9 páginasConfiabilidadJuanAún no hay calificaciones

- Análisis Crítico 3Documento2 páginasAnálisis Crítico 3Lourdes CarolinaAún no hay calificaciones

- Clase4 ValidezDocumento21 páginasClase4 ValidezsifuentesdocenciaAún no hay calificaciones

- Contenido 3. Validez y Fiabilidad.Documento5 páginasContenido 3. Validez y Fiabilidad.Iván Zárate GonzálezAún no hay calificaciones

- Clase 3-Validez Constructo y CriterioDocumento16 páginasClase 3-Validez Constructo y CriterioKelly HuamanAún no hay calificaciones

- Validez Y Confiabilidad de Un Instrumento de Medición: La Validación ImplicaDocumento7 páginasValidez Y Confiabilidad de Un Instrumento de Medición: La Validación ImplicaHebert Marcos Yujra LimachiAún no hay calificaciones

- Fases en La Contruccion de Un Test Psicologico 22Documento14 páginasFases en La Contruccion de Un Test Psicologico 22Frederick del valle alcantaraAún no hay calificaciones

- Investigacionparte 1Documento7 páginasInvestigacionparte 1rositaleoAún no hay calificaciones

- Estimaciones de ConfiabilidadDocumento9 páginasEstimaciones de ConfiabilidadJose Leonardo Materano PerozoAún no hay calificaciones

- Lectura Fundamental 5 PDFDocumento13 páginasLectura Fundamental 5 PDFLorena RamirezAún no hay calificaciones

- Psicología Aplicada - E. Cerdá - Los Test MentalesDocumento2 páginasPsicología Aplicada - E. Cerdá - Los Test MentalesAdri Ana0% (1)

- Diseño Hidraulico de CunetasDocumento6 páginasDiseño Hidraulico de CunetasJordin Jesús ChumaceroAún no hay calificaciones

- Tracción PuraDocumento17 páginasTracción PuraJordin Jesús ChumaceroAún no hay calificaciones

- Organizador Visual La Motivación Laboral Cómo ImplementarlaDocumento1 páginaOrganizador Visual La Motivación Laboral Cómo ImplementarlaJordin Jesús Chumacero100% (2)

- Ejercicio 1Documento1 páginaEjercicio 1Jordin Jesús ChumaceroAún no hay calificaciones

- Factores de ReducciónDocumento2 páginasFactores de ReducciónJordin Jesús ChumaceroAún no hay calificaciones

- Perdida Por FricionDocumento14 páginasPerdida Por FricionJordin Jesús ChumaceroAún no hay calificaciones

- Ejercicio ResueltoDocumento4 páginasEjercicio ResueltoJordin Jesús ChumaceroAún no hay calificaciones

- Caracteristicas de Bocatomas y Presas.Documento11 páginasCaracteristicas de Bocatomas y Presas.Jordin Jesús ChumaceroAún no hay calificaciones

- Ejercicio 22Documento6 páginasEjercicio 22Jordin Jesús ChumaceroAún no hay calificaciones

- Presas Clasificacion y DiseñoDocumento23 páginasPresas Clasificacion y DiseñoJordin Jesús ChumaceroAún no hay calificaciones

- Practica Nº 04Documento4 páginasPractica Nº 04Jordin Jesús ChumaceroAún no hay calificaciones

- Plantas Naturales Medicinales de La Provinica de JaenDocumento8 páginasPlantas Naturales Medicinales de La Provinica de JaenJordin Jesús Chumacero100% (1)

- Informe ParkinsonDocumento27 páginasInforme ParkinsonMartaGonzalezAún no hay calificaciones

- Bienestar Subjetivo y Calidad de Vida en La Infancia en Chile PDFDocumento15 páginasBienestar Subjetivo y Calidad de Vida en La Infancia en Chile PDFJuan OyanedelAún no hay calificaciones

- Repaso General IMPORTANTEDocumento7 páginasRepaso General IMPORTANTELeo HernandezAún no hay calificaciones

- ACOMPAÑAMIENTODocumento3 páginasACOMPAÑAMIENTOMaribel Chuye CoronadoAún no hay calificaciones

- Adaptacion Del Inventario de AutoestimaDocumento18 páginasAdaptacion Del Inventario de Autoestimaaldemar39Aún no hay calificaciones

- Curric. Del Mtro. Migue. ResumidoDocumento2 páginasCurric. Del Mtro. Migue. ResumidoAnahi CruzAún no hay calificaciones

- Ensayo Del Ser Humano y La Calida en Su Vida DiariaDocumento1 páginaEnsayo Del Ser Humano y La Calida en Su Vida DiariaOscar SolerAún no hay calificaciones

- Cap 4Documento20 páginasCap 4Viky Yahairitah Alcalde FloresAún no hay calificaciones

- Sesion 1 Sanrea - 2022Documento41 páginasSesion 1 Sanrea - 2022Guisell FloresAún no hay calificaciones

- Informe Escolar 2018Documento3 páginasInforme Escolar 2018Camila Andrea Cáceres ElguetaAún no hay calificaciones

- Desarrollo y Validación de La Versión Española de La Spouse-Specific Dependency Scale (SSDS)Documento23 páginasDesarrollo y Validación de La Versión Española de La Spouse-Specific Dependency Scale (SSDS)Jahnavi ObandoAún no hay calificaciones

- Estructura de Los Servicios de Orientación (Castellano)Documento10 páginasEstructura de Los Servicios de Orientación (Castellano)Ana UrbietaAún no hay calificaciones

- Factores Que Afectan La Intención de Las Enfermeras de Dejar Sus Trabajos Actuales en Arabia Saudita PDFDocumento8 páginasFactores Que Afectan La Intención de Las Enfermeras de Dejar Sus Trabajos Actuales en Arabia Saudita PDFPsicología PoligranAún no hay calificaciones

- Cuadro de Horas - IEP. 5121 - 2015terminadoDocumento18 páginasCuadro de Horas - IEP. 5121 - 2015terminadoMarisol Sánchez NinahuamánAún no hay calificaciones

- Desarrollo Humano y Los Factores Que Lo AfectanDocumento8 páginasDesarrollo Humano y Los Factores Que Lo AfectanAfe Maggot BFMVAún no hay calificaciones

- ANEXO V Plan de Accion TutorialDocumento13 páginasANEXO V Plan de Accion TutorialMARIA JOSEAún no hay calificaciones

- Estudio Hogar y Felicidad 2019Documento21 páginasEstudio Hogar y Felicidad 2019Cooperativa.clAún no hay calificaciones

- PROYECCIÓN SOCIAL Educacion para La SaludDocumento7 páginasPROYECCIÓN SOCIAL Educacion para La SaludWilliam Quispe LaymeAún no hay calificaciones

- Esquema Tesis IIIDocumento9 páginasEsquema Tesis IIIBrayan YbañezAún no hay calificaciones

- 1º CDocumento2 páginas1º CAlberto M. Fernández HuamánAún no hay calificaciones

- Indicadores de Calidad de VidaDocumento10 páginasIndicadores de Calidad de VidaViviana Zelegna Chi VegaAún no hay calificaciones

- Inducción de Personal Ingresante RV00Documento7 páginasInducción de Personal Ingresante RV00MAUAún no hay calificaciones

- Instrumento para Medir El Liderazgo Directivo Dr. Ricardo Rossi ValverdeDocumento16 páginasInstrumento para Medir El Liderazgo Directivo Dr. Ricardo Rossi ValverdeRossi Mori Manuel100% (3)