Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Estrategias de Evaluación de Programas de Intervención

Cargado por

Gerard SnchzDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Estrategias de Evaluación de Programas de Intervención

Cargado por

Gerard SnchzCopyright:

Formatos disponibles

A

D -;=tea

4f /^

4

V

XXI, Revista de Educacin. 4 (2002): 181-202. Universidad de Huelva

Estrategias para la evaluacin

de programas de orientacin

Juan Manuel Mndez Garrido

Manuel Monescillo Palomo

Universidad de Huelva

En este artculo los autores ponen de relieve las caractersticas e importancia

de la evaluacin de programas como estrategia de investigacin para garan-

tizar la calidad de las intervenciones orientadoras y educativas. Tras justifi

- car la necesidad de evaluar las propuestas de accin orientadora y aproxi-

marnos al concepto de evaluacin de programas nos exponen la finalidad y

objetivos que sta persigue y presentan distintos modelos tericos que pue-

den servir de referencia para introducirse en esta prctica Investigadora.

Encontraremos tambin en este trabajo referencias a las fases a seguir en el

proceso evaluadory propuestas prcticas para facilitarla evaluacin de pro-

gramas. Por ltimo se advierte sobre las posibles dificultades que podran

presentarse al afrontar el reto de una investigacin evaluativa.

In this article, the authors point out the characteristics and the importance

of the evaluation of programmes as a research strategy to guarantee the

quality of educational and guidance interventions. After justifying the

necessity of evaluating the guidance proposals and taking into account the

concept of evaluation of programmes, the authors show us its aims and

objectives and several theoretical models which can be used as references

for its Implementation. This paper shows references for the phases to follow

the evaluating process and practical proposals to facilitate the evaluation of

programmes. Finally, the authors draw attention to the possible difficulties

which can be found when facing evaluating research.

1. Introduccin

En la poca actual, nadie pone en duda el papel tan fundamental e imprescindi-

ble que juega la evaluacin en todo el proceso de la Intervencin educativa. Una

evaluacin que no slo se va a ocupar de valorar los resultados finales, sino que va

a impregnar a todo el proceso educativo, es decir, antes, durante y despus del

mismo, con una sola finalidad como es la mejora de la calidad educativa.

181

Universidad de Huelva 2009

XX1

Revista de Educacin

La necesidad de evaluar los programas se justifica desde el momento en que se

disea un trabajo y se desea recoger Informacin que sirva, en primer lugar, para

asistir o ayudar sobre su elaboracin e implantacin; en segundo lugar, valorar su

incidencia, efectividad y utilidad; y, por ltimo, contribuir a la mejora del propio

programa. Por tanto, la evaluacin es un elemento ms en el diseo de todo pro-

grama de orientacin, adems de ser una exigencia del sistema educativo actual,

reflejado en los propios documentos oficiales:

La evaluacin del sistema educativo es competencia y obligacin de las admi-

nistraciones educativas; la de los procesos educativos lo es, en primera instancia,

de los profesores y alumnos como agentes de estos procesos (MEC, 1989:65).

...Evaluar los efectos de los procesos de reordenacin e innovacin en el siste-

ma educativo, valorar los programas y centros, ir ms all de las impresiones inge-

nuas en el conocimientos de las estructuras y de las interacciones en que se enmarcan

los hechos educativos, facilitando as la toma de decisiones (Libro Blanco, 1989:64).

Gade (1981), citado por Sanz (1990:60) seala una serie de ventajas para los

equipos de profesionales encargados del diseo y elaboracin de nuevos progra-

mas:

a) Recibir un constante feedback sobre el grado de efectividad del programa de

orientacin.

b) Poder identificar a estudiantes cuyas necesidades no estn siendo satisfe-

chas.

c) Elegir y utilizar las tcnicas de orientacin sobre la base de su efectividad.

d) Poder justificar la eliminacin de actividades innecesarias.

e) Disponer de una evidencia para requerir un incremento de servicios perso-

nales y materiales para satisfacer los objetivos del programa.

Por su parte el propio Sanz (1990:59) destaca la necesidad de la evaluacin

como componente imprescindible en el diseo de todo programa, sealando las

siguientes razones:

a) Comprobar si la funcin de la orientacin est dando satisfaccin a las nece-

sidades de los estudiantes.

b) Servir de base para la mejora del programa.

c) Tomar decisiones razonadas sobre el mismo.

d) Ayudar a la comunidad educativa a estar mejor informada en su toma de

decisiones.

Prez Juste (1997:119 y ss.) considera que esa exigencia que se aprecia en los

documentos oficiales, para realizar la evaluacin de programas, no se ve reflejada

en la prctica habitual, por lo que propone que motivemos al profesorado desta-

cndole las razones que pueden justificar su uso:

a) Relacin entre evaluacin y eficacia escolar.

b) Incidencia entre evaluacin y calidad.

c) Relacin de la evaluacin y los programas de mejora.

d) Incidencia de la evaluacin y la filosofa de superacin.

En este artculo pretendemos aproximarnos al concepto actual de evaluacin de

programas, poniendo de relieve su importancia como metodologa de Investiga

-cin, clarificando su finalidad y objetivos, presentando diferentes modelos y, fi-

182

nalmente, ofreciendo unas propuestas prcticas que puedan servir de gua a quie-

nes quieran adentrarse en esta faceta investigadora.

Universidad de Huelva 2009

0

A

V

2. Conceptualizacin de la evaluacin de

programas

A pesar de las dificultades y de las reticencias por parte del profesorado, en las

postrimeras del siglo XX, la evaluacin ha tomado un lugar destacado en el mbito

educativo, debido en parte a las ventajas que hemos analizados con anterioridad,

pero sobre todo a la nueva mentalidad del docente que busca la mejora de la

calidad educativa. Para llegar hasta este momento, se ha tenido que recorrer un

largo camino donde las distintas ideas sobre la sociedad y la educacin han ido

configurndola y dotndola de fundamentos actuales.

Desde el concepto de evaluacin como valoracin del rendimiento de los alum-

nos, orientadas desde la subjetividad o por medidas estandarizadas, objetivas y

que hacen referencia a la norma, hasta llegar a la denominada evaluacin orien-

tada hacia los objetivos transcurre un perodo muy amplio de tiempo. Es precisa-

mente Tyler con sus aportaciones, considerado como el padre de la evaluacin

educativa, quien provoca a partir de la dcada de los sesenta una seria reflexin

sobre la reconceptualizacin del significado de la evaluacin que va a poner en

entredicho su modelo y va a dar lugar a otros nuevos orientados hacia una evalua-

cin de corte investigativo sobre las metas, los resultados de los programas, las

tareas, el propio sistema educativo, los proyectos curriculares, los centros, los pla-

nes de formacin e incluso al profesorado y su actividad docente y con una finali-

dad crtica y formativa para la mejora. El desarrollo de la evaluacin de programas

surge en mbito educativo a partir de los inicios de la dcada de los sesenta, sobre

todo en los pases anglosajones, con Estados Unidos a la cabeza, con el objetivo de

valorar la eficacia de los programas de accin social.

Tejada (1999:31), nos realiza una excelente sntesis de una gran variedad de

definiciones, agrupndolas en cuatro bloques:

a) Definiciones que contienen especificaciones o normas sobre atributos que

han de haber conseguido los alumnos despus de un proceso instructivo.

b) Definiciones que centran la evaluacin en la determinacin del mrito o

valor.

c) Definiciones que afrontan la evaluacin como el proceso que proporciona

informacin para la toma de decisiones.

d) Definiciones que intentan sintetizar y aglutinar los aspectos anteriores.

Ante tal panorama, podemos decir que el trmino evaluacin admite muchos

significados, a veces diferentes, pero que lo enriquecen. Hagamos una referencia

ilustrativa de autores nacionales, con la que podamos extraer sus notas ms carac-

tersticas.

Para Prez Juste (1997:124), la evaluacin de programas es un proceso sistem-

tico, diseado intencional y tcnicamente, de recogida de Informacin rigurosa -

valiosa, vlida y fiable-, orientado a valorar la calidad y los logros de un programa,

como base para la posterior toma de decisiones de mejora tanto del programa

como del personal implicado y, de modo indirecto, del cuerpo social en que se

encuentra inmerso.

Segn Gimeno (1992:338), evaluar hace referencia a cualquier proceso por medio

del que alguna o varias caractersticas de un alumno, de un grupo de estudiantes,

de un ambiente educativo, de objetivos educativos, de materiales, profesores, progra-

mas, etc., reciben la atencin del que evala, se analizan y se valoran sus caracte-

rsticas y condiciones en funcin de unos criterios o puntos de referencia para

emitir un juicio que sea relevante para la educacin.

De la Orden (1997:16), entiende que la evaluacin podra considerarse como el

proceso sistemtico de recogida, anlisis e interpretacin de informacin relevan-

te y fiable para describir cualquier faceta de la educacin y formular un juicio de

183

Universidad de Huelva 2009

xx'

Revista de Educacin

valor sobre su adecuacin a un criterio o patrn como base para la toma de deci-

siones respecto a dicha faceta.

lvarez Rojo (1987:54), por su parte, afirma que la evaluacin en orientacin

educativa es un proceso, no una serie de juicios de valor sobre la conducta de los

individuos, en el que se mide cualitativa y cuantitativamente de forma continua y

sistemtica el impacto que un programa de orientacin tiene en un medio escolar

espec f i c o .

Para Repetto (1987:250), la evaluacin de programas es concebida como la ac-

tividad sistemtica y continua, integrada dentro del proceso educativo, que tiene

por objeto proporcionar el anlisis de la mxima informacin cientfica sobre la

que se pueda formular un juicio de valor que apoye la subsiguiente toma de deci-

siones sobre dicho programa. Por programa se entiende el proyecto que expone el

conjunto sistemtico de actuaciones que se van a realizar para alcanzar determina-

dos objetivo. E n esta misma lnea, Casanova (1992:3 1), mantiene que la evaluacin

consiste en un proceso sistemtico de recogida de datos, incorporado al sistema

general de actuacin educativa, que permite obtener informacin vlida y fiable

para formar juicios de valor acerca de una situacin. E stos juicios, a su vez, se

utilizarn en la toma de decisiones consecuente con objeto de mejorar la actividad

educativa valorada.

De entre todas estas definiciones, nos encontramos con una serie de notas carac-

tersticas que le dan razn de ser. Destacamos en primer lugar su carcter procesual,

que lo abarca todo, antes, durante y despus de la intervencin. E n segundo lugar,

su sistematizacin, algo que no se puede improvisar, sino que se parte de una plani-

ficacin previa, donde no se debe olvidar ningn elemento, por lo que puede ser

considerada como un modo de Investigacin: la llamada investigacin evaluativa. La

recogida de informacin, que nos permitir tener puntos de referencia sobre la uti-

lidad y efectividad del programa. La valoracin de los datos a partir de criterios

preestablecidos y referencias adecuadas. Y por ltimo, destacar su carcter formati-

vo de toma de decisiones orientada a la mejora de la prctica.

3. Finalidad y objetivos de la evaluacin de

programas

La evaluacin de programas de orientacin se viene centrando, tanto en valorar

los diferentes elementos que los conforman, como en enjuiciar la efectividad en las

distintas fases del proceso de diseo y experimentacin; en ambos casos, la inten-

cin o pretensin del evaluador suele variar. E n este apartado reflejaremos las

opiniones de distintos autores, acerca de las finalidades y objetivos de la evalua-

cin de programas.

Para Garanto (1989:58), centrado en el modelo iluminativo (Stufflebeam y

Shinkfield 1989:313-339), la evaluacin de un programa tiene como finalidad:

a) Analizar cmo funciona.

b) Descubrir cmo es influido por las diferentes situaciones escolares donde se

aplica.

c) Conocer las ventajas o desventajas que aprecian aquellos que estn directa-

mente implicados en su desarrollo.

E n opinin de Repetto (1994:886-888), los objetivos generales de la evaluacin

de programas de orientacin tienden a:

a) Poder emitir un juicio razonado sobre el valor y la utilidad del programa

evaluado.

18^ b) Asistir a quienes toman las decisiones sobre la Implantacin, expansin y

supresin de los programas.

Universidad de Huelva 2009

c) Servir a las funciones polticas.

Por su parte, Stufflebeam y Shinkfield (1989:91-110) manifiestan que los obje-

tivos que se asignan a la evaluacin van a depender de las distintas concepciones

que sobre ella existen y, en este sentido, argumentan que mientras autores como

Tyler proponen que la evaluacin de un programa debe centrarse exclusivamente

en los resultados finales para comprobar si se han logrado las metas inicialmente

propuestas, otros, como Aubrey (1982:58), afirman que tambin hay necesidad

de evaluacin al comienzo del programa, durante el proceso del programa y a su

finalizacin. Est Jaro que para los autores situados en la segunda tendencia la

evaluacin debe ser un Instrumento til que impregne todo el proceso de diseo,

desarrollo y evaluacin y capaz de proporcionar informaciones tiles, que nos

presenten alternativas de accin para poder mejorar el propio programa que se

evala.

Valorando el carcter prctico y funcional que se le asigna a la evaluacin coma

instrumento de mejora, y siguiendo a Stufflebeam y Shinkfield (1989:175-233),

estimamos que la evaluacin de un programa de orientacin debe atender, tanto a

la evaluacin del contexto -a fin de identificar las peculiaridades del entorno y las

demandas prioritarias y, a partir de ellas concretar los objetivos que orientarn el

diseo del programa-, como a la evaluacin de los instrumentos y estrategias

organizativas y metodolgicas, la evaluacin del proceso desarrollado y, por su-

puesto, la evaluacin de los resultados logrados en relacin a las metas de referen-

cia propuestas inicialmente.

Sin lugar a dudas, la evaluacin aporta una serie de ventajas en la organizacin

y desarrollo de la orientacin; en este sentido, Gade (1981) asegura que una eva-

luacin sistemtica de los programas permite a los responsables:

a) Recibir informacin permanente sobre la efectividad que est teniendo el

programa.

b) Poder detectar las necesidades de grupo o individuales no atendidas por el

programa.

c) Seleccionar las tcnicas de orientacin ms apropiadas.

d) Justificar por qu se hacen o no se hacen ciertas actividades en el programa.

e) Poder razonar el requerimiento de recursos materiales y humanos necesa-

rios.

Lo expresado en las lneas anteriores nos lleva a confirmar que la evaluacin de

un programa, y por tanto la finalidad de una investigacin evaluativa, es necesaria

abordarla y debe permitirnos, como apunta Tejedor (1994:94), emitir un juicio

valorativo sobre el programa y, al mismo tiempo, determinar en qu medida se

logran los objetivos marcados. Por supuesto, tambin se tomarn en consideracin

las afirmaciones de Prez Juste (1992), lograr que contribuya tanto a la mejora de

las personas como a la mejora del propio programa.

4. Modelos de evaluacin de programas

En las ltimas dcadas ha proliferado gran cantidad de modelos lo que ha gene-

rado gran cantidad de bibliografa al respecto. No existe por tanto un modelo ge-

neralizado, lo que pone de manifiesto la dificultad de llegar a puntos de encuen-

tros como consecuencia de la complejidad de la propia evaluacin, pero es un

claro indicio del auge que est tomando la actividad evaluadora. Ante tal situa-

cin, no nos ha de sorprender la variedad de clasificaciones que se realizan por

distintos autores atendiendo a supuestos criterios diferenciadores, que en algunos

casos lo que hacen es confundir al lector (Gardner, 1977 -citado por De La Orden,

1997-; Popham, 1980; Repetto, - 1987; Castillo y Gento, 1995; Estebaranz, 1995;

Tejada, 1999, entre otros). -t

Universidad de Huelva 2009

XXI

Revista de Educacin

Las investigaciones sobre la evaluacin van generando modelos tericos que

tratan de justificar y racionalizar la prctica de la evaluacin a partir de unos

principios particulares utilizando las metodologas que los caracterizan. Los dis-

tintos modelos pueden servirnos de referencia para analizar y evaluar los materia-

les curriculares; stos pueden aportarnos ideas para proceder a disear un docu-

mento gil que nos permita someter a evaluacin un programa de orientacin

antes de proceder a su experimentacin en la prctica. Existe una gran variedad de

modelos para la evaluacin de programas; trataremos de centrarnos slo en aque-

llos que tienen ms posibilidades de ser aplicados en el mbito de la educacin.

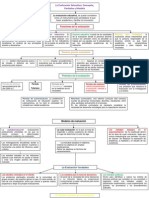

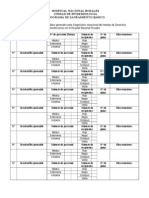

Modelos de evaluacin de programas educativos

I ndicadores

Eficientista H uman stico Holstico

F inalidad Control tcnico T ransformacin Valoracin integral

socio- contextual

Fundamentacin T ecnolgica Psicosociolgica S istemtica e integral

T ipo de Experimental S ociolgica S ocio-emp rica

I nvestigacin

Rol del evaluador T cnico externo Promotor colaborador Apoyo tcnico

colaborativo

C riterios Eficiencia I doneidad de procesos I mplicacin global

de evaluacin

I nstrumentos O bjetivo- cuantitativos C uantitativos C uantitativos

T ratamiento de la T cnico estad sticas T cnicas estad sticas Evidencia

I nformacin y participativas cient fico- interpretativas

Explotacin de Por autoridades Por los implicados Por protagonistas

resultados externas y autoridades

I ndicadores diferenciales de los modelos de evaluacin de programas educativos

(Castillo y Gento, 1995:39)

Los modelos que han venido aplicndose en las investigaciones evaluativas han

resultado bastante confusos e inapropiados para aplicarlos en el mbito educativo,

dado que hab an nacido en contextos no educativos. As lo expresa Lombana (1985)

cuando comenta que es dif cil aplicar con garant a y eficacia unos modelos creados

para las industrias y empresas que hablan de materias presupuestarias, inversio-

nes, clientes y beneficios. No obstante, para el mbito espec fico de la orientacin

existen diversos modelos comprensivos que pueden ser utilizados en la evaluacin

de programas.

C ontamos con diversas clasificaciones de los modelos de evaluacin de progra-

mas. As , Popham (1980) reconoce cuatro modelos: a) el de consecucin de metas;

b) el de enjuiciamiento sobre criterios intr nsecos; c) el de enjuiciamiento sobre

criterios extr nsecos; y d) el de facilitacin de decisiones. Por su parte, Stufflebeam

y Shinkfield (1995) distinguen tres modelos:

a) Pseudoevaluaciones, donde se incluyen las investigaciones encubiertas y los

estudios basados en las relaciones pblicas.

b) Cuasievaluaciones, a su vez clasificadas en estudios basados en objetivos y

estudios basados en la experimentacin.

c) Verdaderas evaluaciones, que integra: estudios de orientacin de la decisin;

estudios centrados en el cliente; estudios pol ticos y estudios basados en el

consumidor.

I84

A continuacin, presentamos aquellos modelos que creemos que han sido ms

significativos en la evaluacin de programas educativos, tomando como referencia

Universidad de Huelva 2009

las aportaciones de Stufflebeam y Shinkfield (1989) y apoyndonos en la clasifica-

cin de ms reciente aparicin (Tejada, 1999:42-56), por la que nos agrupa los

diferentes modelos en ocho grandes bloques.

4.1. Modelo de evaluacin orientada hacia los

objetivos

Su principal representante es Tyler (1967), para quien la evaluacin es el pro-

ceso de determinar la congruencia entre los objetivos y los logros. El modelo cuan-

titativo o tambin llamado modelo de Tyler lo que hace es una evaluacin del

aprendizaje del estudiante ya que hace una proposicin de objetivos que sirve

como referencia para la evaluacin. ste fue el primer modelo sistemtico de eva-

luacin, que al utilizar la medicin tena bastante paralelismo con la investigacin

cientfica.

Tyler hace una diferenciacin entre lo que es la medida y lo que es evaluacin.

La medida es slo una de las formas en que podemos apoyarnos en el proceso de

evaluacin. Considera que la evaluacin es muy necesaria debido a las diferencias

individuales, que nos encontramos entre los alumnos, los ambientes en los que se

lleva a cabo la enseanza y la capacidad y formacin del docente para desarrollar

los planes de estudio. Establece las siguientes fases en el proceso evaluador:

a) Determinar los objetivos especficos de cada rea de contenido.

b) Identificar situaciones en las que los estudiantes puedan demostrar la con-

ducta expresada en los objetivos.

c) Examinar o desarrollar instrumentos capaces de probar cada objetivo: de

tener objetividad, posibilidad y validez.

d) Aplicar los instrumentos para poder comprobar que se han dado cambios y

que pueden ser imputados al currculum.

e) Examinar los resultados para determinar las reas del currculum ms fuer-

tes y ms dbiles.

f) Desarrollar hiptesis y probarlas para explicar los patrones observados de

consistencia o debilidad.

g) Hacer modificaciones apropiadas en el currculum.

Utiliza la evaluacin para mejorar los programas y refinar el currculum. Esta

idea de evaluacin lleva incluido la retroalimentacin o feedback que nos llevar

hacia el concepto de evaluacin formativa. Se le critic este modelo porque enten-

di la evaluacin como un proceso terminal, a los productos, objetivos y activida-

des expresadas en conducta observada. Pensaba que haba que formular hiptesis

y probarlas. Se utiliz en psicologa cognitiva para elaborar tests criteriales, para

ver el nivel de competencia, con el fin de conseguir un aprendizaje jerarquizado.

4.2. El modelo cientfico de evaluacin

En el modelo cientfico de evaluacin se parte de la Idea de que el evaluador

debe ser un investigador y la evaluacin de programas debe basarse en la lgica

del mtodo cientfico. Asume los siguientes propsitos evaluativos:

a) Describir si los objetivos han sido alcanzados y de qu manera.

b) Determinar las razones de cada uno de los xitos y fracasos.

c) Descubrir los principios que subyacen en un programa que ha tenido xito.

d) Dirigir el curso de los experimentos mediante tcnicas que aumenten su

efectividad. 187

Universidad de Huelva 2009

XX1

Revista de Educacin

e) Sentar las bases de una futura investigacin sobre las razones del relativo

xito de tcnicas alternativas.

f) Redefinir los medios que hay que utilizar para alcanzar los objetivos, as

como las submetas, a la luz de los descubrimientos de la investigacin.

4.3. El modelo de toma de decisiones

Representado por Stufflebeam y Shinkfield (1989), para quien su concepto de

evaluacin resume su propuesta del modelo C.I.P.P. (Context-Input-Process-

Product): La evaluacin es el proceso de identificar, obtener y proporcionar Infor-

macin til y descriptiva acerca del valor y el mrito de las metas, la planificacin,

la realizacin y el impacto de un objeto determinado, con el fm de servir de gua

para la toma de decisiones, solucionar los problemas de responsabilidad y promo-

ver la comprensin de los fenmenos implicados .

En este modelo la evaluacin est orientada al perfeccionamiento de los siste-

mas. Se basa en mejorar la prctica educativa, para ello es necesario disear, obte-

ner y proporcionar Informacin para as poder juzgar las alternativas de decisin.

Este juicio lo realizaremos al hacer las comparaciones de las necesidades de la

gente a la que se debe servir. Sus componentes son:

- Contexto: mbito en el que se inscribe el programa. En la evaluacin del

contexto, se analiza los problemas o necesidades educativas, lo cual permite

identificar las metas y objetivos generales y especficos, y a partir de stos,

establecer un programa.

- Entrada: diseo y manejo de recursos. La evaluacin del input es la evalua-

cin de las estrategias de accin que van a permitir la consecucin de las

metas y objetivos del programa. Decidir qu estrategias educativas, cmo y

cundo utilizarlas son los objetivos de esta modalidad de evaluacin.

- Proceso: camino a seguir hacia la meta. Es la evaluacin del proceso, donde

se detectan fallos en el diseo del procedimiento, lo que permite analizar

retrospectivamente todos los componentes del programa en curso.

- Producto: resultados obtenidos. En la evaluacin del producto, el objetivo es

la medicin e interpretacin de los resultados del programa, no slo cuando

ste finaliza, sino tambin durante el desarrollo del mismo, y siempre te-

niendo como punto de referencia y comparacin los objetivos Iniciales, lo

que se esperaba conseguir.

Estas cuatro fases, contexto, entrada, proceso y producto, han de formar parte

de un todo orgnico estructurado, si queremos contar con un proceso Integral que

recoja todas las dimensiones de la compleja realidad evaluativa en el campo de la

realidad escolar, porque como seala Aubrey (1982) hay necesidad de evaluacin

al comienzo del programa, durante el proceso del programa y a su finalizacin,

permitiendo el desarrollo de un proceso cclico de Interaccin y feedback constan-

te entre los distintos componentes.

Estos componentes los podramos identificar con los cuatro elementos que cita

Prez Gmez (1983:426): tener conciencia de la necesidad de tomar una decisin,

disear la situacin de decisin, escoger entre las distintas alternativas y actuar

segn la alternativa elegida.

Aunque a Stufflebeam (1966, 1967) se le considera el mximo representante de

este importantsimo enfoque al considerar que la evaluacin deba ser utilizada

tanto para el perfeccionamiento de un programa como para enjuiciar su valor,

introduciendo una conceptualizacin de la evaluacin basada en la idea de que

sta debera ayudar a los educadores a tomar y justificar decisiones que pudieran

satisfacer mejor las necesidades de los estudiantes, se debe a Cronbach (1963) las

700

primeras aportaciones cuando introdujo a los evaluadores en la idea de que la

orientacin deba ser reorientada y que, de basarse en objetivos, deba pasar a ser

Universidad de Huelva 2009

A

P 0

4 ^

4 4

V

una ayuda para que los educadores tomaran decisiones ms acertadas acerca de

cmo educar. Muchos otros autores han continuado desarrollando este enfoque,

encontrndose entre ellos Alkin (1969) y Guba (1978).

El modelo C.S.E. (Centro para el Estudio de la Evaluacin de la Universidad de

California) dirigido por Alkin establece cinco fases, recogidas por Garanto (1989:57),

citando al propio autor:

a) Valoracin de las necesidades y fijacin del problema que surge del contraste

entre los logros reales de un programa y los que se pretendan obtener: las

necesidades permiten identificar y fijar las metas educativas.

b) Planificacin del programa, a partir de la informacin sobre los programas

posibles para cubrir las necesidades detectadas.

c) Evaluacin de la instrumentalizacin que permita, si el programa no se est

desarrollando segn lo previsto, la modificacin del programa mismo.

d) Evaluacin de progresos o evaluacin del logro o no de los objetivos pro-

puestos.

e) Evaluacin de los resultados, que permita la certificacin/adopcin de un

programa por parte de quienes toman las decisiones, o por el contrario, la

revisin, modificacin del programa o la Implantacin de uno nuevo.

Como observamos, esta propuesta evaluativa, dentro de la corriente decisoria

nos aporta interesantes referencias y datos a tener presente en el desarrollo de un

programa, a fin de Ir regulando su implementacin, en funcin de necesidades e

instrumentalizacin, y no slo por los resultados.

4.4. Modelo de evaluacin respondente

Elaborado por Stake (1967, 1975) y conocido al principio como mtodo de

evaluacin de la figura, entendindola como la imagen total de la misma, una

especie de red o mapa donde se puedan ubicar y adaptar los distintos mtodos y

modelos evaluativos. Este autor es sensible a las necesidades e intereses de la au-

diencia. Por eso la primera fase de la evaluacin son los problemas y para poder

saber cules son, propone que hay que hablar con la gente, con los implicados (de

ah la denominacin de evaluacin centrada en el cliente). Estos problemas son las

reas de desacuerdos, las dudas, las preguntas que la audiencia se hace. Deben

utilizarse para discusiones y para organizar el plan de recogida de datos, las accio-

nes correspondientes y la bsqueda de soluciones. Otro aspecto a considerar es

que los evaluadores deben escribir programas con relacin tanto a los anteceden-

tes y las operaciones como a los resultados.

Otros dos elementos sustanciales de su modelo es el tratamiento que le da los

observadores, como los mejores instrumentos de evaluacin para muchos proble-

mas, y la validacin, no estando completa la evaluacin hasta que no se emiten

juicios de valor. Asimismo, cree que los efectos secundarios y los logros accidenta-

les deben ser tan estudiados como los resultados buscados y que los evaluadores

deben evitar la presentacin de conclusiones finales resumidas.

Este modelo se presenta en forma de reloj por tener doce fases, empezando en

las doce en punto y terminando tambin en este mismo lugar. Lo presenta as

porque la informacin y la observacin deben ser continuas y estar presentes en

todas las fases:

a) Hablar con los clientes, el personal del programa y las audiencias.

- Identificar el alcance del programa.

- Panorama de las actividades del programa.

- Descubrir los propsitos e intereses.

- Conceptualizar las cuestiones y los problemas.9

Universidad de Huelva 2009

XX1

R e v i s t a de E d u c a c i n

- Identificar los datos necesarios para investigar los problemas.

- Seleccionar observadores, jueces e instrumentos si los hay.

- Observar los antecedentes, las transacciones y los resultados propuestos.

- Desarrollar temas, preparar descripciones y estudiar casos concretos.

- Validacin: confirmacin, bsqueda de evidencias para la no confirma

-cin.

- Esquema para uso de la audiencia.

- Reunir los Informes formales, si los hay.

b) Hablar con los clientes, el personal del programa y las audiencias.

Comprobamos claramente que muchas de estas recomendaciones son esen-

ciales para garantizar el xito de la aplicacin y evaluacin de cualquier pro-

grama en general, para su aplicacin y puesta en prctica en el aula, as como

para la extraccin de conclusiones fiables y vlidas sobre sus resultados.

4.5. Modelo de evaluacin iluminativa

Propuesto por Parlett y Hamilton (1977), la evaluacin iluminativa aparece como

una estrategia holstica que surge en el contexto de proyectos curriculares

Innovadores, vinculado a un paradigma de investigacin antropolgica, como al-

ternativa a los modelos de corte cuantitativo, al considerarlos como inadecuados y

limitados para dilucidar los complejos problemas con los que se enfrentan.

Segn Prez Gmez (1983:441), las caractersticas ms relevantes del modelo

son:

a) Los estudios sobre evaluacin deben comprender una tendencia holstica y

tener en cuenta el amplio contexto en el que funciona.

b) Se preocupan ms de la descripcin e Interpretacin que de la medida y la

prediccin.

c) Se orientan al anlisis de los procesos ms que al anlisis de los productos.

d) La evaluacin se desarrolla baj condiciones naturales o de campo y no bajo

condiciones experimentales.

e) Los mtodos principales de recogida de datos son la observacin y la entre

-vista.

f) El investigador al presentar el informe tendr que agudizar la discusin, ais-

lar lo significativo de lo trivial y facilitar la profundizacin en el debate.

Stufflebeam y Shinkfield (1989), por su parte, indican las siguientes:

a) Observacin: de todas las variables que afecten al resultado del programa

(registro de datos, grabaciones, etc.).

b) Investigacin: seleccin y planteamiento de preguntas sobre el programa en

su contexto (entrevistas, cuestionarios, test, etc.).

c) Explicacin: se ven las posibles relaciones causa-efecto en sus operaciones.

En este modelo es importantsimo tener en cuenta los componentes del contex-

to donde surge y se desarrolla un programa: el sistema instructivo (plan de estudio

o programa de contenidos) y el ambiente de aprendizaje (las relaciones entre va-

riables culturales, sociales, institucionales y psicolgicas).

La funcin principal de la evaluacin iluminativa es la de comprender, descri-

bir e interpretar, de una forma amplia e inmersa en la realidad, los procesos

190

curriculares innovadores, tratando de ver las relaciones entre las creencias y las

prcticas, la organizacin y las concepciones de los sujetos. No slo son Importan-

Universidad de Huelva 2009

A

b4

0

tes los hechos sino tambin las interpretaciones que hagan de ellos las personas

implicadas. Como indica Garanto (1989: 58), tiene como finalidad analizar cmo

funciona, cmo es influido por las diferentes situaciones escolares, en dnde se

aplica y qu ventajas o desventajas ven aqullos que estn directamente Implica-

dos. Su objetivo es descubrir lo que los alumnos y enseantes participantes en el

proyecto experimentan, y cules son los aspectos ms importantes, los procesos

crticos y los fenmenos concomitantes y recurrentes .

En definitiva, el modelo iluminativo nos aporta clarificacin sobre un progra-

ma, donde el rango de innovador exige un anlisis minucioso y pormenorizado de

toda la situacin escolar para descubrir, con los profesores y alumnos implicados,

las virtualidades y limitaciones del mismo.

4.6. Modelo de evaluacin sin referencia a los

objetivos (metas)

Fue propuesto por Scriven (1967) y tiene la peculiaridad de obviar los objetivos

del programa, creyendo que con esta ignorancia por parte del evaluador, ser ms

objetivo al evaluar los resultados (previsto o no) del programa.

La evaluacin aqu se ve como un proceso que implica una descripcin y un

juicio de valor. Segn Scriven la realidad tiene valor, pero este valor hay que con-

siderarlo en dos sentidos: un valor libre de contexto o intrnseco, mrito, y un

valor dentro de un contexto, dignidad o valor. Estos valores son variables segn los

distintos indicadores que las personas tengan de ellos, audiencia, y de la situacin.

Realiza una distincin entre evaluacin formativa y evaluacin sumativa. Por

ser dos tipos de valor, su determinacin se hace con diferentes tipos de evaluacin:

a) Formativa: Esta evaluacin es llevada a cabo por los mtodos cualitativos. Es

parte integrante del proceso de desarrollo. Trata de refinar y mejorar los

criterios y los juicios sobre aspectos Intrnsecos de las realidades evaluadas.

b) Sumativa: Trata de determinar los impactos en el contexto en el que se obtie-

nen los resultados. Debe de realizarse por un experto que aumente la objeti-

vidad. Los resultados deben hacerse pblicos. Ayuda a decidir si se modifica

o no el currculum.

Este modelo lo que trata es de evaluar el programa en sus efectos, al margen de

los objetivos previstos, siendo los criterios que se siguen las necesidades de los

sujetos a los que va dirigido el programa. En la prctica evaluativa de programas

educativos, no ha tenido un gran desarrollo, debido sobre todo a que representa

un posicionamiento ideolgico sobre la evaluacin ms que un mtodo de actua-

cin suficientemente definido y estructurado.

4.7. Modelo de evaluacin basado en la crtica

artstica

Propuesto por Eisner (1975), aporta una concepcin humanstico-crtica de la

evaluacin, donde la enseanza es un arte y el profesor un artista, para lo cual se

apoya en el currculum como una realidad cultural que encarna normas y reglas

implcitas de la cultura.

Est de acuerdo con el modelo iluminativo pero cree que el investigador no

evala porque no tiene inters en mejorar la cultura, sino que lo que pretende es

mejorar la educacin. Para ello necesita tres condiciones:

a) Disponer de valores, para poder juzgar sobre el mrito y la dignidad de un

proceso educativo.

b) Conocimiento refinado, arte de la apreciacin. Es personal y exige un desa-

rrollo, un afinamiento, de la capacidad de percepcin.

Universidad de Huelva 2009

XX1

Revista de Educacin

c) La crtica evaluativa, arte de dar a conocer al otro los conocimientos obtenidos.

E ste modelo responde a la siguiente estructura: descripcin (para poder ver los

contenidos); interpretacin (para poder comprender los hechos); evaluacin (del

valor educativo segn criterios) y conclusin (generalizacin).

4.8. Modelo de evaluacin democrtica

McDonald (1973) propone un modelo que acepta la complejidad de los proce-

sos educativos bajo un planteamiento holstico o unitario. Se sita en un plantea

-miento eminentemente cualitativo, dentro de una visin naturalista de la realidad.

E l modelo de evaluacin democrtica surge en un marco terico pero tiene en

cuenta el factor poltico, por lo que muchos autores lo sitan a caballo entre los mode-

los prcticos y los crticos. McDonald (1985) piensa que las distintas formas de eva-

luacin responden a diferentes posiciones sobre la distribucin del sistema educativo.

Tambin seala que la informacin de la evaluacin sirve a diversos intereses polti -

cos. Su idea es la de llamar la atencin hada una dimensin de la evaluacin orientada

por valores. l mismo dasifica los estudios de evaluacin en tres tipos:

Burocrticos. Son trabajos que les sirven a las agencias gubernamentales con

poder para distribuir los recursos educativos:

- E l evaluador acepta los valores de la autoridad, y ofrece la informacin

necesaria para conseguir sus objetivos polticos.

- Las tcnicas deben ser crebles y eficaces.

- Los informes pertenecen a la administracin.

Autocrticos. E s un servido condicional a las agencias con poder para distri-

buir los recursos:

- E l evaluador se preocupa de determinar el valor educativo de su poltica

y actuar como consejero experto.

- Las tcnicas deben ser cientficas, respaldadas por la comunidad de cientficos.

- Los informes son burocrticos y cientficos: se publican.

- Si sus recomendaciones no se siguen no se valida la poltica.

- Se rige por los principios, la objetividad y la responsabilidad profesional.

Democrticos. E s un servido de informacin a la comunidad entera sobre las

caractersticas del programa educativo. E s un estudio negociado, basado en

el derecho de saber, y cuyos conceptos claves son negociacin,

confidencialidad y accesibilidad:

- Reconoce la pluralidad de valores, y busca la forma de integrar los dife-

rentes intereses en la investigacin.

- E l investigador es un agente honesto que busca recoger las definiciones y

las reacciones al programa. Y su rol es democratizar el conocimiento.

- Las tcnicas de recogida de datos y de presentacin son accesibles a per-

sonas no especialistas.

- La tarea principal consiste en presentar las diversas visiones del progra-

ma, manteniendo el secreto a los informantes.

- Los informes pertenecen a los informantes. E llos tienen el control sobre el

uso de la informacin.

- La finalidad de la evaluacin democrtica es proporcionar datos relevan-

tes para los que tienen que tomar decisiones, iluminando las prioridades,

I92 los valores y las circunstancias.

Universidad de Huelva 2009

O

A 4

- Criterio de xito: el nmero de personas a las que puede ayudar.

Algunas limitaciones del modelo se encuentran en el poder y utilidad de la

Informacin, al no ser neutral el evaluador ante las audiencias y el rigor la preci-

sin que se emplee en la exposicin de planteamientos y conceptos.

Creemos oportuno sealar las referencias de Moreno, Delgado y Sanz (1996:389)

a los modelos de evaluacin transaccional y de Lombana:

a) El modelo de evaluacin transaccional

El modelo de Atkinson, Furlong y Janoff (1979) propone que ha de hacerse

una evaluacin transaccional o del proceso y una evaluacin de los produc-

tos o efectos, que van a depender del tipo de informacin que se maneja

(cualitativa/descriptiva o cuantitativa). Si interrelacionamos los dos tipos de

evaluacin y las dos fuentes de informacin obtendramos cuatro categoras

de datos que pueden interesar para ser utilizados con audiencias concretas.

El cuadro siguiente representa las citadas categoras:

Informacin cualitativa/descriptiva

CATEGORA I: Datos cualitativos- CATEGORA II: Datos cualitativos -

transaccionales. producto.

Qp Informacin descriptiva pue- Qu informacin cuantitativa pue-

de ser aportada para fundamentar de ser aportada para establecer los

lo que hace el orientador? efectos de la intervencin orienta-

dora?

CATEGORA III: Datos cuantitativos-

CATEGORA IV: Datos cuantitativos -

transaccionales.

producto.

Qp Informacin cuantitativa pue-

Qu Informacin descriptiva pue-

de ser aportada para fomentar lo

de ser aportada para establecer los

que se hace el orientador?

efectos de la intervencin orienta-

dora?

Informacin cuantitativa

Cuadro 1. Categoras de datos en el modelo de evalucacin transaccional

(Moreno, Delgado y Sanz, 1996:389)

b) El modelo de Lombana

El modelo de Lombana (1985), distingue dos tipos de objetivos y dos tipos

de procedimientos de evaluacin. Por un lado, estaran los objetivos del cliente

(el estudiante) y, por otro, los del programa (institucional). En relacin a los

procedimientos de evaluacin, considera la evaluacin emprica y la evalua-

cin valorativa u orientativa: la primera, nos permite conocer si un objetivo

se ha logrado y, la segunda, nos da conocer los juicios de valor de las perso-

nas implicadas. De la combinacin entre los dos tipos de objetivos y los dos

tipos de procedimientos de evaluacin obtenemos las categoras que se re-

presentan en el siguiente cuadro.

Evaluacin emprica

CATEGORA I El orientador logr CATEGORA II Los estudi antes cam-

la tarea identificada en el objetivo? biaron su conducta como resultado

de los esfuerzos del orientador?

CATEGORA III Cmo perciben CATEGORA IV Cmo perciben

otros la efectividad del logro del otros la efectividad en los cambios

orientador? de conducta del estudiante?

Evaluacin orientativa

Cuadro 2. Categoras de datos en el modelo de Lombadal (Moreno, Delgado

y Sanz, 1996:389)

193

W

u v

^b

b

p

rn

E.

n

o

>w

c

O-^

O

N

^ D

c^

Universidad de Huelva 2009

XXI

R e v i s t a d e E d u c a c i n

A nuestro entender, cada uno de los modelos presentados nos aporta elementos

que pueden servirnos de orientacin en el proceso evaluador. Sin embargo, hay

que tener muy en cuenta que la tendencia actual en orientacin es la utilizacin de

los modelos comprensivos o globalizados.

5. Fases y propuestas prcticas para la

evaluacin de programas

Considerando que la evaluacin debe orientar el proceso de diseo, desarrollo

y la misma evaluacin, partiremos de la premisa de que sta no puede hacerse slo

al final para valorar los resultados, sino que deber estar presente de forma per-

manente actuando como un instrumento eficaz que nos aporte las informaciones

precisas para poder tomar decisiones razonadas. Como mantiene Wilson (1992), la

evaluacin tiene que ser una actividad inseparable del rol profesional del Orienta-

dor. En la misma lnea De Miguel (1985) entiende que la evaluacin de la orienta

-cin implica la bsqueda de indicadores para valorar los Programas, los procesos

y los resultados. No obstante, y sin perder de vista la continuidad que caracteriza

al proceso evaluador, las distintas aportaciones analizadas hacen referencia clara

a momentos puntuales para evaluar y a aspectos concretos que, necesariamente,

han de evaluarse. Estos momentos son:

- Evaluacin inicial de las necesidades que justifican el diseo del programa.

- Evaluacin del propio diseo.

- Evaluacin del desarrollo.

- Evaluacin de los resultados.

Sanz (1990:64-71), apoyndose en las aportaciones de diferentes autores esta

-blece un plan de evaluacin con cinco pasos bsicos. Para l, la evaluacin tiene

que verse como el ncleo central del programa, interactuando con todos los dems

elementos fundamentales de ste. El proceso de evaluacin del programa de orien-

tacin pasa por los siguientes pasos bsicos:

a) Anlisis de necesidades. El objetivo es determinar los indicadores en los que

basar el xito del programa, utilizando el dilogo con los implicados en el

mismo y apoyndose en instrumentos de recogida de informacin.

b) Establecimiento de metas y objetivos. A partir de la priorizacin de las nece-

sidades, se fijan las metas que constituyen los logros finales que se desean

conseguir, enuncindose como conductas generales que no son directamen-

te medibles, establecindose a la vez objetivos de rendimiento observables y

medibles.

c) Diseo del programa. El siguiente paso es la planificacin de actividades, su

temporaiizadn, los recursos necesarios y el costo.

d) Modificacin y mejora del programa. Realizada gracias a la evaluacin con-

tinua.

e) Informe y utilizacin de los resultados del programa. Se debe dirigir a todas

las partes implicadas. Con los datos obtenidos, podremos basar nuestras de-

cisiones, comprobar si los procedimientos de evaluacin fueron los apropia-

dos y si el programa produjo los resultados esperados en los alumnos.

En la aportacin de Prez Juste (1997:125-145), aparecen tres momentos crti-

cos de la evaluacin de programas con las siguientes recomendaciones:

- Primer momento: Hacer una evaluacin del programa como documento aten

-diendo a las siguientes dimensiones:

- Contenidos, calidad tcnica y evaluabilldad.

194 - Adecuacin a los destinatarios.

Universidad de Huelva 2009

A

- Nivel de viabilidad.

Segundo momento: Hacer una evaluacin procesual considerando las dimen-

siones siguientes:

- Ejecucin: actividades, secuencia, temporalizacin, etc.

- Marco: clima social, coherencia institucional, etc.

Tercer momento: Evaluar el producto obtenido considerando las dimensiones:

- Medida y logros: constatacin, contraste...

- Valoracin: criterios, referencias...

- Continuidad: decisiones, incorporacin de las mejoras, seguimiento,...

El mismo autor nos presenta los criterios y las sugerencias a tener en cuenta en

cada una de las fases o momentos de la evaluacin de programas. En relacin a los

criterios apunta los siguientes:

a) Respecto a la evaluacin del programa en s mismo:

- Para evaluar la calidad intrnseca del programa: coherencia con las bases

socio-psico-pedaggicas; grado de especificacin de los objetivos, los me-

dios y la evaluacin; nivel de coherencia/congruencia y grado de rele-

vancia de la informacin.

- Para evaluar la adecuacin a los destinatarios: la coherencia interna, la

congruencia externa, la sensibilizacin del personal, la participacin y el

consenso existente.

- Para evaluar la viabilidad o adecuacin a la situacin de partida: realismo

en las metas, existencia de apoyos y de recursos y capacitacin del profe-

sorado.

b) Respecto a la evaluacin del programa en su desarrollo:

- Para evaluar la ejecucin del programa: conformidad con el plan (desfases,

resultados parciales, efectos no planteados).

- Para evaluar el marco: incardinacin efectiva en el proyecto general y

satisfaccin del personal.

c) Respecto a la evaluacin del programa en sus resultados:

- Para evaluar los logros y hacer valoraciones: circunstancias, normatividad,

criterialidad, idiosincrasia...

- Para evaluar la continuidad: participacin, control interno del plan y sis

-tema de revisin.

En cuanto a la metodologa a seguir en cada fase, el autor nos recomienda lo

siguiente:

a) En relacin a la evaluacin del programa en s mismo:

- Para evaluar la calidad intrnseca del programa: el anlisis de contenido y

el juicio de expertos (cientficos, tcnicos, pedaggicos y metodolgicos).

- Para evaluar la adecuacin a los destinatarios: el anlisis de contenido, el

contraste con datos de observacin, los estudios prospectivos y el anlisis

de la demanda.

- Para evaluar la viabilidad o adecuacin a la situacin de partida: contras-

te recursos/exigencias, entrevista con el personal y observacin de la rea-

lidad.

b) En relacin a la evaluacin del programa en su desarrollo:

- Se tendr en cuenta la complementariedad metodolgica, utilizando la

observacin, el dilogo, las entrevistas, el anlisis de tareas, las pruebas

formativas, etc. 1 9 4 5

Universidad de Huelva 2009

XX1

R e v i s t a de E d u c a c i n

c) En relacin a la evaluacin del programa en sus resultados:

- Para evaluar los logros y hacer valoraciones se pueden emplear. pruebas

de diversa naturaleza, inventarios, cuestionarios, escalas, diseos experi-

mentales, diseos cuasi-experimentales, tcnicas correlacionales, diseos

longitudinales y tratamiento cuantitativo-cualitativo.

- Para evaluar la continuidad: diseos longitudinales, estudios de casos,

anlisis de documentos y tratamiento cuantitativo/cualitativo.

Momentos Qu se evala? Dimensiones Finalidad

Evaluacin El propio Programa Calidad formal Los aspectos formales

nidal Maquetadn

(antes) Estructura

Calidad de los Grado de aceptacin

contenidos Respuesta a necesidades

Evaluabllidad

Adecuacin a Implicacin

destinatarios Inters

Adecuacin al Viabilidad

contexto Recursos

Medios

Evaluacin El desarrollo del Ejecucin del Estrategias

continua Programa Programa Organizacin

(durante) Interaccin

Marco contextual Nivel de incidencia

Evaluad Los resultados Resultados Efectividad

sumativa conseguidos

Valoracin Enjuiciar aportaciones (al final) con el Programa

Consecuencias Implicaciones

Toma de decisiones

Continuidad

Cuadro 3: Propuesta para evaluacin de programas

(Adaptacin de Prez Juste 1995:86)

Basndose en todo lo anterior, Prez Juste (1997:147-150) recomienda las pau-

tas siguientes para hacer la evaluacin de programas. Se trata de una propuesta

interesante que puede guiamos en un trabajo de investigacin. La aportacin es la

siguiente:

a) Evaluacin del programa en s mismo

a. 1. Calidad intrnseca del programa

Contenido del programa:

- Se han explicitado las bases cientficas y socio-psicolgicas del pro-

grama?

- El tratamiento dado a los acontecimientos, temas o teoras, es ade-

cuado/distorsionado/desequilibrado?

- Estn actualizados o desfasados los contenidos?

- Los contenidos que incluye se consideran relevantes, desde pers-

pectivas cientficas, sociales, psicolgicas y pedaggicas?

196 Calidad tcnica del programa:

Universidad de Huelva 2009

A

D ^

4 D

O ^

V

- Se incluyen en el programa objetivos, actividades, medios, la me-

todologa y el sistema de evaluacin?

- La formulacin de los elementos anteriores, es adecuada para orien-

tar tanto la enseanza como el aprendizaje?

- Se puede considerar que los objetivos son congruentes con los plan-

teamientos cientfico-curriculares, con las demandas sociales y con

las caractersticas evolutivas de los destinatarios?

- Se da coherencia interna entre los diversos elementos del progra-

ma y de ellos en relacin con los objetivos?

- Se da adecuacin del programa a las caractersticas diferenciales

del alumnado: motivacin, intereses, capacidad?

Evaluabilidad:

- La informacin contenida en el programa de cara a su posterior

evaluacin, se considera suficiente, relevante y adecuada?

- Se dispone de informacin clara y precisa sobre los aspectos

metodolgicos y de contenido del programa?

a.2. Adecuacin al contexto

- Se da un funcionamiento democrtico, participativo e implicativo del

Centro, as como corresponsabilidad en las tareas?

- Los profesores responsables del programa, funcionan en autntico

equipo?

- Se da cooperacin con las familias cuando es necesaria para el desa-

rrollo del programa?

- Se dan reuniones con profesores de cursos anteriores de cara a la

planificacin del nuevo programa?

- Existen datos (registros, informes, actas...) en el Centro sobre las ne-

cesidades y carencias de los alumnos?

- Se cuenta con sistemas de deteccin de necesidades y carencias del

alumnado, tales como pruebas de carcter diagnstico, entrevistas...?

- Se ha previsto un sistema de ajuste inicial a las carencias y dificulta-

des detectadas, tales como clases de recuperacin, sistemas de

monitores..

a.3. Adecuacin al punto de partida

- Responde el programa a las demandas de los interesados?

- Estn previstos los espacios, momentos en el horario, recursos y per-

sonal necesarios para su desarrollo?

- Existen en el Centro los medios necesarios para un correcto desarro-

llo del programa?

- Est prevista la temporalizacin del programa?

- Se realizan reuniones del equipo de profesores responsables del pro-

grama?

- Se da entre el equipo de profesores, y en el Centro en general, un

trabajo de tipo cooperativo?

- Ha sido aprobado el programa por el equipo?

- Apoyan el programa el claustro de profesores, los padres y dems

personal Implicado/afectado?

b) Proceso de aplicacin del programa

b.1. Puesta en marcha del programa 1,97

Universidad de Huelva 2009

XXI

Revista de Educacin

- La metodologa utilizada, resulta adecuada para el desarrollo de los

objetivos del programa?

- Muestran los alumnos inters/motivacin hacia las actividades del

programa?

- Se aprecia correccin en la secuencia de las actividades programadas?

- Se detectan desfases significativos en la temporalizacin prevista?

- Se respeta la planificacin en lo referente a espacios, tiempos, apoyos

y recursos?

- Los niveles parciales de logro se consideran alejados o acomodados a

los propuestos?

- Se da rigidez o flexibilidad en la aplicacin del programa?

b.2. Marco de aplicacin del programa

- Se aprecian conflictos y tensiones entre el personal del Centro que

puedan repercutir en el desarrollo del programa?

- Las relaciones con el alumnado, se pueden calificar de cordiales o

problemticas?

- Se detecta algn conflicto entre los objetivos y/o planteamientos del

programa con los del proyecto educativo o con los de otros profesores

del equipo o del Centro?

- Se da concordancia entre la organizacin y disciplina del aula en que

se desarrolla el programa y el sistema organizativo y disciplinar del

Centro?

- Se da un clima de confianza en el xito por parte de los alumnos y

profesores?

c) Evaluacin final del programa

c. 1. Medida y logros

- Se han tomado precauciones para asegurar la calidad tcnica de las

pruebas con que se apreciarn los niveles de logro del programa?

- Se planificaron las pruebas y dems instrumentos elaborados para la

recogida de datos en el momento de disear el programa, a fin de

asegurar la mxima coherencia con los objetivos?

- Se recurre a tcnicas variadas de recogida de datos, acordes con la

diversidad de objetivos?

- Se especificaron los criterios de calificacin y de los niveles de logro

del programa?

c.2. Valoracin

- Se especificaron, de modo claro y preciso, los criterios y las referen-

cias para valorar los resultados?

- Se aplican criterios y referencias de conformidad con las previsiones

y con las exigencias tcnicas?

- Se dispone de informacin, rica y matizada, sobre los momentos ini-

cial y procesual del programa, como base para valorar los resultados?

c.3. Continuidad

- El estilo imperante entre los responsables del programa, es

participativo y colaborativo, o directivo y autoritario?

- Existe un proceso institucionalizado de evaluacin, de forma que los

198

resultados se plasmen en nuevos procesos programadores?

Universidad de Huelva 2009

O

D: ^o

4 alb D

eC^4

V

- Se asignan tareas concretas a los diferentes responsables de los cam-

bios a introducir?

Por otra parte, Zabalza (1977:88) recomienda que los pasos en la evaluacin de

un programa educativo deben ser los siguientes:

a) Especificacin de los objetivos que se desean evaluar y razn para evaluarlos.

b) Transformacin de los objetivos educativos en tipos o niveles de eficiencia.

c) Seleccin de las variables relevantes que se vayan a utilizar.

d) Seleccin y construccin de los instrumentos de obtencin de datos.

e) Determinacin de la muestra y el campo de utilizacin para obtener las infor-

maciones necesarias.

f) Recoger los datos, ordenarlos y analizarlos para obtener el diagnstico de la

situacin que se evala.

g) Interpretacin y valoracin de datos, mostrando posibles alternativas de ac-

cin.

h) Toma de decisiones respecto a la permanencia, modificacin o abandono del

programa.

Del Carmen (citado por Parcerisa, 1996: 70), seala que junto al material dise

-ado para el alumnado debe elaborarse una gua didctica y propone como di-

mensiones de anlisis las siguientes:

a) Caracterizacin general (mbito de aplicacin del proyecto, descripcin de

los materiales, objetivos generales...).

b) Adecuacin al curriculum prescriptivo (correspondencia entre los objetivos

generales del proyecto y los del currculum prescriptivo; entre unos y otros

contenidos...).

c) Adecuacin a los criterios que comparte el equipo de profesores que va a

utilizar los materiales (acomodacin de la propuesta al Proyecto Curricular

de Centro, acuerdo del quipo docente con los objetivos generales del proyec-

to y con la orientacin en el tratamiento del rea o reas...).

6. Dificultades en la evaluacin de programas

El proceso evaluador de los programas de orientacin no va a estar exento de

algunas dificultades. Resumiendo las ideas aportadas por distintos autores pode-

mos establecer dos grandes grupos:

a) Dificultades organizativas. Es conveniente tener en cuenta aquellos proble-

mas que nos podamos encontrar durante las fases del proceso, siendo algu-

nos de ellos los siguientes:

- Desvinculacin del profesorado y el centro en la planificacin y el diseo

del programa.

- No Inclusin del programa en el proyecto educativo del centro, por lo que

se ve como algo aislado y ajeno.

- No establecimiento de responsabilidades y grado de implicacin de los

distintos miembros de la comunidad educativa en el desarrollo del pro-

grama.

- Participacin de personas ajenas al centro en tareas de observacin y

evaluacin.

- Seleccin de los grupos.

- Formacin del Profesorado.1

Universidad de Huelva 2009

xxi

Revista de Educacin

b) Dificultades didcticas. Las principales que podemos encontrar giran en tor-

no a:

Falta de concordancia entre los objetivos del programa y los del centro.

- Delimitacin de objetivos, metas y criterios evaluativos. En este sentido

es bastante clarificador la postura defendida por Rodrguez Espinar

(1993:591) sobre la dificultad de medir los objetivos si no han sido for-

mulados en resultados de conducta cuando afirma: No hay tampoco una

-nimidad entre los profesionales sobre cules son los resultados ms ade-

cuados para medir los logros en orientacin, y, por ltimo, a veces cuesta

decidirse por unos resultados a corto plazo, de lo que resulta fcil recoger

informacin, o por otros, ms a largo plazo, como indicadores de la efec-

tividad del programa.

- Saber interpretar los resultados de la evaluacin.

Referencias

ALKIN, M.C. (1969): Evaluation Theory Developemente, en Ucla CSE. Evaluation

Coment, 2; 2-7.

LVAREZ ROJO, V. (1987): Metodologa de la orientacin educativa. Sevilla, Alfar.

ATKINSON, D.R.; FURLONG, M.J. y JANOFF, D.S. (1979): A four-component model

for proactive accountability in school counselind, School Counselor, 37; 23-

30.

AUBREY, R. (1982): Program Planning and Evaluation: Roal Map of the 80's, en

Elementary School Guidance, 15; 188-193.

CASANOVA, M. A. (1992): L a evaluacin, garanta de calidad para el Centro educa

-tivo. Madrid, Edelvives.

CASTILLO, S. y GENTO, S. (1995): Modelos de evaluacin de programas educati-

vos, en MEDINA, A. y VILLAR, L.M.: Evaluacin de Programas Educativos,

Centros y Prof esores. Madrid, UNED; 25-69.

CRONBACH, L.J. (1963): Course Improvement through evaluation, en Teachers

college record, 64, 672-683.

DE LA ORDEN, A. (1997): Evaluacin y optimizacin educativa , en SALMERN, H.

(Ed.): Evaluacin educativa. Granada, Grupo Editorial Universitario; 13-28.

DE MIGUEL, M. (1985): Evaluacin de la investigacin orientadora , en Congreso

de Orientacin Escolar y Prof esional. Madrid.

EISNER, E. W. (1975): The Perceptive Eye: Toward the Ref ormation of Educational

Evaluation. Stanford (Calif.): Standard Evaluation Consortium.

ESTEBARANZ, A. (1995): Didctica e innovacin curricular. Sevilla, Universidad de

Sevilla.

GARANTO, J. (1989): Modelos de evaluacin de programas educativos , en ABAR-

CA, M.P.: L a evaluacin de programas educativos. Madrid, Escuela Espaola.

GADE, E. (1981): How to evaluate a School Guidance Program, en WALZ, G.R. y

otros: Resources f or Guidance Program Improvement. Michigan, ERIC/CAPS,

Ann Arbor.

GIMENO, J. (1992): El currculum: los contenidos de la enseanza o un anlisis

de la prctica ?, en GIMENO, J. y PtREZ, A.I.: Comprender y transf ormar la

enseanza. Madrid, Morata.

GUBA, E.G. (1978): Wtoward a Methodology of Naturalistic Inquiry in Educational

Evaluation, los Angeles, UCL A, Center f or the Study of Evaluation.

LOMBANA, J.H. (1985): Guidance accountability: A new lok at an old problem, en

200Schooll Counselor, 32; 340-346.

Universidad de Huelva 2009

4

0

McDONALD, B. (1973): Humanities Curriculum Project, en TAWNEY, D. (Ed.):

Evaluation in Curriculum Developmen: Twelve Case Studies. Londres,

McMillan.

McDONALD, B. (1985): La evaluacin y el control de la educacin, en GIMENO, J,

y P R E Z , A.: La enseanza, su teora y su prctica. Madrid, Akal; 467-478.

McDONALD, B. (1992): Mejora de los centros escolares, eficacia escolar y evalua-

cin: una perspectiva internacional, en ALVAR E Z , M. (Coord.): La direccin

escolar: formacin y puesta al da. Madrid, E scuela E spaola, 93-109.

MEC (1989): Diseo Curricular Base. Educacin Primaria. Madrid, Ministerio de

E ducacin y Ciencia.

MEC (1989): Libro Blanco para la Reforma Educativa. Madrid, Ministerio de E duca

-cin y Ciencia

MOR E NO, F.; DE LGADO, J. y SANZ, R. (1996): Diseo de programas de orienta-

cin, en BISQUERRA, R. y ALVAR E Z GONZ LE Z , M. (Coords.): Manual de Orien-

tacin y Tutora. Barcelona, Praxis; 355-381.

MOR E NO, F., DE LGADO, J. y SANZ, R. (1996): E valuacin de programas de Orienta-

cin, en BISQUERRA, R. y ALVAR E Z GONZALEZ, M. (Coords.): Manual de Orien-

tacin y Tutora. Barcelona, Prxis; 383-398.

PARCERISA, A. (1996): Materiales curriculares. Cmo elaborarlos, seleccionarlos y

usarlos. Barcelona, Grao.

PARLETT, M.R. y HAMILTON, D. (1977): Evaluation and Rumination: A New

Approach to the Study of Innovative Programmes, en HAMILTON y otros

(Comp.): Beyond the Numbers Game. London, McMillan.

PARLEIT, M.R. y HAMILTON, D. (1985): La evaluacin iluminativa, en P R E Z , A.I.

y GIMENO, J.: La enseanza: su teora y su prctica. Madrid, Akal.

P R E Z G ME Z , A. (1983): Modelos contemporneos de evaluacin, en P R E Z , A. y

GIMENO, J.: La enseanza: su teora y su prctica. Madrid, Akal; 426-449.

P R E Z JUSTE, R. (1992): E valuacin de programas de Orientacin, en V Semina-

rio Iberoamericano de Orientacin. Tenerife, AEOEP.

P R E Z JUSTE, R. (Coord.) (1995): Evaluacin de programas y Centros Educativos.

Madrid, UNED.

P R E Z JUSTE, R. (1995): E valuacin de programas educativos, en ME DINA, A. y

VILLAR , L.M.: Evaluacin de programas educativos, centros y profesores.

Madrid, Universitas.

P R E Z JUSTE, R. (1995): Metodologa para la evaluacin de programas educati-

vos, en ME DINA, A. y VILLAR , L.M. (Coords.): E valuacin de P rogramas Edu-

cativos, Centros y P rofesores. Madrid, Humanitas; 107-144.

P R E Z JUSTE, R. (1997): La evaluacin de programas, en SALMERN, H. (Ed.):

Evaluacin educativa. Granada, Grupo Editorial Universitario; 111-150.

POPHAM, W.J. (1980): Problemas y tcnicas de la evaluacin educativa. Madrid,

Anaya.

REPETTO, E. (1987): E valuacin de P rogramas de Orientacin, en ALVAR E Z , V.

(Ed.): Metodologa de la Orientacin Educativa. Sevilla, Alfar; 247-275.

REPETTO, E. (1994): E valuacin de P rogramas de Orientacin, en REPETTO, E.;

R US, V. y P UIG, J.: Orientacin educativa e Intervencin psicopedaggica.

Madrid, UNED; 879-901.

RODROGUEZ E SP INAR , S. (Coord.) (1993): Teora y Prctica de la Orientacin Edu-

cativa. Barcelona, PPU.

SANZ, R. (1990): Evaluacin de programas de orientacin educativa. Madrid, Pir-

mide.

SCRIVEN, M.S. (1967): The methodology of evaluation, en Perspectives of

curriculum evaluation. Chicago, Rand McNally.

201

Universidad de Huelva 2009

XXI

Revista de Educacin

STAKE, R.E. (1967): Towards a technology for the evaluation of educational

programs, en TYLER, R.W., GAGN, R.M. y SCRIVEN, M. (Eds.): Perspectives

of curriculum evaluation. Chicago, Rand McNally.

STAKE, R.E. (1967): The countenance of educational evaluation, en Teachers

College Record, 68, 523-544.

STAKE, R.E.(1975): Program evaluation, particularly responsive evaluation, en

Ocasional Paper Series, n5. University of Western Michigan.

STUFFLEBEAM, D.L. y SHINKFIELD, A.J. (1989): Evaluacin sistemtica. Gua terica

y prctica. Barcelona, Paids/MEC.

STUFFLEBEAM, D.L. y SHINKFIELD, A.J. (1995): Evaluacin sistemtica. Barcelona,

Paids/MEC.

TEJADA, J. (1999): La evaluacin: su conceptualizacin, en JIMNEZ , B. (Ed.):

Evaluacin de programas, centros y profesores. Madrid, Sntesis; 25-56.

TEJEDO R, F.J. y otros (1994): Perspectivas metodolgicas actuales de la evalua-

cin de programas en el mbito educativo, en Revista de Investigacin Edu-

cativa, 23; 93-127.

TYLER, R.W. (1967): Changing concepts of educational evaluation, en STAKE,

R.E. (Com.): Perspectives of Curriculum Evaluation, vol 1. New York, Rand

McNally.

WILSO N, J.D. (1992): Cmo valorarla calidad de la enseanza. Barcelona, Paids/

MEC.

Z ABALZ A, A. (1977): El proceso de evaluacin, en VARIO S: Didctica H. Madrid,

UNED.

Juan Manuel Mndez Garrido y Manuel Monescillo Palomo

son profesores del Departamento Educacin de la Universidad de Huelva.

Correos electrnicos:

jmendez@uhu.es y mnones@uhu.es

202

Universidad de Huelva 2009

También podría gustarte

- Los Modelos de OrientaciónDocumento22 páginasLos Modelos de Orientaciónricardo diazAún no hay calificaciones

- Evaluación del aprendizaje: retos y mejores prácticasDe EverandEvaluación del aprendizaje: retos y mejores prácticasAún no hay calificaciones

- Modelos de Evaluación ContemporaneoDocumento13 páginasModelos de Evaluación ContemporaneoAdmón de EmpresasAún no hay calificaciones

- Asumir la educación universitaria a partir de un modelo crítico basado en competenciasDe EverandAsumir la educación universitaria a partir de un modelo crítico basado en competenciasAún no hay calificaciones

- Ensayo Evaluación de ProgramasDocumento8 páginasEnsayo Evaluación de ProgramasZAMANTHA100% (1)

- Estrategias de evaluación: Evaluar los procesos de aprendizajeDe EverandEstrategias de evaluación: Evaluar los procesos de aprendizajeAún no hay calificaciones

- Eval de Prog (Documento)Documento17 páginasEval de Prog (Documento)araAún no hay calificaciones

- Modelos de CalidadDocumento13 páginasModelos de CalidadSofía González JeriaAún no hay calificaciones

- Elaboracion Sistema IndicadoresDocumento25 páginasElaboracion Sistema IndicadoresAntonio SánchezAún no hay calificaciones

- EVAL - DE - PRACTICA - DE - ENSENANZA - Enriquez y PandiellaDocumento24 páginasEVAL - DE - PRACTICA - DE - ENSENANZA - Enriquez y Pandiellamarina spinettaAún no hay calificaciones

- Lectura BásicaDocumento123 páginasLectura BásicaPatricio Rojas Jiménez100% (1)

- Los Elementos y Criterios para La Evaluación de Objetivos, Recursos, Currículo y Programas DidácticosDocumento7 páginasLos Elementos y Criterios para La Evaluación de Objetivos, Recursos, Currículo y Programas DidácticosJose AzuajeAún no hay calificaciones

- Antecedentes de La Investigación, Entornos VirtualesDocumento9 páginasAntecedentes de La Investigación, Entornos VirtualesChelotime La ParaAún no hay calificaciones

- Lectura Evaluacion CurricularDocumento4 páginasLectura Evaluacion Curricularjavier pardo yngaAún no hay calificaciones

- EASI Rodríguez CondeDocumento7 páginasEASI Rodríguez CondeMatíasNicolásEyheramendyAún no hay calificaciones

- Producto 12Documento5 páginasProducto 12Mitzumy TorillamaAún no hay calificaciones

- Ensayo Modelo Evaluacion CurricularDocumento27 páginasEnsayo Modelo Evaluacion CurricularJesus Gaytan90% (20)

- InvestigaciónDocumento12 páginasInvestigaciónJazmin OlmosAún no hay calificaciones

- Resumen Evaluación CurricularDocumento6 páginasResumen Evaluación CurricularFanny De La Torre Gómez100% (1)

- UN 3. Evaluacion - RESUMENDocumento29 páginasUN 3. Evaluacion - RESUMENAgustinGilabertAún no hay calificaciones

- Problemática de La Enseñanza UniversitariaDocumento16 páginasProblemática de La Enseñanza UniversitariaCarolina MoralesAún no hay calificaciones

- Ferraro - Diseño de Herramienta de Evaluación de La Capacitación - Visto AliciaDocumento15 páginasFerraro - Diseño de Herramienta de Evaluación de La Capacitación - Visto AliciaSoledad FerraroAún no hay calificaciones

- Cuadro Sinoptico de DidacticaDocumento2 páginasCuadro Sinoptico de DidacticaAmilcar Perez Cañaveral100% (2)

- M3L3 Evaluación y Mejora de La Gestión EscolarDocumento12 páginasM3L3 Evaluación y Mejora de La Gestión EscolarCamila AmadoAún no hay calificaciones

- Resumen Del Compendio de Información de EvaluaciónDocumento15 páginasResumen Del Compendio de Información de EvaluaciónLAURA BEATRIZ MARTINEZ LAZCANOAún no hay calificaciones

- Evaluación Del Aprendizaje, Una Guía Práctica PDFDocumento53 páginasEvaluación Del Aprendizaje, Una Guía Práctica PDFANGEL IGNACIO PACHECO VELASCOAún no hay calificaciones

- Articulo Arbitrado Cnel AntunezDocumento14 páginasArticulo Arbitrado Cnel AntunezJesus GomezAún no hay calificaciones

- Evaluacion EducativaDocumento9 páginasEvaluacion EducativaGenesis Tavarez MoralwsAún no hay calificaciones

- Cuáles Son Los Principales Hitos en La Biografía de TylerDocumento4 páginasCuáles Son Los Principales Hitos en La Biografía de TylerDunia Cristina Rosas VargasAún no hay calificaciones

- Pice CBTDocumento23 páginasPice CBTdactylussAún no hay calificaciones

- Tema 63Documento31 páginasTema 63alex_gil_9210100% (1)

- Evaluación Del Aprendizaje: Una Guía Práctica para ProfesoresDocumento53 páginasEvaluación Del Aprendizaje: Una Guía Práctica para ProfesoresJoany BerriosAún no hay calificaciones

- LC1-S1 Introducción A La Evaluación de Los AprendizajesDocumento14 páginasLC1-S1 Introducción A La Evaluación de Los AprendizajesJaneth Liliana Loli MonzonAún no hay calificaciones

- Condiciones de La Evaluación EducativaDocumento19 páginasCondiciones de La Evaluación EducativaMaria Del Carmen SuárezAún no hay calificaciones

- XI Evaluacion Del CurriculoDocumento8 páginasXI Evaluacion Del CurriculoDr Arlines RodriguezAún no hay calificaciones

- Sanchez Carlos Act 2Documento10 páginasSanchez Carlos Act 2Ing Carlos Sanchez100% (1)

- Evaluación Del Aprendizaje. Una Guía para ProfesoresDocumento53 páginasEvaluación Del Aprendizaje. Una Guía para ProfesoresJesús María López RojasAún no hay calificaciones

- A#4EQ10 ProyectoDocumento19 páginasA#4EQ10 Proyectodesirée torres marroquinAún no hay calificaciones

- Cuadro Comparativo Modelos de EvaluacionDocumento7 páginasCuadro Comparativo Modelos de Evaluacionvivalaaudrey67% (3)

- Guia Evaluacion Aprendizaje2010Documento54 páginasGuia Evaluacion Aprendizaje2010Agustín GarcíaAún no hay calificaciones

- Concepto de Evaluación AplicadaDocumento21 páginasConcepto de Evaluación AplicadaVictoriano Rodriguez100% (1)

- EducacionDocumento48 páginasEducacioncampeontolucaAún no hay calificaciones

- La Evaluación de Los Aprendizajes en Entornos Virtuales - Texto DescargableDocumento24 páginasLa Evaluación de Los Aprendizajes en Entornos Virtuales - Texto Descargablesara517100% (2)

- Organismos EvaluadoresDocumento30 páginasOrganismos EvaluadoresAaron CastilloAún no hay calificaciones

- Evaluación de Programas de Intervención TutorialDocumento22 páginasEvaluación de Programas de Intervención TutorialVioleta SotoAún no hay calificaciones

- La Evaluación Del CurriculumDocumento10 páginasLa Evaluación Del Curriculumkatherine hoyosAún no hay calificaciones

- Las Pruebas Estandarizadas SonDocumento6 páginasLas Pruebas Estandarizadas SonYulissa Perez100% (1)

- 2-01 y 2-02 - Fundamentos de La Evaluación CurricularDocumento4 páginas2-01 y 2-02 - Fundamentos de La Evaluación CurricularOMAR EDUARDO CHAVEZ ESPINOZAAún no hay calificaciones

- Planificación Estratégica de La Evaluación Educativa. Clase #1. Modulo VIII: 1.1.. La Evaluación y Sus Propósitos en El Ámbito EducativoDocumento7 páginasPlanificación Estratégica de La Evaluación Educativa. Clase #1. Modulo VIII: 1.1.. La Evaluación y Sus Propósitos en El Ámbito EducativoYanina JerezAún no hay calificaciones

- Evaluación CurricularLicDocumento36 páginasEvaluación CurricularLicPamela AndradeAún no hay calificaciones

- Esquema CurricularDocumento34 páginasEsquema CurricularCinthya IbarraAún no hay calificaciones

- Monografia - La Evaluacion Criterios e IndicadoresDocumento7 páginasMonografia - La Evaluacion Criterios e IndicadoresCindy Hernandez EspinozaAún no hay calificaciones

- MODELOS Alternativos DE LA EVALUACION EDUCATIVADocumento12 páginasMODELOS Alternativos DE LA EVALUACION EDUCATIVAThais SojoAún no hay calificaciones

- Evaluación CurricularDocumento12 páginasEvaluación CurricularAlan GómezAún no hay calificaciones

- PRINCIPALES TEORIAS EVALUATIVAS - EnsayoDocumento10 páginasPRINCIPALES TEORIAS EVALUATIVAS - EnsayoVivian Isabel Barboza BertelAún no hay calificaciones