Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Arboles de Regresion Ejemplo 2023-2024

Cargado por

Antonio JoseTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Arboles de Regresion Ejemplo 2023-2024

Cargado por

Antonio JoseCopyright:

Formatos disponibles

Aprendizaje

Automático

1/ 21

Tutora:

Àngela Martín

Ejemplo Técnicas inductivas mixtas

Primera Búsqueda:

Generar árbol de

Regresión

Árboles de Regresión. M5

Parámetros ω y τ

Cálculo de τ

Generar subarbol

Ejemplo

Árbol final

Tutora: Àngela Martín

10-11-2023

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

1/ 21 1 / 21

Indice

Aprendizaje

Automático

2/ 21

Tutora:

Àngela Martín

Ejemplo

Primera Búsqueda:

1 Ejemplo

Generar árbol de

Regresión Primera Búsqueda: Generar árbol de Regresión

Parámetros ω y τ

Parámetros ω y τ

Cálculo de τ

Generar subarbol Cálculo de τ

Árbol final

Generar subarbol

Árbol final

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

2/ 21 2 / 21

Indice

Aprendizaje

Automático

3/ 21

Tutora:

Àngela Martín

Ejemplo

Primera Búsqueda:

1 Ejemplo

Generar árbol de

Regresión Primera Búsqueda: Generar árbol de Regresión

Parámetros ω y τ

Parámetros ω y τ

Cálculo de τ

Generar subarbol Cálculo de τ

Árbol final

Generar subarbol

Árbol final

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

3/ 21 3 / 21

Tabla de ejemplos

Aprendizaje

Automático

4/ 21

Tutora:

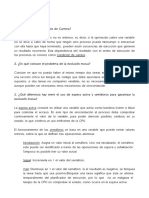

Àngela Martín La fila i, i = 1.,7, representa que una persona que haga ejercicio

(Si/No), su alimentacion sea saludable (Si/No), tome alcohol

Ejemplo (Si/No) y tenga sobrepeso (Si/No), la tasa de colesterol será la

Primera Búsqueda:

Generar árbol de

Regresión

correspondiente al valor de la columna Colesterol que es la clase.

Parámetros ω y τ

Cálculo de τ

Generar subarbol Ej. Ejercicio Alimentacion Alcohol Sobrepeso Colesterol

Árbol final (A1 ) saludable (A2 ) (A3 ) (A4 ) (Clase)

1 Si Si No No 200

2 Si Si Si No 250

3 No No Si Si 400

4 Si No No No 290

5 Si No Si No 300

6 No No No Si 450

7 Si Si No Si 220

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

4/ 21 4 / 21

Aprendizaje

Automático

5/ 21

Tutora:

Àngela Martín

Calculo de la media de los valores de la clase para los valores

Ejemplo

de los atributos

Primera Búsqueda:

Generar árbol de

Regresión

Parámetros ω y τ 200 + 250 + 290 + 300 + 220

Cálculo de τ µA1 =Si = = 252

Generar subarbol 5

Árbol final

400 + 450

µA1 =No = = 425

2

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

5/ 21 5 / 21

Aprendizaje

Automático

Cálculo de la desviación típica de los atributos

6/ 21

Segun la fórmula de la corrección de Bessel en la cual se

Tutora:

Àngela Martín

utiliza n-1 en lugar de n por no tratarse de la población

completa tenemos:

Ejemplo

s n

1

Primera Búsqueda:

X

Generar árbol de σ= (x − x )2

Regresión n−1

Parámetros ω y τ i=1

Cálculo de τ

Generar subarbol

Árbol final x es la media de los valores de la clase para el valor del atributo

y n la cantidad de ejemplos para cada uno de los dos valores

diferentes en el dominio de A1 .

q

1

σA1 =Si = ((200 − 252)2 + (250 − 252)2 + (290 − 252)2 + (300 − 252)2 + (220 − 252)2 ) = 43, 24

5−1

q

1

σA1 =No = ((400 − 425)2 + (450 − 425)2 ) = 35, 35

2−1

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

6/ 21 6 / 21

Aprendizaje

Automático

Calculo del error ponderado de A1

7/ 21

Partimos de:

Tutora:

Àngela Martín

X |Ei |

× σEi

Ejemplo i

|E |

Primera Búsqueda:

Generar árbol de

Regresión

Parámetros ω y τ

donde:

Cálculo de τ E es el conjunto de ejemplos en el nodo a dividir.

Generar subarbol

Ei son los ejemplos con valor i del atributo considerado.

Árbol final

|.| es el número de ejemplos de cada conjunto.

σEi es la desviación típica del valor de la clase en Ei .

Entonces para A1 :

5

ErrorA1 =Si = × 43, 24 = 30, 88

7

2

ErrorA1 =No = × 35, 35 = 10, 10

7

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

7/ 21 7 / 21

Aprendizaje

Automático

8/ 21

Tutora: Calculo error total

Àngela Martín

Ejemplo

Primera Búsqueda:

ErrortotalA1 = 30, 88 + 10, 10 = 40, 98

Generar árbol de

Regresión

Parámetros ω y τ Hacemos lo mismo con el resto de los atributos: A2 , A3 y A4

Cálculo de τ

Generar subarbol

Árbol final

ErrortotalA2 = 101, 60

ErrortotalA3 = 100, 54

ErrortotalA4 = 77, 81

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

8/ 21 8 / 21

Primera Búsqueda: generar árbol de regresión

Aprendizaje

Automático

9/ 21

Tutora:

Àngela Martín

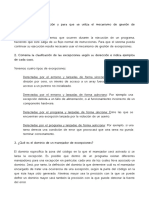

Selección del nodo raiz

Ejemplo El mejor atributo es A1 ya que es el que tiene menor error. Por

Primera Búsqueda:

Generar árbol de tanto, se crea un nodo raiz que se distingue por este atributo y

Regresión

Parámetros ω y τ que tiene dos sucesores etiquetados con los valores Si y No:

Cálculo de τ

Generar subarbol

Árbol final

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

9/ 21 9 / 21

Parámetros ω y τ

Aprendizaje

Automático

10/ 21

Tutora:

Sucesores del nodo raiz (A1 )

Àngela Martín

Necesitamos definir ω y τ .

Ejemplo ω indica el mínimo número de ejemplos del conjunto inicial

Primera Búsqueda:

Generar árbol de que debe tener un nodo para seguir subdividiendose. Gene-

Regresión

Parámetros ω y τ ralmente se escoge ω > 3.

Cálculo de τ

Generar subarbol

Árbol final

M5 no divide un nodo si tiene pocos ejemplos (en este caso

menos de 4). Weka utiliza ω = 4. No obstante, no se puede

dividir un nodo si la desviación típica de los valores de la

Clase de los ejemplos que concurren en el nodo no supera el

5 % de la desviación típica del conjunto de ejemplos inicial

(τ ).

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

10/ 21 10 / 21

Cálculo de τ

Aprendizaje

Automático

11/ 21 Cálculo de τ

Tutora:

Àngela Martín Media de los valores de la clase:

Ejemplo

Primera Búsqueda:

200 + 250 + 400 + 290 + 300 + 450 + 220

Generar árbol de µClase = = 301, 42

Regresión

Parámetros ω y τ

7

Cálculo de τ

Generar subarbol Desviación típica:

Árbol final

σClase = 86, 53

Valor para τ :

τ = 86, 53 ∗ 0, 05 = 4,32

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

11/ 21 11 / 21

Aprendizaje

Automático

12/ 21

Tutora:

Àngela Martín

Ejemplos cubiertos por cada valor de los atributos

n

Si =⇒ (1, 2, 4, 5, 7)

A1 = (1)

Ejemplo No =⇒ (3, 6)

Primera Búsqueda:

Generar árbol de

Regresión n

Parámetros ω y τ Si =⇒ (1, 2, 7)

A2 = (2)

Cálculo de τ No =⇒ (3, 4, 5, 6)

Generar subarbol

Árbol final

n

Si =⇒ (2, 3, 5)

A3 = (3)

No =⇒ (1, 4, 6, 7)

n

Si =⇒ (3, 6, 7)

A4 = (4)

No =⇒ (1, 2, 4, 5)

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

12/ 21 12 / 21

Generar subarbol

Aprendizaje

Automático

13/ 21

Tutora:

Àngela Martín

Ejemplo Tabla de los ejemplos (1,2,4,5,7)

Primera Búsqueda:

Generar árbol de Ej. Ejercicio Alimentacion Alcohol Sobrepeso Colesterol

Regresión

(A1 ) saludable (A2 ) (A3 ) (A4 ) (Clase)

Parámetros ω y τ

1 Si Si No No 200

Cálculo de τ

2 Si Si Si No 250

Generar subarbol

4 Si No No No 290

Árbol final

5 Si No Si No 300

7 Si Si No Si 220

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

13/ 21 13 / 21

Aprendizaje

Automático

14/ 21

Tutora: Calculo errores totales

Àngela Martín

Calculamos el error total de los tes atributos del modelo reducido.

Ejemplo

Primera Búsqueda:

Generar árbol de

Regresión

σA2 =Si = 15, 09 , σA2 =No = 2, 82

Parámetros ω y τ

Cálculo de τ ErrortotalA2 = 17, 91

Generar subarbol

Árbol final σA3 =Si = 35, 35 , σA3 =No = 47, 25

ErrortotalA3 = 42, 49

σA4 =Si = 0 , σA4 =No = 45, 46

ErrortotalA4 = 36, 36

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

14/ 21 14 / 21

Aprendizaje

Automático

15/ 21

Tutora:

Àngela Martín El mejor atributo es A2 ya que es el que tiene menor error y

supera el valor de τ que era 4,32. Por tanto se crea el hijo

Ejemplo izquierdo del nodo raiz.

Primera Búsqueda:

Generar árbol de

Regresión

Parámetros ω y τ

Cálculo de τ

Generar subarbol

Árbol final

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

15/ 21 15 / 21

Árbol final

Aprendizaje

Automático

16/ 21

Tutora:

Àngela Martín

Tabla de los ejemplos (1,2,4,5,7) para los atributos A2 A3 y A4

Ejemplo

Primera Búsqueda:

Generamos el subarbol del nodo A2 procediendo de la misma

Generar árbol de

Regresión manera que para el caso anterior y nos queda la siguiente tabla:

Parámetros ω y τ

Cálculo de τ

Ej. Alimentación Alcohol Sobrepeso Colesterol

Generar subarbol (A2 ) (A3 ) (A4 ) (Clase)

Árbol final 1 Si No No 200

2 Si Si No 250

4 No No No 290

5 No Si No 300

7 Si No Si 220

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

16/ 21 16 / 21

Aprendizaje

Automático

17/ 21

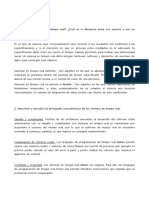

Tutora: Como hemos cogido una ω > 3 ya no podemos continuar gene-

Àngela Martín

rando subarboles puesto que ninguno de los nodos tiene más de

Ejemplo

tres de los ejemplos del conjunto original. El arbol resultante es

Primera Búsqueda:

Generar árbol de

el siguiente:

Regresión

Parámetros ω y τ

Cálculo de τ

Generar subarbol

Árbol final

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

17/ 21 17 / 21

Aprendizaje Con este árbol vemos que la tabla de ejemplos iniciales ha sido

Automático

18/ 21 clasificada en tres grupos que son los formados por los ejemplos

Tutora: que caen en cada una de las hojas. Ahora, se debería generar

Àngela Martín

un modelo de regresión lineal para cada nodo hoja del árbol

Ejemplo

utilizando la ecuación vista en la introducción y que es:

Primera Búsqueda:

Generar árbol de

Regresión

a

X

Parámetros ω y τ Ci = α0 + αj × Aij

Cálculo de τ

Generar subarbol j=1

Árbol final

A continuació se calculan los modelos lineales del resto de nodos

y para ello se utilizan los atributos que aparecen en los subarboles

por debajo de ellos.

Nota: Una forma relativamente sencilla de construir árboles de

regresión es sustituyendo el modelo lineal de cada uno de sus

nodos hoja por el promediado del valor del atributo clase de los

casos pertenecientes a dicha hoja.

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

18/ 21 18 / 21

Segunda búsqueda

Aprendizaje

Automático

19/ 21

Tutora:

Àngela Martín

Ejemplo

Primera Búsqueda: El segundo paso (segunda búsqueda) intenta simplificar el

Generar árbol de

Regresión

Parámetros ω y τ

árbol de regresión generado en el paso anterior, borrando

Cálculo de τ de los modelos lineales los atributos que no incrementan en

Generar subarbol

Árbol final error estimado de clasificación.

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

19/ 21 19 / 21

Tercera búsqueda

Aprendizaje

Automático

20/ 21

Tutora:

Àngela Martín El tercer paso (tercera búsqueda) trata de reducir el árbol

(podarlo) sin que pierdan propiedades. El árbol resultante

Ejemplo separa los ejemplos de entrenamiento dependiendo de su

Primera Búsqueda:

Generar árbol de

Regresión

clase y tiene asociado en cada nodo hoja un modelo lineal

Parámetros ω y τ

Cálculo de τ

que calcula el valor de la clase dependiendo del valor de los

Generar subarbol

Árbol final

atributos que intervienen en el modelo.

NOTA: en la asignatura se prescinde de la etapa de poda del

árbol pero, se puede ver el árbol podado en weka. Las dos últimas

búsquedas se pueden hacer juntas y de este modo solo se recorre

el árbol una vez.

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

20/ 21 20 / 21

Sobre la poda

Aprendizaje

Automático

21/ 21

Tutora:

Àngela Martín

Una manera de corregir el sobreentrenamiento es podar el

Ejemplo árbol. Normalmente los criterios de parada suelen ser laxos

Primera Búsqueda:

Generar árbol de

Regresión (ω y τ ) o incluso inexistentes.

Parámetros ω y τ

Cálculo de τ Hay muchas maneras de podar el árbol y una de ellas se

Generar subarbol

Árbol final basa en estimar mediante validación cruzada de k bloques

o K-fold el error de un determinado subarbol para ver si se

puede eliminar.

Tutora: Àngela Martín Aprendizaje Automático (UNED) 10-11-2023

21/ 21 21 / 21

También podría gustarte

- Evaluacion Final - Escenario 8 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo A01)Documento10 páginasEvaluacion Final - Escenario 8 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo A01)Betty MosqueraAún no hay calificaciones

- Práctica 2 de 2013-14 de Fund-Sis - Dig.Documento13 páginasPráctica 2 de 2013-14 de Fund-Sis - Dig.Antonio JoseAún no hay calificaciones

- Test Pata NegraDocumento7 páginasTest Pata NegramariaAún no hay calificaciones

- Arboles de Regresion IntroduccionDocumento18 páginasArboles de Regresion IntroduccionCharo PradosAún no hay calificaciones

- Practica Calcul DavidDocumento19 páginasPractica Calcul DavidBlanca ViteAún no hay calificaciones

- Laboratorio 08 EDO Homogeneas 2023 - 1Documento15 páginasLaboratorio 08 EDO Homogeneas 2023 - 1junior.saavedraAún no hay calificaciones

- DeterminantesDocumento15 páginasDeterminantesSaid AmadorAún no hay calificaciones

- Evaluacion Final - Escenario 8 - PRIMER BLOQUE-CIENCIAS BASICAS - ALGEBRA LINEAL - (GRUPO B06)Documento11 páginasEvaluacion Final - Escenario 8 - PRIMER BLOQUE-CIENCIAS BASICAS - ALGEBRA LINEAL - (GRUPO B06)ca muAún no hay calificaciones

- Centro Polivalente de Arte 2ºaño Matematica Guia 2Documento8 páginasCentro Polivalente de Arte 2ºaño Matematica Guia 2Laura CamargoAún no hay calificaciones

- Actividad de Puntos Evaluables - Escenario 2 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo b01)Documento5 páginasActividad de Puntos Evaluables - Escenario 2 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo b01)kustAún no hay calificaciones

- Actividad de Puntos Evaluables - Escenario 6Documento8 páginasActividad de Puntos Evaluables - Escenario 6Kevin PalacioAún no hay calificaciones

- ColegioSecundarioCaciqueAngaco - Primeraño - Matemática - Orientada - Guia 3Documento5 páginasColegioSecundarioCaciqueAngaco - Primeraño - Matemática - Orientada - Guia 3Oscar Alberto Cortez DippAún no hay calificaciones

- EcuacionesDocumento97 páginasEcuacionesMeliza HiguerasAún no hay calificaciones

- Tarea 4Documento2 páginasTarea 4Nancy GrayAún no hay calificaciones

- Evaluacion de Diagnostico Fund Elec y Maq ElecDocumento2 páginasEvaluacion de Diagnostico Fund Elec y Maq ElecRobertoAún no hay calificaciones

- Teoría de Exponentes - Quiroz AlvaresDocumento5 páginasTeoría de Exponentes - Quiroz Alvares7c083a8132Aún no hay calificaciones

- Unidad I - IOP IDocumento53 páginasUnidad I - IOP IJesus Cerdan Solier0% (2)

- Parcial Final - Algebra LinealDocumento14 páginasParcial Final - Algebra LinealMichaelAún no hay calificaciones

- ALGEBRALINEAL1Documento74 páginasALGEBRALINEAL1Frederick AmadoAún no hay calificaciones

- Matemática Sem-09 Sesión-09 2023-1 Operaciones Con MatricesDocumento32 páginasMatemática Sem-09 Sesión-09 2023-1 Operaciones Con MatricesKatherine GalindoAún no hay calificaciones

- Evaluacion Final - Escenario 8 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo 01)Documento10 páginasEvaluacion Final - Escenario 8 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo 01)karol67% (3)

- Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo 01)Documento10 páginasPrimer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo 01)karolAún no hay calificaciones

- Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo 01)Documento10 páginasPrimer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo 01)karolAún no hay calificaciones

- 2-Matrices y DeterminantesDocumento31 páginas2-Matrices y DeterminantesPablo JaimeAún no hay calificaciones

- Examen Final - Semana 8 - CB - Primer Bloque-Algebra LinealDocumento7 páginasExamen Final - Semana 8 - CB - Primer Bloque-Algebra LinealCamilo CuellarAún no hay calificaciones

- Guía N°5-MATEMAT-Potenciación y Radicación de Números Enteros1Documento6 páginasGuía N°5-MATEMAT-Potenciación y Radicación de Números Enteros1estefany cardozoAún no hay calificaciones

- AlgebraDocumento6 páginasAlgebracamila torresAún no hay calificaciones

- Tema 1 - Introducción A La EconometríaDocumento75 páginasTema 1 - Introducción A La EconometríaS Kendra G CabaAún no hay calificaciones

- Sustentacion Trabajo Colaborativo - Escenario 7 - PRIMER BLOQUE-CIENCIAS BASICAS - ALGEBRA LINEAL - (GRUPO B04)Documento4 páginasSustentacion Trabajo Colaborativo - Escenario 7 - PRIMER BLOQUE-CIENCIAS BASICAS - ALGEBRA LINEAL - (GRUPO B04)Fernando MuñozAún no hay calificaciones

- Propiedades de PotenciaDocumento8 páginasPropiedades de PotenciaKATHERINE SUAZOAún no hay calificaciones

- Examen Trimestral de Math 2022Documento1 páginaExamen Trimestral de Math 2022Osmal MoránAún no hay calificaciones

- T01B - Hoja de RespuestasDocumento1 páginaT01B - Hoja de RespuestasPohol Antony Suarez TorresAún no hay calificaciones

- Determinante de Una MatrizZDocumento6 páginasDeterminante de Una MatrizZAMYNNXXXXAún no hay calificaciones

- Guia Iii Momento Matemticas 4 ElcaDocumento13 páginasGuia Iii Momento Matemticas 4 ElcaAinaruAún no hay calificaciones

- Evaluacion Formativa 6°Documento11 páginasEvaluacion Formativa 6°sandra barrientosAún no hay calificaciones

- Fabiola Martinez PDFDocumento14 páginasFabiola Martinez PDFAndrea Martinez GallegoAún no hay calificaciones

- ALGEBRADocumento33 páginasALGEBRAjailinderAún no hay calificaciones

- 2 Intento Examen Parcial - Semana 4 - CB - PRIMER BLOQUE-ALGEBRA LINEAL - (GRUPO1) PDFDocumento6 páginas2 Intento Examen Parcial - Semana 4 - CB - PRIMER BLOQUE-ALGEBRA LINEAL - (GRUPO1) PDFDewis Araujo RodriguezAún no hay calificaciones

- Guia Multiplicacion de EnterosDocumento4 páginasGuia Multiplicacion de EnterosFrancisco CastillaAún no hay calificaciones

- Teoría de La UtilidadDocumento47 páginasTeoría de La UtilidadLeoAún no hay calificaciones

- 11 Exponentes y RadicalesDocumento12 páginas11 Exponentes y RadicalesQuimica TecnologiaAún no hay calificaciones

- Sustentacion Trabajo Colaborativo - Escenario 7 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo b07)Documento5 páginasSustentacion Trabajo Colaborativo - Escenario 7 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo b07)FABIO IMITOLAAún no hay calificaciones

- Tarea1 Ospino LeeDocumento11 páginasTarea1 Ospino LeeLee Antony Ospino VegaAún no hay calificaciones

- 8vo Evaluación N°3 (1) .......Documento5 páginas8vo Evaluación N°3 (1) .......Antonella Segovia GallardoAún no hay calificaciones

- Algebra Lineal (MAT061) : Clase 10Documento19 páginasAlgebra Lineal (MAT061) : Clase 10Claudio KeimAún no hay calificaciones

- Algebra Final 8Documento10 páginasAlgebra Final 8Andres vAún no hay calificaciones

- Trabajo de Investigación-Matriz Inversa y Determinantes YISEDocumento11 páginasTrabajo de Investigación-Matriz Inversa y Determinantes YISEYoselin SantiagoAún no hay calificaciones

- 1º Eso Proporcionalidad y PorcentajesDocumento3 páginas1º Eso Proporcionalidad y PorcentajesFernando AlonsoAún no hay calificaciones

- 02 Potencias Radicales y LogaritmosDocumento20 páginas02 Potencias Radicales y LogaritmosIsabel BelloAún no hay calificaciones

- 8°C GUÍA DE SINTESIS - I SemestreDocumento5 páginas8°C GUÍA DE SINTESIS - I SemestreCarolinaCastilloAún no hay calificaciones

- Cuadernillo-1 MT22 Operatoria en ZDocumento8 páginasCuadernillo-1 MT22 Operatoria en ZTamara LazoAún no hay calificaciones

- Determinante Clase 1Documento22 páginasDeterminante Clase 1Justina MirandaAún no hay calificaciones

- Evaluacion Final - Escenario 8 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo b06)Documento13 páginasEvaluacion Final - Escenario 8 - Primer Bloque-Ciencias Basicas - Algebra Lineal - (Grupo b06)ca muAún no hay calificaciones

- Hoja de Evaluación Final.Documento3 páginasHoja de Evaluación Final.Yesica NarvaezAún no hay calificaciones

- MatricesDocumento7 páginasMatricesraul rodriguez juacheAún no hay calificaciones

- Exa 1T Mat 2do BguDocumento3 páginasExa 1T Mat 2do BgupallangostalinAún no hay calificaciones

- s02s2 Practica Calificada n01 Calculo Aplicado A La Fisica 1 12806 Jairo SifuentesDocumento5 páginass02s2 Practica Calificada n01 Calculo Aplicado A La Fisica 1 12806 Jairo Sifuentesmiguel casqui quispe100% (1)

- Series de Taylor y Errores Por TruncamientoDocumento2 páginasSeries de Taylor y Errores Por TruncamientoarelyAún no hay calificaciones

- Ta2 Tema 9Documento58 páginasTa2 Tema 9Antonio JoseAún no hay calificaciones

- Ta2 Tema 10Documento67 páginasTa2 Tema 10Antonio JoseAún no hay calificaciones

- Preguntas de Desarrollo Del ForoDocumento8 páginasPreguntas de Desarrollo Del ForoAntonio JoseAún no hay calificaciones

- Ta2 Tema 11Documento41 páginasTa2 Tema 11Antonio JoseAún no hay calificaciones

- 2015 - Guía EstudioDocumento9 páginas2015 - Guía EstudioAntonio JoseAún no hay calificaciones

- Ta2 Presentacion AsignaturaDocumento7 páginasTa2 Presentacion AsignaturaAntonio JoseAún no hay calificaciones

- Tipos de DemostracionesDocumento69 páginasTipos de DemostracionesJoseAún no hay calificaciones

- GuiaUnica 71014017 2018Documento9 páginasGuiaUnica 71014017 2018Antonio JoseAún no hay calificaciones

- Cap 2 STRDocumento4 páginasCap 2 STRAntonio JoseAún no hay calificaciones

- Cap 5 STRDocumento2 páginasCap 5 STRAntonio JoseAún no hay calificaciones

- Pra 01Documento18 páginasPra 01Antonio JoseAún no hay calificaciones

- Cap 3 STRDocumento6 páginasCap 3 STRAntonio JoseAún no hay calificaciones

- Cap 1 STRDocumento6 páginasCap 1 STRAntonio JoseAún no hay calificaciones

- Cap 4 STRDocumento3 páginasCap 4 STRAntonio JoseAún no hay calificaciones

- Programación Orientada A EventosDocumento56 páginasProgramación Orientada A EventosNestorPastorPieraAún no hay calificaciones

- Problemas Alu 2016Documento4 páginasProblemas Alu 2016Antonio JoseAún no hay calificaciones

- Idasignatura 04830022 PDFDocumento3 páginasIdasignatura 04830022 PDFAntonio JoseAún no hay calificaciones

- Problemas de CritologiaDocumento48 páginasProblemas de CritologiacaperuruAún no hay calificaciones

- Análisis de Eficiencia de Algoritmos PDFDocumento20 páginasAnálisis de Eficiencia de Algoritmos PDFAntonio JoseAún no hay calificaciones

- Listado AsignaturasDocumento10 páginasListado AsignaturasAntonio JoseAún no hay calificaciones

- Guia Sobre Educacion Sexual IntegralDocumento31 páginasGuia Sobre Educacion Sexual IntegralBakers HeavenargAún no hay calificaciones

- Flexibilidad Verbal y RendimientoDocumento5 páginasFlexibilidad Verbal y RendimientopmartinrAún no hay calificaciones

- La Prehistoria de La Sal La FactoriaDocumento34 páginasLa Prehistoria de La Sal La FactoriavdiazpardoAún no hay calificaciones

- Las 11 FespDocumento14 páginasLas 11 FespMilu MarchAún no hay calificaciones

- Facultad de Ciencias Humanas Programa Curricular de Psicología Fundamentos Del ConductismoDocumento4 páginasFacultad de Ciencias Humanas Programa Curricular de Psicología Fundamentos Del ConductismoVivian Samantha Palacios PachonAún no hay calificaciones

- El NitrógenoDocumento2 páginasEl NitrógenoRonald Nilson CAAún no hay calificaciones

- Ho'oponopono y La Ley de La AtracciónDocumento92 páginasHo'oponopono y La Ley de La AtracciónMariela Estofan80% (5)

- Proyecto de Inversion para Comercializacion de Jugo de CañaDocumento10 páginasProyecto de Inversion para Comercializacion de Jugo de CañaJulio Cesar Urquidi BarbozaAún no hay calificaciones

- Caracterización E Historia de SR Wok 1.1 Reseña HistóricaDocumento12 páginasCaracterización E Historia de SR Wok 1.1 Reseña HistóricaMaria RoldanAún no hay calificaciones

- Trabajo de Sociales CruzadasDocumento7 páginasTrabajo de Sociales Cruzadasyenny gomezAún no hay calificaciones

- La Sana DoctrinaDocumento19 páginasLa Sana DoctrinaALBERTO VALDIVIA100% (1)

- Existencialismo LatinoamericanoDocumento4 páginasExistencialismo LatinoamericanoFrancisco Fernando FrigeriAún no hay calificaciones

- Actividad TA3 - MTA3-Propiedades Del Agua PDFDocumento2 páginasActividad TA3 - MTA3-Propiedades Del Agua PDFNelly Huamán0% (1)

- La Maquina de La PazDocumento2 páginasLa Maquina de La PazCezzi VinAún no hay calificaciones

- Encofrados Con Madera de Vigas y LosasDocumento35 páginasEncofrados Con Madera de Vigas y LosasEvelyn SusanaAún no hay calificaciones

- T I R, T I O, Razón Beneficio Costo, ROIDocumento6 páginasT I R, T I O, Razón Beneficio Costo, ROINelsonAún no hay calificaciones

- Análisis y Diseño de Una Solución para Uso de Servicios de BiDocumento7 páginasAnálisis y Diseño de Una Solución para Uso de Servicios de BiHugo Francisco Felipe CacerosAún no hay calificaciones

- Anexo Actividad Semana 3Documento37 páginasAnexo Actividad Semana 3OIL TEST INTERNACIONAL DE COLOMBIA S.A.SAún no hay calificaciones

- Caso 01. Negocios InternacionalesDocumento2 páginasCaso 01. Negocios InternacionalesDaniela Midori Álvarez BringasAún no hay calificaciones

- Tarea 3-Gestion de OperacionesDocumento35 páginasTarea 3-Gestion de OperacionespaolaAún no hay calificaciones

- HISTORIADocumento1 páginaHISTORIADaniela PerezAún no hay calificaciones

- HUMEDAD DEL SUELO Practica Mecanica de SuelosDocumento9 páginasHUMEDAD DEL SUELO Practica Mecanica de SuelosLau AlviraAún no hay calificaciones

- F I LosalimentosDocumento8 páginasF I LosalimentosKIARA LUCERO QUIROZ CELISAún no hay calificaciones

- CaratulaDocumento7 páginasCaratulaDinael AlvarezAún no hay calificaciones

- Gaume, Historia de La Sociedad Doméstica.Documento365 páginasGaume, Historia de La Sociedad Doméstica.Ana RamosAún no hay calificaciones

- Italia 10Documento2 páginasItalia 10Nicolás Buriano MazzeiAún no hay calificaciones

- Diario de Doble EntradaDocumento2 páginasDiario de Doble EntradaGabriel AvilaAún no hay calificaciones

- Agregados CristalinosDocumento2 páginasAgregados CristalinosEstip Esnaider Cahuana Maron100% (1)

- NTC4772 Deteccion E-Coli en AguasDocumento11 páginasNTC4772 Deteccion E-Coli en AguasLucila Pelayo SerranoAún no hay calificaciones