Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Invest 1 Control

Cargado por

Rogerforever123Título original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Invest 1 Control

Cargado por

Rogerforever123Copyright:

Formatos disponibles

INVESTIGACION 1: INTRODUCCION DE LA TEORIA DE CONTROL

Rogelio Valdez Hernandez

Ing Abraham Flores Rubio

Control

Instituto Tecnológico de Reynosa

Índice

1.1 Reseña del desarrollo de los sistemas de control .............................. 2

1.2 Definiciones......................................................................................... 3

1.2.1 Elementos que conforman los sistemas de control .......................... 3

1.2.1.1 Lazo abierto ................................................................................... 4

1.2.1.2 Lazo cerrado .................................................................................. 4

1.2.2 Ejemplos de sistemas de control ...................................................... 5

1.3 Control clásico contra control moderno............................................ 5

Referencias ................................................................................................ 6

ROGELIO VALDEZ HERNANDEZ 1

1.1 Reseña del desarrollo de los sistemas de control

El desarrollo de los sistemas de control ha sido un área crucial en la historia de la ingeniería y la

tecnología. Desde los primeros rudimentos de control manual hasta los complejos sistemas automatizados

de hoy en día, este campo ha experimentado un crecimiento significativo a lo largo del tiempo. A

continuación, se presenta una reseña del desarrollo de los sistemas de control:

Control Manual Primitivo: Los primeros sistemas de control eran completamente manuales y se

basaban en la intervención humana directa. Un ejemplo temprano es el control del flujo de agua en

sistemas de irrigación antiguos mediante la apertura y cierre de compuertas.

Sistemas de Control Mecánico: Durante la Revolución Industrial, se desarrollaron sistemas de control

mecánico para automatizar procesos industriales. Esto incluía dispositivos mecánicos como reguladores

de velocidad y mecanismos de retroalimentación para mantener constantes ciertas variables.

Desarrollo de la Teoría de Control: A principios del siglo XX, ingenieros como Nicolas Minorsky y

James Clerk Maxwell comenzaron a desarrollar teorías matemáticas para entender y diseñar sistemas de

control. Esta fue una fase crucial en el desarrollo de los sistemas de control modernos, ya que sentó las

bases para el análisis y diseño sistemático de sistemas de control.

Control Automático Electrónico: Con el advenimiento de la electrónica en el siglo XX, se hizo posible

desarrollar sistemas de control automático más avanzados. El uso de amplificadores operacionales,

transistores y otros dispositivos electrónicos permitió la implementación de sistemas de control más

precisos y rápidos.

Teoría de Control Moderna: Durante la segunda mitad del siglo XX, se desarrollaron teorías de control

más avanzadas, como el control óptimo, el control adaptativo y el control robusto. Estas teorías

permitieron el diseño de sistemas de control más sofisticados capaces de manejar una amplia gama de

condiciones y perturbaciones.

Control Digital: A medida que la tecnología digital se hizo más accesible, surgieron los sistemas de

control digital. Estos sistemas utilizan computadoras y algoritmos digitales para realizar el control en

lugar de hardware analógico. El control digital ofrece ventajas como una mayor precisión, flexibilidad y

capacidad de procesamiento.

Control Inteligente y Automatización Avanzada: En las últimas décadas, ha habido un enfoque

creciente en el control inteligente y la automatización avanzada. Esto incluye el uso de técnicas de

inteligencia artificial, como redes neuronales y algoritmos genéticos, para desarrollar sistemas de control

que puedan aprender y adaptarse a medida que interactúan con su entorno.

En resumen, el desarrollo de los sistemas de control ha sido un proceso continuo de avances tecnológicos

y teóricos a lo largo de la historia. Desde sus inicios en la era preindustrial hasta los sistemas de control

digital y automatización inteligente de hoy en día, este campo ha evolucionado para satisfacer las

crecientes demandas de precisión, eficiencia y flexibilidad en una amplia gama de aplicaciones

industriales y tecnológicas.

ROGELIO VALDEZ HERNANDEZ 2

1.2 Definiciones

La teoría de control es una disciplina fundamental en la ingeniería y la ciencia que se ocupa del

análisis y diseño de sistemas dinámicos para lograr ciertos objetivos de control. Estos sistemas pueden ser

tan simples como un termostato que regula la temperatura de una habitación, o tan complejos como un

sistema de control de vuelo en un avión. La teoría de control proporciona herramientas y técnicas para

comprender, modelar, analizar y diseñar sistemas de control que satisfagan requisitos específicos de

rendimiento, estabilidad y robustez.

1. Sistema: Es cualquier entidad o proceso que acepta entradas y produce salidas. Un

sistema puede ser físico, como un robot o una planta de energía, o abstracto, como un

modelo matemático de un fenómeno natural.

2. Variable de Estado: Es una cantidad que describe completamente el estado de un

sistema en un momento dado. Las variables de estado pueden ser físicas, como posición y

velocidad, o abstractas, como la carga de un servidor informático.

3. Controlador: Es un dispositivo o algoritmo que calcula las acciones de control

necesarias para llevar el sistema desde un estado inicial a un estado deseado o mantenerlo

en un estado deseado. El controlador utiliza la retroalimentación de las mediciones del

sistema para ajustar su comportamiento.

4. Sistema de Control: Es la combinación del sistema que se está controlando, el

controlador y cualquier interfaz de retroalimentación o actuación. El sistema de control se

diseña para lograr ciertos objetivos de rendimiento, como la estabilidad, la precisión y la

rapidez de respuesta.

5. Retroalimentación (Feedback): Es la información sobre el estado actual del sistema que

se utiliza para ajustar las acciones de control. La retroalimentación puede ser positiva,

donde se amplifica la señal de salida, o negativa, donde se utiliza para corregir errores y

mantener el sistema en un estado deseado.

6. Estabilidad: Un sistema de control se considera estable si su respuesta permanece

acotada y converge a un estado deseado a pesar de perturbaciones externas. La

estabilidad es un objetivo fundamental en el diseño de sistemas de control.

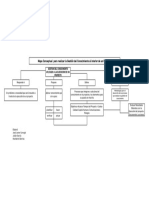

1.2.1 Elementos que conforman los sistemas de control

Planta (o proceso): Es el sistema físico o abstracto que se está controlando. Puede ser una máquina, un

proceso químico, un sistema eléctrico, o cualquier otro sistema que acepte entradas y produzca salidas. La

planta es el objeto sobre el cual se aplica el control para lograr ciertos objetivos.

Sensor(es): Son dispositivos que detectan y convierten magnitudes físicas o variables de estado del

sistema en señales eléctricas o digitales que pueden ser procesadas por el controlador. Los sensores

proporcionan retroalimentación al sistema de control sobre el estado actual de la planta, permitiendo

tomar decisiones informadas sobre las acciones de control necesarias.

ROGELIO VALDEZ HERNANDEZ 3

Actuador(es): Son dispositivos que reciben señales de control del controlador y producen cambios en la

planta. Los actuadores convierten señales eléctricas o digitales en acciones físicas, como movimientos

mecánicos, cambios en la energía suministrada, o alteraciones en el flujo de materiales. Estos efectúan las

correcciones necesarias para llevar el sistema hacia el estado deseado.

Controlador: Es el componente central del sistema de control que calcula las acciones de control

necesarias para mantener o modificar el comportamiento de la planta. Utiliza la información de

retroalimentación proporcionada por los sensores para generar señales de control adecuadas para los

actuadores. Los controladores pueden ser implementados en hardware, software o ambos, y utilizan

algoritmos de control específicos para alcanzar los objetivos deseados.

Interfaz de Usuario: En algunos sistemas de control, se incluye una interfaz de usuario que permite a

los operadores humanos interactuar con el sistema. Esta interfaz puede proporcionar información sobre el

estado del sistema, permitir ajustes en los parámetros de control, y visualizar datos relevantes para la

supervisión y el diagnóstico del sistema.

1.2.1.1 Lazo abierto

El lazo abierto es un concepto fundamental en teoría de control que describe un tipo de sistema en el cual

la salida del sistema no influye en la entrada o en el proceso de control. En otras palabras, en un sistema

de lazo abierto, no se utiliza retroalimentación para corregir o ajustar la salida del sistema.

Ejemplos comunes de sistemas de lazo abierto incluyen:

Una lavadora que ejecuta un ciclo de lavado predefinido sin ajustar su operación en función de la

suciedad o la carga de la ropa.

Un horno que calienta a una temperatura constante sin medir la temperatura real del ambiente o los

alimentos.

Aunque los sistemas de lazo abierto son simples y fáciles de implementar, tienden a ser menos robustos y

menos precisos en comparación con los sistemas de lazo cerrado, donde se utiliza la retroalimentación

para ajustar y corregir el comportamiento del sistema en tiempo real. Sin embargo, los sistemas de lazo

abierto aún tienen aplicaciones en situaciones donde la precisión no es crítica o donde el costo y la

simplicidad son factores importantes.

1.2.1.2 Lazo cerrado

El lazo cerrado, también conocido como sistema de retroalimentación, es un concepto central en teoría de

control que describe un tipo de sistema en el cual la salida del sistema se utiliza como retroalimentación

para controlar la entrada y ajustar el comportamiento del sistema. En otras palabras, en un sistema de lazo

cerrado, la salida del sistema se compara con un valor deseado o de referencia, y esta diferencia se utiliza

para ajustar la entrada o el proceso de control.

Ejemplos comunes de sistemas de lazo cerrado incluyen:

ROGELIO VALDEZ HERNANDEZ 4

Un sistema de control de temperatura en un horno que mide continuamente la temperatura y ajusta la

entrada de energía para mantener la temperatura deseada.

Un sistema de control de velocidad en un vehículo que utiliza un regulador de velocidad de crucero

para mantener una velocidad constante en función de la velocidad medida y la configuración del

conductor.

1.2.2 Ejemplos de sistemas de control

Control de Temperatura en un Horno

Control de Velocidad en un Motor

Control de Nivel en un Tanque

Control de Posición en un Robot Industrial

Control de pH en un Proceso Químico

Control de Presión en un Sistema de Aire Acondicionado

Control de Autopiloto en un Avión

1.3 Control clásico contra control moderno

Control Clásico:

Enfoque Frecuencial: El control clásico se basa en el análisis de sistemas en el dominio de la frecuencia

utilizando herramientas como el diagrama de Bode y el diagrama de Nyquist.

Uso de Funciones de Transferencia: Las funciones de transferencia son fundamentales en el control

clásico. Estas describen la relación entre la entrada y la salida de un sistema en el dominio de la

frecuencia.

Diseño Basado en Margen de Fase y Margen de Ganancia: En el control clásico, el diseño de

controladores se realiza principalmente ajustando los parámetros para lograr un margen de fase y un

margen de ganancia adecuados.

Limitado a Sistemas Lineales e Invariantes en el Tiempo (LTI): El enfoque clásico es más adecuado

para sistemas lineales e invariantes en el tiempo, lo que limita su aplicabilidad en sistemas no lineales y

sistemas que cambian con el tiempo.

Control Moderno:

Enfoque en el Espacio de Estado: El control moderno se basa en el análisis y diseño de sistemas en el

dominio del espacio de estado, lo que permite una representación más completa y flexible de los sistemas

dinámicos.

Uso de Modelos de Espacio de Estado: En lugar de funciones de transferencia, los modelos de espacio

de estado se utilizan para describir la dinámica de los sistemas en términos de ecuaciones diferenciales de

primer orden.

ROGELIO VALDEZ HERNANDEZ 5

Diseño Basado en Técnicas de Optimización y Control Óptimo: El control moderno utiliza técnicas de

optimización y control óptimo para diseñar controladores que optimizan criterios de rendimiento

específicos, como minimizar el error cuadrático medio o maximizar la estabilidad del sistema.

Aplicabilidad a Sistemas No Lineales y Variables en el Tiempo: El enfoque moderno es más robusto y

adaptable a una amplia gama de sistemas, incluidos los sistemas no lineales y variables en el tiempo, lo

que lo hace más adecuado para aplicaciones en las que los sistemas son inherentemente no lineales o

cambian con el tiempo

Referencias

ControlTutorials.com

Coursera.org

"Control Systems Engineering" de Norman S. Nise

"Modern Control Engineering" de Katsuhiko Ogata

ROGELIO VALDEZ HERNANDEZ 6

También podría gustarte

- Instrumentación y control en instalaciones de proceso, energía y servicios auxiliares. QUIE0108De EverandInstrumentación y control en instalaciones de proceso, energía y servicios auxiliares. QUIE0108Calificación: 4.5 de 5 estrellas4.5/5 (8)

- Resumen 1Documento4 páginasResumen 1MOISES XAVI DIAZ MEZAAún no hay calificaciones

- Instalación de equipos y elementos de sistemas de automatización industrial. ELEM0311De EverandInstalación de equipos y elementos de sistemas de automatización industrial. ELEM0311Calificación: 2 de 5 estrellas2/5 (1)

- Identificación de Variables de Un Sistema de ControlDocumento14 páginasIdentificación de Variables de Un Sistema de ControlRodri EnriquezAún no hay calificaciones

- Sistemas de Control PDFDocumento68 páginasSistemas de Control PDFroberttv374Aún no hay calificaciones

- Control AnalogicoDocumento6 páginasControl Analogicofray1308Aún no hay calificaciones

- Control Automatico de Procesos 2Documento13 páginasControl Automatico de Procesos 2elisa butoAún no hay calificaciones

- Control Modulante de ProcesosDocumento28 páginasControl Modulante de ProcesosJuan SuarezAún no hay calificaciones

- Tesis 1 (Marco Teorico)Documento7 páginasTesis 1 (Marco Teorico)royAún no hay calificaciones

- Controles Clasicos Un1Documento15 páginasControles Clasicos Un1CesarAún no hay calificaciones

- Introducción A Los Sistemas de Control IndustrialDocumento10 páginasIntroducción A Los Sistemas de Control IndustrialLuigi RodriguezAún no hay calificaciones

- Monografia - Practica 0Documento39 páginasMonografia - Practica 0luisAún no hay calificaciones

- Capitulo I Control I 2019 IIDocumento25 páginasCapitulo I Control I 2019 IIWilinthon Segura Ortega100% (1)

- TP Instrumentación y Control - Carmen MartínezDocumento13 páginasTP Instrumentación y Control - Carmen MartínezDejanira Martínez BalbuenaAún no hay calificaciones

- Imprimible Sca s1Documento9 páginasImprimible Sca s1Alejandra janethAún no hay calificaciones

- INFORMEDocumento10 páginasINFORMEAntonio CaceresAún no hay calificaciones

- P9 SabadoV3 625 1808164Documento18 páginasP9 SabadoV3 625 1808164Andres OrdoñezAún no hay calificaciones

- MonografiaDocumento13 páginasMonografiaJusto Jose Ramos AnahueAún no hay calificaciones

- Inversion de Giro de Un MotorDocumento14 páginasInversion de Giro de Un MotorAbel Apaza FuentesAún no hay calificaciones

- DinamicaDocumento8 páginasDinamicaJose FrancoAún no hay calificaciones

- Actividad 1Documento20 páginasActividad 1eduardoacevedo793Aún no hay calificaciones

- Tema 48 - Técnicas Avanzadas Regul AutomDocumento17 páginasTema 48 - Técnicas Avanzadas Regul AutomlauAún no hay calificaciones

- (Control Analogico) Evaluacion Unidad IIIDocumento16 páginas(Control Analogico) Evaluacion Unidad IIIAlfonso García MartínezAún no hay calificaciones

- Sistemas de Control AutomaticoDocumento56 páginasSistemas de Control AutomaticoAlonso GongoraAún no hay calificaciones

- Informe InstrumentacionDocumento7 páginasInforme InstrumentacionAndrewRAún no hay calificaciones

- Mi Exposición de Sistemas AutomáticosDocumento3 páginasMi Exposición de Sistemas AutomáticosGénesis Nicole Conza ZambranoAún no hay calificaciones

- Espin Deber1Documento11 páginasEspin Deber1Jonathan Antonio Espín RosalesAún no hay calificaciones

- Automatizacion ComponentesDocumento41 páginasAutomatizacion ComponentesPedro Martin Llaguento PortillaAún no hay calificaciones

- Laboratorio 1 - Automatizacion Industrial PDFDocumento24 páginasLaboratorio 1 - Automatizacion Industrial PDFichmeyo0% (1)

- SISTEMAS DE CONTROL Primer TrabajoDocumento14 páginasSISTEMAS DE CONTROL Primer TrabajoeduardoAún no hay calificaciones

- Luis Aguirre Instrumentación 2Documento6 páginasLuis Aguirre Instrumentación 2Luis AguirreAún no hay calificaciones

- Sistema MecatrónicoDocumento3 páginasSistema MecatrónicoHector GAAún no hay calificaciones

- Guía Laboratorio IDocumento16 páginasGuía Laboratorio Ijhonatan cullas urbinaAún no hay calificaciones

- Tarea No 1 Introducción A Los Sistemas de ControlDocumento20 páginasTarea No 1 Introducción A Los Sistemas de ControlTristan HernandezAún no hay calificaciones

- Control Industrial EXPDocumento12 páginasControl Industrial EXPJorge Eduardo Macías TuarezAún no hay calificaciones

- Monografia T1 Nieto CachoDocumento47 páginasMonografia T1 Nieto CachoChristian Jesús Hernández PérezAún no hay calificaciones

- Análisis Del Sistema de Control Discreto y ContinuoDocumento2 páginasAnálisis Del Sistema de Control Discreto y ContinuoBryanAún no hay calificaciones

- Cerrado Automatico de Una Cortina y Otros Dispositivos de CorrimientoDocumento9 páginasCerrado Automatico de Una Cortina y Otros Dispositivos de CorrimientoRuddy Calle AlconAún no hay calificaciones

- Capitulo I Control I Teoria 2016 IDocumento17 páginasCapitulo I Control I Teoria 2016 IYhon Polanco AimitumaAún no hay calificaciones

- Scada Supervision y ControlDocumento26 páginasScada Supervision y ControlJuan RomeroAún no hay calificaciones

- Plantilla Del ReporteDocumento5 páginasPlantilla Del ReporteBombona EsraelmAún no hay calificaciones

- Semana 1 y 2Documento21 páginasSemana 1 y 2Alejandra AgudeloAún no hay calificaciones

- I3 E4 5°eDocumento15 páginasI3 E4 5°eluis angelAún no hay calificaciones

- Sistemas de ControlDocumento19 páginasSistemas de ControlJosuè Priego SanabriaAún no hay calificaciones

- MODULO 2 Control y AutomatizacionDocumento43 páginasMODULO 2 Control y AutomatizacionEdwinCordovaPazAún no hay calificaciones

- Actividad 1 - Sistemas de Control - PDFDocumento18 páginasActividad 1 - Sistemas de Control - PDFhiram galindoAún no hay calificaciones

- Control AutomaticoDocumento13 páginasControl AutomaticoJadiel Isai100% (2)

- Sistema de ControlDocumento6 páginasSistema de ControlEimer SalgueroAún no hay calificaciones

- UNIDAD 1 ControlDocumento11 páginasUNIDAD 1 ControlJose Abraham Regalado CabreraAún no hay calificaciones

- Monografia Ingeneirea de ControDocumento13 páginasMonografia Ingeneirea de ControCristian Chata ClarosAún no hay calificaciones

- Controles AutomaticosDocumento14 páginasControles AutomaticosReynier Valor NietoAún no hay calificaciones

- UNIDAD 5 Desarrollo de Instrumentos Virtuales PDFDocumento19 páginasUNIDAD 5 Desarrollo de Instrumentos Virtuales PDFNestor CoronaAún no hay calificaciones

- Informe Sistemas de Control AutomaticoDocumento20 páginasInforme Sistemas de Control AutomaticoSebastian VegaAún no hay calificaciones

- Actividad - Sistemas de Control - Araujo Galindo - WordDocumento18 páginasActividad - Sistemas de Control - Araujo Galindo - Wordhiram galindoAún no hay calificaciones

- Informe1 Grupo4 LinoDocumento10 páginasInforme1 Grupo4 LinoMANFRED PAUL ROJAS ATIENCIEAún no hay calificaciones

- Informe1 Grupo1 JiménezDocumento16 páginasInforme1 Grupo1 JiménezMANFRED PAUL ROJAS ATIENCIEAún no hay calificaciones

- Niveles Jerarquicos de Control AvanzadoDocumento12 páginasNiveles Jerarquicos de Control AvanzadoCheChyHrAún no hay calificaciones

- Unidad 1 Agosto 2022 PDFDocumento23 páginasUnidad 1 Agosto 2022 PDFLuis GarcíaAún no hay calificaciones

- Sistemas de ControlDocumento4 páginasSistemas de ControlJAIME BOLIVAR MALO CAMPOVERDEAún no hay calificaciones

- Fundamentos de Regulación AutomáticaDocumento8 páginasFundamentos de Regulación AutomáticahombredehieloAún no hay calificaciones

- Padrón de Proveedores 2016Documento351 páginasPadrón de Proveedores 2016Gierman StaceyAún no hay calificaciones

- CI574 Formato TB1 El ProblemaDocumento14 páginasCI574 Formato TB1 El ProblemaEdison EspinozaAún no hay calificaciones

- ¿Cómo Hago La Subsanación A Un Proceso de Contratación en El SECOP II - Colombia Compra Eficiente - Agencia Nacional de Contratación PúblicaDocumento1 página¿Cómo Hago La Subsanación A Un Proceso de Contratación en El SECOP II - Colombia Compra Eficiente - Agencia Nacional de Contratación Públicajorge ramirezAún no hay calificaciones

- 15 Diferentes Extensiones de Audio.Documento2 páginas15 Diferentes Extensiones de Audio.2122300465Aún no hay calificaciones

- Tesis Participacion CiudadanaDocumento20 páginasTesis Participacion Ciudadanaspprojects0% (1)

- Sustentación MonografiaDocumento5 páginasSustentación Monografiajuan david obando adarme (Juan David Obando)Aún no hay calificaciones

- GUÍA ORIENTADORA PARA DESARROLLAR UNIDAD III (Parte 1)Documento2 páginasGUÍA ORIENTADORA PARA DESARROLLAR UNIDAD III (Parte 1)Alba Marina Rodriguez DiazAún no hay calificaciones

- ¿Qué Es AgilidadDocumento6 páginas¿Qué Es Agilidadjgiorgi_1Aún no hay calificaciones

- Reunión 29 de Diciembre 2022Documento2 páginasReunión 29 de Diciembre 2022César LÓPEZ MATIENZOAún no hay calificaciones

- Syllabus Inf 393 II 2019 BWDocumento3 páginasSyllabus Inf 393 II 2019 BWFrancisco AbarcaAún no hay calificaciones

- Robot ManipuladorDocumento3 páginasRobot ManipuladorDiego VelezAún no hay calificaciones

- Bairon Reyes Campuzano PEC1Documento4 páginasBairon Reyes Campuzano PEC1John CortezAún no hay calificaciones

- Termopar Tipo KDocumento7 páginasTermopar Tipo KAnonymous IoreTDh7Aún no hay calificaciones

- s7 Tarea Set A Matma1102Documento3 páginass7 Tarea Set A Matma1102Ignacio Mondaca Fuentes0% (3)

- Obtención de Requerimientos. Técnicas y EstrategiasDocumento9 páginasObtención de Requerimientos. Técnicas y EstrategiasezequielruizgarciaAún no hay calificaciones

- Sisprobovcarne PDFDocumento2 páginasSisprobovcarne PDFJmx Cj XAún no hay calificaciones

- Matriz de ConsistenciaDocumento1 páginaMatriz de Consistenciajuvenal aquino condezoAún no hay calificaciones

- Dgti U1 Ea TeavDocumento14 páginasDgti U1 Ea TeavTeresita De Jesus AlonzoAún no hay calificaciones

- CM20170420 47085 59951Documento24 páginasCM20170420 47085 59951gianiAún no hay calificaciones

- Sensor VSSDocumento4 páginasSensor VSSJhon LemosAún no hay calificaciones

- Ejercicios Semana 2Documento3 páginasEjercicios Semana 2Tom PinarAún no hay calificaciones

- Identificar Los Tipos de Motores Dentro de Un Sistema ElectromecanicoDocumento3 páginasIdentificar Los Tipos de Motores Dentro de Un Sistema ElectromecanicoKimSeokJin100% (1)

- Los Derechos Humanos en El CiberespacioDocumento20 páginasLos Derechos Humanos en El CiberespaciogabrielAún no hay calificaciones

- Mapa Conceptual para Realizar La Gestión Del Conocimiento Al Interior de Un ProyectoDocumento1 páginaMapa Conceptual para Realizar La Gestión Del Conocimiento Al Interior de Un ProyectoJose Javier Carvajal PradaAún no hay calificaciones

- Empower Pre-Intermediate 3 2021Documento3 páginasEmpower Pre-Intermediate 3 2021luxi0Aún no hay calificaciones

- 3220mx - es-MX (Manual de Usuario) PDFDocumento92 páginas3220mx - es-MX (Manual de Usuario) PDFMiguel Bautista100% (2)

- Excel Intermedio 1Documento3 páginasExcel Intermedio 1antonioAún no hay calificaciones

- Operadores LogísticosDocumento26 páginasOperadores LogísticosYakuza Korps100% (1)

- Ventajas y Desventajas Del SwtichDocumento5 páginasVentajas y Desventajas Del SwtichÄbïïs R Mërcädö0% (1)

- Matriz FODA de Una ImprentaDocumento9 páginasMatriz FODA de Una ImprentaBrianAnthonyRiveraGoicocheaAún no hay calificaciones

- Clics contra la humanidad: Libertad y resistencia en la era de la distracción tecnológicaDe EverandClics contra la humanidad: Libertad y resistencia en la era de la distracción tecnológicaCalificación: 4.5 de 5 estrellas4.5/5 (117)

- Excel 2021 y 365 Paso a Paso: Paso a PasoDe EverandExcel 2021 y 365 Paso a Paso: Paso a PasoCalificación: 5 de 5 estrellas5/5 (12)

- EL PLAN DE MARKETING EN 4 PASOS. Estrategias y pasos clave para redactar un plan de marketing eficaz.De EverandEL PLAN DE MARKETING EN 4 PASOS. Estrategias y pasos clave para redactar un plan de marketing eficaz.Calificación: 4 de 5 estrellas4/5 (51)

- Excel y SQL de la mano: Trabajo con bases de datos en Excel de forma eficienteDe EverandExcel y SQL de la mano: Trabajo con bases de datos en Excel de forma eficienteCalificación: 1 de 5 estrellas1/5 (1)

- LAS VELAS JAPONESAS DE UNA FORMA SENCILLA. La guía de introducción a las velas japonesas y a las estrategias de análisis técnico más eficaces.De EverandLAS VELAS JAPONESAS DE UNA FORMA SENCILLA. La guía de introducción a las velas japonesas y a las estrategias de análisis técnico más eficaces.Calificación: 4.5 de 5 estrellas4.5/5 (54)

- Guía de cálculo y diseño de conductos para ventilación y climatizaciónDe EverandGuía de cálculo y diseño de conductos para ventilación y climatizaciónCalificación: 5 de 5 estrellas5/5 (1)

- 7 tendencias digitales que cambiarán el mundoDe Everand7 tendencias digitales que cambiarán el mundoCalificación: 4.5 de 5 estrellas4.5/5 (87)

- Influencia. La psicología de la persuasiónDe EverandInfluencia. La psicología de la persuasiónCalificación: 4.5 de 5 estrellas4.5/5 (14)

- Excel para principiantes: Aprenda a utilizar Excel 2016, incluyendo una introducción a fórmulas, funciones, gráficos, cuadros, macros, modelado, informes, estadísticas, Excel Power Query y másDe EverandExcel para principiantes: Aprenda a utilizar Excel 2016, incluyendo una introducción a fórmulas, funciones, gráficos, cuadros, macros, modelado, informes, estadísticas, Excel Power Query y másCalificación: 2.5 de 5 estrellas2.5/5 (3)

- ¿Cómo piensan las máquinas?: Inteligencia artificial para humanosDe Everand¿Cómo piensan las máquinas?: Inteligencia artificial para humanosCalificación: 5 de 5 estrellas5/5 (1)

- Lógica de programación: Solucionario en pseudocódigo – Ejercicios resueltosDe EverandLógica de programación: Solucionario en pseudocódigo – Ejercicios resueltosCalificación: 3.5 de 5 estrellas3.5/5 (7)

- EL PLAN DE NEGOCIOS DE UNA FORMA SENCILLA. La guía práctica que ayuda a poner en marcha nuevos proyectos e ideas empresariales.De EverandEL PLAN DE NEGOCIOS DE UNA FORMA SENCILLA. La guía práctica que ayuda a poner en marcha nuevos proyectos e ideas empresariales.Calificación: 4 de 5 estrellas4/5 (20)

- Machine Learning y Deep Learning: Usando Python, Scikit y KerasDe EverandMachine Learning y Deep Learning: Usando Python, Scikit y KerasAún no hay calificaciones

- Inteligencia artificial: Análisis de datos e innovación para principiantesDe EverandInteligencia artificial: Análisis de datos e innovación para principiantesCalificación: 4 de 5 estrellas4/5 (3)

- Design Thinking para principiantes: La innovación como factor para el éxito empresarialDe EverandDesign Thinking para principiantes: La innovación como factor para el éxito empresarialCalificación: 4.5 de 5 estrellas4.5/5 (10)

- El mito de la inteligencia artificial: Por qué las máquinas no pueden pensar como nosotros lo hacemosDe EverandEl mito de la inteligencia artificial: Por qué las máquinas no pueden pensar como nosotros lo hacemosCalificación: 5 de 5 estrellas5/5 (2)

- Manual Técnico del Automóvil - Diccionario Ilustrado de las Nuevas TecnologíasDe EverandManual Técnico del Automóvil - Diccionario Ilustrado de las Nuevas TecnologíasCalificación: 4.5 de 5 estrellas4.5/5 (14)

- Ciberseguridad industrial e infraestructuras críticasDe EverandCiberseguridad industrial e infraestructuras críticasAún no hay calificaciones

- Todo Sobre Tecnología Blockchain: La Guía Definitiva Para Principiantes Sobre Monederos BlockchainDe EverandTodo Sobre Tecnología Blockchain: La Guía Definitiva Para Principiantes Sobre Monederos BlockchainAún no hay calificaciones

- Problemas resueltos de Hidráulica de CanalesDe EverandProblemas resueltos de Hidráulica de CanalesCalificación: 4.5 de 5 estrellas4.5/5 (7)

- EL MARKETING DE MANERA SENCILLA. La guía práctica sobre las estrategias básicas de mercadotecnia profesional y orientación comercialDe EverandEL MARKETING DE MANERA SENCILLA. La guía práctica sobre las estrategias básicas de mercadotecnia profesional y orientación comercialCalificación: 4.5 de 5 estrellas4.5/5 (7)

- Manual de prácticas de Ingeniería de Alimentos: Propiedades, operaciones y bioprocesosDe EverandManual de prácticas de Ingeniería de Alimentos: Propiedades, operaciones y bioprocesosAún no hay calificaciones

- Curso básico de Python: La guía para principiantes para una introducción en la programación con PythonDe EverandCurso básico de Python: La guía para principiantes para una introducción en la programación con PythonAún no hay calificaciones

- La psicología del trading de una forma sencilla: Cómo aplicar las estrategias psicológicas y las actitudes de los comerciantes ganadores para operar con éxito en línea.De EverandLa psicología del trading de una forma sencilla: Cómo aplicar las estrategias psicológicas y las actitudes de los comerciantes ganadores para operar con éxito en línea.Calificación: 4.5 de 5 estrellas4.5/5 (3)