Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Tema4-Mini IA

Tema4-Mini IA

Cargado por

Francisco CalveraDescripción original:

Título original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Tema4-Mini IA

Tema4-Mini IA

Cargado por

Francisco CalveraCopyright:

Formatos disponibles

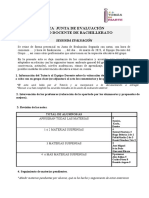

Tema 4. Representación del Conocimiento.

Incertidumbre e Imprecisión

Francisco José Ribadas Pena

INTELIGENCIA ARTIFICIAL

5o Informática

ribadas@uvigo.es

17 de enero de 2006

– c FJRP 2005 ccia ia –

4.1 Introducción

Incertidumbre e imprecisión

Hasta ahora se ha manejado conocimiento categórico

• conocimiento siempre era verdadero o falso

• razonamiento ”exacto” (reglas, hechos y conclusiones no ambiguos)

En el ”mundo real”

• el conocimiento es dudoso y/o incompleto

• el sistema inteligente puede no tener acceso a toda la info. necesaria

• el razonamiento es inexacto (hechos y/o reglas inciertas)

Incertidumbre: falta de info. adecuada para tomar una decisión o

realizar un razonamiento

• Puede impedir llegar a una conclusión correcta

Ejemplos:

• Incertidumbre

∀x tieneF iebre(x) → tieneGripe(x)

No es necesariamente cierto en todos los casos. Una persona

con fiebre puede tener catarro, bronquitis, etc. Una forma ”mas

correcta” (pero poco util) serı́a:

∀x tieneF iebre(x) → tieneGripe(x) ∨ tieneCatarro(x) ∨ tieneBronquitis(x) ∨ ...

• Incertidumbre

∀x f iebreAlta(x) ∧ dolorM uscular(x) → tieneGripe(x)

∀x f iebreAlta(x) ∧ dolorM uscular(x) → tieneEbola(x)

¿A cuál de las dos ”reglas” habrı́a que hacer más caso?

• Imprecisión

∀x f renteM uyCaliente(x) → f iebreAlta(x)

¿Cúando es Verdadero o Falso el antecedente?

– c FJRP 2005 ccia ia – 1

Causas:

• Falta de conocimiento (o conocimiento incompleto)

◦ No es posible identificar o manejar todo el conocimiento relevante

(o no es práctico hacerlo)

◦ Ignorancia:

⋄ no existe conocimiento completo de un dominio determinado

⋄ aún habiéndolo, no se puede acceder a todos los datos que serı́an relevantes

• Inexactitud del conocimiento

◦ Manejo de conocimiento erróneo (errores de lectura de un sensor,

error humano, creencias falsas,...)

◦ Imprecisión en la formulación del conocimiento (ambigüedad en

el significado de las reglas y hechos)

◦ Inferencias previas incorrectas (incertidumbre en cascada)

◦ Conocimiento contradictorio

Técnicas generales

Idea básica: Asociar a los elementos del formalismo de representación

informacion adicional (normalmente valores numéricos) que indique su

grado de certeza y manejar esa info. en las inferencias

• grados de certidumbre

• probabilidades

• grados de verdad

Teorı́a de las probabilidades

• La probabilidad ”resume” en un número la incertidumbre respecto

a un hecho

• Modelo teóricos sólido y bien conocido

• Problemas:

◦ En ocasiones poco intuitivo.

En algunos dominios puede no ser ”natural” pensar en términos de probabi-

lidades

◦ Restrictivo.

Para su aplicación práctica necesita asumir ciertas propiedades (independencia

entre variables aleatorias) que no siempre se ajustan a la realidad.

– c FJRP 2005 ccia ia – 2

Modelo de los factores de certidumbre

• Modelo ”ad hoc” desarrollado originalmente para sistemas de

diagnóstico médico basados en reglas

• Carece de base teórica sólida

• Muy intuitivo (facilita adquisición de conocim. de expertos)

• Asocia a los hechos y reglas factores de certidumbre

◦ cuantifican el grado de confianza y desconfianza en ellos

◦ en las inferencias se combinan y propagan los valores de certi-

dumbre asociados a los elementos implicados para obtener otros

nuevos

Lógica difusa

• Ampliación de la lógica clásica

• Orientada a dar soporte a razonamiento con imprecisión

• Uso de grados de verdad

◦ los elementos de la lógica no son totalmente Verdaderos o Falsos

◦ se establece una gradación

• Reglas de inferencia (modus ponens difuso) combinan esos grados

de verdad

– c FJRP 2005 ccia ia – 3

4.2 Razonamiento probabilı́stico

Modelo teórico más sólido para manejar incertidumbre.

Ofrece un lenguaje formal para representar conocimiento incierto y meca-

nismos para razonar con él.

4.2.1 Teoria de la Probabilidad

(a) Variables aleatorias

Vars. aleatorias: representan caracterı́sticas del dominio

8

< proposiciones: Verdadero/Falso

Pueden ser: medidas fı́sicas: valor numérico

categorı́as: colores, letras,...

:

P (V1 = v1 , V2 = v2 , ..., Vn = vn ) : (probab. a priori) probab. conjunta

de que las variables V1, V2, ..., Vn tomen los valores v1, v2, ..., vn

• Tambien se representa como P (V1 = v1 ∧ V2 = v2 ∧ ... ∧ Vn = vn)

• Toma valores en el intervalo [0, 1]:

0: creencia inequı́voca en que la afirmación es Falsa

1: creencia inequı́voca en que la afirmación es Cierta

[0,1]: niveles intermedios de certeza

• Se verifica: v1,v2,...,vn P (V1 = v1, V2 = v2, ..., Vn = vn) = 1

P

• Probab. a priori se obtenen:

◦ mediante técnicas estadı́sticas (muestreo, estudio de frecuencias,...)

◦ basándose en reglas generales (modelos estadı́sticos)

◦ de forma subjetiva (asignadas por experto)

Nota: de ahora en adelante consideraremos que las vars. aleatorias se

refieren unicamente

a proposiciones lógicas con valores V/F.

Vi = V erdadero Vi

Notación:

Vi = F also ¬Vi

– c FJRP 2005 ccia ia – 4

(b) Probabilidad Condicional

Probab. a priori (incondicional): probab. de que determinadas vars. aleatorias

tomen un conjunto determinado de valores, sin ningún conocimiento previo de otras

situaciones. (ej. P (bateria encendida))

Probab. a posteriori (condicional): probab. de que determinadas vars. alea-

torias tomen un conjunto determinado de valores en función de conocimiento so-

bre los valores tomados por otro conj. de variables en situaciones previas. (ej.

P (bateria encendida|robot se mueve))

Utilidad: Se pretende usar la info. sobre el valor de unas variables, para

obtener la probabilidad de otras

inferencia probabilı́stica

lo veremos en términos de hipótesis (Hi) y evidencias (Ej ).

Definición probab. condicional:

P (Hi ,Ej ) ”Probab. de la hipótesis Hi condiconado

P (Hi |Ej ) = P (Ej ) a que la evidencia Ej sea cierta”

Util en diagnóstico, como ”modificador” de la certeza de las reglas

IF fiebre THEN gripe WITH P (gripe|f iebre) = 0, 75

Puede expresarse probab, conjunta en base a probab. condicionadas

P (Hi , Ej ) = P (Hi |Ej ) · P (Ej )

Con n variables: Regla del producto

Qn

P (V1 , V2 , ..., Vn−1 , Vn ) = i=1 P (Vi |Vi−1 , Vi−2 , ..., V1 ) =

= P (Vn |Vn , Vn−1 , ..., V1 ) · P (Vn−1 |Vn−1 , ..., V1 ) · ... · P (V2 |V1 ) · P (V1 )

– c FJRP 2005 ccia ia – 5

(c) Teorema de Bayes

En la práctica es difı́cil calcular/estimar directamente los valores P (H|E)

Más fácil disponer de valores para P (E|H), P (H), y P (E).

Sobre todo si existe una relación cuasal entre H y E .

La hipótesis H es causante de la evidencia E

Especialmente útil en tareas de diagnóstico

Teorema de Bayes

P (H, E) = P (E, H) (usando regla del producto)

P (H, E) = P (H|E)P (E) = P (E|H)P (H) = P (E, H)

P (E|H)P (H)

P (H|E) = P (E)

Ejemplo: Diagnóstico médico

Ante un paciente con fiebre (evidencia), se desea determinar qué enfermedad tiene:

gripe, bronquitis o ébola (hipótesis)

Idea base: Bastará calcular las probabilidades de todas las posibles hipótesis en base a

las evidencias disponibles y tomar la/las más probable/probables

¿P (gripe|f iebre)? ¿P (bronquitis|f iebre)? ¿P (ebola|f iebre)?

Difı́cil estimar ese tipo de probabilidades (P (H|E)). Más fácil estimar P (E|H) si hay

relación causa-efecto.

¿P (gripe|muerte)?, ¿P (ebola|muerte)? Probab. de que un muerto tenga gripe/ébola

P (muerte|gripe) = 0, 03, P (muerte|ebola) = 0, 9 Probab. de que un paciente de gripe/ébola muera

– c FJRP 2005 ccia ia – 6

Asumumos que se dispone de las siguientes reglas causales, ”cuantificadas” con las

probabilidades condicionadas

IF gripe THEN fiebre P (f iebre|gripe) = 0, 85

IF bronquitis THEN fiebre P (f iebre|bronquitis) = 0, 80

IF ébola THEN fiebre P (f iebre|ebola) = 0, 95

(Probab. de que la gripe/bronquitis/ébola provoque fiebre)

Se dispone de P (f iebre) = 0, 45: Incidencia de fiebre (el 45 % de los enfermos tiene fiebre)

Se dispone de P (gripe) = 0, 35, P (bronquitis) = 0, 10 y P (ebola) = 0, 0001: Indicencia

de las enfermedades (gripe, bronquitis y ébola)

Aplicando el Teorema de Bayes

P (f iebre|gripe)P (gripe) 0,85·0,35

P (gripe|f iebre) = = 0,45 = 0, 661

P (f iebre)

P (f iebre|bronquitis)P (bronquitis) 0,80·0,10

P (bronquitis|f iebre) = = 0,45 = 0,178

P (f iebre)

P (f iebre|ebola)P (ebola) 0,95·0,0001

P (ebola|f iebre) = = 0,45 = 0,0002

P (f iebre)

– c FJRP 2005 ccia ia – 7

Nota: No es estrictamente necesario disponer de P (E)

Uso de probabilidades relativas (bastan para ”seleccionar” la/s me-

jor/es hipótesis)

P (H|E) ≈ P (E|H)P (H)

1 , factor normaliz. para obtener probab. e

P (H|E) = αP (E|H)P (H)con α = P (E)

Reformular teorema de Bayes introduciendo ¬H

P (E)

P (H|E) + P (¬H|E) = 1 = P (E)

P (E|H)P (H) P (E|¬H)P (¬H) P (E)

P (E)

+ P (E)

= P (E)

P (E) = P (E|H)P (H) + P (E|¬H)P (¬H)

Teorema de Bayes

P (E|H)P (H)

P (H|E) =

P (E|H)P (H) + P (E|¬H)P (¬H)

Conclusión: Para obtener la probab. de las hipótesis (Hi y ¬Hi) condicio-

nadas a las evidencias Ej , bastará con estimar/disponer en la ”base de

conocimiento” de las siguientes probab.:

P (Ej |Hi ) IF Hi THEN Ej WITH probab P (Ej |Hj )

P (Ej |¬Hi ) IF ¬Hi THEN Ej WITH probab P (Ej |¬Hj )

P (H)

– c FJRP 2005 ccia ia – 8

(d) Teorema de Bayes con Múltiples Evidencias (com-

binación de evidencias)

Generalización de la regla del producto P (V1 , V2 , ..., Vn |E) =

Q n

i=1 P (Vi |Vi−1 , Vi−2 , ..., V1 , E) =

= P (Vn |Vn , Vn−1 , ..., V1 , E)·P (Vn−1 |Vn−1 , ..., V1 , E)·...·P (V2 |V1 , E)·

P (V1 |E)

Teorema de Bayes con 2 evidencias

P (E1 ,E2 |H)P (H) P (E1 |E2 ,H)P (E2 |H)P (H)

P (H|E1 , E2 ) = P (E1 ,E2 )

= P (E1 |E2 )P (E2 )

(El denominador P (E1 , E2 ) puede omitirse (uso prob. relativas o introducir ¬H ))

Aplicando la regla del producto generalizada puede extenderse a n evi-

dencias.

Problema: Al incluir más evidencias el número de probab. conjuntas

distintas a especificar/estimar crece exponencialmente.

Ejemplo: Inclusión de nuevas evidencias sobre el paciente: tos y dolor de pecho

P (f iebre|tos,dolor,gripe)P (tos|dolor,gripe)P (dolor|gripe)P (gripe)

P (gripe|f iebre, tos, dolor) =

P (f iebre|tos,dolor)P (tos|dolor)P (dolor)

En general, en este caso se necesitarı́a disponer en la B.C. de probab. de la forma:

P (f iebre|tos, dolor, gripe) P (f iebre|tos, gripe) P (f iebre|gripe)

P (tos|f iebre, dolor, gripe) P (f iebre|dolor, gripe) P (tos|gripe)

P (dolor|f iebre, tos, gripe) P (tos|f iebre, gripe) P (dolor|gripe)

P (tos|dolor, gripe)

P (dolor|f iebre, gripe)

P (dolor|dolor, gripe)

Conclusión: En la práctica no es directamente aplicable el Teorema de

Bayes, se necesita imponer restricciones que simplifiquen el cálculo.

– c FJRP 2005 ccia ia – 9

(e) Independencia Condicional

Restrición adicional impuesta sobre las evidencias que permite simplicar

el cáculo de probabilidades condicionadas

Definición: Una variable Vi es condicionalmente independiente de otra

variable Vj , dado un conjunto de variables V (puede ser vacio) si:

P (Vi |Vj V) = P (Vi |V)

La variable Vj no afecta a las probabilidades de la variable Vi .

Una vez que se sabe algo sobre V , no importa lo que se sepa de Vj de cara a calcular

probabilidades relacionadas con Vi .

Se puede extender a conjuntos de variables.

Consecuencia: Si Vi y Vj son condicionalmente independientes respecto

aV

P (Vi , Vj |V) = P (Vi |V)P (Vj |V)

(P (Vi , Vj |V) = P (Vi |Vj , V)P (Vj |V) = P (Vi |V)P (Vj |V))

Regla del producto con vars. independientes

En general, si todas la vars. son mutuamente independientes respecto a

V , se simplifica la regla del producto

Qn

P (V1 , V2 , ..., Vn |V) = i=1 P (Vi |V) = P (V1 |V)P (V2 |V)...P (Vn |V)

Teorema de Bayes con variables independientes

Si E1 y E2 son condicionalmente independientes respecto a H

P (E2 |H)P (E1 |H)P (H)

P (H|E1 , E2 ) = P (E1 ,E2 )

– c FJRP 2005 ccia ia – 10

Conclusión: Si las vars. son condicionalmente independ. el número de

probabilidades a especificar crece linealmente con el número de evidencias.

Ejemplo.

Si se asume que fiebre, tos y dolor sólo dependen de si el paciente tiene gripe, no los

unos de los otros, tenemos:

P (f iebre|gripe)P (tos|gripe)P (dolor|gripe)P (gripe)

P (gripe|f iebre, tos, dolor) =

P (f iebre, tos, dolor)

Solo necesitamos: P (f iebre|gripe), P (tos|gripe), P (dolor|gripe) y P (gripe)

Nota: Esta simplificacion del teorema de Bayes solo es posible si las

evidencias E1 y E2 son independientes entre si dado H .

Normalmente en el caso de relaciones causales suele existir independencia

dada la causa (= hipotesis H ).

Si H es causa de E1 y E2, entonces ambas seran independientes entre si

dado H .

P (E1 |H, E2 ) = P (E1 |H)

P (E2 |H, E1 ) = P (E2 |H)

Nos interesara identificar esas relaciones causales.

Redes Bayesianas: Estructuras de datos para representar relaciones de dependencia e

independencia condicional

Tambien redes de creencias o redes causales.

Muy usadas en inferencia probabilistica

Determina ”implicitamente” que variables son condicionalmente independientes ⇒

ahorro de calculos

– c FJRP 2005 ccia ia – 11

4.2.2 Redes Bayesianas

Definición

Representación gráfica de dependencias condicionales para razona-

miento probabilı́stico

Red bayesiana: Grafo dirigido acı́clico (GDA)

• Nodo: representa una variable aleatoria (puede ser causa o efecto).

• Arco Dirigido: representa una dependencia probabilı́stica entre 2

variables (normalmente relación causal)

• Cada nodo tiene asociada una tabla de probabilidades condicionales

respecto a sus padres.

◦ Especifica (cuantifica) el efecto de los padres sobre el nodo Vi

◦ A los nodos sin padres (evidencias/percepciones iniciales) se les

asocia su probabilidad a priori.

Se verifica: Vi es condicionalmente independiente de cualquier con-

junto A de nodos no descendientes de Vi, dados sus padres (conjunto

padres(Vi))

• Siendo A cualquier conj. de no descencientes de Vi

• Dados los padres de Vi, Vi es independiente de A

P (Vi |A, padres(Vi )) = P (Vi |padres(Vi ))

NOTA: Normalmente los arcos representan relaciones causales.

Vi −→ Vj ≈ “Vi es la causa de Vj ”

Ejemplo:

– c FJRP 2005 ccia ia – 12

Interpretación de las R.B.

Las R.B. tienen dos componentes:

• topologı́a de la red: arcos representan relaciones causales

• conjunto de probab. condicionadas parciales: “cuantifican” esas

relaciones

2 posibles formas de interpretarlas

1. Representación distribuida de las prob. conjuntas de las variables

de la red

• R.B. permite calcular cualquier probab. conjunta donde inter-

vengan nodos de la red

• Cada nodo es independiente condicionalmente respecto a sus no

descendientes, dados sus padres.

• Suponiendo un “ordenamiento adecuado” de las variables impli-

cadas, tomando como base el GDA.

◦ ORDENAMIENTO: Dado Vi, supondremos que todos los Vk con

k ≤ i están “por encima” de Vi en la R.B.

◦ Resulta: P (Vi|Vi−1, Vi−2, . . ., V1) = P (Vi|padres(Vi))

→ en Vi−1, Vi−2, . . ., V1 están los padres de Vi (orden “adecuado”)

→ los demás nodos no influyen

• La probabilidad conjunta global era: (regla del producto)

1

Y

P (V1 , V2 , . . ., Vn ) = P (Vi |Vi−1 , Vi−2 , . . ., V1 )

i=n

• En R.B. resulta: (regla del producto en RB)

1

Y

P (V1 , V2 , . . ., Vn ) = P (Vi |padres(Vi ))

i=n

• Ejemplo:

– c FJRP 2005 ccia ia – 13

2. Representación de un conj. de independencias condicionales

• Topologı́a de la red representa independencias condicionales

• En general: si un arco representa una relación causal, implı́cita-

mente da lugar a una independencia condicional

• Ejemplo:

• R.B ≈ base de reglas causales + tabla prob. condic.

• NOTA: Además de independencias basadas en los padres, pueden

existir otras independencias condicionales más generales.

◦ OBJETIVO: Saber si un conj. de vars. A es condicionalmente

independiente de otro conj. B dado un tercer conj. C .

◦ En general, A y B serán independientes dado C , si al eliminar

los nodos de C los nodos de A y B están desconectados.

(separación-d)

◦ Los padres siempre realizarán una separación de este tipo.

• Las relaciones de independencia simplifican:

◦ represent. del conocimiento (menos probab. a especificar)

◦ razonamiento (menos probab. a propagar + cálculo sencillo)

– c FJRP 2005 ccia ia – 14

Inferencia en R.B.

Objetivo: Realizar el cálculo de la probab. condicionada de unas variables

de consulta (hipótesis), en base a otro conjunto de variables (evidencias).

En las RR.BB., cualquier variable podrá actuar como hipótesis o

evidencia

IDEA: Se propagan probabilidades partiendo de las evidencias a través

de los arcos de la R.B., para obtener la prob. de las hipótesis.

4 tipos de inferencia en función de la situación de hipótesis y evidencias

dentro de la topologı́a de la red.

(a) Inferencia Causal (descendente)

Queremos conocer la probab. de un efecto suponiendo que “sabe-

mos” que su causa ha sucedido.

Conocemos las causas, queremos evaluar sus efectos

evidencias = causas

hipótesis = efectos

Determinar P(Q|E), donde E es causa de Q.

Ejemplo: P (JuanLlama|Robo)

Cálculo de la probabilidad:

• Cálculo ascendente de forma iterativa, a través de la red.

1. introducir todas las posibles combinaciones de padres del nodo

Q que no sean evidencias, condicionadas a las evidencias E .

P (JuanLlama|Robo) = P (JuanLlama, Alarma|Robo)+

P (JuanLlama, ¬Alarma|Robo)

“la prob. de que llame si hubo un robo es igual a la prob. de que suene la alarma y llame

cuando hubo robo más la prob. de que no suene la alarma y llame cuando hubo robo”

2. transformar la expresión para que quede condionada a los

padres (usar regla del producto)

= P (JuanLlama|Alarma, Robo)P (Alarma|Robo)+

P (JuanLlama|¬Alarma, Robo)P (¬Alarma|Robo)

– c FJRP 2005 ccia ia – 15

3. aplicar la independencia respecto a los padres para simplificar

las probab. (eliminación de las evidencias iniciales E )

= P (JuanLlama|Alarma) P (Alarma|Robo)+

P (JuanLlama|¬Alarma) P (¬Alarma|Robo)

4. repetir estos pasos para las probab. de padres condiciondos a

las evidencias E (paso iterativo [son inferencias causales])

→ parar cuando se llegue a los nodos superiores (no condicionados)

P (Alarma|Robo) = P (Alarma, T emblor|Robo) + P (Alarma, ¬T emblor|Robo) =

= P (Alarma|T emblor, Robo)P (T emblor|Robo)+

P (Alarma|¬T emblor, Robo)P (¬T emblor|Robo)

no depende de otras vars.

◦ T emblor es una causa sin padres ⇒

tenemos su prob. a priori

◦ P (Alarma|T emblor, Robo) y P (Alarma|¬T emblor, Robo) ya están en

las tablas de probab. parciales del nodo Alarma

◦ MISMO RAZONAMIENTO para P (¬Alarma|Robo)

• Al final, en el cálculo sólo aparecerán probabilidades a priori de

los nodos sin padres y probabilidades condicionadas diponibles

en las tablas parciales de la R.B.

(b) Inferencia de Diagnóstico (ascendente)

Queremos conocer la probab. de una causa suponiendo que “sabe-

mos” que su efecto ha sucedido.

Conocemos

los efectos, queremos evaluar sus causas

evidencias = efectos

hipótesis = causas

Determinar P(Q|E), donde Q es causa de E .

Ejemplo: P (Robo|JuanLlama)

Cálculo de la probabilidad:

• Aplicar teorema de Bayes para transformar el problema en una

inferencia causal.

P (JuanLlama|Robo)P (Robo)

P (Robo|JuanLlama) =

P (JuanLlama)

P (JuanLlama|Robo) es una inferencia causal pura ⇒ usar cálculo anterior

P (JuanLlama) se puede omitir o reescribir.

– c FJRP 2005 ccia ia – 16

(c) Inferencia Intercausal (justificación)

Queremos conocer la probab. de una causa condicionada a que

“sabemos” que su efecto se ha producido y que también ha

sucedido otra posible causa de dicho efecto.

Conocemos los efectos y una causa, queremos evaluar otra causa

posible

evidencias = efectos + causa

hipótesis = otra causa posible

Determinar P(Q1|E, Q2), donde Q1 y Q2 son causas de E .

• Ver cómo afecta el conocimiento de una causa a la probab. de otra

• Suele suceder que la presencia de una causa disminuya la probab. de la otra

Ejemplo: P (Robo|Alarma, T emblor) (≤ P (Robo|Alarma))

Cálculo de la probabilidad:

• Aplicar el teorema de Bayes y transformarlo en inferencias cau-

sales y de diagnótico puras.

P (Alarma,T emblor|Robo)P (Robo)

P (Robo|Alarma, T emblor) = =

P (Alarma,T emblor)

P (Alarma|T emblor,Robo)P (T emblor|Robo)P (Robo)

=

P (Alarma|T emblor)P (T emblor)

• NOTA: Realmente se tratará como una inferencia mixta

(d) Inferencia Mixta

Combinación de las inferencias anteriores.

Ejemplo: P (Alarma|T emblor, JuanLlama) (inf. causal + diagnóstico)

– c FJRP 2005 ccia ia – 17

Algoritmos de Propagación de Probabilidades

Implementación de la inferencia probabilı́stica para el caso general

(inferencias mixtas)

Depende de la estructura de la red.

• Árboles: estructuras más sencillas

• Poliárboles: entre 2 nodos cualquiera existe como máximo una ruta

no dirigida

• Redes Multiconectadas: sin restricciones en la topologı́a

Propagación en árboles y poliárboles

• Caso más simple (existe algoritmo lineal)

• Se distinguen dos componentes en el conj. de evidencias totales

(E ).

+ −

◦ P (Q|E) con E = EQ ∪ EQ

◦ E+ Q : apoyo causal de Q

⋄ conj. de vars. de evidencia ”por encima” de Q

⋄ conectadas a Q a través de sus padres

◦ E− Q : apoyo evidencial de Q

⋄ conj. de vars. de evidencia ”por debajo” de Q

⋄ conectadas a Q a través de sus hijos

◦ Conjuntos separados por el nodo de consulta Q

+ −

⇒ EQ y EQ son independientes (separación-d mediante Q)

P (E − ,E + |Q)P (Q)

P (Q|E) = P (Q|E − , E + ) = = (teorema de Bayes)

P (E − ,E + )

P (E − |E + ,Q)P (E + |Q)P (Q)

= = (regla producto)

P (E − ,E + )

P (E − |Q)P (E + |Q)P (Q)

= (independ. E- y E+ dado Q

P (E − ,E + )

⋄ P (E −, E +) puede omitirse o reescribirse

⋄ P (E −|Q) es una inferencia causal

⋄ P (E +|Q) es una inferencia de diagnóstico

• Ejemplo: poliárbol

– c FJRP 2005 ccia ia – 18

Propagación en redes multiconectadas

• Mayor complejidad ⇒ necesidad de técnicas alternativas

• IDEA: uso de métodos aproximados

◦ simplificar la red para obtener poliárboles

◦ forzar algunas trayectorias instanciando el valor ciertas variables

◦ uso de simulaciones previas para asignar valores a variables

– c FJRP 2005 ccia ia – 19

4.2.3 Inconvenientes de los métodos probabilı́sticos

Requiere gran cantidad de datos estadı́sticos para construir Base de

Conocim.

• determinar/estimar todas las prob. a priori y condicionadas nece-

sarias

• en R.B., además especificar topologı́a

◦ existen técnicas de aprendizaje automático que construyen RB

en base a grandes colecciones de datos de entrenamiento.

Dificultad para explicar el razonamiento efectuado.

• las relaciones se reducen a números

En algunos dominios da lugar a contradicciones

• Teorı́a de la probab. permite que una misma evidencia apoye a la

vez a la hipótesis y su negación (no aceptable en algunos dominios)

Probab. de diagnóstico Interpretación causal

P (gripe|f iebre) = 0,75 gripe origina fiebre

P (¬gripe|f iebre) = 0,25 no-gripe origina fiebre

• Exigencias sobre independencia pueden no ”encajar” en la visión

del mundo de los expertos.

Como respuesta surgieron técnicas heurı́sticas menos formales.

– c FJRP 2005 ccia ia – 20

También podría gustarte

- Pruebadehiptesisparadistribucionesnormalytstudent 170104054445 PDFDocumento25 páginasPruebadehiptesisparadistribucionesnormalytstudent 170104054445 PDFkjatariAún no hay calificaciones

- Monografia Estadistica FinalDocumento25 páginasMonografia Estadistica FinalPercy Alex Sanchez Mendoza100% (2)

- HipotesisDocumento23 páginasHipotesisFigueroa CristianAún no hay calificaciones

- BAYESIANADocumento103 páginasBAYESIANAjresendiznAún no hay calificaciones

- Redes Bayesianas1Documento39 páginasRedes Bayesianas1Carolina Flores VillalbaAún no hay calificaciones

- Clase 4. ModeladoDocumento18 páginasClase 4. ModeladoVictor GomezAún no hay calificaciones

- Prueba de HipotesisDocumento9 páginasPrueba de Hipotesisl_fitoAún no hay calificaciones

- Estadistica Semana 11 s1Documento19 páginasEstadistica Semana 11 s1Adriana HilarioAún no hay calificaciones

- Pruebas de Hipotesis Con Una Muestra S9Documento16 páginasPruebas de Hipotesis Con Una Muestra S9ERICK RICARDO VEINTIMILLA SALAZARAún no hay calificaciones

- S04.s1 - Material EIPs - Marzo 2023Documento33 páginasS04.s1 - Material EIPs - Marzo 2023Angela Palomino100% (1)

- S11.s1 - MaterialDocumento20 páginasS11.s1 - Materialnathaly nicol ramirez garciaAún no hay calificaciones

- Prueba de HipotesisDocumento30 páginasPrueba de HipotesisJose A. CubaAún no hay calificaciones

- S05.s1 Prueba de HipotesisDocumento20 páginasS05.s1 Prueba de HipotesisMargorith RamosAún no hay calificaciones

- Prueba de HipótesisDocumento41 páginasPrueba de Hipótesissebastian benitez rodriguezAún no hay calificaciones

- Wuolah-Free-Conceptos Clave Tema 3 - MetodologíaDocumento4 páginasWuolah-Free-Conceptos Clave Tema 3 - MetodologíaAlejandro Moreno MuñozAún no hay calificaciones

- Distribucion de Chi CuadradoDocumento23 páginasDistribucion de Chi CuadradodanielymiriamAún no hay calificaciones

- Conferencia 4. Tratamiento de La IncertidumbreDocumento29 páginasConferencia 4. Tratamiento de La IncertidumbreYoansel Ruiz100% (1)

- Clase 2 Pruebas de HipótesisDocumento17 páginasClase 2 Pruebas de HipótesisDeivid Carvajal CcoilloAún no hay calificaciones

- Lectura Obligatoria 04Documento53 páginasLectura Obligatoria 04CARMEN VELASQUEZ LOPEZAún no hay calificaciones

- T6 Tests 3Documento33 páginasT6 Tests 3Pilar de la CruzAún no hay calificaciones

- 2 InferenciaDocumento39 páginas2 InferenciaMarilo Rus GuerreroAún no hay calificaciones

- Pruebas de SignificanciaDocumento43 páginasPruebas de SignificanciaJaspin SpAún no hay calificaciones

- Prueba de Hipotesis CompletoDocumento60 páginasPrueba de Hipotesis CompletoJANINA YASUMAAún no hay calificaciones

- Conocimiento Científico: Sistematización Del Conocimiento CotidianoDocumento18 páginasConocimiento Científico: Sistematización Del Conocimiento Cotidianoyelab gaytan pazosAún no hay calificaciones

- Practica Ix GQDocumento4 páginasPractica Ix GQLouis Michael MHAún no hay calificaciones

- 9 2redes Bayesianas1Documento25 páginas9 2redes Bayesianas1Alfredo Cori MamaniAún no hay calificaciones

- Tema II PHDocumento7 páginasTema II PHGriselys CaraballoAún no hay calificaciones

- Epistemología Clase 4 El Método Hipotético Deductivo en Versión SimpleDocumento19 páginasEpistemología Clase 4 El Método Hipotético Deductivo en Versión SimpleMarco De NinisAún no hay calificaciones

- Semana 10 - Introducción A Contraste de HipótesisDocumento26 páginasSemana 10 - Introducción A Contraste de HipótesisSandra Paola Urpeque ChepeAún no hay calificaciones

- Lrcial CompressedDocumento9 páginasLrcial CompressedVeronica Celeste MartinoAún no hay calificaciones

- Metodos Inductivo y DeductivoDocumento36 páginasMetodos Inductivo y DeductivoarimovilAún no hay calificaciones

- Prueba HipótesisDocumento25 páginasPrueba HipótesisUnacPerúAún no hay calificaciones

- Cap III BDocumento30 páginasCap III BDesconAún no hay calificaciones

- C - Compendio Bioestadistica 2021Documento51 páginasC - Compendio Bioestadistica 2021Vania Caro100% (1)

- 5 Pruebas de HipótesisDocumento17 páginas5 Pruebas de HipótesisDaniel AltamiranoAún no hay calificaciones

- U2 - 3 Hipotesis y Errores y Seleccion de Pruebas de HipotesisDocumento17 páginasU2 - 3 Hipotesis y Errores y Seleccion de Pruebas de HipotesisJorge AntonioAún no hay calificaciones

- Wuolah Premium T4.CA - EsDocumento6 páginasWuolah Premium T4.CA - EsAneMiren22Aún no hay calificaciones

- Pruebas de SignificanciaDocumento43 páginasPruebas de Significanciajuan jose de la torreAún no hay calificaciones

- Metodología de La Prueba de Hipótesis (I)Documento19 páginasMetodología de La Prueba de Hipótesis (I)Erik victor Anchivilca ZavaletaAún no hay calificaciones

- Autoevaluación 5 - ESTADISTICA APLICADA PARA LOS NEGOCIOS (8675)Documento7 páginasAutoevaluación 5 - ESTADISTICA APLICADA PARA LOS NEGOCIOS (8675)yris cuya hurtadoAún no hay calificaciones

- Clase Prueba de HipotesisDocumento18 páginasClase Prueba de HipotesisJeimy Hernandez LopezAún no hay calificaciones

- Unidad 3 y 4Documento119 páginasUnidad 3 y 4Paola PérezAún no hay calificaciones

- SESIÓN 9 DMAIC Hipótesis-ANOVADocumento47 páginasSESIÓN 9 DMAIC Hipótesis-ANOVAMelh RaimondiAún no hay calificaciones

- (TEORÍA) Prueba de Hipótesis para Una MuestraDocumento7 páginas(TEORÍA) Prueba de Hipótesis para Una MuestraJulio GirónAún no hay calificaciones

- HipotesisDocumento24 páginasHipotesisCervantes Jose Villarreal CalderonAún no hay calificaciones

- S1 Pruebas de HipótesisDocumento54 páginasS1 Pruebas de HipótesisKarla RodriguezAún no hay calificaciones

- Prueba de HipotesisDocumento54 páginasPrueba de HipotesisLuis Carlos Arias CelisAún no hay calificaciones

- 09.los Trabajos Experimentales-1Documento23 páginas09.los Trabajos Experimentales-1Nadia Belén OvandoAún no hay calificaciones

- Metodología de La Investigación Científica: Universidad Michoacana de San Nicolás de HidalgoDocumento301 páginasMetodología de La Investigación Científica: Universidad Michoacana de San Nicolás de HidalgoGuzman SánchezAún no hay calificaciones

- S0009739X03721629Documento5 páginasS0009739X03721629mishellrodriguezaAún no hay calificaciones

- 01conferencia - 1 Probabilidad y Modelo de DistribucionDocumento32 páginas01conferencia - 1 Probabilidad y Modelo de DistribucionLorena VélizAún no hay calificaciones

- Notas - Argumentación 1Documento7 páginasNotas - Argumentación 1Morales98Aún no hay calificaciones

- Prueba de Hipotesis - ADocumento31 páginasPrueba de Hipotesis - AFranklin WilkinsAún no hay calificaciones

- Sem3 - Módulo 5 - VC 2020-0Documento35 páginasSem3 - Módulo 5 - VC 2020-0Jimena AngelesAún no hay calificaciones

- Estad Quim TH1Documento10 páginasEstad Quim TH1gustavoAún no hay calificaciones

- Clase 04 ProbabilidadesDocumento25 páginasClase 04 ProbabilidadesCamila Mycal De La Cruz NorabuenaAún no hay calificaciones

- Taller 2 TABLAS PIKARDocumento2 páginasTaller 2 TABLAS PIKARJoel JmcAún no hay calificaciones

- De Santa María: Universidad CatólicaDocumento18 páginasDe Santa María: Universidad CatólicaLuis Angel AlarconAún no hay calificaciones

- TALLER Capacitacion y DesarrolloHumanoDocumento2 páginasTALLER Capacitacion y DesarrolloHumanoErica Yohana Ramirez PereaAún no hay calificaciones

- Rúbrica de Química GneralDocumento2 páginasRúbrica de Química GneralParis Mia AUGIER BOHORQUEZAún no hay calificaciones

- Trabajo de Mecanica de Rocas IIDocumento3 páginasTrabajo de Mecanica de Rocas IIElizabeth NinaAún no hay calificaciones

- Plantas Medicinales de La Región PatagónicaDocumento24 páginasPlantas Medicinales de La Región PatagónicaBandu SifuentesAún no hay calificaciones

- Final Cuentos de La SelvaDocumento8 páginasFinal Cuentos de La SelvaJACQUELINE VILLEDAAún no hay calificaciones

- Actividad 1, AlbanoMarilú (Estadística)Documento3 páginasActividad 1, AlbanoMarilú (Estadística)Daniel SandovalAún no hay calificaciones

- semana 3- Audiorreseña UPN.pdfDocumento21 páginassemana 3- Audiorreseña UPN.pdfANGEL TAIPEAún no hay calificaciones

- Barreras de Comunicacion EficazDocumento6 páginasBarreras de Comunicacion EficazjoseAún no hay calificaciones

- EBA 1ro. Avanzado-prueba-DPC-Cuadernillo 2Documento12 páginasEBA 1ro. Avanzado-prueba-DPC-Cuadernillo 2Nelson L. Blacido AparicioAún no hay calificaciones

- Actividad de Puntos Evaluables - Escenario 2 - Segundo Bloque-Teorico-Practico - Virtual - Proceso Estratégico 1 - (Grupo b18)Documento5 páginasActividad de Puntos Evaluables - Escenario 2 - Segundo Bloque-Teorico-Practico - Virtual - Proceso Estratégico 1 - (Grupo b18)Raton ElmerAún no hay calificaciones

- Beneficios PolloDocumento86 páginasBeneficios PolloKimberly Figueroa RamirezAún no hay calificaciones

- Práctico Nº1 - Segunda ParteDocumento3 páginasPráctico Nº1 - Segunda ParteFranco E. OrozcoAún no hay calificaciones

- Trabajo (TG2) CURRÍCULUMDocumento32 páginasTrabajo (TG2) CURRÍCULUMAugusto QueipulAún no hay calificaciones

- Analisis Literario-Carbajal Solano KenerDocumento14 páginasAnalisis Literario-Carbajal Solano KenerLIZ HAYLY CARBAJAL SOLANOAún no hay calificaciones

- Acta BACH. - 2º Trimestre - OdtDocumento4 páginasActa BACH. - 2º Trimestre - Odtnayara kingsAún no hay calificaciones

- Material de Apoyo 2Documento43 páginasMaterial de Apoyo 2CatherineOspinaAún no hay calificaciones

- Taller 2doc - Primera EntregaDocumento4 páginasTaller 2doc - Primera EntregaCarlosAún no hay calificaciones

- Normas Aplicables A La ConstrucciónDocumento5 páginasNormas Aplicables A La ConstrucciónJuan Jesus Ortega MartinezAún no hay calificaciones

- Escuela de Medicina Homeopática de VeronaDocumento46 páginasEscuela de Medicina Homeopática de VeronaGerardo ABAún no hay calificaciones

- Inyección de CO2 Alternada Con AguaDocumento8 páginasInyección de CO2 Alternada Con AguaAnonymous mO1f6tAsBAún no hay calificaciones

- Analisis y Diagnostico Organizacional - Actv 2Documento9 páginasAnalisis y Diagnostico Organizacional - Actv 2Adrian Curbelo DuarteAún no hay calificaciones

- Cuadros Sinópticos y Comparativos Sobre Materia y Los Cambios de EstadoDocumento5 páginasCuadros Sinópticos y Comparativos Sobre Materia y Los Cambios de EstadoferAún no hay calificaciones

- Fe Y Razón en La Filosofía Medieval: Introducción ConclusiónDocumento1 páginaFe Y Razón en La Filosofía Medieval: Introducción ConclusiónIsabel Apaza CruzAún no hay calificaciones

- 84108353Documento151 páginas84108353Yolanda Aranda RubioAún no hay calificaciones

- Aproximacion A La Cronologia de Cogotas IDocumento14 páginasAproximacion A La Cronologia de Cogotas IiñigoAún no hay calificaciones

- Estudio de Impacto Ambiental - EiaDocumento54 páginasEstudio de Impacto Ambiental - EiaGesu BlestAún no hay calificaciones

- 11611607529temario Matemática Secundaria EBR N21Documento2 páginas11611607529temario Matemática Secundaria EBR N21Luis DavilaAún no hay calificaciones

- TEMARIODocumento6 páginasTEMARIOIbrahym SánchezAún no hay calificaciones