0% encontró este documento útil (0 votos)

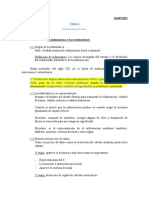

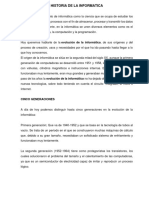

59 vistas47 páginasIntroducción a la Informática y Computación

Antecedentes de la informática

Cargado por

RoldanDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PPTX, PDF, TXT o lee en línea desde Scribd

0% encontró este documento útil (0 votos)

59 vistas47 páginasIntroducción a la Informática y Computación

Antecedentes de la informática

Cargado por

RoldanDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PPTX, PDF, TXT o lee en línea desde Scribd