0% encontró este documento útil (0 votos)

170 vistas13 páginasEstimación y Métodos en Inferencia Estadística

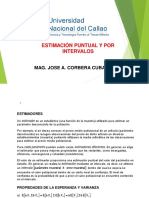

1. La estimación estadística involucra el uso de técnicas para obtener información sobre una población a partir de una muestra aleatoria.

2. Existen dos tipos principales de estimadores: puntuales, que asignan un solo valor al parámetro, e intervalos, que contienen el parámetro dentro de un intervalo con un nivel de confianza dado.

3. Para que un estimador sea útil, debe ser insesgado (su valor esperado debe ser igual al parámetro) y tener una varianza pequeña. El error cuadrado

Cargado por

Valesska SánchezDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PDF, TXT o lee en línea desde Scribd

0% encontró este documento útil (0 votos)

170 vistas13 páginasEstimación y Métodos en Inferencia Estadística

1. La estimación estadística involucra el uso de técnicas para obtener información sobre una población a partir de una muestra aleatoria.

2. Existen dos tipos principales de estimadores: puntuales, que asignan un solo valor al parámetro, e intervalos, que contienen el parámetro dentro de un intervalo con un nivel de confianza dado.

3. Para que un estimador sea útil, debe ser insesgado (su valor esperado debe ser igual al parámetro) y tener una varianza pequeña. El error cuadrado

Cargado por

Valesska SánchezDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PDF, TXT o lee en línea desde Scribd