Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Cadena de Markov

Cargado por

cesar anaya100%(1)100% encontró este documento útil (1 voto)

6 vistas6 páginasEl documento habla sobre las cadenas de Markov, que analizan las probabilidades futuras basadas en las probabilidades presentes. Una cadena de Markov asume que el sistema comienza en un estado inicial y que las probabilidades de cambiar de un estado a otro se conocen a través de una matriz de probabilidades de transición. Los estados pueden ser absorbentes, transitorios, recurrentes o periódicos dependiendo de las probabilidades de transición.

Descripción original:

REALIZAR CADENA DE MARKOV

Título original

CADENA DE MARKOV

Derechos de autor

© © All Rights Reserved

Formatos disponibles

PDF, TXT o lea en línea desde Scribd

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoEl documento habla sobre las cadenas de Markov, que analizan las probabilidades futuras basadas en las probabilidades presentes. Una cadena de Markov asume que el sistema comienza en un estado inicial y que las probabilidades de cambiar de un estado a otro se conocen a través de una matriz de probabilidades de transición. Los estados pueden ser absorbentes, transitorios, recurrentes o periódicos dependiendo de las probabilidades de transición.

Copyright:

© All Rights Reserved

Formatos disponibles

Descargue como PDF, TXT o lea en línea desde Scribd

100%(1)100% encontró este documento útil (1 voto)

6 vistas6 páginasCadena de Markov

Cargado por

cesar anayaEl documento habla sobre las cadenas de Markov, que analizan las probabilidades futuras basadas en las probabilidades presentes. Una cadena de Markov asume que el sistema comienza en un estado inicial y que las probabilidades de cambiar de un estado a otro se conocen a través de una matriz de probabilidades de transición. Los estados pueden ser absorbentes, transitorios, recurrentes o periódicos dependiendo de las probabilidades de transición.

Copyright:

© All Rights Reserved

Formatos disponibles

Descargue como PDF, TXT o lea en línea desde Scribd

Está en la página 1de 6

CADENA DE MARKOV

GENERALIDADES EL ANÁLISIS DE MARKOV ES UNA

TÉCNICA QUE MANEJA LAS PROBABILIDADES DE

OCURRENCIA FUTURA, MEDIANTE EL ANÁLISIS DE LAS

PROBABILIDADES CONOCIDAS EN EL PRESENTE. TIENE

DIVERSAS APLICACIONES EN LOS NEGOCIOS.

EL ANÁLISIS DE MARKOV SUPONE QUE EL SISTEMA

COMIENZA EN UN ESTADO O CONDICIÓN INICIAL. LAS

PROBABILIDADES DE CAMBIO DE UN ESTADO A OTRO SE

CONOCEN COMO MATRIZ DE PROBABILIDADES DE

TRANSICIÓN.

• . Existe un número limitado o finito de estados posibles.

• 2. La probabilidad de cambiar de estado permanece igual con el paso del

tiempo.

• 3. Podemos predecir cualquier estado futuro a partir del estado anterior y la

matriz de probabilidades de transición.

• 4. El tamaño y la composición del sistema no cambia durante el análisis.

CONCEPTO MATEMATICO

• Concepto matemático que sirve para usar

magnitudes aleatorias que varían con el

tiempo o para caracterizar una sucesión de

variables aleatorias que evolucionan en

función de otra variable (tiempo) § Sea Χ!

una variable aleatoria que caracteriza el

estado del sistema en puntos discretos en el

tiempo � = 1,2, … § La familia de variables

aleatorias {Χ!} forma un proceso estocástico

con una cantidad finita de estados

CLASIFICACION DE CADENA DE MARKOV

• Los estados de una cadena de Markov se clasifican con base en la probabilidad

de transición' de P

• 1. Un estado es absorbente si está seguro de regresar a sí mismo en una

transición, es decir =

• 2. Un estado es transitorio si puede llegar a otro estado pero no puede

regresar desde otro estado.

• 3. Un estado es recurrente si la probabilidad de ser revisitado desde otros

estados es 1. Esto puede suceder si, y solo si, el estado no es transitorio

• 4. Un estado es periódico con periodo > 1 si es posible un retorno sólo en

,…pasos

• Propiedad de Markov Proceso estocástico à variables aleatorias que

evolucionan a través del tiempo Un proceso estocástico es un proceso de

Markov si un estado futuro depende sólo del estado inmediatamente anterior

• Cuando la probabilidad de transición es independiente de para todo se

obtiene una cadena de Markov homogénea que se escribe de la siguiente

manera:

• Propiedad de Markov Un proceso estocástico {Xt} (t = 0, 1, . . .) es una cadena

de Markov si presenta la

También podría gustarte

- Cadena de MarkovDocumento6 páginasCadena de Markovcesar anayaAún no hay calificaciones

- Actividad 7 - Características de Los Sistemas Introducción A Las Cadenas de MarkovDocumento7 páginasActividad 7 - Características de Los Sistemas Introducción A Las Cadenas de Markovkaren alexandra sotelo leivaAún no hay calificaciones

- Cadenas de MarkovDocumento52 páginasCadenas de MarkovGloria SepúlvedaAún no hay calificaciones

- Tarea 2 IO2Documento6 páginasTarea 2 IO2Marco CastañazaAún no hay calificaciones

- Comprobación de Lectura Semana 9Documento2 páginasComprobación de Lectura Semana 9Sergio CastilloAún no hay calificaciones

- Cadenas de MarkovDocumento17 páginasCadenas de MarkovOskarSanchezAún no hay calificaciones

- Apuntes Procesos EstocásticosDocumento31 páginasApuntes Procesos EstocásticosLuis Téllez100% (1)

- Cadenas de MarkovDocumento24 páginasCadenas de MarkovIris CoralAún no hay calificaciones

- Proceso Estocástico 22023Documento33 páginasProceso Estocástico 22023darknessevil3Aún no hay calificaciones

- Qué EsDocumento96 páginasQué EsFelix Americo QuispeAún no hay calificaciones

- Javier Nava 29574304 M - S - II A - 4Documento7 páginasJavier Nava 29574304 M - S - II A - 4Javier NavaAún no hay calificaciones

- 4.1 Fernandez Lopez AdrianDocumento12 páginas4.1 Fernandez Lopez AdrianAdrian FernandezAún no hay calificaciones

- 08 Procesos de MarkovDocumento8 páginas08 Procesos de MarkovDARWIN LUIS CHÁVEZAún no hay calificaciones

- Análisis de MarkovDocumento51 páginasAnálisis de MarkovPerla_Celeste__754886% (7)

- Modelo de MarkovDocumento105 páginasModelo de MarkovEliezer VerasAún no hay calificaciones

- Cadenas de MarkovDocumento18 páginasCadenas de MarkovEl BoxeadorAún no hay calificaciones

- Clase 1Documento51 páginasClase 1ehl_kakooAún no hay calificaciones

- Análisis de MacdonaldDocumento5 páginasAnálisis de MacdonaldJohan ArjonaAún no hay calificaciones

- Investigación OperativaDocumento32 páginasInvestigación OperativaMarcos Bartra PerezAún no hay calificaciones

- Cadena-De-marko Abosorbent y Regular ConceptovDocumento19 páginasCadena-De-marko Abosorbent y Regular ConceptovTeresa Estrada BarreyraAún no hay calificaciones

- IOINFOGRAMASDocumento5 páginasIOINFOGRAMASCoco TvAún no hay calificaciones

- Cadenas de Markov: Trabajo de Investigación Unidad 4 Que PresentaDocumento19 páginasCadenas de Markov: Trabajo de Investigación Unidad 4 Que PresentaPEDRO ZEPEDA SANCHEZ100% (1)

- Investigacion Segundo ParcialDocumento10 páginasInvestigacion Segundo ParcialcindyAún no hay calificaciones

- Presentación Cadenas de MarkovDocumento12 páginasPresentación Cadenas de MarkovOmar ReyesAún no hay calificaciones

- ActExtra - U4 Rodriguez Santiago Pedro AlejandroDocumento16 páginasActExtra - U4 Rodriguez Santiago Pedro AlejandroPEDRO ALEJANDRO RODRIGUEZ SANTIAGOAún no hay calificaciones

- Cadenas de MarkovDocumento6 páginasCadenas de MarkovCindy J Lauper100% (1)

- Cadenas de Markov - Sanchez Martinez RodrigoDocumento6 páginasCadenas de Markov - Sanchez Martinez RodrigoRodrigo SanchezmtzAún no hay calificaciones

- Cadena de MarkovDocumento7 páginasCadena de MarkovCarlos ZFAún no hay calificaciones

- Trabajo Investigación Investigación de Operaciones 2Documento14 páginasTrabajo Investigación Investigación de Operaciones 2Marco CastañazaAún no hay calificaciones

- Unidad 5 Procesos EstocásticosDocumento30 páginasUnidad 5 Procesos EstocásticosLG LupAún no hay calificaciones

- Analisis de MarkovDocumento18 páginasAnalisis de MarkovMilthon Loza ChambillaAún no hay calificaciones

- Cadenas de MarkovDocumento46 páginasCadenas de MarkovGABRIEL IAN VELAZQUEZ UGALDEAún no hay calificaciones

- Analisis de MarkovDocumento47 páginasAnalisis de MarkovChristian LeónAún no hay calificaciones

- Informe Cadenas de MarkovDocumento5 páginasInforme Cadenas de MarkovAnthony TaracheAún no hay calificaciones

- Cadena de Markov. Grupo 3Documento26 páginasCadena de Markov. Grupo 3Aldair Vega AlbanAún no hay calificaciones

- Análisis de MarkovDocumento4 páginasAnálisis de Markovgustavo ctAún no hay calificaciones

- Cadenas de MarkovDocumento25 páginasCadenas de MarkovCristhianAún no hay calificaciones

- Capitulo 16 de RenderDocumento13 páginasCapitulo 16 de RenderJose Eduardo Ortega RiosAún no hay calificaciones

- Probabilidad y Estadistica Bloque 6Documento19 páginasProbabilidad y Estadistica Bloque 6Lesly TimchenkoAún no hay calificaciones

- Métodos EstadísticosDocumento12 páginasMétodos EstadísticosDiego MunozAún no hay calificaciones

- 1.4 PrrosDocumento4 páginas1.4 PrrosDaniel ReyesAún no hay calificaciones

- l3 Cadenas de MarkovDocumento46 páginasl3 Cadenas de MarkovAshly MadrigalAún no hay calificaciones

- Cadenas de MárkovDocumento10 páginasCadenas de MárkovEzdine ViescaAún no hay calificaciones

- Tecnológico Nacional de México: PeríodoDocumento20 páginasTecnológico Nacional de México: PeríodoWendy Estefania Saldivar CuervoAún no hay calificaciones

- ProcesosEstocasticos CadenasdeMarkovDocumento88 páginasProcesosEstocasticos CadenasdeMarkovRoberto Jahnsen GuerreroAún no hay calificaciones

- Cadenasdemarkov Unidad 4Documento8 páginasCadenasdemarkov Unidad 4feliizzAún no hay calificaciones

- Introduccion Al Procesos EstocasticsDocumento16 páginasIntroduccion Al Procesos Estocasticsbyron29Aún no hay calificaciones

- Proceso Estocástico 1Documento15 páginasProceso Estocástico 1Luis Enrique GarcíaAún no hay calificaciones

- Cadenas de MarkovDocumento9 páginasCadenas de MarkovJuan Francisco Montero CastilloAún no hay calificaciones

- Cadenas de MarkovDocumento6 páginasCadenas de MarkovDaniel Ordaz AlvarezAún no hay calificaciones

- Inv - Ope.2 - UNIDAD IVDocumento22 páginasInv - Ope.2 - UNIDAD IVJonathan Millan RodríguezAún no hay calificaciones

- Actividad 9 - Cadenas de Markov - Carlos Agustin Hernandez HernandezDocumento5 páginasActividad 9 - Cadenas de Markov - Carlos Agustin Hernandez HernandezCarlos HernandezAún no hay calificaciones

- Procesos Estocasticos - 1Documento39 páginasProcesos Estocasticos - 1Javier Berumen100% (1)

- Procesos de MarkovDocumento2 páginasProcesos de MarkovedwardAún no hay calificaciones

- Ensayo Cadenas de Markov - 2010Documento10 páginasEnsayo Cadenas de Markov - 2010Viviana HernándezAún no hay calificaciones

- Investigacion 1Documento10 páginasInvestigacion 1Joaquin SeñaAún no hay calificaciones

- Introducción A Las Cadenas o Procesos de MarkovDocumento3 páginasIntroducción A Las Cadenas o Procesos de MarkovAztroResendizAún no hay calificaciones

- Que Es Examen Y PRUEBA PsicométricoDocumento6 páginasQue Es Examen Y PRUEBA Psicométricocesar anayaAún no hay calificaciones

- FINANZAS LLLDocumento13 páginasFINANZAS LLLcesar anayaAún no hay calificaciones

- Politica TributariaDocumento7 páginasPolitica Tributariacesar anayaAún no hay calificaciones

- Coordinación FiscalDocumento9 páginasCoordinación Fiscalcesar anayaAún no hay calificaciones

- ADMNISTRCIONDocumento10 páginasADMNISTRCIONcesar anayaAún no hay calificaciones

- FINANZAS LLLDocumento13 páginasFINANZAS LLLcesar anayaAún no hay calificaciones

- Politica de DanoneDocumento3 páginasPolitica de Danonecesar anayaAún no hay calificaciones

- Manual de Usuario Sobre El PC Portátil: S2219 / Noviembre 2005Documento68 páginasManual de Usuario Sobre El PC Portátil: S2219 / Noviembre 2005aktechnology360Aún no hay calificaciones

- Formato Guia 11 Arboles DirigidosDocumento13 páginasFormato Guia 11 Arboles DirigidosA CAún no hay calificaciones

- Dosificacion 1 Grado 190 DiasDocumento16 páginasDosificacion 1 Grado 190 DiasFogwillAún no hay calificaciones

- El Teclado Es El Periférico de Entrada Por Excelencia Presente en Todos Los Ordenadores PortátilesDocumento5 páginasEl Teclado Es El Periférico de Entrada Por Excelencia Presente en Todos Los Ordenadores PortátilesJme MtzAún no hay calificaciones

- Erick Edu Huarancca Portilla SINU-144 - Entregable01Documento5 páginasErick Edu Huarancca Portilla SINU-144 - Entregable01Erick Huarancca Portilla100% (1)

- Las Nuevas Tecnologías de La ComunicaciónDocumento2 páginasLas Nuevas Tecnologías de La ComunicaciónEdgar Benhumea RosalesAún no hay calificaciones

- 6 Los Arreglos, Vectores y MatricesDocumento15 páginas6 Los Arreglos, Vectores y MatricesAlfredo TorresgAún no hay calificaciones

- Ciberseguridad en Infraestructuras CriticasDocumento25 páginasCiberseguridad en Infraestructuras Criticasfran.obando1332Aún no hay calificaciones

- Informe Pasantias YudarlinDocumento22 páginasInforme Pasantias YudarlinCopias ACPC209 ImpresiónAún no hay calificaciones

- Caso de NegocioDocumento12 páginasCaso de NegocioJesusDanielAún no hay calificaciones

- 3-PARAMETOS - M - X y KDocumento10 páginas3-PARAMETOS - M - X y KLeonardo OrozcoAún no hay calificaciones

- Aca 1P - Sonido IiDocumento4 páginasAca 1P - Sonido IiKEVIN SANTIAGO QUINTERO RIVEROSAún no hay calificaciones

- GuiaCompleta 71901014 2022Documento38 páginasGuiaCompleta 71901014 2022Alfredo Mituy Okenve ObiangAún no hay calificaciones

- Estima SW PresupuestosDocumento9 páginasEstima SW PresupuestosJose De La Cruz De La OAún no hay calificaciones

- AlcanceDocumento5 páginasAlcanceJose LuisAún no hay calificaciones

- Guía 6 - 7 - 8Documento13 páginasGuía 6 - 7 - 8NathalyGurtierrezAún no hay calificaciones

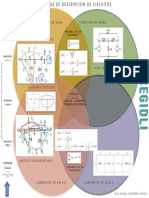

- Infografia Circuitos PDFDocumento1 páginaInfografia Circuitos PDFJose Miguel Guerrero RiveraAún no hay calificaciones

- Herramientas Informaticas Aplicadas (Guías)Documento53 páginasHerramientas Informaticas Aplicadas (Guías)Pablo AvilaAún no hay calificaciones

- Taller 1 Adobe Premiere IntroduccionDocumento2 páginasTaller 1 Adobe Premiere IntroduccionNIEVES LOPEZ DIEGO ALEXANDERAún no hay calificaciones

- CIBER PRIVACIDAD-valeglezDocumento5 páginasCIBER PRIVACIDAD-valeglezValeria GonzalezAún no hay calificaciones

- Copia de Copia de Facturacion Materiales Desde Nov 2019Documento1319 páginasCopia de Copia de Facturacion Materiales Desde Nov 2019jesus navaAún no hay calificaciones

- Evaluacion Examen Domingos S 1Documento7 páginasEvaluacion Examen Domingos S 1Tecnopcyportatiles Antioquia RionegroAún no hay calificaciones

- Diagrama de FlujoDocumento12 páginasDiagrama de FlujoAlejandroDubonAún no hay calificaciones

- Practica Final Desarrollo de Un Proyecto Miguel Antonio Mejia 20-Eist-1-030 Seccion 0821Documento5 páginasPractica Final Desarrollo de Un Proyecto Miguel Antonio Mejia 20-Eist-1-030 Seccion 0821Miguel Antonio Mejia BatistaAún no hay calificaciones

- Taller Tablas HTMLDocumento7 páginasTaller Tablas HTMLAngela HernandezAún no hay calificaciones

- Metodo de Gauss Jordan Equipo 4Documento20 páginasMetodo de Gauss Jordan Equipo 4Leo HMAún no hay calificaciones

- Relación de La Música Con La TecnologíaDocumento4 páginasRelación de La Música Con La TecnologíaJoseAún no hay calificaciones

- Examen Final ExcelDocumento4 páginasExamen Final ExcelRon PaAún no hay calificaciones

- Manual de Instalación Go Global PDFDocumento17 páginasManual de Instalación Go Global PDFDIANA POVEDAAún no hay calificaciones

- MA020 - R01ES - Apostila de Treinamento Da MITDocumento31 páginasMA020 - R01ES - Apostila de Treinamento Da MITSandra CanteroAún no hay calificaciones