Documentos de Académico

Documentos de Profesional

Documentos de Cultura

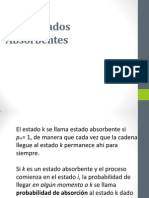

Cadenas de Markov

Cargado por

Lening SegoviaDescripción original:

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Cadenas de Markov

Cargado por

Lening SegoviaCopyright:

Formatos disponibles

Cadenas de Markov (Ejercicios

Resueltos)

Por GEO Tutoriales el 31/08/2015 en Cadenas de Markov 1

Un proceso estocástico en tiempo discreto se denomina una Cadena de Markov en

tiempo discreto si y solo sí se satisface la Propiedad Markoviana (esto es básicamente

que el futuro t=n+1 es independiente del pasado dado el presente t=n) y Propiedad

Estacionaria (la probabilidad de pasar de un estado i a un estado j al cabo de una

etapa no depende de la etapa n). A continuación presentamos un conjunto de problemas

resueltos de Cadenas de Markov que sirvan de complemento para los estudios de

nuestros usuarios.

Ejercicios Resueltos de Cadenas de Markov

Ejercicio N°1: Una empresa esta considerando utilizar Cadenas de Markov para

analizar los cambios en las preferencias de los usuarios por tres marcas distintas de un

determinado producto. El estudio ha arrojado la siguiente estimación de la matriz de

probabilidades de cambiarse de una marca a otra cada mes:

Si en la actualidad la participación de mercado es de 45%, 25% y 30%,

respectivamente. ¿Cuales serán las participaciones de mercado de cada marca en dos

meses más?.

En primer lugar definimos la variable aleatoria que representa la marca que adquiere

un cliente cualquiera en el mes n. Dicha variable aleatoria puede adoptar los valores

1,2,3 en el mes n=0,1,2,3,..

Adicionalmente conocemos cuál es la distribución inicial y la matriz de probabilidades

de transición en una etapa tal como se observa a continuación:

Luego para conocer la distribución de las participaciones de mercado al cabo de 2 meses

(2 etapas) podemos utilizar la fórmula :

Se concluye que las cuotas de mercado (participaciones de mercado) en dos meses a

cambiado de un 45% a un 40.59%; de un 25% a un 33.91% y de un 30% a un 25.50%,

para las marcas 1,2 y 3 respectivamente.

Ejercicio N°2: ¿Cuál es la cuota de mercado en el largo plazo para cada una de las

marcas descritas en el Ejercicio N°1?.

La Cadena de Markov del Ejercicio N°1 es irreducible (es decir todos los estados se

comunican entre sí) con estados recurrentes positivos y aperiódicos. Lo anterior se

concluye luego de la Clasificación de Estados de una Cadena de Markov en Tiempo

Discreto. Verificado lo anterior podemos obtener la Distribución Límite de una

Cadena de Markov en Tiempo Discreto a través del siguiente sistema de ecuaciones:

La solución del sistema corresponde a: , y , que

representan las cuotas de mercado en el largo plazo para las marcas 1,2 y 3,

respectivamente. Notar que las actuales participaciones de mercado difieren

significativamente de las cuotas obtenidas en el largo plazo lo cual sugiere que de

alguna manera deban ser corregidas las probabilidades de transición.

Ejercicio N°3: En una Unidad de Cuidados Intensivos en un determinado hospital, cada

paciente es clasificado de acuerdo a un estado crítico, serio o estable. Estas

clasificaciones son actualizadas cada mañana por un médico internista, de acuerdo a la

evaluación experimentada por el paciente. Las probabilidades con las cuales cada

paciente se mueve de un estado a otro se resumen en la tabla que sigue:

¿Cuál es la probabilidad que un paciente en estado crítico un día Jueves esté estable

el día Sábado?.

Sea la variable aleatoria que indica el estado que se encuentra un paciente cualquiera

en el hospital en el día n. Los valores posibles para dicha variable son C, S y E,

representando los estados crítico, serio y estable, respectivamente. Un grafo que

representa dicho proceso estocástico dada la tabla anterior es:

La probabilidad de que un paciente esté en estado crítico el día Jueves y que el día

Sábado esté estable, esta dado por: , es decir, la probabilidad de pasar del estado

crítico al estado estable al cabo de 2 etapas (días).

Notar que de forma equivalente se pueden utilizar las ecuaciones

matriciales :

Se comprueba que la probabilidad de pasar del estado crítico al estado estable al cabo de

2 etapas es de un 17%.

¿Cuál es la probabilidad que un paciente que está en estado estable el Lunes

experimente alguna complicación y no esté estable nuevamente el Miércoles?.

En este caso cambia la distribución inicial respecto al escenario anterior (ahora el

paciente está en estado estable), no obstante, también resulta de nuestro interés analizar

qué sucede al cabo de 2 etapas.

Con color verde se marca la probabilidad de que comenzando en un estado estable al

cabo de 2 días un paciente se encuentre en estado crítico o serio. La suma de dichas

probabilidades es un 66% que da respuesta a la interrogante anterior.

¿Qué porcentaje de la Unidad de Cuidados Intensivos usted diseñaría y equiparía

para pacientes en estado crítico?.

Naturalmente se desea estimar la probabilidades de estado en el largo plazo

independiente de la distribución inicial. La cadena es irreducible con estados recurrentes

positivos aperiódicos. Utilizando las ecuaciones de estado estable presentadas en el

Ejercicio N°2 se obtiene que , y , que

representan la probabilidad de que un individuo se encuentre en estado crítico, serio y

estable, respectivamente.

El software Interactive Operations Research Tutorial (IORTutorial) permite estimar

las probabilidades de largo plazo luego de ingresar la matriz de probabilidades de

transición según se muestra a continuación:

Comentarios: En el Blog hemos desarrollado otros ejercicios resueltos que

recomendamos revisar, entre ellos uno que aborda una Política de Gestión de

Inventarios a través de Cadenas de Markov en Tiempo Discreto y Ejemplo de una

Cadena de Markov en Tiempo Discreto. Adicionalmente en la categoría de

contenidos de Cadenas de Markov periódicamente estamos publicando nuevo material

didáctico sobre dicha materia. Esperamos que este material sea de utilidad para tus

estudios y te agradecemos puedas ayudarnos a difundir éste a través de las redes

sociales.

También podría gustarte

- Farmacometría:Curvas dosis-respuesta de tipo gradual. Volumen 1De EverandFarmacometría:Curvas dosis-respuesta de tipo gradual. Volumen 1Aún no hay calificaciones

- Análisis de cambios en preferencias de marcas y probabilidad de estados de pacientes usando Cadenas de MarkovDocumento5 páginasAnálisis de cambios en preferencias de marcas y probabilidad de estados de pacientes usando Cadenas de MarkovNaydú Cortés100% (1)

- Cadenas de Markov discretasDocumento15 páginasCadenas de Markov discretasfranksaldasAún no hay calificaciones

- EJERCICIOS DE CADENAS DE MARKOV Y PROBABILIDADESDocumento5 páginasEJERCICIOS DE CADENAS DE MARKOV Y PROBABILIDADESGuillenevilAún no hay calificaciones

- 7 Modelo de Servicio de MaquinasDocumento9 páginas7 Modelo de Servicio de MaquinasDiana PatyAún no hay calificaciones

- Deber Ene18 5Documento2 páginasDeber Ene18 5Trajano Saúl Guevara MoralesAún no hay calificaciones

- Ejercicio Resuelto CADENAS de MARKOVDocumento6 páginasEjercicio Resuelto CADENAS de MARKOVJulio Hector Medina SarayasiAún no hay calificaciones

- Taller 4lDocumento4 páginasTaller 4lNazly Tatiana Ramirez PardoAún no hay calificaciones

- Imprimir p2Documento9 páginasImprimir p2Javi GalleguillosAún no hay calificaciones

- Calculos Taller Cadenas de MarkovDocumento19 páginasCalculos Taller Cadenas de MarkovHeidy Katherine Molina León50% (2)

- Cadenas de Markov - Estados Absorbentes y de Tiempo ContinuoDocumento23 páginasCadenas de Markov - Estados Absorbentes y de Tiempo ContinuoAlberto CarranzaAún no hay calificaciones

- Tema 3 Problema 3Documento12 páginasTema 3 Problema 3ChristoferBarruetoAún no hay calificaciones

- Conjunto Problemas Cap 17 Markov Chains TAHA 8th EditionDocumento13 páginasConjunto Problemas Cap 17 Markov Chains TAHA 8th Editiongoolunm0% (1)

- Cadenas de Markov Absorventes y No AbsorventesDocumento9 páginasCadenas de Markov Absorventes y No AbsorventesDanilo0% (1)

- Markov Problemas 2012-2 5pcDocumento8 páginasMarkov Problemas 2012-2 5pcLuis Ramirez0% (1)

- Investigacion de Operaciones 9na Edicion-Taha-639Documento1 páginaInvestigacion de Operaciones 9na Edicion-Taha-639Mayerli PerazaAún no hay calificaciones

- Taller Segundo SeguimientoDocumento29 páginasTaller Segundo SeguimientoDaniel Carvajal TinocoAún no hay calificaciones

- Ejercicios DiversosDocumento3 páginasEjercicios DiversosGastonVertiz50% (2)

- Practica de Cadenas de Markov 2-2018Documento4 páginasPractica de Cadenas de Markov 2-2018NANAAún no hay calificaciones

- Problemas 3Documento22 páginasProblemas 3Pedro RuizAún no hay calificaciones

- Practico CDMDDocumento3 páginasPractico CDMDclaudio0% (1)

- Taller de Investigacion de OperacionesDocumento20 páginasTaller de Investigacion de OperacionesArnold Geovannis BenjumeaAún no hay calificaciones

- Ejercicio RLMDocumento3 páginasEjercicio RLMisrael lopez ramirez100% (1)

- Análisis de pronósticos de demanda para Altavox ElectronicsDocumento2 páginasAnálisis de pronósticos de demanda para Altavox Electronicsmay_soul0% (1)

- Actividad 6.t2.algoritmos.Documento24 páginasActividad 6.t2.algoritmos.katia martinezAún no hay calificaciones

- Trabajo de Investigación de Operaciones Casos EspecialesDocumento14 páginasTrabajo de Investigación de Operaciones Casos EspecialesDixon MartinezAún no hay calificaciones

- Simulación de procesos productivos en industria mineraDocumento2 páginasSimulación de procesos productivos en industria mineranicolas LisboaAún no hay calificaciones

- Cómo hacer un MPSDocumento6 páginasCómo hacer un MPSJair GarciaAún no hay calificaciones

- Huayllani Chavez RolandoDocumento6 páginasHuayllani Chavez RolandoAlias Apaza Spiritbreaker0% (4)

- Quiz Io-2Documento2 páginasQuiz Io-2Ana Maria Valbuena0% (1)

- Problemas Resueltos Cadenas de MarkovDocumento7 páginasProblemas Resueltos Cadenas de MarkovPaco Zavala100% (1)

- Modelos líneas espera Poisson servidor únicoDocumento38 páginasModelos líneas espera Poisson servidor únicoIsaac Chako MartínezAún no hay calificaciones

- Unidad 4 Cadenas de MarkovDocumento13 páginasUnidad 4 Cadenas de MarkovJesus Esteban Cota DominguezAún no hay calificaciones

- Taller en Grupo Cadenas de MarkovDocumento2 páginasTaller en Grupo Cadenas de MarkovDayro Avila0% (2)

- Guía 2 (6 Files Merged)Documento55 páginasGuía 2 (6 Files Merged)Made Urzua100% (1)

- Tarea 4.1 Admin 2Documento10 páginasTarea 4.1 Admin 2José RiveraAún no hay calificaciones

- 2.1 Procesos de PoissonDocumento27 páginas2.1 Procesos de PoissonEddy Fernández OchoaAún no hay calificaciones

- Cadenas de Markov en problemas de ingeniería y administraciónDocumento4 páginasCadenas de Markov en problemas de ingeniería y administraciónNinel FernandezAún no hay calificaciones

- Uane - Ing.met.c18.. Capacitación y Otras Prácticas AdministrativasDocumento3 páginasUane - Ing.met.c18.. Capacitación y Otras Prácticas AdministrativasGerman Martinez100% (1)

- Ejercicios Cadenas de Markov, Teoría de Colas y de JuegpsDocumento18 páginasEjercicios Cadenas de Markov, Teoría de Colas y de JuegpsJose Manuel BetancourtAún no hay calificaciones

- Práctica calificada de inferencia estadísticaDocumento2 páginasPráctica calificada de inferencia estadísticaDiego TerronesAún no hay calificaciones

- ResueltosmarkovDocumento8 páginasResueltosmarkovjuanchote77Aún no hay calificaciones

- Tarea Grupal Nro 2Documento2 páginasTarea Grupal Nro 2Dony Guillermo Chavez CastilloAún no hay calificaciones

- 09 DerivadasDocumento7 páginas09 Derivadasedwin_danAún no hay calificaciones

- ABC Emprendimiento EjerciciosDocumento3 páginasABC Emprendimiento EjerciciosJunior Emilio ValleAún no hay calificaciones

- PCP Ii WRD-S3.1Documento28 páginasPCP Ii WRD-S3.1gemaAún no hay calificaciones

- Diseños en bloques completamente al azar (DBCADocumento4 páginasDiseños en bloques completamente al azar (DBCAVivi SanchezAún no hay calificaciones

- 5 PC - Teo Dec - 2013 I - Aula B402Documento3 páginas5 PC - Teo Dec - 2013 I - Aula B402Catherine Palomino Aguilar0% (1)

- Balanceo de LineaDocumento16 páginasBalanceo de Linearuben escobarAún no hay calificaciones

- Tarea 1 Unidad 3 - MuñozdelaCruzDocumento36 páginasTarea 1 Unidad 3 - MuñozdelaCruzLupitaSalayaAún no hay calificaciones

- Cadena Markov sangre hospitalDocumento11 páginasCadena Markov sangre hospitalViviana GalarzaAún no hay calificaciones

- Cadenas de MarkovDocumento38 páginasCadenas de MarkovSocrates MartinezAún no hay calificaciones

- Cadenas de Markov (Ejercicios Resueltos)Documento14 páginasCadenas de Markov (Ejercicios Resueltos)Ronald Jason López100% (1)

- Cadenas de Markov Investigacion de OperacionesDocumento6 páginasCadenas de Markov Investigacion de OperacionesFederico HuertaAún no hay calificaciones

- Cadenas de MarkovDocumento14 páginasCadenas de MarkovRebeca Cabrera100% (1)

- Cadenas de Markov Ejercicios Resueltos 1 8 1 6Documento6 páginasCadenas de Markov Ejercicios Resueltos 1 8 1 6Flores Altamirano ChessyAún no hay calificaciones

- Cadenas de Markov y análisis de preferencias de usuariosDocumento11 páginasCadenas de Markov y análisis de preferencias de usuariosJorge PulidoAún no hay calificaciones

- Ejercicios de MarkovDocumento15 páginasEjercicios de MarkovAlvaro González Parrales100% (1)

- Procesos de MarkovDocumento4 páginasProcesos de Markovjose luisAún no hay calificaciones

- PDF Unidad I Organizacion de Puesto de Direccion de La Lucha No ArmadaDocumento6 páginasPDF Unidad I Organizacion de Puesto de Direccion de La Lucha No ArmadaLening SegoviaAún no hay calificaciones

- Unidad 6º RESPONSABILIDAD CIVIL DEL INGENIERO EN EJERCICIO Y PRINCIPIOS DEL DERECHO PENAL Y COMPEDocumento12 páginasUnidad 6º RESPONSABILIDAD CIVIL DEL INGENIERO EN EJERCICIO Y PRINCIPIOS DEL DERECHO PENAL Y COMPEAndreina Escorcha Gonzalez100% (2)

- ENSAYO TEMA VII Marco LegalDocumento3 páginasENSAYO TEMA VII Marco LegalLening SegoviaAún no hay calificaciones

- PDF Regimen Legal Especial Aplicado A Las Especialidades y Ley de Arbitraje ComercialdocDocumento6 páginasPDF Regimen Legal Especial Aplicado A Las Especialidades y Ley de Arbitraje ComercialdocLening SegoviaAún no hay calificaciones

- Ensayo Tema VI Marco LegalDocumento4 páginasEnsayo Tema VI Marco LegalLening SegoviaAún no hay calificaciones

- July Rodríguez Mensajes de TelegramDocumento181 páginasJuly Rodríguez Mensajes de TelegramLening SegoviaAún no hay calificaciones

- ENSAYO TEMA VII Marco LegalDocumento4 páginasENSAYO TEMA VII Marco LegalLening SegoviaAún no hay calificaciones

- Ejercicio profesional ingeniería administración pública privadaDocumento26 páginasEjercicio profesional ingeniería administración pública privadaLening SegoviaAún no hay calificaciones

- Informe Inferencial para La Toma de DecisionesDocumento4 páginasInforme Inferencial para La Toma de DecisionesLening SegoviaAún no hay calificaciones

- Derecho Romano IVDocumento20 páginasDerecho Romano IVLening SegoviaAún no hay calificaciones

- Conexión DSLDocumento11 páginasConexión DSLLening SegoviaAún no hay calificaciones

- Auditoría de Seguridad Física y LógicaDocumento20 páginasAuditoría de Seguridad Física y LógicaLening SegoviaAún no hay calificaciones

- Auditoria BD VenezuelaDocumento10 páginasAuditoria BD VenezuelaLening SegoviaAún no hay calificaciones

- El Derecho Mercantil Es Aquella Rama Del Derecho Privado QueDocumento8 páginasEl Derecho Mercantil Es Aquella Rama Del Derecho Privado QueLening SegoviaAún no hay calificaciones

- Sistemas internacionales protección DDHHDocumento16 páginasSistemas internacionales protección DDHHirmar26Aún no hay calificaciones

- Informe y Actas PolicialesDocumento27 páginasInforme y Actas PolicialesLening SegoviaAún no hay calificaciones

- La Clausula PenalDocumento15 páginasLa Clausula PenalLening SegoviaAún no hay calificaciones

- Auditoria BD VenezuelaDocumento10 páginasAuditoria BD VenezuelaLening SegoviaAún no hay calificaciones

- Auditoria BD VenezuelaDocumento10 páginasAuditoria BD VenezuelaLening SegoviaAún no hay calificaciones

- Vuelta A La PatriaDocumento7 páginasVuelta A La PatriaLening SegoviaAún no hay calificaciones

- Auditoria BD VenezuelaDocumento10 páginasAuditoria BD VenezuelaLening SegoviaAún no hay calificaciones

- Etiquetas para ExpedienteDocumento1 páginaEtiquetas para ExpedienteLening SegoviaAún no hay calificaciones

- Auditoria de La Calidad Del Software-Trabajo-Semestre VIIDocumento14 páginasAuditoria de La Calidad Del Software-Trabajo-Semestre VIILening SegoviaAún no hay calificaciones

- Sistematización de servicios públicos y privados como elementos estratégicos de la LUNADocumento63 páginasSistematización de servicios públicos y privados como elementos estratégicos de la LUNAYanidira ReyesAún no hay calificaciones

- Trabajo Catedra IIDocumento5 páginasTrabajo Catedra IILening SegoviaAún no hay calificaciones

- Carta de Solicitud de Desbloqueo de La CuentaDocumento1 páginaCarta de Solicitud de Desbloqueo de La CuentaLening Segovia88% (8)

- Etiquetas para Expediente StefanyDocumento1 páginaEtiquetas para Expediente StefanyLening SegoviaAún no hay calificaciones

- DossierDocumento4 páginasDossierLening SegoviaAún no hay calificaciones

- Poisson 2Documento23 páginasPoisson 2roze00Aún no hay calificaciones

- Guia Didactica Java - 3Documento93 páginasGuia Didactica Java - 3william sanchez orjuelaAún no hay calificaciones

- Menu Lomo y La Aguja San SalvadorDocumento20 páginasMenu Lomo y La Aguja San SalvadorJocelyn CastroAún no hay calificaciones

- Elaboracion Del Plan de InvestigacionDocumento18 páginasElaboracion Del Plan de InvestigacionNoe AguilarAún no hay calificaciones

- INFORMACION NONI RECOLECCION Noni PDFDocumento18 páginasINFORMACION NONI RECOLECCION Noni PDFRocio Mazariegos0% (1)

- Material de Reforzamiento U4Documento1 páginaMaterial de Reforzamiento U4joansAún no hay calificaciones

- Guia Unidad 5 Apuntes y Plan LectorDocumento2 páginasGuia Unidad 5 Apuntes y Plan LectorSonia AlbanoAún no hay calificaciones

- Solicitud de Cancelacion de Medida Cautelar - Exp. 1921-2019Documento6 páginasSolicitud de Cancelacion de Medida Cautelar - Exp. 1921-2019Gian Ricardo FloresAún no hay calificaciones

- Entorno en El Trabajo Leccion 1Documento3 páginasEntorno en El Trabajo Leccion 1realvilleAún no hay calificaciones

- Cuestionarioa de Bienestar PsicosocialDocumento14 páginasCuestionarioa de Bienestar PsicosocialespinodelacuevacarlosrAún no hay calificaciones

- Estudio de CasoDocumento7 páginasEstudio de CasoDayanara VelascoAún no hay calificaciones

- Formato de Solicitud de Dotacion para Personal CartagenaDocumento16 páginasFormato de Solicitud de Dotacion para Personal Cartagenaorlando33% (3)

- La Pastoral Familiar y Sus ProgramasDocumento10 páginasLa Pastoral Familiar y Sus ProgramasMons Nicolás Gregorio Nava Rojas100% (2)

- TRIPTICO MI EMPRENDIMIENTO FAMILIAR J J J JMDocumento2 páginasTRIPTICO MI EMPRENDIMIENTO FAMILIAR J J J JMVirginia cantoral reyesAún no hay calificaciones

- Telescopic ADocumento21 páginasTelescopic AJ Antonio Cervantes100% (1)

- Codigo Organico Integral PenalDocumento356 páginasCodigo Organico Integral PenalGenaro PicoAún no hay calificaciones

- SP621-2018 (51482)Documento57 páginasSP621-2018 (51482)Angela Maria Gomez GiraldoAún no hay calificaciones

- Funciones Del DRHDocumento5 páginasFunciones Del DRHFabio José Tapia AcostaAún no hay calificaciones

- El Rol Del Abogado Ante La Ética y El Ejercicio ProfesionalDocumento29 páginasEl Rol Del Abogado Ante La Ética y El Ejercicio ProfesionalCristopher LeonAún no hay calificaciones

- Trastornos Emotivo SeverosDocumento14 páginasTrastornos Emotivo SeverosprincesapolyAún no hay calificaciones

- GUIA No.5 PROTOBOARDDocumento12 páginasGUIA No.5 PROTOBOARDSantiago Reyes BarraganAún no hay calificaciones

- Banco de Preguntas I BimestreDocumento11 páginasBanco de Preguntas I Bimestrecésar ponce del carpioAún no hay calificaciones

- Sikadur - 41 CF NormalDocumento4 páginasSikadur - 41 CF NormalPatricio GonzálezAún no hay calificaciones

- Impacto Ambiental Cierre de Camino Cierre de Causes Cierre de Campamento Restauraciòn de Areas Del Aprovechamiento ForestalDocumento24 páginasImpacto Ambiental Cierre de Camino Cierre de Causes Cierre de Campamento Restauraciòn de Areas Del Aprovechamiento Forestalkeyla yellicza espiritu guevaraAún no hay calificaciones

- Historia Criminologica. Estudio de Caso. Caso Luciano XDocumento18 páginasHistoria Criminologica. Estudio de Caso. Caso Luciano XMariel GnisciAún no hay calificaciones

- Informe Ev Propuesta Técnica (Cci X)Documento5 páginasInforme Ev Propuesta Técnica (Cci X)guillermoAún no hay calificaciones

- Análisis Foda de La PNPDocumento2 páginasAnálisis Foda de La PNPAlexandra Condor Arias82% (11)

- La Literatura y El Sentido ComúnDocumento3 páginasLa Literatura y El Sentido ComúnGabriel Alemán TapiaAún no hay calificaciones

- Manual HeridasDocumento43 páginasManual HeridasKarina Wolf Vergara100% (1)

- Administrador Del Sistema Integraciones C4C - HCI - ECCDocumento8 páginasAdministrador Del Sistema Integraciones C4C - HCI - ECCAlberto FernándezAún no hay calificaciones

- CSJN Caso RadziwilDocumento5 páginasCSJN Caso RadziwilMarcelo AranedaAún no hay calificaciones

- Ensenianzas de Un PelotudoDocumento3 páginasEnsenianzas de Un PelotudolibadorAún no hay calificaciones