0% encontró este documento útil (0 votos)

51 vistas18 páginasProcesos ETL y Tipos de Datos en BI

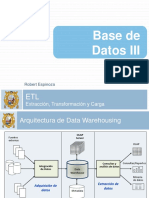

Este documento describe los conceptos clave del proceso ETL, incluyendo la extracción, transformación y carga de datos de diferentes fuentes. Explica los tipos de datos estructurados, semiestructurados y no estructurados, así como las etapas y objetivos del proceso ETL.

Cargado por

Fabio PintoDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PPTX, PDF, TXT o lee en línea desde Scribd

0% encontró este documento útil (0 votos)

51 vistas18 páginasProcesos ETL y Tipos de Datos en BI

Este documento describe los conceptos clave del proceso ETL, incluyendo la extracción, transformación y carga de datos de diferentes fuentes. Explica los tipos de datos estructurados, semiestructurados y no estructurados, así como las etapas y objetivos del proceso ETL.

Cargado por

Fabio PintoDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PPTX, PDF, TXT o lee en línea desde Scribd