Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Arquitectura Vonmewman

Cargado por

Sorely Reyes0 calificaciones0% encontró este documento útil (0 votos)

13 vistas4 páginasLa arquitectura Von Neumann es la más utilizada actualmente. Consiste en una unidad central de proceso que se comunica a través de un solo bus con un banco de memoria donde se almacenan tanto los códigos de instrucción como los datos. La arquitectura Harvard separa la memoria de instrucciones y datos para evitar cuellos de botella.

Descripción original:

Título original

Arquitectura vonmewman

Derechos de autor

© © All Rights Reserved

Formatos disponibles

DOCX, PDF, TXT o lea en línea desde Scribd

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoLa arquitectura Von Neumann es la más utilizada actualmente. Consiste en una unidad central de proceso que se comunica a través de un solo bus con un banco de memoria donde se almacenan tanto los códigos de instrucción como los datos. La arquitectura Harvard separa la memoria de instrucciones y datos para evitar cuellos de botella.

Copyright:

© All Rights Reserved

Formatos disponibles

Descargue como DOCX, PDF, TXT o lea en línea desde Scribd

0 calificaciones0% encontró este documento útil (0 votos)

13 vistas4 páginasArquitectura Vonmewman

Cargado por

Sorely ReyesLa arquitectura Von Neumann es la más utilizada actualmente. Consiste en una unidad central de proceso que se comunica a través de un solo bus con un banco de memoria donde se almacenan tanto los códigos de instrucción como los datos. La arquitectura Harvard separa la memoria de instrucciones y datos para evitar cuellos de botella.

Copyright:

© All Rights Reserved

Formatos disponibles

Descargue como DOCX, PDF, TXT o lea en línea desde Scribd

Está en la página 1de 4

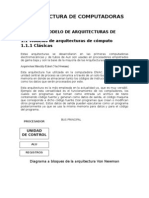

Arquitectura Von Newman

Esta arquitectura fue utilizada en la computadora ENIAC. Consiste en una unidad

central de proceso se comunica a través de un solo bus con un banco de memoria en

donde se almacenan tanto los códigos de instrucción del programa, como los datos

que serán procesados por este. Esta arquitectura es la más empleada en la actualidad

ya, que es muy versátil. Ejemplo de esta versatilidad es el funcionamiento de los

compiladores, los cuales son programas que toman como entrada un archivo de texto

conteniendo código fuente y generan como datos de salida, el código máquina que

corresponde a dicho código fuente (Son programas que crean o modifican otros

programas). Estos datos de salida pueden ejecutarse como un programa

posteriormente ya que se usa la misma memoria para datos y para el código del

programa.

BUS PRINCIPAL

PROCESADOR

ALU

REGISTROS

UNIDAD DE CONTROL

Diagrama a bloques de la arquitectura Von Newman

La principal desventaja de esta arquitectura, es que el bus de datos y direcciones único

se convierte en un cuello de botella por el cual debe pasar toda la información que se

lee de o se escribe a la memoria, obligando a que todos los accesos a esta sean

secuenciales. Esto limita el grado de paralelismo (acciones que se pueden realizar al

mismo tiempo) y por lo tanto, el desempeño de la computadora. Este efecto se conoce

como el cuello de botella de Von Newman En esta arquitectura apareció por primera

vez el concepto de programa almacenado. Anteriormente la secuencia de las

operaciones era dictada por el alambrado de la unidad de control, e cambiarla

implicaba un proceso de recableado laborioso, lento (hasta tres semanas) y propenso a

errores. En esta arquitectura se asigna un código numérico a cada instrucción. Dichos

códigos se almacenan en la misma unidad de memoria que los datos que van a

procesarse, para ser ejecutados en el orden en que se almacenados en memoria. Esto

permite cambiar rápidamente la aplicación de la computadora y dio origen a las

computadoras de propósito general. Mas a detalle, el procesador se subdivide en una

unidad de control (C.U.), una unidad lógica aritmética (A.L.U.) y una serie de registros.

Los registros sirven para almacenar internamente datos y estado del procesador. La

unidad aritmética lógica proporciona la capacidad de realizar operaciones aritméticas y

lógicas. La unidad de control genera las señales de control para leer el código de las

instrucciones, decodificarlas y hacer que la ALU las ejecute.

Arquitectura Harvard

Esta arquitectura surgió en la universidad del mismo nombre, poco después de que la

arquitectura Von Newman apareciera en la universidad de Princeton. Al igual que en la

arquitectura Von Newman, el programa se almacena como un código numérico en la

memoria, pero no en el mismo espacio de memoria ni en el mismo formato que los

datos. Por ejemplo, se pueden almacenar las instrucciones en bits en la memoria de

programa, mientras los datos de almacenan en 8 bits en una memoria aparte

Diagrama a bloques de la arquitectura de Harvard

Bus de programa PROCESADOR Bus de datos

Diagrama a bloques de la arquitectura de Harvard

El hecho de tener un bus separado para el programa y otro para los datos permite que

se lea el código operación de una instrucción, al mismo tiempo se lee de la memoria de

datos los operados de la instrucción previa. Así se evita el problema del cuello de

botella de Von Newman y se obtiene un mejor desempeño En la actualidad la mayoría

de los procesadores modernos se conectan al exterior de manera similar a la

arquitectura Von Newman, con un banco de memoria masivo único, pero

internamente incluyen varios niveles de memoria cache con bancos separados en

cache de programa y cache de datos, buscando un mejor desempeño sin perder la

versatilidad

Arquitectura de computadoras

La arquitectura de computadoras es el diseño conceptual y la estructura operacional

fundamental de un sistema de computadora. Es decir, es un modelo y una descripción

funcional de los requerimientos y las implementaciones de diseño para varias partes

de una computadora, con especial interés en la forma en que la unidad central de

proceso (UCP) trabaja internamente y accede a las direcciones de memoria. También

suele definirse como la forma de seleccionar e interconectar componentes de

hardware para crear computadoras según los requerimientos de funcionalidad,

rendimiento y costo. El ordenador recibe y envía la información a través de los

periféricos por medio de los canales. La UCP es la encargada de procesar la

información que le llega al ordenador. El intercambio de información se tiene que

hacer con los periféricos y la UCP. Todas aquellas unidades de un sistema exceptuando

la UCP se denomina periférico, por lo que el ordenador tiene dos partes bien

diferenciadas, que son: la UCP (encargada de ejecutar programas y que está

compuesta por la memoria principal, la Unidad aritmético lógica (UAL) y la Unidad de

Control) y los periféricos (que pueden ser de entrada, salida, entrada-salida y

comunicaciones).

Arquitectura Clásica

Estas arquitecturas se desarrollaron en las primeras computadoras electromecánicas y

de tubos de Aun son usadas en procesadores empotrados de gama baja y son la base

de la mayoría de las Arquitecturas modernas.

La arquitectura de von Neumann es una familia de arquitecturas de

computadoras que utilizan el mismo dispositivo de almacenamiento tanto para

las instrucciones como para los datos (a diferencia de la arquitectura Harvard).

La mayoría de computadoras modernas están basadas en esta arquitectura, aunque

pueden incluir otros dispositivos adicionales (por ejemplo, para gestionar las

interrupciones de dispositivos externos como ratón, teclado, etc).

Los ordenadores con esta arquitectura constan de cinco partes: La unidad aritmético-

lógica o ALU, la unidad de control, la memoria, un dispositivo de entrada/salida y el

bus de datos que proporciona un medio de transporte de los datos entre las distintas

partes.

Un ordenador con esta arquitectura realiza o emula los siguientes pasos

secuencialmente:

Enciende el ordenador y obtiene la siguiente instrucción desde la memoria en la

dirección indicada por el contador de programa y la guarda en el registro de

instrucción.

Aumenta el contador de programa en la longitud de la instrucción para apuntar a la

siguiente.

Decodifica la instrucción mediante la unidad de control. Ésta se encarga de coordinar

el resto de componentes del ordenador para realizar una función determinada.

Se ejecuta la instrucción. Ésta puede cambiar el valor del contador del programa,

permitiendo así operaciones repetitivas. El contador puede cambiar también cuando

se cumpla una cierta condición aritmética, haciendo que el ordenador pueda 'tomar

decisiones', que pueden alcanzar cualquier grado de complejidad, mediante la

aritmética y lógica anteriores.

Originalmente, el término Arquitectura Harvard hacía referencia a las

arquitecturas de computadoras que utilizaban dispositivos de almacenamiento

físicamente separados para las instrucciones y para los datos (en oposición a la

Arquitectura de von Neumann). El término proviene de la computadora

Harvard Mark I, que almacenaba las instrucciones en cintas perforadas y los

datos en interruptores.

Todas las computadoras constan principalmente de dos partes, la CPU que procesa los

datos, y la memoria que guarda los datos. Cuando hablamos de memoria manejamos

dos parámetros, los datos en sí, y el lugar donde se encuentran almacenados (o

dirección). Los dos son importantes para la CPU, pues muchas instrucciones frecuentes

se traducen a algo así como "coge los datos de ésta dirección y añádelos a los datos de

ésta otra dirección", sin saber en realidad qué es lo que contienen los datos.

En los últimos años la velocidad de las CPUs ha aumentado mucho en comparación a la

de las memorias con las que trabaja, así que se debe poner mucha atención en reducir

el número de veces que se accede a ella para mantener el rendimiento. Si, por

ejemplo, cada instrucción ejecutada en la CPU requiere un acceso a la memoria, no se

gana nada incrementando la velocidad de la CPU (este problema es conocido como

limitación de memoria).

Se puede fabricar memoria mucho más rápida, pero a costa de un precio muy alto. La

solución, por tanto, es proporcionar una pequeña cantidad de memoria muy rápida

conocida con el nombre de memoria caché. Mientras los datos que necesita el

procesador estén en la caché, el rendimiento será mucho mayor que si la caché tiene

que obtener primero los datos de la memoria principal. La optimización de la caché es

un tema muy importante de cara al diseño de computadoras.

La arquitectura Harvard ofrece una solución particular a este problema. Las

instrucciones y los datos se almacenan en cachés separadas para mejorar el

rendimiento. Por otro lado, tiene el inconveniente de tener que dividir la cantidad de

caché entre los dos, por lo que funciona mejor sólo cuando la frecuencia de lectura de

instrucciones y de datos es aproximadamente la misma. Esta arquitectura suele

utilizarse en DSPs, o procesador de señal digital, usados habitualmente en productos

para procesamiento de audio y video.

También podría gustarte

- 1 - ArquitecturaDocumento14 páginas1 - Arquitecturaancca2857Aún no hay calificaciones

- Arquitectura HarvardDocumento4 páginasArquitectura HarvardCarlos PertuzAún no hay calificaciones

- Arquitectura Von NeumannDocumento9 páginasArquitectura Von NeumannAndrea Alejandra Hernández RodríguezAún no hay calificaciones

- Tipos de Arquitectura de PCDocumento41 páginasTipos de Arquitectura de PCJeffrey De La Cruz100% (1)

- Arquitectura Harvard y NewmanDocumento6 páginasArquitectura Harvard y NewmanAbraham Lira0% (1)

- Evidencia #1Documento7 páginasEvidencia #1Berenice KztroAún no hay calificaciones

- Arquitectura Von Neuman y HarvardDocumento2 páginasArquitectura Von Neuman y HarvardAbel Ancona Perez100% (1)

- Arquitectura de HarvardDocumento9 páginasArquitectura de HarvardManuel Villarroel100% (1)

- La Arquitectura de Von NeumannDocumento4 páginasLa Arquitectura de Von NeumannwilkinsAún no hay calificaciones

- Arquitectura de Un PCDocumento3 páginasArquitectura de Un PCDaniel De la TorreAún no hay calificaciones

- ArquitecturamicroDocumento15 páginasArquitecturamicroRenny SerranoAún no hay calificaciones

- Historia de La Arquitectura Von NeumannDocumento3 páginasHistoria de La Arquitectura Von NeumannFredy SosaAún no hay calificaciones

- Arquitectura Actividad 4Documento13 páginasArquitectura Actividad 4Carlos Alfonso SerapioAún no hay calificaciones

- Modelo de Arquitectura Von NeumannDocumento8 páginasModelo de Arquitectura Von NeumannChristopherTrujilloAún no hay calificaciones

- Arquitectura Clásica de ComputadorasDocumento8 páginasArquitectura Clásica de ComputadorasCarlos Alejandro Medina CasillasAún no hay calificaciones

- Arquitectura de ComputadorasDocumento47 páginasArquitectura de ComputadorasRigoberto He HeAún no hay calificaciones

- MODULO 1 Arquitectura y Estructura Logica Del ProcesadorDocumento14 páginasMODULO 1 Arquitectura y Estructura Logica Del ProcesadorFrancisco HernándezAún no hay calificaciones

- Comparación Entre Microcontroladores y MicroprocesadoresDocumento7 páginasComparación Entre Microcontroladores y MicroprocesadorespabloAún no hay calificaciones

- Arquitecturas de ComputoDocumento34 páginasArquitecturas de ComputoStephanie Martinez100% (1)

- Modelos de Arquitecturas de CómputoDocumento16 páginasModelos de Arquitecturas de CómputoFERNANDA JAQUELINE GONZALEZ LOPEZAún no hay calificaciones

- Arquitectura de ComputadorasDocumento53 páginasArquitectura de Computadorastilsma100% (3)

- Arquitectura Von NeumannDocumento5 páginasArquitectura Von NeumannYEIMY MARIBEL CAC OSORIOAún no hay calificaciones

- Taller # 2 Organización de ComputadorasDocumento7 páginasTaller # 2 Organización de Computadorascarlos javier alcala orozcoAún no hay calificaciones

- Unidad 1 Modelo de Arquitecturas de CómputoDocumento37 páginasUnidad 1 Modelo de Arquitecturas de CómputoRosario Ramírez Rios100% (1)

- Ensayo Descriptivo de Von Neumann y HarvardDocumento3 páginasEnsayo Descriptivo de Von Neumann y HarvardByron GarciaAún no hay calificaciones

- Arquitectura de Computadoras IDocumento35 páginasArquitectura de Computadoras IJorge Díaz Ordás100% (1)

- Ensayo Descriptivo de Von Neumann y HarvardDocumento2 páginasEnsayo Descriptivo de Von Neumann y Harvardandres david gonzalez betancourt50% (4)

- Neumann Vs HarvardDocumento4 páginasNeumann Vs HarvardElamor De La Vida de KarenAún no hay calificaciones

- Modelo de Arquitectura de ComputadorasDocumento40 páginasModelo de Arquitectura de ComputadorasBrat Stell100% (4)

- Actividad 3.1 Arquitecturas Von Neumman y HarvardDocumento4 páginasActividad 3.1 Arquitecturas Von Neumman y HarvarddiegoAún no hay calificaciones

- Sistema MInimoDocumento19 páginasSistema MInimoAlejandro AguilarAún no hay calificaciones

- Gonzalez Ibarra Reporte ArquitecturaDocumento11 páginasGonzalez Ibarra Reporte ArquitecturaCarolina GonzalezAún no hay calificaciones

- Arquitectura-Computacionales Unidad 1Documento24 páginasArquitectura-Computacionales Unidad 1Raphael Gutierrez DelgadoAún no hay calificaciones

- 8.2.2.7 Packet Tracer - Configuring OSPFv2 in A Single Area InstructionsDocumento42 páginas8.2.2.7 Packet Tracer - Configuring OSPFv2 in A Single Area InstructionsJuan Manuel PintoAún no hay calificaciones

- Arquitectura Von Neumann y Arquitectura HarvardDocumento3 páginasArquitectura Von Neumann y Arquitectura HarvardJuan RuizAún no hay calificaciones

- Arquitectura de Computadoras y Modelos de ArquitecturasDocumento15 páginasArquitectura de Computadoras y Modelos de ArquitecturasPabloGomezPerezAún no hay calificaciones

- Arquitectura de Las ComputadorasDocumento14 páginasArquitectura de Las ComputadorasOliver Atom0% (1)

- Arquitecturas Clasicas y Segmentadas, Angel Hernandez DiazDocumento10 páginasArquitecturas Clasicas y Segmentadas, Angel Hernandez DiazÁngel Hernández DíazAún no hay calificaciones

- La Arquitectura HarvardDocumento7 páginasLa Arquitectura HarvardLuis Enrique Canales RuizAún no hay calificaciones

- Arquitectura de Von NeumannDocumento4 páginasArquitectura de Von NeumannJuanjo Rlloz GlAún no hay calificaciones

- Arquitectura de Las ComputadorasDocumento5 páginasArquitectura de Las ComputadorasHermes MejíaAún no hay calificaciones

- Exp No 5 Arquitectura Del ProcesadorDocumento32 páginasExp No 5 Arquitectura Del ProcesadorRichy PlonedaAún no hay calificaciones

- Arquitectura de Computadoras Unidad I - Otoño 2021Documento42 páginasArquitectura de Computadoras Unidad I - Otoño 2021rafaelAún no hay calificaciones

- Resumen de La Máquina de Von NeumannDocumento3 páginasResumen de La Máquina de Von NeumannMel JergiAún no hay calificaciones

- Arquitecturas ClasicasDocumento27 páginasArquitecturas ClasicasOscar A. Arellano AvilesAún no hay calificaciones

- Unidad1 AC CompletaDocumento25 páginasUnidad1 AC CompletaCamila Soledad Monz�n LascanoAún no hay calificaciones

- 1 Tipos de ArquitecturasDocumento9 páginas1 Tipos de ArquitecturasKenia CruzAún no hay calificaciones

- Arquitectura Computadoras ISCDocumento256 páginasArquitectura Computadoras ISCSergio BrownAún no hay calificaciones

- Arquitecturas de MicrocontroladoresDocumento19 páginasArquitecturas de MicrocontroladoresStephenakd13Aún no hay calificaciones

- Arquitectura Harvard y Von NeumannDocumento6 páginasArquitectura Harvard y Von NeumannAngel VelayAún no hay calificaciones

- Arquitectura HarvardDocumento9 páginasArquitectura HarvardCarlos Manuel Limaylla HuaynatesAún no hay calificaciones

- Arquitecturas Harvard y Von NeumannDocumento3 páginasArquitecturas Harvard y Von NeumannCarlos RiveraAún no hay calificaciones

- Actividad 1.1.1Documento14 páginasActividad 1.1.1luisAún no hay calificaciones

- Actividad 3.1 Arquitecturas Von Neumman y HarvardDocumento5 páginasActividad 3.1 Arquitecturas Von Neumman y HarvarddiegoAún no hay calificaciones

- Resumen Teoría de Null - Orga 1Documento57 páginasResumen Teoría de Null - Orga 1facundoAún no hay calificaciones

- Arquitectura Según Von Neumann y HarvardDocumento2 páginasArquitectura Según Von Neumann y Harvardsamuel gazabonAún no hay calificaciones

- Arquitectura Computadoras ISCcccDocumento254 páginasArquitectura Computadoras ISCcccrtsazepolAún no hay calificaciones

- UF0852 - Instalación y actualización de sistemas operativosDe EverandUF0852 - Instalación y actualización de sistemas operativosCalificación: 5 de 5 estrellas5/5 (1)

- Programación de microcontroladores paso a paso: Ejemplos prácticos desarrollados en la nubeDe EverandProgramación de microcontroladores paso a paso: Ejemplos prácticos desarrollados en la nubeAún no hay calificaciones

- Computadores para bases de datos. IFCT0310De EverandComputadores para bases de datos. IFCT0310Aún no hay calificaciones

- Ensayo de ContaDocumento9 páginasEnsayo de ContaWILMAAún no hay calificaciones

- Oficina Del Tribunal Eclesiástico - Diócesis de Tucson Declaración Jurada de La Libertad para Contraer MatrimnioDocumento3 páginasOficina Del Tribunal Eclesiástico - Diócesis de Tucson Declaración Jurada de La Libertad para Contraer MatrimnioLuz Nogales-TapiaAún no hay calificaciones

- Conceptualización de Espacio Territorio y Límite Desde La Geografía y Su Implicación en La Práctica Geográfica Dentro Del Contexto NeoliberalDocumento14 páginasConceptualización de Espacio Territorio y Límite Desde La Geografía y Su Implicación en La Práctica Geográfica Dentro Del Contexto Neoliberalmilton javier diago ortizAún no hay calificaciones

- Esquema Figuras LiterariasDocumento9 páginasEsquema Figuras Literariasesmith81Aún no hay calificaciones

- Guia de Practicas Farmacologia Ii 2021-IiDocumento114 páginasGuia de Practicas Farmacologia Ii 2021-IiMarco Mamani HuamanculiAún no hay calificaciones

- Añadir Un Título-4Documento1 páginaAñadir Un Título-4ALEXA ESTEVEZAún no hay calificaciones

- Evaluación de La Calidad de La TecnologíaDocumento16 páginasEvaluación de La Calidad de La TecnologíaMónica Marcela Cano LópezAún no hay calificaciones

- Ejercicio Externalización GRUPO E.1Documento5 páginasEjercicio Externalización GRUPO E.1Isaac CumbaAún no hay calificaciones

- Plan de Atencion Primaria Educacion FisicaDocumento3 páginasPlan de Atencion Primaria Educacion FisicaF Cr100% (2)

- Aclaración, Rectificación O EnmiendaDocumento3 páginasAclaración, Rectificación O EnmiendaFernando Faret Saalfeld0% (1)

- Mandos MediosDocumento7 páginasMandos MediosGY HERNANDEZAún no hay calificaciones

- Prueba de Diagnostico 2013-I y SolucionarioDocumento34 páginasPrueba de Diagnostico 2013-I y Solucionariocamargo420Aún no hay calificaciones

- Área y Línea de Investigación. Douglas A. García PeñaDocumento2 páginasÁrea y Línea de Investigación. Douglas A. García PeñaDouglas100% (2)

- Presentación de Administración Integral de YacimientosDocumento17 páginasPresentación de Administración Integral de YacimientosAlliiziitha Kstiille100% (2)

- Ccna Icnd2: Guía Oficial para El Examen de CertificaciónDocumento738 páginasCcna Icnd2: Guía Oficial para El Examen de CertificaciónJulio Anibal Ochoa Marroquin100% (1)

- La Integración Del Plogging A Través Del Aprendizaje Servicio en Educación Física. Una Intervención Educativa ...Documento23 páginasLa Integración Del Plogging A Través Del Aprendizaje Servicio en Educación Física. Una Intervención Educativa ...luiscarlosguerrero1983Aún no hay calificaciones

- Tarot XX Le Jugement (El Juicio)Documento9 páginasTarot XX Le Jugement (El Juicio)Juan CarlosAún no hay calificaciones

- Ficha de Identidad 2023Documento2 páginasFicha de Identidad 2023enrique esperilla espirillaAún no hay calificaciones

- Prueba Comprensiva de QuintoDocumento8 páginasPrueba Comprensiva de QuintoElieth AlvarezAún no hay calificaciones

- Manual de ScanerDocumento62 páginasManual de ScanerJorge Alberto Ospina MontezaAún no hay calificaciones

- Trabajos Jeaneth 05 de MarzoDocumento5 páginasTrabajos Jeaneth 05 de MarzoJosé Ángel EndeyorAún no hay calificaciones

- Práctica Estática IIDocumento4 páginasPráctica Estática IIAracely Palomino HuamanAún no hay calificaciones

- Memoria Descriptiva Estructuras Los PortalesDocumento5 páginasMemoria Descriptiva Estructuras Los PortalesAlexanderCabreraVásquezAún no hay calificaciones

- Estandar de Perforación y Voladura 1Documento10 páginasEstandar de Perforación y Voladura 1Freiser Ramos miñanoAún no hay calificaciones

- Friccion y RozamientoDocumento5 páginasFriccion y RozamientoLizandro Tapia MejiaAún no hay calificaciones

- Exposicion de Desarrollo PersonalDocumento32 páginasExposicion de Desarrollo PersonalCarlos Antonio Camerón0% (1)

- Especificaciones TécnicasDocumento3 páginasEspecificaciones TécnicasGeroge VanegasAún no hay calificaciones

- Formato Estrategia Del ProductoDocumento5 páginasFormato Estrategia Del ProductoElisa Velasquez ArizaAún no hay calificaciones

- Ejercicio Obras de Toma Lateral (Autoguardado)Documento6 páginasEjercicio Obras de Toma Lateral (Autoguardado)Anonymous BldjDbAún no hay calificaciones

- Tarea 2.1 - Creatividad e InnovaciónDocumento3 páginasTarea 2.1 - Creatividad e InnovaciónStalin DiosesAún no hay calificaciones