Documentos de Académico

Documentos de Profesional

Documentos de Cultura

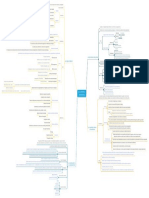

Mapa Mental Paralelos

Cargado por

Loreto GarciaTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Mapa Mental Paralelos

Cargado por

Loreto GarciaCopyright:

Formatos disponibles

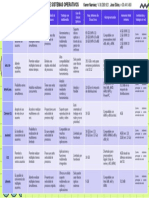

DAS: Direct-attached storage disco asociado a nodo

Tolerancia a fallos SW NAS: Network-attached storage Nodo que gestiona un conjunto de discos

Plataforma basada en commodity HW

No altas prestaciones pero gran paralelismo Conexión de dispos. Red dedicada al almacenamiento Almacenamiento no vinculado a ningún nodo

almacenamiento

Modo de operación batch Redes comunicación separadas para datos de aplicación y ficheros

Perfil de aplicaciones previstas

Millones de ficheros grandes SAN: Storage Area Networks Redes de almacenamiento incluyen hubs, switches, etc.

Intro

Escritor genera fichero completo inmutable Conectividad total entre nodos y dispositivos:

Patrones de acceso típicos

Múltiples escritoresañaden Conectividad directa entre dispositivos

Con gran paralelismo

Google juega con ventaja Datos de fichero distribuidos entre discos del sistema

Por la especialización hacia el éxito Uso de stripping

Especialización: sí pero no demasiada Similar a RAID 0 pero por software y entre varios nodos

Mayoría lecturas grandes (>1MB) y secuenciales shared disk file systems Nuevo reparto de funcionalidad de SF en 2 niveles

Algunas lecturas pequeñas aleatorias Sistemas de Proporcionado por la SAN

ficheros paralelos Nivel inferior: servicio de almacenamiento distribuido

Mayoría escrituras grandes (>1MB) y secuenciales Perfil de aplicaciones Si no SAN, módulo de servicio de disco en cada nodo E/S (NES)

Habitual escrituras pequeñas simultáneas al final del fichero Cada NC accede a los discos como si fueran locales

Carga de trabajo prevista y API

Escrituras pequeñas aleatorias no previstas Nivel superior: sist. ficheros en cada nodo de cómputo (NC) Cada NC gestiona la metainfo. de los datos que accede

API, y modelo de coherencia, no estándar Se requiere un mecanismo de cerrojos distribuido

Tomar como base un SF convencional Gran escala soporte grandes volúmenes, ficheros y directorios

Sistema de ficheros para clusters

Añadir: cada trozo de fichero almacenado en nodo distinto Presente en la mayoría de los Top 500

problema de fiabilidad -> réplicas Datos repartidos en discos Soporte para SAN y nodos con discos: Shared disk file system

Receta para diseñar Una primera aproximación a GFS File System

No usar caché en nodos cliente Sistemas heterogéneos

Único nodo maestro gestiona toda la información del SF Semántica POSIX Escrituras atómicas

Intro

a del nodo maestro Escalabilidad

Sistemas de

Facilidades para implementar biblioteca MPI-IO

Trozos fichero repartidos entre nodos de almacenamiento (NA)

ficheros paralelos

Optimiza acceso para 1 fichero/N procesos y N ficheros/1 proceso

Paralelismo en gestión de datos y metadatos

Tamaño de trozo/chunk/stripe: ¡64MB Ops. administración también con paralelismo y “en caliente”

mejor aprovechamiento discos y red Clásicas Tolerancia a fallos en discos, nodos y comunicación

Ventajas Striping

Menos gasto de memoria Bloques de fichero repartidos round-robin en discos de un SF

Escalabilidad del maestro

Menos trabajo Si SF formado por RAIDs: T múltiplo de tamaño franja de RAID

Tamaño bloque T entre 16K y 1M: típico 256K

relacionadas con fragmentació Clásicas Ficheros pequeños y colas de ficheros: subbloques de hasta T/32

Desventajas

Striping

Menos paralelismo Uso de prefetching en lecturas con detección de patrones de acceso:

Lecturas y escrituras de un nodo aprovechan paralelismo

Evolución de las necesidades Uso de write-behind para escrituras paralelas en discos

Finalmente se nos ha quedado pequeño

Problemas (relación directa/indirecta con maestro único) Configuración maximizando rendimiento o prestaciones

Si discos de un SF no uniformes en tamaño y/o prestaciones

GFS entra en la era de los “múltiples maestros” Reparto de bloques no uniforme

reescritura completa Datos de los ficheros

GFS II/Colossus

Tamaño de bloque 1MB SF gestiona diversos tipos de “objetos” Metadatos del fichero inodo y bloques indirectos

Tiempo de recuperación de pocos segundos Metadatos del sistema de ficheros información de espacio libre, etc.

Todavía poca información

Paralelismo y control

Uso de códigos correctores vs. replicación SF usa caché de “objetos” en nodo de cómputo Necesidad de coherencia en gestión de cachés

de coherencia

Más especialización Si “objeto” se extiende por varios dispositivos Necesidad de coherencia si se requiere actualización atómica

Solución basada en gestor de cerrojos distribuidos se trata de cerrojos internos del SF

Gestor de tokens (GT) único en sistema ejecutando en un NC Posible problema de escalabilidad y punto único de fallo

GeneralParallelFileSystemdeIBM Gestiona tokens lectura/escritura para distintos tipos de objetos Rangos

Control acceso paralelo a objeto

Doble rol del token

Gestor de cerrojos

control de caché del objeto

distribuidos

Operación en NC requiere token para cierto objeto Lo solicita a GT y lo mantiene

Solicitud múltiples tokens en una sola petición

Escalabilidad GT: minimizar su intervención NC que requiere token solicita directamente revocación a NCs

Nuevo fichero reutiliza inodo manteniendo tokens asociados al mismo

Protocolo basado en tokens asociados a rangos de bytes

1. Proceso lee/escribe fichero usando N llamadas: 1 único token

Optimización en la gestión de tokens

2. M proc. escriben fich. (1/M cada uno) con N llamadas/pr.: M tokens

Coherencia en acceso a datos

Rango requerido: el especificado en operación read/write

Solicitud de token incluye dos rangos:

Rango deseado: al que podría querer acceder en el futuro

Se revocan tokens que entran en conflicto con rango requerido

Resolución de solicitud:

Se concede rango deseado que no entre en conflicto

Si ningún otro cliente accede a F, no más peticiones de tokens.

Optimización en gestión de tokens En primera escritura/lectura a F, rango deseado [0,∞]

el proceso sólo pide un token

Directas (chmod)

Modificaciones concurrentes a metadatos de fichero

Indirectas: write -> fecha modificación, tamaño y punteros a bloques

Uso de token de acceso exclusivo por inodo no es eficiente Solicitud token de inodo por cada escritura aunque no solapadas

Coherencia acceso metadatos fichero

Idea actualización de inodo en paralelo y mezcla de cambios

token de escritura compartida y exclusiva

Solución

Ciertas ops. requieren token escritura exclusiva

También podría gustarte

- GuíaBurros: Redes Locales: Todo lo que debes saber para montar una red localDe EverandGuíaBurros: Redes Locales: Todo lo que debes saber para montar una red localCalificación: 4 de 5 estrellas4/5 (4)

- Intensivo Power BIDocumento97 páginasIntensivo Power BIClaudia Palma Cervera100% (4)

- Unix Programacion Avanzada, 3ª edicion.: PROGRAMACIÓN INFORMÁTICA/DESARROLLO DE SOFTWAREDe EverandUnix Programacion Avanzada, 3ª edicion.: PROGRAMACIÓN INFORMÁTICA/DESARROLLO DE SOFTWARECalificación: 3.5 de 5 estrellas3.5/5 (3)

- Acta de Nacimiento SOVK040118MDFTGSA8Documento1 páginaActa de Nacimiento SOVK040118MDFTGSA8Kashya StröpAún no hay calificaciones

- Das, Nas y SanDocumento3 páginasDas, Nas y SanAmelia Ferreras VaraAún no hay calificaciones

- Puntos Extra 4 AutocalificableDocumento5 páginasPuntos Extra 4 AutocalificableVicente Romero80% (5)

- DB2Documento58 páginasDB2joseAún no hay calificaciones

- Ejemplos de SELECT (Transact-SQL)Documento13 páginasEjemplos de SELECT (Transact-SQL)David NedAún no hay calificaciones

- Cuadro ComparativoDocumento5 páginasCuadro ComparativoNorma Victoria Vazquez GutierrezAún no hay calificaciones

- Tema1 08 SANyNASDocumento31 páginasTema1 08 SANyNASpabloAún no hay calificaciones

- CassandraDocumento12 páginasCassandraRosemary MontillaAún no hay calificaciones

- Nas San Arreglos AlmacenamientoDocumento3 páginasNas San Arreglos AlmacenamientoCarlos Gustavo Mogollon AbreuAún no hay calificaciones

- LAN Red de Área LocalDocumento4 páginasLAN Red de Área LocalAnahi FloresAún no hay calificaciones

- SGBD Caracteristicas Ventajas DesventajaDocumento2 páginasSGBD Caracteristicas Ventajas DesventajaLuis RomeroAún no hay calificaciones

- Mapa Conceptual Motores de BusquedaDocumento1 páginaMapa Conceptual Motores de BusquedaWily TorresAún no hay calificaciones

- SAN y NASDocumento2 páginasSAN y NAStjbaidal100% (1)

- Redes SANDocumento3 páginasRedes SANDennis HerreraAún no hay calificaciones

- UT4 Actividad3Documento3 páginasUT4 Actividad3alejandro pradillo martinAún no hay calificaciones

- Blog SGBD CARACTERISTICAS VENTAJAS - ¿ DESVENTAJA PDFDocumento3 páginasBlog SGBD CARACTERISTICAS VENTAJAS - ¿ DESVENTAJA PDFDeivid RamirezAún no hay calificaciones

- NAS, SAN y Arreglos de AlmacenamientoDocumento3 páginasNAS, SAN y Arreglos de AlmacenamientoYeison BARBOSA SAún no hay calificaciones

- Unidad 1: Conceptos de Bases de Datos No Relacionales, Orientadas A Objetos y A DocumentosDocumento7 páginasUnidad 1: Conceptos de Bases de Datos No Relacionales, Orientadas A Objetos y A DocumentosFabian IbarraAún no hay calificaciones

- Aa2 - Instalacion y Configuracion de Sistemas Gestores de Bases de DatosDocumento19 páginasAa2 - Instalacion y Configuracion de Sistemas Gestores de Bases de DatosRafael Arturo Forero MolanoAún no hay calificaciones

- DDBD U3 A3 YgblDocumento11 páginasDDBD U3 A3 YgblYair Gigael Basilio LopezAún no hay calificaciones

- SgbdsDocumento3 páginasSgbdsEmmanuel HernandezAún no hay calificaciones

- Semana 6Documento4 páginasSemana 6Josias GarduñoAún no hay calificaciones

- Evelin GutierrezDocumento7 páginasEvelin GutierrezEdgar Horacio Obregoón SixtosAún no hay calificaciones

- 103 NAS, SAN y Arreglos de VirtualizaciónDocumento3 páginas103 NAS, SAN y Arreglos de VirtualizaciónOtoniel Rodriguez G.Aún no hay calificaciones

- Actividad N°1 Tipologia de RedesDocumento8 páginasActividad N°1 Tipologia de RedesAngie Peña OspinoAún no hay calificaciones

- Tipos de Servidores Segun Su Forma FisicaDocumento1 páginaTipos de Servidores Segun Su Forma Fisicafel ovAún no hay calificaciones

- Ventajas y Desventajas Sistema OperativoDocumento4 páginasVentajas y Desventajas Sistema OperativoJetsabelAún no hay calificaciones

- Obrefon Sixtos EdgarhoracioDocumento6 páginasObrefon Sixtos EdgarhoracioEdgar Horacio Obregoón SixtosAún no hay calificaciones

- Trabajo de EdgarDocumento6 páginasTrabajo de EdgarEdgar Horacio Obregoón SixtosAún no hay calificaciones

- AA2 - Cuadro Comparativo Bases de DatosDocumento3 páginasAA2 - Cuadro Comparativo Bases de DatosYu AyakawaAún no hay calificaciones

- Arquitecturas de Bases de Datos PDFDocumento17 páginasArquitecturas de Bases de Datos PDFEuler ValenciaAún no hay calificaciones

- Tipos de Sistemas DistribuidosDocumento3 páginasTipos de Sistemas DistribuidosCYNTHIA ESTELA PISCIL SANTANDERAún no hay calificaciones

- Villa Preciado Everardo - Sistemas Gestores de Bases de Datos - (50)Documento2 páginasVilla Preciado Everardo - Sistemas Gestores de Bases de Datos - (50)Everardo Villa PreciadoAún no hay calificaciones

- CADC #06 PresenDocumento37 páginasCADC #06 PresenEduardo AugustoAún no hay calificaciones

- DB2 en EsDocumento7 páginasDB2 en EsRicardoAún no hay calificaciones

- Tarea2 ArquitecturasBasesdeDatosNoSQLDocumento4 páginasTarea2 ArquitecturasBasesdeDatosNoSQLBryan DardonAún no hay calificaciones

- Diagrama de FlujoDocumento3 páginasDiagrama de Flujoaraceli ramirezAún no hay calificaciones

- TablaResumen ServiciosRed MonitoreoDocumento11 páginasTablaResumen ServiciosRed MonitoreoDamian Enríquez ValleAún no hay calificaciones

- Arquitectura de Bases de DatosDocumento9 páginasArquitectura de Bases de DatosJhon Kenner Rojas MorenoAún no hay calificaciones

- Cluster BeowulfDocumento14 páginasCluster BeowulfFranco Leonardo AvellanedaAún no hay calificaciones

- ARQUI Cuadro Comparativo PDFDocumento6 páginasARQUI Cuadro Comparativo PDFDeNey LiZondo Garcia DlcgAún no hay calificaciones

- Cuadro ComparativoDocumento1 páginaCuadro Comparativoalejandro alvaradoAún no hay calificaciones

- Villagran Cynthia SODocumento21 páginasVillagran Cynthia SOpamevcvAún no hay calificaciones

- Dokumen - Tips - Tabla Modelo Osi 55c9def85aba4Documento2 páginasDokumen - Tips - Tabla Modelo Osi 55c9def85aba4César PanchiAún no hay calificaciones

- Diferencia Entre El Sistema Operativo de Red y El Sistema Operativo DistribuidoDocumento4 páginasDiferencia Entre El Sistema Operativo de Red y El Sistema Operativo DistribuidoEduardo GMAún no hay calificaciones

- Guia-Computación para IngenierosDocumento2 páginasGuia-Computación para Ingenierosberebaggins4017Aún no hay calificaciones

- Tarea Semana 7Documento8 páginasTarea Semana 7Walter CortesAún no hay calificaciones

- Tutorial Samba PDFDocumento9 páginasTutorial Samba PDFJean AlvarezAún no hay calificaciones

- Cuadro Comparativo de Base de DatosDocumento3 páginasCuadro Comparativo de Base de DatosJulio HernándezAún no hay calificaciones

- 2019-03-29-Computacion de Altas Prestaciones - File SystemsDocumento26 páginas2019-03-29-Computacion de Altas Prestaciones - File SystemsYarol Parra VargasAún no hay calificaciones

- Tarea 2.1 - 20051252Documento6 páginasTarea 2.1 - 20051252Sánchez Piña Lydia LizethAún no hay calificaciones

- Mapa Conceptual de Las Diferentes Arquitectura de ComputadorasDocumento4 páginasMapa Conceptual de Las Diferentes Arquitectura de ComputadorasJose GutierrezAún no hay calificaciones

- Actividad de InvestigaciónDocumento2 páginasActividad de InvestigaciónJhonatan BarreraAún no hay calificaciones

- Modelos Distribuidos y ArquitecturaDocumento2 páginasModelos Distribuidos y ArquitecturaUriel ChávezAún no hay calificaciones

- Componentes de Una Red Local PDFDocumento9 páginasComponentes de Una Red Local PDFKatherinAún no hay calificaciones

- Tablamodeloosi 120612150511 Phpapp02Documento2 páginasTablamodeloosi 120612150511 Phpapp02melyromano842Aún no hay calificaciones

- Tipos de ServidoresDocumento3 páginasTipos de ServidoresUriel ChávezAún no hay calificaciones

- Resumen de SAMBA Y NFSDocumento5 páginasResumen de SAMBA Y NFSCésarAún no hay calificaciones

- Instituto Tecnologico de Ciudad JuarezDocumento3 páginasInstituto Tecnologico de Ciudad JuarezLuis DanielAún no hay calificaciones

- Cuadro Comparativo Informatica, Karen Narváez 30.389.921Documento1 páginaCuadro Comparativo Informatica, Karen Narváez 30.389.921JoseAún no hay calificaciones

- Presentacin Semana 8Documento14 páginasPresentacin Semana 8Diego AlvarezAún no hay calificaciones

- Contenidos DistribuidosDocumento1 páginaContenidos Distribuidosnoslen reivaxAún no hay calificaciones

- Anticodigo - MaliciosoDocumento11 páginasAnticodigo - MaliciosoLoreto GarciaAún no hay calificaciones

- BulletDocumento23 páginasBulletLoreto GarciaAún no hay calificaciones

- Bullet AzulDocumento23 páginasBullet AzulLoreto GarciaAún no hay calificaciones

- BulletDocumento23 páginasBulletLoreto GarciaAún no hay calificaciones

- 1 IntroduccinDocumento7 páginas1 IntroduccinLoreto GarciaAún no hay calificaciones

- 2-Codigo SeguroDocumento12 páginas2-Codigo SeguroLoreto GarciaAún no hay calificaciones

- 5-Otras DefensasDocumento18 páginas5-Otras DefensasLoreto GarciaAún no hay calificaciones

- 3-Codigo MaliciosoDocumento9 páginas3-Codigo MaliciosoLoreto GarciaAún no hay calificaciones

- Bullet GrisDocumento23 páginasBullet GrisLoreto GarciaAún no hay calificaciones

- Servicio de Nombres PDFDocumento10 páginasServicio de Nombres PDFLoreto GarciaAún no hay calificaciones

- G ProcesosDocumento12 páginasG ProcesosLoreto GarciaAún no hay calificaciones

- Mapa Mental ParalelosDocumento1 páginaMapa Mental ParalelosLoreto GarciaAún no hay calificaciones

- SIn SolDocumento17 páginasSIn SolLoreto GarciaAún no hay calificaciones

- SincronizaciónDocumento12 páginasSincronizaciónLoreto GarciaAún no hay calificaciones

- Mapa Mental SDFDocumento1 páginaMapa Mental SDFLoreto GarciaAún no hay calificaciones

- Servicio de Directorio PDFDocumento5 páginasServicio de Directorio PDFLoreto GarciaAún no hay calificaciones

- Tema 4Documento2 páginasTema 4Loreto GarciaAún no hay calificaciones

- Mapa Mental T1y2Documento1 páginaMapa Mental T1y2Loreto GarciaAún no hay calificaciones

- Tema 1 (Si Puedes A Color) PDFDocumento2 páginasTema 1 (Si Puedes A Color) PDFLoreto GarciaAún no hay calificaciones

- Sistemas de Ficheros DistribuidosDocumento13 páginasSistemas de Ficheros DistribuidosLoreto GarciaAún no hay calificaciones

- Sist. Ficheros ParalelosDocumento7 páginasSist. Ficheros ParalelosLoreto GarciaAún no hay calificaciones

- Tema 1Documento3 páginasTema 1Loreto GarciaAún no hay calificaciones

- Comunicación en Sistemas DistribuidosDocumento7 páginasComunicación en Sistemas DistribuidosLoreto GarciaAún no hay calificaciones

- Mapa - Tema 5Documento1 páginaMapa - Tema 5Loreto GarciaAún no hay calificaciones

- Comunicación en Sistemas DistribuidosDocumento7 páginasComunicación en Sistemas DistribuidosLoreto GarciaAún no hay calificaciones

- Mapa - Tema 1-3Documento1 páginaMapa - Tema 1-3Loreto GarciaAún no hay calificaciones

- Mapa Mental T3y4Documento1 páginaMapa Mental T3y4Loreto GarciaAún no hay calificaciones

- Mapa Mental t5Documento1 páginaMapa Mental t5Loreto GarciaAún no hay calificaciones

- Sist. Ficheros ParalelosDocumento7 páginasSist. Ficheros ParalelosLoreto GarciaAún no hay calificaciones

- Mapa - Tema 4Documento1 páginaMapa - Tema 4Loreto GarciaAún no hay calificaciones

- Taller 2 SQLDocumento12 páginasTaller 2 SQLfredy rodríguezAún no hay calificaciones

- Qué Es La Integridad ReferencialDocumento1 páginaQué Es La Integridad ReferencialJesus FiestasAún no hay calificaciones

- Reparar Con TestDocumento14 páginasReparar Con TestjovannyAún no hay calificaciones

- Practica S5Documento5 páginasPractica S5Nelida GarciaAún no hay calificaciones

- Modelo Entidad Relacion Er (Trabajo)Documento9 páginasModelo Entidad Relacion Er (Trabajo)johannyAún no hay calificaciones

- Capitulo 6Documento21 páginasCapitulo 6Antonio MaldonadoAún no hay calificaciones

- Talle de Base de Datos IIDocumento7 páginasTalle de Base de Datos IIAnonymous pGbuqKwcAún no hay calificaciones

- Bases de Datos Semana 4 UTELDocumento8 páginasBases de Datos Semana 4 UTELjorgeAún no hay calificaciones

- Prac Repaso GLOBAL SQLDocumento2 páginasPrac Repaso GLOBAL SQLdario velasquezAún no hay calificaciones

- Base de Datos I: Ing. Sergio Valladares CastilloDocumento22 páginasBase de Datos I: Ing. Sergio Valladares CastilloCarlos RodriguezAún no hay calificaciones

- Test LinuxDocumento7 páginasTest LinuxAlejandro Panizo AstoquillcaAún no hay calificaciones

- Disco SSD WikiDocumento3 páginasDisco SSD WikiSmart PaperAún no hay calificaciones

- Instalación PentahoDocumento9 páginasInstalación PentahoDukDarkAún no hay calificaciones

- 2014-7 - SOLUCIÓN Nombre Archivos Demasiado LargosDocumento10 páginas2014-7 - SOLUCIÓN Nombre Archivos Demasiado LargosJosé RomeroAún no hay calificaciones

- Explicacion de .NETCoreDocumento13 páginasExplicacion de .NETCoreANDRESAún no hay calificaciones

- Ejercicio Unix 3 ResueltoDocumento6 páginasEjercicio Unix 3 ResueltozyzzAún no hay calificaciones

- Plan de Clases Base de DatosDocumento4 páginasPlan de Clases Base de DatosRicardo ArmasAún no hay calificaciones

- Crear DSN de Sistema Desde Vb6Documento8 páginasCrear DSN de Sistema Desde Vb6mymsystemasAún no hay calificaciones

- Características y Funciones de Seguridad Del SMBD SeleccionadoDocumento8 páginasCaracterísticas y Funciones de Seguridad Del SMBD SeleccionadoJonatan AlexanderAún no hay calificaciones

- Comandos GitDocumento9 páginasComandos GitMisael GonzalezAún no hay calificaciones

- Paginación de Resultados Con PHP y MySQLDocumento48 páginasPaginación de Resultados Con PHP y MySQLFabián Castillo FauneAún no hay calificaciones

- Listasdoblementeenlazadas 160520020240Documento18 páginasListasdoblementeenlazadas 160520020240ernestoAún no hay calificaciones

- Postgres V2Documento26 páginasPostgres V2López Agustín AbelAún no hay calificaciones

- Semana 7Documento2 páginasSemana 7Esmeralda Caballero PonteAún no hay calificaciones

- Instalacion de LitinloginDocumento4 páginasInstalacion de LitinloginRicardo AndreAún no hay calificaciones