Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Abs Colinealidad PDF

Cargado por

NathalyVargas29Título original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Abs Colinealidad PDF

Cargado por

NathalyVargas29Copyright:

Formatos disponibles

Colinealidad

Introduccin ( 1 )

Colinealidad: importancia y aspectos prcticos.

Colinealidad: Si XyZ son independientes: situacin sin dificultades

estn relacionadas: situacin delicada

La colinealidad es condicin necesaria para confusin

Ortogonalidad implica no confusin

Recomendaciones de los libros

Principios: Dos utilidades del anlisis estadstico

Papel (rol) de las variables en el modelo

Definicin de efecto causal

Interpretacin de los principios: Debemos condicionar o ajustar por los atributos Z

Otras medidas X de la misma causa: reduciremos la dimensin

Podemos ajustar por causas X competitivas

No ajustemos por variables Y posteriores a Y

Ajustemos y no ajustemos por variables Y intermedias entre X e Y

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad

Introduccin ( 2 )

Una situacin sin dificultades: X y Z son independientes.

Z no molesta al estudiar X con Y Y representa la respuesta

Z+ Y+ Y- Z- Y+ Y- Y+ Y- X la hipottica causa en estudio

X+ 60 30 X+ 30 60 X+ 90 90 Z una tercera variable relacionada

X- 60 30 X- 30 60 X- 90 90 con la respuesta Y

or = 1 or = 1 or = 1 Como X y Z son independientes*

Y+ X+ X- Y- X+ X- X+ X- hay la misma conclusin

Z+ 60 60 Z+ 30 30 Z+ 90 90 al ajustar por Z que

Z- 30 30 Z- 60 60 Z- 90 90 al olvidar Z

or = 1 or = 1 or = 1

Independencia XZ equilibrio,

X+ Y+ Y- X- Y+ Y- Y+ Y- balanceo,

Z+ 60 30 Z+ 60 30 Z+ 120 60 ortogonalidad,...

Z- 30 60 Z- 30 60 Z- 60 120

or = 4 or = 4 or = 4 Es lo que persigue el diseo de experimentos

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad

Introduccin ( 3 )

Una situacin delicada: X y Z no son independientes.

Z nos confunde al estudiar X con Y Ahora X y Z son dependientes*

no hay la misma conclusin

Z+ Y+ Y- Z- Y+ Y- Y+ Y- al ajustar$ por Z que

X+ 80 40 X+ 20 40 X+ 100 80 al olvidar# Z

X- 40 20 X- 40 80 X- 80 100

or = 1 or = 1 or = 1'563 * dependencia XZ relacin XZ,

Y+ X+ X- Y- X+ X- X+ X- colinealidad,...

Z+ 80 40 Z+ 40 20 Z+ 120 60 $

ajustar por... tener en cuenta,

Z- 20 40 Z- 40 80 Z- 60 120

condicionar,

or = 4 or = 4 or = 4

estudio parcial, ...

X+ Y+ Y- X- Y+ Y- Y+ Y-

Z+ 80 40 Z+ 40 20 Z+ 120 60 #

olvidar... colapsar,

Z- 20 40 Z- 40 80 Z- 60 120 estudio marginal, ...

or = 4 or = 4 or = 4

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad

Introduccin ( 4 )

Colinealidad: condicin necesaria para confusin.

Ntese que, en la tabla anterior, Z est relacionada con Y

Z est relacionada con X

X

Y

Z

Al olvidarnos de Z, aparece una relacin esprea.

X

Y

Para que exista confusin: ZX: Z y X deben ser colineales

ZY: Z debe ser predictora de Y

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad

Introduccin ( 5 )

Qu dicen los libros sobre la colinealidad?

1) Ortogonalidad implica no confusin.

Sea el modelo Y = X +

subdividiendo en T componentes

la matriz X X = { X1 , X2 , ... , Xt , ... XT}

y el vector : = { 1' , 2' , ... , t' , ... T }

de forma que: E(Y) = X = X1 1 + X2 2 + ... + Xt t +... + XT T

Si las columnas Xt son ortogonales (Xt' Xt = 0) entre s, entonces vase, p.e., Pea

(1) SC(b) = SC(b1) + SC(b2) + ... + SC(bt) +... + SC(bT)

= b1' X1' Y + b2' X2' Y +...+ bt' Xt' Y + ... + bT' XT' Y

(2) bt es el estimador de t

(3) SC(bt) = bt' Xt' Y

Est o no, en el modelo, el resto -ortogonal- de la matriz.

Luego la colinealidad es necesaria para que exista confusin.

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad

Introduccin ( 6 )

2) Recomendaciones:

- Seleccionar variables segn: - aportacin de informacin independiente,

- acuerdo en su significado/interpretacin,

- facilidad/coste de su obtencin,

- tiempo de su obtencin (previas),

- variabilidad de su determinacin,..

- Estudiar: - la matriz de correlaciones bivariantes entre las X.

- El coeficiente de correlacin mltiple entre un regresor y los restantes: Ri,resto

- El FIV (factor de incremento de la varianza).

- A.C.P. entre los regresores: identificar dimensin de X.

son los ltimos valores propios cercanos a 0?

ndice de condicionamiento: (1/k) Si >15 Cuidado

Si >30 Peligro

- Transformar regresores:

- a priori, segn criterio (suma, resta,...)

- a posteriori, mediante ACP (identifica componentes que influyen en varias variables

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .1

Principios ( 1 )

Dos utilidades del anlisis estadstico.

a) Intervencin : Utilizo una variable (X) para cambiar el valor de otra (Y)

Precisa una relacin ntima muy especial: relacin de causa-efecto

b) Prediccin: Utilizo una variable (X) para adivinar el valor de otra (Y)

No precisa relacin de causa-efecto.

Ejemplo: puedo acercarme a la mortalidad por cncer a partir del consumo de mocasines.

Seleccionar las variables independientes a ser incluidas en el modelo segn:

- Aportacin de informacin nueva, independiente

- Disponibilidad en el tiempo: variables tardas restan utilidad

- Fiabilidad de su medicin ( 2INTRA): por premisa (modelo I) X no es v.a.

- Coste de su obtencin

- Significado, coherencia, acuerdo en su interpretacin

EJEMPLO: Para seleccionar fetos con alta probabilidad de Sd. Down,

qu variable cumple mejor estas propiedades, la edad de la madre o del padre?

ATENCIN: Relaciones causales tendrn mayor validez externa: sern ms utilizables por

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .2

Principios ( 2 )

terceros.

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .3

Principios ( 3 )

Papel (rol) de las variables en el modelo.

Y variable respuesta o dependiente.

Queremos estudiar cmo

las variables independientes X y Z permiten predecir o incluso modificar Y.

X variable(s) Independiente(S) con papel Primario: son el objetivo fundamental del estudio.

Pretenderemos intervenir sobre ellas para modificar la respuesta.

Precisa relacin causa-efecto.

Segn origen datos: experimental: la aleatorizacin permite inferir relacin causal

P.e.: tratamiento, condiciones de fabricacin, ...

observacional: necesitamos no confusin para inferir causalidad.

P.e.: factor de riesgo (no asignable a humanos).

Z: variables Independientes con papel Secundario:

Suelen ser atributos de los datos, meras condiciones. P.e.: gnero, edad, ...

Dado que no podemos decidir su valor en una unidad,

la asociacin estadstica puede tener utilidad predictiva, pero no causal o manipulativa.

Son posibles confusoras que se desea tener controladas o condicionadas (ajuste)

Incluirlas aumenta potencia estadstica y evita sesgos.

Al ser atributos, Z son anteriores a X en la cadena causal.

Se incluyen en el modelo por premisas previas [prueba de hiptesis no relevante]

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .4

Principios ( 4 )

Cmo definimos el efecto causal?

Sean: - Dos causas X: t: tratamiento o propuesta alternativa en estudio

c: control

- Una poblacin de unidades Ui

- Una respuesta Y que tiene dos posibles manifestaciones:

Yc,i : la respuesta Y observable en la unidad ui cuando se le asigna c

Yt,i : la respuesta Y observable en la unidad ui cuando se le asigna t

Se define

el efecto de la causa t

relativo al control c

en la respuesta Y

en el individuo ui

como: t causa el efecto y t i - y c i

O bien, en toda la poblacin de unidades:

t causa el efecto (promedio) E[Y t,i ] - E[Y c,i ]

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .1

Interpretacin de los principios ( 1 )

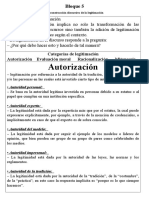

1) Debemos condicionar o ajustar por los atributos Z.

Los atributos no son modificables.

Queremos conocer el efecto, dadas estas condiciones previas Z .

Debemos realizar una nueva definicin de efecto causal:

t causa el efecto (promedio) ajustado E[Yt/z] - E[Yc/z]

Ello implica:

O bien equilibrar las condiciones en las que se

estudian ambos tratamientos

Slo posible en el entorno experimental

O bien ajustar, condicionar por estas variables Z

para anular el efecto de los desequilibrios.

Posible tambin en el entorno observacional

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .2

Interpretacin de los principios ( 2 )

Ajuste. Adaptada de Kleimbaum et al. Epidemiologic Research, 1982

Opcin Fase* Nombre Ventajas Inconvenientes

Restriccin Control Completo Reduce generabilidad

Diseo (criterios inclu-

sin y exclusin)

Barato Limitado nmero de variables

Restriccin

Simple de disear Posible confusin residual

Anlisis de

Anlisis Simple de analizar (si las restricciones son amplias)

un subgrupo

Bloques Potencia Pierde flexibilidad

Diseo

(Apareamiento) Eficiencia Coste

Anlisis por

Subgrupos Sin premisas Dispersin de casos en estratos

Anlisis Estratificacin Directa Diferentes estratificaciones

(Apareamiento)

Clculo simple Difcil sumarizacin

Factible con pocos casos Muchas premisas

Diseo Modelado

Redondea efectos menores Eleccin del modelo

Modelado

Permite predicciones Eleccin de variables

Estadsticio Covarianza,

Anlisis Permite continuas (!) Interpretacin

Regresin, ... Permite varias (!) Parametrizacin del software

* Tiene mayor credibilidad un ajuste previamente especificado en el protocolo de la investigacin.

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .3

Interpretacin de los principios ( 3 )

2) Otras medidas X de la misma causa: reduciremos la dimensin.

Para decidir si las consideramos como otras mediciones X de la misma causa X en estudio,

la pregunta clave es: podemos intervenir sobre X sin cambiar X?

podemos cambiar X dejando fija X?

Si al cambiar X, tocamos tambin X:

1) No es til estimar el efecto de X a nivel fijo, independientemente, de X

2) Resulta ms simple considerar ambas variables como

simples indicadores o mediciones de una tercera variable que est detrs ()

Solucin: Substituir X y X por una medicin nica de

- transformaciones decididas a priori

- modelos estructurales de medida

- ACP

Ntese que suelen tener una alta colinealidad.

Ejemplo: La Presin Arterial Sistlica (PAS o mxima) y

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .4

Interpretacin de los principios ( 4 )

la Presin Arterial Diastlica (PAD o mnima)

pueden utilizarse para predecir el grado de afectacin ateroesclertica.

S.E.(b)

SCE b PAS PAD

PAS 1.00 3.14

178378 150250 1220

PAD 1.02 -0.68 26908

PAS 177158 .31 2.51 266236

PAD 151470 .32 2.35

Ntese: (1) SCE se modifica menos al suprimir PAD del modelo que incluye las dos.

(2) la estimacin puntual de PAS baja al aadir PAD.

(3) la estimacin puntual de PAD cambia al aadir PAS.

Recurdese que i representa la variacin en Y a nivel constante de las restantes X:

PAS|PAD : cambio esperado en ATERO (por el cambio en una unidad de PAS)

cuando la PAD permanece constante.

tiene sentido PAS|PAD si resulta que cuando PAD vara tambin lo hace PAS?

La correlacin de PAS con PAD vale: rPAS,PAD = 095045

por lo que qu sentido tiene un cambio en PAS si PAD no vara?

Disponemos de un tratamiento que modifica PAS dejando fija PAD?

Ms sentido tendra definir PAM = (PAS+PAD)/2 la presin arterial media

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .5

Interpretacin de los principios ( 5 )

PAR = PAS-PAD la resta o presin arterial diferencial

cuya correlacin vale: rPAM,PAR = 004231

Resumen SCE S.E.(b) b

PAM 0.318 2.46

178378

PAR 0.997 1.91

PAM 168318 .322 2.49

PAR 13822 1.260 2.23

PAM

PAR

164556 3761

10061

266236

Ntese:

(1) Los errores tpicos ahora disminuyen en el modelo ampliado

(2) Las estimaciones puntuales de PAM y de PAR cambian poco.

(3) Ahora tienen sentido los coeficientes parciales de PAM y de PAR

3) Podemos ajustar por causas X competitivas.

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .6

Interpretacin de los principios ( 6 )

Se trata de otras variables X intervenibles independientemente.

Por ejemplo, horas de estudio teora: X1

laboratorio: X2

problemas. X3

Tiene sentido el efecto de X1 a nivel fijo de X2 y X3.

Suele poder imaginarse un estudio ortogonalizado.

4) No ajustemos por variables Y posteriores a Y.

El efecto causal sobre-ajustado E[Yt/Z,Y] - E[Yc/Z,Y] no significa nada

ATENCIN: XY/ZY no tiene sentido, pero

XY/ZY podra tenerlo.

Sean: Y: HTA (respuesta intermedia)

Y: AVC (autntica respuesta)

XY/ZY : Recoge Y (HTA) todo el efecto del tratamiento X en la respuesta Y (AVC)?

(Criterio de Prentice para un buen surrogate)

5) Ajustemos y no ajustemos por variables Y intermedias entre X e Y

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad .7

Interpretacin de los principios ( 7 )

parcial por E[Yt/Z,Y] - E[Yc/Z,Y] XY/ZY directo

La asociacin Y o bien estima el efecto

marginal de E[Yt/Z] - E[Yc/Z] XY/Z total

Ejemplo: Se sospecha que el gen X (1=si, 2=no) provoca la aparicin de AVC (Y1=si, Y2=no) .

Se sabe que las hiperlipidemias Y (1=si, 2=no) originan tambin (Y).

Adems, se sospecha que el gen X provoca las hiperlipidemias Y.

El orden natural de aparicin de estas variables es X, Y, Y

Qu pasa entre X, Y e Y? En un servicio de hiperlipdicos (Y1),

no se detecta relacin (parcial) entre X e Y.

Y1 Y1 Y2 Y2 Y1 Y2 Y1 Y2

X1 503 185 X1 37 151 X1 540 336 En toda la poblacin,

X2 155 56 X2 83 337 X2 234 393 se demuestra relacin (marginal) XY

or = 101 or = 099 or = 27 Y

IC95% 07-14 IC95%: 06-15 IC95%:2,2-3,3 X Y

Conclusiones: 1) por supuesto, X es predictora de Y

2) el efecto del gen X en Y viene mediatizado por los lpidos Y.

el efecto nocivo de X tambin podra anularse interrumpiendo la cadena en Y!

Checkoway, H., & Waldman, G.T. (1985). Assessing the possible extent of confounding in occupational case-referent studies. Scand J Work

Environ Health, 11, 131-133.

Cochran, W.G. (1968). The effectiveness of adjustment by subclasssification in removing bias in observational studies. Biometrics, 24? 295-

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

Colinealidad

Bibliografa

313.

Davis, L.J. (1989). Intersection union tests for strict collapsibility in three-dimensional contingency tables. The annals of statistics, 17, 1693-

1708.

Ducharme, G.R., & Lepage, Y. (1986). Testing collapsibility in contingency tables. J R Statist Soc B, 48, 197-205.

Flanders, W.D., & Khoury, M.J. (1990). Inderect assessment of confounding: Graphic Description and limits on effect of adjusting for covariates.

Epidemiology, 239-246.

Geng, Z. (1992). Collapsibility of relative risk in contingency tables with a response variable. J R Statist Soc B, 54, 585-593.

Geng, Z., & Asano, C. (1993). Strong collapsibility of association measures in linear models. J R Statist Soc B, 55, 741-747.

Glonek, G.F.V. (1993). On the Behaviour of Wald stistics for the disjunction of two regular hypotheses. J R Statist Soc B, 55, 749-755.

Greenland, S., & Mickey, R.M. (1988). Closed form and dually consistent methods for inference on strict collapsibility in 2x2xK and 2xJxK

tables. Appl Statist, 37, 335-343.

Guo, J., & Geng, Z. (1995). Collapsibilty of logistic regrssion coefficients. J R Statist Soc B, 57, 263-267.

Mickey, R.M., & Greenland, S. (1989). The impact of confounder selection criteria on effect estimation. Am J Epidemiol, 129, 125-137.

Robins, J.M. (1992). Estimation of the time-dependent accelerated failure time model in the presence of confounding factors. Biometrika, 79,

321-334.

Robins, J.M., Mark, S.D., & Newey, W.K. (1992). Estimating exposure effects by modelling the expectation of exposure conditional on

confounders. Biometrics, 48, 479-495.

Senn, S. (1994). Fisher's game with the devil. Statistics in medicine, 13, 217-230.

Stone, R. (1993). The assumptions on which causal inference rest. J R Statist Soc B, 55, 455-466.

Weinberg, C.R. (1993). Towrd a clearer definition of confounding. Am J Epidemiol, 137, 1-8.

Wemuth, N. (1987). Parametric collapsibility and the lack of moderating effects in contingency tables with a dichotomous response variable. J R

Statist Soc B, 49, 353-364.

Erik Cobo, EIO, FME, UPC 04/01/2012

e-mail: erik.cobo@upc.es Servei dEstadstica UAB

También podría gustarte

- Resumen Mecánica de Fluidos PDFDocumento11 páginasResumen Mecánica de Fluidos PDFNathalyVargas29Aún no hay calificaciones

- Fluidos Newtonianos y No NewtonianosDocumento2 páginasFluidos Newtonianos y No NewtonianosNathalyVargas29Aún no hay calificaciones

- Cinética QuímicaDocumento8 páginasCinética QuímicaNathalyVargas29Aún no hay calificaciones

- Condición de ColinealidadDocumento24 páginasCondición de ColinealidadNathalyVargas29Aún no hay calificaciones

- Geometria Analítica - Hugo Iñiguez PDFDocumento313 páginasGeometria Analítica - Hugo Iñiguez PDFNathalyVargas2990% (10)

- Legitimación de MensajesDocumento5 páginasLegitimación de MensajesNathalyVargas2950% (8)

- Concepto de CienciaDocumento3 páginasConcepto de CienciaLiz RinconAún no hay calificaciones

- El Pasado, Presente y Futuro de La Politica Comparada - Un SimposioDocumento2 páginasEl Pasado, Presente y Futuro de La Politica Comparada - Un Simposiofrida100% (1)

- Investigacion Perfil Cognitivo y Metacognitivo.Documento140 páginasInvestigacion Perfil Cognitivo y Metacognitivo.mariabelencapitanAún no hay calificaciones

- DiapositivaDocumento15 páginasDiapositivaalejandra doradoAún no hay calificaciones

- Ruben Pardo Verdad e Historicidad El Conocimiento Cinetiico y Sus FracturasDocumento5 páginasRuben Pardo Verdad e Historicidad El Conocimiento Cinetiico y Sus FracturasMailen Mastrandrea100% (1)

- Taxonomía Bloom Adaptada Anderson-KrathwohlDocumento1 páginaTaxonomía Bloom Adaptada Anderson-KrathwohlKarlaHerreraJorqueraAún no hay calificaciones

- Formato para La Evaluación Artículos CientificosDocumento5 páginasFormato para La Evaluación Artículos CientificosAndrea CarrilloAún no hay calificaciones

- Que Es El IntuicionismoDocumento11 páginasQue Es El IntuicionismoJuan Camilo LouridoAún no hay calificaciones

- Monografía Acerca de Metodología de La Investigación PDFDocumento31 páginasMonografía Acerca de Metodología de La Investigación PDFOsvaldo Baez Bezama100% (2)

- Tema 1unidad Los Estudios de Ciencia Tecnología y SociedadDocumento9 páginasTema 1unidad Los Estudios de Ciencia Tecnología y SociedadgilbertobetancurAún no hay calificaciones

- La Interpretación de CopenhagueDocumento6 páginasLa Interpretación de CopenhaguemiguelsiondinoAún no hay calificaciones

- Noam ChomskyDocumento3 páginasNoam ChomskyJOSUE FRANCISCO ROJAS MORALESAún no hay calificaciones

- Dimensiones de La Investigación y Métodos GeneralesDocumento6 páginasDimensiones de La Investigación y Métodos GeneralesLuis DuarteAún no hay calificaciones

- Metodología de La Investigación: El Problema Debe Expresar Una Relación Entre Variables o Conceptos (DosDocumento4 páginasMetodología de La Investigación: El Problema Debe Expresar Una Relación Entre Variables o Conceptos (DosRenso Fernando Gutierrez OjedaAún no hay calificaciones

- Investigacion Formativa 2Documento6 páginasInvestigacion Formativa 2Juana Zabala OrtizAún no hay calificaciones

- Teorìas y Corrientes PedagògicasDocumento24 páginasTeorìas y Corrientes PedagògicasJesús GalvanAún no hay calificaciones

- Mapa Conceptual Word ExplicativoDocumento14 páginasMapa Conceptual Word ExplicativoNana RivasAún no hay calificaciones

- Seminario de Diseño de ProyectosDocumento155 páginasSeminario de Diseño de ProyectosEricka TrejoAún no hay calificaciones

- Diapositivas Positivismo Comte Primera ClaseDocumento28 páginasDiapositivas Positivismo Comte Primera ClaseSaray Manjarrez MelendezAún no hay calificaciones

- Resumen Capitulos DO French y Bell.Documento17 páginasResumen Capitulos DO French y Bell.Sarahi Garcia Traslosheros33% (3)

- Análisis HolisticoDocumento4 páginasAnálisis Holisticodavidcuevas178100% (1)

- Bases Conceptuales Bioestadisticaz PDFDocumento1 páginaBases Conceptuales Bioestadisticaz PDFMarizabel ClarosAún no hay calificaciones

- Dialnet LaHistoriaDeLaCienciaComoRecursoDidacticoEnFisicaY 4193622Documento22 páginasDialnet LaHistoriaDeLaCienciaComoRecursoDidacticoEnFisicaY 4193622GisellaPuentesAún no hay calificaciones

- Reumen MetodologiaDocumento8 páginasReumen MetodologiaJessanen Claribeth BenitesAún no hay calificaciones

- La Ciencia Conceptos BasicosDocumento5 páginasLa Ciencia Conceptos BasicosMj Sanabria100% (1)

- Resumen Sobre La Comprensión Epistemológica de La PsicopedagogíaDocumento6 páginasResumen Sobre La Comprensión Epistemológica de La PsicopedagogíaGabriela Mata50% (2)

- Ensayo de Las Corrientes Filosóficas Del Racionalismo y Empirismo 21 MarzoDocumento7 páginasEnsayo de Las Corrientes Filosóficas Del Racionalismo y Empirismo 21 Marzoantonio navaAún no hay calificaciones

- Notas para Corazonar El Diario de CampoDocumento2 páginasNotas para Corazonar El Diario de CampoOmar EskolaAún no hay calificaciones

- DiapositivaDocumento19 páginasDiapositivaRossanna MorelAún no hay calificaciones

- Aprendizaje SituadoDocumento4 páginasAprendizaje SituadoMaryMtzAún no hay calificaciones