Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Regresión Lineal

Regresión Lineal

Cargado por

Yadira LlumiquingaDescripción original:

Título original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Regresión Lineal

Regresión Lineal

Cargado por

Yadira LlumiquingaCopyright:

Formatos disponibles

Introducción métodos de Machine Learning Supervisado

Regresión Lineal

Andrea Canals

Magister en Bioestadística

ESCUELA INTERNACIONAL DE VERANO 2021

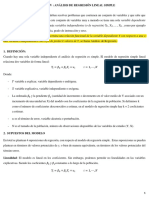

Regresión Lineal Simple

▪ Se asume que existe una relación lineal entre una variable

predictora X y una variable respuesta Y.

▪ El coeficiente 𝛽0 corresponde al intercepto y 𝛽1 a la pendiente de

la recta.

▪ Una vez que se hayan estimado los coeficientes del modelo con

la base de datos de entrenamiento, se pueden obtener los

valores predichos de Y.

ESCUELA INTERNACIONAL DE VERANO 2021

Estimación de los coeficientes

▪ Método de mínimos cuadrados

ESCUELA INTERNACIONAL DE VERANO 2021

Estimación de los coeficientes

▪ Método de mínimos cuadrados

Se buscan los valores de 𝛽0 y 𝛽1 que minimicen la Suma de

Cuadrados del Error (SCE o RSS, en inglés).

Con 𝑒𝑖 = 𝑦𝑖 − 𝑦ෝ𝑖 = 𝑦𝑖 − (𝛽0 + 𝛽1 𝑥𝑖 ) (residuos).

ESCUELA INTERNACIONAL DE VERANO 2021

Supuestos

1. Existencia: Para cada valor fijo de X, Y tiene cierta distribución con

media μY/X y varianza σ2Y/X

2. Independencia: Los valores de Y son independientes unos de otros.

Los errores aleatorios también.

3. Linealidad: La media de Y (μY/X) es una función lineal de X.

4. Homocedasticidad: La varianza de Y es la misma para cada valor de

X. σ2Y/X = σ2

5. Normalidad: Para cada valor de X, Y tiene distribución normal.

Y/X~N(μY/X,σ2)

εi~N(0,σ2)

FACULTAD DE MEDICINA UNIVERSIDAD DE CHILE

Inferencia sobre los coeficientes

Modelo:

Intervalos de confianza:

Estimación de 𝜎 2 :

Cuadrados Medios del Error (CME o RSS, en inglés)=SCE/(n-2)

Estimación de 𝜎 : Error Estándar Residual (RSE)

ESCUELA INTERNACIONAL DE VERANO 2021

Inferencia sobre los coeficientes

Test de hipótesis para 𝛽1

Estadístico:

cuya distribución es T de Student con (n-2) grados de libertad.

ESCUELA INTERNACIONAL DE VERANO 2021

Inferencia sobre los coeficientes

ESCUELA INTERNACIONAL DE VERANO 2021

Ajuste del Modelo

▪ Error Estándar Residual(RSE)

▪ R2

▪ Estadístico F

ESCUELA INTERNACIONAL DE VERANO 2021

Regresión Lineal Múltiple

▪ Modelo:

▪ Estimación coeficientes:

▪ Estadístico F:

ESCUELA INTERNACIONAL DE VERANO 2021

Variables dummy

▪ Cuando una de las variables predictoras corresponde a una

variable categórica, se utilizan variables que usualmente

toman los valores 0 y 1.

▪ Si la variable tiene k categorías, en el modelo se incluyen

(k-1) variables dummy.

▪ Ejemplo:

ESCUELA INTERNACIONAL DE VERANO 2021

Variables dummy

▪ Ejemplo:

ESCUELA INTERNACIONAL DE VERANO 2021

Extensiones del modelo de regresión lineal

Al ajustar un modelo de regresión lineal se asume que la relación entre

X e Y es lineal y aditiva.

• Lineal: el cambio en Y por cada unidad de aumento en X es siempre

el mismo.

• Aditiva: el efecto de uno de los predictores en Y, es independiente de

los valores del resto de las variables predictoras.

ESCUELA INTERNACIONAL DE VERANO 2021

Extensiones del modelo de regresión lineal

Eliminación supuesto de aditividad

Para permitir un efecto multiplicativo podemos incorporar variables de

interacción al modelo, las que se construyen como el producto entre

dos variables predictoras.

Ejemplo:

con

* con este cambio permitimos que el efecto de X1 en Y, varíe

dependiendo del valor de X2.

ESCUELA INTERNACIONAL DE VERANO 2021

Extensiones del modelo de regresión lineal

Eliminación supuesto de aditividad

ESCUELA INTERNACIONAL DE VERANO 2021

Extensiones del modelo de regresión lineal

Eliminación supuesto de aditividad

ESCUELA INTERNACIONAL DE VERANO 2021

Extensiones del modelo de regresión lineal

Relaciones no lineales

Para permitir relaciones no lineales podemos realizar una regresión

polinomial.

ESCUELA INTERNACIONAL DE VERANO 2021

Potenciales problemas

▪ No linealidad en la relación entre X e Y

▪ Errores correlacionados

▪ Heterocedasticidad (varianza de los errores no constante)

▪ Outliers (valores extremos)

▪ Valores influyentes (alto “leverage”)

▪ Colinealidad

ESCUELA INTERNACIONAL DE VERANO 2021

No linealidad

• Si la relación entre las variables predictoras e Y es realmente

lineal, al graficar la relación entre los residuos y cada variable

predictora (o entre los residuos y los valores predichos de Y), no

se debiera observar ningún patrón.

• Posibles solución: realizar transformaciones a la variable

predictora (log 𝑋 , 𝑋 2 , 𝑋).

ESCUELA INTERNACIONAL DE VERANO 2021

Errores correlacionados

• Esto se puede observar en datos correspondientes a series de

tiempo, y se puede detectar graficando los valores de los

residuos en función del tiempo.

• Si existe correlación entre los residuos, residuos adyacentes

tendrán valores similares.

• También se puede observar al seleccionar individuos que sean

familiares, o que compartan ciertas variables que pudiesen incidir

en la relación que se está estudiando.

ESCUELA INTERNACIONAL DE VERANO 2021

Errores correlacionados

ESCUELA INTERNACIONAL DE VERANO 2021

Heterocedasticidad

▪ Si existe homocedasticidad, al graficar los residuos versus los

valores predichos, la variabilidad de los errores debiera ser similar

para distintos valores de 𝑦.

ො

▪ Posible solución: transformar la variable respuesta Y: log 𝑌 , 𝑌

▪ Posible solución: método de mínimos cuadrados ponderados.

ESCUELA INTERNACIONAL DE VERANO 2021

Heterocedasticidad

ESCUELA INTERNACIONAL DE VERANO 2021

Outliers

▪ Un outlier corresponde a una observación cuyo valor predicho se

aleja mucho de su valor real.

▪ Pueden deberse a errores de registro, o ser valores reales.

▪ Pueden afectar al modelo estimado y al valor de RSE.

Modelo con outlier: RSE=1,09, R2=80,5%

Modelo sin outlier: RSE=0,77, R2=89,2%

ESCUELA INTERNACIONAL DE VERANO 2021

Valores influyentes

▪ Son observaciones con valores inusuales de X.

▪ Se pueden detectar fácilmente en el caso de una regresión lineal

simple, pero para una regresión lineal múltiple es más complejo.

▪ Estadístico “leverage”

Si hi>(p+1)/n se considera valor influyente.

ESCUELA INTERNACIONAL DE VERANO 2021

Valores influyentes

ESCUELA INTERNACIONAL DE VERANO 2021

Colinealidad

▪ Se produce cuando las variables predictores se encuentran

relacionadas entre sí.

▪ Reduce la precisión de las estimaciones debido al aumento en los

errores estándar de los coeficientes.

▪ Se puede detectar observando la matriz de correlaciones entre

las variables predictoras.

▪ Factor de Inflación de la Varianza (VIF)

𝑅𝑋2𝑗/𝑋𝑗−1 corresponde al R2 de la regresión de Xj en función del

resto de los predictores.

Si 𝑅𝑋2𝑗 /𝑋𝑗−1 es cercano a 1, VIF tomará valores altos.

ESCUELA INTERNACIONAL DE VERANO 2021

Colinealidad

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

▪ Regresión lineal:

o Método paramétrico

o Pocos parámetros a estimar

o Fácil de interpretar

o Muchos supuestos

▪ Regresión KNN:

o Método no paramétrico (mayor flexibilidad)

o Dado un valor de K y una observación de prueba x0, detecta las K

observaciones de entrenamiento más próximas de x0, representado por N0.

o Estima f(x0) como el promedio de todos los valores de Y de las observaciones

que pertenecen a N0.

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

ESCUELA INTERNACIONAL DE VERANO 2021

Comparación Regresión Lineal y KNN

▪ Métodos paramétricos superan a los no paramétricos, cuando

existen pocas observaciones por predictor.

▪ Si la relación entre X e Y es lineal (o cercana a la linealidad), la

regresión lineal tendrá menores errores que la regresión KNN.

▪ Cuando la relación entre X e Y se aleja de la linealidad, se

obtendrán menores errores con la regresión KNN.

ESCUELA INTERNACIONAL DE VERANO 2021

También podría gustarte

- Estadistica InvestigaciónDocumento10 páginasEstadistica InvestigaciónLynda HernandezAún no hay calificaciones

- Cuestionario 2Documento15 páginasCuestionario 2ana lizette lombrañaAún no hay calificaciones

- Cuestionario 2Documento15 páginasCuestionario 2ana lizette lombraña100% (1)

- Deber ValidacionDocumento4 páginasDeber ValidacionLukas GalarzaAún no hay calificaciones

- Temas de RegresionDocumento18 páginasTemas de RegresionDANIEL GARCIAAún no hay calificaciones

- Apuntes Examen - Econometría IDocumento15 páginasApuntes Examen - Econometría IBrandon NuñezAún no hay calificaciones

- Regresion RidgeDocumento31 páginasRegresion RidgeJalil BarriosAún no hay calificaciones

- Tema 5 Regresion Lineal SimpleDocumento28 páginasTema 5 Regresion Lineal SimpleAbelardo GarciaAún no hay calificaciones

- Introduc Estadistica Tema5Documento53 páginasIntroduc Estadistica Tema5Manuel RodríguezAún no hay calificaciones

- Regresión LinealDocumento62 páginasRegresión LinealConstanza Vásquez Nettig100% (1)

- Regresiòn Lineal 3Documento12 páginasRegresiòn Lineal 3Grittsell Fabiola Trujillo DavilaAún no hay calificaciones

- Semana 6Documento36 páginasSemana 6Edwin Johny Asnate SalazarAún no hay calificaciones

- Presentacion1 de Estadistica PDFDocumento33 páginasPresentacion1 de Estadistica PDFjensy MataAún no hay calificaciones

- 6 Regresión Lineal PDFDocumento102 páginas6 Regresión Lineal PDFJose David Jiménez TolozaAún no hay calificaciones

- Cuest 1 Estinf 2 IngindDocumento5 páginasCuest 1 Estinf 2 IngindJuan Raymundo Lopez VazquezAún no hay calificaciones

- II. Analisis de Regresión y CorrelaciónDocumento55 páginasII. Analisis de Regresión y CorrelaciónHember Monroy Bermudez100% (2)

- El Problema de La MulticolinealidadDocumento16 páginasEl Problema de La MulticolinealidadRamiroVergaraAún no hay calificaciones

- Trabajo Grupal - Alex Haro - David Vega - Regresion Lineal Simple - Regresion Lineal Simple - Probabilidad y Estadistica Basica - GR3Documento8 páginasTrabajo Grupal - Alex Haro - David Vega - Regresion Lineal Simple - Regresion Lineal Simple - Probabilidad y Estadistica Basica - GR3Alex HaroAún no hay calificaciones

- Estad P Adm 5Documento26 páginasEstad P Adm 5josemaslashAún no hay calificaciones

- Manual de Clases para El EstudianteDocumento97 páginasManual de Clases para El EstudianteClinton BrowningAún no hay calificaciones

- Uni-Estadistica-Ciclo 4Documento13 páginasUni-Estadistica-Ciclo 4Fernando Garcia TupesAún no hay calificaciones

- Doc. Apoyo 3. Modelos de Regresión y Sus Aplicaciones..Documento52 páginasDoc. Apoyo 3. Modelos de Regresión y Sus Aplicaciones..Diana LapoAún no hay calificaciones

- Unidad I Regresion Lineal Simple y CorrelacionDocumento8 páginasUnidad I Regresion Lineal Simple y CorrelacionBety TorMarAún no hay calificaciones

- Regresión Lineal SimpleDocumento42 páginasRegresión Lineal SimpleYoselin Dayana Banegas HumireAún no hay calificaciones

- El Consumo Maximo de Oxigeno Es Uno de Los Indicadores Mas ImportantesDocumento18 páginasEl Consumo Maximo de Oxigeno Es Uno de Los Indicadores Mas ImportantesGabriel HiAún no hay calificaciones

- Análisis de RegresiónDocumento6 páginasAnálisis de RegresiónMARLON CATAGUAAún no hay calificaciones

- RL Simple MultipleDocumento29 páginasRL Simple MultipleOmar Santiago CruzAún no hay calificaciones

- Cap V Análisis de Regresión Lineal SimpleDocumento23 páginasCap V Análisis de Regresión Lineal SimpleAnonymous lmo7YKd3Aún no hay calificaciones

- Power de Correlacià N y Regresià NDocumento36 páginasPower de Correlacià N y Regresià NValenn GalloAún no hay calificaciones

- Unidad III, MaterialDocumento10 páginasUnidad III, MaterialAntonela Lía Pajares RuizAún no hay calificaciones

- Cap 1-Introduccion A La Regresion PDFDocumento24 páginasCap 1-Introduccion A La Regresion PDFYanina MonasterioAún no hay calificaciones

- Ma470 202102 Cuaderno de Trabajo Unidad VDocumento17 páginasMa470 202102 Cuaderno de Trabajo Unidad VJessica CardenasAún no hay calificaciones

- Regresión Lineal Simple, de Las Páginas 360 A La 366Documento7 páginasRegresión Lineal Simple, de Las Páginas 360 A La 366Ernesto RamírezAún no hay calificaciones

- PinquilladaDocumento20 páginasPinquilladaRicardo Toure Ayala100% (1)

- Trabajo en Grupo - Alex Haro - David Vega - Probabilidad y Estadistica Basica - GR3Documento5 páginasTrabajo en Grupo - Alex Haro - David Vega - Probabilidad y Estadistica Basica - GR3Alex HaroAún no hay calificaciones

- 09-13-2019 221602 PM SESION 11Documento12 páginas09-13-2019 221602 PM SESION 11Hilber SifuentesAún no hay calificaciones

- Regresion Lineal (Econometria)Documento9 páginasRegresion Lineal (Econometria)Alexandra GonzalezAún no hay calificaciones

- 4.mínimos Cuadrados OrdinariosDocumento66 páginas4.mínimos Cuadrados Ordinariosmaricelly.rincon.pAún no hay calificaciones

- S015.s1 Material - Regresion y Correlacion PDFDocumento26 páginasS015.s1 Material - Regresion y Correlacion PDFCielo Milagros Allende EspinolaAún no hay calificaciones

- Unidad 1. Regresión Lineal SimpleDocumento7 páginasUnidad 1. Regresión Lineal SimpleleticiaAún no hay calificaciones

- CorrelaciónDocumento4 páginasCorrelaciónGiancarlo PadoanAún no hay calificaciones

- Fase 2 - Andrea GaleanoDocumento19 páginasFase 2 - Andrea GaleanoAndrea GaleanoAún no hay calificaciones

- Actividad 4 EstadisticaDocumento11 páginasActividad 4 EstadisticaYatziri TenorioAún no hay calificaciones

- La Regresión Lineal Simple Se Aplica en Aquellas InvestigaciDocumento8 páginasLa Regresión Lineal Simple Se Aplica en Aquellas InvestigaciAnabel HiraldoAún no hay calificaciones

- Análisis de Regresión y Correlación 2023Documento16 páginasAnálisis de Regresión y Correlación 2023Tuesta Merma Alisson Brisa NicoleAún no hay calificaciones

- Regresión LinealDocumento18 páginasRegresión LinealRonaldo Rojas MelgarejoAún no hay calificaciones

- Analisis MultivariadoDocumento25 páginasAnalisis MultivariadoCarlos Leal ContrerasAún no hay calificaciones

- DiapositivasRegresionLogistica (Samuel Educacion2024)Documento42 páginasDiapositivasRegresionLogistica (Samuel Educacion2024)mcuevaAún no hay calificaciones

- Tema 4 y 5Documento15 páginasTema 4 y 5Anna Redondo AlgobiaAún no hay calificaciones

- MatemáticaDocumento13 páginasMatemáticaJOHAMBEL ROLANDO SALAS DIEGOAún no hay calificaciones

- Regresión Lineal MultipleDocumento14 páginasRegresión Lineal Multiplelisseth dominguezAún no hay calificaciones

- Cap 4-5 MetodosDocumento10 páginasCap 4-5 MetodosYazmin ElizondoAún no hay calificaciones

- Practica N 3 Pronosticos PDFDocumento10 páginasPractica N 3 Pronosticos PDFedmundo herreraAún no hay calificaciones

- Maria Losada Paso 4 Descripción de La Información.Documento13 páginasMaria Losada Paso 4 Descripción de La Información.Carla MantillaAún no hay calificaciones

- Autocorrelación y Homocedasticidad Noviembre 2021Documento65 páginasAutocorrelación y Homocedasticidad Noviembre 2021Alan GonzálezAún no hay calificaciones

- Ema5. Diagnosis y Validación Del Modelo de Regresión Lineal MúltiplepdfDocumento28 páginasEma5. Diagnosis y Validación Del Modelo de Regresión Lineal MúltiplepdfEliana MendozaAún no hay calificaciones

- Regresión Lineal Simple: PredecirDocumento18 páginasRegresión Lineal Simple: PredecirAngel Evaristo Flores RamírezAún no hay calificaciones

- Regresión Lineal Múltiple, PronósticosDocumento56 páginasRegresión Lineal Múltiple, PronósticosJefferson Abarca80% (5)

- Regresión LinealDocumento18 páginasRegresión LinealErvin De La Cruz BaldeonAún no hay calificaciones

- Ejercicio Precipitacion Media Junio 2020Documento1 páginaEjercicio Precipitacion Media Junio 2020Yadira LlumiquingaAún no hay calificaciones

- Hds - Cloroformo Kit 3857, 3857-035Documento8 páginasHds - Cloroformo Kit 3857, 3857-035Yadira LlumiquingaAún no hay calificaciones

- Articulo - Calidad de Agua e IdentificaciónDocumento12 páginasArticulo - Calidad de Agua e IdentificaciónYadira LlumiquingaAún no hay calificaciones

- 1 Company Questionary Part 5Documento7 páginas1 Company Questionary Part 5Yadira LlumiquingaAún no hay calificaciones

- Precipitaciones 24 Horas Rio Malatus AaDocumento7 páginasPrecipitaciones 24 Horas Rio Malatus AaYadira LlumiquingaAún no hay calificaciones

- Proced I Mi EtnosDocumento3 páginasProced I Mi EtnosYadira LlumiquingaAún no hay calificaciones

- VIERNESMJDocumento3 páginasVIERNESMJYadira LlumiquingaAún no hay calificaciones

- GeoideDocumento13 páginasGeoideYadira Llumiquinga100% (1)

- Descripcion Actividad G5Documento4 páginasDescripcion Actividad G5Yadira LlumiquingaAún no hay calificaciones

- Planificación Semana 4 4to ADocumento7 páginasPlanificación Semana 4 4to AYadira LlumiquingaAún no hay calificaciones

- Planificacion de Actividades Semana 3 y 4 Cuartos GradosDocumento5 páginasPlanificacion de Actividades Semana 3 y 4 Cuartos GradosYadira LlumiquingaAún no hay calificaciones

- Ejercicio de AnalisisDocumento4 páginasEjercicio de AnalisisLILIANA HERRERA100% (2)

- GUIA2QUIM11Documento6 páginasGUIA2QUIM11LalitaMezaAún no hay calificaciones

- Norma Tecnica Ecuatoriana NTE INEN 2 207 - 2002 PDFDocumento9 páginasNorma Tecnica Ecuatoriana NTE INEN 2 207 - 2002 PDFJefferson M. MoralesAún no hay calificaciones

- Resumen BDIDocumento2 páginasResumen BDICarlos AlfonzoAún no hay calificaciones

- Informe Carga y DescargaDocumento8 páginasInforme Carga y DescargaSilvana RinconAún no hay calificaciones

- Tema 01 - Raz Trig de Ángulos de Cualquier MagnitudDocumento4 páginasTema 01 - Raz Trig de Ángulos de Cualquier MagnitudandersonAún no hay calificaciones

- Hugo - Jorge - Gutierrez - Choque-Laboratorio 2Documento9 páginasHugo - Jorge - Gutierrez - Choque-Laboratorio 2Hugo Jorge Gutierrez ChoqueAún no hay calificaciones

- Laboratorio N 6Documento12 páginasLaboratorio N 6Luis Angel Quispe MachacaAún no hay calificaciones

- Lab. Ope SecadoDocumento7 páginasLab. Ope SecadoMilagrosAún no hay calificaciones

- Diseño y Simulación de Una Maquina Automatizada Alimentadora de CaolínDocumento143 páginasDiseño y Simulación de Una Maquina Automatizada Alimentadora de CaolínInvedeAún no hay calificaciones

- Registro Anecdótico Prof. GuíasDocumento5 páginasRegistro Anecdótico Prof. GuíasVice Presidente SánchezAún no hay calificaciones

- SCK 16 40 Instrucciones PDFDocumento26 páginasSCK 16 40 Instrucciones PDFsebastian100% (1)

- Grupo de Cold TestDocumento7 páginasGrupo de Cold Testnorma olaechea barrientosAún no hay calificaciones

- Sap 2000 PropiedadesDocumento5 páginasSap 2000 Propiedadesusa2010xdAún no hay calificaciones

- Plantación PrimariaDocumento12 páginasPlantación PrimariaGABRIEL CENTENOAún no hay calificaciones

- Lavadores VenturiDocumento13 páginasLavadores Venturiarchivos_cidcpAún no hay calificaciones

- Cálculo Del Momento EléctricoDocumento17 páginasCálculo Del Momento EléctricoNadia BarahonaAún no hay calificaciones

- Evaluacion Inicial Matematicas 3º PrimariaDocumento24 páginasEvaluacion Inicial Matematicas 3º PrimariaJuan Novo PhigaroAún no hay calificaciones

- Elementos de La GeometríaDocumento1 páginaElementos de La GeometríaRyan LopezAún no hay calificaciones

- LAQUA1000 CatálogoDocumento16 páginasLAQUA1000 CatálogomiltonerazoalvAún no hay calificaciones

- 12.1. Analisis de ConsistenciaDocumento15 páginas12.1. Analisis de ConsistenciaMauricio Minaya SilveraAún no hay calificaciones

- Resumen Sobre Ecuaciones 12moDocumento72 páginasResumen Sobre Ecuaciones 12moErick LegratAún no hay calificaciones

- Código de BarrasDocumento9 páginasCódigo de BarrasRonaldo LitumaAún no hay calificaciones

- Solorzano Salvador Carlos Jaime Pool - Tarea N°1Documento8 páginasSolorzano Salvador Carlos Jaime Pool - Tarea N°1Dcorazon SinapeAún no hay calificaciones

- S09.s2 - MaterialDocumento23 páginasS09.s2 - Materialnathaly nicol ramirez garciaAún no hay calificaciones

- Candy - Carrasco - Tarea - 3Documento5 páginasCandy - Carrasco - Tarea - 3sandra carrascoAún no hay calificaciones

- Examen Ito XDDocumento16 páginasExamen Ito XDFelipe Ortiz DiazAún no hay calificaciones

- Control Clásico Vs Control ModernoDocumento15 páginasControl Clásico Vs Control ModernoJorgeValdz100% (2)

- CTOSCOMBINATORIOSDocumento7 páginasCTOSCOMBINATORIOSIsc Edgar EduardoAún no hay calificaciones

- 1400 Matematicas IVDocumento88 páginas1400 Matematicas IVLuis Enrique Ramirez Ferrer75% (4)