Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Perceptron Multinivel (MLP)

Cargado por

Herney PalaciosTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Perceptron Multinivel (MLP)

Cargado por

Herney PalaciosCopyright:

Formatos disponibles

Rede Neuronales Artificiales

Perceptron Multinivel MLP

Profesor:

Eduardo Caicedo Bravo Ph.D.

ecaicedo@univalle.edu.co

Contenido

Introduccin

Arquitectura

Notacin

Algoritmo de Entrenamiento

Consideraciones Prcticas

Introduccin

Limitaciones del Perceptron de Rosenblatt

Perceptrons [Misky y Papert]

Solucin de Ronsenblatt: Incluir una capa de neuronas

entre las capas de entrada y salida

Pero cul fue la mayor dificultad para poner en

prctica la nueva propuesta?

cmo calcular el error de la capa intermedia para

modificar los pesos sinpticos de esta nueva capa,

que llamaremos capa oculta?

Al mediados de la dcada de los setenta, Paul

Werbos en su tesis doctoral propone el Algoritmo

Backpropagation, que permite entrenar al

perceptron multicapa y posibilita su aplicacin en la

solucin de una gran variedad de problemas de alta

complejidad

Arquitectura Propuesta

1 k M

1 j L

1 i N

x

p1

x

pi

x

pN

o

p1

o

pk

o

pM

1

Principio de Funcionamiento

1 k M

1 j L

1 i N

x

p1

x

pi

x

pN

o

p1

o

pk

o

pM

1

1. Red aprende un conjunto de aprendizaje

x=[x

1

x

2

. x

P

]

y=[y

1

y

2

. y

P

]

2. Si se aplica un estmulo x

1

se propaga una

seal PARALELA hacia las capas superiores

3. La seal de salida se compara con una salida

deseada y se calcula un error para cada salida

4. Las seales de error se transmiten hacia atrs

partiendo desde la salida hacia capas

intermedias

5. Este proceso hacia atrs se repite capa por

capa hasta que todos los nodos de la red hayan

recibido una seal de error que describa su

contribucin relativa al error total

6. Con base en la seal de error percibida se

actualizan los pesos de conexin de cada unidad

7. Despus del entrenamiento:

Generalizacin

Inhibicin ante tramas desconocidas

Aprendizaje: Regla Delta

Generalizada

1 k M

1 j L

1 i N

x

p1

x

pi

x

pN

o

p1

o

pk

o

pM

1

Conformada por capas con propagacin hacia

delante

Red interconectada totalmente entre capas

Relacin funcional Entrada - Salida

y = (x)

x

p

Patrn o vector de entrada

x

pi

Entrada i-sima del vector de entrada x

p

N Nmero de neuronas de la capa de entrada

Dimensin del vector de entrada

P Nmero de vectores de entradas diferentes

P ejemplos de parejas [x,y]

L Nmero de neuronas de la capa oculta h

M Nmero de neuronas de la capa de salida

Dimensin del vector de salida

Aprendizaje: Regla Delta

Generalizada

1 k M

1 j L

1 i N

x

p1

x

pi

x

pN

o

p1

o

pk

o

pM

1

oculta capa la de sima - j la con entrada de

sima - i neurona la entre conexin de Peso

h

ji

w

oculta capa la de tendencia de Trmino

h

j

u

oculta unidad sima - j la de neta Entrada

h

pj

neta

oculta unidad sima - j la de Salida

pj

i

oculta unidad

sima - j la de activacin de Funcin

h

j

f

Aprendizaje: Regla Delta

Generalizada

1 k M

1 j L

1 i N

x

p1

x

pi

x

pN

o

p1

o

pk

o

pM

1

oculta capa la de sima - j la con salida de

sima - k neurona la entre conexin de Peso

o

kj

w

salida de capa la de

unidad sima - k de tendencia de Trmino

o

k

u

salida de unidad

sima - k la de neta Entrada

o

pk

neta

salida de unidad sima - k la de Salida

pk

o

salida unidad

sima - k la de activacin de Funcin

o

k

f

Algoritmo Backpropagation

Consideraciones Prcticas

Experiencia mejor maestro

Conjunto de datos:

Entrenamiento

Validacin o parada anticipada

Test y verificacin

Introducir niveles de ruido en los datos

Generaliza bien (dificultades para extrapolar)

Distribuir el entrenamiento entre datos de

diferentes clases

Si se entrena una red con una clase de datos y se

pasa a otra clase, la red olvidar el entrenamiento

original

1. Datos de Entrenamiento:

Consideraciones Prcticas

1. Dimensin de la Red:

Cuantas neuronas elegir?

Entrada

Salida

Capa Oculta

Son suficientes tres capas?

Entre ms capas la red tiene mayor capacidad de

discernir

Dificultades en la implementacin

Ejemplo compresin de datos (64 b - 16b - 64b)

Tratar de utilizar el menor nmero de unidades

en la capa oculta

Eliminar unidades ocultas superfluas

Consideraciones Prcticas

1. Dimensin de la Red:

Valores pequeos [0,1], [-1, -1]

Inicializacin aleatoria distribucin Gaussiana o ruido

blanco [0.5] [-0.5, 0.5]

o: Velocidad de aprendizaje, es fundamental su

eleccin

alfa pequeo alto nmero de iteraciones

alfa grande puede generar oscilaciones en el

aprendizaje

Es posible modificar alfa en el proceso de aprendizaje?

APRENDIZAJE CON o ADAPTATIVO

Convergencia a mnimos locales?

Momentum q : Tcnica para incrementar la velocidad

de convergencia

( ) ( ) ( ) 1 1 A + + = + t w i t w t w

o

kj p pj

o

pk

o

kj

o

kj

q oo

PREGUNTAS???

También podría gustarte

- Python Deep Learning: Introducción práctica con Keras y TensorFlow 2De EverandPython Deep Learning: Introducción práctica con Keras y TensorFlow 2Calificación: 3.5 de 5 estrellas3.5/5 (5)

- Sesion Redes Neuronales v3Documento46 páginasSesion Redes Neuronales v3WILLIAM MARTIN GUTIERREZ SAN MIGUELAún no hay calificaciones

- Perceptronparte2 120718194301 Phpapp02 PDFDocumento25 páginasPerceptronparte2 120718194301 Phpapp02 PDFJesus Romero MirandaAún no hay calificaciones

- Sesion Redes V4Documento22 páginasSesion Redes V4Carlos EstelaAún no hay calificaciones

- 07MBID Transparencias - 6 Redes NeuronalesDocumento43 páginas07MBID Transparencias - 6 Redes Neuronaleskevin_1234Aún no hay calificaciones

- Presentacion Redes NeuronalesDocumento33 páginasPresentacion Redes NeuronalesEddy Paz TiconaAún no hay calificaciones

- S05.s2 - Redes Neuronales y Lógica DifusaDocumento29 páginasS05.s2 - Redes Neuronales y Lógica DifusaJonathan Gabriel Catari AlanocaAún no hay calificaciones

- Trabajo Mundo de WumpusDocumento40 páginasTrabajo Mundo de WumpusCarlos MezaAún no hay calificaciones

- HopfieldDocumento10 páginasHopfieldjumh9908Aún no hay calificaciones

- Aula MLPDocumento17 páginasAula MLPMarco CardenasAún no hay calificaciones

- Clase 9. Redes NeuronalesDocumento16 páginasClase 9. Redes NeuronalesMaria Edilma ParraAún no hay calificaciones

- Redes NeuronalesDocumento3 páginasRedes Neuronalesjonathan cuellar roblesAún no hay calificaciones

- Reporte de Laboratorio 2 - Redes NeuronalesDocumento7 páginasReporte de Laboratorio 2 - Redes NeuronalesEliseo Pillaca SichaAún no hay calificaciones

- Redes NeuronalesDocumento24 páginasRedes NeuronalesDarkrampageAún no hay calificaciones

- S05.s1 - Redes Neuronales y Lógica DifusaDocumento23 páginasS05.s1 - Redes Neuronales y Lógica DifusaJonathan Gabriel Catari AlanocaAún no hay calificaciones

- Clase8 Anal Discrim NoLineal RNADocumento41 páginasClase8 Anal Discrim NoLineal RNAAlex GomezAún no hay calificaciones

- 2 Practica Simulación Redes NeuronalesDocumento29 páginas2 Practica Simulación Redes NeuronalesauberAún no hay calificaciones

- Hard LimDocumento5 páginasHard LimYeCeci ChambaAún no hay calificaciones

- RetropropagacionDocumento7 páginasRetropropagacionRocioAún no hay calificaciones

- Proyecto de La Backpropagation PDFDocumento33 páginasProyecto de La Backpropagation PDFValerie CalaAún no hay calificaciones

- E18. RN FeedForwardDocumento38 páginasE18. RN FeedForwardYoansel Ruiz ChavezAún no hay calificaciones

- Informe FinalDocumento13 páginasInforme FinalDennisIncacutipaAún no hay calificaciones

- Aprendizaje Automático: Redes de Neuronas ArtificialesDocumento35 páginasAprendizaje Automático: Redes de Neuronas ArtificialesaokyAún no hay calificaciones

- Clase 1 - 7 Redes Neuronales Multicapa O Perceptrones MulticapaDocumento9 páginasClase 1 - 7 Redes Neuronales Multicapa O Perceptrones MulticapaRaul TicllacuriAún no hay calificaciones

- Redes Neuronales 2Documento38 páginasRedes Neuronales 2Luis Emilio Alvarez O.Aún no hay calificaciones

- Resumenes Machine Learning 5Documento5 páginasResumenes Machine Learning 5saradt.claseAún no hay calificaciones

- Redes NeuronalesDocumento30 páginasRedes NeuronalesIsabella VargasAún no hay calificaciones

- Propagación Hacia AtrásDocumento8 páginasPropagación Hacia AtrásJulio Chinchilla ValenzuelaAún no hay calificaciones

- Diapositiva 8Documento9 páginasDiapositiva 8GABRIEL EDUARDO DEL CARPIO VILLAFUERTEAún no hay calificaciones

- Redes NeuronalesDocumento37 páginasRedes Neuronalesalam chabAún no hay calificaciones

- Dia3 IntroMLDocumento33 páginasDia3 IntroMLjesus_larrazabal_salasAún no hay calificaciones

- Funcion-Hardlim y HardlimsDocumento7 páginasFuncion-Hardlim y HardlimsRonald RojasAún no hay calificaciones

- Redes Neuronales y Aplicaciones en IngenieríaDocumento67 páginasRedes Neuronales y Aplicaciones en IngenieríaEddy Caceres100% (1)

- S06.s1 - Redes Neuronales y Lógica DifusaDocumento26 páginasS06.s1 - Redes Neuronales y Lógica DifusaJonathan Gabriel Catari AlanocaAún no hay calificaciones

- Respuestas de Simulación de Una Neurona ArtificialDocumento6 páginasRespuestas de Simulación de Una Neurona Artificialdiego ivan perea montealegreAún no hay calificaciones

- Machine Learning - Redes Neuronales Convolucionales HerramientasDocumento20 páginasMachine Learning - Redes Neuronales Convolucionales HerramientasJuan Pablo ChambiAún no hay calificaciones

- Convolución Con CNNDocumento11 páginasConvolución Con CNNRubén Mendieta MelendezAún no hay calificaciones

- Informe Adeline Perceptron MulticapaDocumento13 páginasInforme Adeline Perceptron MulticapaJhoselyn Jara EspinozaAún no hay calificaciones

- S06.s01 - MaterialDocumento30 páginasS06.s01 - MaterialCesar Fabrissio Camacho MalquiAún no hay calificaciones

- Informe Redes MulticapaDocumento5 páginasInforme Redes MulticapaLucya LemaAún no hay calificaciones

- Cim 2000Documento30 páginasCim 2000Diego Alejandro Ledesma FloresAún no hay calificaciones

- Redes NeuronalesDocumento37 páginasRedes NeuronalesJonathan OrtizAún no hay calificaciones

- Clase10 - RedNeuronalDocumento33 páginasClase10 - RedNeuronalLukas JamesAún no hay calificaciones

- Redes Neuronales Grupo 3Documento66 páginasRedes Neuronales Grupo 3Galo Leonardo TrávezAún no hay calificaciones

- Presentacion Redes NeuronalesDocumento28 páginasPresentacion Redes NeuronalesJhon Quinteros MontañoAún no hay calificaciones

- Introducción A Las Redes NeuronalesDocumento16 páginasIntroducción A Las Redes Neuronalesjacastillo68Aún no hay calificaciones

- La Neurona ArtificialDocumento10 páginasLa Neurona ArtificialJairo BandaAún no hay calificaciones

- Guia 9Documento6 páginasGuia 9Code MakerAún no hay calificaciones

- Clase 8. Redes NeuronalesDocumento23 páginasClase 8. Redes NeuronalesMaria Edilma ParraAún no hay calificaciones

- Perceptro Multicapa 2019Documento16 páginasPerceptro Multicapa 2019Anonymous 1dVLJSVhtrAún no hay calificaciones

- ppt12 Perceptron Multicapa Cont PDFDocumento16 páginasppt12 Perceptron Multicapa Cont PDFAnonymous 1dVLJSVhtrAún no hay calificaciones

- Presentacion Perceptron MulticapaDocumento18 páginasPresentacion Perceptron MulticapaJair Vázquez PalmaAún no hay calificaciones

- Red Hopfield (Editado)Documento18 páginasRed Hopfield (Editado)sonia marcela duqueAún no hay calificaciones

- Redes NeuronalesDocumento2 páginasRedes NeuronalesИрвинг ГонсалесAún no hay calificaciones

- REDneuronalDocumento9 páginasREDneuronalEmy OlivasAún no hay calificaciones

- Guia 10Documento11 páginasGuia 10Code MakerAún no hay calificaciones

- Redes NeuronalesDocumento44 páginasRedes NeuronalesAldemar Hernandez100% (3)

- Perceptron Multicapa para Aproximación de SeñalesDocumento37 páginasPerceptron Multicapa para Aproximación de SeñalesAlejandro Hernandez100% (1)

- 100 Circuitos de Shields para MotoresDe Everand100 Circuitos de Shields para MotoresCalificación: 4.5 de 5 estrellas4.5/5 (4)

- Guias RNA 02Documento10 páginasGuias RNA 02luquitas214Aún no hay calificaciones

- Este EsDocumento2 páginasEste EsHerney PalaciosAún no hay calificaciones

- Guias RNA 01 (Lab1)Documento11 páginasGuias RNA 01 (Lab1)Herney PalaciosAún no hay calificaciones

- Guias RNA 01 (Lab1)Documento11 páginasGuias RNA 01 (Lab1)Herney PalaciosAún no hay calificaciones

- Reconocimiento de Voz en MatlabDocumento88 páginasReconocimiento de Voz en MatlabJennyfer Herrera AvilezAún no hay calificaciones

- Introduccion MatlabDocumento30 páginasIntroduccion MatlabAlvaro Andrés NavarroAún no hay calificaciones

- Perceptron Multinivel (MLP)Documento14 páginasPerceptron Multinivel (MLP)Herney PalaciosAún no hay calificaciones

- Eventos en HTMLDocumento2 páginasEventos en HTMLHerney PalaciosAún no hay calificaciones

- Problemas de Gestion TácticaDocumento2 páginasProblemas de Gestion TácticaPaul Lopez0% (4)

- Deber de Conjuntos 2Documento2 páginasDeber de Conjuntos 2Tyrone SanchezAún no hay calificaciones

- Manual de OptySystemDocumento18 páginasManual de OptySystemEynar LCAún no hay calificaciones

- Guia de Estudios Base de DatosDocumento6 páginasGuia de Estudios Base de DatosLuis Fernando Gonzalez GarciaAún no hay calificaciones

- Caso OracleDocumento8 páginasCaso OracleRobinson dominguez reyesAún no hay calificaciones

- Estadistica Aplicada A La Investigacion EducativaDocumento116 páginasEstadistica Aplicada A La Investigacion EducativaManuel Alejandro San MartinAún no hay calificaciones

- Introducción Al TecladoDocumento26 páginasIntroducción Al TecladoAnahis Cardenas0% (1)

- Sesion 01 SistemasDocumento115 páginasSesion 01 Sistemasxolar2002Aún no hay calificaciones

- Exc Bas Exa 01Documento5 páginasExc Bas Exa 01Pamela CastilloAún no hay calificaciones

- Plantilla para La Presentación Del Articulo CientificoDocumento11 páginasPlantilla para La Presentación Del Articulo CientificoJairo MojicaAún no hay calificaciones

- Tarea 1.1Documento4 páginasTarea 1.1juan megaAún no hay calificaciones

- CV Ronnie PerezDocumento4 páginasCV Ronnie PerezHector Mayhuay TarazonaAún no hay calificaciones

- Formas InternasDocumento4 páginasFormas InternasDaniel AlfonsoAún no hay calificaciones

- Aplicaciones de La Informática en El Trabajo de Oficina FinalDocumento70 páginasAplicaciones de La Informática en El Trabajo de Oficina FinalEddie September100% (1)

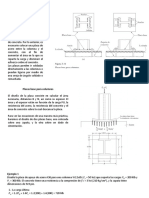

- Placas Base para Columnas PDFDocumento8 páginasPlacas Base para Columnas PDFr moralesAún no hay calificaciones

- TESISDocumento93 páginasTESISErick Osuna CanoAún no hay calificaciones

- TP PowerPointDocumento2 páginasTP PowerPointarnaldokissAún no hay calificaciones

- Auditoria de Sistemas. Seguridad Fisica y LogicaDocumento55 páginasAuditoria de Sistemas. Seguridad Fisica y LogicaErick RomeroAún no hay calificaciones

- Módulo 0504 Semestre 2021-2 Programación de Actividades PSICOLOGÍA TEÓRICA I NEEDocumento21 páginasMódulo 0504 Semestre 2021-2 Programación de Actividades PSICOLOGÍA TEÓRICA I NEEPaupau PaupauAún no hay calificaciones

- Evidencia de Conocimiento 3Documento4 páginasEvidencia de Conocimiento 3Ivänk Müñöz100% (2)

- Autoevaluación 3 - MARKETING DIGITAL (12539)Documento5 páginasAutoevaluación 3 - MARKETING DIGITAL (12539)Celia Stephany Urrutia LozanoAún no hay calificaciones

- Crear, Abrir y Cerrar Una Base de DatosDocumento2 páginasCrear, Abrir y Cerrar Una Base de DatosUsuario UsuarioAún no hay calificaciones

- Nuevas Guias de EjericiciosDocumento4 páginasNuevas Guias de EjericiciosGeovanny RAún no hay calificaciones

- Elect Dev Cir Capitulo 8.en - EsDocumento74 páginasElect Dev Cir Capitulo 8.en - EsJaime VargasAún no hay calificaciones

- MANUAL Pocket Doppler IFU PDFDocumento56 páginasMANUAL Pocket Doppler IFU PDFtomaAún no hay calificaciones

- Practica Ley de KirchoffDocumento14 páginasPractica Ley de KirchoffGabo M. Rivera100% (1)

- GT8 Herramientas, Materiales y Equipos - RedesDocumento7 páginasGT8 Herramientas, Materiales y Equipos - Redesjose Miguel -Aún no hay calificaciones

- Gjiogm 9876 FJBDFBDocumento4 páginasGjiogm 9876 FJBDFBJorgeLuisGuevaraMartinezAún no hay calificaciones

- Parcial 1-Eleaneth RosDocumento20 páginasParcial 1-Eleaneth RosCandelaria Eleaneth Ros EstebanAún no hay calificaciones

- Introducción A Los AlgoritmosDocumento44 páginasIntroducción A Los AlgoritmosAlejandro GarcésAún no hay calificaciones