Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Entropia en Canal Sin Ruido

Cargado por

Eduard Campoverde EncaladaTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Entropia en Canal Sin Ruido

Cargado por

Eduard Campoverde EncaladaCopyright:

Formatos disponibles

ENTROPA DE UN CANAL SIN RUIDO

Eduardo Israel Brito Vivanco

israedu_18@hotmail.com

Eduardo Luis Campoverde Encalada

eduarce_925@hotmail.com

Luis Gerardo Hidalgo Garca

luisgh9@hotmail.com

Mauricio Fernando Romn Rodrguez

mauriciofromanr@hotmial.com

RESUMEN: El presente trabajo tiene como objetivo

presentar una aplicacin de entropa utilizada para

comparar la cantidad de informacin mutua que se

obtiene en un canal sin ruido cuando las probabilidades

de la matriz de ingreso son independientes respecto de

una matriz con entradas equiprobables (Capacidad),

determinando as en donde existe menor redundancia y

mayor eficiencia.

PALABRAS CLAVE: Canal sin ruido, capacidad de un

canal, entropa a priori, entropa a posteriori, eficiencia

de un canal, informacin mutua, redundancia de un

canal.

1. INTRODUCCIN

2. CANALES DE INFORMACIN

Un canal de informacin viene determinado por un

alfabeto de entrada A={ai} donde i=1,2,3,4,...,r; un

alfabeto de salida B={bj} donde j=1,2,3,4,...,s; y un

conjunto de probabilidades condicionales prospectivas

P(bj/ai). P(bj/ai) es la probabilidad de recibir a la salida el

smbolo bj cuando se enva el smbolo ai [1].

Un canal de informacin est completamente

definido por su matriz de probabilidades prospectivas P

cuando la matriz de probabilidades tiene el siguiente

prototipo:

P(b2 /a1 )

P(b2 /a2 )

P(b2 /ar )

2.1. TEOREMA DE BAYES

El teorema de Bayes es empleado en los canales

de informacin para en base a las entradas, las salidas

y los elementos de la matriz de probabilidades

prospectivas poder obtener la matriz de probabilidades

retrospectivas del canal de informacin representado. El

enunciado del teorema de Bayes es el siguiente [2]:

P(ai /bj ) =

Como parte de la materia de Probabilidad y

Procesos Estocsticos el presente informe hace

mencin al tema de entropa aplicada a un canal sin

ruido con entradas tanto independientes como

equiprobables.

P(b1 /a1 )

P(b1 /a2 )

=[

P(b1 /ar )

El tamao de la matriz que representa al canal de

informacin es de rxs donde r es el nmero de entradas

que se tiene y s es el nmero de salidas que se obtienen

al pasar por dicho canal de informacin.

P(bs /a1 )

P(bs /a2 )

]

P(bs /ar )

P(bj /ai ). P(ai )

P(bj )

Y la matriz de probabilidades retrospectivas queda

definida de la siguiente manera:

P(a1 /b1 )

P(a1 /b2 )

=[

P(a1 /bs )

P(a2 /b1 )

P(a2 /b2 )

P(a2 /bs )

P(ar /b1 )

P(ar /b2 )

]

P(ar /bs )

El tamao de la matriz de probabilidades

retrospectivas es de sxr donde s es el nmero de

entradas que se tiene y r es el nmero de salidas.

2.2. ENTROPA A PRIORI

La entropa a priori es la cantidad de informacin

que se tiene a la entrada de un canal o a la salida del

mismo. La expresin matemtica que define la entropa

a priori en la entrada de un canal es [1]:

() = () log 2

1

()

Mientras que la entropa a priori en la salida del

canal es [1]:

() = () log 2

1

()

La redundancia de un canal hace alusin a la

informacin repetida que se obtiene a la salida del canal

y viene determinada por [1]:

2.3. ENTROPA A POSTERIORI

La entropa a posteriori es la cantidad de

informacin que se tiene al pasar por un canal

determinado; as se tiene que la entropa a posteriori de

la salida B dada la entrada A es [1]:

(/) = (, ) log 2

,

1

(/)

= 1

2.7. EFICIENCIA DE UN CANAL

Porcentaje que indica que cun til es un canal

para trasladar informacin y viene dado por [1]:

=

Donde: (, ) = (/). () = (/). ()

(, ) + (|)

+ (|)

(|)

100%

2.8. CANAL SIN RUIDO

Por lo tanto:

(/) = (/). () log 2

,

1

(/)

Un canal sin ruido es aquel canal definido por una

matriz con un elemento y solamente uno, distinto de cero

en cada columna [1].

Mientras que la entropa a posteriori de la entrada

A dada una salida B es [1]:

(/) = (/). () log 2

,

2.4. INFORMACIN

CANAL

1

(/)

En un canal sin ruido se cumple que la entropa de

la entrada A dada la salida B es igual a cero de la

siguiente manera [1]:

(/) = 0

MUTUA

DE

UN

La informacin mutua de un canal es la cantidad de

informacin resultante de atravesar un canal con ruido y

con prdidas; la cantidad de informacin de un canal

viene dada por [1]:

(, ) = () (/)

(, ) = () (/)

Una de las propiedades de la informacin mutua es

la simetra que tiene; sta viene dada por [1]:

(, ) = (, )

2.5. CAPACIDAD DE UN CANAL

La capacidad de un canal es la cantidad de

informacin mxima que se tiene al atravesar dicho

canal; al ser la capacidad del canal la cantidad de

informacin mxima, sta se da cuando la entropa en la

entrada del canal es mxima y ello se presenta al tener

entradas equiprobables [1].

= (, ) = (, )

Por consiguiente, se tendr que la cantidad de

informacin en un canal sin ruido es igual a la entropa

en la entrada:

0

(, ) = () (/)

(, ) = ()

3. DESCRIPCIN DEL PROGRAMA

Se ha determinado que la matriz de ingreso cuente

con tres entradas mientras la matriz del canal sin ruido

sea de tres filas por seis columnas. Se adquieren los

valores ingresados de cada matriz y luego son

transformados a tipo numrico para poderse trabajar.

A=get(handles.entrada,'String');

A=str2num(A); %matriz de entradas independientes

P=get(handles.matriz_prospect,'String');

P=str2num(P); %matriz de canal sin ruido

Ahora se procede a calcular la matriz de salida, la

matriz del canal retrospectivo, las entropas a priori H(A),

H(B), las entropas a posteriori H(A|B), H(B|A), la

informacin mutua I(A|B) e I(B|A):

B=A*P; %matriz de salida

2.6. REDUNDANCIA DE UN CANAL

%Clculo de la matriz retrospectiva

P1=[0 0 0;0 0 0;0 0 0;0 0 0;0 0 0;0 0 0];

for(i=1:6)

for(j=1:3)

P1(i,j)=P(j,i)*A(j)/B(i); % teorema de Bayes

end

end

%Clculo de la entropa a priori H(A)

HA=0;

for(i=1:3)

HA=HA + A(i)*log2(1/A(i));

end

%Clculo de la entropa a priori H(B)

HB=0;

for(i=1:6)

HB=HB + B(i)*log2(1/B(i));

end

%Clculo de la entropa a posteriori H(A/B)

HAB=0;

for(i=1:3)

for(j=1:6)

s=P1(j,i)*B(j)*log2(1/P1(j,i));

a=isnan(s);

if(a==1)

s=0;

end

HAB=HAB+s;

end

end

%Clculo de la informacin mutua I(A,B)

IAB=HA-HAB;

%Clculo de la entropa a posteriori H(B/A)

HBA=0;

for(i=1:6)

for(j=1:3)

s=P(j,i)*A(j)*log2(1/P(j,i));

a=isnan(s);

if(a==1)

s=0;

end

HBA=HBA+s;

end

end

%Clculo de la informacin mutua I(B,A)

IBA=HB-HBA;

Ahora para la matriz con entradas equiprobables se

adquieren los valores de ingreso y se repite el cdigo

anterior para encontrar el resto de parmetros:

A=get(handles.entrada_eq,'String'); %matriz de

entradas equiprobables

A=str2num(A);

Finalmente se calcula la redundancia y eficiencia

del canal tanto con entradas independientes como con

entradas equiprobables:

%Redundancia del canal

R=1-((IAB + HAB)/(C + HAB)); %entradas

independientes

Re=1-((IABe + HAB)/(C + HAB)); %entradas

equiprobables

%Eficiencia del canal

E=IAB/C; %entradas independientes

Ee=IABe/C; %entradas equiprobables

4. RESULTADOS OBTENIDOS

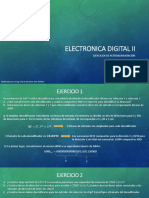

En base a la figura se observa que al estar la matriz de

ingreso integrada por las entradas independientes [0,2

0,5 0,3] la entropa de A es de 1,48548 bits/smbolo, la

entropa de B es 2,36379 bits/smbolo, la entropa de A

dado B es de 0, la entropa de B dado A es de 0,878312

bits/smbolo, la informacin mutua del canal es de

1,48548 bits, la redundancia del canal es de 0,0627694

y la eficiencia del canal es de 93.7231%. Mientras que al

estar la matriz de ingreso formada por entradas

equiprobables [1/3 1/3 1/3] la entropa de A es de

1,58496 bits/smbolo, la entropa de B es 2,44302

bits/smbolo, la entropa de A dado B es de 0, la entropa

de B dado A es de 0,858057 bits/smbolo, la informacin

mutua del canal es de 1,58496 bits, la redundancia del

canal es de 0 y la eficiencia del canal es de 100%.

Adems, se puede notar que las matrices de salida

cambian para ambos casos pero la matriz del canal

retrospectivo es la misma para ambos casos sin importar

las entradas y que corresponde a la matriz de un canal

determinante.

5. REFERENCIA

[1] ABRAMSON Norman, 1981, TEORA DE LA

INFORMACIN Y CODIFICACIN, PARANINFO SA, Quinta

Edicin, pg. 111-166.

[2] NAVIDI William, 2006, ESTADSTICA PARA INGENIEROS

Y CIENTFICOS, McGraw-Hill, pg. 78-79.

También podría gustarte

- Filtro adaptativo: Mejora de la visión por computadora mediante filtrado adaptativoDe EverandFiltro adaptativo: Mejora de la visión por computadora mediante filtrado adaptativoAún no hay calificaciones

- Examen Comunicaciones DigitalesDocumento2 páginasExamen Comunicaciones DigitalesJessi CruelAún no hay calificaciones

- Composición alfa: Dominar el arte de la composición de imágenes en visión por computadoraDe EverandComposición alfa: Dominar el arte de la composición de imágenes en visión por computadoraAún no hay calificaciones

- INFORME Lab #1 PDFDocumento5 páginasINFORME Lab #1 PDFIsabel Kaulitz CedeñoAún no hay calificaciones

- Comunicaciones InalambricasDocumento5 páginasComunicaciones InalambricasIsabel Kaulitz CedeñoAún no hay calificaciones

- Relleno de inundación: Relleno de inundación: exploración del terreno dinámico de la visión por computadoraDe EverandRelleno de inundación: Relleno de inundación: exploración del terreno dinámico de la visión por computadoraAún no hay calificaciones

- Canal AwgnDocumento6 páginasCanal AwgnNelson BarrazuetaAún no hay calificaciones

- La Teoría de La Información y CodificaciónDocumento7 páginasLa Teoría de La Información y CodificaciónbuyesyohanAún no hay calificaciones

- 100 Circuitos de Audio (ES) - volume 1De Everand100 Circuitos de Audio (ES) - volume 1Calificación: 5 de 5 estrellas5/5 (2)

- Tema 8 Comunicaciones II - Transmisión y Deteccion de Banda Base Con AWGN Mayo de 2014Documento50 páginasTema 8 Comunicaciones II - Transmisión y Deteccion de Banda Base Con AWGN Mayo de 2014Julio RamosAún no hay calificaciones

- Banco de filtros: Información sobre las técnicas del banco de filtros de Computer VisionDe EverandBanco de filtros: Información sobre las técnicas del banco de filtros de Computer VisionAún no hay calificaciones

- Lab 4 - DigModAWGNDocumento9 páginasLab 4 - DigModAWGNLinda CastilloAún no hay calificaciones

- Canales de ComunicacionDocumento9 páginasCanales de ComunicacionJJARAún no hay calificaciones

- 2 Teoria de La Información y CodificaciónDocumento37 páginas2 Teoria de La Información y CodificaciónLeiddy LilibethAún no hay calificaciones

- Propuestos Teoria de La Informacion y CodificacionDocumento3 páginasPropuestos Teoria de La Informacion y CodificacionnapstindAún no hay calificaciones

- Practico 3Documento5 páginasPractico 3Yamile EscuderoAún no hay calificaciones

- Guia L4 Tele2 El Efecto de ISI y Del Ruido Mediante La Observación Del Diagrama de OjoDocumento9 páginasGuia L4 Tele2 El Efecto de ISI y Del Ruido Mediante La Observación Del Diagrama de OjosergioengelsAún no hay calificaciones

- Unidad II - 4Documento11 páginasUnidad II - 4Me llaman RomeoAún no hay calificaciones

- Compar AdoresDocumento7 páginasCompar AdoresRamón Altamirano MontalvoAún no hay calificaciones

- Laboratorio 2 ModificadaDocumento4 páginasLaboratorio 2 ModificadaDesireeKarinaAgueroMayzAún no hay calificaciones

- PROYECTO1Documento12 páginasPROYECTO1Mario GonzalezAún no hay calificaciones

- P 2.M D O: Ráctica Odulación IgitalDocumento4 páginasP 2.M D O: Ráctica Odulación IgitalDesireeKarinaAgueroMayzAún no hay calificaciones

- Simulación de Un Canal de Comunicacion BinarioDocumento8 páginasSimulación de Un Canal de Comunicacion BinarioJhona ValenciaAún no hay calificaciones

- Problemas Propuestos Examen Parcial Ee514 Tele II 16-10-13Documento4 páginasProblemas Propuestos Examen Parcial Ee514 Tele II 16-10-13Marcos CnAún no hay calificaciones

- Práctica 1 Lab Sistemas de Comunicaciones IiDocumento4 páginasPráctica 1 Lab Sistemas de Comunicaciones IiCarlos LBAún no hay calificaciones

- Guia L3 - Diagrama de OjoDocumento10 páginasGuia L3 - Diagrama de OjoBoris Huaman SeguraAún no hay calificaciones

- Teoremas de ShannonDocumento4 páginasTeoremas de ShannonLuis LópezAún no hay calificaciones

- Practica2 COMUNIK DIGITALESDocumento10 páginasPractica2 COMUNIK DIGITALESClaudia MendozaAún no hay calificaciones

- Clase Practica de TelefoniaDocumento5 páginasClase Practica de TelefoniaLuis LópezAún no hay calificaciones

- Modulación ASKDocumento4 páginasModulación ASKJairo SantistebanAún no hay calificaciones

- Capacidad Del CanalDocumento4 páginasCapacidad Del CanalLuis LópezAún no hay calificaciones

- Convertidor ADCDocumento12 páginasConvertidor ADCRonaldReyesAún no hay calificaciones

- Transmision Digital en Banda BaseDocumento6 páginasTransmision Digital en Banda BaseAlejandro CeladaAún no hay calificaciones

- Teoría de Información Taller Canales de Informnación.Documento3 páginasTeoría de Información Taller Canales de Informnación.Danilo GutierrezAún no hay calificaciones

- Teoría de Información Taller Canales de Informnación.Documento3 páginasTeoría de Información Taller Canales de Informnación.Danilo GutierrezAún no hay calificaciones

- Teoría de Información Taller Canales de Informnación.Documento3 páginasTeoría de Información Taller Canales de Informnación.Danilo GutierrezAún no hay calificaciones

- Ejercicios Fase3Documento13 páginasEjercicios Fase3Luis Ortega50% (2)

- Clase12 Tele II Modulacion Qam (20 11)Documento67 páginasClase12 Tele II Modulacion Qam (20 11)Richard VillanuevaAún no hay calificaciones

- ProblemasDocumento7 páginasProblemasVictor HugoAún no hay calificaciones

- Problemas Tema 2 - v1Documento4 páginasProblemas Tema 2 - v1Lorena AgachiAún no hay calificaciones

- Práctica 05 Demodulador AMDocumento8 páginasPráctica 05 Demodulador AMAlvaro ChinchinAún no hay calificaciones

- Practica InformaticaDocumento6 páginasPractica InformaticaJerry Escobar PintoAún no hay calificaciones

- Practico 2Documento4 páginasPractico 2Yamile EscuderoAún no hay calificaciones

- Practica 8 AM y DSB PDFDocumento8 páginasPractica 8 AM y DSB PDFDIEGO IVAN PASCUAZA POPAYANAún no hay calificaciones

- Lab VDocumento3 páginasLab VLuis Fernando RiveraAún no hay calificaciones

- Práctica 04 Demodulador AMDocumento8 páginasPráctica 04 Demodulador AMbartolome777ooAún no hay calificaciones

- Telecom Problemas ResueltosDocumento22 páginasTelecom Problemas ResueltosYerko Kitzelmann Muñoz100% (1)

- Carga de Canal de ComunicacionesDocumento8 páginasCarga de Canal de ComunicacionesLiliana GavidiaAún no hay calificaciones

- Unidad III. Diseño de Sistemas CombinacionalesDocumento7 páginasUnidad III. Diseño de Sistemas CombinacionalesJessica LeivaAún no hay calificaciones

- Práctica 1er Parcial Rev BDocumento4 páginasPráctica 1er Parcial Rev BAriza FlorentinoAún no hay calificaciones

- Ejercicos de DigtalesDocumento43 páginasEjercicos de DigtalesJoximar Hinestroza PereaAún no hay calificaciones

- Ask FSK PSKDocumento68 páginasAsk FSK PSKWilliam TamayoAún no hay calificaciones

- Práctica # 1 Sistemas PAM y PCM Con Filtros de AcoplamientoDocumento14 páginasPráctica # 1 Sistemas PAM y PCM Con Filtros de AcoplamientoCarlos LBAún no hay calificaciones

- Taller2 Compuertas Lógicasversion2Documento3 páginasTaller2 Compuertas Lógicasversion2JHAM C BEAT'S TURNERAún no hay calificaciones

- Articulo Actividad 3Documento18 páginasArticulo Actividad 3Ivan David Guerrero GuevaraAún no hay calificaciones

- Ejercicios de Capacidad Del CanalDocumento4 páginasEjercicios de Capacidad Del CanalEsteban TapiaAún no hay calificaciones

- Balotario ParcialDocumento9 páginasBalotario Parcialalexis uribe arangoitiaAún no hay calificaciones

- Fcbol 3Documento6 páginasFcbol 3Paola Flors'RedheadAún no hay calificaciones

- Apex SegurosDocumento5 páginasApex SegurosEduard Campoverde EncaladaAún no hay calificaciones

- Amplificador para 2.2 GHZ en Base A Transistor FETDocumento20 páginasAmplificador para 2.2 GHZ en Base A Transistor FETEduard Campoverde EncaladaAún no hay calificaciones

- Modelo de Propagacion en Interiores - VisiwaveDocumento26 páginasModelo de Propagacion en Interiores - VisiwaveEduard Campoverde EncaladaAún no hay calificaciones

- Frecuencias de Radio en FM en La Ciudad de LojaDocumento1 páginaFrecuencias de Radio en FM en La Ciudad de LojaEduard Campoverde Encalada100% (1)

- Para Escribir Uan Tesis Juridica Tecnicas de Investigacion en DerechoDocumento16 páginasPara Escribir Uan Tesis Juridica Tecnicas de Investigacion en DerechoJhordan AlexAún no hay calificaciones

- Listado de Tutores para TesisDocumento3 páginasListado de Tutores para TesisSerCL1Aún no hay calificaciones

- SP SL Programa Orientacion y Habilidades para El Trabajo Manual de Facilitation PresentacionDocumento38 páginasSP SL Programa Orientacion y Habilidades para El Trabajo Manual de Facilitation PresentacionJs SamudioAún no hay calificaciones

- Programa de Intervención Con Padres - Psicoeducación Sesión2Documento11 páginasPrograma de Intervención Con Padres - Psicoeducación Sesión2Gabriela GarcíaAún no hay calificaciones

- Rendir Examen MedicoDocumento2 páginasRendir Examen MedicoLipe BaressiAún no hay calificaciones

- Características Principales de Los Instrumentos DCDocumento11 páginasCaracterísticas Principales de Los Instrumentos DCYugi-ohstoretcg Tiendadecartasyugi-ohAún no hay calificaciones

- JamoviDocumento85 páginasJamoviArnold Tafur MendozaAún no hay calificaciones

- Arcaismo en El EspanolDocumento8 páginasArcaismo en El EspanolAngel RiveraAún no hay calificaciones

- Conferencia 20 y 21 de FreudDocumento1 páginaConferencia 20 y 21 de FreudMirkoAún no hay calificaciones

- Presupuesto General: Página 1Documento3 páginasPresupuesto General: Página 1Israel Guijarro DomínguezAún no hay calificaciones

- El Proceso de Expropiación en La Legislación PeruanaDocumento9 páginasEl Proceso de Expropiación en La Legislación PeruanaronaldgaAún no hay calificaciones

- Modulo de OfimaticaDocumento38 páginasModulo de OfimaticaEdgar CampañaAún no hay calificaciones

- Caso de La BallenaDocumento41 páginasCaso de La BallenagabandpaulaAún no hay calificaciones

- ACT 8.2.VI MAT 4carlosDocumento3 páginasACT 8.2.VI MAT 4carlosyesenia manrique padillaAún no hay calificaciones

- Velocidad Crítica y Analisis de RigidezDocumento9 páginasVelocidad Crítica y Analisis de RigidezAbril Alvarez100% (2)

- Proctor Modificado T-180Documento13 páginasProctor Modificado T-180Roly Ivan Rojas Cornejo0% (1)

- Archivoforo 2022621141710Documento6 páginasArchivoforo 2022621141710ODALIS NARCISA CLEMENTE PINCAYAún no hay calificaciones

- Capitulo I Programa de Mantenimiento para Equipos de La Linea de Produccion de Quesos de Industrias Lácteas PacomelaDocumento7 páginasCapitulo I Programa de Mantenimiento para Equipos de La Linea de Produccion de Quesos de Industrias Lácteas PacomelasteverosembergAún no hay calificaciones

- Trabajo Factores Que Influyen en La Toma de DecisionesDocumento14 páginasTrabajo Factores Que Influyen en La Toma de DecisionesJorge Roman100% (1)

- Reporte de Difusion Ssu Resp - Soc.vii A Ing - Civil HansDocumento1 páginaReporte de Difusion Ssu Resp - Soc.vii A Ing - Civil HansNick TorresAún no hay calificaciones

- Método HúngaroDocumento2 páginasMétodo HúngaroWences PenicheAún no hay calificaciones

- Familia Funcional y DisfuncionalDocumento35 páginasFamilia Funcional y Disfuncionalcarlos gavancho100% (1)

- Ciencias 7 Cuaderno Ejercicios PDFDocumento162 páginasCiencias 7 Cuaderno Ejercicios PDFNelson ValdesAún no hay calificaciones

- Concepto de Cultura de La CapacitacionDocumento4 páginasConcepto de Cultura de La CapacitacionJemimakElianaDiazRodriguezAún no hay calificaciones

- Fornet Betancourt - Interculturalidad o Barbarie (Articulo)Documento15 páginasFornet Betancourt - Interculturalidad o Barbarie (Articulo)MinBsbAún no hay calificaciones

- Oyaneder Jara, Patricio - Aproximación Al Mito PDFDocumento10 páginasOyaneder Jara, Patricio - Aproximación Al Mito PDFignacio_solanaAún no hay calificaciones

- Historia Clinica, Expediente Clinico, Informe PsicologicoDocumento8 páginasHistoria Clinica, Expediente Clinico, Informe Psicologicomarco briones100% (1)

- Manual para LigarDocumento6 páginasManual para LigarJose Manuel Ramos CamachoAún no hay calificaciones

- Prueba Del Capítulo 2Documento6 páginasPrueba Del Capítulo 2Pavel MayorgaAún no hay calificaciones

- Levantamiento Topográfico Con Nivel de IngenieroDocumento15 páginasLevantamiento Topográfico Con Nivel de IngenieroCLC VERSION LIMITADA100% (4)