Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Resumen Sesion 12

Cargado por

giocres89Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Resumen Sesion 12

Cargado por

giocres89Copyright:

Formatos disponibles

--Mtodos de Aprendizaje en Redes Neuronales: -Algoritmo Backpropagation: -Entrenamiento de redes feedforward (Backpropagation): Siendo fzm; tmgm=1:::n un conjunto de n patrones

de entrenamiento,con zm las entradas conocidas para el m ??simo patrn y tmlas salidas deseadas en cada neurona de salida para ese patrn Algo ritmo Backpropagation 1 Iniciar aleatoriamente los pesos de la red 2 Para cada p atrn m de entrenamiento, de 1 a n 1 Presentar un patrn de entrada zm a la Red Neur onal. 2 Propagar stas entradas hacia la capa de salida. 3 Calcular el error en la capa de salida 4 'Retropropagar' dicho error hacia la capa oculta a travs de la regla delta 5 Cambiar los pesos de las conexiones. 3 Si tras recorrerse todos lo s patrones el error cuadrtico medio de la salida para todos y cada uno de ellos e s menor a un umbral, terminar. En caso contrario, volver a 2 -Propagacin (Feedforward):Funcionamiento usual de la red (entrenada o durante ent renamiento).Consiste en Propagacin 1 Inicializar todos los valores vi; i 2 C0 de las unidades de entrada con el patrn a procesar 2 Para cada capa Ck; k 1 (oculta o salida) 1 Para cada neurona j en la capa Ck 1 Calcular la entrada de la neuron a netj = X i2Ck??1 viwij + j 2 Calcular la salida de la neurona -Estimacin y uso del Error: El error global de la red en cada paso n del entrenam iento se puede cuanticar con la suma de errores cuadrticos En = 1 2 X j2Cout (tj;m ?? vj)2 establecindose as la condicin de parada, imponiendo un mximo error aceptab le en la salida, "max. As, la condicin es En < "max Se busca la minimizacin del err or mediante la variacin de los pesos, segn @E @wij = @E @netj@netj@wij=@E@net jviporque @netj @wij = vi, la entradas a la neurona j desde la neurona i de la capa anterior. Esto nos deja la notacin -Porqu el resultado para j ?: Para las neuronas de salida, la contribucin al error d e cada neurona j slo depende de su entrada fvigi2Cout??1 y de los pesos que la co nectan con dicha entrada. -Regla Delta adaptada: Dado lo anterior, podemos plantear la expresin de actualiz acin de pesos para conexiones con neuronas de la capa de salida wij = ?? @E @wij = jv i Para las neuronas ocultas, el error en la neurona oculta i de la capa k se est ima considerando todos los errores inducidos en las neuronas de la capa siguient e. Teniendo la estimacin inicial del error en la capa de salida, para calcular lo s i en las capas ocultas se hace: i = 0(neti) X j2Ck+1 wijj y se aplica la misma reg la de actualizacin iterativamente (tiempo n) para todas las conexiones de la red -Algoritmo de Backpropagation: Parmetros: : tasa de aprendizaje, "max: umbral de er ror, fzp; SpgN patrones de entrenamiento, N: nmero de patrones Inicializar todos los pesos wj con valores aleatorios Hacer 1 Inicializar bandera de error a fal so 2 Para p = 0 hasta N 1 Propagar!Estimar la salida, vi para el patrn de entrada zp 2 Calcular E. Si E > "max cambiar a verdadero la bandera de error, sino, pas ar a siguiente patrn zp+1 3 Con Sp, estimar el j para cada neurona j de la capa de salida Cout 4 Para todas las capas ocultas desde Cout??1hasta C1 1 Para todas l as neuronas i de cada capa Calcular el error i y el i, actualizar i 5 Para todas las conexiones de la red Calcular el wij Actualizar los pesos de las conexiones wij Mientras bandera de error sea verdadera -Modelos Competitivos Auto-organizados Red de Kohonen: Estructura bicapa Las neu ronas de la capa de entrada, x = [x1; x2; ; xm] son captadores simples (toman da tos presentados a la red y los pasan a la siguiente capa de manera ponderada a t ravs de los pesos a las conexiones). Las neuronas de la capa siguiente son una ma triz bidimensional conocida como mapa auto-organizado, en la que los elementos s e activan por regiones (vecindades), segn sean los patrones de entrada Datos de c omplejidad arbitraria pueden ser proyectados al espacio del mapa auto-organizado de forma ponderada a travs de un vector (matriz) de pesos. Esto es (para la ksima iteracin del entrenamiento) wk i = wk i1;wk i2; ;wk inT donde n es el nmero de neuro nas. -Aprendizaje en la Red de Kohonen: El aprendizaje en la red de Kohonen es de tip o competitivo: Se premia a las neuronas que se activan de forma diferenciada ant e un patrn de entrenamiento especco Se trata de un modelo de aprendizaje nosupervisa do No se presenta a la red un conjunto de salidas deseadas sino que se refuerza el comportamiento que se considera deseable El algoritmo de entrenamiento es un

proceso de auto-organizacin Los patrones son presentados iterativamente en la cap a de entrada e, iterativamente, los pesos se van ajustando de modo que una neuro na o regin es activada para cada patrn Las neuronas compiten entre s por ser activa das de acuerdo a los patrones de entrada presentados, segn una funcin de ponderacin que refuerza la activacin de la regin ms activa La tasa de aprendizaje es variable . p.ej -Algoritmo de entrenamiento para la red de Kohonen: 1 Inicializacin: 1 El peso w0 ij de cada conexin entre las neuronas i de la capa de entrada y j del mapa auto-o rganizado se asigna (aleatoriamente), 2 Denir la vecindad de las neuronas a travs del valor r, su radio 2 Presentar un patrn de entrenamiento conocido z = [z1; z2; ; zm] 3 Se determina la neurona n cuyo vector de pesos es el ms cercano al vecto r patrn de entrada. Se suele emplear la distancia eucldea min n di(n); di(n) = sXi (xk i ?? wk i;n)2 4 Se actualizan los pesos de todas las conexiones wi;n, para la nsima unidad del mapa (n jo) wk+1 i;n = (wk i + k(xk i ?? wk i;n) si i 2 Br wk i; n si i =2 Br 5 Regresar a 2. hasta que k alcance un nmero de iteraciones especicad o -Memorias Asociativas Bidireccionales (BAM): Casos particulares de la mquina de m emoria bicapa sin conexiones laterales El conocimiento se almacena en los pesos de la red que asocian entradas con salidas mediante un proceso de transformacin L a conguracin de entradas y salidas debe tener una correspondencia intrnseca. Los va lores entrantes y salientes suelen ser binarios ((0, 1) o (-1, 1)). Se suelen po larizar los patrones (representarlos como funcin signo) Las neuronas de la capa o culta permiten procesar el conocimiento de las conexiones sobre el patrn de entrada , aproximndolo a un patrn conocido previamente entrenado Se genera un modelo de me moria asociativa -Funcionamiento de una red tipo BAM: El Patrn de entrada es presentado a la red a travs de la capa de entrada con valores en el vector A, propagndose a la capa de salida, B, a travs de las conexiones con pesos en la matriz W, activndolas con un vector de valores B A !W! B Los valores de activacin B de la capa oculta regresan a la capa visible mediante la aplicacin de la matriz transpuesta de pesos WT B ! WT ! A0 El vector de valores obtenido en la capa A0 se propaga de nuevo hacia la capa oculta, generando nuevos valores de activacin, B0 A0 !W! B0 Este proceso se repite hasta que la red alcance un estado estable (variaciones por debajo de un umbral aceptable - menor energa almacenada en W) -Aprendizaje de una red tipo BAM: 1 Inicializar aleatoriamente W 2 Leer un vecto r de entrada A y un vector de salida B, polarizndolos si es necesario (pasar de ( 0,1) a (-1,1)) 3 Para todos los elementos fwijg que unen a neuronas ai 2 A y bj 2 B hacer wn+1 ij = wn ij + aibj 4 Si hay ms patrones de entrada, volver a 2. has ta presentarlos todos a la red BAM -Recuperacin de patrones en una red tipo BAM: 1 Leer un vector de entrada A en la red 2 Generar la salida B para el patrn de presentado. Para todos los bj bn+1 j =8><>: 1 si Pi aiwij > 0 0 si Pi aiwij < 0 bn si Pi aiwij = 0 3 Generar la salid a A0 para el patrn de presentado. Para todos los ai an+1 i =8> <> : 1 si Pj bjwij > 0 0 si Pj bjwij < 0 bn si Pj bjwij = 0 4 Volver a 2. hasta que A y B dejen de cambiar.

También podría gustarte

- ELIPSEDocumento4 páginasELIPSEPedro Cuyate100% (4)

- Paleografia y Diplomatica HispanoamericanaDocumento96 páginasPaleografia y Diplomatica HispanoamericanaAnonymous 8MMsV3Aún no hay calificaciones

- Entendiendo El Posicionamiento de Una Solución MDMDocumento5 páginasEntendiendo El Posicionamiento de Una Solución MDMgiocres89Aún no hay calificaciones

- Ejemplos BPMNDocumento25 páginasEjemplos BPMNYasna LeónAún no hay calificaciones

- Ligapostobonfixture 2012 SegundosemestreDocumento1 páginaLigapostobonfixture 2012 Segundosemestregiocres89Aún no hay calificaciones

- Funciones Con CadenasDocumento2 páginasFunciones Con Cadenasgiocres89Aún no hay calificaciones

- FINAL - Documento Casos de UsoDocumento18 páginasFINAL - Documento Casos de Usogiocres89Aún no hay calificaciones

- Tema 6Documento9 páginasTema 6giocres89Aún no hay calificaciones

- CAÑADADocumento28 páginasCAÑADABertín VásquezAún no hay calificaciones

- Actividad Cuales Son Los Pasos Del Metodo CientificoDocumento4 páginasActividad Cuales Son Los Pasos Del Metodo CientificoValentina Lujan CabezaAún no hay calificaciones

- Taller Economía CircularDocumento2 páginasTaller Economía CircularBrahian ferney nieto chavesAún no hay calificaciones

- DIRECTIVA 002-2023 Movilidad LocalDocumento19 páginasDIRECTIVA 002-2023 Movilidad LocalRAMON CARO BAYONAAún no hay calificaciones

- Cuaderno de Trabajo 6° MaestroDocumento352 páginasCuaderno de Trabajo 6° MaestroFrancisco EuanAún no hay calificaciones

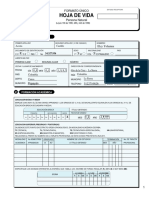

- Hoja de Vida Formato UnicoDocumento7 páginasHoja de Vida Formato UnicoLa papelería com PopayanAún no hay calificaciones

- Taller de Preparación para El Segundo Parcial 2019-30Documento10 páginasTaller de Preparación para El Segundo Parcial 2019-30esgom819Aún no hay calificaciones

- Reserva - B - Criterios Modelo 6 Andaluc°a 15-16Documento2 páginasReserva - B - Criterios Modelo 6 Andaluc°a 15-16benitaAún no hay calificaciones

- Historia de La EconomiaDocumento9 páginasHistoria de La EconomiaCOOGENESIS CALIAún no hay calificaciones

- Guía de Aprendizaje de SalsasDocumento4 páginasGuía de Aprendizaje de Salsasciber lideresAún no hay calificaciones

- Comprobaciones Del Pilar C11Documento54 páginasComprobaciones Del Pilar C11Jose OsorioAún no hay calificaciones

- Examen de Aritmetica-Cuarto Año SecDocumento2 páginasExamen de Aritmetica-Cuarto Año SecJose Paiva MozoAún no hay calificaciones

- Efectividad de Trampas y Cebos en La Captura de Micromamíferos en El KMDocumento9 páginasEfectividad de Trampas y Cebos en La Captura de Micromamíferos en El KMRicardo AbadieAún no hay calificaciones

- Trabajo de InvestigacionDocumento9 páginasTrabajo de InvestigacionJeanpiere Alexis Quiliche PesantesAún no hay calificaciones

- Informe Visita Tecnica Hidroelectrica ManduriacuDocumento9 páginasInforme Visita Tecnica Hidroelectrica ManduriacuKamik LópezAún no hay calificaciones

- Propuesta Tecnica y Economica Empresa - FactibilidadDocumento4 páginasPropuesta Tecnica y Economica Empresa - FactibilidadOrlando Jimenez TelloAún no hay calificaciones

- Termodinámica taller presión volumen temperatura cálculosDocumento2 páginasTermodinámica taller presión volumen temperatura cálculosDeinis GomezAún no hay calificaciones

- Mantenimiento Del Software y Herramientas CaseDocumento7 páginasMantenimiento Del Software y Herramientas CaseJosue CastroAún no hay calificaciones

- Reparar inyectores Isuzu TrooperDocumento5 páginasReparar inyectores Isuzu Troopercasa1271Aún no hay calificaciones

- Equipo1 - Bioquimica - Propiedades Fisicoquimicas Del AguaDocumento7 páginasEquipo1 - Bioquimica - Propiedades Fisicoquimicas Del AguaAryday SanchezAún no hay calificaciones

- Programacion I EjerciciosDocumento4 páginasProgramacion I EjerciciosLenin Eli Flores BalandraAún no hay calificaciones

- EJERCICIOS - Si (Y y Si (ODocumento4 páginasEJERCICIOS - Si (Y y Si (OMiguel RomeroAún no hay calificaciones

- Practica FinalDocumento4 páginasPractica FinalGabriel RomeroAún no hay calificaciones

- Guia 6 HDocumento15 páginasGuia 6 HDannix CastilloAún no hay calificaciones

- Fuentes Del Derecho Ambiental Diapositivas - IrmaDocumento8 páginasFuentes Del Derecho Ambiental Diapositivas - IrmaRudiel VasquezAún no hay calificaciones

- Album RevolucionesDocumento12 páginasAlbum RevolucionesJeremy AlvarezAún no hay calificaciones

- Agua, Liquidos y ElectrolitosDocumento24 páginasAgua, Liquidos y ElectrolitosArgelia BorgesAún no hay calificaciones

- El Tunel de Agua Negra Y Su Potencial Contribucion A Una Integracion Fronteriza, Entre La Provincia de San Juan Y La Region de CoquimboDocumento18 páginasEl Tunel de Agua Negra Y Su Potencial Contribucion A Una Integracion Fronteriza, Entre La Provincia de San Juan Y La Region de CoquimboDiego Ignacio Jiménez CabreraAún no hay calificaciones