Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Test Sumativo - Métricas de Rendimiento - Coursera

Cargado por

Tomas Barrientos BrunaDescripción original:

Título original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Test Sumativo - Métricas de Rendimiento - Coursera

Cargado por

Tomas Barrientos BrunaCopyright:

Formatos disponibles

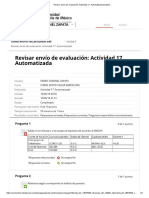

Test sumativo: métricas de rendimiento

Volver Fecha límite 5 de ene. 23:59 -03

Tarea calificada • 1 h 30 m

Tu calificación:

Menú 37,50 %

Tu calificación más reciente: 37,50 % • Tu calificación más alta: 37,50 %

Guardamos

Tarea tu puntaje más alto. Revisa tus calificaciones generales del curso here.

calificada

Test sumativo:

Próximo artículo métricas de rendimiento

Revisar los objetivos de aprendizaje

Instrucciones

Detalles de la tarea

1. Para un algoritmo de clasificación, se aplica una validación cruzada 4-fold a la muestra de entrenamiento, obteniendo las siguientes matrices de confusión: 1 / 1 punto

Fecha límite Intentos

5 de ene. 23:59 -03 Quedan 1 Probar de nuevo

Enviado Límite de tiempo

5 de ene. 22:48 -03 1 h 30 m por intento

Envíos

1 restantes (1 total dentro del límite de tiempo)

A partir de esta información se tiene que

Tu calificación

El Accuracy promedio es 0,1588

Revisa tus calificaciones generales de curso here. Guardamos tu puntaje más alto.

Ver entrega Ver comentarios

37,50 %

El -score promedio es 0,7729

La Precisión promedio es 0,6858

La sensibilidad promedio es 0,8853

Me gusta Correcto No me gusta Informar de un problema

Incorrecto. Revisar las clases 5 y 6 para ver la definición de la presición y ver como se combina dentro de la validación cruzada k-fold.

2. ¿Cuáles de los siguientes argumentos diferencian las métricas de evaluación global de modelos de clasificación (misclassification, impureza de Gini y Entropía) con las métricas que provienen de la matriz de confusión (precisión, recall, especificidad y Fb-score)? 0 / 1 punto

Las métricas globales (Misclassification, impureza de Gini y Entropía) son medidas de bondad de ajuste, es decir, mientras más altas mejor. Sin embargo, las métricas precisión, recall, especificidad y -score son medidas de error, por lo que, mientras más bajo su valor, el modelo subyacente es mejor clasificador.

Esto no debería estar seleccionado

Incorrecto. Las interpretaciones son opuestas, ver la clase 5 para mayores detalles.

Las métricas globales; Misclassification, impureza de Gini y Entropía, y las métricas provenientes de la matriz de confusión precisión, recall, especificidad y -score no tienen diferencias para escoger el modelo de clasificación.

Las métricas de evaluación global; Misclassification, impureza de Gini y Entropía, identifican un mejor modelo de clasificación mientras más cercano a 0 es su valor, mientras las métricas precisión, recall, especificidad y -score deben ser valores lo más cercano a 1 posible.

Las métricas globales Misclassification, impureza de Gini y Entropía pueden ser utilizadas directamente en problemas de clasificación multiclase (más de dos niveles), mientras que las métricas precisión, recall, especificidad y -score se utilizan solo en el contexto de dos clases.

3. Si tenemos una variable respuesta que es categórica, ¿Cuál o cuáles de las siguientes métricas de rendimiento son apropiadas para dicha variable? 0 / 1 punto

El AUC, (el área bajo la curva ROC).

Correcto

Correcto. El AUC proporciona una medida del rendimiento del modelo en términos de su capacidad para discriminar entre las dos clases, por lo que mientras mayor es su valor, mejor es el clasificador

El Accuracy o Exactitud

El coeficiente de Determinación (R2)

El error cuadrático medio (RMSE)

No seleccionaste todas las respuestas correctas

4. ¿Cuál de las siguientes alternativas describe correctamente cómo se selecciona un modelo de clasificación de aprendizaje automático? 0 / 1 punto

La especificidad es la métrica que evalúa la clase negativa, por lo que, mientras menor es su valor, el modelo subyacente es mejor.

La tasa de clasificación errónea (misclassification) se utiliza para elegir el modelo que tiene este valor más cercano a 0.

El -score se utiliza para elegir el modelo que tiene este valor más cercano a 0 para fijo.

La curva ROC se utiliza para elegir el modelo que tiene el AUC más bajo.

Incorrecto

Incorrecto. Revisar el Tutorial 6 donde se profundiza sobre la curva ROC.

5. Luego de aplicar un algoritmo de clasificación, se obtuvo la siguiente matriz de confusión desde la muestra de entrenamiento. 0 / 1 punto

yes no

yes 870 399

no 112 1840

De la matriz de confusión, se puede decir que

La cantidad de datos en la muestra de entrenamiento es igual a 3221 de los cuales 1269 son de la categoría yes, mientras que 1952 son de la categoría no.

La cantidad de datos en la muestra de entrenamiento es igual a 3221 de los cuales 2239 son de la categoría yes, mientras que 982 son de la categoría no.

La cantidad de datos en la muestra de entrenamiento es igual a 3221 de los cuales 982 son de la categoría yes, mientras que 2239 son de la categoría no.

La cantidad de datos en la muestra de entrenamiento es igual a 3221 de los cuales 1952 son de la categoría yes, mientras que 1269 son de la categoría no.

Incorrecto

Incorrecto. Revisar el material de la matriz de confusión en la clase 5.

6. Si tenemos una variable respuesta que es numérica, ¿Cuál o cuáles de las siguientes métricas de rendimiento son apropiadas para dicha variable? 0 / 1 punto

El coeficiente de Determinación (R2)

Correcto

Correcto. El coeficiente de determinación cuantifica la proporción de la variabilidad de la variable respuesta que es explicada por los regresores, así mientras más cercano a 1 mejor es el rendimiento del modelo.

El error cuadrático medio (RMSE)

Correcto

Correcto. Efectivamente el RMSE es la medida más utilizada para cuantificar el error en un problema de regresión.

La curva ROC.

El Accuracy o Exactitud

Esto no debería estar seleccionado

Incorrecto. Revisar la clase 5 donde se explica baja que contexto se utiliza el Accuracy.

7. Para un algoritmo de clasificación, se aplica una validación cruzada 4-fold a la muestra de entrenamiento, obteniendo las siguientes matrices de confusión: 1 / 1 punto

¿Cuál de los siguientes procedimientos es el adecuado para medir la calidad de ajuste del método empleado?

En la matriz de confusión 1 se calcula el Accuracy, en la matriz 2 se calcula la precisión, en la matriz 3 se calcula el recall y en la matriz 4 se calcula la especificidad. Luego, se promedian estos cuatro valores para tener una única métrica.

La información de las matrices de confusión no es suficiente, ya que se necesitan los valores individuales para calcular el RMSE (raíz del error cuadrático medio).

Fijar una métrica de la matriz de confusión, como Accuracy, calcularla para cada una de las 4 matrices y luego promediar dicha métrica.

La información de las matrices confusión no es correcta, ya que las columnas no son consistentes en sus sumas, es decir, la suma de la columna 1 en la matriz 1 es diferente a la suma de la columna 1 en la matriz 2.

Correcto

Correcto. En la validación cruzada k-fold se calcula la misma métrica en cada carpeta y luego se promedia para tener una sola métrica.

8. Luego de aplicar un algoritmo de clasificación, se obtuvo la siguiente matriz de confusión desde la muestra de entrenamiento. 1 / 1 punto

yes no

yes 870 399

no 112 1840

De la matriz de confusión, se puede decir que

870

La precisión es 870+399 = 0.6856

870+1840

El Accuracy es 870+1840+112+399 = 0.8414

1840

La especificidad es 1840+399

= 0.8218

870

El Recall es 870+112 = 0.8859

Correcto

Correcto. Efectivamente, el Accuracy está dado por .

También podría gustarte

- Modalidad de Exámenes - Semana 5Documento3 páginasModalidad de Exámenes - Semana 5Luis Enrique Chuquimantari Jauregui100% (9)

- Preparación para el Examen de GED, Segunda edicionDe EverandPreparación para el Examen de GED, Segunda edicionCalificación: 5 de 5 estrellas5/5 (17)

- Modalidad de Exámenes - Semana 1 - Revisión Del IntentoDocumento2 páginasModalidad de Exámenes - Semana 1 - Revisión Del IntentoFrederick PerezAún no hay calificaciones

- Matemáticas para Los Negocios Puntos Extra 5 AutocalificableDocumento3 páginasMatemáticas para Los Negocios Puntos Extra 5 AutocalificableVICENTE OMAR VERA MARTELL33% (3)

- Examen Segundo Parcial Segunda Vuelta Revisi N Del Intento PDFDocumento3 páginasExamen Segundo Parcial Segunda Vuelta Revisi N Del Intento PDFGriseldaRodriguez0% (1)

- (M4-E1) Evaluación (Prueba4) - INVESTIGACIÓN DE MERCADOSDocumento9 páginas(M4-E1) Evaluación (Prueba4) - INVESTIGACIÓN DE MERCADOSMarlene Espinoza C.Aún no hay calificaciones

- Modalidad de Exámenes - Semana 6 - Revisión Del IntentoDocumento4 páginasModalidad de Exámenes - Semana 6 - Revisión Del IntentoGonzales Vargas Efrin83% (6)

- Revisar Envío de Evaluación - Actividad 17. Automatizada &ndash..Documento4 páginasRevisar Envío de Evaluación - Actividad 17. Automatizada &ndash..GERARDO RAFAEL REYNOSO IBARRAAún no hay calificaciones

- PracticaDocumento4 páginasPracticaRodrigo SaavedraAún no hay calificaciones

- Guia de Actividades - Fase 2 - Identificación y Análisis Del ProblemaDocumento11 páginasGuia de Actividades - Fase 2 - Identificación y Análisis Del Problemanathalia shekAún no hay calificaciones

- Control de La Calidad Externo QMS 24Documento43 páginasControl de La Calidad Externo QMS 24Clari Malpartida100% (1)

- (M4-E1) Evaluación (Prueba) - PROBABILIDAD Y ESTADÍSTICA-90Documento15 páginas(M4-E1) Evaluación (Prueba) - PROBABILIDAD Y ESTADÍSTICA-90Lejandra Riveros100% (1)

- Valuacion de PuestosDocumento41 páginasValuacion de PuestosedisontigasiAún no hay calificaciones

- Pp-Valuacion Por PuntosDocumento37 páginasPp-Valuacion Por PuntosYeliza Veta ElyBethAún no hay calificaciones

- Examén Final EstadisticaDocumento10 páginasExamén Final EstadisticaJessica Lorena Garrido100% (1)

- Examen Final Estadistica InferencialDocumento10 páginasExamen Final Estadistica InferencialPaolaAún no hay calificaciones

- Azure IA - En.esDocumento69 páginasAzure IA - En.esArturo GonzalezAún no hay calificaciones

- Puntos Extra 2 - Revisión Del IntentoDocumento2 páginasPuntos Extra 2 - Revisión Del IntentoIsaac Pérez NavarroAún no hay calificaciones

- Examen Parcial - Semana 4Documento19 páginasExamen Parcial - Semana 4josé wilmer pinzón cabreraAún no hay calificaciones

- Estadistica para Economia - Exámenes - Semana 4 - Revisión Del IntentoDocumento3 páginasEstadistica para Economia - Exámenes - Semana 4 - Revisión Del Intentomilena100% (2)

- Puntos Extra 4 - Revisión Del IntentoDocumento2 páginasPuntos Extra 4 - Revisión Del IntentoIsaac Pérez NavarroAún no hay calificaciones

- Certificación para Legalización O Apostilla: AnexosDocumento4 páginasCertificación para Legalización O Apostilla: AnexosraulAún no hay calificaciones

- Redes NeuronalesDocumento7 páginasRedes NeuronalesJUAN ALFONSO DE LA CRUZ ORELLANA MAGUIÑAAún no hay calificaciones

- Valuacion de PuestosDocumento44 páginasValuacion de PuestosTodo UsadoAún no hay calificaciones

- Modalidad de Exámenes - Semana 4Documento2 páginasModalidad de Exámenes - Semana 4Luis Enrique Chuquimantari JaureguiAún no hay calificaciones

- Primer Bloque-EconometriaDocumento12 páginasPrimer Bloque-EconometriaYenifer LeonAún no hay calificaciones

- Examen Parcial - Semana 4 - INV - PRIMER BLOQUE-PRODUCCION - (GRUPO1)Documento15 páginasExamen Parcial - Semana 4 - INV - PRIMER BLOQUE-PRODUCCION - (GRUPO1)yoni vega100% (1)

- Sustentacion Trabajo Colaborativo - Escenario 7 - Primer Bloque-Ciencias Basicas - Virtual - Estadística Inferencial - (Grupo b08)Documento5 páginasSustentacion Trabajo Colaborativo - Escenario 7 - Primer Bloque-Ciencias Basicas - Virtual - Estadística Inferencial - (Grupo b08)Miguel Angel Amaya RomeroAún no hay calificaciones

- Pp-Valuacion Por PuntosDocumento37 páginasPp-Valuacion Por PuntosMaría Guadalupe Escamilla SantanaAún no hay calificaciones

- Valuacion de PuestosDocumento44 páginasValuacion de PuestosLore Lopez100% (1)

- Resultado Evaluacion 17903154Documento5 páginasResultado Evaluacion 17903154Gabriela montiel diazAún no hay calificaciones

- Metodo de Escalas GraficasDocumento18 páginasMetodo de Escalas Graficasmarry OCAún no hay calificaciones

- Modalidad de Ex Menes Semana 3 Revisi N Del Intento PDFDocumento2 páginasModalidad de Ex Menes Semana 3 Revisi N Del Intento PDFAlejandroAún no hay calificaciones

- Test de Matrices Progresivas de RavenDocumento2 páginasTest de Matrices Progresivas de RavenY A M100% (1)

- Examen Parcial - Semana 4 - INV - PRIMER BLOQUE-ECONOMETRIA - (GRUPO B01)Documento12 páginasExamen Parcial - Semana 4 - INV - PRIMER BLOQUE-ECONOMETRIA - (GRUPO B01)Juan MoraAún no hay calificaciones

- Examen Parcial - Semana 4 - INV - SEGUNDO BLOQUE-GERENCIA DE PRODUCCION - (GRUPO6)Documento21 páginasExamen Parcial - Semana 4 - INV - SEGUNDO BLOQUE-GERENCIA DE PRODUCCION - (GRUPO6)JOSE ALEXANDER100% (1)

- Modalidad de Exámenes - Semana 4 - Revisión Del Intento OPPDocumento5 páginasModalidad de Exámenes - Semana 4 - Revisión Del Intento OPPDani Manchu50% (2)

- Examen Final - Semana 8 - INV - PRIMER BLOQUE-ECONOMETRIA - (GRUPO1)Documento14 páginasExamen Final - Semana 8 - INV - PRIMER BLOQUE-ECONOMETRIA - (GRUPO1)Nicolás González100% (1)

- Unidad 6Documento42 páginasUnidad 6wdwd wedwedwAún no hay calificaciones

- Evaluacion Final - Escenario 8 - SEGUNDO BLOQUE-CIENCIAS BASICAS - VIRTUAL - ESTADÍSTICA 2 - (GRUPO B10)Documento10 páginasEvaluacion Final - Escenario 8 - SEGUNDO BLOQUE-CIENCIAS BASICAS - VIRTUAL - ESTADÍSTICA 2 - (GRUPO B10)Ana Maria CAún no hay calificaciones

- Modalidad de Exámenes - Semana 2 - Revisión Del IntentoDocumento3 páginasModalidad de Exámenes - Semana 2 - Revisión Del Intentoandres valeciaAún no hay calificaciones

- Hora 4 - Análisis de Práctica 2 - Motivación para Recta Final Del CicloDocumento22 páginasHora 4 - Análisis de Práctica 2 - Motivación para Recta Final Del CiclonadiadavilareyAún no hay calificaciones

- Taller de InvestDocumento6 páginasTaller de InvestJUDITH ISMENIA YAGUANA ESCOBARAún no hay calificaciones

- Modalidad de Exámenes - Semana 1 - Revisión Del Intento EPDocumento2 páginasModalidad de Exámenes - Semana 1 - Revisión Del Intento EPDani ManchuAún no hay calificaciones

- Modalidad de Exámenes - Semana 4 - Revisión Del IntentoDocumento2 páginasModalidad de Exámenes - Semana 4 - Revisión Del IntentoPanchito JacksonAún no hay calificaciones

- Modalidad de Exámenes - Semana 5 - Revisión Del IntentoDocumento3 páginasModalidad de Exámenes - Semana 5 - Revisión Del IntentoDani Manchu100% (1)

- Rbd16673 Dia Matematica 7 A MonitoreoDocumento15 páginasRbd16673 Dia Matematica 7 A MonitoreoPaulina Herrera AhumadaAún no hay calificaciones

- Modalidad de Exámenes - Semana 5 - Revisión Del Intento PDFDocumento3 páginasModalidad de Exámenes - Semana 5 - Revisión Del Intento PDFEsdras RiosAún no hay calificaciones

- PES1!Documento2 páginasPES1!Rudy OrtizAún no hay calificaciones

- Examen Parcial - Semana 4 - Inv - Segundo Bloque-Gerencia de Produccion - (Grupo8)Documento14 páginasExamen Parcial - Semana 4 - Inv - Segundo Bloque-Gerencia de Produccion - (Grupo8)AlejandraAún no hay calificaciones

- Manual Saiiut Version CompetenciasDocumento18 páginasManual Saiiut Version CompetenciasOmar GOmezAún no hay calificaciones

- Tarea 2Documento8 páginasTarea 2MagdalenaAún no hay calificaciones

- Reporte ResultadosDocumento6 páginasReporte ResultadosCristian Camilo ChalaAún no hay calificaciones

- Metodo de Valuacion Por PuntosDocumento36 páginasMetodo de Valuacion Por Puntosdanny_93_mx8845Aún no hay calificaciones

- Proceso Ultimo Metodo Conclusiones y RecomendacionesDocumento4 páginasProceso Ultimo Metodo Conclusiones y RecomendacionesjoseAún no hay calificaciones

- Evaluacion Final - Escenario 8 - PRIMER BLOQUE-CIENCIAS BASICAS - ESTADISTICA INFERENCIAL - (GRUPO4) PDFDocumento9 páginasEvaluacion Final - Escenario 8 - PRIMER BLOQUE-CIENCIAS BASICAS - ESTADISTICA INFERENCIAL - (GRUPO4) PDFESTUDIO EXAMENAún no hay calificaciones

- PDF Actividad Evaluativa Eje 1 p1 DDDocumento12 páginasPDF Actividad Evaluativa Eje 1 p1 DDjohn100% (1)

- Guía de Actividades y Rúbrica de Evaluación - Fase 2 - Muestreo e Intervalos de ConfianzaDocumento20 páginasGuía de Actividades y Rúbrica de Evaluación - Fase 2 - Muestreo e Intervalos de ConfianzaJean Carlos Celis estradaAún no hay calificaciones

- Modalidad de Exámenes - Semana 3 - Revisión Del Intento EPDocumento2 páginasModalidad de Exámenes - Semana 3 - Revisión Del Intento EPDani ManchuAún no hay calificaciones

- Examen Parcial - Semana 4-Gerencia de Produccion - (Grupo10)Documento23 páginasExamen Parcial - Semana 4-Gerencia de Produccion - (Grupo10)sandy lorena cometta uribeAún no hay calificaciones

- Resumen Examen DominoDocumento3 páginasResumen Examen DominoLorena IrigoyenAún no hay calificaciones

- Syllabus Analisis de Datos en Python DGDocumento5 páginasSyllabus Analisis de Datos en Python DGTomas Barrientos BrunaAún no hay calificaciones

- Brochure - MAgister en Ciencia de DatosDocumento19 páginasBrochure - MAgister en Ciencia de DatosTomas Barrientos BrunaAún no hay calificaciones

- Ficha FPAC COMPACT ESDocumento2 páginasFicha FPAC COMPACT ESTomas Barrientos BrunaAún no hay calificaciones

- 2022-008-PRO-GA-001-2 Carta GanttDocumento1 página2022-008-PRO-GA-001-2 Carta GanttTomas Barrientos BrunaAún no hay calificaciones

- DDE - Disenos de CribadoDocumento50 páginasDDE - Disenos de CribadoTomas Barrientos BrunaAún no hay calificaciones

- Metodo Interpolacion Geoestadisticos para La Prediccion Niveles Digitales Imagen SatelitalDocumento13 páginasMetodo Interpolacion Geoestadisticos para La Prediccion Niveles Digitales Imagen SatelitalfabumzaAún no hay calificaciones

- P2 Mineriadedatos LourdescalleDocumento39 páginasP2 Mineriadedatos Lourdescallelurdescl5Aún no hay calificaciones

- Modelos Econométricos Con Herramientas de Inteligencia Artificial/aprendizaje AutomáticoDocumento2 páginasModelos Econométricos Con Herramientas de Inteligencia Artificial/aprendizaje AutomáticoDiego De La CruzAún no hay calificaciones

- Trabajo 1 - IsatisDocumento20 páginasTrabajo 1 - IsatisCristian Felipe Alcaíno GallardoAún no hay calificaciones

- GARCIA - Evaluating The Conservation State of The Paramo Ecosystem ESDocumento22 páginasGARCIA - Evaluating The Conservation State of The Paramo Ecosystem ESCristian GuañoAún no hay calificaciones

- Clasificacion de Frases Obscenas o Vulgares Dentro de TweetsDocumento10 páginasClasificacion de Frases Obscenas o Vulgares Dentro de TweetsSebastián Levin BravoAún no hay calificaciones

- GWR BivandDocumento4 páginasGWR BivandEnriqueAún no hay calificaciones

- SplinesDocumento18 páginasSplinesLuis Miguel Buelvas Pestana100% (1)

- Maxent Tutorial 2021.en - EsDocumento40 páginasMaxent Tutorial 2021.en - EsIvánIsmaelBalcasYucraAún no hay calificaciones

- Grupo 7Documento20 páginasGrupo 7Gonzalo Carreño BahamondezAún no hay calificaciones

- Algoritmos y Validación de Modelos de Machine LearningDocumento79 páginasAlgoritmos y Validación de Modelos de Machine LearningJuan Martín Pividori BenvenuttiAún no hay calificaciones

- Libro 03Documento92 páginasLibro 03zoraida carrascoAún no hay calificaciones

- Capitulo 6 - INFERENCIA ESTADÍSTICA MODELOS MULTIVARIANTESDocumento57 páginasCapitulo 6 - INFERENCIA ESTADÍSTICA MODELOS MULTIVARIANTESLeonardo Torres LudeñaAún no hay calificaciones

- Vázquez, Gabriel Clasificador Con Redes Neuronales para El Pronostico de La Enfermedad Renal CronicaDocumento105 páginasVázquez, Gabriel Clasificador Con Redes Neuronales para El Pronostico de La Enfermedad Renal CronicaMario GuillènAún no hay calificaciones

- Hartungetal Inpress EJP - En.esDocumento63 páginasHartungetal Inpress EJP - En.esAlber AAGAún no hay calificaciones

- Langley Et Al-2018-Journal of Forensic Sciences - En.esDocumento8 páginasLangley Et Al-2018-Journal of Forensic Sciences - En.esMiguel Angel Rojas MedinaAún no hay calificaciones

- Azure VisionDocumento117 páginasAzure VisionGuillermo MoralesAún no hay calificaciones

- Validacion Cruzada Geoestadística TeoríaDocumento12 páginasValidacion Cruzada Geoestadística Teoríainnovaciones111 proyectosAún no hay calificaciones

- Mineria Datos Unidad 1aDocumento34 páginasMineria Datos Unidad 1aAdrián LeónAún no hay calificaciones

- Nirs3 YoguresDocumento67 páginasNirs3 YoguresJes JesAún no hay calificaciones

- Semana1 - 19 Experimentos AleatoriosDocumento4 páginasSemana1 - 19 Experimentos AleatoriosrolyAún no hay calificaciones

- Ejercicios Aa SolucionesDocumento13 páginasEjercicios Aa SolucionesMaria ConchesoAún no hay calificaciones

- Clasificación Automática de Nubes de Imágenes de Todo El CieloDocumento15 páginasClasificación Automática de Nubes de Imágenes de Todo El CieloFarArrunateguiAún no hay calificaciones

- Introduccion Al Machine LearningDocumento9 páginasIntroduccion Al Machine LearningBrayan CastilloAún no hay calificaciones

- Lasso y LoessDocumento27 páginasLasso y LoessDiego MoralesAún no hay calificaciones

- Modelos Predictivos Por Aprendizaje Automatizado de Accidentes Laborales y Factores Psicosociales Del TrabajoDocumento43 páginasModelos Predictivos Por Aprendizaje Automatizado de Accidentes Laborales y Factores Psicosociales Del TrabajoeL_suicidaAún no hay calificaciones

- 03 MétodosSupervisados PDFDocumento84 páginas03 MétodosSupervisados PDFCastaneda MayeAún no hay calificaciones

- Wuolah Free APUNTES TEMA 5 MDPDocumento16 páginasWuolah Free APUNTES TEMA 5 MDPsyvt7d59x9Aún no hay calificaciones