100% encontró este documento útil (2 votos)

661 vistas131 páginasFundamentos de Redes Neuronales Con Python

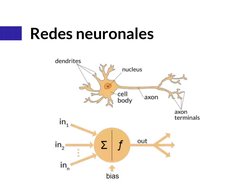

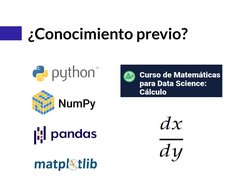

Este documento presenta una introducción a las redes neuronales artificiales. Explica conceptos básicos como las neuronas, las capas de una red neuronal, los vectores y matrices de pesos, las funciones de activación como la sigmoidal y ReLU, y las funciones de pérdida como el error cuadrático medio. También introduce los frameworks de deep learning como Keras y los algoritmos de entrenamiento como el descenso del gradiente.

Cargado por

Rich MDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PDF, TXT o lee en línea desde Scribd

100% encontró este documento útil (2 votos)

661 vistas131 páginasFundamentos de Redes Neuronales Con Python

Este documento presenta una introducción a las redes neuronales artificiales. Explica conceptos básicos como las neuronas, las capas de una red neuronal, los vectores y matrices de pesos, las funciones de activación como la sigmoidal y ReLU, y las funciones de pérdida como el error cuadrático medio. También introduce los frameworks de deep learning como Keras y los algoritmos de entrenamiento como el descenso del gradiente.

Cargado por

Rich MDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como PDF, TXT o lee en línea desde Scribd