Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Glosario Calidad

Glosario Calidad

Cargado por

Valen VelandiaTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Glosario Calidad

Glosario Calidad

Cargado por

Valen VelandiaCopyright:

Formatos disponibles

La calibración es el conjunto de operaciones que establecen la relación entre lo que involucra la comparación de la

lectura del instrumento que se está calibrando con la lectura generada por un instrumento de referencia (o patrón), bajo

determinadas condiciones.}

Verificar: Comprobar que un aparato, instalación, etc., funciona correctamente

se denomina EXACTITUD a la capacidad de un instrumento de acercarse al valor de la magnitud real.

Alcance: De un instrumento de medida se define su ALCANCE, como la mayor medida que se puede obtener.

EL SESGO examina la diferencia entre la medición promedio observada y un valor de referencia.

El sesgo indica cuál es la exactitud del sistema de medición cuando se compara con un valor de referencia.

REPETIBILIDAD: Grado de concordancia entre resultados de sucesivas mediciones del mismo mensurando.

ESTABILIDAD: Aptitud de un instrumento de medida para conservar constantes sus características metrológicas a lo

largo del tiempo.

LA HISTÉRESIS es la tendencia de un material a conservar una de sus propiedades, en ausencia del estímulo que la ha

generado. Algunos instrumentos presentan un fenómeno de descompensación que existe cuando se hace una

comparación entre la variación de una misma medida tanto a nivel descenderte como ascendente, que en realidad

debería de tener el mismo recorrido. Se expresa en porcentaje, por ejemplo si un manómetro de 0-100% la presión real

es de 18 psig y la lectura en el indicador marca 18.2 psig al ir del cero al 100% de la variable y cuando se encuentra la

variable en 18 al desplazarse del cien al 0% el valor indicado es 17.7 la histéresis se calcularía así: (18.2 – 17.7/100 –0) x

100 =+- 0.5 %

DERIVA: Variación lenta de una característica metrológica de un instrumento de medida.

LA RESOLUCIÓN es la mínima variación de la magnitud medida que da lugar a una variación perceptible de la indicación

correspondiente.

DISCRIMINACIÓN, es la máxima variación del valor de la magnitud medida que no causa variación detectable de la

indicación correspondiente.

EL ERROR de medición se define como la diferencia entre el valor medido y el "valor verdadero" para cuantificar la

imperfección del método e instrumento de medida empleado.

existe siempre la posibilidad de confundir una incertidumbre con esa diferencia, se sugiere (Burns y otros, 1973) que

cuando se trate de evaluar la calidad del resultado de una medida se utilice el término incertidumbre en lugar del

término error.

El error de medida tiene dos componentes, el error sistemático y el error aleatorio.

Considerando todas las correcciones necesarias, su valor final es de 317,518 m con una incertidumbre muy pequeña,

casi despreciable, digamos por debajo de la décima de milímetro. Por tanto, la longitud 317,518 m se considerará como

el valor de referencia de la distancia en cuestión.

Así pues, el error de medida para el resultado de una medición individual es igual a la suma del error sistemático y el

error aleatorio. En el caso de la primera medida, el error de medida es por tanto de (-0,002 – 0,001) = -0,003 m.

ZM. Son aquellas donde la sensibilidad del instrumento es nula lo que hace que no cambie su indicación y señal de salida

INTERVALO: Porción de tiempo o de espacio que hay entre dos hechos o dos cosas, generalmente de la misma

naturaleza.

El proceso de medición debe diseñarse para impedir resultados erróneos y debe asegurar la rápida detección de

deficiencias y la oportunidad de acciones correctivas.

La reproducibilidad tiene que ver con la réplica de una prueba en manos de la comunidad científica de una rama

determinada.

También podría gustarte

- Actividad 3 Segundo Avance Del Blog Resolucion de ConflictosDocumento6 páginasActividad 3 Segundo Avance Del Blog Resolucion de Conflictosramiro pinzon100% (2)

- Tema 5. Sistema Financiero Mexicano. FinanzasDocumento18 páginasTema 5. Sistema Financiero Mexicano. FinanzasSailly Arreola100% (1)

- Teoría Constitucional, Luis de La HidalgaDocumento18 páginasTeoría Constitucional, Luis de La HidalgaLaura Cevallos50% (2)

- NTC 750 QuesoDocumento26 páginasNTC 750 QuesoValen VelandiaAún no hay calificaciones

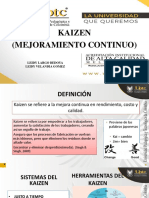

- Kaizen DiapositivasDocumento9 páginasKaizen DiapositivasValen VelandiaAún no hay calificaciones

- P+L OroDocumento6 páginasP+L OroValen VelandiaAún no hay calificaciones

- Presentación NTC 10012Documento25 páginasPresentación NTC 10012Valen VelandiaAún no hay calificaciones

- Encuesta Padres de Familia Del ColegioDocumento2 páginasEncuesta Padres de Familia Del ColegioValen Velandia100% (3)

- Actividad Fisica en AdultoDocumento12 páginasActividad Fisica en AdultoNICOLLE TATIANA BENITEZ GIRONAún no hay calificaciones

- Cuál Es La Clasificación de Riesgos Laborales y Cómo PrevenirlosDocumento5 páginasCuál Es La Clasificación de Riesgos Laborales y Cómo PrevenirlosLiliana SanchezAún no hay calificaciones

- (Tea) Seminario PDFDocumento18 páginas(Tea) Seminario PDFmelisa0% (1)

- De La Octava de Carnavales Sera El 06 de Marzo Del 2022 Con Esto Termina La Tradicional Fecha de LosDocumento2 páginasDe La Octava de Carnavales Sera El 06 de Marzo Del 2022 Con Esto Termina La Tradicional Fecha de Losdavid ajendro barragan huayllaAún no hay calificaciones

- Examen Final de Metodología de InvestigaciónDocumento15 páginasExamen Final de Metodología de InvestigaciónAndrea Cuenca DiazAún no hay calificaciones

- Beta de MercadoDocumento13 páginasBeta de MercadoTito VanegasAún no hay calificaciones

- Mis Apuntes Del Organismo HumanoDocumento2 páginasMis Apuntes Del Organismo Humanoeltizi206Aún no hay calificaciones

- Como Corregir La IrritabilidadDocumento3 páginasComo Corregir La Irritabilidadpiita198050% (2)

- Taller LogicaDocumento5 páginasTaller LogicaKaren Lorena Alvarez ToribioAún no hay calificaciones

- Cultura de La CalidadDocumento10 páginasCultura de La CalidadCLARA PAOLA BARRETO PEDRAZAAún no hay calificaciones

- Guia Nomenclatura Quimica Organica 2 Medio PDFDocumento20 páginasGuia Nomenclatura Quimica Organica 2 Medio PDFMario Latrach GuzmanAún no hay calificaciones

- Actassi Pacífico - ACT4P5EUCM3RBBUDocumento2 páginasActassi Pacífico - ACT4P5EUCM3RBBUgino.maurelliAún no hay calificaciones

- Guion TeatralDocumento13 páginasGuion TeatralGustavo Cc100% (1)

- Revista Enfermeria EpocDocumento58 páginasRevista Enfermeria Epocmancoca26100% (13)

- Vivir en Las Nubes Anuncia TormentaDocumento210 páginasVivir en Las Nubes Anuncia TormentaMANUELAún no hay calificaciones

- Planificamos La Declamación de Poemas Sobre El Aniversario Del ColegiDocumento3 páginasPlanificamos La Declamación de Poemas Sobre El Aniversario Del ColegiElizabeth Romero TarazonaAún no hay calificaciones

- Factores AbioticosDocumento8 páginasFactores AbioticosLewisAún no hay calificaciones

- Programacion de Octubre 2022 Filmoteca Espa OlaDocumento62 páginasProgramacion de Octubre 2022 Filmoteca Espa OlajorgecrapAún no hay calificaciones

- El Coplero Campesino PDFDocumento133 páginasEl Coplero Campesino PDFMichel H. G. S.Aún no hay calificaciones

- Permiso de Viaje CapacitacionDocumento5 páginasPermiso de Viaje CapacitacionEdgar MuchaAún no hay calificaciones

- Meliza Charla EsayminDocumento13 páginasMeliza Charla EsayminMeliza MeraAún no hay calificaciones

- Jaider FilosofíaDocumento2 páginasJaider Filosofíamario alejando portelaAún no hay calificaciones

- Alianzas Estratégicas para La Participación Juvenil en La ComunidadDocumento21 páginasAlianzas Estratégicas para La Participación Juvenil en La ComunidadSergio EstigarribiaAún no hay calificaciones

- XXXI JAM Libro de ResumenesDocumento211 páginasXXXI JAM Libro de ResumenesSarmiento Románovich Asterión GildaroAún no hay calificaciones

- Discurso de Graduación 2018 2019Documento2 páginasDiscurso de Graduación 2018 2019JOSE GUADALUPE REYES MENDOZAAún no hay calificaciones

- Practica 7. Reacciones QuímicasDocumento18 páginasPractica 7. Reacciones QuímicasMendoza Galicia Fernando EmmanuelAún no hay calificaciones

- Interacciones de Los AntihelmínticosDocumento13 páginasInteracciones de Los AntihelmínticosDeybi TorresAún no hay calificaciones