Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Cadena de Markov

Cadena de Markov

Cargado por

oscarhmgDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Cadena de Markov

Cadena de Markov

Cargado por

oscarhmgCopyright:

Formatos disponibles

Captulo 10

Cadenas de Markov

PROCESOS ESTOCSTICOS

Una sucesin de observaciones X

1

, X

2

, . . . se denomina proceso estocs-

tico

Si los valores de estas observaciones no se pueden predecir exactamente

Pero se pueden especicar las probabilidades para los distintos valores

posibles en cualquier instante de tiempo.

X

1

: v.a. que dene el estado inicial del proceso

X

n

: v.a. que dene el estado del proceso en el instante de tiempo n

Para cada posible valor del estado inicial s

1

y para cada uno de los sucesivos

valores s

n

de los estados X

n

, n = 2, 3, . . ., especicamos:

P(X

n+1

= s

n+1

| X

1

= s

1

, X

2

= s

2

, . . . , X

n

= s

n

)

103

104 Cadenas de Markov

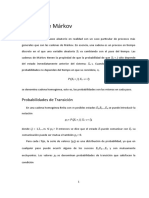

CADENAS DE MARKOV

Una cadena de Markov es un proceso estocstico en el que

Si el estado actual X

n

y los estados previos X

1

, . . . , X

n1

son conocidos

La probabilidad del estado futuro X

n+1

F No depende de los estados anteriores X

1

, . . . , X

n1

, y

F Solamente depende del estado actual X

n

.

Es decir,

Para n = 1, 2, . . . y

Para cualquier sucesin de estados s

1

, . . . , s

n+1

P(X

n+1

= s

n+1

| X

1

= s

1

, X

2

= s

2

, . . . , X

n

= s

n

) =

= P(X

n+1

= s

n+1

| X

n

= s

n

)

Cadenas de Markov 105

EJEMPLO

Consideremos que en un locutorio telefnico con 5 lneas de telfono en

un instante de tiempo dado puede haber un nmero cualquiera de lneas

ocupadas. Durante un periodo de tiempo se observan las lneas telefnicas

a intervalos de 2 minutos y se anota el nmero de lneas ocupadas en cada

instante.

Sea X

1

la v.a. que representa el nmero de lneas ocupadas al principio del

periodo.

Sea X

2

la v.a. que representa el nmero de lneas ocupadas cuando se

observa en el segundo instante de tiempo, 2 minutos ms tarde.

En general, n = 1, 2, . . . X

n

es una v.a. que representa el nmero de

lneas ocupadas cuando se observan en el instante de tiempo nsimo.

El estado del proceso en cualquier instante de tiempo es el nmero de lneas

que estn siendo utilizadas en ese instante.

Un proceso estocstico como el que acabamos de describir se llama proceso

de parmetro discreto, ya que las lneas se observan en puntos discretos

a lo largo del tiempo.

Para que el proceso estocstico del nmero

de lneas ocupadas sea una cadena de Markov

es necesario que la probabilidad de cada posible nmero de

lneas ocupadas en cualquier instante de tiempo

dependa solamente del nmero de

lneas ocupadas 2 minutos antes.

106 Cadenas de Markov

CADENAS DE MARKOV FINITAS

CON PROBABILIDADES DE

TRANSICIN ESTACIONARIAS

CADENA DE MARKOV FINITA

Es una cadena de Markov para la que existe slo un nmero nito k de

estados posibles s

1

, . . . , s

k

y en cualquier instante de tiempo la cadena est

en uno de estos k estados.

PROBABILIDAD DE TRANSICIN

Es la probabilidad condicionada

P(X

n+1

= s

j

| X

n

= s

i

)

PROBABILIDAD DE TRANSICIN ESTACIONARIA

Una cadena de Markov tiene probabilidades de transicin estaciona-

rias si para cualquier par de estados s

i

y s

j

existe una probabilidad de

transicin p

ij

tal que

P(X

n+1

= s

j

| X

n

= s

i

) = p

ij

para n = 1, 2, . . .

Cadenas de Markov 107

MATRIZ DE TRANSICIN

MATRIZ ESTOCSTICA

Es una matriz cuadrada cuyos elementos son no negativos y tal que la

suma de los elementos de cada la es igual a 1.

MATRIZ DE TRANSICIN EN UN SOLO PASO

Dada una cadena de Markov con k estados posibles s

1

, . . . , s

k

y probabili-

dades de transicin estacionarias.

Si p

ij

= P(X

n+1

= s

j

|X

n

= s

i

) = P =

p

11

p

1k

p

21

p

2k

.

.

.

.

.

.

p

k1

p

kk

La matriz de transicin P de cualquier cadena de Markov nita con

probabilidades de transicin estacionarias es una matriz estocstica

EJEMPLO

Supongamos que el clima de una determinada regin slo puede ser soleado

(s

1

) o nublado (s

2

) y que las condiciones del clima en maanas sucesivas forman

una cadena de Markov con probabilidades de transicin estacionarias. La matriz

de transicin est dada por:

P =

0.7 0.3

0.6 0.4

Si un da concreto est nublado, cul es la probabilidad de que est nublado

el da siguiente?

p

22

= 0.4

108 Cadenas de Markov

MATRIZ DE TRANSICIN EN VARIOS PASOS

Dada una cadena de Markov con k posibles estados s

1

, . . . , s

k

y matriz de transicin P

Si notamos p

(2)

ij

= P(X

n+2

= s

j

|X

n

= s

i

)

p

(2)

ij

: Elemento de la isima la y jsima columna de la matriz P

2

P

m

: Potencia msima de P, con (m = 2, 3, . . .) y

F p

(m)

ij

: Elemento de la la i y de la columna j de la matriz P

m

GENERALIZANDO

P

m

es la matriz de probabilidades p

(m)

ij

de que la cadena pase del estado s

i

al estado s

j

en m pasos; para cualquier valor de m, (m = 2, 3, . . .).

P

m

es la matriz de transicin de m pasos de la cadena de Markov

EJEMPLO

En el ejemplo del clima con matriz de transicin

P =

0.7 0.3

0.6 0.4

Si un mircoles est nublado, cul es la probabilidad de que el viernes

siguiente haga sol?

Calculamos la matriz de transicin en dos pasos,

P

2

=

0.67 0.33

0.66 0.34

=Probabilidad pedida es 0.66

Cadenas de Markov 109

VECTOR DE PROBABILIDADES INICIALES

VECTOR DE PROBABILIDADES

w = (w

1

, . . . , w

k

) se llama vector de probabilidades si

N w

i

0 para i = 1, . . . , k, y

N

k

X

i=1

w

i

= 1.

Consideramos una cadena de Markov con:

1. s

1

, . . . , s

k

posibles estados en los que la cadena puede estar en el tiempo

de observacin inicial n = 1

2. Para i = 1, . . . , k; P(X

1

= s

i

) = v

i

, con v

i

0 y v

1

+ . . . + v

k

= 1

VECTOR DE PROBABILIDADES INICIALES

El vector de probabilidades v = (v

1

, . . . , v

k

) se llama vector de proba-

bilidades iniciales de la cadena.

El vector de probabilidades iniciales y

la matriz de transicin determinan la probabilidad

para el estado de la cadena en el segundo instante de tiempo,

dicha probabilidad viene dada por el vector vP

Adems, si las probabilidades de los diversos estados en el instante n se

especican por el vector de probabilidades w, entonces

Las probabilidades en el instante n + 1

se especican por el vector de probabilidades wP

110 Cadenas de Markov

EJEMPLO

En el ejemplo del clima con matriz de transicin:

P =

0.7 0.3

0.6 0.4

Suponemos que la probabilidad de que el mircoles haga sol es 0.2 y la

probabilidad de que est nublado es 0.8.

Calcular:

1. Probabilidad de que est nublado el jueves.

2. Probabilidad de que est nublado el viernes.

3. Probabilidad de que est nublado el sbado.

Solucin

1. Mircoles: v = (0.2, 0.8) = w = vP = (0.62, 0.38)

P [ est nublado el jueves] = 0.38

2. w = vP = (0.62, 0.38) = vP

2

= vPP = wP = (0.662, 0.338)

P [ est nublado el viernes] = 0.338

3. vP

2

= (0.662, 0.338) =vP

3

= vP

2

P = (0.6662, 0.3338)

P [ est nublado el sbado] = 0.3338

Cadenas de Markov 111

EJEMPLO

Suponemos que en el ejemplo del locutorio telefnico los nmeros de lneas

que estn siendo utilizadas en los instantes de tiempo 1, 2, . . . constituyen

una cadena de Markov con probabilidades de transicin estacionarias.

Sea b

i

el estado en el que se estn utilizando exactamente i lneas en un

instante de tiempo determinado (i = 0, 1, . . . , 5)

Matriz de transicin P

P =

0.1 0.4 0.2 0.1 0.1 0.1

0.2 0.3 0.2 0.1 0.1 0.1

0.1 0.2 0.3 0.2 0.1 0.1

0.1 0.1 0.2 0.3 0.2 0.1

0.1 0.1 0.1 0.2 0.3 0.2

0.1 0.1 0.1 0.1 0.4 0.2

F Si las cinco lneas estn ocupadas en un instante de tiempo concreto.

P [ Exactamente 4 lneas ocupadas en el siguiente instante de tiempo] =

= p

65

= 0.4

F Si en un instante de tiempo no hay ninguna lnea ocupada.

P [ Al menos una lnea ocupada en el siguiente instante de tiempo] =

= 1 p

11

= 0.9

112 Cadenas de Markov

Matriz de transicin en dos pasos

P

2

=

0.14 0.23 0.2 0.15 0.16 0.12

0.13 0.24 0.2 0.15 0.16 0.12

0.12 0.2 0.21 0.18 0.17 0.12

0.11 0.17 0.19 0.2 0.2 0.13

0.11 0.16 0.16 0.18 0.24 0.15

0.11 0.16 0.15 0.17 0.25 0.16

F Si dos lneas estn ocupadas en un instante de tiempo concreto.

P [ Cuatro lneas ocupadas dos instantes despus] = 0.17

F Si en un instante de tiempo concreto hay tres lneas ocupadas.

P [ Dos instantes despus haya de nuevo tres lneas ocupadas] = 0.2

P

3

=

0.123 0.208 0.192 0.166 0.183 0.128

0.124 0.207 0.192 0.166 0.183 0.128

0.120 0.197 0.192 0.174 0.188 0.129

0.117 0.186 0.186 0.179 0.199 0.133

0.116 0.181 0.177 0.176 0.211 0.139

0.116 0.180 0.174 0.174 0.215 0.141

F Si las 5 lneas estn ocupadas en un instante de tiempo concreto.

P [ No haya lneas ocupadas tres instantes despus] = 0.116

Cadenas de Markov 113

F Si una lnea est ocupada en un instante de tiempo.

P [Tres instantes despus haya de nuevo una lnea ocupada] = 0.207

F Al inicio del proceso de observacin (instante n = 1)

P [ No haya lneas ocupadas] = 0.5

P [ Haya una lnea ocupada] = 0.3

P [ Haya dos lneas ocupadas] = 0.2

Vector de probabilidades iniciales: v =(0.5, 0.3, 0.2, 0, 0, 0)

vP =(0.13, 0.33, 0.22, 0.12, 0.1, 0.1) =

P [No haya lneas ocupadas en el instante 2] = 0.13

vP

2

= vPP = (0.1333, 0.227, 0.202, 0.156, 0.162, 0.12) =

P [Haya 2 lneas ocupadas en el instante 3] = 0.202

114 Cadenas de Markov

SUPUESTO PRCTICO DE

CADENA DE MARKOV

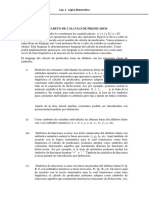

Consideremos el laberinto siguiente

Supongamos que introducimos un ratn de forma aleatoria en una de las

celdas de dicho laberinto.

Este ratn se traslada aleatoriamente de cada celda a una de las con-

tiguas.

PLANTEAMIENTO DE LA CADENA DE MARKOV

Y ESTUDIO

Denicin de las variables aleatorias

X

n

celda ocupada en el instante n

Cadenas de Markov 115

Estados

Los posibles estados son: 1, 2, 3, 4, 5 y 6

Comprobar que se trata de una cadena de Markov (comprobar la condicin

de Markov)

Conocido el presente,

el futuro no depende del pasado

Se cumple la condicin de Markov

Es una cadena de Markov

Probabilidades de transicin

p

ij

= P[X

n+1

= j|X

n

= i]

Matriz de transicin

p

11

p

12

p

13

p

14

p

15

p

16

p

21

p

22

p

23

p

24

p

25

p

26

p

31

p

32

p

33

p

34

p

35

p

36

p

41

p

42

p

43

p

44

p

45

p

46

p

51

p

52

p

53

p

54

p

55

p

56

p

61

p

62

p

63

p

64

p

65

p

66

116 Cadenas de Markov

Desde el estado 1

p

11

= P[X

n+1

= 1|X

n

= 1] p

12

= P[X

n+1

= 2|X

n

= 1]

p

13

= P[X

n+1

= 3|X

n

= 1] = 0 p

14

= P[X

n+1

= 4|X

n

= 1]

p

15

= P[X

n+1

= 5|X

n

= 1] = 0 p

16

= P[X

n+1

= 6|X

n

= 1] = 0

Desde el estado 2

p

21

= P[X

n+1

= 1|X

n

= 2] p

22

= P[X

n+1

= 2|X

n

= 2]

p

23

= P[X

n+1

= 3|X

n

= 2] = 0 p

24

= P[X

n+1

= 4|X

n

= 2] = 0

p

25

= P[X

n+1

= 5|X

n

= 2] = 0 p

26

= P[X

n+1

= 6|X

n

= 2] = 0

Cadenas de Markov 117

Desde el estado 3

p

31

= P[X

n+1

= 1|X

n

= 3] = 0 p

32

= P[X

n+1

= 2|X

n

= 3] = 0

p

33

= P[X

n+1

= 3|X

n

= 3] p

34

= P[X

n+1

= 4|X

n

= 3] = 0

p

35

= P[X

n+1

= 5|X

n

= 3] = 0 p

36

= P[X

n+1

= 6|X

n

= 3]

Desde el estado 4

p

41

= P[X

n+1

= 1|X

n

= 4] p

42

= P[X

n+1

= 2|X

n

= 4] = 0

p

43

= P[X

n+1

= 3|X

n

= 4] = 0 p

44

= P[X

n+1

= 4|X

n

= 4]

p

45

= P[X

n+1

= 5|X

n

= 4] = 0 p

46

= P[X

n+1

= 6|X

n

= 4] = 0

118 Cadenas de Markov

Desde el estado 5

p

51

= P[X

n+1

= 1|X

n

= 5] = 0 p

52

= P[X

n+1

= 2|X

n

= 5] = 0

p

53

= P[X

n+1

= 3|X

n

= 5] = 0 p

54

= P[X

n+1

= 4|X

n

= 5] = 0

p

55

= P[X

n+1

= 5|X

n

= 5] p

56

= P[X

n+1

= 6|X

n

= 5]

Desde el estado 6

p

61

= P[X

n+1

= 1|X

n

= 6] = 0 p

62

= P[X

n+1

= 2|X

n

= 6] = 0

p

63

= P[X

n+1

= 3|X

n

= 6] p

64

= P[X

n+1

= 4|X

n

= 6] = 0

p

65

= P[X

n+1

= 5|X

n

= 6] p

66

= P[X

n+1

= 6|X

n

= 6]

Cadenas de Markov 119

Son estacionarias las probabilidades de transicin?

p

ij

no depende del instante en que

se encuentre el proceso

las probabilidades de transicin son estacionarias

Matriz de transicin

P =

p

11

p

12

0 p

14

0 0

p

21

p

22

0 0 0 0

0 0 p

33

0 0 p

36

p

41

0 0 p

44

0 0

0 0 0 0 p

55

p

56

0 0 p

63

0 p

65

p

66

Matriz de transicin en dos pasos

P

2

Desde el estado 1

120 Cadenas de Markov

Matriz de transicin en dos pasos

p

(2)

11

= p

2

11

+ p

14

p

41

+ p

12

p

21

p

(2)

12

= p

12

p

22

+ p

11

p

12

p

(2)

14

= p

14

p

44

+ p

11

p

14

p

(2)

21

= p

21

p

11

+ p

22

p

21

p

(2)

22

= p

2

22

+ p

21

p

12

p

(2)

24

= p

21

p

14

p

(2)

33

= p

2

33

+ p

36

p

63

p

(2)

35

= p

36

p

65

p

(2)

36

= p

36

p

66

+ p

33

p

36

p

(2)

41

= p

41

p

11

+ p

44

p

41

p

(2)

42

= p

41

p

12

p

(2)

44

= p

2

44

+ p

41

p

14

p

(2)

53

= p

56

p

63

p

(2)

55

= p

2

55

+ p

56

p

65

p

(2)

56

= p

55

p

56

+ p

56

p

66

p

(2)

63

= p

63

p

33

+ p

66

p

63

p

(2)

65

= p

65

p

55

+ p

66

p

65

p

(2)

66

= p

2

66

+ p

63

p

36

+ p

65

p

56

Vector de probabilidades iniciales

v = (p

1

, p

2

, p

3

, p

4

, p

5

, p

6

)

P[estar en la celda 1 en el instante 1] = p

1

P[estar en la celda 2 en el instante 1] = p

2

P[estar en la celda 3 en el instante 1] = p

3

P[estar en la celda 4 en el instante 1] = p

4

P[estar en la celda 5 en el instante 1] = p

5

P[estar en la celda 6 en el instante 1] = p

6

Cadenas de Markov 121

Probabilidad de estar en cierta celda en el instante de tiempo 2

vP = ([p

1

p

11

+ p

2

p

21

+ p

4

p

41

], [p

1

p

12

+ p

2

p

22

], [p

3

p

33

+ p

6

p

63

],

[p

1

p

14

+ p

4

p

44

], [p

5

p

55

+ p

6

p

65

], [p

3

p

36

+ p

5

p

56

+ p

6

p

66

])

P[estar en la celda 1 en el instante 2] = p

1

p

11

+ p

2

p

21

+ p

4

p

41

P[estar en la celda 2 en el instante 2] = p

1

p

12

+ p

2

p

22

P[estar en la celda 3 en el instante 2] = p

3

p

33

+ p

6

p

63

P[estar en la celda 4 en el instante 2] = p

1

p

14

+ p

4

p

44

P[estar en la celda 5 en el instante 2] = p

5

p

55

+ p

6

p

65

P[estar en la celda 6 en el instante 2] = p

3

p

36

+ p

5

p

56

+ p

6

p

66

CASO A

Consideremos que la probabilidad de introducir el ratn en cada una de las

celdas del laberinto para comenzar el experimento es la misma. Una vez

dentro del laberinto el ratn se va a cualquier celda contigua o se queda

en la celda en la que est con la misma probabilidad.

Probabilidades de transicin

Desde el estado 1

p

11

= P[X

n+1

= 1|X

n

= 1] = 1/3 p

12

= P[X

n+1

= 2|X

n

= 1] = 1/3

p

13

= P[X

n+1

= 3|X

n

= 1] = 0 p

14

= P[X

n+1

= 4|X

n

= 1] = 1/3

p

15

= P[X

n+1

= 5|X

n

= 1] = 0 p

16

= P[X

n+1

= 6|X

n

= 1] = 0

122 Cadenas de Markov

Desde el estado 2

p

21

= P[X

n+1

= 1|X

n

= 2] = 1/3 p

22

= P[X

n+1

= 2|X

n

= 2] = 1/3

p

23

= P[X

n+1

= 3|X

n

= 2] = 0 p

24

= P[X

n+1

= 4|X

n

= 2] = 1/3

p

25

= P[X

n+1

= 5|X

n

= 2] = 0 p

26

= P[X

n+1

= 6|X

n

= 2] = 0

Desde el estado 3

p

31

= P[X

n+1

= 1|X

n

= 3] = 0 p

32

= P[X

n+1

= 2|X

n

= 3] = 0

p

33

= P[X

n+1

= 3|X

n

= 3] = 1/2 p

34

= P[X

n+1

= 4|X

n

= 3] = 0

p

35

= P[X

n+1

= 5|X

n

= 3] = 0 p

36

= P[X

n+1

= 6|X

n

= 3] = 1/2

Desde el estado 4

p

41

= P[X

n+1

= 1|X

n

= 4] = 1/2 p

42

= P[X

n+1

= 2|X

n

= 4] = 0

p

43

= P[X

n+1

= 3|X

n

= 4] = 0 p

44

= P[X

n+1

= 4|X

n

= 4] = 1/2

p

45

= P[X

n+1

= 5|X

n

= 4] = 0 p

46

= P[X

n+1

= 6|X

n

= 4] = 0

Desde el estado 5

p

51

= P[X

n+1

= 1|X

n

= 5] = 0 p

52

= P[X

n+1

= 2|X

n

= 5] = 0

p

53

= P[X

n+1

= 3|X

n

= 5] = 0 p

54

= P[X

n+1

= 4|X

n

= 5] = 0

p

55

= P[X

n+1

= 5|X

n

= 5] = 1/2 p

56

= P[X

n+1

= 6|X

n

= 5] = 1/2

Cadenas de Markov 123

Desde el estado 6

p

61

= P[X

n+1

= 1|X

n

= 6] = 0 p

62

= P[X

n+1

= 2|X

n

= 6] = 0

p

63

= P[X

n+1

= 3|X

n

= 6] = 1/3 p

64

= P[X

n+1

= 4|X

n

= 6] = 0

p

65

= P[X

n+1

= 5|X

n

= 6] = 1/3 p

66

= P[X

n+1

= 6|X

n

= 6] = 1/3

Matriz de transicin

P =

1/3 1/3 0 1/3 0 0

1/2 1/2 0 0 0 0

0 0 1/2 0 0 1/2

1/2 0 0 1/2 0 0

0 0 0 0 1/2 1/2

0 0 1/3 0 1/3 1/3

Vector de probabilidades iniciales

v =

1

6

,

1

6

,

1

6

,

1

6

,

1

6

,

1

6

F P[estar en la celda 1 en el instante 1] =

1

6

F P[estar en la celda 2 en el instante 1] =

1

6

F P[estar en la celda 3 en el instante 1] =

1

6

F P[estar en la celda 4 en el instante 1] =

1

6

124 Cadenas de Markov

F P[estar en la celda 5 en el instante 1] =

1

6

F P[estar en la celda 6 en el instante 1] =

1

6

Probabilidad de estar en cierta celda en el instante de tiempo 2

vP =

2

9

,

5

36

,

5

36

,

5

36

,

5

36

,

2

9

P[ Celda 1 en el instante 2] =

2

9

P[ Celda 2 en el instante 2] =

5

36

P[ Celda 3 en el instante 2] =

5

36

P[ Celda 4 en el instante 2] =

5

36

P[ Celda 5 en el instante 2] =

5

36

P[ Celda 6 en el instante 2] =

2

9

CASO B

Supongamos que en el laberinto el ratn se traslada a celdas contiguas con

igual probabilidad y que la probabilidad de introducir el ratn en cada una

de las celdas del laberinto para comenzar el experimento es

P[X

1

= 1] = 0.2 P[X

1

= 2] = 0.2 P[X

1

= 3] = 0.1

P[X

1

= 4] = 0.05 P[X

1

= 5] = 0.05 P[X

1

= 6] = 0.4

Cadenas de Markov 125

Matriz de transicin

P =

1/3 1/3 0 1/3 0 0

1/2 1/2 0 0 0 0

0 0 1/2 0 0 1/2

1/2 0 0 1/2 0 0

0 0 0 0 1/2 1/2

0 0 1/3 0 1/3 1/3

Vector de probabilidades iniciales

v =

2

10

,

2

10

,

1

10

,

5

100

,

5

100

,

4

10

P[Celda 1 en el instante 1] = 0.2 P[Celda 2 en el instante 1] = 0.2

P[Celda 3 en el instante 1] = 0.1 P[Celda 4 en el instante 1] = 0.05

P[Celda 5 en el instante 1] = 0.05 P[Celda 6 en el instante 1] = 0.4

En el instante 2: Calculamos vP

vP = (0.191666, 0.1666, 0.18333, 0.091666, 0.158333, 0.208333)

P[Celda 1, instante 2] = 0.191666 P[Celda 2, instante 2] = 0.1666

P[Celda 3, instante 2] = 0.1666 P[Celda 4, instante 2] = 0.091666

P[Celda 5, instante 2] = 0.158333 P[Celda 6, instante 2] = 0.208333

126 Cadenas de Markov

CASO C

Supongamos ahora que, en el laberinto el ratn ir a una celda contigua

con probabilidad proporcional al nmero de la celda y que la probabilidad

de introducir el ratn en cada una de las celdas del laberinto para comenzar

el experimento es la misma.

Matriz de transicin

P =

1/7 2/7 0 4/7 0 0

1/3 2/3 0 0 0 0

0 0 3/9 0 0 6/9

1/5 0 0 0 4/5 0

0 0 0 0 5/11 6/11

0 0 3/14 0 5/14 6/14

Vector de probabilidades iniciales

v =

1

6

,

1

6

,

1

6

,

1

6

,

1

6

,

1

6

P[Celda 1 en el instante 1] =

1

6

P[Celda 2 en el instante 1] =

1

6

P[Celda 3 en el instante 1] =

1

6

P[Celda 4 en el instante 1] =

1

6

P[Celda 5 en el instante 1] =

1

6

P[Celda 6 en el instante 1] =

1

6

Cadenas de Markov 127

En el instante 2: Calculamos vP

vP =

71

630

,

10

63

,

23

252

,

8

35

,

125

924

,

379

1386

P[Celda 1 en el instante 2] =

71

630

P[Celda 2 en el instante 2] =

10

63

P[Celda 3 en el instante 2] =

23

252

P[Celda 4 en el instante 2] =

8

35

P[Celda 5 en el instante 2] =

125

924

P[Celda 6 en el instante 2] =

379

1386

Bibliografa utilizada:

F D.R. Cox, H.D. Miller (1970). The Theory Stochastic Processes. Methuen.

F A.T. Bharucha-Reid (1960). Elements Of The Theory of Markov Processes And

Their Applications. McGraw Hill Series in Probability and Statistics.

Temporalizacin: Cuatro horas

También podría gustarte

- Unidad 4 Cadenas de MarkovDocumento19 páginasUnidad 4 Cadenas de MarkovCristofer MagañaAún no hay calificaciones

- Flipbook FraccionesDocumento3 páginasFlipbook FraccionesSara Ayesh50% (2)

- Cadenas de MarkovDocumento15 páginasCadenas de MarkovMagbep100% (1)

- Criterios de PrimalidadDocumento61 páginasCriterios de Primalidadfezal_08100% (2)

- Metodos Matematicos para Sistemas Lineales PDFDocumento472 páginasMetodos Matematicos para Sistemas Lineales PDFpepito pela papas100% (1)

- Cadenas de MarkovDocumento17 páginasCadenas de MarkovNely Gámez MokayAún no hay calificaciones

- Cadenas de Markov 2010 IIDocumento129 páginasCadenas de Markov 2010 IIroberto1809100% (3)

- Cadenas MarkovDocumento68 páginasCadenas MarkovRamón Flores RodríguezAún no hay calificaciones

- Resumen Cadena MarkovDocumento10 páginasResumen Cadena MarkovLiliMarcce0% (1)

- Act 2 Tema 4Documento15 páginasAct 2 Tema 4Gabriel Salas alonsoAún no hay calificaciones

- Procesos EstocasticosDocumento73 páginasProcesos EstocasticosYoleidy Huerfano100% (1)

- Proceso de Markov Cap IVDocumento39 páginasProceso de Markov Cap IVsmith palaciosAún no hay calificaciones

- Unidad 4 Cadenas de MarkovDocumento13 páginasUnidad 4 Cadenas de MarkovJesus Esteban Cota DominguezAún no hay calificaciones

- Lectura Fundamental 4Documento16 páginasLectura Fundamental 4'Nicolás Niño'Aún no hay calificaciones

- MarkovDocumento11 páginasMarkovvictorAún no hay calificaciones

- Cadenas de MarkovDocumento12 páginasCadenas de MarkovDanielaAún no hay calificaciones

- Elementos de Cadenas de MarkovDocumento28 páginasElementos de Cadenas de MarkovIvan Alex Apaza0% (1)

- 3 Cadenas Markov Procesos DiscretosDocumento184 páginas3 Cadenas Markov Procesos DiscretosCynthia0015Aún no hay calificaciones

- Cadena de Markov - Poisson - Martingala - Mov BrownianoDocumento10 páginasCadena de Markov - Poisson - Martingala - Mov BrownianoEnoc BarrigaAún no hay calificaciones

- Markov ChainDocumento32 páginasMarkov ChainmemfilmatAún no hay calificaciones

- MarkovDocumento32 páginasMarkovNicolas Gomez100% (1)

- Aplicación Cadenas de Markov en Tiempo DiscretoDocumento7 páginasAplicación Cadenas de Markov en Tiempo DiscretoBarbaraAún no hay calificaciones

- Tema 6Documento13 páginasTema 6Oliver CastilloAún no hay calificaciones

- Ta - Inv - Oper.-6-5-Zurita-Avalos-JesusDocumento19 páginasTa - Inv - Oper.-6-5-Zurita-Avalos-JesusJesus ZuritaAún no hay calificaciones

- Cadenas de Markov - Dr. Joaquín Ortega Sánchez CIMAT PDFDocumento41 páginasCadenas de Markov - Dr. Joaquín Ortega Sánchez CIMAT PDFasdAún no hay calificaciones

- PNL y MARKOVDocumento4 páginasPNL y MARKOVMary Cruz Meza CahuanaAún no hay calificaciones

- Clasificación de Los Estados de La Cadena de Markov y Matriz de TransiciónDocumento38 páginasClasificación de Los Estados de La Cadena de Markov y Matriz de TransicióncarlosAún no hay calificaciones

- Cadenas de Markov 2.1 (M14)Documento69 páginasCadenas de Markov 2.1 (M14)Jorge AvilaAún no hay calificaciones

- Análisis de MarcovDocumento18 páginasAnálisis de MarcovKELLY KIARA VELEZ AGUILARAún no hay calificaciones

- Unidad 4 y 5Documento43 páginasUnidad 4 y 5Karla LiceaAún no hay calificaciones

- Cadenas de MarkovDocumento48 páginasCadenas de MarkovCharly KodeAún no hay calificaciones

- Sesión Cadenas de MarkovDocumento29 páginasSesión Cadenas de MarkovEliza H. AguilarAún no hay calificaciones

- Cadenas de Markov Informe CorregidoDocumento14 páginasCadenas de Markov Informe CorregidojoegeAún no hay calificaciones

- Cadenas de MarkovDocumento18 páginasCadenas de MarkovCIELOCIAún no hay calificaciones

- Cadenas de MarkovDocumento41 páginasCadenas de MarkovAleja Sanchez50% (2)

- Cadenas de Markov para Procesos Estocasticos (LATEX)Documento3 páginasCadenas de Markov para Procesos Estocasticos (LATEX)Raul SantoyAún no hay calificaciones

- Markov EjerciciosDocumento19 páginasMarkov Ejerciciosstinger037Aún no hay calificaciones

- R 66900Documento30 páginasR 66900as_oleo_mys_ca100% (1)

- Tarea 1Documento4 páginasTarea 1Leslie AguilarAún no hay calificaciones

- Cadenas de Markov 12Documento40 páginasCadenas de Markov 12Astrid SandovalAún no hay calificaciones

- Cadenas de Markov Informe CorregidoDocumento14 páginasCadenas de Markov Informe CorregidojoegeAún no hay calificaciones

- Meio 2Documento42 páginasMeio 2Cèsar Enrique Racer FestAún no hay calificaciones

- Cadenas de MarkovDocumento21 páginasCadenas de MarkovJrn WilliamAún no hay calificaciones

- Procesos Estocásticos - Cadenas de MarkovDocumento16 páginasProcesos Estocásticos - Cadenas de MarkovRafaelAún no hay calificaciones

- Cadenas de MarkovDocumento10 páginasCadenas de MarkovLUIS EMANUEL RAMOS ARZATEAún no hay calificaciones

- Cadenas de Márkov en Tiempo Discreto-2022Documento10 páginasCadenas de Márkov en Tiempo Discreto-2022DIEGO LEONARDO BLACIDO HERNANDEZAún no hay calificaciones

- A.A.2 Investigacion de Operaciones LLDocumento18 páginasA.A.2 Investigacion de Operaciones LLEnrique GonzalezAún no hay calificaciones

- Ejercicios Procesos Estocasticos, Cadenas de Markov DiscretasDocumento4 páginasEjercicios Procesos Estocasticos, Cadenas de Markov DiscretasJUAN DAVID ALVAREZ GAMEZ100% (1)

- Cadenas de MarkovDocumento37 páginasCadenas de MarkovCarlos Nava100% (1)

- Cadenas de Markov2Documento9 páginasCadenas de Markov2Paola Andrea VelezAún no hay calificaciones

- Eduardo - Cristian U3 Parte 1 - Cadenas MarkovDocumento14 páginasEduardo - Cristian U3 Parte 1 - Cadenas MarkovEduardo LesseyAún no hay calificaciones

- Una Cadena de MarkovDocumento22 páginasUna Cadena de MarkovCynthya Mercedes MontesAún no hay calificaciones

- 2 Cadenas de MarkovDocumento43 páginas2 Cadenas de MarkovgustavobenitesAún no hay calificaciones

- Cadema MarkovDocumento54 páginasCadema MarkovVanesa RojasAún no hay calificaciones

- Tecnológico Nacional de México: PeríodoDocumento20 páginasTecnológico Nacional de México: PeríodoWendy Estefania Saldivar CuervoAún no hay calificaciones

- Cadena de Markov1Documento7 páginasCadena de Markov1anon_615179342Aún no hay calificaciones

- Cadenas de Marko-ResumenDocumento16 páginasCadenas de Marko-ResumenArturo CLorcaAún no hay calificaciones

- Io2 1Documento23 páginasIo2 1Cristina Huañapaco GutierrezAún no hay calificaciones

- CADENASDEMARKOVU4Documento18 páginasCADENASDEMARKOVU4Raul Duron SotoAún no hay calificaciones

- Las Cadenas de MarkovDocumento10 páginasLas Cadenas de MarkovGlenny Noemi Guerrero Gonzalez0% (1)

- 50 Aplicaciones de DerivadaDocumento8 páginas50 Aplicaciones de DerivadaWalter LescanoAún no hay calificaciones

- Resumen Sistema de EcuacionesDocumento3 páginasResumen Sistema de Ecuacionescristopher leon marceloAún no hay calificaciones

- Unidad IV. Programación EnteraDocumento5 páginasUnidad IV. Programación EnteraFernanda G FigueroaAún no hay calificaciones

- Cartilla CPrIUn2018 3 PolinomiosDocumento15 páginasCartilla CPrIUn2018 3 PolinomiosGonzalo Matias MartínezAún no hay calificaciones

- Cadenas de MarkovDocumento5 páginasCadenas de Markovalejandragdo26100% (1)

- Cov y CTRVDocumento2 páginasCov y CTRVjalizarazoaAún no hay calificaciones

- 6to Grado - OPERADORES MATEMÁTICOSDocumento5 páginas6to Grado - OPERADORES MATEMÁTICOSandersonAún no hay calificaciones

- m7 - Mapa - U1 MATEMATICASDocumento1 páginam7 - Mapa - U1 MATEMATICASClaudia EsperanzaAún no hay calificaciones

- Calculo de Predicadoa-Corregido FinalDocumento9 páginasCalculo de Predicadoa-Corregido FinalDarwin Db'Aún no hay calificaciones

- Guía CincoDocumento3 páginasGuía CincoAyelen DuránAún no hay calificaciones

- Ejercicios de Tarea de La Unidad IIDocumento7 páginasEjercicios de Tarea de La Unidad IIMariana Mojica DiazAún no hay calificaciones

- Tabla Con Los Valores de Las Razones Trigonométricas de Los Siguientes ÁngulosDocumento2 páginasTabla Con Los Valores de Las Razones Trigonométricas de Los Siguientes Ángulosluispdzp88% (50)

- FACTORIZACIÓN2Documento36 páginasFACTORIZACIÓN2RodEx007Aún no hay calificaciones

- Deber 8Documento2 páginasDeber 8Suanny CasaresAún no hay calificaciones

- Trabajo Sobre La Probabilidad, Permutaciones Taller 1Documento9 páginasTrabajo Sobre La Probabilidad, Permutaciones Taller 1Evanis RomeroAún no hay calificaciones

- Evaluacion ParcialDocumento6 páginasEvaluacion Parcial73187511Aún no hay calificaciones

- Practica de Matematica AvanzadaDocumento9 páginasPractica de Matematica AvanzadaDeam AlvaAún no hay calificaciones

- Miscelanea 1 para El Examen Final-72-74Documento3 páginasMiscelanea 1 para El Examen Final-72-74Santhier Mosquera AmpudiaAún no hay calificaciones

- 421 Tarea 2-Erly Sarmiento.Documento14 páginas421 Tarea 2-Erly Sarmiento.Jose Ricardo Araujo PerezAún no hay calificaciones

- Resumen de Factor ComúnDocumento8 páginasResumen de Factor Comúnyeiner mauricio quinto mosqueraAún no hay calificaciones

- Segundo Examen Parcial - Revisión Del IntentoDocumento8 páginasSegundo Examen Parcial - Revisión Del IntentoJuan Manuel De los santosAún no hay calificaciones

- Apunte ProgresionesDocumento6 páginasApunte Progresionesandrea0% (1)

- Parte KatiaDocumento17 páginasParte KatiaAmelia RodriguezAún no hay calificaciones

- RectaDocumento3 páginasRectajuanAún no hay calificaciones

- Taller 2Documento2 páginasTaller 2Diego Fernando Sanchez CarrilloAún no hay calificaciones

- Introduccion Calculo IntegralDocumento4 páginasIntroduccion Calculo IntegralSANTIAGO BELTRAN GONZALEZAún no hay calificaciones

- Guía - Cómo IntegrarDocumento3 páginasGuía - Cómo IntegrarDavidAún no hay calificaciones