Documentos de Académico

Documentos de Profesional

Documentos de Cultura

2 Cadenas de Markov

Cargado por

gustavobenitesDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

2 Cadenas de Markov

Cargado por

gustavobenitesCopyright:

Formatos disponibles

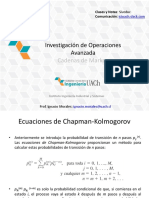

Investigacin Operativa 2

Captulo 2: Cadenas de Markov

Profesor: Eduardo Carbajal

2

NDICE

1. Definicin de procesos estocsticos.

2. Definicin de cadenas de Markov.

3. Probabilidad de transicin de n etapas.

4. Clasificacin de estados de una cadena de Markov.

5. Probabilidades de estado estable.

6. Tiempo promedio de primera pasada.

7. Cadenas de Markov con recompensa.

8. Cadenas de Markov absorbentes.

3

1. Definicin de procesos estocsticos

Un proceso estocstico discreto en el tiempo es una

descripcin de la relacin entre las variables aleatorias

X

0,

X

1,

X

2

.. X

n

Ejemplo 2.1

X

t

= Temperatura mxima registrada en cada da del ao en la

ciudad de Lima.

Ejemplo 2.2

X

t

= Cantidad de alumnos que egresan semestralmente en la

especialidad de ingeniera industrial (PUCP).

Ejemplo 2.3

X

t

= El precio de una accin en la BVL al inicio del da.

4

2. Definicin de cadenas de Markov (1)

Un tipo especial de procesos estocsticos de tiempo discreto se

llama cadena de Markov.

Para simplificar supondremos que en cualquier tiempo, el proceso

estocstico de tiempo discreto puede estar en uno de un nmero

finito de estados identificados por 1,2,...s.

Un proceso estocstico de tiempo discreto es una cadena de

Markov, si para t = 0,1,2 y todos los estados

P(X

t+1

= i

t+1

|X

t

= i

t

, X

t-1

=i

t-1

,,X

1

=i

1

, X

0

=i

0

) = P(X

t+1

=i

t+1

|X

t

= i

t

)

En esencia, la distribucin de probabilidad del estado en el tiempo

t+1 depende del estado t (en i

t

) y no depende de los estados por

los cuales pas la cadena para llegar a i

t

en el tiempo t.

5

Las p

ij

s se denominan probabilidades de transicin para la

cadena de Markov.

Esta ecuacin implica que la ley de probabilidad que relaciona el

estado del siguiente periodo con el estado actual no cambia en el

tiempo.

Por esta razn se le llama Suposicin Estacionaria y cualquier

cadena de Markov que satisface esta condicin es llamada

cadena de Markov estacionaria.

Tambin definimos q

i

como la probabilidad de que la cadena est

en el estado i en el tiempo 0; en otras palabras, P(X

0

=i) = q

i

.

2. Definicin de cadenas de Markov (2)

6

Llamamos al vector q= [q

1

, q

2

,q

s

] distribucin de

probabilidad inicial para la cadena de Markov.

En la mayora de las aplicaciones, las probabilidades de

transicin se muestran como una matriz de probabilidades

de transicin P de orden s x s. La matriz de probabilidad de

transicin P se puede escribir como

(

(

(

(

=

ss s s

s

s

p p p

p p p

p p p

P

2 1

2 22 21

1 12 11

2. Definicin de cadenas de Markov (3)

7

Dado que el estado es i en el tiempo t, el proceso debe estar

en algn lugar en el tiempo t+1. Esto significa que para cada i,

j=1,s

P(X

t+1

=j / X

t=i

) =

j=1,s

p

ij

= 1

Tambin sabemos que cada elemento de la matriz P debe ser

no negativo (p

ij

> 0).

Por lo tanto, todos los elementos de la matriz de probabilidad

de transicin son no negativos; los elementos de cada fila

deben sumar 1.

2. Definicin de cadenas de Markov (4)

8

Problema 2.1

Supongamos, que en Lima, si un da est nublado, el

90% del tiempo ser nublado al da siguiente y que si

un da est soleado, con probabilidad 30% ser

soleado al da siguiente.

Halle la Matriz de Probabilidades de Transicin.

2. Definicin de cadenas de Markov (5)

9

Problema 2.2

El estado de nimo de Juan puede ser, alegre, triste o

molesto. Si est alegre, habr una probabilidad de

80% de que siga alegre al da siguiente y 15% de que

est triste. Si est triste, 30% de que siga triste y 50%

de que est molesto. Y, si est molesto, 80% de que

no siga molesto y 50% de que est alegre al da

siguiente.

Halle la Matriz de Probabilidades de Transicin.

2. Definicin de cadenas de Markov (6)

10

Problema 2.3

Considere que para ver el comportamiento de una accin, se

toma en cuenta lo siguiente: Si la accin sube o no maana

depende de si subi o no hoy y ayer.

Si la accin subi hoy y ayer, maana subir con

probabilidad a.

Si la accin subi hoy y ayer baj, maana subir con

probabilidad b.

Si la accin baj hoy y ayer subi, la probabilidad de que

suba maana es c.

Si la accin baj hoy y ayer, la probabilidad de que suba

maana es d.

Halle la Matriz de Probabilidades de Transicin.

2. Definicin de cadenas de Markov (7)

11

3. Probabilidad de transicin de n

etapas (1)

Si una cadena de Markov se encuentra en el estado i

en el tiempo m, la probabilidad de que n periodos

despus la cadena de Markov est en el estado j es:

p

ij

(n) = P(X

m+n

= j / X

m

= i) = P(X

n

= j / X

0

= i)

donde p

ij

(n) se llama probabilidad de n pasos

12

Problema 2.4

Una fotocopiadora de oficina, poco segura tiene el siguiente

comportamiento: si est funcionando un da, existe un 75% de

probabilidades de que al da siguiente funcione y un 25% de

probabilidades de que no funcione. Pero si no est funcionando,

hay un 75% de probabilidades de que tampoco funcione al da

siguiente y slo un 25% de que si lo haga.

a) Si actualmente la fotocopiadora est funcionando, cul es la

probabilidad que est funcionando dentro de dos das?

b) Si actualmente la fotocopiadora no est funcionando, cul es la

probabilidad que no est funcionando dentro de tres das?

3. Probabilidad de transicin de n

etapas (2)

13

Definicin

Dados dos estados i y j, una trayectoria de i a j es una

secuencia de transiciones que comienza en i y termina

en j, tal que cada transicin en la secuencia tiene una

probabilidad positiva de ocurrir.

Definicin

Un estado j es alcanzable desde el estado i si hay una

trayectoria que conduzca de i a j.

4. Clasificacin de estados de una

cadena de Markov (1)

14

Definicin

Dos estados i y j se comunican si j es alcanzable

desde i, e i es alcanzable desde j.

Definicin

un conjunto de estados S en una cadena de Markov es

un conjunto cerrado si ningn estado fuera de S es

alcanzable desde algn estado en S.

4. Clasificacin de estados de una

cadena de Markov (2)

15

4. Clasificacin de estados de una

cadena de Markov (3)

Ejemplo 2.4

Identifique los estados de la matriz de transicin de la

cadena de Markov mostrada.

(

(

(

(

(

(

=

2 . 0 8 . 0 0 0 0

1 . 0 4 . 0 5 . 0 0 0

0 7 . 0 3 . 0 0 0

0 0 0 5 . 0 5 . 0

0 0 0 6 . 0 4 . 0

P

16

1

2

0.40

0.50

0.60

0.50

3

4

0.3

0.4

0.5

0.7

0.1

5

0.2

0.8

4. Clasificacin de estados de una

cadena de Markov (4)

17

El estado 5 es alcanzable desde el estado 3.

El estado 5 no es alcanzable desde el estado 1.

Los estados 1 y 2 se comunican.

S

1

= {1, 2} y S

2

= {3, 4, 5} son conjuntos cerrados.

4. Clasificacin de estados de una

cadena de Markov (5)

18

Definicin

Un estado i es un estado absorbente si p

ii

=1.

Definicin

Un estado i es un estado transitorio si existe un estado

j que es alcanzable desde i, pero el estado i no es

alcanzable desde el estado j.

Definicin

Si un estado no es transitorio, se llama estado

recurrente.

4. Clasificacin de estados de una

cadena de Markov (6)

19

Ejemplo 2.5

Identifique los estados de la matriz de transicin de la

cadena de Markov mostrada.

4. Clasificacin de estados de una

cadena de Markov (7)

(

(

(

(

(

(

=

0 0 0 0 1

0 67 . 0 33 . 0 0 0

0 0 1 0 0

0 0 0 5 . 0 5 . 0

0 0 0 75 . 0 25 . 0

P

20

1

2

0.25 0.50

0.75

0.50

5

3

4

1

0.67

0.33

1

4. Clasificacin de estados de una

cadena de Markov (8)

21

4. Clasificacin de estados de una

cadena de Markov (9)

El estado 3 es absorbente.

Los estados 4 y 5 son transitorios.

Los estados 1 y 2 son recurrentes.

22

Definicin

Un estado i es peridico con periodo k > 1, si k

es el nmero ms pequeo tal que las

trayectorias que conducen del estado i de

regreso al estado i tienen una longitud que es un

mltiplo de k. Si un estado recurrente no es

peridico, se conoce como aperidico.

4. Clasificacin de estados de una

cadena de Markov (10)

23

4. Clasificacin de estados de una

cadena de Markov (11)

Ejemplo 2.6

Determinar si los estados de la cadena de Markov

mostrada son aperodicos o no.

(

(

(

=

0 0 1

1 0 0

0 1 0

P

24

1

2

3

1

1 1

4. Clasificacin de estados de una

cadena de Markov (12)

Cada estado tiene perodo 3

25

Definicin

Si los estados en una cadena de Markov son

recurrentes, aperidicos y se comunican entre s,

se dice que la cadena es ergdica.

4. Clasificacin de estados de una

cadena de Markov (13)

26

4. Clasificacin de estados de una

cadena de Markov (14)

Ejemplo 2.7

Evaluar la siguiente cadena de Markov.

(

(

(

=

75 . 0 25 . 0 1

50 . 0 0 50 . 0

0 67 . 0 33 . 0

P

27

1

2

0.33

0.67

0.50

3

0.75

0.50

0.25

4. Clasificacin de estados de una

cadena de Markov (15)

La cadena de Markov es ergdica

28

5. Probabilidades de estado estable (1)

Las probabilidades de estado estable se usan para

describir el comportamiento a largo plazo de las

cadenas de Markov.

Teorema 1: Sea P la matriz de transicin de una

cadena de Markov ergdica. Existe entonces un vector

= [

1

2

s

] tal que

(

(

(

(

=

s

s

s

n

n

P

t t t

t t t

t t t

2 1

2 1

2 1

lim

29

El teorema 1 establece que para cualquier estado

inicial i,

El vector = [

1

2

s

] se llama distribucin

de estado estable, o tambin distribucin de

equilibrio, para la cadena de Markov.

j ij

n

n P t =

) ( lim

5. Probabilidades de estado estable (2)

30

Observe que para n grande, P

n

tiende a una

matriz con filas idnticas. Esto quiere decir que

despus de largo tiempo, la cadena de Markov se

estabiliza e, independientemente del estado

inicial i, hay una probabilidad

j

de que nos

encontremos en el estado j.

5. Probabilidades de estado estable (3)

31

Las

j

satisfacen de manera nica el siguiente

sistema de ecuaciones:

Adems

=

=

=

s k

k

kj k j

p

1

t t

1 ...

2 1

= + + +

s

t t t

5. Probabilidades de estado estable (4)

32

Problema 2.5

Las compras de los consumidores estn influidas por la

publicidad, el precio y muchos otros factores. Con

frecuencia un factor clave es la ltima compra del

consumidor.

De hecho, una investigacin de mercado puede

determinar el grado de lealtad a la marca encuestando a

los consumidores. En trminos de cadenas de Markov,

los resultados de la investigacin son las probabilidades

de transicin de seguir con la marca o de cambiar.

5. Probabilidades de estado estable (5)

33

Problema 2.5 (continuacin)

En la siguiente cadena de Markov, la marca A es la

marca de inters, y la marca B representa todas las

dems marcas. Los clientes son bastante leales, el 80%

de ellos son clientes que vuelven a comprar el producto.

La oposicin conserva el 70% de sus clientes.

Qu porcentaje del mercado esperar recibir el

fabricante de la marca A en el largo plazo?

5. Probabilidades de estado estable (6)

34

6. Tiempos promedio de primera

pasada (1)

Para una cadena ergdica, sea m

ij

= nmero esperado

de transiciones antes de llegar por primera vez al

estado j, dado que en la actualidad nos encontramos

en el estado i; m

ij

se llama tiempo promedio de

primera pasada del estado i al estado j.

35

6. Tiempos promedio de primera

pasada (2)

Para obtener los tiempos promedio de primera pasada,

se necesitan resolver las ecuaciones lineales

Cuando i=j, m

jj

se llama tiempo promedio de

recurrencia. Se puede demostrar que:

=

+ =

j k

kj ik ij

m p m 1

i

ii

m

t

1

=

36

6. Tiempos promedio de primera

pasada (3)

Problema 2.6

Una computadora se inspecciona cada hora. Se

encuentra que est trabajando o descompuesta. Si

est trabajando, la probabilidad de que siga trabajando

la siguiente hora es 0.90. Si est descompuesta, se

repara, lo que puede llevar ms de una hora. Siempre

que la computadora esta descompuesta, la

probabilidad de que siga descompuesta la siguiente

hora es 0.35.

Encontrar las m

ij

.

37

7. Cadenas de Markov con recompensa

El costo promedio a largo plazo, por unidad de

tiempo est dado por:

=

=

=

s k

k

j j

C g

1

t

38

8. Cadenas de Markov absorbentes (1)

Una cadena de Markov es absorbente si tiene por lo

menos un estado absorbente, y es posible ir desde

cada estado no absorbente hasta por lo menos un

estado absorbente.

Para toda cadena de Markov absorbente se desea

conocer:

Si la cadena comienza en un estado determinado

transitorio, y antes de alcanzar un estado absorbente,

cul es el nmero esperado de veces que se llegar a un

estado? Cuntos periodos esperamos pasar en un

determinado estado transitorio antes que se efecte la

absorcin?

Si una cadena inicia en un estado transitorio dado, cul

es la probabilidad de terminar en cada uno de los estados

absorbentes?

39

Para contestar estas preguntas necesitamos formular

la matriz de transicin con los estados en una lista con

el siguiente orden: primero los estados transitorios y

despus los absorbentes. Para precisar, se supondr

que hay s-m estados transitorios y m estados

absorbentes. Entonces la matriz de transicin para la

cadena de absorcin puede escribirse como sigue:

s-m

columnas

m columnas

s - m filas Q R

m filas O I

8. Cadenas de Markov absorbentes (2)

40

As tenemos:

I es una matriz identidad de orden m x m que representa

las probabilidades de permanecer dentro de un estado

absorbente.

Q es una matriz de orden (s-m) x (s-m) que representa

las probabilidades de ir de un estado transitorio hasta otro

estado transitorio.

R es una matriz de orden (s-m) x m que representa las

probabilidades de ir de un estado transitorio hasta un

estado absorbente.

O es una matriz nula de orden m x (s-m) que representa

las probabilidades de ir de un estado absorbente hasta un

estado transitorio.

8. Cadenas de Markov absorbentes (3)

41

En base a esto, es posible determinar:

- El nmero esperado de veces que se llegar a un estado:

(I - Q)

-1

- El nmero de periodos que esperamos pasar en un

determinado estado transitorio antes que se efecte la

absorcin: (I - Q)

-1

- La probabilidad de terminar en cada uno de los estados

absorbentes: (I - Q)

-1

R

8. Cadenas de Markov absorbentes (4)

42

Problema 2.7

Un contralor proporciona, a travs del anlisis de cuentas por

cobrar pasadas, los datos que se muestran en la tabla siguiente.

Cuenta por

cobrar con

retraso de

0-30 das

Cuenta por

cobrar con

retraso de

31-90 das

Cuenta

pagada

Deuda

morosa

Cuenta por cobrar con

retraso de 0-30 das

0.4 0.1 0.5 0

Cuenta por cobrar con

retraso de 31-90 das

0.1 0.2 0.6 0.1

Cuenta pagada 0 0 1 0

Deuda morosa 0 0 0 1

8. Cadenas de Markov absorbentes (5)

43

Problema 2.7 (continuacin)

El balance de cuentas por cobrar indica que se tiene I/.60,000.00

en cuentas por cobrar con retraso entre 0 y 30 das, y

I/.40,000.00 en cuentas por cobrar con retraso entre 30 y 90

das. Cul debe ser la concesin diaria?

8. Cadenas de Markov absorbentes (6)

También podría gustarte

- Trabajo Final de Cadenas de MarkovDocumento20 páginasTrabajo Final de Cadenas de MarkovThomas Mcdonald0% (2)

- Cadenas de Markov: Análisis de transiciones de estadosDocumento33 páginasCadenas de Markov: Análisis de transiciones de estadosMiguel Angel Iribe Zazueta100% (1)

- Cadenas de Markov 2010 IIDocumento129 páginasCadenas de Markov 2010 IIroberto1809100% (3)

- Investigación de Operaciones II U4Documento19 páginasInvestigación de Operaciones II U4Karla Avila100% (1)

- Métodos de Análisis Del Arreglo Físico de Las InstalacionesDocumento19 páginasMétodos de Análisis Del Arreglo Físico de Las Instalacionesacamate0% (1)

- Cadenas de MarkovDocumento15 páginasCadenas de MarkovMagbep100% (1)

- CadenaMarkovIO2Documento8 páginasCadenaMarkovIO2feliizzAún no hay calificaciones

- Cadenas de Marko-ResumenDocumento16 páginasCadenas de Marko-ResumenArturo CLorcaAún no hay calificaciones

- Cadenas de MarkovDocumento21 páginasCadenas de MarkovangieebiirofbAún no hay calificaciones

- Cadena de Markov: Introducción a su representación gráfica y clasificaciónDocumento27 páginasCadena de Markov: Introducción a su representación gráfica y clasificaciónDiego Villena NuñezAún no hay calificaciones

- CMTD - Cadenas de Markov en Tiempo DiscretoDocumento35 páginasCMTD - Cadenas de Markov en Tiempo DiscretoEljem Nefta100% (1)

- Modelo de MarkovDocumento105 páginasModelo de MarkovEliezer VerasAún no hay calificaciones

- Cadenas de MarkovDocumento40 páginasCadenas de MarkovAstrid SandovalAún no hay calificaciones

- Cadena de MarkovDocumento27 páginasCadena de MarkovLeo MessiAún no hay calificaciones

- Cad MarkDocumento14 páginasCad MarkRoguiciiAún no hay calificaciones

- R 66900Documento30 páginasR 66900as_oleo_mys_ca100% (1)

- CADENAS DE MARKOV (1) .En - EsDocumento14 páginasCADENAS DE MARKOV (1) .En - EsKevin FloresAún no hay calificaciones

- Unidad 4Documento11 páginasUnidad 4Humberto Prestegui0% (3)

- Unidad 4Documento11 páginasUnidad 4Jovyt Lopez miguelAún no hay calificaciones

- Investigación de Las Cadenas de Markov U4 - LCARDocumento8 páginasInvestigación de Las Cadenas de Markov U4 - LCARArellano RamosAún no hay calificaciones

- Trabajo Final de Cadenas de MarkovDocumento20 páginasTrabajo Final de Cadenas de MarkovluisAún no hay calificaciones

- 3 Cadenas Markov Procesos DiscretosDocumento184 páginas3 Cadenas Markov Procesos DiscretosCynthia0015Aún no hay calificaciones

- Cadenas MarkovDocumento51 páginasCadenas MarkovYsmar Laisney Lucena Perdomo0% (2)

- Modelos Estocásticos Sesión 2Documento22 páginasModelos Estocásticos Sesión 2Juancho CorreaAún no hay calificaciones

- Procesos Estocásticos 2019 PDFDocumento56 páginasProcesos Estocásticos 2019 PDFstephanie leivaAún no hay calificaciones

- Modelos Estocasticos Markov ContinuoDocumento18 páginasModelos Estocasticos Markov ContinuoJose Manuel Hernandez CarratalaAún no hay calificaciones

- Procesos de Markov PDFDocumento3 páginasProcesos de Markov PDFDanny MartínezAún no hay calificaciones

- Cadenas de Markov Finitas IntroducciónDocumento29 páginasCadenas de Markov Finitas IntroducciónEliza H. AguilarAún no hay calificaciones

- Inves RochaDocumento12 páginasInves RochaJesus PerezAún no hay calificaciones

- Cadenas de MarkovDocumento10 páginasCadenas de MarkovLUIS EMANUEL RAMOS ARZATEAún no hay calificaciones

- 1 Cadenas de Markov en Tiempo DiscretoDocumento36 páginas1 Cadenas de Markov en Tiempo DiscretoJuan Pablo UrreaAún no hay calificaciones

- Cadenas MarkovDocumento14 páginasCadenas MarkovAdriana SuarezAún no hay calificaciones

- Unidad 4 y 5Documento43 páginasUnidad 4 y 5Karla LiceaAún no hay calificaciones

- Eduardo - Cristian U3 Parte 1 - Cadenas MarkovDocumento14 páginasEduardo - Cristian U3 Parte 1 - Cadenas MarkovEduardo LesseyAún no hay calificaciones

- E3T1 Coronado López Alejandra MarcelaDocumento8 páginasE3T1 Coronado López Alejandra MarcelaALEJANDRA MARCELA CORONADO LOPEZAún no hay calificaciones

- Clasificación de Estados de Una Cadena de Markov en Tiempo DiscretoDocumento5 páginasClasificación de Estados de Una Cadena de Markov en Tiempo DiscretoGricelda Prado OrdonezAún no hay calificaciones

- Cadena de Markov1Documento7 páginasCadena de Markov1anon_615179342Aún no hay calificaciones

- Unidad II Clasificación de EstadosDocumento15 páginasUnidad II Clasificación de EstadosDaríoPlacencioHidalgoAún no hay calificaciones

- Cadenas de MarkovDocumento36 páginasCadenas de MarkovKeivis Jaramillo RamosAún no hay calificaciones

- Cadenas de Markov Act1 Tema 4Documento8 páginasCadenas de Markov Act1 Tema 4Papeleria vatisAún no hay calificaciones

- Cadenas de MarkovDocumento24 páginasCadenas de MarkovIris CoralAún no hay calificaciones

- Cadena de Markov Ejerciciodocx PDFDocumento26 páginasCadena de Markov Ejerciciodocx PDFPaolaAún no hay calificaciones

- Introducción A Las Cadenas o Procesos de MarkovDocumento3 páginasIntroducción A Las Cadenas o Procesos de MarkovAztroResendizAún no hay calificaciones

- Cadena-De-marko Abosorbent y Regular ConceptovDocumento19 páginasCadena-De-marko Abosorbent y Regular ConceptovTeresa Estrada BarreyraAún no hay calificaciones

- Cadenas de Markov en tiempo continuoDocumento12 páginasCadenas de Markov en tiempo continuoSerchimanAún no hay calificaciones

- Tecnológico Nacional de México: PeríodoDocumento20 páginasTecnológico Nacional de México: PeríodoWendy Estefania Saldivar CuervoAún no hay calificaciones

- Cadenas de Markov.Documento8 páginasCadenas de Markov.Luis Luna RamírezAún no hay calificaciones

- 7 - Cadenas de Markov Largo PlazoDocumento25 páginas7 - Cadenas de Markov Largo PlazoNacho HualaAún no hay calificaciones

- Cadenas de Markov para determinar probabilidadesDocumento7 páginasCadenas de Markov para determinar probabilidadesIan EstradaAún no hay calificaciones

- Trabajo de Procesos Estocásticos IIIDocumento10 páginasTrabajo de Procesos Estocásticos IIILening SegoviaAún no hay calificaciones

- Cadena de Markov en Tiempo DiscretoDocumento5 páginasCadena de Markov en Tiempo DiscretoGricelda Prado OrdonezAún no hay calificaciones

- Cadena de Markov para analizar la participación de operadores de telefonía móvil en ColombiaDocumento10 páginasCadena de Markov para analizar la participación de operadores de telefonía móvil en ColombiaAlexis Huaman VargasAún no hay calificaciones

- Cadena Markov PDFDocumento10 páginasCadena Markov PDFManuel VásquezAún no hay calificaciones

- Mpes U2 Ea ElvcDocumento5 páginasMpes U2 Ea Elvcjose calderonAún no hay calificaciones

- MarcosMI Actividad1 Modulo3Documento53 páginasMarcosMI Actividad1 Modulo3Isael Marcos MatusAún no hay calificaciones

- 4.1 Fernandez Lopez AdrianDocumento12 páginas4.1 Fernandez Lopez AdrianAdrian FernandezAún no hay calificaciones

- 02.cadenas de MarkovDocumento32 páginas02.cadenas de Markovcristian julio ochoaAún no hay calificaciones

- Capitulo 3Documento40 páginasCapitulo 3Daniela Núñez PrietoAún no hay calificaciones

- TRABAJO COLABORATIVO Cifrado Hill PoliDocumento14 páginasTRABAJO COLABORATIVO Cifrado Hill PoliJohn Jairo Herrera W.Aún no hay calificaciones

- Matrices Especiales FLORES APAZA KARENDocumento5 páginasMatrices Especiales FLORES APAZA KARENCarla FloresAún no hay calificaciones

- FUNCION BUSCARV Buscarh PDFDocumento6 páginasFUNCION BUSCARV Buscarh PDFFenix AtilaAún no hay calificaciones

- Algoritmo de MapeoDocumento22 páginasAlgoritmo de MapeoCRISTIAN FLOREZ TRASLAVINAAún no hay calificaciones

- Matriz cambio base producto internoDocumento3 páginasMatriz cambio base producto internoAlicia EspinolaAún no hay calificaciones

- TI-NspireCAS ReferenceGuide ESDocumento279 páginasTI-NspireCAS ReferenceGuide ESDavid MendezAún no hay calificaciones

- Mate 3012 Aplicaciones de Matrices Inversas Estud2Documento11 páginasMate 3012 Aplicaciones de Matrices Inversas Estud2Hernan PerezAún no hay calificaciones

- Taller Determinantes e InversasDocumento2 páginasTaller Determinantes e InversasLaura Valentina Parada BeltranAún no hay calificaciones

- Algebra LinealDocumento3 páginasAlgebra LinealU.a.PedritoAún no hay calificaciones

- 3ra PROGRA - GUstavo PradoDocumento29 páginas3ra PROGRA - GUstavo PradoBryan PeñalozaAún no hay calificaciones

- Aplicacion de Las Matrices en La Vida Diaria.Documento3 páginasAplicacion de Las Matrices en La Vida Diaria.Luis Trejo MartínezAún no hay calificaciones

- Gonzalez Martinez Manuel de Jesus Modelado U2 T2Documento12 páginasGonzalez Martinez Manuel de Jesus Modelado U2 T2Eiter Antonio SantiagoAún no hay calificaciones

- Matriz-Insumo ProductoDocumento15 páginasMatriz-Insumo ProductoKevin JuaresAún no hay calificaciones

- Teoría GrafosDocumento63 páginasTeoría GrafosSara NaminaoAún no hay calificaciones

- Pauta Evaluación Regular 3 Álgebra Lineal INSCT111 1-2023 Forma B v2Documento6 páginasPauta Evaluación Regular 3 Álgebra Lineal INSCT111 1-2023 Forma B v2Daniel vergara 100RXAún no hay calificaciones

- Matriz Marco Lógico: Herramienta de Análisis para ProyectosDocumento10 páginasMatriz Marco Lógico: Herramienta de Análisis para ProyectosLuis DiazAún no hay calificaciones

- MATRICESDocumento17 páginasMATRICESAndy DiazAún no hay calificaciones

- Ejemplo de PFADocumento4 páginasEjemplo de PFALuis Alejandro Alvarez ZapataAún no hay calificaciones

- 4 La Matriz PeyeaDocumento24 páginas4 La Matriz PeyeaalexAún no hay calificaciones

- Reglas Practicas Diseño Base Datos PDFDocumento118 páginasReglas Practicas Diseño Base Datos PDFAlejandro Garcia GarayAún no hay calificaciones

- Matematicas III 2017Documento367 páginasMatematicas III 2017Carlos Mario EscobarAún no hay calificaciones

- Manual de Programa Porticos HP 49G de Mario de Lama I ParteDocumento6 páginasManual de Programa Porticos HP 49G de Mario de Lama I Partedavidgutierrez_22Aún no hay calificaciones

- Palu PDFDocumento36 páginasPalu PDFJoaquín VélezAún no hay calificaciones

- Contextualización de grupos étnicos desde la etnopsicologíaDocumento11 páginasContextualización de grupos étnicos desde la etnopsicologíaYuliana ParraAún no hay calificaciones

- Ejercicio MatlabDocumento10 páginasEjercicio MatlabAldo Chara RojasAún no hay calificaciones

- Sistema de Notacion Musical en IberoamericaDocumento163 páginasSistema de Notacion Musical en IberoamericaAlfonzo TorresAún no hay calificaciones

- Capitulo 13Documento52 páginasCapitulo 13Franklin AvendañoAún no hay calificaciones