Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Tema 05 - Implementación de Un DW

Cargado por

Jorge Manuel Bodden0 calificaciones0% encontró este documento útil (0 votos)

7 vistas17 páginasTítulo original

Tema 05 - Implementación de un DW

Derechos de autor

© © All Rights Reserved

Formatos disponibles

PDF, TXT o lea en línea desde Scribd

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

© All Rights Reserved

Formatos disponibles

Descargue como PDF, TXT o lea en línea desde Scribd

0 calificaciones0% encontró este documento útil (0 votos)

7 vistas17 páginasTema 05 - Implementación de Un DW

Cargado por

Jorge Manuel BoddenCopyright:

© All Rights Reserved

Formatos disponibles

Descargue como PDF, TXT o lea en línea desde Scribd

Está en la página 1de 17

Inteligencia de Negocios

IMPLEMENTACIÓN DE UN DATAWAREHOUSE

PROF. LEANDRO FONDEUR

UNIVERSIDAD APEC

Qué veremos?

Granularidad

Agregación

ETL

Staging Area

Granularidad

Es importante a la hora de diseñar una tabla de hechos, tener

en cuenta el nivel de granularidad que va a tener, es decir, el

nivel de detalle más atómico que vamos a encontrar de los

datos

No es lo mismo tener una fila por cada venta, que una fila

donde se indiquen las ventas del día para cada artículo y tienda

A mayor granularidad, mayor será el número de filas de nuestra

tabla de hechos, y dado que el espacio en disco y rendimiento

no se ven notablemente afectados en los sistemas actuales,

debemos llegar siempre al máximo nivel de granularidad que

resulte útil a los usuarios

Agregación

Proceso por el cual se resumen los datos a partir de las filas

de detalle de máxima granularidad

Hoy en día disponemos de sistemas OLAP que se encargan

de agregar dichos datos y ofrecerlos al usuario con una gran

rapidez y eficacia

Extract-Transform-Load (ETL)

Proceso que Sirve

permite a las principalmente

organizaciones para mantener

extraer, una consistencia

transformar y en los datos y

cargar los datos eliminar o

a otra fuente de corregir los que

información estén erróneos

ETL (Extract, Transform and Load)

Procesos que leen los datos de las

diferentes fuentes, los transforman y

adaptan al modelo que hayamos

definido, los depuran y limpian, y los

introducen en la base de datos destino

Se deben reconciliar todos los datos de

las diferentes fuentes, realizar los

cálculos necesarios, mejorar la calidad

de los datos, adaptarlos al nuevo

modelo físico y almacenarlos en él

ETL - Extracción de los datos

• Actualización completa

Borrar los datos y volver a cargarlos

• Actualización incremental

Borrar sólo parte de los datos, por ejemplo desde una fecha, y cargar los

nuevos datos

Comparar los datos de origen y de destino, actualizando sólo los cambios

Uso de triggers u otras técnicas de replicación

Captura de datos mediante una aplicación diseñada específicamente para

ello

Existencia de columnas timestamp que permitan seleccionar las filas

modificadas desde la última extracción y aplicar dichos cambios en destino

ETL - Transformación de los datos

• Asegurar que los datos sean válidos, de su integridad y de su

utilidad, lo que suele incluir realizar cálculos y generar

nuevos valores

• Los datos deben ser depurados para eliminar inconsistencias,

discrepancias y duplicidades

• Estas transformaciones suelen conllevar cambios con

respecto a la estructura de origen para adaptarla al destino,

cambios en el contenido de los valores de origen y creación

de nuevos valores en las filas de destino

ETL - Carga en el Data Warehouse

• Proceso de incorporar los datos al Data Warehouse y/o a los

diferentes DataMarts, y a los cubos OLAP

• Todo ello según la presentación, formatos definidos y

periodicidad de actualización propuesta

Área de staging

Es un área temporal que se encuentra en el flujo de datos entre

las fuentes y el Data Mart o Data Warehouse con el fin de:

Facilitar la extracción de datos

Realizar tareas de limpieza (data cleansing)

Mejorar la calidad de los datos

Ser utilizada como caché de los datos operacionales o acceder a

un nivel de detalle de los datos y de los cambios no almacenados

en el DataMart o Data Warehouse

Stating Area - Ejemplo

Recomendaciones para la carga de un

área de staging

• Mínimo impacto sobre el origen

◦ Para conseguir una máxima escalabilidad y para afectar lo mínimo

posible al rendimiento de los servidores transaccionales que van a ser

nuestros orígenes de datos, debemos consumir de ellos los mínimos

recursos posibles, y centrar el consumo de dichos recursos en el

servidor que se encarga de realizar los procesos ETL

• Trazabilidad del dato

◦ Es muy importante saber dónde, cuándo y quién ha realizado cada

cambio.

◦ Realizar los procesos de extracción y de obtención de diferencias

entre el origen y el destino

◦ Ir almacenando todos los cambios que nos encontremos para poder

seguir la pista de cualquier dato y de los cambios que ha sufrido

Recomendaciones para la carga de un

área de staging (Cont.)

• Generación de tablas Delta

◦ Que tenga registradas las operaciones de inserción, actualización y borrado

que se han ido produciendo en el origen, y aplicar esos cambios en el destino

◦ Este proceso es más eficiente y consume menos recursos en origen y destino,

que hacer una lectura de dicho origen, compararlo con el destino, y obtener

de ahí las diferencias para seguidamente aplicarlas al destino

• Limpieza de datos

◦ Es importante llevar a cabo una serie de tareas de limpieza de datos y

detección de incoherencias

◦ Podemos hacer ciertas correcciones sobre datos que tenemos la certeza de

que no son correctos, o simplemente no entrarlos al destino y dejarlos en

algún lugar para que alguien los revise

Carga de una tabla en el área de Staging

cuyo origen es una base de datos relacional

Carga de una tabla en el área de Staging. Control Flow

Tratamiento de filas nuevas y modificadas – Data Flow

Tratamiento de filas eliminadas – Data Flow

También podría gustarte

- Evaluación Final - ISO931 - (24 PTS) - MAY-AGO 2021 GRADO - INTELIGENCIA DE NEGOCIOS (ISO-931-2)Documento14 páginasEvaluación Final - ISO931 - (24 PTS) - MAY-AGO 2021 GRADO - INTELIGENCIA DE NEGOCIOS (ISO-931-2)Jorge Manuel BoddenAún no hay calificaciones

- Tema 04 - Diseño de Un DWDocumento36 páginasTema 04 - Diseño de Un DWJorge Manuel BoddenAún no hay calificaciones

- Tema 06 - Inteligencia de Negocios (Parte 1)Documento19 páginasTema 06 - Inteligencia de Negocios (Parte 1)Jorge Manuel BoddenAún no hay calificaciones

- Examen Práctico de Álgebra Lineal MAT-222 Mayo-Agosto 2020.Documento1 páginaExamen Práctico de Álgebra Lineal MAT-222 Mayo-Agosto 2020.Jorge Manuel BoddenAún no hay calificaciones

- Especificación de DiseñoDocumento13 páginasEspecificación de DiseñoJorge Manuel BoddenAún no hay calificaciones

- Unidad VII - Material ISO500Documento17 páginasUnidad VII - Material ISO500Jorge Manuel BoddenAún no hay calificaciones

- Que Es La IPODocumento4 páginasQue Es La IPOJorge Manuel BoddenAún no hay calificaciones

- Taller Practico 1 Minimizando Residuos PeligrososDocumento8 páginasTaller Practico 1 Minimizando Residuos PeligrososANDRES CHAVEZAún no hay calificaciones

- RIED. Revista Iberoamericana de Educación A Distancia 1138-2783Documento6 páginasRIED. Revista Iberoamericana de Educación A Distancia 1138-2783fredys padillaAún no hay calificaciones

- Unidad 5 Segunda OportunidadDocumento14 páginasUnidad 5 Segunda OportunidadERICKAún no hay calificaciones

- Tesis MartinizingDocumento57 páginasTesis MartinizingErwin OrtízAún no hay calificaciones

- Manual Alarma GSM&PSTNDocumento19 páginasManual Alarma GSM&PSTNcesar carrilloAún no hay calificaciones

- Desarrollo SostenibleDocumento15 páginasDesarrollo SostenibleLeslie Elena Parra Perozo100% (1)

- 101 Habilidades para La VidaDocumento13 páginas101 Habilidades para La VidaVancouver MainsfieldAún no hay calificaciones

- UAS-OPR-P01-GU01 v3 Guia - Registro.operador - UASDocumento35 páginasUAS-OPR-P01-GU01 v3 Guia - Registro.operador - UASUsos VariosAún no hay calificaciones

- Diagrama de VibracionDocumento14 páginasDiagrama de Vibracionyoselin gilAún no hay calificaciones

- Manual de Usuario Ultrasonido Fujifilm Sonosite IvizDocumento205 páginasManual de Usuario Ultrasonido Fujifilm Sonosite IvizAlex CeballosAún no hay calificaciones

- Comparativa de La Eficiencia Entre Un Sistema Fotovoltaico Con Seguimiento Solar y Un Sistema Fotovoltaico FijoDocumento25 páginasComparativa de La Eficiencia Entre Un Sistema Fotovoltaico Con Seguimiento Solar y Un Sistema Fotovoltaico FijoCorporacion H21Aún no hay calificaciones

- Metodologia 5s, Aseo y LimpiezaDocumento40 páginasMetodologia 5s, Aseo y LimpiezaMoisés GarciaAún no hay calificaciones

- Evolución Histórica de La Educación Básica A Través de Los Proyectos Nacionales 1921-1999Documento18 páginasEvolución Histórica de La Educación Básica A Través de Los Proyectos Nacionales 1921-1999canekyespartacoAún no hay calificaciones

- Kaso U1 A3Documento10 páginasKaso U1 A3Efra RinconAún no hay calificaciones

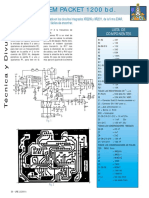

- Modem Packet 1200 BaudiosDocumento2 páginasModem Packet 1200 BaudiosExperiment BarthAún no hay calificaciones

- Linea de Tiempo InformaticaDocumento9 páginasLinea de Tiempo Informaticamildrey gonzalezAún no hay calificaciones

- Lab 8Documento6 páginasLab 8Luis Alberto Parco AtanacioAún no hay calificaciones

- Examen Documentacion Iso 9001Documento4 páginasExamen Documentacion Iso 9001Khriz IriarteAún no hay calificaciones

- Practica 1 PDFDocumento13 páginasPractica 1 PDFAnaya Vazquez EmilianoAún no hay calificaciones

- REGIUS Sigma II OPERATION MANUAL Spanish - A5ERBC01ES03Documento36 páginasREGIUS Sigma II OPERATION MANUAL Spanish - A5ERBC01ES03Mafer YgAún no hay calificaciones

- Transfer Maker Manual CHA-27Documento25 páginasTransfer Maker Manual CHA-27Ivan SaladinoAún no hay calificaciones

- Mini Proyecto en PythonDocumento1 páginaMini Proyecto en PythonKrlitooz GaviriaAún no hay calificaciones

- Cuaderno de InformesDocumento24 páginasCuaderno de InformesJuan DominguezAún no hay calificaciones

- Construyendo Una Educación de CalidadDocumento223 páginasConstruyendo Una Educación de CalidadPablo SevillanoAún no hay calificaciones

- Amplificadores OperacionalesDocumento22 páginasAmplificadores OperacionalesDaniela BurgosAún no hay calificaciones

- Calidad de La Atencion MedicaDocumento54 páginasCalidad de La Atencion MedicaJessica Cristina Mendoza Moreno100% (1)

- Trabajo FinalDocumento9 páginasTrabajo FinalRoberto Carlos Vencis EspinozaAún no hay calificaciones

- Taller Método Puntos Muestrales..Documento8 páginasTaller Método Puntos Muestrales..SARA LUCIA CELY MONTEGROAún no hay calificaciones

- Analitico - Gastos Exp TecnicoDocumento1 páginaAnalitico - Gastos Exp Tecnicopedro OrtizAún no hay calificaciones

- Tarea 5 InformaticaDocumento2 páginasTarea 5 InformaticaPaola CalcañoAún no hay calificaciones