Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Clases 4 ESTD081 UnidadI 2019

Cargado por

Servic Tec Pc Led LcdTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Clases 4 ESTD081 UnidadI 2019

Cargado por

Servic Tec Pc Led LcdCopyright:

Formatos disponibles

UNIDAD I

CORRELACIÓN

LINEAL Y ANÁLISIS

DE REGRESIÓN

LINEAL SIMPLE

CLASE N°4

ESTD081

Prof.: Magaly Moraga C.

Inferencias acerca de los coeficientes de regresión

2

Los intervalos de confianza al nivel de confianza 1 − 𝛼 100%

para 𝛽0 𝑦 𝛽1 se construyen a partir de los estadísticos t y

resultan:

Intervalo de confianza para β0

σ𝑛 2

𝑖=1 𝑥𝑖 σ𝑛 2

𝑖=1 𝑥𝑖

𝛽መ0 – 𝑡(1−𝛼,𝑛−2) 𝑆መ𝑅2 ≤ 𝛽0 ≤ 𝛽መ0 + 𝑡1−𝛼,𝑛−2 𝑆መ𝑅2

2 𝑛𝑆𝑥𝑥 2 𝑛𝑆𝑥𝑥

𝛼

donde 𝑡1−𝛼,𝑛−2 es el cuantil 1 − de la distribución t-student con

2 2

𝑛 − 2 grados de libertad.

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

3

Intervalo de confianza para β1

2

𝑆መ𝑅 2

𝑆መ𝑅

𝛽መ1 – 𝑡(1−𝛼,𝑛−2) ≤ 𝛽1 ≤ 𝛽መ1 + 𝑡(1−𝛼,𝑛−2)

2 𝑆𝑥𝑥 2 𝑆𝑥𝑥

𝛼

donde 𝑡 𝛼

1− 2 ,𝑛−2 es el cuantil 1 − de la distribución t-student con

2

𝑛 − 2 grados de libertad.

Estadística II Prof. Magaly M.

Prueba de hipótesis en la regresión lineal

4

Una parte importante al evaluar la adecuación de un modelo de

regresión lineal son las pruebas de hipótesis estadísticas sobre

los parámetros del modelo y la construcción de intervalos de

confianza.

Supóngase que se desea probar la hipótesis que la pendiente es

igual a una constante, por ejemplo, 𝛽∗ . Las hipótesis

apropiadas son:

𝐻𝑜: 𝛽1 = 𝛽 ∗ y 𝐻1: 𝛽1 ≠ 𝛽∗ ,

Estadística II Prof. Magaly M.

Prueba de hipótesis en la regresión lineal

5

𝛽1 −𝛽1

Luego tenemos que 𝑡1 = መ

~𝑡1−𝛼,𝑛−2 bajo 𝐻𝑜 .

𝑆𝑅 / 𝑆𝑥𝑥 2

Puede rechazarse 𝐻𝑜 si |𝑡1 | > 𝑡1−𝛼,𝑛−2 .

2

El estadístico de prueba puede escribirse como:

𝛽መ1 − 𝛽 ∗

𝑡1 =

𝑠𝑒(𝛽መ1 )

Puede emplearse un procedimiento similar para probar la

hipótesis con respecto a la ordenada al origen. Se quiere

contrastar la hipótesis:

Estadística II Prof. Magaly M.

Prueba de hipótesis en la regresión lineal

6

Puede emplearse un procedimiento similar para probar la

hipótesis con respecto a la ordenada al origen. Se quiere

contrastar la hipótesis:

𝐻𝑜: 𝛽0 = 𝛽∗ y 𝐻1: 𝛽0 ≠ 𝛽∗

Se utiliza el estadístico:

0 −𝛽0

𝛽 0 −𝛽∗

𝛽

𝑡0 = = 𝑠𝑒(𝛽0 )

σ 𝑥2

𝑆መ𝑅 ൗ𝑛𝑆

𝑥𝑥

Luego se rechaza la hipótesis nula si |𝑡0 | > 𝑡1−𝛼,𝑛−2

2

Estadística II Prof. Magaly M.

Prueba de hipótesis en la regresión lineal

7

Un caso especial es cuando 𝐻𝑜: 𝛽1 = 0. Estas hipótesis están

relacionadas con la significancia de la regresión. Cuando no

hay suficiente evidencia para rechazar 𝐻𝑜: 𝛽1 = 0 es

equivalente a concluir que no hay ninguna relación lineal entre

x e Y. Como alternativa, si 𝐻𝑜: 𝛽1 = 0 se rechaza, esto explica

que x tiene importancia al explicar la variabilidad de Y.

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

8

la resolución del contraste consiste en calcular el p-valor

asociado al valor absoluto de la estimación, 𝑡0 𝑜 |𝑡1 |,

según el caso, esto es, 𝑝 − 𝑣𝑎𝑙𝑜𝑟 = 𝑃(𝑡𝑛−2 < |𝑡𝑖 |) . El

contraste se resuelve de la siguiente forma:

Se rechaza 𝐻0 a nivel 𝛼 cuando 𝑝 − 𝑣𝑎𝑙𝑜𝑟 ≤ 𝛼,

Si 𝑝 − 𝑣𝑎𝑙𝑜𝑟 > 𝛼, se dice que los datos no proporcionan

suficientes evidencias en contra de la hipótesis nula y ésta

no se puede rechazar.

Cuando el contraste propuesto sobre 𝛽0 ó 𝛽1 tiene 𝛽 ∗ = 0,

en realidad se está contrastando, respectivamente, si la

recta de regresión tiene interceptación o pendiente nula.

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

9

Análisis de varianza para β

El análisis de varianza es un método que utiliza la

estadística F para probar la significancia de la

ecuación de regresión muestral o la existencia de

regresión en la población.

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

10

Construir la tabla ANOVA o análisis de varianza consiste

en:

Descomponer la variabilidad de los datos en la parte

que es explicad por el modelo y la parte que se deja sin

explicar, es decir, la variabilidad de los residuos, y

Compararlas y valorar estadísticamente si la

variabilidad explicada por el modelo ajustado es

suficientemente grande.

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

11

Las hipótesis nula y alternativa para esta prueba son

respectivamente:

Ho: β1 = 0 y H1: β1 ≠ 0

H0: el modelo lineal NO explica bien la respuesta.

H1: el modelo lineal explica bien la respuesta

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

12

La estadística F de la prueba se obtiene de la partición de

la varianza Y:

S y2

i

( y y ) 2

n 1

en dos varianzas, la varianza no explicada y la varianza

explicada por la regresión.

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

13

La partición es la siguiente identidad de suma de cuadrados:

n n n

i

( y

i 1

y ) 2

i

( y ˆ

y

i 1

) 2

i

( ˆ

y y ) 2

i 1

SCT = SCE + SCR

Variabilidad datos = variabilidad Residuos + variabilidad recta

La prueba de la hipótesis nula Ho: β1= 0 se resume en la

siguiente tabla de análisis de varianza (ANOVA)

Estadística II Prof. Magaly M.

Inferencias acerca de los coeficientes de regresión

14

ANOVA para β1 = 0

Fuente de Suma de Grados de Cuadrados F calculada

variación cuadrados libertad medios

Regresión SCR 1 CMR=SCR/1

F = CMR/CME

Error SCE n-2 CME = SCE/n-2

Total SCT n-1

Dado el nivel de significancia α, y los grados de libertad 1 y

n-2, en la tabla de probabilidades F, se encuentra el valor

crítico c = f 1-α;1,n-2

Estadística II Prof. Magaly M.

¿Cómo medir la bondad de una regresión?

Imaginemos un diagrama de dispersión, y vamos

a tratar de comprender en primer lugar qué es

el error residual, su relación con la varianza de Y,

y de ahí, cómo medir la bondad de un ajuste.

Estadística II Prof. Magaly M. 15

Interpretación de la variabilidad en Y

Y

En primer lugar olvidemos que existe la

variable X. Veamos cuál es la variabilidad

en el eje Y.

La franja sombreada indica la zona donde

varían los valores de Y.

Proyección sobre el eje Y = olvidar X

Estadística II Prof. Magaly M. 16

Interpretación del residuo

Fijémonos ahora en los errores de predicción Y

(líneas verticales). Los proyectamos sobre el eje Y.

Se observa que los errores de predicción,

residuos, están menos dispersos que la

variable Y original.

Cuanto menos dispersos sean los residuos,

mejor será la bondad del ajuste.

Estadística II Prof. Magaly M. 17

Bondad de un ajuste

18

Resumiendo: Y

• La dispersión del error residual será una

fracción de la dispersión original de Y

•Cuanto menor sea la dispersión del error

residual

mejor será el ajuste de regresión.

Eso hace que definamos como medida de

bondad de un ajuste de regresión,

o coeficiente de determinación a:

𝑆መ𝑅2

𝑅2 = 1 − 2

𝑆𝑦

𝑆መ𝑅2 < 𝑆𝑦2

Estadística II Prof. Magaly M.

Resumen sobre bondad de un ajuste

19

La bondad de un ajuste de un modelo de regresión se mide usando el

coeficiente de determinación R2

R2 es una cantidad adimensional que sólo puede tomar valores en [0, 1]

Cuando un ajuste es bueno, R2 será cercano a uno.

Cuando un ajuste es malo R2 será cercano a cero.

A R2 también se le denomina porcentaje de variabilidad explicado por el

modelo de regresión.

R2 puede ser pesado de calcular en modelos de regresión general, pero en

el modelo lineal simple, la expresión es de lo más sencilla: R2=r2

Estadística II Prof. Magaly M.

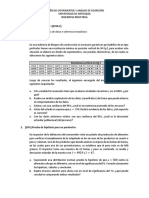

Ejemplo utilizando R

20

Parece ser que el dinero gastado en la mantención de tractores es

mayor a medida que aumenta la edad del tractor (Draper y Smith,

1998, pag.100). Se tienen la variable edad de tractor (años) y los

costos de la mantención de los tractores (en 6 meses).

edad<-c(4.5,4.5,4.5,4.0,4.,4.,5,5,5.5,5,0.5,0.5,6,6,1,1,1)

costos<-c(619,1049,1033,495,723,681,890,1522,987,1194,163,

182,764,1373, 978,466,549)

para visualizar gráficamente la relación entre las variables, en R

podemos hacer el diagrama de dispersión mediante la siguiente

función:

plot(edad,costos,xlab="edad (en años)",ylab="Costos en 6 meses")

Estadística II Prof. Magaly M.

Ejemplo utilizando R

21

Estadística II Prof. Magaly M.

Ejemplo utilizando R

22

Para determinar la covarianza

cov(edad,costos)

[1] 521.7812

Este valor indica que la relación de ambas variables

es directa.

Para determinar el coeficiente de correlación lineal

de Pearson:

cor(edad,costos)

[1] 0.6906927

Estadística II Prof. Magaly M.

Ejemplo utilizando R

23

Para ajustar el modelo lineal:

mi.modelo<-lm(costos~edad)

El modelo ajustado queda en mi.modelo (si desean, pueden hacerlo directo con

función lm(costos~edad)

Para visualizar el modelo ajustado:

mi.modelo

Call: lm(formula = costos ~ edad)

Coefficients:

(Intercept) edad

323.6 131.7

En esta salida el modelo ajustado es: 𝑦ො = 323,6 + 131,7𝑋

Estadística II Prof. Magaly M.

Ejemplo utilizando R

24

Otra opción de ver el modelo, incluyendo las inferencia para los coeficientes de regresión es:

summary(mi.modelo)

Call:

lm(formula = costos ~ edad) #aquí variable dependiente: costos, independiente: edad

Residuals:

Min 1Q Median 3Q Max #información sobre los residuales

-355.49 -207.48 -61.06 132.65 539.80

Coefficients:

Estimate Std. Error t value Pr(>|t|) # valor de los estimadores, error estándar

(Intercept) 323.62 146.94 2.202 0.04369 * # de los estimadores, valor t y p-valor

edad 131.72 35.61 3.699 0.00214 **

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 283.5 on 15 degrees of freedom

Multiple R-squared: 0.4771, Adjusted R-squared: 0.4422

F-statistic: 13.68 on 1 and 15 DF, p-value: 0.002143

Estadística II Prof. Magaly M.

Ejemplo utilizando R

25

La estimación de la varianza podemos solicitarlo

por:

summary(mi.modelo)$sigma^2

[1] 80360.47

* esto es lo mismo que obtener el cuadrado del

error residual estándar, es decir, (Residual standard

error: 283.5)

𝜎 2 = (283,5)2 = 80360,47

Un valor bastante grande.

Estadística II Prof. Magaly M.

Ejemplo utilizando R

26

Los intervalos de confianza para los parámetros (betas) se obtienen con la

función confint:

confint(mi.modelo)

2.5 % 97.5 %

(Intercept) 10.42936 636.8152 #10,43 ≤ 𝛽0 ≤ 636,82

edad 55.82166 207.6113 #55,82 ≤ 𝛽1 ≤ 207,61

• Podemos ver que ambos parámetros son significativos, es decir, ambos

son distintos de cero al 95% de confianza (este nivel de confianza por

defecto).

• Para solicitar un intervalo con un nivel de confianza distinto, la función es,

por ejemplo:

confint(mi.modelo, level=0.9)

Estadística II Prof. Magaly M.

Ejemplo utilizando R

27

¿Podemos mejorar el ajuste, en este ejemplo?

Podemos mejorar el ajuste, considerando una

transformación para la variable costos, dado que tiene

un rango grande.

Si consideramos el logaritmo de los costos en busca de

mejorar la linealidad y por tanto la calidad del ajuste,

tenemos:

x<-edad

y<-log(costos)

modelo.log<-lm(y~x)

summary(modelo.log)

Estadística II Prof. Magaly M.

Ejemplo utilizando R

28

Call:

lm(formula = y ~ x)

Residuals:

Min 1Q Median 3Q Max

-0.72257 -0.31200 -0.04122 0.21549 0.95371

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 5.70085 0.22677 25.140 1.12e-13 ***

x 0.23095 0.05495 4.203 0.000769 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 0.4375 on 15 degrees of freedom

Multiple R-squared: 0.5408, Adjusted R-squared: 0.5101

F-statistic: 17.66 on 1 and 15 DF, p-value: 0.0007687

Estadística II Prof. Magaly M.

Ejemplo utilizando R

29

Con esta transformación, se reduce

considerablemente el error de los residuos a 0.4375,

y por consiguiente la varianza del error:

> summary(modelo.log)$sigma^2

[1] 0.1913944

Por otro lado, el coeficiente de determinación

mejora, ahora 𝑅2 =, 54 lo que indica que tenemos

un mejor modelo.

Estadística II Prof. Magaly M.

Ejemplo utilizando R

30

# Los intervalos de confianza para los parámetros se

obtienen con:

confint(modelo.log)

2.5 % 97.5 %

(Intercept) 5.2175063 6.1841920

x 0.1138189 0.3480721

Ambos parámetros, betas, son significativos al 95%

de confianza.

Estadística II Prof. Magaly M.

También podría gustarte

- Prueba de HipotesisDocumento4 páginasPrueba de HipotesisFrank estiwenson Amado Martínez0% (1)

- Contraste de HipotesisDocumento3 páginasContraste de HipotesisGabriela Alejandra ParraAún no hay calificaciones

- 03 em 06 Emae U2 A8Documento12 páginas03 em 06 Emae U2 A8Kira Lange RodriguezAún no hay calificaciones

- 2018 Bioestadística Módulo III - Estimación e InferenciaDocumento17 páginas2018 Bioestadística Módulo III - Estimación e InferenciaNicole SantiagoAún no hay calificaciones

- Silva, R. A. (1992) - Lógica de La Inferencia Estadística México. Trillas. Pp. 369-393Documento16 páginasSilva, R. A. (1992) - Lógica de La Inferencia Estadística México. Trillas. Pp. 369-393Angel RuizAún no hay calificaciones

- Estadística II ProblemasDocumento2 páginasEstadística II ProblemasMathiasAún no hay calificaciones

- Anova JaspDocumento20 páginasAnova JaspDaniel Santiago Gutierrez Cuartas100% (1)

- Ctol Estad Procesos CepDocumento150 páginasCtol Estad Procesos CepSebastián PeredaAún no hay calificaciones

- Practica Catapulta.1Documento5 páginasPractica Catapulta.1Juan GonzalezAún no hay calificaciones

- Pif Estadística IIDocumento16 páginasPif Estadística IIYuliana RendonAún no hay calificaciones

- Diseño ExperimentalDocumento3 páginasDiseño ExperimentalJuan Esteban PosadaAún no hay calificaciones

- Actividad 6 Taller Pruebas de HipótesisDocumento14 páginasActividad 6 Taller Pruebas de HipótesisYESSICA ASTRID DAZA MONTILLAAún no hay calificaciones

- Prueba 1 Estadística IIDocumento4 páginasPrueba 1 Estadística IIJosh Moser SharpAún no hay calificaciones

- Presentación 19.20Documento25 páginasPresentación 19.20Daniel EliasAún no hay calificaciones

- 8 Tema 8 Nociones de Inferencia EstadisticaDocumento33 páginas8 Tema 8 Nociones de Inferencia EstadisticaANTONY BRAYAN DE LA CRUZ CRISÓSTOMOAún no hay calificaciones

- Anova-Analisis de Varianza-Semana 16Documento32 páginasAnova-Analisis de Varianza-Semana 16ÉstaMate Prof. Hender Noé Llauce ChapoñanAún no hay calificaciones

- Pasos de HipotesisDocumento4 páginasPasos de HipotesisyerisAún no hay calificaciones

- El Valor de La Estadistica para La Salud PúblicaDocumento8 páginasEl Valor de La Estadistica para La Salud PúblicaSteban Toro VerdoorenAún no hay calificaciones

- 5 Ejercicios Propuestos Prueba de Hipotesis de 1,2 Medias PDFDocumento3 páginas5 Ejercicios Propuestos Prueba de Hipotesis de 1,2 Medias PDFMarco RodriguezAún no hay calificaciones

- Actividad de Puntos Evaluables - Escenario 6 - SEGUNDO BLOQUE-CIENCIAS BASICAS - ESTADISTICA II - (GRUPO B15)Documento6 páginasActividad de Puntos Evaluables - Escenario 6 - SEGUNDO BLOQUE-CIENCIAS BASICAS - ESTADISTICA II - (GRUPO B15)Nicolas RinconAún no hay calificaciones

- Guia Didactica 1-2023Documento73 páginasGuia Didactica 1-2023Ali Melgar AraúzAún no hay calificaciones

- Prueba de HipótesisDocumento4 páginasPrueba de HipótesisLuis GranielAún no hay calificaciones

- Estadistica Prueva de HipotesisDocumento21 páginasEstadistica Prueva de HipotesisLindsay De La Sota LandaAún no hay calificaciones

- Taller de Reforzamiento N 6 de Estadistica Aplicadasd-1Documento9 páginasTaller de Reforzamiento N 6 de Estadistica Aplicadasd-1Mario EspinozaAún no hay calificaciones

- 9 Analisis de La Homogeneidad de Varianza Homocedasticidad PDFDocumento7 páginas9 Analisis de La Homogeneidad de Varianza Homocedasticidad PDFVicente AriasAún no hay calificaciones

- PP A2 Mendez CruzDocumento6 páginasPP A2 Mendez Cruzalberta100% (1)

- Vdocuments - MX Antologia Taller de Investigacion IIDocumento53 páginasVdocuments - MX Antologia Taller de Investigacion IImargaritabonifacia1593Aún no hay calificaciones

- Entendimiento de La Robustes EstadisticaDocumento6 páginasEntendimiento de La Robustes EstadisticaAquiles Caigo ParadoAún no hay calificaciones

- Datos EstadísticosDocumento6 páginasDatos Estadísticosjesus carrilloAún no hay calificaciones