0% encontró este documento útil (0 votos)

4K vistas5 páginasInterpolación y regresión: diferencias clave

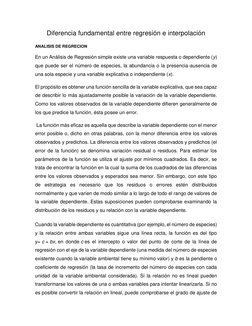

La regresión analiza la relación entre una variable dependiente y una o más variables independientes para generar una función que describa la relación, mientras que la interpolación usa puntos de datos conocidos para estimar valores desconocidos. La diferencia clave es que la regresión busca una función general que describa los datos, mientras que la interpolación solo conecta puntos específicos de datos.

Cargado por

benjamin zavaletaDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como DOCX, PDF, TXT o lee en línea desde Scribd

0% encontró este documento útil (0 votos)

4K vistas5 páginasInterpolación y regresión: diferencias clave

La regresión analiza la relación entre una variable dependiente y una o más variables independientes para generar una función que describa la relación, mientras que la interpolación usa puntos de datos conocidos para estimar valores desconocidos. La diferencia clave es que la regresión busca una función general que describa los datos, mientras que la interpolación solo conecta puntos específicos de datos.

Cargado por

benjamin zavaletaDerechos de autor

© © All Rights Reserved

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como DOCX, PDF, TXT o lee en línea desde Scribd