Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Apunte Est I. de Conf

Cargado por

Luis Sanhueza AniñirDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Apunte Est I. de Conf

Cargado por

Luis Sanhueza AniñirCopyright:

Formatos disponibles

1

ESTIMACION DE PARAMETROS

La estadstica descriptiva tal como la hemos visto hasta aqu, no requiere de la teora de

probabilidades para describir el conjunto de datos x ,x ,...,x . Como su nombre lo indica, slo son

" # n

tcnicas para describir, sin importar el orgen de los datos. En particular, no se hace ningn intento

para generalizar ms all de la informacin que se tiene en ese momento. La inferencia estadstica,

sin embargo, est fundamentalmente interesada en la poblacin, fuente u origen de los datos. Ella

supone que los nmeros x ,x ,...,x son valores observados de variables aleatorias, los que han

" # n

sido recolectados como resultados de realizar, por ejemplo, un experimento que sigue un modelo

probabilstico. Este modelo probabilstico puede entonces ser utilizado para realizar inferencias

acerca del fenmeno estudiado en el experimento.

1.1. Propsito de la Inferencia Estadstica

Cuando hablamos de obtener conclusiones respecto de una poblacin particular, nos estamos

refiriendo a algunas caractersticas distribucionales de la poblacin. Especficamente, nos

referimos a algunos parmetros que caracterizan la distribucin poblacional. Esto significa que la

inferencia en cuestin ser relativa a un conjunto de De aqu que se parmetros poblacionales.

habla tambin de inferencia paramtrica

Como un ejemplo, supongamos que una estudiante de ingeniera tiene clases de Estadstica a las 8

AM los das Lunes, Mircoles y Viernes y hay una probabilidad (desconocida) de que ella llegue )

atrasada a la clase en cualquiera de estos das. La llegada a esta clase cada da podemos pensarla

como un ensayo Bernoulli, donde xito corresponde al hecho de llegar atrasada a la clase de

Estadstica. Si consideramos que estos ensayos son independientes, para una sucesin de n das de

clases observamos X , X ,..., X variables aleatorias Bernoulli independientes, cada una de

" # n

parmetro , donde X = 1 si la estudiante llega atrasada en el da i y X = 0 si no. Cmo esta )

i i

sucesin de ceros y unos podemos utilizarla para obtener informacin acerca de , la probabilidad )

de llegar atrasada a su clase de Estadstica cada da?. En este caso x corresponde al nmero de

!

n

i

i

"

das, del total de n, en que ella llega atrasada, por lo que parece intuitivamente claro que x =

!

n

i

i

"

x /n sera una buena aproximacin para . )

En este ejemplo hemos observado valores de variables aleatorias independientes X , X ,..., X ,

" # n

donde cada una de las X tiene la misma distribucin de probabilidades. En estos casos hablamos

i

de de tamao n, un concepto que ya habamos adelantado en la Seccin 4.9. muestra aleatoria

Formalmente, y a modo de recuerdo, si X , X ,..., X son variables aleatorias independientes y

" # n

estn idnticamente distribudas, cada una con la misma distribucin de alguna variable aleatoria

X, entonces llamamos a X ,X ,...,X una muestra aleatoria (m.a.) de la variable aleatoria X.

" # n

2

Si X , X ,..., X es una muestra aleatoria de una variable aleatoria X, entonces se acostumbra a

" # n

llamar a X o sencillamente . variable aleatoria poblacional poblacin

Por otra parte, si X= ( X , X ,..., X ) es una muestra aleatoria, entonces su distribucin de

_

" # n

probabilidades conjunta est completamente especificada por sus distribuciones marginales. Esto

es.

f (x ,x ,...,x ) = f (x ).f (x ).....f (x )

X n X 1 X 2 X n _ " #

1 2 n

= f (x ).f (x ).....f (x )

X 1 X 2 X n

si X es una variable continua y

p (x ,x ,...,x ) = p (x ).p (x ).....p (x )

X n X 1 X 2 X n _ " #

1 2 n

= p (x ).p (x ).....p (x )

X 1 X 2 X n

si X es una variable discreta.

Los valores observados x , x ,..., x son llamados valores de la muestra aleatoria seleccionados

" # n

desde la poblacin en estudio.

La definicin que estamos manejando para una muestra aleatoria no es vlida para poblaciones

finitas, cuando por ejemplo n nmeros son seleccionados al azar y sin reemplazo desde una

poblacin de tamao N (N n); sin embargo, si una muestra de tamao n se selecciona al azar,

sin reemplazo, desde una poblacin finita y n es pequeo comparado con N, entonces X , X ,...,

" #

X , satisface, aproximadamente, la definicin de muestra aleatoria.

n

Cuando X , X ,..., X es una muestra aleatoria de una poblacin X, y conocemos la distribucin

" # n

de probabilidades de X, entonces conocemos tambin la distribucin conjunta de X , X ,..., X y

" # n

podemos evaluar inmediatamente la distribucin de cada X . Generalmente, por supuesto, uno o

i

ms aspectos de la distribucin de probabilidades para la poblacin sern desconocidos para

nosotros, por ejemplo l o los parmetros que caracterizan a la distribucin o incluso podemos

desconocer la densidad o funcin de probabilidad, y por lo tanto, debemos slo suponer que X ,

"

X ,..., X son independientes y nuestra interrogante es saber si tienen alguna distribucin

# n

especfica conocida, tal como una distribucin normal, exponencial etc. Nuestro propsito en la

inferencia, es utilizar los elementos de la muestra para determinar todos los aspectos desconocidos

de nuestro inters, en la mejor forma posible, al considerar la distribucin de probabilidades de la

poblacin.

Veremos que ciertas funciones de los elementos de una muestra aleatoria tales como

X = (Media Muestral)

!

n

i

i

"

X

n

3

S = (Varianza Muestral)

#

!

n

i

i

"

#

(X X)

n 1

X = Mximo (X ,X ,...,X )

" # n n

X = Mnimo (X ,X ,...,X )

" " # n

sern muy tiles en la inferencia estadstica.

Definicin. Cualquier funcin de los elementos de una muestra aleatoria que no dependa de algn

parmetro desconocido se llama . estadstico

Los estadsticos son, por lo tanto, variables aleatorias, cuyos valores observados pueden ser

evaluados despus que los valores observados para X ,X ,...,X son conocidos. Como de

" # n

costumbre, usaremos letras maysculas para denotar a las variables aleatorias, y minsculas para

representar sus valores observados. Como los estadsticos son variables aleatorias, sus valores

variarn de muestra en muestra y tiene sentido determinar la distribucin de estas variables

aleatorias. A estas distribuciones nos referiremos como distribuciones muestrales.

1.2. Distribucin de la media muestral

Teorema 1.1. Si X ,X ,...,X es una muestra aleatoria de una poblacin X que tiene media y

" # n

.

varianza , entonces X tiene valor esperado y varianza /n. 5 . 5

# #

Demostracin. El valor esperado de X es

E(X ) = E( X /n)

!

n

i

i

"

= (1/n) E(X )

!

n

i

i

"

= (1/n)

!

n

i"

.

= (1/n)(n ) = . .

y su varianza es

Var (X ) = Var ( X /n)

D

i

= (1/n ) Var(X ) por independencia de las X

#

D

i i

= (1/n ) por estar las X idnticamente distribudas

# #

D5

i

4

= n /n = /n. 5 5

# # #

La raz cuadrada positiva de la varianza de X se conoce con el nombre de

error estndar de la

media, = / n . 5 5

X

Notemos que decrece a medida que el tamao de la muestra crece. Esto significa que cuando n 5

X

se hace grande por lo que tenemos ms informacin podemos esperar valores de X ms

cercanos a , lo que significa que el valor observado x es una buena aproximacin de .. . .

Teorema 1.2. Si X ,X ,...,X es una muestra aleatoria de una poblacin normal de parmetros y

" # n

.

5 . 5

# #

, entonces X tiene distribucin Normal con parmetros y /n.

Demostracin. Consideremos la funcin generadora de momentos de la variable aleatoria X .

M (t) = E(e )

X

_

tX

_

= E(e )

t x /n D

i

= E(e )E(e )...E(e )

tX /n tX /n tX /n

" # n

= M (t/n) M (t/n)...M (t/n)

X X X

" # n

= e

. 5 t n t n

n

#

# #

= e

. 5 t t n

"

#

# #

que corresponde a la funcin generadora de momentos de una variable aleatoria normal de

parmetros y /n. . 5

#

Por otra parte, si la muestra proviene de una poblacin que no tiene distribucin normal, entonces

el siguiente teorema, , cuya demostracin ya realizamos en la seccin 4.11, nos del Lmite Central

garantiza que la distribucin de la sucesin de medias muestrales estandarizadas tiende a la

distribucin normal estndar. Este teorema, que reproducimos aqu, es la base para justificar

muchas aproximaciones en Estadstica.

Teorema 1.3. Si X ,X ,...,X es una muestra aleatoria de una poblacin infinita que tiene media

" # n

.

y varianza , entonces la distribucin lmite (cuando n tiende a ) de Z , donde 5

#

_

n

= = Z ,

n

n

n

(X ) n Dx

i

.

5

.

5

es la distribucin Normal estndar.

5

Ejemplo. Una maquina puede ser regulada de modo que descarge un promedio de kilos por hora .

( desconocido). Se ha observado que la cantidad descargada por la maquina se distribuye normal .

con =1.0 kg. Se selecciona al azar una muestra de tamao n = 9 horas de descarga, pesando el 5

#

total descargado en cada hora seleccionada. Se desea encontrar la probabilidad que la media

muestral est entre +/- 0.3 kg. de la verdadera media . .

Si definimos la variable aleatoria Y como el peso total descargado en la hora i, entonces Y se

i i

distribuye N( , 1), para todo i=1,...,9, por lo tanto, de acuerdo al Teorema 6.2, Y se distribuye .

N( , 1/9). La probabilidad que deseamos determinar es .

P(|Y | 0.3) = P[ 0.3 (Y ) 0.3]

. .

= P[ 0.3 n/ (Y ) n/ 0.3 n/ ]

5 . 5 5

= P[ 0.3 9/1 Z 0.3 9/1]

= P[ 0.9 Z 0.9]

utilizando las tablas de la distribucin normal estndar, obtenemos

P(|Y | 0.3) = 2(0.3159) = 0.6318.

.

As, la probabilidad que la media muestral est dentro de +/- 0.3 de la media poblacional es .

0.6318.

1.3. Distribucin de la Varianza Muestral

En esta seccin veremos algunos resultados importantes, relacionados con la variamza muestral,

S , que sern de referencia constante en este y en otros captulos del texto.

#

Teorema 1.4. Si X ,X ,...,X es una muestra aleatoria de una distribucin con media y varianza

" # n

.

5 5

# # #

, entonces la varianza muestral S = tiene valor esperado igual a .

D(X X)

n 1

i

#

Demostracin. Utilizando la definicin de esperanza tenemos

E(S ) = E[ X n X ]

# #

#

1

n 1

D

i

= ( E(X ) nE(X ))

1

n 1

D

#

#

i

y usando la relacin E(X ) = Var(X) + (E(X)) cualquiera sea la variable aleatoria X, tenemos

# #

E(S ) = ( ( + ) n( /n+ ))

# # # # #

1

n 1

D 5 . 5 .

6

= ((n +n ) n )

1

n 1

5 . 5 .

# # # #

=

(n 1)

n 1

5

#

= . 5

#

Notemos que si observamos x ,x ,...,x , no es verdadero que s = sea igual a . Lo que

" #

# #

n

D(x x)

n 1

i

#

5

el Teorema 6.4 dice es que si tomamos repetidas muestras aleatorias del mismo tamao y

calculamos s para cada una de ellas, entonces el promedio de los valores de s es . A causa de

# # #

5

este resultado, el valor observado s para la variable aleatoria S , parece ser una aproximacin

# #

razonable para . 5

#

Un resultado muy importante que se usa frecuentemente cuando se muestrea de poblaciones

normales est dado en el siguiente teorema.

Teorema 1.5. Sea X ,X ,...,X una muestra aleatoria de una poblacin X cuya distribucin es

" # n

normal de media y varianza . Entonces . 5

#

a) La media muestral X y la varianza muestral S son variables aleatorias

#

independientes.

b) es una variable aleatoria con distribucin Chi-cuadrado con

D

5 5

(X X) (n 1)S

i

# #

# #

=

n 1 grados de libertad.

Demostracin. Consideremos la forma estndar de X , i =1,...,n

i

Z = , i = 1,...,n,

i

X

i

.

5

entonces Z ,...,Z son variables normales estndar independientes. Sea

" n

Z = Z /n =

D

i

D . 5 .

5

(X )/ X

n

i

= .

Entonces Z N(0,1/n) y n Z N(0,1). Por lo tanto nZ es una variable aleatoria Chi-

#

cuadrado con 1 grado de libertad.

Ahora, como Z ,...,Z son variables aleatorias normales independientes, ellas estn no

" n

correlacionadas (Teorema 4.3), adems para cada i =1,...,n , Z y Z Z estn no correlacionadas

i

(ver ejemplo de seccin 4.9). Ms an, Z y Z Z son independientes ya que ellas tienen

i

distribucin normal bivariante para todo i=1,2,....,n. Por Teorema 4.6, Z y (Z Z ) son

D

i

#

independientes por lo que tambin lo son nZ y (Z Z ) , y finalmente aplicando el Teorema

#

#

D

i

4.5 encontramos que

7

nZ = X y = = S

5

# #

D D (Z Z) (X X)

n 1 n 1

i i

# #

son independientes, con lo que concluye la demostracin de parte (a).

Para la parte (b), notemos que (Z Z ) = y mostremos que esta variable tiene D

i

#

(n 1)S

#

#

5

distribucin Chi cuadrado con n 1 grados de libertad. En efecto, como

(Z Z ) = Z nZ D D

i

i

# #

#

tenemos que

Z = (Z Z ) + nZ . D D

# #

#

i

i

Por otra parte, la funcin generadora de momentos de Z es por definicin

!

i=1

n

i

#

E[e ] = E[e ]

t Z t (Z Z) + tnZ D D

# #

#

i

i

= E[e ] E[e ]

t (Z Z) tnZ D

i

#

#

por la independencia de las variables aleatorias involucradas.

Dado que Z y nZ se distribuyen Chi-cuadrado con n y n-1 grados de libertad respectivamente, D

#

#

i

tenemos

(1 2t) = E[e ] (1 2t) .

^ ^ "#

n t ( ) # D

i

#

As,

E[e ] = (1 2t)

t ( ) n D ^ ^

i

"#

#

es la funcin generadora que corresponde a una distribucin Chi-cuadrado con n 1 grados de

libertad.

Ejemplo. Consideremos nuevamente el Ejemplo anterior y supongamos que extraemos una

muestra aleatoria de tamao n=10. Si estas observaciones son utilizadas para calcular S , podra

#

ser til especificar un intervalo de valores que incluya a S con alta probabilidad; esto es, encontrar

#

por ejemplo los nmeros b y b tales que

" #

P(S < b ) = 0.05 y P(S b ) = 0.95

# #

" #

para as tener

8

P(b S b ) = 0.9

" #

#

Notemos en este ejemplo que

P(b S b ) = P[(n 1)b / (n 1)S / (n 1)b )/ ].

" # " #

# # # # #

5 5 5

Dado que =1 y n=10, se sigue que (n 1)S / = 9S , tiene distribucin con 9 grados de 5 5 ;

# # # # #

libertad. Usando las tablas (9) podemos encontrar los dos nmeros 9b y 9b tales que ;

#

" #

P(9b 9S 9 b ) = 0.90

" #

#

Los valores correspondientes de la tabla son: 9b = 3.325 y 9b = 16.919, de donde se tiene que b

" # "

= 0.396 y b = 1.88. Luego, el intervalo (0.369, 1.88) contiene a S con probabilidad 0.90.

#

#

De los resultados del Teorema 1.5 es fcil ver que la distribucin de la variable aleatoria

n(X )/S, cuando X ,...,X es una muestra aleatoria de una poblacin normal, es t-student

.

" n

con n 1 grados de libertad. En efecto, sabemos que n(X )/ se distribuye N(0,1) y que

. 5

(n 1)S / se distribuye (n 1). Adems, estas dos variables son independientes, por lo que,

# # #

5 ;

de acuerdo a la definicin de una variable t-student con grados de libertad, /

T = = n (X )/S

Z

/

n(X )/

(n 1)S / (n 1)

; /

. 5

5

# #

=

.

se distribuye t- student con n-1 grados de libertad.

Este resultado corresponde a la desmostracin del siguiente teorema:

Teorema 1.6. Si X ,X ,...,X es una muestra aleatoria de una poblacin normal con media y

" # n

.

varianza , entonces n(X )/S tiene distribucin t-student con n 1 grados de libertad. 5 .

#

Lo ms importante de este resultado es que el parmetro se cancela al formar el cuociente en la 5

definicin de la variable aleatoria T, y la distribucin para n(X )/S es la misma no

.

importando el valor de . Esta variable aleatoria con distribucin t-student ser muy importante al 5

efectuar inferencias acerca de la media de una poblacin normal con varianza desconocida. . 5

#

Para aclarar las frecuentes confusiones que se producen respecto del uso de la distribucin Normal

(estndar) y la distribucin t-student, en relacin a expresiones del tipo

T = y Z = ,

(X ) (X )

S

. .

5

o como en el caso de la media

T = y Z = ,

(X ) (X )

S/ n / n

. .

5

9

observemos que si el valor de es conocido y el tamao de n es suficientemente grande, entonces 5

Z tendr distribucin normal estndar (utilizando el Teorema del Lmite Central). Si es 5

desconocida y la poblacin de donde se est muestreando es normal, entonces la distribucin de T

ser la de una t-student con (n-1) grados de libertad. No obstante lo anterior, y dada la similitud de

ambas distribuciones cuando n es grande; esto es, por ejemplo, cuando, n > 30 (este nmero es

tambin discutible), la distribucin t-student se puede aproximar por la normal estndar.

Ejemplo. La resistencia a la traccin de un cable se distribuye normalmente con media y .

varianza ambas desconocidas. Se seleccionan al azar 6 trozos de alambre y se mide la 5

#

resistencia X de cada uno de ellos. Tanto la media como la varianza poblacional pueden ser

i

estimadas mediante X y S , respectivamente. Encuentre la probabilidad que X est entre +/-

#

2S/ n veces la verdadera media poblacional ..

.

Deseamos encontrar la probabilidad

P (X )

2 S 2 S

n n

.

que es equivalente a calcular

P 2 2 = P(-2 T 2)

n(X )

S

.

donde T = tiene distribucin t-student con n 1 =5 g l. Esta probabilidad corresponde

n(X )

S

.

aproximadamente a

P( 2.015 T 2.015) = 0.90.

Por lo tanto, hay una probabilidad de 0.90 de que X est entre +/- dos desviaciones estndar de la

verdadera media. Si hubiese sido conocida, esta probabilidad se habra obtenido mediante la 5

#

relacin

P (X ) = P 2 2

2 2

n n

n(X )

5 5

.

5

= P( 2 Z 2)

= 0.9544.

1.4. Mtodos de Estimacin

Los problemas de inferencia estadstica (y sus soluciones) se dividen en dos reas: Estimacin de

parmetros y Pruebas de Hiptesis. Examinaremos la primera en esta seccin. Generalmente en un

10

problema de estimacin de parmetros se dispone una muestra aleatoria de una variable

poblacional X, cuya distribucin de probabilidades se supone conocida, salvo por algunos

parmetros que son desconocidos. El problema es entonces cmo usar las observaciones

muestrales para estimar los valores de estos parmetros.

Denotaremos por el parmetro desconocido, y por a su estimador. No haremos distincin, en la

^

) )

notacin, entre estadstico (variable aleatoria) usado como estimador de y el valor observado del )

estadstico, en ambos casos usaremos , en el entendido que quedar claro, segn el contexto, a

^

)

cul de los dos nos estamos refiriendo.

1.5 Mtodo por Momentos

Un procedimiento sencillo para obtener estimadores de parmetros es el mtodo de los momentos

que fue propuesto por Karl Pearson (1894). Sea q( ), una funcin que deseamos estimar. El )

mtodo de los momentos consiste en escribir la funcin de , q( ), como una funcin continua h ) )

de los primeros r momentos poblacionales, esto es,

q( ) = h( ,..., ) ) . .

" <

donde = E(X ) es el ; k=1,2,...,r, y luego considerar como .

k

k

k-simo momento poblacional

estimador por momentos a

T(X ,...,X ) = q( ) = h(M ,M ,...,M ),

" " # < n

)

s

donde M = X es el ; k = 1,2,...,r.

k

i=1

n

k

i

1

n

!

k-simo momento muestral

Veamos algunos ejemplos como ilustracin de este mtodo.

Ejemplo. Una muestra aleatoria de n observaciones X ,... X se selecciona desde una poblacin

"

n

con distribucin uniforme sobre el intervalo (0, ), en que es desconocido. Deseamos encontrar, ) )

mediante el mtodo de los momentos, un estimador de . ) )

s

El valor de para una variable aleatoria uniforme es = E(X) = /2. As, . . )

" "

= h( ) = 2 ) . .

" "

y

M = 1/n X = X

"

"

!

n

i

i

es el primer momento muestral. Por lo tanto, el estimador por momentos de es )

T(X ,X ,...,X ) = = 2M = 2X .

" # " n

)

s

11

Ejemplo. Supongamos que queremos estimar, por el mtodo de momentos, la varianza, , de una 5

#

poblacin cualquiera X.

Sabemos que = E(X ) (E(X) ) = = h( , ) Luego, si consideramos una muestra 5 . . . .

# # # #

# " #

"

aleatoria X ,...,X de esta poblacin, tenemos que el estimador por momento de la varianza

" n

poblacional es 5

#

T(X ,...,X ) = h(M ,M ) = M M

" " # #

#

"

n

= X X

1 1

n n

D D

# #

i

i

= X X

1

n

D

#

#

i

=

D(X X)

n

i

#

Para emplear el mtodo de momentos es necesario conocer los momentos poblacionales y no

necesariamente se debe conocer la distribucin de probabilidades de la poblacin. Aunque esta es

una ventaja del mtodo, este no proporciona estimadores nicos, debido a que el mtodo slo

exige exhibir una funcin h que involucre algunos momentos poblacionales y no siempre esta

funcin es nica, como lo veremos en el ejemplo siguiente.

Ejemplo. Estamos interesados en estimar el parmetro de una poblacin X con distribucin

Poisson de parmetro y, para ello, considermos una muestra aleatoria X ,....,X de X. )

" n

Como = E(X), entonces un estimador por momentos de es M = X , pero como tambin = , ) ) ) 5

"

#

en una distribucin Poisson, tenemos que un estimador por momentos tambin sera S . Si

n 1

n

#

n=5 y los valores observados de la muestra aleatoria son: 1, 2, 2, 3, 1,. podemos reportar como

valor estimado de a = 1.8 o = 0.56. ) ) )

s s

1.6. Mtodo Mximo Verosmil

Este mtodo es en general superior al mtodo de los momentos (en aquellos casos que resulten dos

estimadores distintos por ambos mtodos). Para ilustrar el mtodo, consideremos la siguiente

situacin: Supongamos que disponemos de una caja que contiene tres bolas. Sabemos que algunas

de ellas son rojas y otras son blancas, pero no sabemos el nmero exacto de cada color y nuestro

inters es estimar , el nmero total de bolas rojas. Se nos permite seleccionar al azar dos bolas. Si )

nuestro muestreo da como resultado la extraccin de dos bolas rojas, Cul sera un buen

estimador para ?. Obviamente, , el total de bolas rojas, deber ser dos o tres. Si el contenido real ) )

es de dos rojas y una blanca, esto es = 2, la probabilidad de obtener dos bolas rojas en la muestra )

es 3. En cambio, si = 3, tres bolas rojas en total, la probabilidad de obtener dos rojas es 1. " )

12

Parece entonces razonable elegir el valor tres como estimador de el nmero de bolas rojas en la )

caja, dado que con este valor se maximiza la probabilidad de la muestra observada. Por cierto, es

probable que la caja contenga slo dos bolas rojas, pero la evidencia de la muestra otorga mayor

credibilidad o verosimilitud a la existencia de tres rojas por sobre slo dos.

Definicin. Suponga que x ,...,x son los valores observados de una muestra aleatoria de una x

" n

poblacin X con funcin de probabilidad (o densidad), f(x. ), que depende de un parmetro )

desconocido . La funcin de probabilidad o densidad conjunta de la muestra aleatoria considerada )

como funcin de define a la ) funcin de verosimilitud.

L( ) = f(x , )f(x , ... f(x , ) ) ) ) )

" #

n

El mtodo de mxima verosimilitud consiste en obtener, como estimadores, aquellos valores de

los parmetros que maximizan la funcin de verosimilitud, L( )=L( ; x ,...,x ), considerada como ) )

" n

una funcin de . )

El mximo de L( ) ocurre en muchos casos en aquel valor de donde = 0. As, en la ) )

dL( )

d

)

)

mayora de los casos el estimador mximo verosmil (EMV) de , , se puede determinar desde ) )

s

= 0

dL( ; )

d

=

^

)

)

) )

x

Dado que L( ) es siempre no negativa y logra su mximo para el mismo valor de que ln(L), ) )

generalmente resulta ms simple obtener el EMV de resolviendo )

= 0

dlnL( ; )

d

=

^

)

)

) )

x

En las siguientes observaciones damos algunas propiedades importantes de los EMV.

Observaciones.

La extensin al caso de varios parmetros es natural. Si tenemos m parmetros, la funcin de

verosimilitud es L( ,..., ;x ,...,x ) y los EMV de ; j = 1,...,m los obtenemos resolviendo el ) ) )

" " m n j

sistema de ecuaciones

`

`

lnL

=

^

)

) ) j

j

= 0 ; j =1,2,...,m .

s

Se puede probar que si es el EMV de y si g( ) es una funcin de , uno a uno y ) ) ) )

diferenciable con respecto a , entonces el EMV de g( ) es g( ). Esta es la propiedad conocida ) ) )

s

como , y es muy importante en inferencia estadstica, ya que nos permite determinar invarianza

EMV de algunas funciones de parmetros (por ejemplo de funciones lineales), en condiciones muy

generales.

Ejemplo. Supongamos que x ,..., x corresponden a la realizacin de n ensayos Bernoulli x

" n

independientes con probabilidad de xito en cada ensayo, donde x =1 si el i-simo ensayo es un )

i

13

xito y x =0 si es un fracaso. Queremos determinar el estimador mximo verosmil de la

i

probabilidad de xito . )

La funcin de verosimilitud de la muestra observada es:

L( ; ) = (1 ) , ) ) ) x

y n y

donde y = x

!

n

i

i.

"

Para encontrar el valor de que maximiza L, notemos que L es igual a cero para =0 y 1, y es ) )

continua para valores entre 0 y 1. Luego podemos encontrar el punto mximo haciendo = 0 y

dL( )

d

)

)

resolviendo la ecuacin resultante para . Adems, dado que L es una funcin montona creciente, )

ln(L) y L sern maximizados por el mismo valor de , determinaremos el valor que maximiza )

ln(L) (denotado habitualmente como l( ; )); esto es, ) x

l( ; ) = x ln( ) + (n x )ln(1 ), ) ) ) x

! !

i i

cuya derivada es

dl( ; )/d = x (1/ ) + (n x )( 1/(1 ))

-

) ) ) ) x

! !

i i

Luego, el valor de que maximiza l( ;x) es la solucin de la ecuacin:

-

) )

x / (n x )/(1 ) = 0

! !

i i

) )

cuya solucin es

= x /n = x )

s

!

i

que corresponde precisamente a la fraccin de xitos en los n ensayos.

Ejemplo. Supongamos que X ,..., X representan los tiempos de fallas para una cierta pieza de un

" n

equipo y que los tiempos de vida son exponenciales e independientes con parmetro -

(desconocido). Queremos encontrar el estimador mximo verosmil para . -

Sean =x ,... x los valores observados de X ,..., X . La funcin de verosimilitud es entonces

-

x

" "

n n

L( ; ) = e , x > 0; i = 1,n

-

- - x

n

i

-Dx

i

lnL( ; ) = nln x .

-

- - -D x

i

=

dlnL( ; )

-

d

n -

- -

x

x D

i

Evaluando en = e igualando a cero, tenemos que = - - -

s s

n 1

x x D

i

= .

14

Ejemplo. En el ejemplo anterior vimos que el estimador mximo verosmil para , el parmetro -

de una distribucin exponencial es =1/X . La propiedad de invarianza, dice que el estimador -

s

mximo verosmil para la media de una variable con distribucin exponencial, = 1/ es = 1/ . - . - s

s

= X y el estimador mximo verosmil para P(X > c) es exp( c/x ) , para c>0 fijo.

-

1.7. Propiedades de los Estimadores Puntuales

Hemos estudiado hasta el momento dos mtodos para construir estimadores de parmetros (o

funciones de parmetros). En muchos casos estos dos mtodos conducen a los mismos

estimadores, pero tambin en muchos casos importantes esto no sucede as. Para la eleccin entre

dos o ms estimadores para el mismo parmetro es importante desarrollar criterios para

compararlos.

Consideremos la siguiente situacin: Un tirador dispara a un blanco y acierta justo en el centro de

l. Se trata, sin duda, de un excelente disparo. Pregunta: Sujetara Ud. el blanco sobre su cabeza

para el siguiente disparo?. Obviamente no podemos establecer la precisin del tirador en base a tan

pequea evidencia muestral. Sin embargo, si ste hace un milln de disparos y todos ellos aciertan

sucesivamente en el blanco, podramos confiar en la habilidad del tirador como para sujetar el

blanco en un prximo ensayo. La idea es que no podemos establecer las propiedades de un

estimador en base a un sola observacin. En lugar de ello, deberamos observar los resultados del

procedimiento un gran nmero de veces y construir distribuciones de frecuencia de los valores

obtenidos para el estimador, considerando varias observaciones. De la distribucin del estimador

podemos observar que tan cerca del parmetro de inters se agrupan los distintos valores.

Siguiendo el razonamiento anterior, nos interesa entonces establecer algunos criterios bajo los

cuales la calidad de un estimador puede ser evaluada. Estos criterios definen, en general,

propiedades deseables de los estimadores que nos sirven para compararlos.

Supongamos que deseamos especificar un estimador puntual de un parmetro poblacional . El )

valor estimado de se indica por el smbolo . Con el ejemplo anterior es obvio que una de las ) )

s

propiedades deseables sera que la distribucin muestral de los valores estimados estuviera

centrada en el valor poblacional, , como se muestra en la Figura 5.1. En otras palabras, )

desearamos que la media o el valor esperado del estimador sea igual al valor del parmetro; esto

es, deseamos que E( ) = . Los estimadores puntuales que poseen esta propiedad se llaman ) )

s

estimadores insesgados.

Definicin. Sea un estimador puntual de un parmetro . Se dice que es insesgado si y slo si ) ) )

s s

(ssi.) E( ) = para todo . En caso contrario se dice que es sesgado. ) ) ) )

s s

En otras palabras, con esto esperamos que "en promedio" sea cercano al verdadero valor del )

s

parmetro.

15

Definicin. sesgo El B de un estimador puntual est dado por la expresin )

s

B = E( ) . ) )

s

De acuerdo a lo que hemos visto hasta aqu, si utilizamos X y S como estimadores de la media

#

poblacional y la varianza poblacional , stos seran insesgados. Ahora, si usamos . 5

#

5 D 5 5 s

# # # #

= (X X ) como estimador de la varianza encontramos que su media es , y por

1 n 1

n n

i

tanto sera un estimador sesgado de . Parece natural que un buen estimador no slo debe ser 5 5 s

# #

tal que su media est cercana al verdadero valor del parmetro, sino que tambin debera variar

poco. Por lo tanto, debemos considerar estadsticos que adems de ser insesgados tengan varianza

tan pequea como sea posible.

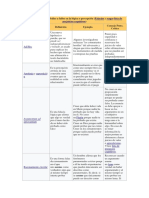

a) b) c)

Figura 1.1. Distribuciones de centradas en . a) y b) muestran mayor varianza

^

) )

que c).

Las Figuras 6.1 corresponden a distribuciones de un estimador insesgado . Es evidente que la

^

)

representada por Figura 6.1 c) es preferida pues tiene una menor varianza, lo que implica que )

s

estar ms de que en las otras distribuciones mostradas. "cerca" )

Definicin. insesgado de Sea un estimador insesgado de . Decimos que es un estimador ) ) )

s s

mnima varianza para , ) si para cualquier otro estimador insesgado de se tiene que ) )

Var( ) Var( ), .

^

) ) ) a

Lo anterior nos permite formular la siguiente regla: Dados dos estimadores para el parmetro , y )

siendo todo el resto de las condiciones equivalentes para ambos, se elegir siempre aquel de

menor varianza.

Ejemplo. Sabemos que la media muestral X es un estimador insesgado de la media poblacional.

Por lo tanto, X es un estimador insesgado de , parmetro de una distribucin Normal; de la

. .

media de una distribucin Poisson( ) y de p parmetro de una distribucin Bernoulli. Nos interesa .

averiguar si la calidad de X mejora cuando n crece. E(X ) = que no depende de n; pero V(X ) =

.

16

5

#

/n decrece cuando n aumenta. Es claro entonces que, basndose en un criterio de mnima

varianza, la calidad de X como estimador de mejora cuando n crece.

.

Una pregunta natural de formular es: basndonos en una muestra fija de tamao n, Podramos

encontrar otro estimador mejor para , distinto de X , en trminos de insesgamiento y mnima .

varianza, para estas distribuciones?. La respuesta est en la desigualdad de Cramer-Rao que

proporciona una cota inferior para la varianza de cualquier estimador insesgado del parmetro de

una distribucin de probabilidades, bajo condiciones de regularidad que incluyen:

i) El espacio de valores de la variable aleatoria involucrada debe ser independiente

del parmetro.

ii) La funcin de densidad (o funcin de probabilidad) debe ser una funcin continua y

diferenciable del parmetro.

Teorema 1.7. (Cramer-Rao). Sea X ,..., X una muestra aleatoria de tamao n de una poblacin X

" n

con funcin de densidad (o funcin de probabilidad) f(x; ), que depende de un parmetro ) )

desconocido, y satisface las condiciones de regularidad. Sea = T(X ,....,X ) un estimador )

s

" n

insesgado para . Entonces )

Var( ) )

s

1

nE ( )

`

`

lnf(x, ) )

)

2

Demostracin. Desarrollaremos la demostracin para el caso en que X es una variable aleatoria

continua. Un resultado anlogo se puede establecer cuando X es discreta.

Dado que X ,..., X es una muestra aleatoria., tenemos que

" n

f(x ,..., x ; ) = f(x ; )...f(x ; ).

" " n n

) ) )

Por otra parte, por la propiedad de insesgamiento de = T(X ,..., X ) y la definicin de valor

^

)

1 n

esperado tenemos

E(T(X ,...,X )) = ;

1 n

)

esto es,

= T(x ,...,x ) f(x ; )...f(x ; )dx ...dx (1.1) ) ) )

(

n

" " " n n n

Adems, sabemos que para i = 1,...,n

f(x ; )dx = 1 (1.2)

(

i i

)

Diferenciando (1.1) con respecto a , tenemos )

17

1 = T(x ,...,x ) f(x ; ) f(x ; )...f(x ; )dx ...dx

1

f(x ; )

(

"

n

" " "

"

n j n n

n

j

j

) )

) ) )

`

`

= T(x ,...,x ) lnf(x ; ) f(x ; )...f(x ; )dx ...dx (1.3)

(

"

n

" " "

"

n j n n

n

j

`

`)

) ) )

Diferenciando (1.2) respecto a tenemos )

0 = f(x ; ) dx , j = 1,n

(

`

`)

)

j j

que podemos escribir como

0 = lnf(x ; )f(x ; )dx , j=1,n. (1.4)

(

`

`)

) )

j j j

Si hacemos Y = lnf(x ; ) obtenemos de (1.4) y (1.3) que

!

n

j

j

"

`

`)

)

E(Y) = 0 y E(TY) = 1.

Adems,

Var(Y) = Var lnf(x ; )

!

n

j

j

"

`

`)

)

= Var( lnf(x ; ))

!

n

j

j

"

`

`)

)

= E lnf(x ; )

!

n

j

j

"

#

`

`)

)

= nE lnf(x ; ) .

`

`)

j

)

#

Por otra parte

Cov(T,Y) = E(TY) pues E(Y) = 0

y por definicin de coeficiente de correlacin tenemos

3

TY

=

E(TY)

5 5

T Y

18

donde = Var (T) y = Var (Y) y es la correlacin entre T e . Entonces 5 5 3

# #

]

]

T

T

]

E(TY) = 3 5 5

TY

T Y

o

1 = 3 5 5

TY

T Y

Finalmente, notando que 1, tenemos que 3

#

Var ( ) = Var(T) = . )

s

1 1

nE( lnf(x; ))

5

)

#

]

`

`)

2

Si no es un estimador insesgado de , se puede probar que la cota de Cramer-Rao est dada por ) )

s

la expresin

. 5

#

s

)

(1+B( )) (1+B( ))

nE( lnf(x; ))

I( )

) )

)

)

s s

# #

`

`)

2

=

La cantidad I( ) es conocida como o . De aqu ) cantidad de informacin Informacin de Fisher

que la CCR tambin se conoce con el nombre de . Desigualdad de Informacin

En la clase de estimadores insesgados, la cota inferior en la desigualdad de informacin es 1/I( ), )

independientemente del estimador que estemos considerando.

Bajo supuestos que implican la existencia de las segundas derivadas y el intercambio del orden de

ciertas integrales con sus derivadas, la desigualdad de Cramer-Rao se puede escribir tambin como

Var ( ) )

s

` `

1

nE{ ln f(X; )/ }

# #

) )

Esta expresin alternativa es ms til para efectos computacionales.

La CCR puede extenderse fcilmente para ciertas transformaciones del parmetro.

Especficamente, si = g( ) es una transformacin uno a uno y diferenciable, entonces: : )

CCR para Var ( ) = CCR para Var ( ), : ) s

s

dg( )

d

)

)

#

donde es un estimador insesgado de . : : s

Dado un estimador insesgado de , la razn de su cota de Cramer-Rao a su varianza, se llama ) )

s

eficiencia de . )

s

Notemos que segn esta definicin, la eficiencia de cualquier estimador insesgado

es siempre menor o igual que uno. Un estimador insesgado con eficiencia uno se dice eficiente.

19

As, con respecto a la pregunta, Es X el mejor estimador para en trminos de insesgamiento y

_

.

mnima varianza?, para responderla consideremos, por ejemplo, la funcin de densidad

correspondiente a una poblacin N( , ), donde slo es desconocido. Entonces, . 5 .

#

ln f(X; ) = ln , .

1

2

(X )

2

1 5

.

5

#

#

=

`

`

ln f(X; ) (X ) . .

. 5

#

y

E = E = 1/ .

`

`

ln f(X; ) X . .

. 5

#

#

#

2

5

La CCR establece entonces, que la varianza de cualquier estimador insesgado de es mayor o .

igual a /n. Como Var(X)= /n, entonces X tiene mnima varianza entre todos los estimadores

_ _

5 5

# #

insesgados para , cuando la poblacin es normal y slo es desconocido. Adems, X es un

_

. .

estimador eficiente, pues la razn entre la CCR y la varianza de X es uno.

_

En algunas situaciones, es deseable obtener estimadores del parmetro de inters, considerando

como criterio la minimizacin tanto del sesgo, como de la varianza del estimador. Esto se logra

minimizando el promedio de la distancia al cuadrado entre y el verdadero valor del parmetro. ) )

s

Esta cantidad se denomina Cuadrado Medio del Error.

Definicin. Cuadrado Medio del error El (CME) de un estimador puntual se define por )

s

CME( ) = E( ) . ) ) )

s s

#

Notemos que

CME( ) = E(( E( ) + (E( ) )) ) ) ) ) )

s s s s

#

= E(( E( )) + (E( ) )) , ) ) ) )

s s s

# #

dado que los dobles productos se hacen 0. Luego, CME( ) = Var ( ) + B . ) )

s s

#

Por lo tanto, si es un estimador insesgado del parmetro , entonces CME( ) =Var( ). ) ) ) )

s s s

Ejemplo. Sea X , X una muestra aleatoria de tamao 2 de X con distribucin Exponencial de

" #

parmetro desconocido. Consideremos a =X y a = X X estimadores de =1/ . En

_

- ) ) . -

s s

" #

1 2

trminos del error cuadrtico medio, cul de los dos es mejor?.

20

El CME( )=Var( )=1/(2 ), por ser X un estimador insesgado de . Ahora,

_

) ) - .

s s

" "

#

CME( ) = Var ( X X ) + (E X X ) ) .

s

#

#

1 2 1 2

de donde

Var( X X ) = E(X X ) E( X )E( X ).

1 2 1 2 1 2

.

Caculemos E( X) con X exponencial de parmetro .

-

E( X) = x e dx = = ( / ) /2

(3/2)

(

_

" # " #

" #

!

/ x /

/

- 1 -

>

-

-

Por lo tanto

Var( X X ) = 1/ /(16 ) =

1 2

- 1 -

# # #

16

16

1

-

#

#

y

B( X X ) = ((1/4) ( / ) 1/ ) =

1 2

1 - -

#

#

1

-

4

4

De aqu, el Error Cuadrtico Medio de est dado por )

s

#

CME( ) = )

s

#

4

2

1

-

#

.

Como 4 < 1 tenemos EMC( ) < EMC( ) y, de acuerdo a este criterio, es preferido a .

s s s s

1 ) ) ) )

# " # 1

Otra propiedad adicional que un estimador puede tener es la propiedad de consistencia. Esta es una

propiedad asinttica o de muestras grandes, ya que describe una propiedad lmite de la distribucin

de probabilidades del estimador, cuando el tamao de la muestra n aumenta.

Supongamos que lanzamos una moneda n veces, con probabilidad p de obtener cara en cada

ensayo. Si los lanzamientos son independientes, y definimos la variable aleatoria Y como el

nmero de caras en los n lanzamientos, entonces Y tiene distribucin Binomial. Si el verdadero

valor de p es desconocido, la proporcin muestral p=Y/n es un estimador insesgado de p. Qu

^

pasa a esta proporcin muestral si aumenta el nmero n de lanzamientos?. Intuitivamente diremos

que a medida que n aumenta, Y/n se acercar al verdadero valor de p. Como Y/n es una variable

aleatoria, esta cercana a p en trminos probabilsticos la cuantificamos mediante la expresin

P(|Y/n-p|< ) para un valor arbitrario >0. Esta probabilidad ser cercana a 1 si nuestra intuicin es % %

correcta.

Definicin consistente . El estimador se dice para si, para cualquier >0, se tiene que ) ) %

s

n

lim (P| | < ) = 1,

n _

s

) ) %

n

21

o equivalentemente

lim P(| | > ) = 0 .

n _

s

) ) %

n

Notemos que, de la desigualdad de Chebyshev

P(| |> ) = ) )

s

n

E( ) CME( ) ) ) )

% %

s s

n n

#

# #

de donde se sigue que si el CME( ) tiende a cero cuando n tiende a infinito; esto es, tanto la )

s

n

varianza como el sesgo de tienden a cero cuando n tiende a infinito, entonces es un ) )

s s

n n

estimador consistente de . )

Teorema 1.8 . Un estimador insesgado de es consistente si ) )

s

n

lim Var( ) = 0.

n _

s

)

n

Ejemplo. Sea X ,...,X una muestra aleatoria de una poblacin con distribucin de probabilidades

" n

con media y varianza < . Verifiquemos que X es un estimador consistente de .

_

. 5 .

#

_

Sabemos que E(X)= y Var(X)= /n. Dado que X es un estimador insesgado para , y como

_ _ _

. 5 .

#

Var(X) 0, cuando n crece, el teorema anterior se aplica directamente.

_

p

Equivalentemente se puede decir que X converge en probabilidad a . Este hecho es tambin

_

.

conocido como la Ley de los Grandes Nmeros.

Hasta el momento hemos utilizado la informacin contenida en una muestra de tamao n para

calcular el valor de estadsticos de inters, como por ejemplo X y S . Debemos preguntarnos, sin

_

#

embargo, si este proceso de condensacin de la informacin ha retenido toda la informacin

disponible acerca de y , o bien, si se ha perdido alguna informacin acerca de los parmetros . 5

#

poblacionales durante el proceso de reduccin de los datos.

En consideracin a la pregunta anterior, debemos buscar estadsticos que resuman toda la

informacin contenida en la muestra acerca del parmetro desconocido de inters. Tales

estadsticos se dice que tienen la propiedad de suficiencia o ms simplemente son llamados

estadsticos suficientes.

Un estadstico T(X ,...,X ) se dice suficiente si utiliza toda la informacin de una muestra

" n

relevante a la estimacin del parmetro poblacional ; esto es, si todo el conocimiento que )

podemos obtener acerca de especificando los valores observados de X = (X ,...,X ), tambin )

" n

puede ser obtenido observando el valor del estadstico T(X).

_

Definicin. Sea X ,...,X una muestra aleatoria de una distribucin de probabilidades con

" n

parmetro desconocido . T = T(X ,...,X ) es un estadstico para , si y slo si (ssi), la ) )

" n

suficiente

distribucin condicional de (X ,...,X ) dado T=t, para todo valor de t, es independiente de .

" n

)

22

Ejemplo. Consideremos los resultados observados de n ensayos Bernoulli independientes

X ,...,X , donde X =1 con probabilidad p y es 0 con probabilidad 1 p.

" n i

Sea T = X = N de xitos en los n ensayos. Si conocemos el valor de T, Podemos ganar

!

i=1

n

i

informacin adicional acerca de p, observando otras funciones de X ,...,X ?.

" n

Una manera de responder es observar la distribucin condicional de X ,...,X dado T=t; esto es:

" n

P(X =x ,...,X =x |T=t) =

" " n n

P(X =x ,...,X =x , T=t)

P(T=t)

" " n n

P(X =x ,...,X =x )

P(T=t

" " n n

=

p (1 p) }

p (1 p)

t n t

t n t

n

t

= .

1

n

t

Como esta probabilidad condicional no depende de p, podemos concluir que una vez conocido T,

ninguna otra funcin de X ,...,X proporciona informacin adicional sobre el posible valor de p.

" n

En este sentido, T contiene la informacin relativa a p y, por tanto, es un estadstico suficiente para

p.

La definicin anterior, no nos permite en forma directa la obtencin de un estadstico suficiente

para un parmetro . El siguiente teorema nos proporciona un criterio para obtener facilmente )

estadsticos suficientes.

Teorema 1.9. (de Factorizacin de Fisher) Sea T(X), un estadstico basado en la muestra

_

aleatoria X=(X ,...,X ). T(X) es un estadstico suficiente para si y solo si, la densidad conjunta de

_ _

" n

)

X (la funcin de verosimilitud L( ,x)), puede ser factorizada en dos funciones no negativas, de la

_

)

forma

L( , x) = g(T(x), ) h(X),

_ _

) )

donde g es una funcin slo de T y , y h no es funcin de . ) )

Ejemplo. Sea X ,...,X una muestra aleatoria de una poblacin con distribucin exponencial con

" n

media ; esto es, X posee funcin de densidad -

i

f( ; x ) = 1/ exp( x / ), x > 0, i=1,n ) - -

3 3 3

La funcin de verosimilitud de la muestra es la densidad conjunta

23

L = f( ; x ,...,x ) = f ( ; x ) f( ; x )...f( ; x ) - - - -

" " # n n

= [exp( x / )] ... [exp( x / )]

"

- - - -

n

= [exp( x / ]

!

n

n

3"

3

- -

= [exp ( nx/ )] .

_

- -

n

Como L es una funcin que depende slo de y x, aplicando el teorema de factorizacin con g( ,

_

- -

x) = [exp( nx/ )] y h(x) = 1, podemos concluir que X es un estimador suficiente para .

_ _

_

_

- - -

n

Notemos tambin que X es otro estadstico suficiente para .

!

4

-

Ejemplo. Sea X ,...,X es una muestra aleatoria de una distribucin uniforme en (0, ) y

" n

)

determinemos un estadstico suficiente para . )

La funcin de verosimilitud de la muestra aleatoria es

L( , x) = (1/ ) , x (0, ) para todo i=1,...,n

_

) ) )

n

3

lo que es equivalente a escribir

L( , x) = (1/ ) , para x < ; donde x = mx (x , x ,...,x ).

_

) ) )

n

n n n " #

As, tenemos la factorizacin

L( , x) = (1/ ) I (x ) = g( , X ),

_

) ) )

n

n n ! )

donde

I (x) =

A

1 si x A

0 si x A

es la funcin indicadora de un conjunto A. Por lo tanto, aplicando el teorema de factorizacin con

h(x) =1, un estadstico suficiente para es T(X ,...,X ) = X . )

" n n

1.8. Estimacin por Intervalos

Hasta aqu, hemos revisado las propiedades de estimadores puntuales de los parmetros de una

distribucin poblacional de probabilidades. Proporcionar un buen estimador, T(X), del parmetro o

funcin del parmetro, , no es suficiente, ya que debemos de alguna manera dar cierta idea de la )

incertidumbre de la estimacin, la que puede ser producto, por ejemplo, de la seleccin de la

muestra. Para esto incorporamos el concepto de precisin o de error del estimador.

Usualmente los investigadores proporcionan como estimacin de un parmetro desconocido a )

T(X) + , donde generalmente es el error cuadrtico medio de T o una estimacin de l. Sin

_

% %

embargo, tambin hay dificultades al reportar, por ejemplo que =2+0.01, ya que a pesar que T(X)

_

)

24

sea un estimador insesgado y sea exactamente la desviacin estndar de T(X), no tenemos %

seguridad que las cotas T+ y T incluyan a . En realidad, en la mayora de los problemas, se % % )

tiene una probabilidad positiva que [T(X) , T(X)+ ] no incluya a , para cualquier dado. % % ) %

Ilustremos esta idea en el ejemplo siguiente

Ejemplo. Sea X ,...,X una muestra aleatoria de una poblacin N( , ) con conocida. Nuestro

"

# #

n

) 5 5

inters es estimar , la media de la poblacin normal. Como el estimador natural a usar es X y su

_

)

desviacin estndar es / n los investigadores establecern que = X+ / n.

_

_

5 ) 5

Podemos calcular la probabilidad que estas cotas, X+ , no incluyan a como sigue

_

_

% )

P(|X |> ) = P > = P(|Z| > )

_

) %

n (X )

_

)

5

% %

5 5

n n

= P(Z> ) + P(Z < )

% %

5 5

n n

= ( ) + (1 ( )) F F

% %

5 5

n n

= 2 ( ) > 0 F

%

5

n

cualquiera sea y n, donde indica la funcin de distribucin de la normal estndar. % F

Si elegimos o n suficientemente grande, esta probabilidad puede hacerse ms pequea que %

cualquier nmero positivo. Si hacemos = / n, por ejemplo, tenemos de las tablas normales que % 5

P(|X |> / n) = 0.32, un nmero no muy pequeo para ser desechado.

_

) 5

Esta ilustracin nos sugiere que en lugar de elegir igual a la desviacin estndar de nuestro %

estimador, debemos elegir un nmero , y despus preocuparnos de elegir (o y n) ! % %

suficientemente grande, de manera de tener

P(|X |> ) = 2 ( ) =

_

) % F !

%

5

n

y, finalmente, afirmar que est entre X y X+ . Equivalentemente, podemos escribir,

_ _

) % %

P(X X+ ) = 1 P(|X |> ) = 1

_ _ _

% ) % ) % !

y afirmar con una confianza del (1 ) 100% que el intervalo aleatorio [X , X ] incluye al

_ _

! % %

verdadero valor del parmetro . )

Lo anterior nos lleva, en la situacin general, a buscar un par de estadsticos, T (X) y T (X), tal

I S

que

25

P(T (X) T (X)) = 1-

I S

) !

para un preasignado. !

En algunas ocasiones, particularmente cuando se trabaja con distribuciones discretas, no podemos

encontrar intervalos (T , T ) razonables tales que P(T (X) T (X)) sea exactamente igual a

I S I S

)

1 , para un fijo. ! !

Definicin. El intervalo aleatorio de extremos (T ,T ) formado por los estadsticos T y T , con

I S I S

T Y , es un intervalo del (1 ) 100% de confianza para , si para todo

I S

! ) )

P(T (X) T (X)) 1 (6.5)

I S

) !

Los extremos T y T se llaman lmite de confianza inferior y superior, respectivamente. 1 se

I S

!

llama . Nivel de Confianza

Es posible tambin, obtener cotas de confianza (1 ) 100% para , tales que ! )

P(T ) 1 o bien P( T ) 1 ,

I S

) ! ) !

donde T y T son estadsticos que conforman una cota superior e inferior para , respectivamente.

S I

)

Dado que la amplitud L = T T es una variable aleatoria, podemos pensar en elegir intervalos

S I

de longitud esperada mnima como un buen criterio de calidad. Desafortunadamente, pueden no

existir estadsticos T y T que generen un intervalo de longitud esperada para todos los posibles

I S

valores de . Se puede probar que si un intervalo de amplitud mnima existe, l puede obtenerse )

utilizando funciones de estadsticos suficientes como lmites de confianza.

Ejemplo. Claramente, el intervalo (X z / n ; X + z / n ) es un intervalo de

_ _

" " ! !

" #

5 5

confianza a nivel 1 ( + ), para la media de una poblacin normal con varianza , ya que ! ! 5

" #

2

satisface (6.5) con = + . Mostremos que el intervalo ms estrecho a nivel 1 de la forma ! ! ! !

" #

(X z / n ; X+z / n)

_ _

" " ! !

" #

5 5

se obtiene considerando = = /2. En efecto, la longitud (esperada) del intervalo es ! ! !

" #

L= (z + z )

5

n

" " ! !

" #

que, bajo la condicin = + , pasa a ser ! ! !

" #

L= (z + z ).

5

n

" " ( ) ! ! !

# #

As, debemos encontrar de manera de minimizar L, lo que es equivalente a minimizar !

#

26

f( ) = z + z !

# 1 + 1 ! ! !

2 2

= (1 + )+ (1 ), F ! ! F !

" "

# #

con (t ) = P(Z t ) = , ( ) = t y Z es la normal estndar. F ! F !

! ! !

"

Derivando la funcin f respecto de tenemos !

2

f ( ) =

w

#

! ,

1 1

( (1 + )) ( (1 )) : F ! ! : F !

" "

# #

donde es la funcin de densidad normal estndar. :

Igualando a cero la derivada obtenemos

( (1 + )) = ( (1 )); : F ! ! : F !

1 1

2 2

o bien,

(x) = (y), : :

donde x = (1 + ) e y = (1 ) F ! ! F !

1 1

2 2

cuya solucin es x = y, ya que es una funcin par. Luego tenemos que (1 + ) = : F ! !

1

2

F ! ! ! ! ! !

1

2 2

2 2

(1 ) que es equivalente a 1 + =1 , de donde se tiene que = /2 y luego

! ! ! !

1 2

= = /2. Por lo tanto, el intervalo de confianza ms estrecho a nivel 1 para la media de una

poblacin normal es

(X z / n ; X+z / n) (6.6)

_ _

" " ! !

/2 /2

5 5

Un mtodo muy til para encontrar intervalos de confianza es el que consiste Mtodo del Pivote,

en determinar una cantidad, llamada que posee las siguientes dos caractersticas: es una Pivote,

funcin de las medidas muestrales y del parmetro ; y tiene una distribucin de probabilidades )

conocida ( tabulada) que no depende del parmetro . )

A continuacin veremos ejemplos de uso de un pivote para construir intervalos de confianza a

nivel (1 ) para distintos parmetros de inters. !

6.9. Intervalos de Confianza para la media en poblaciones N( ,, ) . 5

#

con conocida 5

#

Consideremos una muestra aleatoria X ,...,X de una poblacin X, con distribucin normal. Como

" n

ya probamos en el Teorema 6.2, X se distribuye N( , /n). Si definimos

_

. 5

#

P(Z< z ) = 1 /2

" # !/

!

y

27

P( z < Z < z ) = 1 .

" # " # ! ! / /

!

De aqu obtenemos

P( z < n (X )/ < z ) = 1 ,

_

" # " # ! ! / /

. 5 !

lo que es equivalente a

P(X z < < X+z ) = 1 .

_ _

" # " # ! !

5 5

/ /

n n

. !

As, los lmites de confianza para son .

X + z

_

_

" # !

5

/

n

que coinciden con el obtenido en (6.6).

Este resultado podemos emplearlo tambin en el caso no normal, para estimar medias, si el tamao

muestral es suficientemente grande como para justificar la aplicacin del Teorema del Lmite

Central.

Notemos tambin que el intervalo de confianza es una funcin de X; por lo que variar con la

_

muestra. Por otra parte, la amplitud del intervalo es slo funcin del tamao muestral n, siendo

inversamente proporcional a n.

Un problema que surge de inmediato es Cul es el tamao mnimo de la muestra para lograr un

determinado grado de precisin en la estimacin de ?. Esta pregunta la respondemos en la .

seccin que sigue.

6.10. Determinacin del tamao de muestra

Hasta aqu hemos calculado los intervalos de confianza basndonos en el supuesto de que se

conoce el tamao muestral n. Sin embargo, en muchas situaciones prcticas el tamao muestral

ptimo es desconocido. En tales casos es posible calcular dicho tamao ptimo, siempre que

podamos responder a las preguntas: Qu nivel de confianza deseamos?, y Cul es la diferencia

mxima, , que podemos aceptar entre la estimacin puntual del parmetro poblacional y el %

verdadero valor de dicho parmetro?.

As, si representa el mximo error que podemos tolerar al estimar el parmetro poblacional % )

mediante , la magnitud del mximo error permisible al estimar mediante la definimos como ) ) )

s s

| | = | | . ) ) ) ) %

s s

28

Entonces, el grado de precisin depende tanto de como de 1 , el grado de confianza de que el % !

error no exceda al mximo error permisible.

En general el tamao de la muestra se obtiene de la expresin:

z , 5 %

)

s " # !/

donde z queda determinado por el grado de confianza 1- .

" # - / !

!

Para nuestro ltimo ejemplo tenemos:

= z Var (X) = z %

" # " # ! ! / /

n

de donde el tamao muestral debe ser al menos z / , cuando la varianza es conocida; esto

1 /2

# # #

!

5 %

es,

n z / .

1 /2

# # #

!

5 %

Si en particular deseamos el promedio diario de rendimiento de un proceso de produccin de un .

producto qumico y deseamos adems que con una probabilidad .95, el error de estimacin no sea

mayor que 5 toneladas. Entonces, dado que si repetimos las muestras un gran nmero de veces,

aproximadamente el 95% de las medias muestrales estar entre 2 de , lo que estamos pidiendo 5 .

X

_

es que 2 sea igual a 5 tons., lo que significa que 2 / n = 5. Despejando n obtenemos 5 5

X

_

n 4 /25. 5

#

Esto siginfica que para obtener un valor numrico para n, necesitamos conocer el valor poblacional

del parmetro . Cuando no se dispone del verdadero valor de , debemos utilizar la mejor 5 5

# #

aproximacin disponible, como por ejemplo su estimador S , obtenido de experiencias previas.

#

6.11. Intervalo de Confianza para la media en poblaciones N( , ) con desconocida . 5 5

# #

Sea X ,...,X una muestra aleatoria de una poblacin N( , ). Sabemos que T = n(X )/S se

_

"

#

n

. 5 .

distribuye t-student con =n 1 grados de libertad, entonces podemos determinar t tal que /

" # !/

P( t T t ) = 1 .

" # " # ! ! / /

!

De aqu, reemplazando y despejando nos queda .

P(X t S n X + t S n) = 1 .

_ _

" # " # ! ! / /

. !

As, los lmites de confianza son

29

X + t S n

_

_

" # !/

y

(x t s/ n ; x + t s/ n)

_ _

" # " # ! ! / /

es un intervalo del 100(1 )% para , si x y s son los valores observados de X y S,

_

_

! .

respectivamente.

6.12. Intervalos de Confianza para 5

#

Recordemos aqu que es un nmero que cuantifica la cantidad de variabilidad de la poblacin. 5

#

Este valor es generalmente estimado a partir de la expresin

S = (X X) /(n 1)

_

# #

3"

3

!

n

que es un estimador insesgado de . Adems de necesitar informacin acerca de , para calcular 5 5

# #

intervalos de confianza para la media , podramos estar interesados en obtener intervalos de .

confianza para propiamente tal; esto es, por ejemplo, la estimacin de la cantidad de variacin 5

#

en un proceso de produccin de ciertas unidades.

Como ya hemos mencionado, debemos empezar por definir un pivote. Supongamos una vez ms,

que disponemos de una muestra aleatoria X ,...,X de una distribucin normal con media y

" n

.

varianza , ambas desconocidas. Recordemos tambin que 5

#

[(X X) ] = [(n 1) S ] ,

_

!

n

3"

3

# # # #

5 5

tiene distribucin con (n-1) grados de libertad. Podemos ahora, usando el mtodo del pivote, ;

#

proceder a encontrar dos cantidades y , tales que ; ;

# #

# " # ! ! / - /

P[ (n 1)S / )] = 1 . ; 5 ; !

# # # #

# " # ! ! / /

para un nivel de confianza 1 . !

Debido a la asimetra de la distribucin, nos preocupamos de encontrar los puntos que definen

igual rea en las colas.

Si reordenamos los extremos de la desigualdad en la expresin probabilstica anterior, se tiene,

P[(n 1)S / (n 1)S / ] = 1 .

# # # # #

# #

; 5 ; !

1 / / ! !

Luego,

[(n 1) s / ; (n 1) s / ]

# # # #

# #

; ;

1 / / ! !

30

es un intervalo de confianza del 100(1 )% para la varianza de una poblacin normal con media !

desconocida.

Ejemplo. Un investigador desea verificar la variabilidad de un equipo diseado para medir el

volumen de una fuente de ruido. Utilizando este equipo, se obtienen tres mediciones

independientes del mismo sonido, ellas son: 4.1, 5.2 y 10.2. Se pide estimar con un nivel de 5

#

confianza de .90.

Asumiendo normalidad, tenemos que s =10.57. Considerando /2 =0.05 y (n 1)=2 grados de

#

!

libertad, se obtienen los valores de tabla = 0.103 y =5.991. Por lo tanto, el intervalo de ; ;

# #

!& *&

confianza para la varianza poblacional es (3.53; 205.24). 5

#

Ntese que este intervalo es muy amplio, la razn de esta amplitud es el pequeo tamao de n.

6.13. Intervalo de Confianza para una Proporcin

Supongamos que deseamos construir un intervalo de confianza para el parmetro p, la

probabilidad de xito, de una distribucin Bernoulli. Si disponemos de una muestra aleatoria,

X ,...,X , sabemos que X es un estimador insesgado de p, y si n es grande

_

" n

X N(p, ),

_

pq

n

de donde

Z = N(0, 1) cuando n es grande.

X

_

n

p

pq/

Entonces existe Z tal que

" # - / !

P( Z < Z< Z ) = 1 - ,

" # " # ! ! / /

!

esto es,

P( Z < < Z ) = 1

" # " #

! ! / /

X

_

p

pq/n

!

Notemos que para determinar los lmites de confianza para p, necesitamos resolver para p la

ecuacin

Z ,

|X |

_

/

" #

p

p(1 p)/n

!

lo que es equivalente a:

(X p) Z

_

# #

" # !/

p(1 p)

n

o bien

31

p (1+ ) p(2X + ) + X 0,

_ _

#

# Z

n n

Z

#

" # " # ! ! / /

que es una parbola, cuyas races definen el intervalo dentro del cual la parbola es negativa.

Resolviendo la ecuacin cuadrtica tenemos

(X + ) + X(1 X) +

_ _ _

_

2X + Z /

_

Z Z

Z

# #

" # " # " #

#

" #

! ! !

!

/ / /

2n 4n

n

1/2

/

n

que para n grande y para (1 ) razonable, podemos aproximarlo por !

X + Z X(1 X)/n .

_ _ _

_

" # !/

As, un intervalo de confianza aproximado al 100(1- )% para p est dado por !

x Z x(1 x)/n ; x + Z x(1 x)/n

_ _ _ _ _ _

" # " # ! ! / /

donde x es el valor observado de X.

_

_

Ejemplo. Supongamos que en una muestra aleatoria de 500 personas en la ciudad de Concepcin

se encontr que 375 no estn de acuerdo con los mtodos de eliminacin de desechos industriales.

Un intervalo de confianza del 95% para p, la proporcin real de la poblacin penquista que no est

de acuerdo con dichos mtodos, lo obtenemos como sigue

De la informacin tenemos que n =500 y x =372/500=0.74 y, para =0.05 tenemos de las tablas

_

!

normales que Z = 1.96. As, el intervalo del 95% de confianza para p, est dado por

" # !/

(0.74-0.04 , 0.74+0.04) = (0.70 , 0.78).

6.14. Tamao de Muestra para Proporciones

Notemos que la magnitud del error cometido, cuando utilizamos X como una estimacin de p, est

_

dada por X. p . Empleando nuevamente la distribucin normal, podemos asegurar con

_

probabilidad 1- que la desigualdad !

X. p z p(1 p)/n

_

1 /2 !

se cumplir; es decir, que el error ser a lo sumo z p(1 p)/n.

1 /2 !

Reemplazando X por p tenemos que el error mximo de estimacin es

_

= z X(1 X)/n.

_ _

%

1 /2 !

32

Esta frmula podemos utilizarla para determinar el tamao muestral necesario para alcanzar un

grado deseado de precisin. As, obtenemos

n = p(1 p) ; ( )

z

1 /2 !

%

2

sin embargo, esta frmula no podemos utilizarla en forma directa ya que, a menos que tengamos

informacin acerca del posible valor de p. Si no se dispone de esta informacin se puede utilizar

un criterio de varianza mxima ya que p(1 p) corresponde a la varianza de la poblacion

Bernoulli considerada. As, considerando el hecho que p(1 p) es a lo sumo 1/4, lo cual ocurre

cuando p=1/2, tenemos que con el tamao de muestra mnimo

n =

1

4

z

2

( )

1 /2 !

%

podemos asegurar con una probabilidad de al menos 1 que el error al estimar p por X no

_

!

excede a ; una vez obtenidos los datos, podremos asegurar con una confianza de al menos un %

100(1 )% que el error no sobrepasa . ! %

Ejemplo. Supongamos que deseamos estimar la proporcin real de unidades defectuosas en un

cargamento grande de ladrillos y que se se requiere una confianza del 95% de que el error en la

estimacin sea a lo sumo de 0.04. De qu tamao debe ser la muestra si: a) no se tiene idea acerca

de la proporcin muestral; b) se sabe que la proporcin real no excede a 0.12?.

Si no se tiene idea acerca de cmo podra ser la proporcin muestral entonces usamos la segunda

frmula para el tamao muestral y obtenemos

n = ( ) = 600.25

1 1.96

4 0.04

2

lo que indica que el tamao mnimo debera ser n= 601.

Si sabemos que la proporcin real no excede a 0.12, entonces tomamos p=0.12, y aplicando la

primera frmula para el tamao de muestra obtenemos

n = (0.12)(0.88) 253.55 ( ) =

1.96

0.04

2

o n=254, redondeando al entero ms cercano.

Este ejemplo ilustra la importancia de disponer de alguna informacin auxiliar acerca de la

magnitud posible de p, ya que ello reduce en gran medida el tamao de la muestra requerida.

6.15. Intervalos de Confianza Basados en Dos Muestras

En todo lo visto anteriormente en este captulo de estimacin, hemos considerado una muestra

aleatoria de tamao n de una sola poblacin y hemos estado interesados en hacer inferencias sobre

33

los parmetros, desconocidos, involucrados en su distribucin de probabilidades. En muchos casos

interesa realizar comparaciones de los parmetros de dos o ms poblaciones. As, por ejemplo, si

tenemos dos tipos de autos de precios similares A y B y queremos comparar sus rendimientos

(km/lt), entonces si X es la variable. asociada al rendimiento de los autos tipo A, con X N( , .

"

5 . 5

# #

" #

"

)) e Y es la variable asociada al rendimiento del auto tipo B, con Y N( , ), podramos

estar interesados en estimar , la diferencia entre los rendimientos medios de los dos tipos . .

" #

de autos. Podramos, adems, comparar las varianzas de sus rendimientos a partir del cuociente

5 5

# #

" #

/ .

Consideraremos ahora por lo tanto, problemas que involucren dos muestras aleatorias,

independientes, que provienen de dos poblaciones distintas.

Sea X = (X ,...,X ) una muestra aleatoria de una poblacin X con distribucin de probabilidad

_

" n

"

que depende de un parmetro desconocido y sea Y = (Y ,...,Y ) una muestra aleatoria,

_

)

" " n

#

independiente de la anterior, de una poblacin Y, cuya distribucin de probabilidades depende de

un parmetro desconocido . La independencia de las dos muestras implica que la funcin de )

#

verosimilitud para las n +n , la muestra conjunta, es

" #

L ( , ) = L ( ) L ( )

X Y X Y _ _ _ _ " # " #

) ) ) )

Luego los valores de y que maximicen la funcin de verosimilitud conjunta L ( , ) son ) ) ) )

" # " # X Y _ _

los mismos valores que maximizan a las funciones de verosimilitud L ( ) y L ( ). As, si

X Y _ _

) ) )

" # "

s

maximiza a L ( ) y maximiza a L ( ) entonces L ( , ) es el valor mximo de la

X Y X Y _ _ _ _

) ) ) ) )

" # # " #

s s s

funcin de verosimilitud conjunta. Por lo tanto, los estimadores mximo verosmil para una

funcin g( , ) de los parmetros de las dos distribuciones de probabilidades es g( , ). As, ) ) ) )

" # " #

s s

por ejemplo, el estimador mximo verosmil de es X Y.

_ _

. .

" #

6.16. Intervalos de Confianza para Diferencia de Medias

Consideremos dos muestras aleatorias independientes X e Yde tamaos n y n respectivamente,

_

1

2

provenientes de dos poblaciones normales con medias , y varianzas , , respectivamente, . . 5 5

1 2

# #

" #

donde las varianzas son conocidas. El estadstico natural para estimar la diferencia de medias en

las poblaciones es X Y y, como sabemos, la distribucin de este estadstico es

_ _

X Y N[ , ( /n + /n )]

_ _

. . 5 5

" # " #

# #

" #

y

Z= N(0,1)

X Y ( )

_ _

/n + /n

. .

5 5

1 2

# #

" #

" #

es el pivote que debemos considerar. De aqu, el intervalo de confianza del 100(1- )% para !

. .

" #

est dado por

34

(X Y) + Z ( /n + /n ) .

_ _

_

" # " #

# # " #

" #

!/

/

5 5

Cuando y son desconocidas, pero los tamaos de muestra n y n son suficientemente 5 5

# #

" #

" #

grandes, reemplazamos dichas varianzas por sus correspondientes estimadores S y S . Enseguida

# #

" #

se procede como en el caso en que las varianzas son conocidas.

Ahora bien, cuando y son desconocidas, pero los tamaos de muestra n y n son pequeos, 5 5

# #

" #

" #

la obtencin de la distribucin del pivote no es directa, a menos que las varianza de las dos

poblaciones normales sean iguales. En este caso, si = = , entonces 5 5 5

# # #

" #

Z = N(0, 1)

X Y

_ _

( )

1/n + 1/n

. .

5

" #

" #

Podemos verificar fcilmente que, un estimador mximo verosmil para la varianza comn de 5

#

ambas poblaciones es

= 5s

#

! !

n

1

n

i

2

3" 3"

3

# #

" #

(X X) + (Y Y)

_

n + n

y que

S =

#

:

! !

n n

3"

3 3

# # #

3"

" #

(X X) + (Y Y)

_ _

n + n 2

=

(n 1) S + (n 1) S

n +n 2

" #

# #

" #

" #

es un estimador insesgado de . Adems, 5

#

U = ,

"

#

"

(n 1)S

"

#

"

#

5

;

n )

"

y

U = ,

#

#

"

(n 1)S

#

#

#

#

5

;

n )

#

de donde por Teorema 4.8.

U = U + U = .

" #

#

#

(n 1)S (n 1)S

" #

# #

" #

# #

5 5

+ ;

n +n )

" #

Se puede probar que Z y U son variables aleatorias independientes, por lo que

T = = t

Z

)

X Y

_ _

n n 2 .

U/(n +n 2

( )

S 1/n + 1/n

" #

" #

: " #

. .

" #

35

que el pivote que utilizamos en la construccin del intervalo. Por lo tanto, el intervalo de confianza

del 100(1 )% viene dado por !

(X Y) + t S (1/n +1/n ) .

_ _

_

" # : " #

"#

!/

Ejemplo. Se realiza un estudio para comparar los contenidos de nicotina de dos marcas de

cigarrillo. 10 cigarrillos de la marca A dieron un contenido promedio en nicotina de 3.1 mlgr., con

una desviacin estndar de 0.5 mlgr., mientras que 8 cigarrillos de la marca B dieron un contenido

promedio de nicotina de 2.7 mlgr., con una desviacin estndar de 0.7.

Suponiendo que estos dos conjuntos de datos son muestras aleatorias provenientes de dos

poblaciones normales con varianzas iguales, estamos interesados en construir un intervalo del 95%

para la verdadera diferencia en el contenido medio de nicotina de las dos marcas.

Para = 0.05 encontramos en la tabla correspondiente a la distribucin t-student, con n +n 2 = !

" #

16 gl que t = 2.12. Por otra parte, el valor de S est dado por

!*& :

S = ( = .596,

:

9 0.25 + 7 10.49

/

"'

" #

)

Por lo tanto un intervalo del 95% de confianza es: ( 0.20, 1.00).

Ahora, como la diferencia real podra as ser cero, no podemos concluir en base a este anlisis que

existe una diferencia real en los contenidos de nicotina en las dos marcas.

6.17. Intervalos de confianza para la razn de varianzas de dos

poblaciones Normales

El ejemplo anterior fue resuelto bajo el supuesto que / = 1. Sin este supuesto no habramos 5 5

# #

" #

tenido un procedimiento sencillo para determinar los lmites de confianza de un intervalo para

. .

" #

.

Una forma de chequear la igualdad de varianza es a travs de la construccin de intervalos de

confianza del 100(1 )% para / . Para ello consideremos dos muestras aleatorias ! 5 5

# #

" #

independientes X ,...,X y Y ,...,Y provenientes de dos poblaciones normales con medias y

" " n n ,

" #

varianzas desconocidas.

Sabemos que U = (n 1)S / y U = (n 1)S / son variables aleatorias independientes con

" " # #

# # # #