Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Estadistica

Cargado por

rsgaleanDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Estadistica

Cargado por

rsgaleanCopyright:

Formatos disponibles

Estadstica

2

o

de Ingeniera Informatica

Felix Gomez Marmol

2

Indice general

Introduccion 9

I Probabilidad 11

1. Introduccion a la Teora de la Probabilidad 13

1.1. Introduccion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.2. Primeras Deniciones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.2.1. Operaciones Basicas con Sucesos . . . . . . . . . . . . . . . . . . . . . 14

1.3. Modelos de Probabilidad . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.3.1. Denicion Frecuentista . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.3.2. Denicion Clasica o de Laplace . . . . . . . . . . . . . . . . . . . . . . 15

1.3.3. Denicion Axiomatica . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.4. Probabilidad Condicionada . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

1.4.1. Independencia de Sucesos . . . . . . . . . . . . . . . . . . . . . . . . . 17

1.5. La Formula de la Probabilidad Total y Regla de Bayes . . . . . . . . . . . . . 17

2. Variables Aleatorias Univariantes 19

2.1. Variable Aleatoria y Funcion de Distribucion . . . . . . . . . . . . . . . . . . 19

2.1.1. Funcion de Distribucion de una Variable Aleatoria . . . . . . . . . . . 20

2.1.2. Propiedades de la Funcion de Distribucion . . . . . . . . . . . . . . . . 20

2.2. Clasicacion de las Variables Aleatorias . . . . . . . . . . . . . . . . . . . . . 21

2.2.1. Variables Aleatorias Discretas . . . . . . . . . . . . . . . . . . . . . . . 21

2.2.2. Variables Aleatorias Continuas . . . . . . . . . . . . . . . . . . . . . . 21

2.3. Cambio de Variables . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.4. Descripcion de Variables Aleatorias . . . . . . . . . . . . . . . . . . . . . . . . 24

2.4.1. Esperanza Matematica y Propiedades . . . . . . . . . . . . . . . . . . 24

2.4.2. Momentos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

2.4.3. Desigualdades de Tchebychev . . . . . . . . . . . . . . . . . . . . . . . 28

3. Modelos de Probabilidad Univariantes 31

3.1. Modelo de Bernoulli . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

3.2. Modelo Binomial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

3.3. Modelo Geometrico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

3.4. Modelo Binomial Negativo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

3.5. Modelo Hipergeometrico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

3.6. Modelo de Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

3.7. Modelo Exponencial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

3.8. Modelo Gamma . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

3.9. Modelo de Erlang . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

3.10. Modelo Normal o de Gauss . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

3

4

INDICE GENERAL

3.10.1. Teorema Central del Lmite . . . . . . . . . . . . . . . . . . . . . . . . 37

3.10.2. Casos Particulares . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

3.11. Modelo Uniforme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

3.12. Modelo Beta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

3.12.1. Funcion Beta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

3.13. Modelos que se derivan de la distribucion Normal . . . . . . . . . . . . . . . . 39

3.13.1. Modelo CHI-Cuadrado de Pearson (

2

Pearson) . . . . . . . . . . . 39

3.13.2. Modelo t

n

de Student . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

3.13.3. Modelo T de Fisher o de Snedecor . . . . . . . . . . . . . . . . . . . . 39

4. Variables Aleatorias Multivariantes 41

4.1. Variables Aleatorias Multidimensionales . . . . . . . . . . . . . . . . . . . . . 41

4.1.1. Funci on de Distribucion Conjunta . . . . . . . . . . . . . . . . . . . . 41

4.1.2. Funci on Puntual de Probabilidad Conjunta . . . . . . . . . . . . . . . 42

4.1.3. Funci on de Densidad Conjunta . . . . . . . . . . . . . . . . . . . . . . 42

4.2. Distribuciones Marginales y Condicionadas . . . . . . . . . . . . . . . . . . . 43

4.2.1. Distribuciones Marginales . . . . . . . . . . . . . . . . . . . . . . . . . 43

4.2.2. Distribuciones Condicionadas . . . . . . . . . . . . . . . . . . . . . . . 45

4.2.3. Esperanza Condicionada . . . . . . . . . . . . . . . . . . . . . . . . . . 45

4.3. Independencia de Variables Aleatorias . . . . . . . . . . . . . . . . . . . . . . 46

4.4. Vector de Medias y Matriz de Covarianzas . . . . . . . . . . . . . . . . . . . . 47

4.4.1. Esperanza de una Funcion h(x, y) . . . . . . . . . . . . . . . . . . . . 47

4.4.2. Covarianza de dos v.a. (X, Y ) . . . . . . . . . . . . . . . . . . . . . . . 48

4.4.3. Coeciente de Correlacion . . . . . . . . . . . . . . . . . . . . . . . . . 49

4.4.4. Vector de Medias y Matriz de Covarianzas . . . . . . . . . . . . . . . . 50

4.5. Algunos Modelos Multivariantes . . . . . . . . . . . . . . . . . . . . . . . . . 50

4.5.1. Modelo Multinomial . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

4.5.2. Modelo Hipergeometrico Multivariante . . . . . . . . . . . . . . . . . . 51

4.5.3. Modelo Normal Bidimensional . . . . . . . . . . . . . . . . . . . . . . 51

II Estadstica 53

5. Muestreo e Inferencia Estadstica 55

5.1. Inferencia Estadstica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

5.2. Muestras Aleatorias . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

5.3. Estadsticos y Distribuciones en el Muestreo . . . . . . . . . . . . . . . . . . . 56

5.4. Muestreo en Poblaciones Normales . . . . . . . . . . . . . . . . . . . . . . . . 57

6. Estimacion Puntual 59

6.1. Inferencia Parametrica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

6.1.1. Error Cuadratico Medio . . . . . . . . . . . . . . . . . . . . . . . . . . 59

6.1.2. Insesgadez . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

6.1.3. Eciencia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

6.1.4. Consistencia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

6.2. Metodos de Estimacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

6.2.1. Metodo de la Maxima Verosimilitud . . . . . . . . . . . . . . . . . . . 64

6.2.2. Metodo de los Momentos . . . . . . . . . . . . . . . . . . . . . . . . . 66

INDICE GENERAL 5

7. Intervalos de Conanza y Test de Hipotesis 69

7.1. Intervalos de Conanza . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

7.1.1. Metodo de Construccion . . . . . . . . . . . . . . . . . . . . . . . . . . 69

7.2. Test o Contraste de Hipotesis . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

8. Relacion entre Variables 77

8.1. Introduccion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

8.2. ANOVA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

8.2.1. Tabla ANOVA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 78

8.3. Analisis de Regresion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 79

Apendice A. Tabla de Modelos. 85

Apendice B. Tablas de ANOVA. 87

Apendice C. Tablas: Normal 0/1, t de Student y T de Snedecor. 89

Apendice D. Tablas de Intervalos de Conanza y Tests de Hipotesis. 95

6

INDICE GENERAL

Indice de guras

1.1. Denicion frecuentista de probabilidad . . . . . . . . . . . . . . . . . . . . . . 15

1.2. Particion del espacio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

2.1. Distribucion asimetrica, caso 1 . . . . . . . . . . . . . . . . . . . . . . . . . . 29

2.2. Distribucion asimetrica, caso 2 . . . . . . . . . . . . . . . . . . . . . . . . . . 29

2.3. Distribucion simetrica . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

4.1. Ejemplo de la propiedad 4.3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

4.2. Ejemplo 4.5 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

4.3. Ejemplo 4.11 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

4.4. f(x, y) =

1

2

e

1

2

(x

2

+y

2

)

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

7.1. Tests de hipotesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 74

7.2. Test de hipotesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 74

8.1. Recta de Regresion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 79

8.2. Procedimiento de los mnimos cuadrados . . . . . . . . . . . . . . . . . . . . . 81

8.3. Variables relacionadas (izqda) y no relacionadas(dcha) . . . . . . . . . . . . . 82

8.4. T de Snedecor . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83

8.5. e

i

vs f(x

i

) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83

7

8

INDICE DE FIGURAS

Introduccion

Quisiera agradecer a las siguientes personas por la realizacion de estos apuntes. Sin su

ayuda, apoyo y colaboracion, este proyecto, muy probablemente nunca habra llegado a n:

A Miguela Iniesta Moreno, profesora de Estadstica de la Facultad de Informatica de

Murcia. Pues estos apuntes no dejan de ser la transcripcion digital de los apuntes

tomados en clase, a partir de sus explicaciones. Tambien agradecerle la revision de los

mismos y la inclusion de estos en la pagina web de la asignatura:

http://colossrv.fcu.um.es/estadistica

A Isabel Navarrete Sanchez, profesora del Departamento de Ingeniera de la Informacion

y las Comunicaciones de la Universidad de Murcia, por los conocimientos que sobre

L

A

T

E

X2

me ha transmitido, as como por el material prestado.

A mis padres, por su inestimable apoyo y cari no en todo momento.

A todos mis compa neros, familiares y amigos, por estar siempre ah cuando los necesito.

Tambien quisiera dedicar unas palabras a aquellos alumnos que empleen estos apuntes

como apoyo didactico para prepararse la asignatura de Estadstica:

Solo espero que estos apuntes os sean utiles del mismo modo que lo fueron para m. Si

descubrs alg un error, por favor comunicadselo a la profesora.

Los apuntes originales (los escritos a mano por m) incluan mas imagenes de las que inclu-

yen estos. Mi consejo es, por lo tanto, que hagais todas las anotaciones, gracos, correcciones,

etc. que estimeis oportunos sobre estos apuntes.

Suerte a todos!!

Felix Gomez Marmol

Murcia, a 4 de Octubre de 2003

9

10 Introduccion

Parte I

Probabilidad

11

Captulo 1

Introduccion a la Teora de la

Probabilidad

1.1. Introduccion

En este tema se desarrollaran los conceptos fundamentales de la Teora de la Probabili-

dad: experimento aleatorio, espacio muestral, suceso, modelos de probabilidad, probabilidad

condicionada y regla de Bayes.

El estudio de la Probabilidad en la asignatura de Estadstica se debe a que esta ultima

se basa y se fundamenta en la primera. Mediante la Estadstica se pretende conocer el com-

portamiento de toda una poblacion a partir de una muestra. Es por eso que dicha muestra

debe ser representativa de toda la poblacion para poder extrapolar los resultados obtenidos;

y para ello hacemos uso de los mecanismos de muestreo.

1.2. Primeras Deniciones

Denicion 1.1 Experimento Aleatorio: Es aquel experimento que repetido sucesivamen-

te en condiciones identicas produce resultados distintos e impredecibles. Por ejemplo, tirar

un dado al aire.

Denicion 1.2 Experimento Determinista: Es aquel experimento que repetido sucesi-

vamente en condiciones identicas siempre produce los mismos resultados. Un fenomeno o

experimento determinista pasa a ser aleatorio cuando se introduce un error asociado (en los

instrumentos de medida, por ejemplo).

Denicion 1.3 Punto Muestral o Suceso Elemental: Es cada uno de los resultados

posibles de un experimento aleatorio. Ejemplo: sacar cara al tirar una moneda al aire.

Denicion 1.4 Espacio Muestral (): Es el conjunto de todos los puntos muestrales.

Ejemplo 1.1 El espacio muestral del suceso tirar un dado al airees

= 1, 2, 3, 4, 5, 6

Denicion 1.5 Suceso

1

: Se llama suceso a cualquier subconjunto del espacio muestral .

A

1

La Teora de Sucesos es paralela a la Teora de Conjuntos

13

14 Captulo 1. Introduccion a la Teora de la Probabilidad

Ejemplo 1.2 1. A = obtener cara par = 2, 4, 6 = 2, 4, 6

2. A = Suceso imposible (no se da nunca).

3. A = Suceso seguro.

Denicion 1.6 Suceso Complementario: Denotaremos por

A o bien A

C

al suceso com-

plementario de A, que se dene como:

A

C

= A

1.2.1. Operaciones Basicas con Sucesos

Propiedad 1.1 Union de Sucesos

A ; B ; A B = e

i

/ e

i

A o e

i

B

A B contiene todos los puntos muestrales que estan en A o en B.

Propiedad 1.2 Interseccion de Sucesos

A ; B ; A B = e

i

/ e

i

A y e

i

B

A B contiene todos los puntos muestrales que estan en A y en B simultaneamente.

Propiedad 1.3 Diferencia de Sucesos

A ; B ; AB = e

i

/ e

i

A y e

i

/ B = e

i

/ e

i

A y e

i

B

C

AB contiene todos los puntos muestrales de A que no estan en B.

Todas estas operaciones cumplen las mismas propiedades de asociatividad, distributividad

y conmutatividad que se cumplen en la Teora de Conjuntos.

Dos consecuencias importantes de estas operaciones son:

A A

C

=

A A

C

=

Denicion 1.7 Sucesos Incompatibles: Se dice que dos sucesos A y B son incompatibles

si y solo si A B =

Denicion 1.8 Espacio Probabilizable: Llamamos espacio probabilizable a la pareja (, /).

Denicion 1.9

Algebra de Sucesos (/): Es la familia de sucesos a la que nos interesa

asignarle probabilidad. Este conjunto / cumple:

1. , /

2. A / A

C

/

3. A, B / A B /, A B /

Ejemplo 1.3

/ = , , A, A

C

1.3 Modelos de Probabilidad 15

1.3. Modelos de Probabilidad

1.3.1. Denicion Frecuentista

Denicion 1.10 Dadas n repeticiones de un experimento aleatorio y suponiendo que n

A

es

el n umero de veces que ha resultado el suceso A, se dene la frecuencia de dicho suceso como:

fr(A) =

n

A

n

0 fr(A) 1

Cuando n es peque no fr(A) uct ua mucho mas que cuando n es grande. En este segundo

caso fr(A) se estabiliza en un valor al que se llamo probabilidad de A.

Figura 1.1: Denicion frecuentista de probabilidad

Pero ese lmite no es analtico puesto que no se cumple que

> 0 n

0

/ n > n

0

[fr(A) T(A)[ < .

Se trata mas bien de un hecho contrastable empricamente.

1.3.2. Denicion Clasica o de Laplace

Denicion 1.11 Suponiendo que es nito y que cada punto muestral tiene la misma

probabilidad (equiprobabilidad), podemos denir la probabilidad del suceso A como:

T(A) =

[A[

[[

Ejemplo 1.4 A = obtener cara par = 2, 4, 6 T(A) =

3

6

=

1

2

1.3.3. Denicion Axiomatica (1933)

Denicion 1.12 Dado el espacio probabilizable (, /), diremos que T es una probabilidad

sobre dicho espacio si cumple:

1. T() = 1

2. Si A y B son incompatibles (A B = ) entonces T(A B) = T(A) +T(B)

3. 0 T(A) 1

Por lo tanto podemos denir igualmente la probabilidad mediante la funcion T, denida

como:

T : (, /) [0, 1]

A / T(A)

cumpliendo las condiciones 1 y 2 anteriores.

Esta ultima denicion nos permite comprobar las siguientes propiedades:

16 Captulo 1. Introduccion a la Teora de la Probabilidad

Propiedad 1.4 T(

A) = 1 T(A); T() = 1 T() = 1 1 = 0

= A

A

T() = T(A

A)

1 = T(A) +T(

A)

Propiedad 1.5 T(A B) = T(A) +T(B) T(A B)

T(A B) = T((AB) (A B) (B A)) =

T(AB) +T(A B) +T(B A) = T(A) +T(B A) =

T(A) +T(B A) +T(A B) T(A B) = T(A) +T(B) T(A B)

Propiedad 1.6 T(ABC) = T(A) +T(B) +T(C) T(AB) T(AC) T(BC) +

T(A B C)

Propiedad 1.7 Si A B, entonces T(A) T(B)

B = A (B A)

T(B) = T((A) (B A))

T(B) = T(A) +T(B A) T(A)

Como consecuencia inmediata de esta ultima propiedad se tiene que:

Si A B T(B A) = T(B) T(A)

1.4. Probabilidad Condicionada

En ocasiones puede ocurrir que ciertas informaciones condicionen la probabilidad de

ocurrencia de ciertos sucesos. Por ejemplo, tirar un dado al aire sabiendo de antemano que

algunas de sus caras estan cargadas.

Es por eso que vamos a denir la probabilidad condicionada T(A[

B

), donde B es una

restriccion, una informacion acerca del suceso A.

Denicion 1.13 Sea la funcion de probabilidad T : / [0, 1], el espacio de probabilidad

(, /, T), y sea T(B) > 0. Denimos entonces la probabilidad del suceso A dado B como:

T([

B

) = T

B

: / [0, 1]

A T(A[

B

)

donde

T(A[

B

) =

T(A B)

T(B)

Nota.- Puede demostrarse que P

B

es una funcion de probabilidad. Por tanto:

1. T

B

() = 1

2. T

B

(

A) = 1 T

B

(A)

3. T(A

1

A

2

) = T

B

(A

1

) +T

B

(A

2

) si A

1

A

2

=

Consecuentemente:

T(AB) = T(A[

B

) T(B) = T(BA) = T(B[

A

) T(A), siempre que T(A) > 0 y ambos

condicionamientos sean razonables.

Ejemplo 1.5 La probabilidad de extraer dos ases en dos cartas sin reemplazamiento es:

A

1

: la 1

a

carta es un as

A

2

: la 2

a

carta es un as

T(A

1

A

2

) = T(A

2

[

A

1

) T(A

1

) =

3

39

4

40

1.5 La Formula de la Probabilidad Total y Regla de Bayes 17

1.4.1. Independencia de Sucesos

Denicion 1.14 Decimos que el suceso A es independiente del suceso B si T(A[

B

) = T(A)

T(A[

B

) =

T(A B)

T(B)

T(A B) = T(A[

B

) T(B)

Por lo que si A es independiente de B se tiene que T(A B) = T(A) T(B)

Proposicion 1.1 Si A es independiente de B, entonces B es independiente de A.

T(B[

A

) =

T(B A)

T(A)

=

T(A[

B

) T(B)

T(A)

=

T(A) T(B)

T(A)

= T(B)

Proposicion 1.2 Dos sucesos A, B son independientes si y solo si T(AB) = T(A) T(B)

En el caso de tres sucesos A, B y C, la probabilidad de la interseccion se calcula como:

T(A B C) = T(A (B C)) = T(A[

BC

) T(B C) = T(A[

BC

) T(B[

C

) T(C)

1.5. La Formula de la Probabilidad Total y Regla de Bayes

En muchas ocasiones la forma mas sencilla de calcular la probabilidad de un suceso es

considerar las probabilidad de este bajo un conjunto de condiciones mutuamente excluyentes.

Denimos el conjunto de sucesos E

1

, E

2

, . . . , E

n

mutuamente excluyentes cumpliendo que

n

j=1

E

j

= y ademas E

i

E

j

= si i ,= j.

Figura 1.2: Particion del espacio

Como consecuencia T() = T

_

n

j=1

E

j

_

=

n

j=1

T(E

j

) = 1

Las probabilidades T(A[

E

j

) son conocidas, as como las probabilidades T(E

j

), por lo

tanto estamos en disposicion de denir la probabilidad de A, T(A), como:

Proposicion 1.3 En las condiciones anteriores se tiene que:

T(A) =

n

i=1

T(A[

E

i

) T(E

i

)

(Expresion conocida como Formula de la Probabilidad Total).

Dem.- T(A) = T((AE

1

) (AE

2

) . . . (AE

n

)) = T(AE

1

) +T(AE

2

) +. . . +

T(AE

n

) = T(A[

E

1

)T(E

1

)+T(A[

E

2

)T(E

2

)+. . .+T(A[

E

n

)T(E

n

) =

n

i=1

T(A[

E

i

)T(E

i

)

18 Captulo 1. Introduccion a la Teora de la Probabilidad

Ejemplo 1.6 C: Sacar cara

T: La moneda esta trucada

T(C[

T

) = 1; T(C[

T

) = 0

5

Suponiendo que hay dos monedas, una trucada y otra sin trucar, se tiene que:

T(T) = 0

5

T(

T) = 0

5

Por lo tanto, la probabilidad de que salga cara al tirar una de las dos monedas es:

T(C) = T(C[

T

) T(T) +T(C[

T

) T(

T) = 1 0

5 + 0

5 0

5 = 0

75

A las probabilidades T(E

i

) se les conoce con el nombre de probabilidades iniciales o a

priori , puesto que se produce una asignacion de probabilidad de forma objetiva.

Dado un j concreto se pretende calcular T(E

j

[

A

) para actualizar las probabilidades de

los sucesos de la particion.

Llamaremos a estos probabilidades nales o a posteriori

Teorema 1.1 de Bayes En las condiciones anteriores se tiene que:

T(E

j

[

A

) =

T(A[

E

j

) T(E

j

)

n

i=1

T(A[

E

i

) T(E

i

)

Dem.-

T(E

j

[

A

) =

T(A[

E

j

) T(E

j

)

T(A)

=

Ejemplo 1.7 Una persona que realiza un examen tipo test ha estudiado el 80 % de la materia

de tal forma que podemos jar en 08 la probabilidad de saber la respuesta a una pregunta

cualquiera. Si no sabe la respuesta elige una de las cinco posibles alternativas al azar y nos

gustara asignar probabilidad al suceso A: acertar la respuesta, as como la probabilidad de

saber la respuesta, suponiendo que la ha acertado.

S: Saber la respuesta

A: Acertar la respuesta

T(S) = 0

8; T(A)?

T(A) = T(A[

S

) T(S) +T(A[

S

) T(

S) = 1 0

8 +

1

5

0

2 = 0

84

T(S[

A

) =

T(A[

S

) T(S)

T(A)

=

1 0

8

0

84

0

95

Captulo 2

Variables Aleatorias Univariantes

2.1. Variable Aleatoria y Funcion de Distribucion

Emplearemos el concepto de variable aleatoria, X, para facilitar la labor de asignacion de

probabilidad a un experimento aleatorio del cual nos interesa una caracterstica numerica.

Lo que se hace entonces es transformar un espacio de probabilidad general en un espacio

de probabilidad denido en toda la recta real.

Denicion 2.1 La variable aleatoria X se dene como:

X : (, /, T) (R, B, T

X

)

donde B = T(R), es decir, el conjunto de todos los intervalos de R.

Por lo tanto B B (esto es, para todo intervalo B de R), T

X

(B) T(X

1

(B))

(probabilidad de que X este contenido en el intervalo B), teniendose que cumplir que B B,

X

1

(B) /.

Ejemplo 2.1 X:N umero de caras al tirar una moneda 2 veces

= (C, C), (C, Cr), (Cr, C), (Cr, Cr) = e

1

, e

2

, e

3

, e

4

(Son las 4 posibilidades que hay)

T(e

i

) =

1

4

e

i

A

T(e

i

) = T(A)

X() = 0, 1, 2 (Pueden aparecer 0, 1 o 2 caras)

X : (, /, T) (R, B, T

X

)

e

1

X(e

1

) = 2

e

2

X(e

2

) = 1

e

3

X(e

3

) = 1

e

4

X(e

4

) = 0

Algunos ejemplos de calculo de probabilidades pueden ser:

T

X

((2, 3)) = T(X

1

(2, 3)) = T() = 0

T

X

([2, 3)) = T(e

1

) =

1

4

T

X

([2, +)) = T(e

1

) =

1

4

T

X

((, 1]) = T(e

2

, e

3

, e

4

) =

3

4

19

20 Captulo 2. Variables Aleatorias Univariantes

2.1.1. Funcion de Distribucion de una Variable Aleatoria

Denicion 2.2 La funcion de distribucion de una variable aleatoria, X, es una funcion

denida en la recta real con valores en [0, 1].

F : R [0, 1]

x F(x) = T

X

((, x]) = T(X

1

(, x]) = T(w [ X(w) x) = T(X x)

Ejemplo 2.2 X:N umero de caras al tirar una moneda 2 veces

F(x)

_

_

0 x < 0

1

4

0 x < 1

3

4

1 x < 2

1 x 2

En la siguiente gura, los puntos se nalados con un rombo () representan puntos de

discontinuidad:

2.1.2. Propiedades de la Funcion de Distribucion

Propiedad 2.1 F es no decreciente: x

1

< x

2

F(x

1

) F(x

2

)

F(x

2

) = T

X

((, x

2

]) = T

X

((, x

1

] (x

1

, x

2

]) = T

X

((, x

1

]) + T

X

((x

1

, x

2

]) =

F(x

1

) +T

X

((x

1

, x

2

]) F(x

1

)

Propiedad 2.2 F es siempre continua a la derecha. Esto es, lm

h0

+

F(x +h) = F(x)

F(x+h) = T

X

((, x+h]) = T

X

((, x](x, x+h]) = T

X

((, x])+T

X

((x, x+h]) =

F(x) +T

X

(x < X x +h)

lm

h0

+

F(x +h) = F(x) +T

X

() = F(x)

Sin embargo, F puede no ser continua a la izquierda en alg un punto

F(x) = T

X

((, x]) = T

X

((, xh])(xh, x]) = T

X

((, xh])+T

X

((xh, x]) =

F(x h) +T

X

(x h < X x)

lm

h0

F(x +h) = lm

h0

+

F(x h) = lm

h0

+

F(x) T

X

((x h, x]) = F(x) T

X

(X = x)

Cuando T(X = x) = 0 la funcion sera continua a la izquierda. Pero si x es un punto

muestral, con T(X = x) > 0, en este caso existe una discontinuidad a la izquierda.

Propiedad 2.3 T(a < X b) = F(b) F(a)

F(b) = T

X

((, b]) = T

X

((, a] (a, b]) = T

X

((, a]) +T

X

((a, b]) = F(a) +T(a <

X b)

Propiedad 2.4 lm

x+

F(x) = 1 lm

x

F(x) = 0

F(x) = T

X

((, x]) =

x+

T

X

(R) = 1

x

T

X

() = 0

2.2 Clasicacion de las Variables Aleatorias 21

2.2. Clasicacion de las Variables Aleatorias

Esta clasicacion tendra como referente a la funcion de distribucion de las v.a.

2.2.1. Variables Aleatorias Discretas

Denicion 2.3 Llamamos variables aleatorias discretas a aquellas en las que el espacio

muestral de la variable X, X(), es un conjunto discreto, es decir, nito o, a lo sumo, innito

numerable. Por lo tanto su funcion de distribucion es escalonada.

Denicion 2.4 Se dene la funcion puntual de probabilidad de la v.a. X, como

p(x) = T(X = x), x R

Ademas, esta funcion cumple que

xS

p(x) = 1

(siendo S el conjunto de los puntos muestrales.

1

) y p(x) = 0 si x / S

Ejemplo 2.3 X:N umero de caras al tirar 2 monedas

p(0) = p(2) =

1

4

p(1) =

1

2

y x / 0, 1, 2 p(x) = 0

Ejemplo 2.4 X:N umero de lanzamientos hasta conseguir una cara

X 1, 2, . . . = N

p(x)

_

T(X = x) =

1

2

x

x N

T(X = x) = 0 x / N

xN

p(x) =

+

x=1

1

2

x

=

1

2

1

1

2

= 1

F(x)

_

0 x < 1

nN

1

2

n

[x] < x < [x + 1]

2

2.2.2. Variables Aleatorias Continuas

Denicion 2.5 Llamamos variables aleatorias continuas a aquellas en las que el espacio

muestral de la variable X, X(), es un conjunto continuo, es decir, un intervalo de la recta

real (X() = (a, b) R). Su funcion de distribucion F(x) es, en consecuencia, continua en

todo R.

En este caso se cumple que x X() R, T(X = x) = 0. Intuitivamente podemos

pensar que es muy difcil que, en situaciones de la vida real, la variable X llegue a valer

exactamente el punto muestral x.

Nota.- Los sucesos cuya probabilidad es cero, conteniendo alg un punto muestral

se llaman sucesos casiimposibles.

Por otro lado, el suceso A ,= para el cual T(A) = 1 se llama suceso casi seguro.

1

A partir de ahora lo denotaremos por x X o x X()

2

En este ejemplo [x] representa la parte entera de x

22 Captulo 2. Variables Aleatorias Univariantes

Ejemplo 2.5 X:Longitud de una varilla elegida al azar

X() = X (l , l +)

Construimos la funcion de distribucion:

F(x)

_

_

0 x l

x (l )

2

x (l , l +)

1 x l +

Esta funcion es continua en todo R

Resumen.-

Si X es discreta funcion puntual de probabilidad o funcion de masa.

p : R [0, 1]

x p(x) = T(X = x)

F(x) =

yx

p(y) T(X A) =

xA

p(x)

Si X es continua funcion de densidad.

f : R R

+

x f(x) =

dF(x)

dx

Las ordenadas de esta funcion f (que siempre cumple que f(x) 0) no indica probabilidad;

es el area encerrada por ella quien lo hace. De esta manera se tiene que:

F(x) =

_

x

f(t)dt

Una propiedad importante utilizada para comprobar si la funcion f es una funcion de

densidad o no es la siguiente.

Propiedad 2.5

lm

x+

F(x) = 1

_

+

f(x)dx = 1

Ademas tambien se cumple que:

Propiedad 2.6

T(X (a, b]) = T(X [a, b)) = T(X [a, b]) = T(X (a, b)) = F(b) F(a) =

_

b

a

f(x)dx

2.3 Cambio de Variables 23

Ejemplo 2.6 X:Longitud de una varilla tomada al azar

F(x)

_

_

0 x l

x l +

2

x (l , l +)

1 x l +

f(x)

_

_

_

dF(x)

dx

=

1

2

x (l , l +)

0 x / (l , l +)

T

_

X

_

l, l +

2

__

=

_

l+

2

l

f(x)dx =

2

1

2

=

1

4

= F

_

l +

2

_

F(l)

Ejemplo 2.7 .

F(x)

_

0 x 0

1 e

2x

x > 0

f(x)

_

0 x 0

2e

2x

x > 0

T

_

X >

1

2

_

= 1 F

_

1

2

_

= 1

_

+

1

2

2e

2x

dx = 1

_ 1

2

0

2e

2x

dx = 1 2

_

2e

2x

1

2

0

T

_

X

_

1

2

,

3

2

__

= F

_

3

2

_

F

_

1

2

_

=

_ 3

2

1

2

2e

2x

dx

2.3. Cambio de Variables

Suponemos conocida la funcion F

X

(x) = T(X x). Queremos conocer la funcion de

distribucion de una cierta transformacion Z = h(X)

3

.

Proposicion 2.1 Para una X discreta, sea T(X = x) su funcion puntual de probabilidad.

Entonces se tiene que:

g(z) = T(Z = z) = T(Z(X) = z) = T(X Z

1

(z)) =

xZ

1

(z)

T(X = x)

Ejemplo 2.8 X:N umero de caras al tirar una moneda 2 veces

X 0, 1, 2 T(X = 0) = T(X = 2) =

1

4

T(X = 1) =

1

2

T(X = x) = 0, x / 0, 1, 2

Por ejemplo, sea la transformacion Z = X(X 1).

x X z Z = X(X 1)

0 0 (= 0(0 1))

1 0 (= 1(1 1))

2 2 (= 2(2 1))

z 0, 2

g(0) = T(Z = 0) = T(X = 0) +T(X = 1) =

3

4

g(2) = T(Z = 2) = T(X = 2) =

1

4

3

Por ejemplo: Z = X

2

, Z = X(X 1), Z =

1

2

X

3

, . . .

24 Captulo 2. Variables Aleatorias Univariantes

Ejemplo 2.9

x 2 1 0 1 2

p(x)

1

5

1

5

1

5

1

5

1

5

Z = X

2

0, 1, 4

g(0) = T(Z = 0) =

1

5

g(1) = T(X = 1) +T(X = 1) =

1

5

+

1

5

=

2

5

g(4) = T(X = 2) +T(X = 2) =

1

5

+

1

5

=

2

5

Proposicion 2.2 Para una X continua, se tiene que:

G(z) = T(Z z) = T(Z(X) z) = T(X I(z))

donde I(z) es cierto intervalo que debemos obtener.

Ejemplo 2.10 Sea Z(X) = X

2

, y sea la funcion F(x) denida como:

F(x)

_

_

0 x 1

x

3

+ 1

2

x [1, 1]

1 x 1

As, el espacio muestral de la variable Z es:

(1, 1)

Z(X)=X

2

(0, 1)

G(z) = T(Z z) = T(X

2

z) = T(X (

z,

z)) =

= F(

z) F(

z) =

(

z)

3

+x

2

(

z)

3

+x

2

= (

z)

3

= z

3

2

G(z)

_

_

_

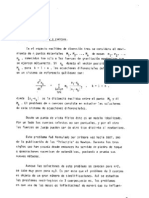

0 z 0

z

3

2

z (0, 1)

1 z 1

Ejemplo 2.11 Sea Z(X) = X

2

y sea la funcion F(x) denida como:

F(x)

_

_

_

0 x 0

x

4

x (0, 1)

1 x 1

(0, 1)

Z(X)=X

2

(0, 1)

G(z) = T(Z z) = T(X

2

z) = T(X (0,

z)) =

= F(

z) F(0) = (

z)

4

= z

2

G(z)

_

_

_

0 z 0

z

2

z (0, 1)

1 z 1

2.4. Descripcion de Variables Aleatorias

La centralizacion indica los valores promedio de una v.a. y seran proximas a valores de

probabilidad alta.

La dispersion indica la desviacion de los valores de la v.a. respecto de los valores promedio.

2.4.1. Esperanza Matematica y Propiedades

Denicion 2.6 Al parametro de centralizacion mas importante de una v.a. X se le llama

esperanza matematica o valor medio teorico

4

de dicha variable. Se denota por E(X) y

se dene como:

E(X) =

xX

x p(x) =

xX

xT(X = x) (para X discretas)

E(X) =

_

+

x f(x)dx (para X continuas)

4

Tambien nos referiremos a la esperanza matematica como la media

2.4 Descripcion de Variables Aleatorias 25

Ejemplo 2.12 X:N umero de caras al tirar 2 veces una moneda

E(X) = 0 p(0) + 1 p(1) + 2 p(2) = 0

1

4

+ 1

1

2

+ 2

1

4

= 1

La media muestral, es decir, la media aritmetica tiende al valor de la esperanza matematica

cuando el n umero de experimentos es elevado.

Propiedades de la Esperanza Matematica

Propiedad 2.7 E(C) = C

5

ya que p(C) = 1 p(x) = 0, x ,= C

Propiedad 2.8 E(X +Y ) = E(X) +E(Y )

Propiedad 2.9 E(aX +bY ) = aE(X) +bE(Y )

Propiedad 2.10 E(X Y ) = E(X) E(Y ) si X e Y son independientes.

Propiedad 2.11 Si Z(X) = Z

E(Z) =

zZ

z g(z) =

xX

z(x)p(x)

E(Z) =

_

+

z g(z)dz =

_

+

z(x) f(x)dx

2.4.2. Momentos

Denicion 2.7 Llamaremos momento ordinario de orden r al valor medio de X

r

, r N.

Lo denotaremos por

r

= E(X

r

) y se dene como:

r

=

xX

x

r

p(x) (v.a. discretas)

r

=

_

+

x

r

f(x)dx (v.a. continuas)

Varianza de una Variable Aleatoria X

Denicion 2.8 Si X es una v.a. con = E(X), denimos el momento central de orden r

como E[(X )

r

] = E[(X E(X))

r

], r N.

En concreto, se dene la varianza de X, que se denota por V (X), como:

V (X) = E[(X E(X))

2

]

Las expresiones que nos permitiran calcular la varianza de una v.a. X son:

V (X) =

xX

(x E(X))

2

p(x) para X discretas

V (X) =

_

+

(x E(X))

2

f(x)dx para X continuas

Pero estas dos expresiones pueden resultar algo complicadas de resolver, por lo que cal-

cularemos otra expresion alternativa:

5

Siendo C una constante

26 Captulo 2. Variables Aleatorias Univariantes

V (X) = E

_

(X E(X))

2

_

= E

_

X

2

2E(X)X +E(X)

2

_

= E(X

2

)2E(X)

2

+E(X)

2

= E(X

2

)E(X)

2

En resumen:

V (X) = E(X

2

) E(X)

2

Como ya sabemos E(X

2

) se puede calcular de la siguiente manera:

2

= E(X

2

) =

xX

x

2

p(x) si X es discreta

2

= E(X

2

) =

_

+

x

2

f(x)dx si X es continua

Ejemplo 2.13 X:N umero de lanzamientos hasta conseguir una cara

X = x 1, 2, 3, . . . p(x) =

1

2

x

, x N

xN

1

2

x

= 1

Veamos el calculo de E(X) (n umero medio de lanzamientos para cara).

E(X) =

+

x=1

x

2

x

= 2 E(X

2

) =

+

x=1

x

2

2

x

Ejemplo 2.14 Sea X una v.a. con f(x) = e

x

, x > 0.

E(X) =

_

+

0

x e

x

dx E(X

2

) =

_

+

0

x

2

e

x

dx

Funcion Generatriz de Momentos

Denicion 2.9 Esta funcion que nos facilita el calculo de los momentos ordinarios, se dene

como sigue: m(t) = E(e

tX

), t R, es decir,

m(t) =

xX

e

tx

p(x) para X discretas

m(t) =

_

+

e

tx

f(x)dx para X continuas

En particular, solo nos interesara que exista en un entorno de t = 0, es decir, t (, );

pudiendo no estar denida fuera de dicho intervalo.

dm(t)

dt

_

t=0

= E(Xe

tX

)

_

t=0

= E(X)

m

(0) = E(X

2

e

tX

)

_

t=0

= E(X

2

)

.

.

.

m

r

(0) = E(X

r

) =

r

Ejemplo 2.15 X:N umero de lanzamientos hasta conseguir cara

m(t) =

+

x=1

e

tx

1

2

x

=

+

x=1

_

e

t

2

_

x

=

e

t

2

1

e

t

2

=

e

t

2 e

t

; t < ln2

e

t

2

< 1 e

t

< 2 t < ln2 =ln2 = > 0

Por lo tanto, m(t) estara bien denida cuando t < ln2

2.4 Descripcion de Variables Aleatorias 27

m

(t) =

e

t

(2 e

t

) +e

2t

(2 e

t

)

2

=

e

t

2 e

t

+

e

2t

(2 e

t

)

2

m

(0) =

1 + 1

1

= 2 = E(X)

m

(t) = m

(t) + 2m(t) m

(t)

m

(0) = 2 + 2m(0) 2 = 2 + 2 1 2 = 6 = E(X

2

)

De esta manera podemos calcular la varianza como:

V (X) = m

(0) (m

(0))

2

= E(X

2

) E(X)

2

= 6 2

2

= 2

Ejemplo 2.16 Sea X una v.a. con f(x) = e

x

, x > 0.

m(t) = E

_

e

tX

_

=

_

+

0

e

tx

e

x

dx =

_

+

0

e

x(t1)

dx =

1

t 1

_

e

x(t1)

_

x=+

x=0

=

1

t 1

[01] =

1

1 t

Veamos en que puntos esta denida t.

lm

x+

e

x(t1)

= 0 cuando t < 1

m

(t) =

1

(1 t)

2

m

(0) = 1 =

_

+

xe

x

dx = E(X)

m

(t) =

2

(1 t)

3

m

(0) = 2 =

_

+

x

2

e

x

dx = E(X

2

)

V (X) = E(X

2

) E(X)

2

= 2 1

2

= 1

Desviacion Tpica de una v.a. X

Denicion 2.10 Otro parametro de dispersion de una v.a. X, relacionado con la varianza,

es la desviacion tpica.

Esta se dene como:

D(X) =

_

V (X) =

La ventaja que presenta la desviacion tpica frente a la varianza es que, mientras esta

ultima se expresa en unidades

2

, la primera se expresa en la misma unidad en que se expresa

X.

Propiedades de la Varianza

Propiedad 2.12 V (X) > 0; V (X) = 0 E(X) = X (es decir, si X = cte

6

)

Propiedad 2.13 V (aX +b) = a

2

V (X), a, b = ctes

Propiedad 2.14 V (X +Y ) = V (X) +V (Y ) si X e Y son independientes

7

Propiedad 2.15 Supongamos Y = a

0

+ a

1

X

1

+ . . . + a

n

X

n

siendo X

1

, X

2

, . . . , X

n

v.a.

independientes y a

0

, a

1

, . . . , a

n

constantes. Entonces se cumple que:

V (Y ) = a

2

1

V (X

1

) +a

2

2

V (X

2

) +. . . +a

2

n

V (X

n

)

6

A las v.a. que son constantes se les conoce con el nombre de variables degeneradas

7

Por ejemplo, V (X Y ) = V (X) +V (Y ) = V (X) + (1)

2

V (Y ) = V (X) +V (Y )

28 Captulo 2. Variables Aleatorias Univariantes

2.4.3. Desigualdades de Tchebychev

Denicion 2.11 Sea X una v.a. con = E(X) y = D(X) nitos. Entonces:

T([X E(X)[ KD(X)) 1

1

k

2

T([X E(X)[ > K D(X)) <

1

k

2

T(E(X) K D(X) X E(X) +K D(X)) 1

1

k

2

Ejemplo 2.17 X:N umero de lanzamientos hasta conseguir cara

E(X) = 2 D(X) =

2 K = 2

T(1

8

X 2 + 2

2) 1

1

2

2

= 0

75 Probabilidad acumulada entre 1 y 2 + 2

2

Ejemplo 2.18 X:Altura

Suponemos E(X) = 175 cm y D(X) = 5 cm. (K = 2)

T(X (175 2 5, 175 + 2 5)) 0

75

T(X (165, 185)) 0

75

Moda de una v.a. X

Denicion 2.12 Una moda de la distribucion de X sera un punto muestral, m

o

(X), para

el cual la funcion puntual de probabilidad (en el caso discreto) o la funcion de densidad (en

el caso continuo) se hace maxima. Es decir:

p(m

o

) es maximo.

f(m

o

) es maximo.

Una funcion se dice unimodal cuando solo tiene una moda.

Mediana de una v.a. X

Denicion 2.13 La mediana de una v.a. X, m

e

(X), o simplemente m

e

, es un punto mues-

tral que cumple que:

En el caso de X discreta:

T(X m

e

)

1

2

y T(X m

e

)

1

2

Para v.a. discretas pueden existir varias medianas.

En el caso de X continua:

F(m

e

) =

1

2

T(X m

e

) =

1

2

Ejemplo 2.19 X:N umero de lanzamientos hasta conseguir cara

T(X 1) =

1

2

T(X 1) = 1

_

X = 1 es mediana

T(X 2) =

1

2

+

1

4

=

3

4

T(X 2) =

1

2

_

_

X = 2 es mediana

Y no existen mas medianas.

8

Ponemos 1 en vez de 2 2

2 porque no interesa un n umero negativo y 1 es el primer valor positivo que

puede tomar X

2.4 Descripcion de Variables Aleatorias 29

Si X es unimodal, con una distribucion asimetrica se cumple que:

O bien m

o

m

e

E(X), tal y como muestra la gura 2.1

O bien E(X) m

e

m

o

), tal y como muestra la gura 2.2

Figura 2.1: Distribucion asimetrica, caso 1

Figura 2.2: Distribucion asimetrica, caso 2

Si X es unimodal, con una distribucion simetrica, se cumple que:

m

o

= m

e

= E(X), tal y como se detalla en la gura 2.3

Figura 2.3: Distribucion simetrica

30 Captulo 2. Variables Aleatorias Univariantes

Captulo 3

Modelos de Probabilidad

Univariantes

Comenzaremos el captulo viendo los modelos o distribuciones que tratan con variables

aleatorias discretas, para despues hacer lo propio con aquellos que se encargan de las variables

continuas.

3.1. Modelo de Bernoulli

X B(1, p)

Los experimentos de Bernoulli son aquellos que solo presentan dos posibles resultados

(sucesos dicotomicos): exito/fracaso, 0/1, par/impar, blanco/negro, etc.

La variable X 0, 1, que toma el valor 1 si sucede A, con probabilidad T(A) = p

conocida, al realizar una sola prueba, se conoce como variable de Bernoulli.

La funcion puntual de probabilidad se dene como p(x) = p

x

(1 p)

1x

con x 0, 1.

Es decir:

T(X = 1) = p

T(X = 0) = 1 p = q

T(X = x) = 0, x / 0, 1

La media y la varianza de una variable de Bernoulli son:

E(X) = 0 (1 p) + 1 p = p

V (X) = E(X

2

) E(X)

2

= 0

2

(1 p) + 1

2

p p

2

= p(1 p) = pq

3.2. Modelo Binomial

X B(n, p)

El modelo Binomial es el que modeliza los experimentos consistentes en repetir n veces de

forma identica (es decir, la probabilidad p es constante en todas la pruebas) e independiente

un experimento de Bernoulli y cuenta el n umero de veces que ha ocurrido el suceso A (con

T(A) = p).

Algunos ejemplos de variables que se rigen por este modelo pueden ser: N umero de

caras al tirar 10 veces una moneda, N umero de bolas blancas al hacer 10 extracciones

con reemplazamiento, N umero de piezas defectuosas en una muestra de 100 elementos sin

reemplazamiento.

31

32 Captulo 3. Modelos de Probabilidad Univariantes

Nota.- Si el espacio muestral es nito, entonces debe haber reemplazamiento

para que los experimentos de Bernoulli sean identicos (p constante en todas las

pruebas). Si el espacio muestral es innito o con cardinalidad mucho mayor que

la muestra que tomamos, se puede considerar que no hay reemplazamiento.

La funcion puntual de probabilidad de una v.a. X seg un este modelo es:

p(x) = T(X = x) =

_

n

x

_

p

x

(1 p)

nx

con X 0, 1, . . . , n

Particularmente, la situacion en que las x primeras veces ocurre A y las n x veces

restantes ocurre

A sera: A

x

. . .A

A

nx

. . .

A. Pues bien, p(x) representa cualquier combinacion de

A

s y

A

s.

Veamos ahora que

n

x=0

p(x) = 1

n

x=0

p(x) =

n

x=0

_

n

x

_

p

x

(1 p)

nx

= (p + (1 p))

n

= 1

Si X es binomial podemos expresarla como:

X = X

1

+X

2

+. . . +X

n

X

i

_

0 si se da

A en el experimento i-esimo

1 si se da A en el experimento i-esimo

Es decir, cada X

i

es una variable de Bernoulli: X

i

B(1, p).

De este modo, la media y la varianza para v.a. que siguen el modelo binomial son:

E(X) = E(X

1

) +E(X

2

) +. . . +E(X

n

) = p +p +. . . +p = np

V (X) = V (X

1

)+V (X

2

)+. . .+V (X

n

) = p(1p)+p(1p)+. . .+p(1p) = np(1p) = npq

Utilizamos el modelo Binomial para analizar la denicion frecuentista de probabilidad.

Denimos la variable aleatoria frecuencia relativa del suceso A en n pruebas independientes.

fr(A) =

n

A

n

n

A

B(n, p)

E(fr(A)) =

1

n

E(n

A

) =

1

n

np = p

V (fr(A)) =

1

n

2

V (n

A

) =

1

n

2

np(1 p) =

p(1p)

n

Por la desigualdad de Tchebychev

T([X E(X)[ < ) 1

V (X)

2

y haciendo X = fr(A) se cumple que T([fr(A) p[ <

) 1

p(1p)

n

2

= 1

p(1 p)

n

2

Si ahora analizamos la funcion p(1p) = pp

2

observamos que su valor maximo lo toma

en 0

5 y es

1

4

, por lo tanto:

T([fr(A) p[ < ) 1

1

4n

2

Y, as, cuando n + se tiene T([fr(A) p[ < ) 1

Es decir, fr(A) T(A) en probabilidad.

Ejemplo 3.1 Cuanto tiene que valer n para que la estimacion de una probabilidad mediante

una frecuencia sea un suceso con probabilidad mayor que 0

95 sabiendo que el error cometido

es menor que 10

2

?

T([fr(A) p[ < 10

2

) 1

1

4n(10

2

)

2

> 0

95 n > 50000

3.3 Modelo Geometrico 33

3.3. Modelo Geometrico

X Ge(p)

X:N umero de pruebas identicas e independientes hasta que ocurre A

X 1, 2, . . .

Y :N umero de fracasos (n

o

de veces que ocurre

A) hasta que ocurre A

Y 0, 1, 2, . . ., es decir, X = Y + 1

La funcion puntual de probabilidad de la variable que se ajusta a este modelo es:

p(x) = T(X = x) = (1 p)

x1

p = q

x1

p

A

A

x1

. . .

A[A x 1, 2, . . .

p(y) = T(Y = y) = (1 p)

y

p = q

y

p

A

A

y

. . .

A[A y 0, 1, . . .

Las esperanzas matematicas de X e Y se diferencian en una unidad, mientras que las

varianzas coinciden.

E(X) = E(Y ) + 1 V (X) = V (Y )

Vamos a calcularlas utilizando la funcion generadora de momentos:

m

X

(t)

t(,)

= E

_

e

tX

_

=

+

x=1

e

tx

q

x1

p = p

+

x=1

e

t

e

t(x1)

q

x1

= pe

t

+

x=1

_

qe

t

_

x1

Esta serie es convergente si qe

t

< 1 e

t

<

1

q

t < ln

_

1

q

_

=

Por lo tanto m

X

(t) = pe

t

1

1 qe

t

=

pe

t

1 qe

t

m

(0) = E(X) =

_

pe

t

(1 qe

t

) pe

t

(qe

t

)

(1 qe

t

)

2

_

t=0

=

p(1 q) +pq)

(1 q)

2

=

p(1 q +q)

p

2

=

1

p

m

(0) = E(X

2

)

En resumen: E(X) =

1

p

E(Y ) =

1

p

1 =

1 p

p

=

q

p

V (X) = V (Y ) =

q

p

2

Ejemplo 3.2 Calcular el n umero medio de Fantas que hay que comprar para reunir las letras

de la palabra VIAJE con sus tapones.

X

i

:N umero de compras necesarias hasta conseguir la i-esima letra diferente

X = X

1

+X

2

+X

3

+X

4

+X

5

X

1

Ge(1) X

3

Ge(

3

5

) X

5

Ge(

1

5

)

X

2

Ge(

4

5

) X

4

Ge(

2

5

)

E(X) = E(X

1

+ X

2

+ X

3

+ X

4

+ X

5

) = E(X

1

) + E(X

2

) + E(X

3

) + E(X

4

) + E(X

5

) =

1 +

5

4

+

5

3

+

5

2

+ 5 = 11

4167

3.4. Modelo Binomial Negativo

X BN(r, p)

X:N umero de pruebas identicas e independientes hasta que sucede A r veces

X r, r + 1, r + 2, . . . con r N

La funcion puntual de probabilidad de las variables que siguen este modelo es:

p(x) = T(X = x) = PR

r1,xr

x1

p

r

q

xr

=

(x 1)!

(r 1)!(x r)!

p

r

q

xr

=

_

x1

r1

_

p

r

q

xr

A

r1

. . . A

A

xr

. . .

A[A

Y su esperanza matematica se calcula como: E(X) =

r

p

34 Captulo 3. Modelos de Probabilidad Univariantes

3.5. Modelo Hipergeometrico

X H(N, n, K)

Supongamos una poblacion nita de tama no N en donde hay K objetos de la clase A y

N K objetos de la clase

A.

Se toma una muestra de tama no n sin reemplazamiento (ya que si hubiera reemplaza-

miento se tratara de un experimento que seguira el modelo binomial).

X:N umero de objetos de la clase A en la muestra de tama no n sin reemplazamiento

As, se tiene que:

n X N K

X n (N K)

_

max0, n (N K) X minn, K

Y por lo tanto: T(X = x) =

_

K

x

__

NK

nx

_

_

N

n

_

Siendo la esperanza y la varianza:

E(X) = n

K

N

= np V (X) = n

K

N

_

1

K

N

__

N n

N 1

_

= npq

N n

N 1

Ejemplo 3.3 En una urna donde hay 3 bolas blancas y 2 negras, calcular la probabilidad de

que X = 2, siendo

X:N umero de bolas blancas en una muestra sin reemplazamiento de tama no 4

X 2, 3

T(X = 2) =

_

3

2

__

2

2

_

_

5

4

_

3.6. Modelo de Poisson

X P()

Este modelo trata los experimentos consistentes en contar el n umero de veces que se pre-

senta un suceso en un intervalo de soporte continuo. Este intervalo se divide en subintervalos

iguales, sucientemente peque nos como para que el experimento se comporte seg un el modelo

Bernoulli dentro de cada uno de ellos.

Siendo el n umero medio de veces que sucede A en cada intervalo, la funcion puntual de

probabilidad de la variable X (que luego obtendremos mediante un paso al lmite) es:

T(X = x) =

e

x

x!

X 0, 1, 2, . . .

Es decir, si

X:N umero de veces que ocurre A en un intervalo unidad de soporte continuo

+

x=0

T(X = x) =

+

x=0

e

x

x!

= e

x=0

x

x!

= e

= 1

La esperanza matematica, as como la varianza son:

E(X) =

+

x=0

xe

x

x!

=

+

x=1

xe

x

x!

=

+

x=1

e

x

(x 1)!

=

+

x=0

e

x1

(x 1)!

=

V (X) =

3.7 Modelo Exponencial 35

Algunos ejemplos de variables modelizadas as seran: X:N umero medio de e-mails re-

cibidos en una terminal en una hora

1

, X:N umero de fallos superciales en un cable de

red

2

Para demostrar la validez de la funcion puntual de probabilidad consideremos un experi-

mento binomial con n repeticiones (correspondientes a los n subintervalos) donde n +.

lm

n+

_

n

x

_

p

x

(1 p)

nx

=

=np

lm

n+

n!

x!(n x)!

_

n

_

x

_

1

n

_

nx

=

=

x!

lm

n+

n

n

n 1

n

n x + 1

n

_

1

n

_

n

_

1

n

_

x

=

x!

lm

n+

_

1

n

_

n

=

e

x

x!

Hasta aqu llegan los modelos discretos que nosotros vamos a ver. A partir de ahora todos

los modelos que veamos seran para variables continuas.

3.7. Modelo Exponencial

T Ex()

Las variables que modeliza el modelo exponencial son aquellas que denotan el tiempo o

distanciaentre dos ocurrencias sucesivas de A.

Al igual que en el modelo de Poisson, :N umero medio de veces que ocurre A por intervalo

de soporte continuo.

Vamos a calcular la probabilidad de que en el instante t no haya ocurrido todava el suceso

A, es decir, T(T > t).

Si denimos la v.a. X

t

como:

X

t

:N umero de veces que ocurre A en un intervalo [0, t]

nos daremos cuenta de que sigue un modelo de Poisson. Esto es:

X

t

P(

t

) donde

t

= t X

t

P(t)

Siendo T(T > t) = T(en el intervalo [0, t] no ha ocurrido A) = T(X

t

= 0) = e

t

; t > 0

F(t) = 1 T(T > t) = 1 e

t

t > 0

f(t) =

d

dt

F(t) = e

t

Ejemplo 3.4 El n umero medio de fallos en la produccion de una cierta pieza es, al a no, de

3 unidades. Calcular la probabilidad de que una pieza tenga una vida de mas de 6 meses.

T:Tiempo de vida (en a nos) de dicha pieza

= 3 T

_

T >

1

2

_

= e

3

2

Para hallar las expresiones de la media, la varianza y la desviacion tpica haremos uso de

la funcion generadora de momentos.

m(t) = E

_

e

tX

_

=

_

+

0

e

tx

e

x

dx =

_

+

0

e

x(t)

dx =

t

_

e

x(t)

_

+

0

t<

=

t

(01) =

t

m

(0) = E(X) =

( t)

2

_

t=0

=

1

(0) = E(X

2

) =

2

( t)

3

_

t=0

=

2

2

= E(X) =

1

2

= V (X) =

2

2

1

2

=

1

2

= D(X) =

1

1

Discretizando el tiempo, que es continuo, en por ejemplo, segundos, y en cada segundo puede haber llegado

un e-mail o no.

2

Discretizando la longitud del cable en secciones de un milmetro, por ejemplo.

36 Captulo 3. Modelos de Probabilidad Univariantes

Este modelo continuo es analogo al modelo geometrico respecto a la propiedad de carencia

de memoria:

T(T > t

0

+t

1

[

T>t

0

) = T(T > t

1

)

T(T > t

0

+ t

1

[

T>t

0

) =

T((T > t

0

+t

1

) (T > t

0

))

T(T > t

0

)

=

T(T > t

0

+t

1

)

T(T > t

0

)

=

e

(t

0

+t

1

)

e

t

0

=

e

t

1

= T(T > t

1

)

Por lo tanto este no es un buen modelo para sistemas que se deterioran con el tiempo.

3.8. Modelo Gamma

X (r, )

Decimos que X sigue una distribucion Gamma de parametros r, , si su funcion de

densidad viene dada por:

f(x) =

r

(r)

x

r1

e

x

x > 0

Donde

(r) =

_

+

0

x

r1

e

x

dx r > 0

recibe el nombre de funcion Gamma y cumple que:

(r) = (r 1)(r 1) para r > 1

De donde se deduce que si x N entonces (r) = (r 1)!

En el caso particular en que r = 1 se tiene que:

(r, ) = (1, ) Ex()

3.9. Modelo de Erlang

X Erlang(r, )

Este modelo modeliza las variables aleatorias X que representan el tiempo o distan-

ciaque transcurre hasta que sucede A r veces; r N

Erlang(r, ) (r, )

3.10. Modelo Normal o de Gauss

X ^(, )

Este modelo es, con diferencia, el mas utilizado para modelizar experimentos aleatorios.

Si una variable X es la suma de un n umero grande de variables independientes, entonces se

puede aproximar X por una distribucion que denominaremos normal.

Diremos que la v.a. X sigue un modelo normal de media y desviacion tpica si su

funcion de densidad es:

f(x) =

1

2

e

1

2

(

x

)

2

x R

Algunas propiedades que cumple esta funcion de densidad f son:

Propiedad 3.1 f( x) = f( +x), x (simetra respecto de )

Propiedad 3.2 f tiene un maximo en x =

Propiedad 3.3 f tiene puntos de inexion en x =

3.10 Modelo Normal o de Gauss 37

Propiedad 3.4

T(X ( , +)) 0

68

T(X ( 2, + 2)) 0

95

T(X ( 3, + 3)) 0

99

Para calcular la probabilidad referida a una v.a. X ^(, ) se debera integrar la

funcion de densidad en cierto intervalo, pero esa integral no tiene primitiva y hay que hacer

uso de metodos numericos para hallarla. No obstante, existen unas tablas de la funcion de

distribucion que nos permiten calcular dichas probabilidades.

Pero como cada experimento tiene su propia media y varianza se necesitara disponer de

innitas tablas. Por suerte cualquier distribucion normal se puede relacionar con la distribu-

cion ^(0, 1), mediante una tipicacion de la variable.

Si X ^(, ) entonces Z =

X

cumple que Z ^(0, 1).

Ejemplo 3.5 X:Altura de los recien nacidos

X ^(0

5, 0

01)

T(X > 0

51) = T

_

Z >

x

_

= T

_

Z >

0

51 0

5

0

01

_

= T(Z > 1) = 0

1587

De este ultimo ejemplo se deduce la siguiente expresion:

T(X x) = T

_

Z

x

_

3.10.1. Teorema Central del Lmite

Sean X

1

, . . . , X

n

v.a. independientes donde cada X

i

^(

i

,

i

).

Y sea la v.a. Y = a

0

+a

1

X

1

+a

2

X

2

+. . . +a

n

X

n

. Entonces se tiene que:

Y ^

_

_

a

0

+

n

i=1

a

i

i

,

_

n

i=1

a

2

i

2

i

_

_

El Teorema Central del Lmite establece que si X

i

son v.a. con E(X

i

) =

i

y D(X

i

) =

i

nitas e independientes y sin necesidad de que X

i

sean normales se tiene que:

Y = a

0

+a

1

X

1

+a

2

X

2

+. . . +a

n

X

n

aprox

^

_

_

a

0

+

n

i=1

a

i

i

,

_

n

i=1

a

2

i

2

i

_

_

Esta aproximacion crece (mejora) a medida que n aumenta y si X B(n, p) la funcion

de distribucion binomial puede ser aproximada por la distribucion normal, puesto que puede

ser expresada como suma de variables de Bernoulli.

38 Captulo 3. Modelos de Probabilidad Univariantes

3.10.2. Casos Particulares

1. Si X

i

son identicamente distribuidas, es decir, tienen la misma distribucion (siguen

el mismo modelo), se cumple lo siguiente:

E(X

i

) = D(X

i

) = i

por lo tanto

Y = a

0

+a

1

X

1

+a

2

X

2

+. . . +a

n

X

n

aprox

^

_

_

a

0

+

n

i=1

a

i

,

2

n

i=1

a

2

i

_

_

2. Si X B(n, p) entonces X = X

1

+X

2

+. . . +X

n

donde X

i

B(1, p)

Y si n es grande X B(n, p)

aprox

^

_

np,

_

np(1 p)

_

3. fr(A) =

n

A

n

donde n

A

B(n, p)

E(fr(A)) =

E(n

A

)

n

=

np

n

= p

V (fr(A)) =

V (n

A

)

n

2

=

np(1 p)

n

2

=

p(1 p)

n

Y as fr(A)

aprox

^

_

p,

_

p(1 p)

n

_

3.11. Modelo Uniforme

X U(a, b)

Se dice que una v.a. X sigue una distribucion uniforme en el intervalo (a, b) si su funcion

de densidad es:

f(x)

_

_

_

1

b a

x (a, b)

0 x / (a, b)

Por lo tanto la funcion de distribucion vendra dada por:

F(x)

_

_

0 x a

x a

b a

x (a, b)

1 x b

La media y la varianza de las variables que siguen este modelo son:

= E(X) =

_

b

a

x

b a

dx =

a +b

2

2

= E(X

2

) =

_

b

a

x

2

b a

dx

2

= V (X) = E(X

2

) E(X)

2

=

(b a)

2

12

Un caso particular del modelo uniforme es X U(0, 1)

3.12 Modelo Beta 39

3.12. Modelo Beta

X (p, q)

El modelo Beta es una generalizacion del modelo uniforme.

Decimos que una v.a. X continua sigue un modelos de parametros p, q (con p, q > 0),

si su funcion de densidad viene dada por:

f(x)

_

_

_

1

(p, q)

x

p1

(1 x)

q1

0 < x < 1

0 en el resto

En el caso en que p = q = 1 se cumple que (1, 1) U(0, 1)

3.12.1. Funcion Beta

: R

+

R

+

R

+

(p, q) (p, q)

(p, q) =

_

1

0

x

p1

(1 x)

q1

dx =

(p)(q)

(p +q)

Ejemplo 3.6 (4, 3) =

(4)(3)

(7)

=

3!2!

6!

= 60

3.13. Modelos que se derivan de la distribucion Normal

3.13.1. Modelo CHI-Cuadrado de Pearson (

2

Pearson)

|

2

n

Sean X

1

, . . . , X

n

v.a. normales tipicadas e independientes, es decir, X

i

^(0, 1).

Entonces el cambio de variable

| = X

2

1

+X

2

2

+. . . +X

2

n

se llama variable

2

Pearson con n grados de libertad (tantos

como sumandos).

3.13.2. Modelo t

n

de Student

T t

n

Supongamos una v.a. Z ^(0, 1) y supongamos tambien otra variable aleatoria |

2

n

Entonces el cambio de variable

T =

Z

_

U

n

t

n

se denomina t

n

de Student, que hereda los grados de libertad de |.

3.13.3. Modelo T de Fisher o de Snedecor

X T

n,m

Supongamos una v.a. |

2

n

y otra v.a. 1

2

m

La variable denida como:

F =

U

n

V

m

=

|

1

m

n

T

n,m

se llama T de Snedecor.

40 Captulo 3. Modelos de Probabilidad Univariantes

Captulo 4

Variables Aleatorias Multivariantes

4.1. Variables Aleatorias Multidimensionales

En el caso de v.a. unidimensionales tenamos que:

X : (, /, T) (R, B, T

X

)

donde T

X

(B) = T(X

1

(B)) con X(B) /.

Si ahora nos interesan varias caractersticas numericas de un suceso, por ejemplo, X

1

:N

o

de ases y X

2

:N

o

de reyes, o tambien X

1

:altura de un individuo y X

2

:peso de ese mismo

individuo, entonces denimos una variable aleatoria K-dimensional como:

X = (X

1

, . . . , X

K

) : (, /, T) (R

K

, B

K

, T

X

)

4.1.1. Funcion de Distribucion Conjunta

Denicion 4.1 La funcion de distribucion conjunta de una variable aleatoria K-dimensional

se dene como:

F : R

K

[0, 1]

(x

1

, . . . , x

k

) F(x

1

, . . . , x

k

) = T(X

1

x

1

, . . . , X

k

x

k

)

Esta funcion cumple las siguientes propiedades:

Propiedad 4.1 F es no decreciente en cada componente, esto es:

Si x

i

< x

i

i = 1, . . . , k entonces F(x

1

, . . . , x

i

, . . . , x

k

) F(x

1

, . . . , x

i

, . . . , x

k

)

Propiedad 4.2 F es continua a la derecha en cada componente.

lm F(x

1

, . . . , x

i

+h, . . . , x

k

) = F(x

1

, . . . , x

i

, . . . , x

k

) i = 1, . . . , k

h 0

h > 0

Propiedad 4.3

lm F(x

1

, . . . , x

i

, . . . , x

k

) = 1

x

1

+

.

.

.

x

i

+

.

.

.

x

k

+

41

42 Captulo 4. Variables Aleatorias Multivariantes

Figura 4.1: Ejemplo de la propiedad 4.3

Veamos esta tercera propiedad para el caso de una v.a. X bivariante:

F(X

1

, X

2

) = T(X

1

x

1

, X

2

x

2

)

Si x

1

+ y x

2

+, vease la gura 4.1

Por otra parte, basta con que una sola variable x

i

cumpla que x

i

para que se

tenga que:

lm F(x

1

, . . . , x

i

, . . . , x

k

) = 0

x

i

Cada una de las K componentes de una v.a. multidimensional X puede ser, indistinta-

mente, continua o discreta.

Nosotros estudiaremos mas detalladamente el caso de v.a. bidimensionales cuyas compo-

nentes sean, simultaneamente, o bien continuas, o bien discretas.

4.1.2. Funcion Puntual de Probabilidad Conjunta

Denicion 4.2 La funcion puntual de probabilidad conjunta de una v.a. bidimensional,

cuyas componentes son discretas, viene dada por:

p(x, y) = T(X = x, Y = y)

Esta funcion cumple las siguientes propiedades:

Propiedad 4.4

p(x, y) > 0 (x, y)

Propiedad 4.5

xX

yY

p(x, y) =

(x,y)(XY )

p(x, y) = 1

Ejemplo 4.1

p(x, y)

XY -1 1

1

1

6

1

3

2

1

12

1

4

3

1

12

1

12

F(2

5, 1) = T(X 2

5, Y 1) =

1

6

+

1

3

+

1

12

+

1

4

4.1.3. Funcion de Densidad Conjunta

Denicion 4.3 La funcion de densidad conjunta de una v.a. bidimensional, cuyas compo-

nentes son continuas, se dene como:

f(x, y) =

2

F(x, y)

xy

4.2 Distribuciones Marginales y Condicionadas 43

Esta funcion cumple las siguientes propiedades:

Propiedad 4.6

f(x, y) > 0 x, y

Propiedad 4.7

_

+

_

+

f(x, y)dxdy = 1

Ejemplo 4.2

_

1

0

dx

_

2

1

dy(x +y) =

_

2

1

dy

_

1

0

dx(x +y) =

_

2

1

__

1

0

dx(x +y)

_

dy

(X, Y ) (0, 1) (1, 2)

_

1

0

dx

_

2

1

dy(x +y) =

_

1

0

dx

_

y

2

2

+xy

_

y=2

y=1

=

_

1

0

dx

_

2 + 2x

1

2

x

_

=

_

1

0

dx

_

x +

3

2

_

=

_

x

2

2

+

3

2

x

_

1

0

=

1

2

+

3

2

= 2 unidades

3

Ejemplo 4.3 Cuanto debe valer K para que la siguiente funcion sea funcion de densidad

conjunta?

f(x, y) =

_

K 0 x 1, 0 y 1, x +y 1

0 en el resto

Solucion:

_

1

0

dx

_

1x

0

dyK =

_

1

0

dy

_

1y

0

dxK = K

_

1

0

dy[x]

1y

0

= K

_

1

0

dy(1 y) = K

_

y

y

2

2

_

1

0

=

k

_

1

1

2

_

=

1

2

K

def

= 1 K = 2

4.2. Distribuciones Marginales y Condicionadas

Nosotros solo veremos los casos para v.a. bivariantes.

4.2.1. Distribuciones Marginales

Se podran denir tantas distribuciones marginales de una v.a. multivariante como di-

mensiones tuviera esta.

Funcion de Distribucion Marginal de X

Denicion 4.4 Siendo F(X, Y ) conocida podemos decir que

F

X

(x) = F(x) = T(X x) = T(X x, Y +) = F(x, +)

O lo que es lo mismo:

F

X

(x) = lm

y+

F(x, y)

F

Y

(y) = lm

x+

F(x, y)

44 Captulo 4. Variables Aleatorias Multivariantes

Funcion Puntual de Probabilidad Marginal de X

Denicion 4.5 Dadas las v.a. X e Y , discretas, podemos armar que

p(x) = T(X = x) =

yY

p(x, y)

Y analogamente,

p(y) = T(Y = y) =

xX

p(x, y)

Ejemplo 4.4 .

p(x, y)

XY -1 1 p(x)

0

1

6

1

3

1

2

1

1

12

1

4

1

3

2

1

12

1

12

1

6

p(y)

1

3

2

3

1

X 0 1 2

p(x)

1

2

1

3

1

6

Y -1 1

p(y)

1

3

2

3

p

X

(0) = p(0, y) = p(0, 1) +p(0, 1) =

1

6

+

1

3

=

1

2

Funcion de Densidad Marginal de X

Denicion 4.6 Si tenemos las v.a. X e Y , continuas, se cumple que

f

X

(x) =

dF

X

(x, y)

dx

=

_

+

f(x, y)dy

f

Y

(y) =

dF

Y

(x, y)

dy

=

_

+

f(x, y)dx

Ejemplo 4.5 Calcular f

X

(x), f

Y

(y) y F(x, y) dada la funcion de densidad conjunta

f(x, y) =

_

2 0 x 1, 0 y 1, x +y 1

0 en el resto

Solucion:

f

X

(x) =

_

1x

0

2dy = 2[y]

1x

0

= 2(1 x) 0 x 1

f

Y

(y) =

_

1y

0

2dx = 2[x]

1y

0

= 2(1 y) 0 y 1

F(x, y) =

_

x

ds

_

y

dtf(s, t)

Figura 4.2: Ejemplo 4.5

F(x, y)

_

_

0 (x, y) A B C

2xy (x, y) D

1 (1 x)

2

(1 y)

2

(x, y) E

1 (1 x)

2

(x, y) F

1 (1 y)

2

(x, y) G

1 (x, y) H

4.2 Distribuciones Marginales y Condicionadas 45

4.2.2. Distribuciones Condicionadas

Funcion Puntual de Probabilidad Condicionada