Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Tema09 x2

Cargado por

Julio Cesar Nuñez GarciaTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Tema09 x2

Cargado por

Julio Cesar Nuñez GarciaCopyright:

Formatos disponibles

Anlisis de datos y Estadstica Avanzada

Mster Interuniversitario de Astrofsica UCM+UAM Tema 9: Anlisis de componentes principales (PCA)

Javier Gorgas y Nicols Cardiel

Departamento de Astrofsica y Ciencias de la Atmsfera Facultad de Ciencias Fsicas Universidad Complutense de Madrid

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 1

1 / 52

Esquema

1

Introduccin PCA dentro del anlisis multivariante Objetivo del PCA Clculo de componentes principales Aproximacin geomtrica Aproximacin algebraica Un ejemplo sencillo El problema del cambio de escala Aplicacin del PCA Reduccin de la dimensionalidad Cuntas componentes retener? Signicado de las componentes principales Algunos ejemplos astrofsicos

Curso 2010/2011 2 2 / 52

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Introduccin

PCA dentro del anlisis multivariante

Tcnicas multivariantes

Consideremos un conjunto de objetos sobre los que se mide una serie de propiedades diferentes. Estudio ptimo? Uso de tcnicas multivariantes, las cuales permiten realizar un anlisis simultneo de todos los objetos y sus propiedades (ver Tema 6).

objeto #1 objeto #2 . . . objeto #n propiedad #1 y11 y21 . . . yn1 propiedad #2 y12 y22 . . . yn2 ... ... ... . . . ... ... ... ... . . . ... propiedad #p y1p y2p . . . ynp

Qu hacer?

8 > > > > > > > > > > > > > > > > > > > > > > > > > > > > > > < > > > > > > > > > > > > > > > > > > > > > > > > > > > > > > :

Contrastes de hiptesis sobre la matriz de covarianza: testear correlacin entre propiedades. Anlisis de componentes principales: bucar un conjunto reducido de combinaciones lineales de las variables que resuman la variacin de los datos. Anlisis de factores: expresar las variables originales como un conjunto de funciones lineales de factores. Anlisis de agrupacin: determinar agrupaciones entre datos (nmero de grupos inicialmente desconocido). Anlisis de clasicacin: ubicacin de nuevos objetos en distintos grupos predenidos. Regresin lineal mltiple: determinar un modelo que prediga un conjunto de propiedades (variables dependientes) a partir de otro conjunto de propiedades (variables independientes). Anlisis discriminante: buscar la combinacin lineal de las variables que mejor discrimine entre diferentes muestras de objetos. ...

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 3

4 / 52

Introduccin

Objetivo del PCA

Simplicar para sobrevivir!

El objetivo principal del anlisis de componentes principales es reducir la dimensionalidad de un conjunto (muy) grande de datos.

Tradicionalmente los astrnomos tienden a representar los parmetros medidos uno frente a otro, tratando de inferir conclusiones a partir de las correlaciones observadas. Esta tcnica es inviable cuando el nmero de parmetros representados es superior a 4 5.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 4 6 / 52

Introduccin

Objetivo del PCA

R permite, de forma trivial, representar todas los posibles diagramas de dispersin de un conjunto de datos multivariante con la ejecucin de un nico comando:

> plot(airquality) los datos estn en el paquete base, cargado por defecto

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 5

8 / 52

Clculo de componentes principales

Aproximacin geomtrica

Como ya vimos en su da, en el trabajo dentro del rea del anlisis multivariante resulta extremadamente til utilizar lgebra matricial.

objeto #1 objeto #2 . . . objeto #i . . . objeto #n medias propiedad #1 y11 y21 . . . yi1 . . . yn1 y1 propiedad #2 y12 y22 . . . yi2 . . . yn2 y2 ... ... ... . . . ... . . . ... ... ... ... ... . . . ... . . . ... ... propiedad #p y1p y2p . . . yip . . . ynp yp

Podemos denir y como un vector aleatorio con p variables (propiedades) medidas en cada objeto. Si tenemos n objetos en la muestra, las observaciones pueden escribirse como y1 , y2 ,. . . ,yn , donde 0 1 0 1 0 1 y11 y12 . . . . . . y1p yi1 y1 B yi2 C B y C B y21 y22 . . . . . . y2p C C B C B 2 C B yi = B . C , Y=B . C=B . . . . . C. . . . . A @ . A @ . A @ . . . . . . . . yip yn1 yn2 . . . . . . ynp yn

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 6 10 / 52

Clculo de componentes principales

Aproximacin geomtrica

Aproximacin geomtrica al problema

(Francis & Wills 1999) Consideremos un conjunto de n observaciones y1 , y2 , . . . , yi , . . . , yn , que forman una nube de puntos en un espacio p-dimensional (como simplicacin, podemos visualizarlo como un elipsoide de puntos). Cada vector yi es un vector columna con p elementos. Si las p propiedades Y1 , Y2 , . . . , Yp estn correlacionadas, la distribucin de puntos no estar orientada paralelamente a los ejes denidos por Y1 , Y2 , . . . , Yp .

A travs del PCA vamos a determinar los ejes naturales de la distribucin de puntos (i.e., los ejes del elipsoide), cuyo origen se encuentra en y, el vector medio de y1 , y2 , . . . , yn . Esto se realiza restando y y calculando la rotacin que minimice la suma de distancias a los ejes (maximice la proyeccin de los datos sobre los mismos ejes).

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 7 11 / 52

Clculo de componentes principales

Aproximacin geomtrica

Aproximacin geomtrica al problema Podemos rotar los ejes multiplicando cada vector p-dimensional yi por una matriz ortogonal A zi = Ayi . Como A es ortogonal, A A = I, la distancia al origen no cambia z zi = (Ayi ) (Ayi ) = y A Ayi = y yi , i i i y por ello zi = Ayi es realmente una rotacin. Buscamos la matriz ortogonal A que nos proporcione unos nuevos parmetros (componentes principales) Z1 , Z2 , . . . , Zp que no estn correlacionadas. Para ello necesitamos que la matriz muestral de covarianzas de z, Sz , sea diagonal 0 2 1 sz1 0 ... 0 B 0 s22 . . . 0 C z B C B . Sz = ASA = B . . C, . . C @ . . . . A 2 0 0 . . . szp donde S es la matriz muestral de covarianzas de y.

Conclusin: El problema se reduce a encontrar A tal que diagonalice S.

(Puede demostrarse que una matriz simtrica S puede ser diagonalizada empleando una matriz ortogonal que contenga los autovectores normalizados de S, y la matriz diagonal resultante contiene los autovalores asociados.)

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 8 12 / 52

Clculo de componentes principales

Aproximacin geomtrica

Aproximacin geomtrica al problema La matriz ortogonal A que diagonaliza S puede escribirse como 0 1 a1 B a C B 2 C A = B . C, @ . A . a p

donde ai son los autovectores de S que verican a aj = ij (estn normalizados y son i ortogonales). Las componentes principales son las nuevas variables Zi = a y, por ejemplo i Los autovalores de S sern las varianzas muestrales de las componentes principales 1 0 1 0 s2 0 ... 0 1 0 ... 0 z1 s22 . . . 0 C B 0 2 . . . 0 C B 0 z C B C B B . . . C=B . . . C, B . . . A @ . . C @ . . . . . . . A 2 0 0 . . . p 0 0 . . . szp siendo habitual ordenar las variables de forma que 1 > 2 > . . . > p . Z1 = a11 Y1 + a12 Y2 + . . . + a1p Yp .

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 9

13 / 52

Clculo de componentes principales

Aproximacin geomtrica

Reduccin de la dimensionalidad

Como los autovalores son varianzas de las componentes principales, podemos denir la proporcin de varianza explicada por las primeras k componentes mediante Proporcin de varianza = 1 + 2 + . . . + k 1 + 2 + . . . + k p = 1 + 2 + . . . + p j=1 sjj

Si los parmetros estn muy correlacionados, la dimensionalidad efectiva es mucho menor que p. En este caso los primeros autovalores son grandes y la proporcin de varianza ser prxima a 1 para valores de k pequeos. Si las correlaciones entre los parmetros originales son pequeas, la dimensionalidad efectiva ser prxima a p y los autovalores sern parecidos. En este caso las componentes principales esencialmente duplicarn los parmetros originales y no se conseguir reducir la dimensionalidad.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 10 14 / 52

Clculo de componentes principales

Aproximacin algebraica

Aproximacin algebraica al problema Otra forma de interpretar el PCA es como un mtodo que permita encontrar combinaciones lineales de variables con una varianza mxima. Por ejemplo, dado un conjunto de p parmetros Y1 , Y2 , . . . , Yp , podemos buscar la direccin denida por el vector p-dimensional a en la que un nuevo parmetro denido como presenta una varianza mxima. Z = a1 Y1 + a2 Y2 + . . . + ap Yp = a y,

Si tenemos un conjunto de n objetos, la varianza muestral de Zi = a yi , con i = 1, . . . , n, puede calcularse en funcin de S, la matriz muestral de covarianzas de y1 , y2 , . . . , yn , como s2 = a Sa. z No es posible calcular un mximo para la expresin anterior porque su valor crece de forma indenida para vectores a sucientemente grandes. Una forma de hacerlo es restringir arbitrariamente (pero de forma razonable) el tamao (norma) de a. Por ejemplo, suponiendo que es un vector unitario, i.e., a a = 1. Podemos entonces buscar el mximo de s2 con la condicin a a = 1. Esto se hace usando z la tcnica de los multiplicadores de Lagrange a imponiendo que la derivada de a Sa (a a 1) sea igual a cero, lo que conduce a (S I)a = 0 Sa = a

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 11

16 / 52

Clculo de componentes principales

Aproximacin algebraica

Aproximacin algebraica al problema El valor ptimo de a (que llamaremos a1 ) es la solucin de Sa = a. Es decir, a1 es el autovector asociado al autovalor 1 de mayor tamao. El segundo eje que maximiza la varianza debe ser perpendicular al primero ya calculado, por lo que tenemos una nueva restriccin a a1 = 0, por lo que la expresin a minimizar es ahora a Sa 2 (a a 1) 2 (a a1 ), donde 2 y 2 son dos nuevos multiplicadores de Lagrange. Tomando derivadas es fcil mostrar que 2 = 0, por lo que la ecuacin a resolver vuelve a ser Sa = a, siendo 2 el segundo autovalor ms grande y a2 su autovector asociado. De forma similar se razona para el resto de los ejes a3 , . . . , ap . Es decir, se obtiene el mismo resultado que ya vimos antes en la aproximacin geomtrica.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 12

17 / 52

Clculo de componentes principales

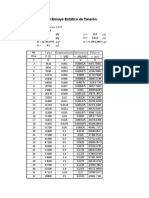

Un ejemplo sencillo

Un ejemplo con MATLAB

Consideremos el siguiente conjunto de datos (n = 25 objetos y p = 2 parmetros)

y1 y2 y1 y2 191 155 190 159 195 149 188 151 181 148 163 137 183 153 195 155 176 144 186 153 208 157 181 145 189 150 175 140 197 159 192 154 188 152 174 143 192 150 176 139 179 158 197 167 183 147 190 163 174 150

load datos.dat y1=datos(:,1); y2=datos(:,2); plot(y1,y2,ro); xlabel(y1); ylabel(y2); ymean=mean(datos); 185.7200 y= 151.1200 52.8683 54.3600

S=cov(datos); 95.2933 S= 52.8683 S es la matriz a diagonalizar.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 13

20 / 52

Clculo de componentes principales

Un ejemplo sencillo

[A,score,lambda,tsquare]=princomp(datos); 0.8249 0.5652 131.5183 A= = 0.5652 0.8249 18.1350 y los autovectores son 0.8249 a1 = 0.5652 0.5652 0.8249 p Las elipses tienen semiejes proporcionales a 1 = 11.47 y p p p 2 = 4.26 (calculadas como y1 1 cos t, y2 2 sin t, con t [0, 2], rotadas por A y con origen en y). y a2 =

La proporcin de varianza explicada por la primera componente ser Proporcin de varianza = 1 1 + 2 = 0.879 88%

Signicado de la primera componente? Al ser el PCA una rotacin de ejes, la primera componente principal minimiza la suma cuadrtica de distancias entre los puntos y la direccin principal (distancia perpendicular). Es, por tanto, equivalente a la regresin ortogonal (ver Tema 4). De hecho, la direccin de la primera componente principal se encuentra ubicada entre la regresin ordinaria de y1 sobre y2 y la regresin ordinaria de y2 sobre y1 .

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 14

21 / 52

Clculo de componentes principales

Un ejemplo sencillo

El mismo ejemplo con R

Volvemos a considerar el mismo conjunto de datos (n = 25 objetos y p = 2 parmetros)

y1 y2 y1 y2 191 155 190 159 195 149 188 151 181 148 163 137 183 153 195 155 176 144 186 153 208 157 181 145 189 150 175 140 197 159 192 154 188 152 174 143 192 150 176 139 179 158 197 167 183 147 190 163 174 150

modelo

120

Variances

80

> datos <- read.table(datos.dat,header=FALSE) > modelo <- prcomp(datos) > barplot(modelo$sdev2,names.arg=c("PC1","PC2"), + xlab="Principal Components", + ylab="Variances",main="modelo") > print(modelo) Standard deviations: [1] 11.468144 4.258521 Rotation: PC1 PC2 V1 -0.8249295 -0.5652357 V2 -0.5652357 +0.8249295 > summary(modelo) Importance of components: Standard deviation Proportion of Variance Cumulative Proportion PC1 PC2 11.4681 4.2585 0.8788 0.1212 0.8788 1.0000

20

40

60

100

PC1 Principal Components

PC2

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 15

23 / 52

Clculo de componentes principales

El problema del cambio de escala

El PCA no es invariante de escala!

Dado que el PCA se basa en la diagonalizacin de la matriz muestral de covarianzas S, es sensible a un cambio de escala en alguno de los parmetros Y. Por tanto, las componentes principales no son invariantes bajo cambios de escala. Siempre que sea posible, las variables bajo estudio deben expresarse en unidades comparables. Si las variables tienen escalas muy distintas, pueden estandarizarse antes del clculo de la componentes principales. Esto es equivalente a calcular las componentes principales de la matriz muestral de correlacin R. Es importante resaltar que los resultados que se obtienen al calcular las componentes principales a partir de la matriz muestral de covarianzas S o a partir de la matriz muestral de correlacin R son diferentes: 0 1 0 1 s11 s12 . . . s1p 1 r12 . . . r1p B s21 s22 . . . s2p C B r21 1 . . . r2p C B C B C S=B . vs. R=B . C . . . . C, . . A . . A @ . @ . . . . . . . sp1 sp2 . . . spp rp1 rp2 . . . 1 donde R = D1 SD1 , con Ds = diag( s11 , s22 , . . . , spp ). s s

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 16

25 / 52

Aplicacin del PCA

Reduccin de la dimensionalidad

Utilidad del PCA

En algunas aplicaciones el PCA constituye un objetivo en s mismo y es objeto de interpretacin. Otras veces es simplemente una herramienta que permite reducir la dimensionalidad de un conjunto de datos que posteriormente puede ser objeto de un anlisis estadstico posterior.

Ejemplos de reduccin de la dimensionalidad

Anlisis de regresin: cuando el nmero de variales es muy grande comparado con el nmero de observaciones (los tets pueden ser inecientes o imposibles de realizar). Anlisis de regresin: cuando las variables independientes estn muy correlacionadas (las estimaciones de los coecientes de regresin son inestables). Chequeo de normalidad multivariada, presencia de outliers,. . . (a travs de diagramas de dispersin de las primeras dos componentes).

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 17 27 / 52

Aplicacin del PCA

Reduccin de la dimensionalidad

Deteccin de outliers (diagrama de dispersin)

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 18

28 / 52

Aplicacin del PCA

Reduccin de la dimensionalidad

Deteccin de outliers (primeras 2 componentes principales)

Los outliers no aparecen al examinar las cuatro variables por separado!

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 19

29 / 52

Aplicacin del PCA

Reduccin de la dimensionalidad

Deteccin de agrupaciones

Deteccin de 4 grupos en el estudio de 19 propiedades en 40 objetos. En este ejemplo la proporcin de varianza explicada por las dos primeras componentes es del 85%, por lo que la representacin grca de z1 y z2 muestra la informacin existente en los datos con poca distorsin.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 20 30 / 52

Aplicacin del PCA

Cuntas componentes retener?

Indicaciones generales

1 2

Retener sucientes componentes para garantizar un porcentaje predenido de la varianza total, por ejemplo el 80%. Retener aquellas componentes cuyos autovalores superen el promedio de todos los P autovalores, p i /p. Para la matriz de correlacin este promedio es 1.0. i=1

Utilizar una representacin grca de i frente a i, y determinar el codo en el que se produce la transicin entre los autovalores grandes y los pequeos.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 21

32 / 52

Aplicacin del PCA

Cuntas componentes retener?

Indicaciones generales (continuacin)

4

Utilizar tests de signicacin. Un test preliminar que resulta til es testear la completa independencia de las variables, por ejemplo en la matriz poblacional de covarianzas H0 : = diag(11 , 22 , . . . , pp ), o lo que es equivalente, en la matriz poblacional de correlacin H0 : P = I. En este caso, el estadstico denido por u = [(n 1) donde u= 1 (2p + 5)] ln(u), 6

|S| = |R|, s11 s22 . . . spp

sigue aproximadamente una distribucin 2 , con f = 1 p(p 1). f 2 Se rechaza H0 si u > 2 . ,f Si el test indica que las variables son independientes, no tiene sentido realizar un anlisis de componentes principales.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 22 33 / 52

Aplicacin del PCA

Cuntas componentes retener?

Indicaciones generales (continuacin)

4

Utilizar tests de signicacin. Para testear la signicacin de las componentes principales, se realiza la hiptesis nula de que los ltimos k autovalores son pequeos e iguales, H0k : pk+1 = pk+2 = . . . = p , donde 1 , 2 , . . . , p son los autovalores poblacionales, es decir, los autovalores de . Para testear H0k se calcula el promedio de los ltimos k autovalores = y se calcula el estadstico u= 2p + 11 n 6

p X

i=pk+1

i , k 1

que sigue aproximadamente una distribucin 2 , con = 1 (k 1)(k + 2). 2 Se rechaza H0 si u 2 . ,

@k ln()

i=pk+1

p X

ln(i )A ,

Normalmente se empieza con H02 : p1 = p . Si se acepta, se sigue con H03 : p2 = p1 = p , y se sigue testeando hasta que H0k se rechaza para algn valor de k.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos Curso 2010/2011 23 34 / 52

Aplicacin del PCA

Signicado de las componentes principales

Signicado de las componentes?

Las componentes principales se obtienen por rotacin de ejes en el espacio de parmetros, proporcionando unas nuevas variables que no estn correlacionadas y que reejan las direcciones de mxima varianza. Estas direcciones no tienen por qu tener una interpretacin evidente. Si las componentes resultantes no pueden interpretarse fcilmente, pueden rotarse buscando anular el mayor nmero de coecientes de las combinaciones lineales para simplicar la intepretacin. Sin embargo, las nuevas componentes rotadas volvern a estar correlacionadas y ya no suministrarn direcciones de mxima varianza (ya no sern componentes principales). Cuando la interpretacin de los datos sea el objetivo fundamental (y no la reduccin de su dimensionalidad), el anlisis de factores es una tcnica alternativa ms til.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 24

36 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Stellar Spectral Classication. I. Application of Component Analysis, T.J. Deeming (1963).

Utilizacin de 5 ndices de intensidad de lnea en 84 estrellas gigantes de tipos espectrales G y K para la realizacin de una clasicacin espectral:

1 2 3 4 5

lnea K de Ca II banda CN4200 Mgb H el triplete de Ca I61026162)

Se obtiene que 1 es claramente mayor que 2 , 3 , 4 y 5 . Como las estrellas se restringen a un intervalo en magnitud absoluta, es razonable interpretar la primera componente (K1 ) como un parmetro indicativo del tipo espectral.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 25

38 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Variations in spectral-energy distributions and absorption-line strengths among elliptical galaxies, S.M. Faber (1973).

1 , 2 , 3 y 4 son signicativamente mayores que las varianzas esperadas por los errores (Qi ). Pero 3 y 4 son signicativos slo si los colores de M31, M32 y NGC205 se incluyen. Como estos ltimos son inciertos, entonces slo parecen signicativas las 2 primeras componentes. Slo hacen falta dos parmetros para especicar completamente los colores de las galaxias elpticas estudiadas.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 26

39 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

The manifold of globular clusters, Brosche & Lentes (1984).

El nmero de parmetros signicativos es p = 2 (el tercer autovalor es slo marginalmente signicativo). No se detectan agrupaciones en el plano PC1, PC2.

Anlisis de datos Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada

Curso 2010/2011 27

40 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

Estudio de 1850 espectros simulados con PEGASE, considerando brotes instantneos que ocurren a t = 0 y con edades comprendidas entre 0.01 y 18.5 Gaos. Ejemplos de espectros simulados para diferentes edades.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 28

41 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

PC1: explica el 98.5% de la variacin en los espectros. Correlaciona el continuo azul con las absorciones de Balmer. PC2: slo explica el 0.9% de la variacin, por lo que las caractersticas espectrales reconocibles (como la lnea K del Ca) tan slo aaden informacin de segundo orden con respecto a PC1. PC3: explica el 0.5% de la variacin. Correlaciona las lneas de Balmer con las absorciones por debajo de 4000 .

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 29

42 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

La proyeccin de PC1 frente a la edad muestra el claro enrojecimiento de las galaxias al hacerse stas ms viejas.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 30

43 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

Brote joven: espectros simulados con edades comprendidas entre 0 y 14 Maos

PC1: explica el 99.5% de la variacin en los espectros. La informacin que contiene es bsicamente las lneas de emisin. PC2: slo explica el 0.7% de la variacin, y se reduce de forma casi exclusiva a un continuo azul. PC3: explica el 0.05% de la variacin. Muestra la correlacin entre lneas de absorcin y la disminucin en el continuo por debajo de 4000 .

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 31

44 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

Brote joven: espectros simulados con edades comprendidas entre 0 y 14 Maos La proyeccin de PC1 y PC2 frente a la edad muestra que las lneas de emisin dominan slo para edades muy jvenes, disminuyendo drsticamente por encima de t = 6 Maos. PC2 indica que sin embargo el continuo tiene un mximo entre 3 y 5 Maos despus del brote, para caer bruscamente en t = 8 Maos.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 32

45 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

El efecto de la metalicidad Simulacin de espectros con distintas metalicidades, y edades comprendidas entre 100 y 1850 Maos. PC1: explica el 96.41% de la variacin en los espectros. Alguna de las lneas metlicas aparecen en emisin (e.g. NaD, Mgb, lneas de Fe). Son lneas de abosorcin pero estn anticorrelacionadas con las absorciones de Balmer y con los colores azules. PC2: slo explica el 2.03% de la variacin, y resulta muy diferente de lo que vimos anteriormente para metalicidad solar constante (tenemos mayor varianza debido precisamente a los efectos de la metalicidad). En este caso tenemos correlacin positiva (mismo signo) para las absorciones metlicas (NaD, Mgb, Fe5015, Fe5782) y las absorciones de Balmer. PC3: explica el 0.34% de la variacin y es ms difcil de interpretar que en el caso de metalicidad solar.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 33

46 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Analysis of synthetic galaxy spectra, Ronen, Aragn-Salamanca, & Lahav (1999).

El efecto de la metalicidad La proyeccin de PC1 frente a la edad para diferentes metalicidades (Z = 0.1, 0.05, 0.02, 0.008 y 0.004, de arriba a abajo). Como PC1 contiene un continuo azul, su valor disminuye (galaxias ms rojas) a medidad que la edad aumenta. Sin embargo, en los modelos ms metlicos se hacen ms azules de nuevo a partir de t = 14 Gaos. Esto se explica asumiendo que en este caso las estrellas esquivan la fase AGB y se mueven rpidamente a la rama horizonal azul debido a la existencia de unos fuertes vientos estelares.

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 34

47 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Anlisis de datos Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada

Curso 2010/2011 35

48 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Anlisis de datos Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada

Curso 2010/2011 36

49 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Anlisis de datos Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada

Curso 2010/2011 37

50 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Anlisis de datos Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada

Curso 2010/2011 38

51 / 52

Aplicacin del PCA

Algunos ejemplos astrofsicos

Referencias

Babu G.J., Feigelson E.D., 1996, Astrostatistics, Chapman & Hall, London Brosche P., Lentes F.-T., 1984, The manifold of globular clusters, A&A, 139, 474 Deeming T.J., 1964, Stellar spectral classication, MNRAS, 127, 493 Faber S.M., 1973, Variations in spectral-energy distributions and absorption-line strengths among elliptical galaxies, ApJ, 179, 731 Francis P.J., Wills B.J., 1999, Introduction to Principal Components Analysis, ASP Conference Series, 162, 363 Rencher A.C., 2002, Methods of multivariate analysis, 2nd edition, John Wiley & Sons Ronen S., Aragn-Salamanca A., Lahav O., 1999, Principal component analysis of synthetic galaxy spectra, MNRAS, 303, 284 Wall J.V., Jenkins C.R., 2003, Practical statistics for astronomers, Cambridge University Press Pgina WEB de VOStat: http://vo.iucaa.ernet.in/~voi/VOStat.html

Tema 9: Anlisis de componentes principales (PCA) () y Estadstica Avanzada Anlisis de datos

Curso 2010/2011 39

52 / 52

También podría gustarte

- Polipastos y Puentes GrúasDocumento23 páginasPolipastos y Puentes GrúasMariano Bernini100% (1)

- Curso FLECS en EspanolDocumento149 páginasCurso FLECS en EspanolCésar Barrera100% (2)

- Que Estudia La Física Como CienciaDocumento2 páginasQue Estudia La Física Como Cienciahumbertizhop64% (14)

- Hojas de Calculo Muro Gavion PDFDocumento6 páginasHojas de Calculo Muro Gavion PDFDiego G. Parra T.Aún no hay calificaciones

- NMX C 416 Once 2003 PDFDocumento101 páginasNMX C 416 Once 2003 PDFMiguel RamírezAún no hay calificaciones

- Propiedades Agua Bajosaturada (Mario Medina)Documento11 páginasPropiedades Agua Bajosaturada (Mario Medina)americaAún no hay calificaciones

- 1 Pre Informe de Volumetria Acido BaseDocumento7 páginas1 Pre Informe de Volumetria Acido BaseCristian CastroAún no hay calificaciones

- Resume NDocumento7 páginasResume NGian Pezo SuarezAún no hay calificaciones

- Catalogo 2014Documento146 páginasCatalogo 2014José BenjamínAún no hay calificaciones

- Programa MC2143Documento2 páginasPrograma MC2143jose mamaniAún no hay calificaciones

- Ebullicion Por EnfriamientoDocumento5 páginasEbullicion Por EnfriamientoMiguel Antony Zumaeta GonzalesAún no hay calificaciones

- Propuesta Mejoramiento Instalaciones Electricas CRISTOFER MENDOZA 31-07-2019Documento44 páginasPropuesta Mejoramiento Instalaciones Electricas CRISTOFER MENDOZA 31-07-2019CENAIDA MENDOZAAún no hay calificaciones

- Factorización Ii: ÁlgebraDocumento4 páginasFactorización Ii: ÁlgebraAlexis Esmith Castañeda RequejoAún no hay calificaciones

- 2magnetoestrictivo PDFDocumento2 páginas2magnetoestrictivo PDFAndrea EstrellaAún no hay calificaciones

- Restauradores VH000 11Documento30 páginasRestauradores VH000 11Juan de LeonAún no hay calificaciones

- Teoría de ConsolidaciónDocumento3 páginasTeoría de ConsolidaciónAdrian PeraltaAún no hay calificaciones

- A-01 Aceite Agip Arnica S (Iso 68) (Eni)Documento7 páginasA-01 Aceite Agip Arnica S (Iso 68) (Eni)xeocAún no hay calificaciones

- Cromatografia de Intercambio IónicoDocumento2 páginasCromatografia de Intercambio IónicoMyle KrizkruAún no hay calificaciones

- FundacionesDocumento46 páginasFundacionesCesarJ.RuizAún no hay calificaciones

- Bio TerminadoDocumento37 páginasBio TerminadoBryan Emerson Chupayo Sandoval100% (1)

- Propiedades de Los Fluidos Petroleros UNAMDocumento6 páginasPropiedades de Los Fluidos Petroleros UNAMRodrigo Adrian Mamani RodriguezAún no hay calificaciones

- Cuento Corto Del Sistema Solar para NiñosDocumento2 páginasCuento Corto Del Sistema Solar para Niñosqmey100% (3)

- Trabajo Tesis Piagetana71Documento31 páginasTrabajo Tesis Piagetana71yarem13Aún no hay calificaciones

- Parcial AnalisisDocumento4 páginasParcial AnalisisRicardoAún no hay calificaciones

- 102 145Documento44 páginas102 145oxd1550% (2)

- Limon TripticoDocumento2 páginasLimon TripticoLucila Iparraguirre Toledo100% (1)

- Aporte de Calibraciones A Los Resultados de Medición - Omar Castellón INGESTECDocumento32 páginasAporte de Calibraciones A Los Resultados de Medición - Omar Castellón INGESTECjaymAún no hay calificaciones

- Trasformador de CorrienteDocumento18 páginasTrasformador de Corrientejhonathan bayron cuesta ledesmaAún no hay calificaciones

- Sistema HidráulicoDocumento4 páginasSistema HidráulicoDavidGuevara100% (1)

- Procedimiento de GraficacionDocumento4 páginasProcedimiento de GraficacionJuan GandaraAún no hay calificaciones