0% encontró este documento útil (1 voto)

1K vistas12 páginasAnalisis Factorial

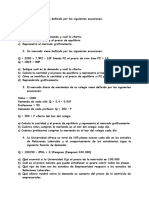

Este documento presenta una introducción al análisis factorial, una técnica estadística que resume la información de una matriz de datos en un número reducido de factores. Explica que el análisis factorial representa las variables originales con una pérdida mínima de información y que sus orígenes se remontan a las técnicas de regresión lineal desarrolladas por Galton y Pearson. También distingue entre el análisis factorial exploratorio y el confirmatorio, y entre el análisis factorial y el análisis de componentes principales.

Cargado por

Lineth RodriguezDerechos de autor

© Attribution Non-Commercial (BY-NC)

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como DOC, PDF, TXT o lee en línea desde Scribd

0% encontró este documento útil (1 voto)

1K vistas12 páginasAnalisis Factorial

Este documento presenta una introducción al análisis factorial, una técnica estadística que resume la información de una matriz de datos en un número reducido de factores. Explica que el análisis factorial representa las variables originales con una pérdida mínima de información y que sus orígenes se remontan a las técnicas de regresión lineal desarrolladas por Galton y Pearson. También distingue entre el análisis factorial exploratorio y el confirmatorio, y entre el análisis factorial y el análisis de componentes principales.

Cargado por

Lineth RodriguezDerechos de autor

© Attribution Non-Commercial (BY-NC)

Nos tomamos en serio los derechos de los contenidos. Si sospechas que se trata de tu contenido, reclámalo aquí.

Formatos disponibles

Descarga como DOC, PDF, TXT o lee en línea desde Scribd