Documentos de Académico

Documentos de Profesional

Documentos de Cultura

CN 1ii2 Seldir

Cargado por

Daniel ReveloTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

CN 1ii2 Seldir

Cargado por

Daniel ReveloCopyright:

Formatos disponibles

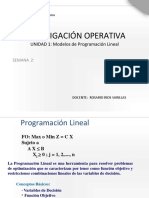

1.II.2. Sistemas de ecuaciones lineales: metodos directos.

Manuel Palacios

Departamento de Matematica Aplicada

Centro Politecnico Superior

Universidad de Zaragoza

Primavera 2001

Contents

1 Resolucion de sistemas triangulares 2

2 Matrices elementales 2

3 Eliminacion gaussiana y factorizacion LU. 3

4 Factorizacion de matrices estructuradas. 9

4.1 Factorizaci on racional de Cholesky . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

4.2 Metodo de Cholesky . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

4.3 Matrices huecas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

4.4 Matrices tridiagonales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

5 Sistemas sobredeterminados 13

6 Factorizacion Q R 14

6.1 Rotaciones de Givens. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

6.2 Reexiones de Householder . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

7 Condicionamiento y renamiento iterativo 20

7.0.1 Renamiento iterativo o correcci on residual . . . . . . . . . . . . . . . . . . . 22

References

[1] Burden, R. L. and Faires, J. D.: An alisis Numerico. Grupo Editorial Iberoamerica, 1985.

[2] Gasca, M.: C alculo numerico: resolucion de ecuaciones y sistemas. Librera Central, 1987.

[3] Hairer, E.: Introduction lAnalyse Numerique. Universite de Geneve, Dept. de Mathematiques,

1993.

[4] Conde, C. y Winter, G.: Metodos y algoritmos del algebra numerica. Editorial Reverte, 1990.

[5] Griel, D. H.: Linear Algebra and its applications. Ellis Horwood, 1989.

[6] Strang, G..: Linear Algebra and its Applications. 3

th

ed. Hardcourt Brace Jovanovich, Inc.,

1988.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 2

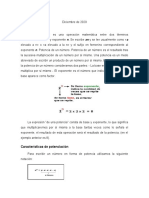

Introducci on

El problema que se pretende resolver en este captulo es el de un sistema de m ecuaciones lineales

con n inc ognitas denido en forma matricial mediante:

Ax = b,

en donde A IR

(m,n)

y b IR

m

son datos y x IR

n

es el vector incognita. Explcitamente se puede

escribir en la forma:

a

11

x

1

+ a

12

x

2

+ . . . + a

1n

x

n

= b

1

a

21

x

1

+ a

22

x

2

+ . . . + a

2n

x

n

= b

2

.

.

.

.

.

. . . .

.

.

.

.

.

.

a

m1

x

1

+ a

m2

x

2

+ . . . + a

mn

x

n

= b

m

(1)

Habitualmente supondremos que m = n y que el sistema posee solucion unica, es decir, det A =

0, o bien, rg A = n.

1 Resoluci on de sistemas triangulares

Un sistema triangular con m = n tiene la forma:

r

11

x

1

+ r

12

x

2

+ . . . + r

1n

x

n

= c

1

r

22

x

2

+ . . . + r

2n

x

n

= c

2

.

.

.

.

.

.

.

.

.

r

nn

x

n

= c

n

(2)

Estos sistemas se resuelven facilmente mediante el algoritmo siguiente denominado de sustitu-

ci on regresiva:

x

n

=

c

n

r

nn

, x

i

=

1

r

ii

(c

i

j=i+1

r

ij

x

j

), para i = n 1, . . . , 1 (3)

El coste computacional de esta resolucion es el siguiente: para cada i = n, n 1, . . . , 1, se

requiere una divisi on, n i productos y n i sumas, es decir, un total de

n

i=1

1 + 2 (n i) = n + n(n 1) = n

2

operaciones aritmeticas elementales.

2 Matrices elementales

Recordemos que se denomina matriz elemental, P

ij

(), a una matriz que multiplicada a la izquierda

(o a la derecha) de una matriz A realiza sobre ella una operaci on elemental, es decir,

a) una permutaci on de las (columnas), P

ij

,

b) una substituci on de la la i-esima por ella mas la j-esima la (la j-esima columna por ella

mas la i-esima la) multiplicada por un escalar , P

ij

();

c) una multiplicaci on de la la (columna) j-esima por un escalar = 0, P

jj

().

Estas operaciones elementales son las operaciones aritmeticas mas sencillas que transforman un

sistema lineal en otro equivalente, es decir, con las mismas soluciones.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 3

Los tres tipos de matrices elementales estan denidos en la forma siguiente: a) P

ij

es la matriz

unidad con sus las i y j cambiadas; b) P

ij

() es la matriz unidad pero su elemento ij es igual a

; c) P

jj

(), = 0, es la matriz unidad pero su elemento jj es igual a . Por ejemplo, si tomamos

matrices de orden 3:

P

23

=

_

_

1 0 0

0 0 1

0 1 0

_

_, P

23

() =

_

_

1 0 0

0 1

0 0 1

_

_, P

22

() =

_

_

1 0 0

0 0

0 0 1

_

_.

Propiedad 2.1 Todas las matrices elementales son regulares y sus inversas son las siguientes:

P

1

ij

= P

ij

, , (P

ij

())

1

= P

ij

(), , (P

22

())

1

= P

22

(1/).

3 Eliminaci on gaussiana y factorizaci on LU.

Supongamos dado el sistema (1), con m = n y det A = 0. Si a

11

= 0, se puede eliminar la variable

x

1

en las ecuaciones de la 2 a la n calculando

l

i1

=

a

i1

a

11

(4)

y realizando las operaciones elementales sobre las las de la matriz ampliada (A, b) denidas por

las matrices elementales P

i1

(l

i1

), i = 2, 3, . . . , n.

De esta manera, el sistema equivalente obtenido puede ser escrito en la forma siguiente:

a

(1)

11

x

1

+ a

(1)

12

x

2

+ . . . + a

(1)

1n

x

n

= b

(1)

1

a

(1)

22

x

2

+ . . . + a

(1)

2n

x

n

= b

(1)

2

.

.

.

.

.

. . . .

.

.

.

.

.

.

a

(1)

n2

x

2

+ . . . + a

(1)

nn

x

n

= b

(1)

n

(5)

donde

a

(1)

1j

= a

1j

, a

(1)

ij

= a

ij

l

i1

a

1j

para i = 2, 3, ..., n

b

(1)

1

= b

1

, b

(1)

i

= b

i

l

i1

b

1

(6)

(evidentemente, si a

11

= 0, hay que cambiar la primera la de (A, b) por otra para obtener a

11

= 0,

lo que siempre es posible, ya que det A = 0.

El sistema (5) contiene un subsistema de dimension n 1 sobre el cual puede repetirse el

procedimiento para eliminar x

2

en las ecuaciones 3 a n, es decir, hay que realizar las operaciones

elementales sobre las las de la matriz (5) denidas por las matrices elementales P

i2

(l

i2

), i =

2, 3, . . . , n, siendo l

i2

= a

(1)

i2

/a

(1)

22

.

Despues de n 1 etapas de este tipo

(A, b) (A

(1)

, b

(1)

) (A

(2)

, b

(2)

) . . . (A

(n1)

, b

(n1)

) =: (R, c)

se obtiene el sistema triangular

r

11

x

1

+ r

12

x

2

+ . . . + r

1n

x

n

= c

1

r

22

x

2

+ . . . + r

2n

x

n

= c

2

.

.

.

.

.

.

.

.

.

r

nn

x

n

= c

n

(7)

que se resuelve en n

2

operaciones aritmeticas en la forma indicada en (3).

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 4

Teorema 3.1 Sea det A = 0. El metodo de eliminaci on gaussiana permite construir matrices L y

U unicas tales que:

P A = LU, (8)

siendo P una matriz de permutaci on y

L =

_

_

_

_

_

_

1

l

21

1

.

.

.

.

.

.

.

.

.

l

n1

. . . l

n,n1

1

_

_

_

_

_

_

, U =

_

_

_

_

_

_

u

11

u

12

. . . u

1n

u

22

. . . u

2n

.

.

.

.

.

.

u

nn

_

_

_

_

_

_

(9)

La f ormula (8) se denomina factorizaci on L U de la matriz A.

Notemos que la matriz de permutacion es el producto de todas las matrices necesarias para

conseguir que ning un pivote salga nulo. Esta matriz es una matriz ortogonal, por lo tanto, det P =

1.

Demostr.: Supongamos que todas las permutaciones necesarias han sido realizadas antes de

comenzar la eliminacion gaussiana; seguiremos llamando A a la matriz P A.

El primer paso de la eliminaci on consiste en la multiplicaci on de la matriz A por las matrices

elementales P

i1

(l

i1

), i = 2, 3, . . . , n, es decir, realizando dicho producto por la matriz

L

1

= P

n1

(l

n1

)...P

21

(l

21

), (10)

Analogamente, el paso k-esimo consiste en la multiplicacion de la matriz A de este paso por las

matrices elementales P

ik

(l

2k

), i = k + 1, , . . . , n, es decir, realizando dicho producto por la matriz

L

k

= P

nk

(l

nk

)...P

k+1,k

(l

k+1,k

), (11)

Por lo tanto, las sucesivas matrices A

(k)

son:

L

1

A = A

(1)

, L

2

A

(1)

= A

(2)

, L

n1

A = A

(n1)

= U

En consecuencia,

U = L

n1

L

n2

...L

1

A =A = (L

n1

L

n2

...L

1

)

1

U

Pero

(L

n1

L

n2

...L

1

)

1

= (P

n,n1

(l

n,n1

)...P

n1

(l

n1

)...P

21

(l

21

))

1

=

P

21

(l

21

)

1

...P

n1

(l

n1

)

1

...P

n,n1

(l

n,n1

)

1

= P

21

(l

21

)...P

n1

(l

n1

)...P

n,n1

(l

n,n1

) = L.

La unicidad de la factorizaci on anterior se prueba como sigue. Supongamos que hubiese dos

factorizaciones del tipo mencionado:

A = LU =

L

U

Entonces, ya que

L es regular, se tendra:

L

1

LU =

U; como U y

U son triangulares superiores y

L y L son triangulares inferiores,

L

1

L deber ser la unidad, es decir,

L = L, y, en consecuencia,

U = U.

La matrices L

1

, L

2

, ... utilizadas en la eliminaci on gaussiana

L

1

=

_

_

_

_

_

_

_

_

1

l

21

1

l

31

0 1

.

.

.

.

.

.

.

.

.

.

.

.

l

n1

0 . . . 0 1

_

_

_

_

_

_

_

_

, L

2

=

_

_

_

_

_

_

_

_

1

0 1

0 l

32

1

.

.

.

.

.

.

.

.

.

.

.

.

0 l

n2

. . . 0 1

_

_

_

_

_

_

_

_

, (12)

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 5

son denominadas matrices de Fr obenius.

En el caso general, m n y rang A n, el proceso de eliminacion gaussiana se realiza de la

misma manera, pero teniendo en cuenta que los pivotes a utilizar siempre deben ser no nulos, para

lo que habr a que considerar, posiblemente, como antes alguna matriz de permutaci on.

Calculo del determinante de una matriz.

La f ormula (8) implica que det P . det A = det L . det U. Pero como det P = (1)

, donde es

el n umero de permutaciones necesarias en la eliminacion, se obtiene

det A = (1)

u

11

u

22

... u

nn

(13)

Observar que la factorizaci on LU permite, teniendo en cuenta la matriz U, determinar el rang A.

Resoluci on de sistemas lineales.

En la pr actica, se encuentra muchas veces que es preciso resolver una serie de sistemas lineales

que tienen todos la misma matriz de coecientes y en los que los terminos independientes s olo se

conocen despues de haber resuelto el sistema anterior. Por eso, para su resolucion se suele proceder

en la forma siguiente:

a) obtenci on de la factorizaci on A = LU y

b) resoluci on de los sistemas triangulares

Lc = P b, U x = c

por sustituci on progresiva y regresiva (algoritmo (3)), respectivamente.

Coste computacional de la factorizaci on LU.

Para el paso de A a A

(1)

se requieren: n 1 divisiones (ver (4)), 2(n 1) (n 1) multiplicaciones

y adiciones (ver (6)).

Para el paso de A

(1)

a A

(2)

se requieren: n 2 divisiones, 2(n 2) (n 2) multiplicaciones y

adiciones. Y as sucesivamente.

El coste total sera:

n1

k=1

(k 1) + 2

n1

k=1

(k 1)

2

n(n 1)

2

+ 2

_

n

0

x

2

dx =

n(n 1)

2

+

2

3

n

3

operaciones.

La elecci on del pivote.

En la eliminaci on gaussiana es preciso, de entrada, elegir una ecuaci on con el elemento a

i1

= 0 (que

se denomina pivote), a partir de la cual se elimina x

1

de todas las restantes ecuaciones. La eleccion

de esta ecuacion, es decir, del pivote, puede tener una gran inuencia en el resultado numerico, si

se realizan las operaciones en coma otante.

Ejemplo 3.2 (Forsythe). Considerese el sistema lineal

1.00 10

4

x

1

+ 1.00 x

2

= 1.00

1.00 x

1

+ 1.00 x

2

= 2.00

(14)

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 6

que tiene la soluci on exacta

x

1

=

1

0.9999

= 1.00010001..., x

2

=

0.9998

0.9999

= 0.99989998...

Realizando las operaciones en coma otante con tres cifras signicativas exactas (en base 10), se

aplica la eliminaci on gaussiana en los dos casos siguientes:

a) Tomando como pivote a

11

= 1.00 10

4

, se obtiene:

l

21

= a

21

/a

11

= 1.0010

4

, a

(1)

22

= 1.001.0010

4

= 1.0010

4

, b

(1)

2

= 2.001.0010

4

= 1.0010

4

En consecuencia:

x

2

=

b

(1)

2

a

(1)

22

= 1.00(exacto!), x

1

=

b

1

a

12

x

2

a

11

=

1.00 1.00 1.00

1.00 10

4

= 0

bien diferente de la soluci on exacta.

b) Cambiando las las de la matriz ampliada, ahora el pivote es 1.00 y la eliminaci on gaussiana

permite obtener:

l

21

= 1.00 10

4

, a

22

= 1.00 1.00 10

4

= 1.00, b

(1)

2

= 1.00 2.00 1.00 10

4

= 1.00

Resultando,

x

2

=

b

(1)

2

a

(1)

22

= 1.00 ( exacto!), x

1

=

b

1

a

12

x

2

a

11

=

2.00 1.00 1.00

1.00

= 1.00 (exacto!).

Para entender mejor donde se ha perdido informaci on esencial, veamos los subproblemas suma,

resta, multiplicaci on y divisi on separadamente y conozcamos su condicion.

Condici on de un problema

Considerese una aplicacion P : IR

n

IR, es decir, el problema de calcular P(x) para los datos

x = (x

1

, . . . , x

n

). Como inuyen las perturbaciones en los datos x sobre el resultado P(x)?.

Denicion 3.3 Se denomina condicion, , de un problema P al n umero real m as peque no tal que

| x

i

x

i

|

|x

i

|

eps =

|P( x) P(x)|

|P(x)|

eps (15)

Se dice que un problema P esta bien condicionado, si no es muy grande, en caso contrario, P

esta mal condicionado.

En esta denici on, eps representa un n umero peque no; si eps fuese la precision del ordenador

(por ejemplo, 10

6

en simple precision), x

i

puede ser considerado como el n umero de maquina de

x

i

. Tengase en cuenta que el n umero de condici on no depende del algoritmo utilizado para resolver

el problema P, sino que depende de los datos x

i

y del propio problema P.

Ejemplo 3.4 Multiplicaci on de dos n umeros reales. Dados x

i

, i = 1, 2, considerese el problema de

calcular P(x

1

, x

2

) = x

1

x

2

.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 7

Tomando los valores perturbados:

x

1

= x

1

(1 +

1

), x

2

= x

2

(1 +

2

), |

i

| eps

se tiene

x

1

x

2

x

1

x

2

x

1

x

2

= (1 +

1

) (1 +

2

) 1 =

1

+

2

+

1

2

Como eps es un n umero peque no,

1

2

se puede despreciar frente |

1

| +|

2

|; por lo tanto,

|

x

1

x

2

x

1

x

2

x

1

x

2

| 2 eps

resulta, = 2, es decir, un problema bien condicionado.

Ejemplo 3.5 Substracci on de dos n umeros reales. Dados x

i

, i = 1, 2, considerese el problema de

calcular P(x

1

, x

2

) = x

1

x

2

.

En forma an aloga al anterior se obtiene:

|

( x

1

x

2

) (x

1

x

2

)

x

1

x

2

| = |

x

1

1

x

2

2

x

1

x

2

|

|x

1

| +|x

2

|

|x

1

x

2

|

eps

En consecuencia, si sign x

1

= sign x

2

, lo que corresponde a una suma, no a una resta, se

tiene = 1, es decir, un problema bien condicionado.

Por el contrario, si x

1

x

2

, el n umero de condici on resulta muy grande y el problema muy mal

condicionado. Por ejemplo,

x

1

=

1

51

, x

2

=

1

52

=

2/50

(1/50)

2

= 100

Si en esta situacion, se realizan las operaciones con 3 cifras exactas (en base 10), se obtiene:

x

1

= 0.196 10

1

, x

2

= 0.192 10

1

y x

1

x

2

= 0.400 10

3

. Como las dos primeras cifras de x

1

y x

2

son las misma, la substraccion las hace desaparecer y solo se conserva una cifra signicativa.

Se dice que ha habido perdida de cifras signicativas. Esto es lo que ha ocurrido en la resoluci on

a) del problema de Forsythe (Ejemplo (3.2))

En consecuencia, se establece la siguiente

Estrategia de elecci on de pivote:

a) pivote parcial, se escoge como pivote el elemento de mayor valor absoluto de la columna involu-

crada en cada etapa.

b) pivote total, se escoge como pivote el elemento de mayor valor absoluto de entre todas las

las y columnas todava no utilizadas en las etapas anteriores.

En ambos casos, el coeciente l

i1

resultante es |l

i1

| 1.

Ya que en el caso b) es preciso permutar las y columnas, con la consiguiente perdida de

signicado de las inc ognitas, suele preferirse la estrategia de pivote parcial sobre la otra.

Algoritmo para la factorizaci on LU.

Un algoritmo para la determinaci on de las matrices L y U de esta factorizacion puede ser conseguido

siguiendo el proceso de Doolitle-Banaciewicz, que consiste en determinar en sucesivas etapas la

primera la de U, la primera columna de L, la segunda la de U, la segunda columna de L, y as

sucesivamente. Lo que se concreta en el algoritmo siguiente:

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 8

Algoritmo de Doolitle-Banaciewicz

Para k = 1, 2, ..., n,

Para j = k, ..., n,

u

kj

= a

kj

k1

p=1

l

kp

u

pj

;

Para i = k + 1, ..., n,

l

ik

=

1

u

kk

(a

ik

k1

i=1

l

ip

u

pk

).

(16)

Si se impone que los elementos u

ii

= 1, i = 1, 2, . . . , n, tambien la factorizaci on LU es unica y

el algoritmo an alogo (que comenzara con la primera columna de L, la primera la de U, etc.) se

denomina algoritmo de Cr out.

Este algoritmo es conveniente para ordenadores escalares, pero para ordenadores vectoriales

sera mejor trabajar en la forma equivalente siguiente.

Algoritmo de Iserles

Denotando las columnas de L por l

1

, l

2

, . . . , l

n

y las las de U por u

T

1

, u

T

2

, . . . , u

T

n

, resulta

A = LU = [ l

1

l

2

l

n

]

_

_

u

T

1

u

T

2

.

.

.

u

T

n

_

_

=

n

k=1

l

k

u

T

k

. (17)

Ya que las primeras k 1 componentes de l

k

y u

k

son todas cero, cada matriz l

k

u

T

k

tiene ceros en

sus primeras k 1 las y columnas.

Como l

k

u

T

k

no cambia si se reemplaza l

k

l

k

, u

k

1

u

k

, donde = 0, la k-esima la de

l

k

u

T

k

es u

T

k

y su k-esima columna es U

k,k

veces l

k

.

Empezando por k = 1, los primeros elementos de l

k

y u

k

son cero para k 2, por lo tanto,

se sigue que u

T

1

debe ser la primera la de A y l

1

debe ser la primera columna de A, dividida por

A

1,1

, para que L

1,1

= 1.

Una vez halladas l

1

y u

1

, se construye la matriz

A

1

= Al

1

u

T

1

=

n

k=2

l

k

u

T

k

.

Como las primeras la y columna de A

1

son cero, se deduce que u

T

2

debe ser la segunda la de

Al

1

u

T

1

, mientras que l

2

debe ser la segunda columna, escalada para que L

2,2

= 1.

En resumen, se tiene as el siguiente

Algoritmo

Poner A

0

:= A

Para k = 1, 2, ..., n

u

T

k

= la k-esima de A

k1

l

k

= columna k-esima de A

k1

, escalada para que L

k,k

= 1

Calcular A

k

:= A

k1

l

k

u

T

k

(18)

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 9

Ejemplo 3.6 (Ejercicio 1.5 de la colecci on). Hallar la factorizaci on LU de la matriz

A =

_

_

_

1 2 3

3 2 4

2 1 1

_

_

_

Soluci on: De acuerdo con el algoritmo (18), para k = 1,

u

T

1

= (1 2 3), l

T

1

= (1 3 2)

T

,

A

1

= Al

1

u

T

1

=

_

_

_

0 0 0

0 4 5

0 5 5

_

_

_,

para k = 2,

u

T

2

= (0 4 5), l

T

2

= (0 4 5)

T

/(4) = (0 1 5/4)

T

,

A

2

= A

1

l

2

u

T

2

=

_

_

_

0 0 0

0 0 0

0 0 5/4

_

_

_,

para k = 3,

u

T

3

= (0 0 5/4), l

T

3

= (0 0 1)

En consecuencia,

L =

_

_

_

1 0 0

3 1 0

2 5/4 1

_

_

_, U =

_

_

_

1 2 3

0 4 5

0 0 5/4

_

_

_

Basta realizar el producto LU para comprobar el resultado.

4 Factorizaci on de matrices estructuradas.

En el caso particular de que la matriz A tenga alg un tipo de estructura, por ejemplo, sea simetrica

o denida positiva o hueca, los algoritmos a utilizar deberan aprovechar dicha estructura. Veamos,

en primer lugar el siguiente resultado.

Teorema 4.1 Si la matriz A es simetrica y denida positiva:

a) La eliminaci on gaussiana es posible sin estrategia de pivote.

b) La descomposici on A = LU satisface

U = DL

T

, siendo D = diag(u

11

, . . . , u

nn

) (19)

Demostr.: a) Ya que la matriz es denida positiva, a

11

> 0, por lo que se puede elegir como pivote

en la primera etapa de la eliminaci on. Con lo cual se obtiene

A =

_

a

11

a

T

a C

_

A

(1)

=

_

a

11

a

T

0 C

(1)

_

, (20)

siendo

C

(1)

= C

1

a

11

a a

T

(21)

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 10

La matriz C

(1)

es simetrica, evidentemente, y denida positiva. En efecto, tomemos y IR

n1

, y =

0, la partici on (20) realizada y el que A es denida positiva implican

(x

1

, y

T

)

_

a

11

a

T

a C

__

x

1

y

_

= a

11

x

2

1

+ 2x

1

y

T

a + y

T

Cy > 0

As, eligiendo x

1

= y

T

a/a

11

, se obtiene de (21) que

y

T

C

(1)

y = y

T

Cy

1

a

11

(y

T

a)

2

> 0

Por recurrencia, se ve que todas las etapas de la eliminacion son posibles sin elegir el pivote.

b) La expresi on (19) es consecuencia de la unicidad de la factorizaci on LU, pues es suciente

escribir U = D

L para obtener

A = LU = LD

L = A

T

= U

T

L

T

=

L

T

(DL

T

),

de donde,

L = L

T

.

4.1 Factorizaci on racional de Cholesky

Denicion 4.2 La descomposici on

A = LDL

T

, (22)

obtenida como consecuencia del teorema 4.1, se denomina descomposici on o factorizaci on racional

de Cholesky.

Un algoritmo escalar an alogo al de Doolitle-Banaciewicz se puede conseguir inmediatamente,

aunque para ordenadores vectoriales sera mejor trabajar en la forma an aloga a la (18) descrita

mas arriba; para ello, se escribe la factorizaci on racional de Cholesky en la forma

A =

_

l

1

l

2

l

n

_

_

_

D

1,1

0 0

0 D

2,2

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

0

0 0 D

n,n

_

_

_

_

l

T

1

l

T

2

.

.

.

l

T

n

_

_

=

n

k=1

D

k,k

l

k

l

T

k

.

(recordar que l

k

es la k-esima columna de L).

La analoga con el algoritmo de la seccion (18) es obvia poniendo U = DL

T

, pero esta forma

es mejor para aprovechar la simetra.

Particularizando, pues, se obtiene el algoritmo siguiente:

Algoritmo:

Poner A

0

= A

Para k = 1, 2, ..., n

D

k,k

= (A

k1

)

k,k

l

k

= columna k-esima de A

k1

, escalada para que L

k,k

= 1

Calcular A

k

:= A

k1

D

k,k

l

k

l

T

k

(23)

Ejemplo 4.3 Sea A = A

0

=

_

2 4

4 11

_

.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 11

Aplicando el algoritmo,

l

1

=

_

1

2

_

, D

1,1

= 2 y A

1

= A

0

D

1,1

l

1

l

T

1

=

_

2 4

4 11

_

2

_

1 2

2 4

_

=

_

0 0

0 3

_

.

Deducimos que l

2

=

_

0

1

_

, D

2,2

= 3 y, nalmente,

A =

_

1 0

2 1

_ _

2 0

0 3

_ _

1 2

0 1

_

.

4.2 Metodo de Cholesky

Ya que A es denida positiva, u

ii

> 0 y, por lo tanto, se puede considerar la raz D

1/2

=

diag(

u

11

, . . . ,

u

nn

), con lo que la descomposicion (22) se convierte en

A = (LD

1/2

)(D

1/2

L

T

) = (LD

1/2

)(LD

1/2

)

T

.

Finalmente, volviendo a llamar L a LD

1/2

, podemos escribir

A = LL

T

, donde L =

_

_

_

_

_

_

l

11

l

21

l

22

.

.

.

.

.

.

.

.

.

l

n1

. . . l

n,n1

l

nn

_

_

_

_

_

_

(24)

que se denomina factorizaci on de Cholesky.

Observar que, por ser la matriz A denida positiva, su matriz diagonal reducida es la matriz

unidad, en consecuencia, hubiera sido suciente realizar la diagonalizaci on de la matriz A mediante

el metodo de las congruencias o el de Lagrange hasta llegar a una matriz diagonal coincidente

con la identidad utilizando una matriz P triangular inferior regular tal que P AP

T

= I. La matriz

L anterior es, precisamente, P

1

.

Evidentemente, se tiene

i = k, a

kk

= l

2

k1

+ . . . + l

2

kk

i > k, a

ik

= l

i1

l

k1

+ . . . + l

ik

l

kk

de donde se deduce el algoritmo siguiente

Algoritmo

Para k = 1, 2, ..., n

l

kk

= (a

kk

k1

j=1

l

2

kj

)

1/2

;

para i = k + 1, ..., n,

l

ik

=

1

l

kk

(a

ik

k1

j=1

l

ij

l

kj

).

(25)

Evidentemente, con el algoritmo de Iserles (23), la localizacion de la matriz L se reduce a

determinar sus columnas con la condici on l

ii

= D

1/2

ii

.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 12

El coste computacional de la factorizaci on de Cholesky por cualquiera de los algoritmos presenta-

dos es del orden de n

3

/3 operaciones aritmeticas elementales, es decir, la mitad que la factorizacion

LU.

Notese que debido a que para matrices simetricas denidas positivas se tiene que

i, j, a

ij

a

ii

a

jj

lo que permitye probar que la factorizaci on de Cholesky es un proceso estable.

4.3 Matrices huecas

Frecuentemente hay que resolver sistemas muy grandes (n = 10

5

es un ejemplo no grande), donde

la mayora de los elementos de A son ceros. Estas matrices son llamadas matrices huecas. La idea

es que, al manipular matrices huecas, deberan resultas factores L y U tambien huecas. La unica

herramienta que permite reducir el n umero de ceros es la permutacion de las y columnas, como

puede verse en el siguiente

Ejemplo 4.4

_

_

3 1 1 2 0

1 3 0 0 1

1 0 2 0 0

2 0 0 3 0

0 1 0 0 3

_

_

=

_

_

1 0 0 0 0

1/3 1 0 0 0

1/3 1/8 1 0 0

2/3 1/4 6/16 1 0

0 3/8 1/19 4/81 1

_

_

_

_

3 1 1 2 0

0 8/3 1/3 2/3 1

0 0 19/8 3/4 1

0 0 0 81/19 4/19

0 0 0 0 272/81

_

_

en donde se ve que la mayora de ceros de A se han transformado en elementos no nulos. Sin

embargo, reordenando simetricamente las y columnas resulta

_

_

2 0 1 0 0

0 3 2 0 0

1 2 3 0 1

0 0 0 3 1

0 0 1 1 3

_

_

=

_

_

1 0 0 0 0

0 1 0 0 0

1/2 2/3 1 0 0

0 0 0 1 0

0 0 6/29 1/3 1

_

_

_

_

2 0 1 0 0

0 3 2 0 0

0 0 29/6 0 1

0 0 0 3 1

0 0 0 0 272/87

_

_

Este es un ejemplo de matrices banda, en donde los elementos no nulos estan en la diagonal o cerca

de ella.

Teorema 4.5 Sea la factorizaci on A = LU obtenida sin pivotaje de una matriz hueca. Entonces,

todos los elementos nulos del comienzo de las las de A son heredados por L y todos los ceros del

comienzo de las columnas de A son heredados por U.

4.4 Matrices tridiagonales

Para matrices tridiagonales (matrices banda, de ancho de banda = 3) conviene reconstruir el

algoritmo de Doolitle (16) para eliminar operaciones innecesarias, por ejemplo, en la forma siguiente

_

_

a

1

c

1

b

2

a

2

c

2

.

.

.

.

.

.

.

.

.

b

n1

a

n1

c

n1

b

n

a

n

_

_

=

_

_

1

2

1

.

.

.

.

.

.

n

1

n1

1 0

_

_

_

1

1

2

2

.

.

.

.

.

.

n1

n1

n

_

_

lo que proporciona el siguiente

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 13

Algoritmo

1

= a

1

,

1

= c

1

,

2

= b

2

/

1

Para: k = 2, 3, . . . , n 1,

k

= a

k

k

k1

,

k

= c

k

,

k+1

= b

k+1

/

k

n

= 0,

n

= a

n

n

n1

(26)

Observese que esta factorizacion no siempre es posible; una condici on suciente para ello es que

|a

1

| > |c

1

| > 0,

|a

k

| |b

k

| +|c

k

|

|a

n

| > |b

n

| > 0

(27)

Coste computacional

El coste computacional de esta factorizacion es 3n 3, ya que son precisas n 1 divisiones, n 1

multiplicaciones y n 1 sumas; para la resoluci on del sistema de ecuaciones habra que a nadir

las operaciones requeridas en las dos sustituciones progresiva y regresiva, que suponen 5n 4

operaciones mas.

5 Sistemas sobredeterminados

Sea el sistema de m ecuaciones lineales con n inc ognitas denido en forma matricial mediante:

Ax = b,

en donde A IR

(m,n)

y b IR

m

son datos y x IR

n

es el vector incognita; explcitamente se puede

escribir en la forma:

a

11

x

1

+ a

12

x

2

+ . . . + a

1n

x

n

= b

1

a

21

x

1

+ a

22

x

2

+ . . . + a

2n

x

n

= b

2

.

.

.

.

.

. . . .

.

.

.

.

.

.

a

m1

x

1

+ a

m2

x

2

+ . . . + a

mn

x

n

= b

m

(28)

Evidentemente, el sistema (28) no posee, en general, solucion. La idea es la de localizar un vector

x tal que

||Ax b||

2

sea mnima (29)

con la norma eucldea. Este proceso se denomina metodo de los mnimos cuadrados, cuyo nombre

indica la eleccion de la norma en (29) (la suma de los cuadrados de los errores debe ser mnima).

Teorema 5.1 Siendo A una matriz mn (con m n) y b IR

m

, el vector x es soluci on de (29)

si y solo si

A

T

Ax = A

T

b (30)

Estas ecuaciones se denominan ecuaciones normales o de Gauss.

Demostr.: Los mnimos de la funci on cuadr atica

f(x) := ||Ax b||

2

2

= (Ax b)

T

(Ax b) = x

T

A

T

Ax 2x

T

A

T

b + b

T

b

estan dados por: 0 = f

(x) = 2(A

T

Ax A

T

b).

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 14

Interpretacion geometrica

El conjunto W = {Ax| x IR

n

} es un subespacio lineal de IR

m

. Para un b IR

m

dado, x es una

solucion del problema (29) si y solamente si Ax es la proyeccion ortogonal de b sobre W, lo que

signica que Axb Az, para todo z IR

n

; en consecuencia, A

T

(Axb) = 0, lo que proporciona

una segunda demostraci on de (30).

Ejemplo 5.2 La solubilidad el NO

3

K respecto de la temperatura medida se representa en la tabla

T 40 60 80 100 120

s 27 39 50 60 69

Encontrar una relaci on entre s y T.

Soluci on: Como s

i

= 12, 11, 10, 9 y

2

s

i

= 1, 1, 1, se sugiere la relacion: s = a + b t + c t

2

.

En forma matricial, el problema de mnimos cuadrados se puede plantear

Ax = b

_

_

_

_

_

_

_

1 40 1600

1 60 3600

1 80 6400

1 100 10000

1 120 14400

_

_

_

_

_

_

_

_

_

_

a

b

c

_

_

_ =

_

_

_

_

_

_

_

27

39

50

60

69

_

_

_

_

_

_

_

cuyas ecuaciones normales son:

A

T

Ax = A

T

b con A

T

A =

_

_

_

5 400 36000

400 36000 3520000

36000 3520000 363840000

_

_

_ y

_

_

_

a

b

c

_

_

_ =

_

_

_

245

21700

2097200

_

_

_

cuya soluci on por el metodo de Cholesky da

a = 0, b = 0.725, c = 0.00125

Observese que si s

5

= 69.1, la soluci on resulta:

a = 0.14, b = 0.7202, c = 0.00121

y es que, debido al mal condicionamiento de la matriz A

T

A, la soluciones son extremadamente

sensibles a los errores en los datos.

Notese que las ecuaciones normales (30) tienen siempre al menos una solucion (la proyecci on de

b sobre W siempre existe). La matriz A

T

A es semidenida positiva, y resulta denida positiva si

rang A = n, es decir, si las columnas de A son linealmente independientes. En estas condiciones, se

suele aplicar el algoritmo de Cholesky para resolver el sistema (30); sin embargo, suele ser preferible

calcular dicha soluci on directamente a partir de (29).

6 Factorizaci on Q R

Como se ha visto (seccion 3), la eliminaci on gaussiana consiste en multiplicar el sistema Ax = b

por una matriz triangular inferior de forma que el problema se reduce a la resoluci on del problema

equivalente Rx = c, siendo R triangular superior. Desgraciadamente, la multiplicaci on de Ax b

por una tal matriz no conserva la norma del vector.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 15

Para resolver (29), se busca una matriz ortogonal Q tal que

Q

T

(Ax b) = Rx c =

_

R

0

_

x

_

c

_

(31)

siendo R

una matriz cuadrada de orden n triangular superior y (c

, c

)

T

la parte de c = Q

T

b tal

que c

IR

n

y c

IR

mn

.

Como el producto por una matriz ortogonal no cambia la norma, ahora, se tiene

||Ax b||

2

2

= ||Q

T

(Ax b)||

2

2

= ||Rx c||

2

2

= ||Rx c

||

2

2

+||c

||

2

2

(32)

Entonces, se obtiene la solucion de (29) sin m as que resolver el sistema

Rx = c

(33)

El problema se ha reducido a calcular una matriz ortogonal Q, es decir, Q

T

Q = I, y una matriz

triangular superior R tales que

A = QR (34)

Denicion 6.1 La descomposici on (34) anterior se denomina factorizaci on QR

Evidentemente, cualquier sistema compatible puede ser resuelto utilizando esta factorizaci on.

Basta calcular, primero, la factorizaci on QR y, despues, resolver el sistema triangular Rx = Q

T

b.

Una interpretaci on de la factorizaci on QR es la siguiente: Sea m n y sean a

1

, a

2

, ..., a

n

y

q

1

, q

2

, ..., q

m

las columnas de A y de Q, respectivamente; puesto que

[a

1

a

2

. . . a

n

] = [q

1

q

2

. . . q

m

]

_

_

R

11

R

12

. . . R

1n

0 R

22

. . .

.

.

.

.

.

.

.

.

.

.

.

.

0 . . . 0 R

nn

.

.

.

.

.

.

0 . . . . . . 0

_

_

,

se obtiene que

a

k

=

k

j

R

jk

q

j

, k = 1, 2, ..., n

En otras palabras, cada columna de A puede ser escrita como combinacion lineal de las k primeras

columnas de Q. Esto es lo que se obtena al construir una familia ortogonal a partir de una familia

libre por medio del metodo de Gram-Schmidt; sin embargo, este proceso es muy inestable (entra na

realizar productos escalares), por lo que para obtener la factorizaci on QR se suelen utilizar las

rotaciones de Givens y las reexiones de Householder.

6.1 Rotaciones de Givens.

Dada una matriz A

0

= A IR

(m,n)

, se busca una secuencia de matrices ortogonales

1

,

2

, ...,

k

IR

(m,m)

tales que la matriz A

i

=

i

A

i1

tenga mas elementos nulos debajo de la diagonal que A

i1

,

para i = 1, 2, ..., k, de forma que la matriz R = A

k

nal es triangular superior; por lo tanto, se

tiene:

k

k1

...

1

A = R

y, en consecuencia, A = QR, siendo Q =

T

1

,

T

2

, ...,

T

k

ortogonal y R triangular superior.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 16

Denicion 6.2 Se denomina matriz de Givens,

[p,q]

, a cualquier matriz ortogonal que coincide

con la matriz unidad, salvo en cuatro elementos, que se construyen en la forma siguiente:

[p,q]

pp

=

[p,q]

qq

= cos ,

[p,q]

pq

= sen ,

[p,q]

qp

= sen ,

para alg un [, ]

Por ejemplo, si m = 4,

[2,4]

=

_

_

1 0 0 0

0 cos 0 sen

0 0 1 0

0 sen 0 cos

_

_

,

[4,2]

=

_

_

1 0 0 0

0 cos 0 sen

0 0 1 0

0 sen 0 cos

_

_

Teorema 6.3 Dada una matriz A IR

mn

, para cada 1 p < q m, i {p, q} y 1 j n,

existe un [, ] tal que (

[p,q]

A)

i j

= 0. Adem as, todas las las de A permanecen sin cambios,

excepto la p-esima y la q-esima que resultan combinaciones lineales de las antiguas las p-esima y

q-esima

Demostr.: Basta denir la matriz

[p,q]

adecuadamente. Sea i = q; si A

pj

= A

qj

= 0, cualquier

valor de sirve; caso contrario, basta escoger:

cos =

A

pj

_

A

2

pj

+ A

2

qj

, sen =

A

qj

_

A

2

pj

+ A

2

qj

Sea i = p, basta escoger:

cos =

A

qj

_

A

2

pj

+ A

2

qj

, sen =

A

pj

_

A

2

pj

+ A

2

qj

.

Ejemplo 6.4 Sea

A =

_

_

_

1 1 1

1 1.0001 2

1 2 2

_

_

_,

basta tomar

Q

1

=

[2,1]

, Q

2

=

[3,1]

, Q

3

=

[3,2]

,

para obtener la factorizaci on A = QR, siendo

Q = Q

T

1

Q

T

2

Q

T

3

=

_

_

_

0.577 0.408 0.707

0.577 0.408 0.707

0.577 0.816 0.0000707

_

_

_, R =

_

_

_

1.732 2.309 0.577

0 0.816 2.041

0 0 2.121

_

_

_,

Observese que en muchas ocasiones, por ejemplo, al resolver un sistema de ecuaciones, lo que

se necesita es el resultado de multiplicar Qb, no la matriz Q; por ello, se suele obtener el resultado

multiplicando el vector b por las matrices Q

j

sucesivas.

Coste computacional

Como para la factorizaci on QR se necesitan menos de mn rotaciones y cada una de ellas reeemplaza

dos las por sus combinaciones lineales, resulta un coste total del orden O(mn

2

).

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 17

6.2 Reexiones de Householder

Una matriz de la forma

H = I 2uu

T

donde u

T

u = 1 (35)

tiene las siguientes propiedades:

H dene una reexi on en el hiperplano {x|u

T

x = 0}, ya que H x = x2u(2u

T

x) y H x+x u

H es simetrica

H es ortogonal, ya que H

T

H = (I 2uu

T

)

T

(I 2uu

T

) = I 4uu

T

+ 4uu

T

uu

T

= I.

Mediante el siguiente algoritmo se puede conseguir transformar la matriz A en otra triangular

superior haciendo ceros en todos los elementos por debajo de la diagonal de cada columna mediante

premultiplicaci on por una matriz de Householder.

Algoritmo

En una primera etapa, se busca una matriz H

1

= I 2u

1

u

T

1

(u

1

IR

m

, y u

T

1

u

1

= 1) tal que

H

1

A =

_

_

_

_

_

_

1

. . .

0 . . .

.

.

.

.

.

.

.

.

.

0 . . .

_

_

_

_

_

_

(36)

Si A

1

es la primera columna de A, se debe cumplir que H

1

A

1

=

1

e

1

= (, 0, ..., 0)

T

, luego:

|

1

| = ||H

1

A

1

||

2

= ||A

1

||

2

. Por denici on de H

1

, debe ser

H

1

A

1

= A

1

2u

1

u

T

1

A

1

=

1

e

1

Como la expresion u

T

1

A

1

es un escalar, resulta que

u

1

= C v

1

, donde v

1

= A

1

1

e

1

(37)

y la constante C se determina de forma que ||u

1

||

2

= 1. Como todava queda la libertad de elegir

el signo de

1

, este se escoge en la forma

1

= (sign a

11

) ||A

1

||

2

(38)

para evitar una sustracci on mal condicionada en el c alculo de v

1

= A

1

1

e

1

Para calcular la matriz H

1

A tengase en cuenta que

H

1

A = A2u

1

u

T

1

A = A v

1

(v

T

1

A), donde =

2

v

T

1

v

1

(39)

Este factor puede ser calculado en la forma siguiente

1

=

v

T

1

v

1

2

=

1

2

(A

T

1

A

1

2a

11

+

2

1

) =

1

(a

11

1

). (40)

En la segunda etapa, se aplica el mismo procedimiento a la submatriz de (36) de tipo (m1)

(n 1); lo cual proporciona un vector u

2

IR

m1

y una matriz de Householder

H

2

= I 2 u

2

u

T

2

.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 18

Escribiendo u

2

= (0, u

2

)

T

y multiplicando (36) por H

2

= I 2 u

2

u

T

2

, se obtiene

H

2

H

1

A = H

2

_

_

_

_

_

_

1

. . .

0

.

.

. C

0

_

_

_

_

_

_

=

_

_

_

_

_

_

1

. . .

0

.

.

.

H

2

C

0

_

_

_

_

_

_

=

_

_

_

_

_

_

_

_

_

1

. . .

0

2

. . .

0 0

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

0 0 . . .

_

_

_

_

_

_

_

_

_

Este proceso se debe continuar n etapas (n 1, si m = n) para obtener la matriz triangular

H

n

... H

2

H

1

A = R =

_

R

0

_

y la matriz ortogonal Q

T

= H

n

... H

2

H

1

.

Notese que a la hora de construir un programa para este algoritmo, no es necesario calcular

explicitamente las matrices H

i

, ni la matriz Q, es suciente retener, ademas de R, los valores de

i

(o

i

) y los vectores v

i

, los cuales contienen toda la informaci on necesaria.

Coste computacional

La primera etapa exige el calculo de

1

mediante la f ormula (38), lo que signican m operaciones,

el calculo de 2/v

t

1

v

1

mediante (40) requiere 3 operaciones y el calculo de H

1

A por la f ormula (39)

necesita (n 1) 2 m operaciones. Esta etapa requiere, pues, unas 2 mn operaciones. Para la

factorizacion QR completase necesitaran:

si m = n, 2 (n

2

+ (n 1)

2

+ ... + 1) 2 n

3

/3 operaciones

si m >> n, 2 m(n + (n 1) + ... + 1) mn

2

operaciones

Puede verse que el coste computacional de la factorizacion QR es aproximadamente el doble

que la factorizaci on LU.

Si las columnas de A son casi linealmente dependientes, la resolucion del sistema (29) mediante

factorizacion QR es preferible a la utilizaci on de las ecuaciones normales.

Ejemplo 6.5 Sea el sistema denido por

A =

_

_

_

1 1

0

0

_

_

_, b =

_

_

_

1

0

0

_

_

_

donde es una peque na constante (por ejemplo,

2

< eps).

Calculando de forma exacta

A

T

A =

_

1 +

2

1

1 1 +

2

_

, A

T

b =

_

1

1

_

y la solucion resulta

x

1

= x

2

=

1

2 +

2

=

1

2

+O(

2

).

Trabajando en coma otante, el

2

desaparece, con lo que el problema se convierte en uno singular

que no tiene soluci on.

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 19

Aplicando el algoritmo de Householder (despreciando

2

), se obtiene:

1

= 1, v

1

= (2, , 0)

T

,

... y, nalmente,

R =

_

_

_

1 1

0

2

0 0

_

_

_, Q

T

b =

_

_

_

1

/

2

/

2

_

_

_;

la resoluci on del sistema (33) da una buena aproximaci on de la soluci on.

Veamoslo resuelto con Matlab en doble precisi on, para = 0.001

alf=-sqrt(1+0.000001)

-1.00000049999988

v=a(1:3,1)-alf*[1;0;0]

2.00000049999988

0.00100000000000

0

bet=1/alf/(alf-a(1,1))

0.49999962500031

hab= ab - bet*v*(v*ab)

-1.00000049999988 -0.99999950000038 -0.99999950000038

0 -0.00099999950000 -0.00099999950000

0 0.00100000000000 0

alf=+sqrt(0.0009999995*0.0009999995+0.001*0.001)

0.00141421320882

v=[0;hab(2:3,2)]-alf*[0;1;0]

0

-0.00241421270882

0.00100000000000

bet=1/alf/(alf-hab(2,2))

2.928933955901685e+05

hab= hab - bet*v*(v*hab)

-1.00000049999988 -0.99999950000038 -0.99999950000038

0 0.00141421320882 0.00070710625086

0 -0.00000000000000 -0.00070710660441

x2=hab(2,3)/hab(2,2)

0.49999975000013

x1= (hab(1,3)-hab(1,2)*x2)/hab(1,1)

0.49999975000012

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 20

7 Condicionamiento y renamiento iterativo

Sabemos que el condicionamiento inuye en la calidad de la soluci on de un problema cualquiera.

En particular, en el problema de hallar la soluci on de un sistema lineal nos encontramos con que

al comparar el valor exacto del termino independiente de un sistema con el calculado puede haber

discrepancias. En concreto, deniendo el vector residual r en la forma

r =

b b,

en donde

b es el valor calculado, resulta:

Teorema 7.1 Si A es una matriz regular, se verica:

1) x x r A

1

2)

x x

x

A A

1

r

b

Demostr.: Como r =

b b = A x Ax = A( x x), resulta

x x = A

1

r r A

1

Por otro lado, como Ax = b, x

b

A

, luego de la desigualdad anterior resulta

x x

x

r A

1

x

A

1

A r

b

De acuerdo con la denici on 3.3, podemos dar la siguiente

Denicion 7.2 Se denomina n umero de condici on de una matriz al n umero

(A) = A A

1

Propiedad 7.3 1) (A) 1

2) (A) = (A)

3) (A

1

) = (A)

4) Si Q es ortogonal, (Q) = 1

Si (A) es peque no, se dice que la matriz A esta bien condicionada, si es grande que A esta mal

condiconada.

Como para encontrar el n umero de condici on de una matriz hace falta conocer la matriz inversa,

tarea bastante costosa, se puede buscar una acotacion o una estimacion del mismo. Lo primero

se consigue, por ejemplo, tomando varios vectores y, calculando el valor d = Ay y acotando

inferiormente la norma A

1

mediante

y

d

A

1

.

Las cotas obtenidas de esta forma suelen ser muy bajas, por ello conviene encontrar una esti-

macion mejor.

Para encontrar una estimacion del n umero de condici on, se resuelve el sistema Ax = b por

eliminaci on gaussiana utilizando aritmetica de p dgitos, obteniendo la soluci on x; a continuaci on,

se resuelve tambien con p dgitos el sistema Ay = r (que es inmediato, ya que se tienen en memoria

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 21

las operaciones de la eliminacion anterior) obteniendo el vector y; nalmente, se usa la desigualdad

de Forsythe y Moler siguiente

r 10

p

A x

para realizar la siguiente estimacion:

y A

1

r A

1

10

p

A x,

lo que permite estimar el n umero de condici on por la siguiente

(A)

y

x

10

p

Este procedimiento proporciona buenas estimaciones del n umero de condici on (cf. Burden y Faires).

En el siguiente teorema veremos la relacion entre las perturbaciones de los elementos del sistema

y el n umero de condici on de la matriz de coecientes.

Suponiendo que la matriz A del sistema

Ax = b

es regular, el sistema perturbado se puede escribir en la forma

(A + A) (x + x) = b + b (41)

Propiedad 7.4 Si

A A

1

< 1,

la matriz de coecientes A + A del sistema perturbado es regular

Demostr.:

A + A = A(I + A

1

A)

Como A es regular, existe A

1

. La matriz I+A

1

A, como sabemos, sera regular si A

1

A < 1,

para lo cual es suciente que A A

1

< 1.

Teorema 7.5 En la situaci on mencionada, se verica la siguiente acotaci on:

x

x

K(A)

1 K(A)

A

A

(

A

A

+

b

b

)

Demostr.: De la ecuacion (41 ) se obtiene:

x + x = (A + A)

1

(b + b) = (A + A)

1

Ax + (A + A)

1

b

Luego:

x = (A + A)

1

(A + A) x + (A + A)

1

Ax + (A + A)

1

b = (A + A)

1

(b Ax)

Tomando normas y aplicando un resultado conocido:

x A

1

(I + A

1

A)

1

b Ax A

1

1

1 A

1

A

(b + |A x)

Y, nalmente, como x es solucion del problema no perturbado, es decir, A x b, resulta el

enunciado .

M. Palacios 1.II.2 Sistemas lineales: metodos directos. 22

Corolario 7.6 Si A = 0, entonces

x

x

K(A)

b

b

Corolario 7.7 Si

A

A

y

b

b

, entonces

x

x

2

K(A)

1 K(A)

= 2 K(A)

1

1

, si = A A

1

En consecuencia, errores peque nos en b pueden producir resultados nefastos en la soluci on x.

7.0.1 Renamiento iterativo o correccion residual

En el caso de que la matriz de coecientes este mal condicionada se puede utilizar el siguiente

algoritmo de renamiento iterativo o correcci on residual para mejorar el resultado. Tengase cuidado

porque si el problema no est a mal condiconado este procedimiento encarece el coste computacional

y no mejora sensiblemente la solucion.

Algoritmo.

Encontrar la soluci on x del sistema Ax = b

Encontrar el vector residual r = A x b con doble precis on

Encontrar la soluci on e de la ecuacion Ae = r

Construir la nueva aproximaci on de la soluci on x = x + e

También podría gustarte

- Apuntes de Probabilidad (Unidad 2)Documento13 páginasApuntes de Probabilidad (Unidad 2)CrizAlexAún no hay calificaciones

- Bma01 Ep 2019 1Documento7 páginasBma01 Ep 2019 1yari santos ptAún no hay calificaciones

- Potenciación Y Sus Propiedades ¿Qué Es La Potenciación?: Área de Formación Año/Sección Docente: Contenido Número de GuíaDocumento7 páginasPotenciación Y Sus Propiedades ¿Qué Es La Potenciación?: Área de Formación Año/Sección Docente: Contenido Número de GuíaMaria AuxiliadoraAún no hay calificaciones

- U2 ModelosdeProgramacionLineal-1Documento29 páginasU2 ModelosdeProgramacionLineal-1Rosario RiosAún no hay calificaciones

- Mapas ConceptualesDocumento4 páginasMapas ConceptualesAndrés TipánAún no hay calificaciones

- Propiedades de La Transformada de LaplaceDocumento6 páginasPropiedades de La Transformada de LaplaceJuanjo Ajata VelazcoAún no hay calificaciones

- PLAN DE CLASE 5 Caso I, II Y III DE FACTORIZACIONDocumento6 páginasPLAN DE CLASE 5 Caso I, II Y III DE FACTORIZACIONJhon Garcia100% (1)

- Medidas de Dispersion, As, AP.Documento24 páginasMedidas de Dispersion, As, AP.Rossa TasaycoAún no hay calificaciones

- Formulas Parcial 1Documento1 páginaFormulas Parcial 1maria alejandra pertuz martinezAún no hay calificaciones

- Informe Sobre Potenciacion y Radicacion ADocumento22 páginasInforme Sobre Potenciacion y Radicacion Aysbecarmen100% (1)

- 158-Tarea 3Documento7 páginas158-Tarea 3JAIME GOMEZAún no hay calificaciones

- Cap2 PDFDocumento39 páginasCap2 PDFAnonymous ouYeTgkw7Aún no hay calificaciones

- S04.s1 - Cinemática IIDocumento20 páginasS04.s1 - Cinemática IIDany Sandoval NimaAún no hay calificaciones

- Algebra Lineal Matriz InversaDocumento3 páginasAlgebra Lineal Matriz InversaAnonymous mfiG2SAún no hay calificaciones

- Sistemas de Ecuaciones y MatricesDocumento5 páginasSistemas de Ecuaciones y MatricesVIANYSAún no hay calificaciones

- Mates-Calculo - Derivadas e IntegralesDocumento387 páginasMates-Calculo - Derivadas e IntegralesMichael Yonatan VargasAún no hay calificaciones

- Clase 1 - PolinomiosDocumento13 páginasClase 1 - PolinomiosBrad Mero'sAún no hay calificaciones

- Corrección Primer Parcial de Cálculo III (Ecuaciones Diferenciales), Lunes 8 de Abril de 2019Documento6 páginasCorrección Primer Parcial de Cálculo III (Ecuaciones Diferenciales), Lunes 8 de Abril de 2019Hans Müller Santa Cruz83% (6)

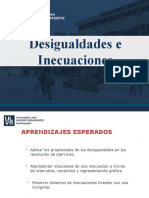

- 1 Desigualdades - e - InecuacionesDocumento34 páginas1 Desigualdades - e - InecuacionesHector CemeteryAún no hay calificaciones

- Espacio HilbertDocumento2 páginasEspacio HilbertEdwardSullaMendietaAún no hay calificaciones

- UNPRG Límites y Continuidad 2Documento15 páginasUNPRG Límites y Continuidad 2Ivan Chapoñan CarranzaAún no hay calificaciones

- Notas de Clase para Precálculo Organized PDFDocumento6 páginasNotas de Clase para Precálculo Organized PDFChristian MoraAún no hay calificaciones

- Identidades TrigonométricasDocumento18 páginasIdentidades TrigonométricasRodrigo ToasaAún no hay calificaciones

- Plantilla Protocolo IndividualDocumento2 páginasPlantilla Protocolo Individualneguith fuertesAún no hay calificaciones

- C3 - Unidad 3Documento12 páginasC3 - Unidad 3GuillesebAún no hay calificaciones

- Interpolacion de NewtonDocumento15 páginasInterpolacion de NewtonBrayanFernandoBermudezCasellesAún no hay calificaciones

- Actividad 1. Límites y Continuidad - Sección 1.1Documento3 páginasActividad 1. Límites y Continuidad - Sección 1.1Jorge MedinaAún no hay calificaciones

- Bioestadistica IndividualDocumento9 páginasBioestadistica IndividualPaola RojasAún no hay calificaciones

- Oscialdor Armonico CuanticoDocumento6 páginasOscialdor Armonico CuanticoAlexis Tepale LunaAún no hay calificaciones

- Plan de Clase n6Documento7 páginasPlan de Clase n6marcosmnjb marcosmnjbAún no hay calificaciones