Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Cadenas de Markov

Cargado por

Prince NoxDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Cadenas de Markov

Cargado por

Prince NoxCopyright:

Formatos disponibles

I.

Cadenas de Markov

Las Cadenas de Markov tienen la propiedad particular de que las

probabilidades que describen la forma en que el proceso evolucionara

en el futuro dependen solo del estado actual en que se encuentra el

proceso y por lo tanto, son independientes de los eventos que

ocurrieron en el pasado. Muchos procesos se ajustan a esta

descripcin por lo que las cadenas de Markov constituyen una clase

de modelo probabilstico de gran importancia.

Las Cadenas de Markov proporcionan las bases para el estudio de los

modelos de decisin, ya que existe una amplia gama de aplicaciones

de las cadenas de Markov. La lista continua de manera indefinida,

pero por el momento veremos una descripcin de los procesos

estocsticos en general y de las cadenas de Markov en particular.

1.1 Procesos Estocsticos

Se definen como una coleccin indexada de variables aleatorias (X,),

donde el ndice t toma valores de un conjunto T dado. Con

frecuenta T se considera el conjunto de enteros no negativos

mientras que X, representa una caracterstica de inters cuantificable

en el tiempo t.

Por ejemplo:

X, puede representar los niveles de invetario al final de la

semana t.

Los procesos estocsticos son de inters para describir el

comporatmiento de un sistema en operacin durante algunos

periodos.

1.2 Dwdwdwa

También podría gustarte

- Sistema financiero peruano y Compartamos FinancieraDocumento112 páginasSistema financiero peruano y Compartamos FinancieraPrince NoxAún no hay calificaciones

- Sistema financiero peruano y Compartamos FinancieraDocumento112 páginasSistema financiero peruano y Compartamos FinancieraPrince NoxAún no hay calificaciones

- El Engano Como Conducta Tipica en La Defraudacion Tributaria-2Documento11 páginasEl Engano Como Conducta Tipica en La Defraudacion Tributaria-2Prince NoxAún no hay calificaciones

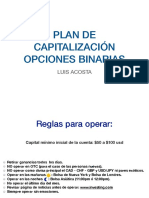

- Plan de Capitalización BinariasDocumento5 páginasPlan de Capitalización BinariasPrince NoxAún no hay calificaciones

- Universidad Privada de TacnaDocumento43 páginasUniversidad Privada de TacnaPrince NoxAún no hay calificaciones

- Proyectos PrivadosDocumento1 páginaProyectos PrivadosPrince NoxAún no hay calificaciones

- Niveles SocioeconómicosDocumento2 páginasNiveles SocioeconómicosPrince NoxAún no hay calificaciones

- Contrato Tarjeta de CréditoDocumento10 páginasContrato Tarjeta de Créditoxlkhristo14Aún no hay calificaciones

- AceitesDocumento2 páginasAceitesPrince NoxAún no hay calificaciones

- INCOTERMSDocumento34 páginasINCOTERMSGustavo Olazabal MendozaAún no hay calificaciones

- Estructura para TrabajosDocumento1 páginaEstructura para TrabajosPrince NoxAún no hay calificaciones

- MKT Internacional Clasificación Nomenclatura ArancelariaDocumento11 páginasMKT Internacional Clasificación Nomenclatura ArancelariaPrince NoxAún no hay calificaciones

- Ingenieria Del Proyecto CompletoDocumento12 páginasIngenieria Del Proyecto CompletoPrince NoxAún no hay calificaciones

- Necesidades Taller Adulto MayorDocumento2 páginasNecesidades Taller Adulto MayorPrince NoxAún no hay calificaciones

- Analisis Porter BeterDocumento12 páginasAnalisis Porter BeterPrince NoxAún no hay calificaciones

- Taller TesisDocumento3 páginasTaller TesisPrince NoxAún no hay calificaciones

- Ejercicios BCGDocumento4 páginasEjercicios BCGPrince Nox0% (1)

- Trabajo TobitDocumento19 páginasTrabajo TobitPrince NoxAún no hay calificaciones

- Ies Tacna 2013Documento158 páginasIes Tacna 2013Prince NoxAún no hay calificaciones

- IncotermsDocumento19 páginasIncotermsPrince NoxAún no hay calificaciones

- Pruebas Resueltas MKTDocumento4 páginasPruebas Resueltas MKTPrince NoxAún no hay calificaciones

- Proveedores IDocumento2 páginasProveedores IPrince NoxAún no hay calificaciones

- Ies Tacna 2013Documento158 páginasIes Tacna 2013Prince NoxAún no hay calificaciones

- Embutido de AlpacaDocumento2 páginasEmbutido de AlpacaPrince NoxAún no hay calificaciones

- Embutido de AlpacaDocumento2 páginasEmbutido de AlpacaPrince NoxAún no hay calificaciones

- MUSHNADocumento7 páginasMUSHNABrian Fernando PaucarAún no hay calificaciones

- RESPOSTERIAouchinDocumento4 páginasRESPOSTERIAouchinPrince NoxAún no hay calificaciones

- Caso Baylon - Despido Nulo-Criterios de Procedibilidad de Las Demandas de Amparo en Materia LaboralDocumento17 páginasCaso Baylon - Despido Nulo-Criterios de Procedibilidad de Las Demandas de Amparo en Materia LaboralWilmer Porras FloresAún no hay calificaciones

- Trabajo Derecho FINALDocumento30 páginasTrabajo Derecho FINALPrince NoxAún no hay calificaciones