Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Algoritmos Geneticos23

Algoritmos Geneticos23

Cargado por

Luis Edo Garcia JaimesTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Algoritmos Geneticos23

Algoritmos Geneticos23

Cargado por

Luis Edo Garcia JaimesCopyright:

Formatos disponibles

ANALISIS DE ALGORITMOS EVOLUTIVOS PARA REDES NEURONALES

Joaqun A. Pacheco, Alberto Aragn Dpto. Economa Aplicada Universidad de BURGOS.

Resumen:

En este trabajo se proponen y analizan diferentes tcnicas Metaheursticas, as como otras tcnicas, en el aprendizaje de Redes Neuronales Artificiales, ms concretamente en el conocido Perceptrn Multicapa. Concretamente se disean una serie de algoritmos evolutivos: Algoritmos Memticos y basados en Scatter Search. Con estos mtodos se intentan ofrecer alternativas a otros mtodos, como los basados en el gradiante, (como el de la Propagacin hacia atrs), ya que han mostrado ser inconsistentes debido al carcter local de su bsqueda. El objetivo de nuestro trabajo es disear estrategias de aprendizaje que den valores bajos en los errores cuadrtricos rpidamente de forma que puedan ser usados como mtodos on-line. A su vez estas estrategias deben ser consistentes y mostrar su capacidad de mejora cuando se disponga de mayor tiempo de computacin.

Palabras clave: Redes Neuronales, Algoritmos Memticos, Scatter Search.

Aprendizaje, Metaheursticos

Evolutivos,

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

1.- EL PROBLEMA

El perceptrn Multicapa es un modelo de red neuronal consistente en varias capas de neuronas: una de entrada, 1 o ms capas ocultas y una de salida. La informacin se transmite de cada nodo a los nodos de la capa siguiente, desde la entrada a la salida. La informacin que sale de un nodo a cada nodo de la capa siguiente se pondera por un peso wji; de forma que la informacin total que llega a cada nodo j de la nueva capa es iwjixi , siendo x el valor de salida de los nodos i de la capa anterior. Este valor de i entrada, para los nodos de las capas ocultas y la de salida, se transforma mediante una funcin de transferencia f produciendo la salida del nodo j, xj = f(iwjixi). Las funciones de transferencia ms usadas son la sigmoide y= 1 , y la identidad o lineal y = x. 1 + ex

Para el aprendizaje de una red se usan vectores de entrenamiento, consistentes cada uno en un vector de entrada y un vector de salida. Para un determinados vector de pesos w y cada vector de entrenamiento, la red lee el vector de entrada y se compara la salida producida por la red (salida observada) con la con los valores del vector de salida (salida esperada). El problema consiste en determinar los valores de los pesos wji de forma que el Error Cuadrtico Medio (E) en el conjunto de vectores de entrenamiento y valores de salida sea mnima. A continuacin se muestra la notacin formal y la formulacin del problema. Sean n y K los nmeros de nodos respectivamente de las capas de entrada y salida; sea S el conjunto de vectores de entrenamiento; (x, y) S x indica el vector de entrada e y el de salida; sea = g(x, w) la salida producida en la red con el vector de pesos w cuando lee el vector de entrada x. Entonces el problema se pude formular como minimizar E(w) siendo 1 E ( w) = S

( x, y )S k =1

yk ) .

2

Los algoritmos basados en el gradiante como el mtodo de Propagacin hacia atrs (Werbos, (1.974)) bsicamente usan la siguiente frmula de actualizacin de pesos w ji = w ji E ; donde es conocido como parmetro de aprendizaje. w ji

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

Precisamente una de las limitaciones de estos mtodos, es la convergencia a ptimos locales no globales y su dependencia de la solucin inicial. Adems no son aplicables a modelos de redes que usan funciones de transferencia no derivables. Se van a proponer algoritmos de aprendizaje basadas en la estrategia denominada Scatter Search y se va a disear un Algoritmo Memtico. Se har una comparacin con otros mtodos propuestos recientemente por otros autores. Nuestro objetivo es el diseos de estrategias que obtengan pesos con buenos resultados de E en el conjunto de aprendizaje. Tambin interesa que los pesos obtenidos den valores bajos de E cuando se presenta otro conjunto de vectores diferentes. (Para verificar que la red haya aprendido y no memorizado). Un segundo objetivo es que estas estrategias sean rpidas, para que puedan ser usadas, como mtodos on-line. Por otra parte, sin dejar de lado la rapidez, interesa que las estrategias obtenidas muestren su capacidad de mejorar cuando se disponga de mayor tiempo de computacin. Finalmente, es interesante que los mtodos sean consistentes y robustos, para que la dependencia de las soluciones iniciales (o poblaciones) sea la menor posible.

2.- ARQUITECTURA DE RED NEURONAL

La redes neuronales con las que se va a trabajar va a estar compuesto por una capa oculta. Se denota a n el nmero de neuronas de la capa de entrada (que lgicamente coincide con el nmero de variables de entrada), y m el nmero de neuronas de la capa oculta. Vamos a considerar una neurona en la capa de salida (i.e. una sola variable de salida a predecir, K = 1). Cada neurona de la capa oculta, as como la de salida tiene un elemento bias (que funciona como constante). Una representacin esquemtica viene dada por la siguiente figura

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

wn +1 1 2 w1 w2 wj wn wm( n+2)+1 w(k-1)(n+1)+ j wk (n+1) k w(k-1)(n +1)+n n w(m-1)(n +1)+n wm (n+1) m wm (n +1)+m wm (n+1)+ k o 1 wm( n+1)+1

Figura 1.- Arquitectura de red neuronal usada (tomada de Laguna y Mart, (2.000))

En este trabajo se van a utilizar 6 neuronas en la capa oculta. Los pesos estn numerados secuencialmente, de forma que los pesos que enlazan la capa de entrada con la primera neurona de la oculta son del w1 al wn y su trmino bias wn+1 . De esta forma la informacin de entrada de cada neurona k, k = 1, ...,m, de la capa oculta, viene dada por wk ( n +1) + w( k 1 )( n +1) + j x j y la neurona de salida recibe la

j =1 m n

siguiente informacin wm ( n + 2 )+1 + wm ( n +1) +k a k donde ak son las salidas de las neuronas

k =1

ocultas. En nuestro caso se usa la sigmoide como funcin de transferencia para la capa oculta y la identidad para la neurona de salida. Un aspecto importante: en este trabajo, los mtodos de aprendizaje propuestos solo se aplican a los pesos asociados con la capa oculta, i.e. de w1 a wm(n+1); los pesos de la neurona de salida se obtienen por mnimos cuadrados ordinarios cada vez que se generan los de la capa oculta. Cuando se genera un nuevo vector de pesos en la capa oculta, automticamente se deben calcular los de la capa de salida y evaluar el valor E (solucin al problema de mnimos cuadrados). Esta idea ha sido sugerida en Sexton y otros, (1.998), y (1.999), y Laguna y Mart, (2.000).

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

Finalmente se ha de indicar que para el entrenamiento los valores de cada una de las variables de los vectores de entrada son escalados entre 1,0 (el menor valor en el conjunto de entrenamiento) y +1,0 (el mayor); y los valores de la salida son escalados entre 0,8 y +0,8.

3.- MEJORA POR ENTORNOS

Sea w una solucin cualquiera de componentes wl y radio un nmero real suficientemente pequeo, se definen los siguientes procedimientos

Procedimiento Perturbar_Peso(w, radio, w) Generar una solucin w cuyos componentes wl toman valores aleatorios en el intervalo (wl - radio wl + radio)

As mismo sea w0 una solucin cualquiera el parmetros entero n_vecinos, el parmetro real radio se define el siguiente

Procedimiento Mejor_Vecino(w0 , radio, n_vecinos, w) min = Para i = 1 hasta n_vecinos hacer Perturbar_Peso(w0 , radio, w) Si E(w) < min hacer: w = w y min = E(w) Un anlisis sobre el efecto de los diferentes valores de radio en este ltimo procedimiento indica que valores altos dan lugar a descensos rpidos, y valores bajos dan lugar a descensos ms lentos y profundos. Por tanto se va a intentar disear una estrategia que combine rpidez con profundidad (calidad de la solucin final). Sean w una solucin inicial, los parmetros reales radio0 (valor inicial de radio) y alfa, y los parmetros entero n_vecinos y max_int, esta estrategia puede describirse en seudocdigo como sigue

Procedimiento Mejora_Radio_Variable(w, radio0, alfa, n_vecinos, max_int)

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

Hacer radio = radio0, n_int = 0; Repetir Ejecutar Mejor_Vecino(w , radio, n_vecinos, w) Si E(w) < E(w) hacer: w = w, radio = radio*alfa y n_int = 0 en caso contrario hacer: radio = radio/alfa y n_int = n_int+1 hasta n_int = max_int 4.- SCATTER SEARCH

Scatter Seach es una estrategia poblacional-evolutiva caracterizada bsicamente por el uso de un Conjunto de Referencia (RefSet) de soluciones. Dicho conjunto esta formado por dos Subconjuntos: Subconjunto de Calidad (RefSet1) formado por las mejores soluciones y Subconjunto de Diversidad (RefSet2) formado por las soluciones ms diferentes con el resto de RefSet. En cada paso o ciclo se generan nuevas soluciones a partir de las del Conjunto de Referencia que actualizan ste. Un tutorial sobre Scatter Search se pueden encontrar en Glover, (1.998). Se ha diseado una versin esttica y una versin dinmica de esta estrategia para este problema. La descripcin en seudocdigo de forma muy general es la siguiente

Procedimiento Scatter Search Esttico Generar un conjunto inicial de soluciones aleatorias Mejorarlas mediante un mtodo preestablecido A partir de estas soluciones obtener RefSet inicial Repetir Construir subconjuntos de 2 y 3 elementos de RefSet Obtener nuevas soluciones a partir de dichos subconjuntos Aplicar a las nuevas soluciones el mtodo de mejora Actualizar RefSet con las nuevas soluciones, (una vez obtenidas todas) Hasta que RefSet se estabilice (i.e. no haya nuevas soluciones)

(1)

El Procedimiento Scatter Search Dinmico es similar cambiando la sentencia (1) por la siguiente Cada vez que se obtiene una nueva solucin actualizar RefSet (1)

En otras palabras: en la versin esttica se generan las nuevas soluciones y, una vez obtenidas, con las ya existentes en RefSet se actualiza este; en la dinmica, en el momento que se genera una nueva solucin se comprueba si mejora el valor de la

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

funcin objetivo E de alguna de las existentes en RefSet1 o aporta ms diversidad que alguna de RefSet2, en cuyo caso se incorpora sin esperar a generar las dems. Como en los tutoriales de Scatter Search, antes mencionados, en la versin dinmica para evitar realizar operaciones (generar nuevas soluciones, mejorarlas y actualizar el conjunto de referencia) con subconjuntos con la misma composicin de elementos que en ciclos anteriores, se propone slo considerar los subconjuntos que contienen algn elemento nuevo, (es decir generado en el ciclo o iteracin anterior). Para medir la diversidad de una solucin w respecto RefSet se usa la siguiente funcin dmin(w) = min {d(w, w) / w R}; donde d(w, w) = i |wi- wi|. Los subconjuntos de 2 elementos se forman con todos los pares de RefSet, y los de 3 elementos se forman al aadir a todos los subconjuntos de 2 el mejor elemento de RefSet1 no presente. La forma de generar nuevos soluciones est inspirada en Kelly y otros (1.996), y se ilustra en la siguiente grfica

nw3 W2 nw1 W1 nw2 nw1 W1

W2 nw2

nw0 W3 nw3

Figura 2.- Formas de generar nuevas soluciones con subconjuntos de 2 y 3

Se define TamRef = |RefSet|, anlogamente TamRef1 = |RefSet1| y TamRef2 = |RefSet2|. Inicialmente se toma TamRef1 = TamRef2 = 5.

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

Adems de estas dos estrategias Esttica y Dinmica analizaremos una variante de la Dinmica que aparece propuesta en los tutoriales antes mencionados. Esta variante consiste en, una vez obtenido el conjunto de referencia inicial, considerar RefSet1 = RefSet, y RefSet2 = (i.e. TamRef1 = 10, en este caso y TamRef2 = 0). En otras palabras, solo se consideraran incorporaciones a RefSet que mejoren la funcin objetivo de alguno de sus elementos, y no se incorporarn soluciones por diversidad. En nuestro caso el procedimiento de mejora es la ejecucin del procedimiento Mejora_Radio_Variable max_int= 2. inicialmente con radio = 0.1, alfa = 1, n_vecinos = 1,

5.- ALGORITMO MEMTICO

Los Algoritmos Memticos tambin son procedimientos basados en poblacin y se han mostrado como tcnicas ms rpidas que los tradicionales Algoritmos Genticos para algunos tipos de problemas. Bsicamente combinan procedimientos de bsqueda local con operadores de cruce o mutacin, por lo que algunos investigadores les han visto como Algoritmos Genticos Hbridos o Algoritmos Genticos Paralelos (PGAs) o mtodos de Bsqueda Local Gentica. El mtodo, descrito originalmente en el trabajo de Moscato, (1.989), est ganando amplia aceptacin en particular en los bien conocidos problemas de optimizacin combinatoria donde grandes ejemplos se han solventado ptimamente y donde otros metaheursticos han fallado. En nuestro caso el Algoritmo Memtico que se propone sigue un esquema muy similar al algoritmo Gentico propuesto en Sexton y otros, (1999). En este caso, se aaden procedimientos de mejora cada vez que se genera una nueva solucin. En seudocdigo puede escribirse de la forma siguiente:

Procedimiento Memtico Generar una poblacin inicial de soluciones Mejorarlas mediante un mtodo preestablecido Repetir - Seleccionar aleatoriamente un subconjunto de elementos (par) de la poblacin con una probabilidad proporcional a su bondad

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

Cruce Reproduccin: Emparejar o cruzar estas soluciones (Padres) para dar lugar a nuevos soluciones (Hijos). De cada pareja de Padres se han den generar una nueva pareja de hijos. - Mutacin: Los soluciones hijas pueden cambiar con una probabilidad pequea alguno de sus elementos (genes) - Aplicar el procedimiento de mejora a los hijos - Sustituir las peores soluciones de la poblacin por las nuevas soluciones hijas - Actualizar el parmetro de mutacin hasta conseguir algn criterio de parada Como en la estrategias Scatter Search del apartado 3 el procedimiento de mejora es Mejora_Radio_Variable con los mismos parmetros. La bondad de cada elemento de la poblacin va a venir dado por el valor de la funcin objetivo E correspondiente. La probabilidad de seleccin de una determinada solucin w va a ser proporcional a Emax E(w) ; donde Emax es el mximo valor de los de E(w) en los elementos de la poblacin de esa poblacin. El operador de cruce sigue el esquema one-point crossing, es decir, sean w y w dos soluciones padres seleccionadas, w = (w1 , w2 , ... wm(n+1)) y w = (w1 , w2 , ... wm(n+1)) se genera aleatoriamente un punto de cruce entre 1 y m(n+1)-1, (pto_cruce), de forma que las nuevas soluciones hijas se definen como w* = (w1 , w2 , ..., wpto_cruce , wpto_cruce+1 , ..., wm(n+1 )) w** = (w1 , w2 , ..., wpto_cruce , wpto_cruce+1 , ..., wm(n+1)). Los pesos de cada nueva solucin hija pueden cambiar o mutar con una pequea probabilidad, p_mut. Para decidir si un determinado peso cambia se genera un valor aleatorio uniformemente en (0,1); si este valor es menor que p_mut se realiza el cambio. Este consiste en asignarle un nuevo punto aleatoriamente en el intervalo (-5, +5), (Mutacin). Este proceso de mutacin tiene por objeto dar diversidad al proceso y evitar que este se encajone en una regin entorno a un mnimo local.

Un aspecto relativamente novedoso es que el valor del parmetro p_mut no es fijo, sino que vara entre dos valores prefijados p_mut_min y p_mut_max. Los valores p_mut_min y p_mut_max representan probabilidades mnimas y mximas de mutacin. El objeto de esta estrategia es Intensificar de la bsqueda en una regin cuando se

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

encuentran mejores soluciones, y favorecer la bsqueda en otras regiones cuando no es as. En este trabajo se utilizan los siguientes valores: p_mut_min = 0,05, p_mut_max = 01. Adems de ello el nmero de elementos de la poblacin ( _pob) es 100, y el n nmero de padres seleccionados (n_sel) es 20.

6.- RESULTADOS COMPUTACIONALES

Para contrastar la bondad de los mtodos propuestos, y compararlos por otros propuestos recientemente se han realizado una serie de pruebas que se describen a continuacin. En primer lugar se han considerado las siguientes funciones: 1 y = x1 + x2 2 y = x1 x 2 3 y =

x1 1+ x2

0.2 y t 5 3 4 y = x12 + x 2 5 y = x13 + x 2 6 y t = y t 1 + 10.5 0.1y t 1 . 2 1 + ( y )10 t 5

Para cada una de las 5 primeras funciones se considera un conjunto de entrenamiento con 50 vectores: Los valores de entrada son enteros generados en [-100, +100] para x 1 y en [-10, +10] para x 2 ; el valor de la salida y viene dado por la funcin correspondiente. En los 5 casos se utilizan los mismos vectores de entrada. Para la sexta funcin se usan 5 nodos o variables de entrada, aunque claramente solo hacen falta 3. Los vectores de entrenamiento en este caso han sido generados recursivamente a partir de los valores (1,6, 0, 0, 0, 0). Estas funciones han sido propuestas en Sexton y otros, (1.998) y (1.999), y utilizadas tambin en Laguna y Mart, (2.000). En este trabajo se usa, as mismo, el mismo conjunto de vectores de entrada que en estas referencias 1 . Los mtodos que se van a utilizar en las pruebas son los siguientes: Scatter Search Esttico (ES), Scatter Search Dinmico (DI), Variante de Scatter Search Dinmico (VD) y Algoritmo Memtico (ME).

Se comparan con los siguientes: Propagacin hacia atrs usado en Neural Works Profession II/Plus de NeuralWare (BP); Algoritmo Bsqueda Tab (TS) de Sexton y otros (1.998); Algoritmo Temple Simulado (SA), Algoritmo Gentico (GA) estos 2 de Sexton y otros (1.999), Adaptacin de Scatter Search de Laguna y Mart, (2.000)

Nuestro agradecimiento a los profesores R.Mart y M.Laguna por facilitarnos esta informacin

10

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

A continuacin se muestra una tabla, tomada de Laguna y Mart, (2.000), en la que se muestran los mejores resultados obtenidos por los algoritmos BP, SA, GA, TS y SS, para cada uno de estos problemas: Funcin 1 2 3 4 5 6 BP SA GA TS SS 5.23E-01 1.05E-05 4.16E-07 1.42E-06 8.93E-08 1.10E+01 3.17E-02 1.27E-02 8.38E-02 5.97E-03 8.43E+00 1.76E+00 1.82E-01 2.45E-01 2.96E-03 1.88E+02 4.84E-01 4.09E-02 4.32E-01 2.31E+00 8.57E+03 4.39E-01 3.06E-03 2.56E-02 2.76E+02 1.55E-01 1.02E-02 2.53E-02 5.35E-02 3.34E-03 Tabla 2.- Mejores resultados obtenidos por BP, SA, GA, TS y SS

Segn, Laguna y Mart, 2.000, Sexton, (1.998) y (1.999), SS limita el nmero de evaluaciones a 50000; BP realiza 4,18 millones, SA entre 112501 y 12,6 millones, GA 100000, y TS entre 190021 y 928061. Por tanto estos, los mtodos ms rpidos son SS y GS. Adems SS obtiene los mejores resultados para las funciones 1, 2, 3 y 6 y GA para las funciones 4 y 5. A continuacin se muestra una tabla, en la que se muestran los mejores resultados obtenidos por nuestros algoritmos con 100000 evaluaciones DI VD ES ME Funcin 1 1,65E-09 8,84E-09 5,60E-12 6,32E-13 2 1,95E-03 1,45E-04 1,01E-04 6,56E-05 3 1,58E-03 1,01E-03 3,00E-03 4,62E-04 4 5,28E-02 2,48E-02 5,27E-03 1,93E-03 5 8,39E-01 2,71E-01 7,33E-01 4,58E-03 6 2,04E-04 5,69E-05 2,47E-04 1,51E-03 Tabla 3.- Mejores resultados finales obtenidos por DI, VD, ES y ME

Posteriormente, se ha generado un conjunto test de 150 vectores donde los valores de entrada se generan con la misma distribucin que los del conjunto de entrenamiento. Este conjunto test se va a usar para examinar la capacidad de la red de predecir valores de y cuando los valores de x no estn en el conjunto de entrenamiento. A continuacin se muestra un cuadro, tomado de Laguna y Mart, (2.000), en la que se sealan los resultados conseguidos en el conjunto test por los pesos obtenidos por los algoritmos BP, SA, GA, TS y SS Funcin 1 2 3 BP 1.76E+00 9.11E+01 2.34E+01 SA 1.56E-05 1.85E-01 5.53E+00 GA 3.68E-07 1.72E-02 1.38E+00 TS 2.79E-06 1.96E-01 1.69E+00 SS 9.37E-07 2.13E-01 1.55E+00

11

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

4 4.31E+02 2.73E+00 4.53E-02 1.15E+00 9.26E+00 5 5.28E+04 1.36E+00 2.02E-02 5.68E-02 5.98E+03 6 1.95E-01 2.69E-01 3.40E-02 6.75E-02 2.90E-01 Tabla 4.- Mejor valor de E obtenido por BP, SA, GA, TS y SS para el conjunto test Finalmente se muestra una tabla con los mejores errores cuadrticos medios para el conjunto test, de los pesos finales obtenidos por los algoritmos propuestos en este trabajo Funcin DI VD ES ME 1 2,34E-09 9,26E-09 2,93E-11 1,13E-11 2 5,72E-03 6,26E-04 2,20E-04 1,45E-04 3 1,38E-01 7,59E-02 1,75E-01 9,89E-02 4 2,24E-01 4,11E-02 1,38E-02 6,52E-03 5 1,72E+00 7,08E-01 1,25E+00 2,43E-02 6 1,16E-01 1,02E-01 1,08E-01 8,64E-02 Tabla 5.- Mejor valor de E obtenido por BP, SA, GA, TS y SS para el conjunto test

8.- CONCLUSIONES FINALES

En este trabajo se han propuesto 4 mtodos evolutivos que tienen en comn la aplicacin de alguno de los procedimientos de mejora anterior cada vez que se generaba una nueva solucin. Los tres primeros de estos mtodos (DI, VD y ES) propuestos estaban basados en la estrategia Metaheurstica denominada Scatter Search, mientras que el cuarto es un Algoritmo Memtico, (ME). Estos 4 mtodos han destacado por lo siguiente: 1) Generan buenas soluciones en poco tiempo; 2) Superan, en casi todos los casos, a los resultados obtenidos por otras estrategias propuestas en trabajos recientes; 3) Mantienen la capacidad de obtener buenos resultados cuando se les presentan valores de entrada diferentes a los utilizados en el aprendizaje.

9.- BIBLIOGRAFA

GLOVER, F. (1998) A Template for Scatter Search and Path Relinking, in Artificial Evolution, Lecture Notes in Computer Science 1363, J.-K. Hao, E. Lutton, E. Ronald, M. Schoenauer and D. Snyers (Eds.), Springer-Verlag, pp. 13-54.

12

Joaqun A. Pacheco y Alberto Aragn

Anlisis de algoritmos evolutivos

KELLY, J. P., B. RANGASWAMY, and J. XU, (1.996): A Scatter Search-Based Learning Algorithm for Neural Networks Training. Journal of Heuristics, vol.2, n.2, 129-146. LAGUNA, M. y R. MART (2.000) Neural Network Prediction in a System for Optimizing Simulations. Aceptada para su publicacin en IEEE Transactions. SEXTON, R. S., B. ALIDAEE, R. E. DORSEY and J. D. JOHNSON (1998) Global Optimization for Artificial Neural Networks: A Tabu search Application, European Journal of Operational Research, vol. 106, pp. 570-584. SEXTON, R. S., R. E. DORSEY and J. D. JOHNSON (1999) Optimization of Neural Networks: A Comparative Analysis of the Genetic Algorithm and Simulated Annealing, European Journal of Operational Research, vol. 114, pp. 589-601. WERBOS, P. (1.974): Beyond Regression: New tools for prediction and analisys in the behavioral sciences. Tesis Doctoral. Harvard. Cambridge.

13

También podría gustarte

- Tablas de Transformada ZDocumento4 páginasTablas de Transformada ZLuis Edo Garcia Jaimes100% (5)

- 43-85 Primeras-Sesiones Seth para-UnPlanDivino-netDocumento70 páginas43-85 Primeras-Sesiones Seth para-UnPlanDivino-netTanya G. Alonso100% (1)

- LevitacionDocumento18 páginasLevitacionLuis Edo Garcia JaimesAún no hay calificaciones

- Control Con Respuesta InversaDocumento6 páginasControl Con Respuesta InversaLuis Edo Garcia JaimesAún no hay calificaciones

- Algoritmos Geneticos27Documento16 páginasAlgoritmos Geneticos27Luis Edo Garcia JaimesAún no hay calificaciones

- Trabajo 07Documento110 páginasTrabajo 07Luis Edo Garcia JaimesAún no hay calificaciones

- PS-4313 Respuesta Temporal PDFDocumento55 páginasPS-4313 Respuesta Temporal PDFLuis Edo Garcia JaimesAún no hay calificaciones

- Control Fraccionario PDFDocumento110 páginasControl Fraccionario PDFLuis Edo Garcia JaimesAún no hay calificaciones

- Control Autoclave Por Realaimentacion Del Estado PDFDocumento6 páginasControl Autoclave Por Realaimentacion Del Estado PDFLuis Edo Garcia JaimesAún no hay calificaciones

- Sistemas de Estructura VariableDocumento205 páginasSistemas de Estructura VariableLuis Edo Garcia JaimesAún no hay calificaciones

- Control de Una Autoclave Por Ganancia Programable PDFDocumento17 páginasControl de Una Autoclave Por Ganancia Programable PDFLuis Edo Garcia JaimesAún no hay calificaciones

- Control de Una Autoclave Por Ganancia ProgramableDocumento17 páginasControl de Una Autoclave Por Ganancia ProgramableLuis Edo Garcia JaimesAún no hay calificaciones

- Catalogo ArduinoDocumento16 páginasCatalogo ArduinoLuis Edo Garcia Jaimes100% (2)

- Articulo Control en Modo DeslizanteDocumento9 páginasArticulo Control en Modo DeslizanteLuis Edo Garcia JaimesAún no hay calificaciones

- Tema 1 Metodologia 2023Documento47 páginasTema 1 Metodologia 2023steven tardilloAún no hay calificaciones

- Dibujo Tecnico 1Documento245 páginasDibujo Tecnico 1alfredoAún no hay calificaciones

- Estructura de Capital y RiesgoDocumento48 páginasEstructura de Capital y RiesgoMateo RodriguezAún no hay calificaciones

- Taller 03-GRUPO 5Documento8 páginasTaller 03-GRUPO 5Gerardo RojasAún no hay calificaciones

- Medidor Multifuncion EMH LZQJXCDocumento2 páginasMedidor Multifuncion EMH LZQJXCMirko Carlotto TriveñoAún no hay calificaciones

- PC3 Sic Junior DominguezDocumento5 páginasPC3 Sic Junior DominguezJUNIOR DOMINGUEZ MARQUEZAún no hay calificaciones

- Lecture - Principle of (XPS)Documento67 páginasLecture - Principle of (XPS)pela210Aún no hay calificaciones

- CERO - Progresión AritméticaDocumento1 páginaCERO - Progresión AritméticaRosa BaezAún no hay calificaciones

- Filósofos de La Edad Antigua y Moderna $15Documento6 páginasFilósofos de La Edad Antigua y Moderna $15Nacho PioquintoAún no hay calificaciones

- Semana 1-Sesión 2-Arq. Del Computador - Jean SuyoDocumento50 páginasSemana 1-Sesión 2-Arq. Del Computador - Jean SuyoSebastianAún no hay calificaciones

- Catálogo 2021Documento10 páginasCatálogo 2021Brow BrungAún no hay calificaciones

- WORDDocumento13 páginasWORDMERY DOMINGUEZAún no hay calificaciones

- FINAL CATALOGO DE PARTES TVS 100 SPORT KLS ELS OCT 2022 - CompressedDocumento81 páginasFINAL CATALOGO DE PARTES TVS 100 SPORT KLS ELS OCT 2022 - Compressedjulian canoAún no hay calificaciones

- Sesion 15 - Hardware de DesarrolloDocumento25 páginasSesion 15 - Hardware de DesarrolloŠaúl ÇønðøríAún no hay calificaciones

- MODELOdeNEGOCIOS - MAPA EMPATIA-CANVAS-CREA-CURVAdeVALOR PDFDocumento98 páginasMODELOdeNEGOCIOS - MAPA EMPATIA-CANVAS-CREA-CURVAdeVALOR PDFFrancisco Javier Robles CuitinoAún no hay calificaciones

- Banco DinamométricoDocumento5 páginasBanco DinamométricojosueAún no hay calificaciones

- Formato Entrega Trabajo Colaborativo - Unidad 1 Fase 1 - Trabajo Estructura de La Materia y Nomenclatura - Grupo XXXDocumento13 páginasFormato Entrega Trabajo Colaborativo - Unidad 1 Fase 1 - Trabajo Estructura de La Materia y Nomenclatura - Grupo XXXEdinson Padilla PajaroAún no hay calificaciones

- Lectura Básica Sobre El AguaDocumento4 páginasLectura Básica Sobre El AguaNicolas ChaconAún no hay calificaciones

- De Que Esta Hecho Un Telefono CellularDocumento11 páginasDe Que Esta Hecho Un Telefono Cellularhchinchilla_10% (1)

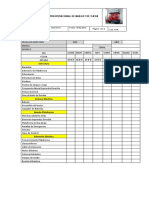

- Preoperacional de Man Lift de TijeraDocumento2 páginasPreoperacional de Man Lift de TijeraConstrucivil Arl SASAún no hay calificaciones

- Algoritmo de La Raiz CuadradaDocumento10 páginasAlgoritmo de La Raiz CuadradaDiego Daniel Burbano ValderramaAún no hay calificaciones

- Grados de LibertadDocumento15 páginasGrados de LibertadEmigdioAún no hay calificaciones

- Instrumentos TopograficosDocumento13 páginasInstrumentos TopograficosERIKA ISABEL ORTIZ ASIPALIAún no hay calificaciones

- Guía Práctica de Matlab - CDDocumento8 páginasGuía Práctica de Matlab - CDjaimeAún no hay calificaciones

- Modulo IV La DerivadaDocumento27 páginasModulo IV La DerivadaANGELICA MORENO GONZALEZAún no hay calificaciones

- UDA 1 - Tensión Compresion y Cortantesolucion de 1 PDFDocumento59 páginasUDA 1 - Tensión Compresion y Cortantesolucion de 1 PDFJulio JpAún no hay calificaciones

- Ulcera IsquiaticaDocumento2 páginasUlcera IsquiaticaDANIEL ALEJANDROAún no hay calificaciones

- Estructura Valle MarcolliDocumento2 páginasEstructura Valle Marcollidaniel_r_fischer0% (1)

- Prac9 2011Documento3 páginasPrac9 2011CHRISTIAN ARTURO RAMOS LOZANOAún no hay calificaciones