Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Analisis Biometrico

Cargado por

Amaury Comas MontañoTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Analisis Biometrico

Cargado por

Amaury Comas MontañoCopyright:

Formatos disponibles

SAP 209 – 95

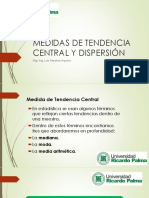

Medidas de tendencia central. Las medidas de tendencia central son medidas

estadísticas que pretenden resumir en un solo valor a un conjunto de valores.

Representan un centro en torno al cual se encuentra ubicado el conjunto de los

datos. A veces, tratamos con una gran cantidad información. Variables que

presentan muchos datos y muy dispares. Datos con muchos decimales, de

diferente signo o longitud. En estos casos, siempre es preferible calcular

medidas que nos ofrezcan información resumida sobre dicha variable. Las

medidas de tendencia central más utilizadas son: media, mediana y moda.

Las medidas de posición central son una ayuda en forma de resumen pero no

son categóricas. Como resumen pueden darnos una información de lo que, en

promedio, cabría esperar. Pero no siempre son precisas.

Para analizar mejor estas medidas, es recomendable combinar las medidas de

tendencia central con medidas de dispersión. Las medidas de dispersión

tampoco son infalibles, pero nos ofrecen información sobre la variabilidad de

una determinada variable.

Media: La media aritmética, también llamada promedio o simplemente media

es el valor característico de una serie de datos cuantitativos, objeto de estudio,

se fundamenta en el concepto de la esperanza matemática o valor esperado,

se obtiene de la suma de todos sus valores dividida entre el total de datos.

Existen muchos tipos de media. La elección de cada tipo de media tiene que

ver, principalmente con el tipo de dato sobre el que se calcula.

Cuando se calcula la media de un conjunto de números, se suman todos los

números y luego se divide por la cantidad de datos del conjunto.

Ejemplo:

Encuentre la media del conjunto {2, 5, 5, 6, 8, 8, 9, 11}.

Hay 8 números en el conjunto. Súmelos, y luego divida entre 8.

= 6.75

Así, la media es 6.75.

Mediana: Es el valor que divide al conjunto ordenado de datos, en dos

subconjuntos con la misma cantidad de elementos. La mitad de los datos son

menores que la mediana y la otra mitad son mayores. Se simboliza como ¨Me¨

Para calcular la mediana de un conjunto de números, primero hay que

organizar todos los números en orden descendente, luego vamos eliminando

los números de ambos extremos hasta obtener el valor central que sería la

mediana. En caso de tener dos números en el centro, sumamos ambos valores

y al resultado lo dividimos entre 2, encontrando así la Mediana

Ejemplo:

Encuentre la mediana del conjunto {3, 10, 36, 255, 79, 24, 5, 8}.

Primero, arregle los números en orden ascendente.

{3, 5, 8, 10, 24, 36, 79, 255}

Hay 8 números en el conjunto -- un número par. Así, encuentre el promedio de

los dos números medios, 10 y 24.

(10 + 24)/2 = 34/2 = 17

Así, la mediana es 17

Moda: Es el valor que más se repite en un conjunto de datos. No tiene fórmula

en sí mismo. Lo que habría que realizar es la suma de las repeticiones de cada

valor. A diferencia de la media aritmética, la moda no se ve afectada por la

ocurrencia de los valores extremos.

Ejemplo:

Encuentre la moda del conjunto {2, 3, 5, 5, 7, 9, 9, 9, 10, 12}.

El 2, 3, 7, 10 y 12 aparecen una vez cada uno.

El 5 aparece dos veces y el 9 aparece tres veces.

Así, el 9 es la moda.

Media Geométrica (MG) Es una medida de tendencia central que puede

utilizarse para mostrar los cambios porcentuales en una serie de números

positivos. Como tal, tiene una amplia aplicación en los negocios y en la

economía, debido a que con frecuencia se está interesado en establecer el

cambio porcentual en las ventas en el producto interno bruto o en cualquier

serie económica. Se define como la raíz índice n del producto de n términos.

La media geométrica se utiliza con más frecuencia para calcular la tasa de

crecimiento porcentual promedio de algunas series dadas, a través del tiempo.

Ventajas

Considera todos los valores de la distribución

Es menos sensible que la media aritmética a los valores extremos.

Desventajas

Es de significado estadístico menos intuitivo que la media aritmética.

Su cálculo es más difícil.

Si un valor es igual a cero, entonces la media geométrica se anula o no

queda determinada.

Solo es relevante la media geométrica si todos los números son positivos.

Como hemos visto, si uno de ellos es 0, entonces el resultado es 0. Si hubiera

un número negativo (o una cantidad impar de ellos) entonces la media

geométrica sería o bien negativa, o bien inexistente en los números reales.

En muchas ocasiones se utiliza su trasformación en el manejo estadístico de

variables con distribución no normal.

La media geométrica es relevante cuando varias cantidades son multiplicadas

para producir un total.

Medidas de Dispersión

Son parámetros que miden la separación de los datos de una distribución

respecto a su media, de esta manera nos pueden informar sobre cuanto se

alejan del centro los valores de la distribución. Parámetros estadísticos que

indican como se alejan los datos respecto de la media aritmética. Sirven como

indicador de la variabilidad de los datos. Las medidas de dispersión más

utilizadas son el rango, la desviación estándar y la varianza.

Rango: Es la diferencia entre el límite superior del ultimo intervalo y el límite

inferior del primer intervalo. Esta medida nos indica la diferencia entre el valor

máximo y el mínimo de una población o muestra estadística

Para calcular el rango de una muestra o población estadística utilizaremos la

siguiente fórmula:

R = Máxx – Mínx

Donde

R es el rango.

Máx es el valor máximo de la muestra o población.

Mín es el valor mínimo de la muestra o población estadística.

x es la variable sobre la que se pretende calcular esta medida.

Ejemplo: Para la muestra (8, 7, 6, 9, 4, 5), el dato menor es 4 y el dato mayor

es 9. Sus valores se encuentran en un rango de: Rango = (9 – 4) = 5

Para esto, no es necesario ordenar los valores de mayor a menor o viceversa.

Si sabemos cuál son los números con mayor y menor valor, tan sólo tendremos

que aplicar la fórmula.

Varianza: La varianza de una muestra o de un conjunto de valores, es la

sumatoria de las desviaciones al cuadrado con respecto al promedio o a la

media, todo esto dividido entre el número total de observaciones menos 1.

De manera muy general se puede decir que la varianza es la desviación

estándar elevada al cuadrado.

En las áreas de economía y finanzas, la varianza se interpreta como el riesgo

de que el rendimiento realizado en algún procedimiento sea distinto al

rendimiento esperado. Por lo general cuando se espera un mayor rendimiento,

el riesgo a su vez es mayor.

Supongamos que se tienen los ingresos anuales de cinco empresas distintas,

pertenecientes a un mismo empresario, los cuales son:

Empresa A: 2.500 $

Empresa B: 1.800 $

Empresa C: 2.300 $

Empresa D: 3.000 $

Empresa E: 2.700 $

Entonces calculamos la media de los ingresos, simplemente sumando cada

cifra y dividiéndolo entre el número total de empresas, lo cual da como

resultado: 2.460$.

Ahora simplemente terminamos de calcular la varianza con la formula ya

expuesta, lo cual da como resultado una varianza de 162.400 $ 2.

Al sacar la raíz cuadrada a este resultado obtenemos la desviación estándar,

siendo ésta 403 $ de diferencia entre los ingresos de las cinco empresas.

Desviación estándar: La desviación estándar o desviación típica es una

medida que ofrece información sobre la dispersión media de una variable. La

desviación estándar es siempre mayor o igual que cero.

Se calcula como la media aritmética de los valores absolutos de las

desviaciones respecto a la media. Al principio es confuso pero es más fácil

siguiendo una serie de pasos

Paso 1: calcular la media.

Paso 2: calcular el cuadrado de la distancia a la media para cada dato.

Paso 3: sumar los valores que resultaron del paso 2.

Paso 4: dividir entre el número de datos.

Paso 5: sacar la raíz cuadrada.

Percentiles: En estadística, un percentil es una medida de posición no central,

al igual que los cuartiles, los deciles o los quintiles.

Todas esas medidas nos informan de la posición de un valor respecto a los

demás. Si un valor está en el cuartil 3 (Q3), indicaría que tres cuartas partes de

los datos son igual o menores que ese valor.

El concepto de percentil es igual pero referido a porcentajes. Si un valor tiene

un percentil 55 (P55), el 55% de los demás datos tendrán un valor igual o más

pequeño.

Imaginemos que la altura de un grupo de personas es el conjunto de datos a

estudiar. Si una altura de 1.75 m está en el P80 (percentil 80), quiere decir que

el 80% de las personas del grupo mide 1.75 o menos.

Para calcular los percentiles, primero hay que ordenar los datos de forma

ascendente.

Una vez ordenados, se resta 0.5 a la posición que ocupa el dato del que

queremos calcular el percentil. Después dividimos entre el número total de

datos y multiplicamos por 100.

Ejemplo: Tenemos un conjunto de 47 datos con diferente valores que van

desde 51 hasta 99. Si queremos saber el percentil al que pertenece el valor 63,

primero ordenamos de menor a mayor y miramos la posición que ocupa e6 63.

Supongamos la posición es 12.

Aplicamos la fórmula:

P = (12 – 0.5) / 47) x 100 = 24.46

Y obtenemos que el 63 está en el percentil 24.46 indica, es decir, que el

24.46% de los datos tienen un valor de 63 o menos. Esto se indica como

P24.46 = 63.

Prevalencia: Es la proporción de individuos de una población que presentan el

evento en un momento, o periodo de tiempo, determinado. Por ejemplo la

prevalencia de diabetes en Madrid en el año 2001 es la proporción de

individuos de esa provincia que en el año 2001 padecían la enfermedad. Se

calcula:

P = N de eventos/ n de individuos totales

Incidencia: es el número de casos nuevos de una enfermedad en una

población determinada y en un periodo determinado.

La frecuencia absoluta: es una medida estadística que nos da información

acerca de la cantidad de veces que se repite un suceso al realizar un número

determinado de experimentos aleatorios. Esta se representa mediante las

letras fi. La letra f se refiere a la palabra frecuencia y la letra i se refiere a la

realización i-ésima del experimento aleatorio.

La frecuencia absoluta es muy utilizada en estadística descriptiva y es útil para

saber acerca de las características de una población y/o muestra. Ésta se

puede utilizar con variables cualitativas o cuantitativas siempre que estas se

puedan ordenar. La frecuencia absoluta se puede utilizar para variables

discretas (las variables se ordenan de menor a mayor) y para variables

continuas (las variables se ordenan de menor a mayor agrupadas por

intervalos). La frecuencia absoluta se utiliza para calcular la frecuencia relativa.

Proporción: es el cociente del número de veces que se presenta un valor o

característica con respecto al total de la muestra de la variable en estudio. Por

ejemplo: en un estudio médico sobre el Alzheimer se examinaron 280 mujeres

y 220 hombres, entonces se puede notar que:

Proporción (mujeres) = 280/500 = 0,56

Proporción (hombres) = 220/500 = 0,44

Es importante aclarar que las proporciones, se relacionan con las frecuencias

relativas simples; su rango, va desde cero hasta uno (ambos inclusive), en

otras palabras, el campo de existencia de las proporciones se encuentra en el

intervalo [0,1] y la sumatoria de las proporciones es igual a uno.

Razón (muestral): es la relación entre dos fenómenos independientes, el rango

es de cero a infinito positivo. Por ejemplo: en un Hospital existen mil pacientes

y un total de cincuenta médicos, por lo cual se tiene una razón de 1000/50=20,

en otras palabras en el Hospital por cada médico existen 20 pacientes.

Índice: Es una medida estadística que tiene como finalidad comparar una

variable o magnitud económica con el tiempo.

Los números índices miden el tamaño o la magnitud de algún objeto en un

punto determinado en el tiempo, como el porcentaje de una base o referencia

en el pasado

Existen varios tipos de índices:

Simples: Son los índices que proporcionan la variación que ha sufrido una

magnitud o concepto entre dos periodos o lugares distintos. Generalmente,

esta comparación se realiza con el valor de un periodo fijo (Periodo base)

Ejemplo:

Si la población estimada en 2012 fie de 8.4 millones de habitantes y la del 2011

fue de 8.2. ¿Cuál fue el índice de crecimiento?

P = 8.4/8.2 * 100 = 102.44

El índice de crecimiento es de 2.44%

Complejos: Generalmente no hay mucho interés en comparar cantidades o

valores individuales, sino que se comparan fenómenos del mundo real donde

intervienen muchas variables. Como consecuencia, la información suministrada

por los índices de diferentes bienes debe ser resumida en un único índice al

que denominamos índice complejo.

La construcción de estos es complicada. Por ejemplo, para elaborar la

evolución del coste de la vida en un país, habría que seleccionar un grupo de

bienes que reflejaran dicho coste, teniendo en cuenta la importancia relativa de

cada uno de estos bienes, decidiendo finalmente la forma de unificar toda la

información para obtener un único índice.

Tasa: es la rapidez de cambio de un fenómeno, se obtiene mediante el

cociente del número de veces que ocurre la situación investigada en un lugar y

lapso de tiempo determinado, entre la población en estudio, multiplicada por

una potencia de 10, su rango es de cero a infinito positivo. Entonces las tasas

se hallan:

Frecuencia de determinado fenómeno en un tiempo específico. 10^n

Población en estudio

Cabe agregar que, las tasas que se refieren a toda la población se

llaman crudas, mientras que las tasas que se refieren solo a una parte de la

población se denominan especificas.

Las tasas más comunes son:

Tasas de mortalidad: riesgo de morir.

Tasas de morbilidad: riesgo de contraer determinada enfermedad.

Tasas de natalidad: miden el crecimiento de las poblaciones.

Tasas de letalidad: miden la gravedad de las enfermedades.

Intervalo de confianza: Un intervalo de confianza es una técnica de

estimación utilizada en inferencia estadística que permite acotar un par o varios

pares de valores, dentro de los cuales se encontrará la estimación

puntual buscada (con una determinada probabilidad).

Un intervalo de confianza nos va a permitir calcular dos valores alrededor de

una media muestral (uno superior y otro inferior). Estos valores van a acotar un

rango dentro del cual, con una determinada probabilidad, se va a localizar el

parámetro poblacional.

Intervalo de confianza = media +- margen de error

Factores de los que depende un intervalo de confianza

El cálculo de un intervalo de confianza depende principalmente de los

siguientes factores:

Tamaño de la muestra seleccionada: Dependiendo de la cantidad de

datos que se hayan utilizado para calcular el valor muestral, este se acercará

más o menos al verdadero parámetro poblacional.

Nivel de confianza: Nos va a informar en qué porcentaje de casos

nuestra estimación acierta. Los niveles habituales son el 95% y el 99%.

Margen de error de nuestra estimación: Este se denomina como alfa

y nos informa de la probabilidad que existe de que el valor poblacional esté

fuera de nuestro intervalo.

Lo estimado en la muestra (media, varianza, diferencia de

medias…): De esto va a depender el estadístico pivote para el cálculo del

intervalo.

Probabilidad

Es la parte de las matemáticas que se encarga del análisis de los fenómenos

aleatorios. Por fenómenos aleatorios entendemos todos aquellos experimentos

que, cuando se repite bajo las mismas condiciones iniciales, el resultado que

se obtiene no siempre es el mismo. El ejemplo más sencillo para entender el

concepto es lanzar una moneda o un dado al aire.

Es una medida de la certidumbre asociada a un suceso o evento futuro y suele

expresarse como un número entre 0 y 1 (o entre 0 % y 100 %).

Una forma tradicional de estimar algunas probabilidades sería obtener la

frecuencia de un acontecimiento determinado mediante la realización de

experimentos aleatorios, de los que se conocen todos los resultados posibles,

bajo condiciones suficientemente estables. Un suceso puede ser improbable

(con probabilidad cercana a 0), probable (probabilidad intermedia) o seguro

(con probabilidad uno).

La probabilidad constituye un importante parámetro en la determinación de las

diversas casualidades obtenidas tras una serie de eventos esperados dentro de

un rango estadístico.

Existen diversas formas como método abstracto, como la teoría Dempster-

Shafer y la teoría de la relatividad numérica, esta última con un alto grado de

aceptación si se toma en cuenta que disminuye considerablemente las

posibilidades hasta un nivel mínimo ya que somete a todas las antiguas reglas

a una simple ley de relatividad.

La probabilidad de un evento se denota con la letra p y se expresa en términos

de una fracción y no en porcentajes, por lo que el valor de p cae entre 0 y 1.

Por otra parte, la probabilidad de que un evento "no ocurra" equivale a 1 menos

el valor de p y se denota con la letra q

Técnicas:

Las Técnicas de conteo son utilizadas en Probabilidad y Estadística para

determinar el número total de resultados.

Principio de multiplicación

Si un evento E puede ocurrir de m formas, e independiente de este evento un

evento F puede ocurrir de n formas, entonces los eventos juntos pueden ocurrir

un total de m x n formas.

Ejemplo: Menú en restaurant

Supongamos que un restaurant ofrece 4 entradas, 5 platos principales y 2

postres. ¿De cuántas formas un cliente puede ordenar una comida?

Respuesta: Se aplica el principio de multiplicación, por lo tanto hay 4 x 5 x 2

formas diferentes de ordenar una comida: 40 formas.

Regla factorial

Una colección de n elementos distintos se pueden acomodar de n! formas

diferentes. Es decir, el primer elemento se puede seleccionar de n maneras

distintas, el segundo de n-1 maneras, y así sucesivamente.

Ejemplo: Mesa de honor

Se requiere acomodar a 8 personas en una mesa de honor y se le solicita que

haga un listado de las diferentes formas de ordenar a las personas. Antes de

aceptar la tarea decide investigar cuántas formas diferentes existen.

Respuesta: Se aplica la regla factorial. Para el primer puesto hay 8 opciones,

para el segundo, 7, para el tercero 6, y así sucesivamente. Entonces hay 8!

Formas de acomodar a las personas: 40320. (No sería sencillo tratar de hacer

la lista completa).

Reglas

La probabilidad de ocurrencia de un evento es siempre igual o mayor a

cero o igual o menor a 1

La suma de todas las probabilidades de un suceso siempre es 1

P (A o B) = P(A) + P(B) Siempre que sean mutuamente excluyentes

Regla general de la adición de probabilidades para eventos no

mutuamente excluyentes. P (A o B) = P(A) + P(B) – P (AyB)

Regla especial de la adición de probabilidades para eventos

mutuamente excluyentes. P (AoB) = P(A) + P(B)

La probabilidad de que ocurra el evento E1 dado que ha ocurrido el

evento E2, es la probabilidad conjunta de ambos eventos, dividido por la

de E2 donde esta última debe ser mayor de cero

La probabilidad conjunta de dos eventos E1 E2, es el producto de la

probabilidad individual de E1 por la probabilidad condicional de E2 dado

que ha ocurrido E1

La probabilidad conjunta de dos eventos E1 y E2 es el producto de la

probabilidad de E1 por la probabilidad de E2

Normalidad estadística

La distribución normal o distribución de Gauss representa la forma en la que se

distribuyen en la naturaleza los diversos valores numéricos de las variables

continuas, como pueden ser estatura, peso, etc.

En estadística y probabilidad se llama distribución normal, distribución de

Gauss o distribución gaussiana , a una de las distribuciones de

probabilidad de variable continua que con más frecuencia aparece en

estadística y en la teoría de probabilidades.

La gráfica de su función de densidad tiene una forma acampanada y es

simétrica respecto de un determinado parámetro estadístico. Esta curva se

conoce como campana de Gauss y es el gráfico de una función gaussiana.2

La importancia de esta distribución radica en que permite modelar numerosos

fenómenos naturales, sociales y psicológicos. Mientras que los mecanismos

que subyacen a gran parte de este tipo de fenómenos son desconocidos, por la

enorme cantidad de variables incontrolables que en ellos intervienen, el uso del

modelo normal puede justificarse asumiendo que cada observación se obtiene

como la suma de unas pocas causas independientes.

De hecho, la estadística descriptiva sólo permite describir un fenómeno, sin

explicación alguna. Para la explicación causal es preciso el diseño

experimental, de ahí que al uso de la estadística en psicología y sociología sea

conocido como método correlacional.

Según el criterio estadístico: La normalidad se basa en la idea de que la

normalidad es aquello que es más probable. Es un criterio matemático basado

en los datos, aquellas conductas más repetidas serán las normales; mientras

que las que apenas se producen serán patológicas o anormales. Tiene una gran

fuerza al suponer un método objetivo de medir la normalidad pero pierde

eficacia cuando existe muchísima variabilidad; y también existe el problema de

definir el umbral porcentual que implica el cambio de anormal a normal.

La distribución normal también aparece en muchas áreas de la propia

estadística. Por ejemplo, la distribución muestral de las medias maestrales es

aproximadamente normal, cuando la distribución de la población de la cual se

extrae la muestra no es normal.4 Además, la distribución normal maximiza

la entropía entre todas las distribuciones con media y varianza conocidas, lo

cual la convierte en la elección natural de la distribución subyacente a una lista

de datos resumidos en términos de media muestral y varianza. La distribución

normal es la más extendida en estadística y muchos test estadísticos están

basados en una "normalidad" más o menos justificada de la variable aleatoria

bajo estudio.

En probabilidad, la distribución normal aparece como el límite de varias

distribuciones de probabilidad continuas y discretas.

Estándares de normalidad: Consiste en el establecimiento de normas a las

que debe ajustarse la información geográfica, los procesos de intercambio de

ésta y la interoperación de los sistemas que deben manejarla.

En el campo de la medicina, conjunto de valores que el médico utiliza para

interpretar los resultados de las pruebas en un paciente. Los valores de

referencia para una prueba determinada se basan en los resultados de la

prueba en el 95% de la población sana. A veces, los pacientes cuyos

resultados están fuera de los valores de referencia pueden estar sanos y

algunos pacientes cuyos resultados están dentro de los valores de referencia

pueden tener un problema de salud. Los valores de referencia de una prueba

pueden ser diferente en distintos grupos de personas (por ejemplo, entre

mujeres y hombres). También se llama intervalo de referencia, límite de

referencia y límite normal.

De la distribución normal se derivan muchos resultados, incluyendo rangos de

percentiles ("percentiles" o "cuantiles"), curvas normales

equivalentes, stanines, z-scores, y T-scores. Además, un número de

procedimientos de estadísticos de comportamiento están basados en la

asunción de que esos resultados están normalmente distribuidos. Por ejemplo,

el test de Student y el análisis de varianza (ANOVA). La gradación de la curva

campana asigna grados relativos basados en una distribución normal de

resultados.

Los valores de referencia (rangos) para sangre, orina, LCR, materia fecal y

otros líquidos (p. ej., ácido gástrico) y paneles utilizados con frecuencia

pueden tener valores de referencia que varían según varios factores, incluidos

las características demográficas de la población sana donde se tomaron las

muestras y los métodos específicos y/o los instrumentos usados para estudiar

estas muestras. Los laboratorios acreditados por el College of American

Pathologists (CAP) deben establecer y/o validar sus propios valores de

referencia al menos 1 vez al año. Por lo tanto, todos los resultados deben

interpretarse según los valores de referencia del laboratorio en el que se

realizó el estudio; el laboratorio debe proporcionar estos valores junto con el

resultado del estudio.

La normalidad es la asunción central de la teoría matemática de errores. De

forma similar en el ajuste de modelos estadístico, un indicador de la bondad del

ajuste es que el error residual (así es como se llaman los errores en esta

circunstancia) sea independiente y normalmente distribuido. La asunción es

que cualquier desviación de la normalidad necesita ser explicada. En ese

sentido, en ambos, ajuste de modelos y teoría de errores, la normalidad es la

única observación que no necesita ser explicada, sino que es esperada. No

obstante, si los datos originales no están normalmente distribuidos (por

ejemplo, si siguen una distribución de Cauchy, entonces los residuos tampoco

estarán normalmente distribuidos. Este hecho es ignorado habitualmente en la

práctica.

Las medidas repetidas de la misma cantidad se espera que cedan el paso a

resultados que están agrupados en torno a un valor particular. Si todas las

fuentes principales de errores se han tomado en cuenta, se asume que el error

que queda debe ser el resultado de un gran número de muy pequeños

y aditivos efectos y, por consiguiente, normal. Las desviaciones de la

normalidad se interpretan como indicaciones de errores sistemáticos que no

han sido tomados en cuenta. Puede debatirse si esta asunción es válida.

También podría gustarte

- Razonamiento cuantitativo, 2ª edición: Notas de claseDe EverandRazonamiento cuantitativo, 2ª edición: Notas de claseCalificación: 5 de 5 estrellas5/5 (1)

- Medidas de Tendencia CentralDocumento5 páginasMedidas de Tendencia CentralVladimir CruzAún no hay calificaciones

- Ejercicios de Promedios Pagina EducativaDocumento4 páginasEjercicios de Promedios Pagina EducativaFranklin Gamboa NajarroAún no hay calificaciones

- Medidas de Tendencia CentralDocumento8 páginasMedidas de Tendencia CentralShiruetto ReikAún no hay calificaciones

- Sumatoria y PropiedadesDocumento12 páginasSumatoria y PropiedadesCamila Blondell100% (2)

- PROMEDIOSDocumento6 páginasPROMEDIOSAnonymous 7za15o067% (3)

- Elementos de estadística para ingeniería: Un curso básicoDe EverandElementos de estadística para ingeniería: Un curso básicoAún no hay calificaciones

- Media GeometricaDocumento10 páginasMedia GeometricaJorge Miniano HuamanchumoAún no hay calificaciones

- Informe (Medidas de Tendencia Central) (Quispe Ticllacuri)Documento10 páginasInforme (Medidas de Tendencia Central) (Quispe Ticllacuri)Jonathan TicllacuriAún no hay calificaciones

- Práctica 3Documento11 páginasPráctica 3Divarny De La Cruz88% (8)

- Estadistica ConceptoDocumento21 páginasEstadistica ConceptoYetzabel Aguirre RodasAún no hay calificaciones

- Medidas centrales y dispersión datosDocumento20 páginasMedidas centrales y dispersión datosMine CruzAún no hay calificaciones

- Media Geometrica y Media ArmonicaDocumento11 páginasMedia Geometrica y Media ArmonicaAlee CruzAún no hay calificaciones

- Escuela de AdministraciónDocumento38 páginasEscuela de AdministraciónMaria gonzalezAún no hay calificaciones

- Semana 1 LabDocumento7 páginasSemana 1 LabJimmy RivasAún no hay calificaciones

- MATEMATICASDocumento9 páginasMATEMATICASduendemendoza666Aún no hay calificaciones

- La estadistica resumenDocumento8 páginasLa estadistica resumenAllan SuárezAún no hay calificaciones

- Las Medidas de Tendencia Central Son Medidas Estadísticas Que Pretenden Resumir en Un Solo Valor A Un Conjunto de ValoresDocumento6 páginasLas Medidas de Tendencia Central Son Medidas Estadísticas Que Pretenden Resumir en Un Solo Valor A Un Conjunto de ValoresEnrique HernandezAún no hay calificaciones

- Estadística - Medidas NuméricasDocumento14 páginasEstadística - Medidas NuméricasDaniel Arturo Escobar PonceAún no hay calificaciones

- Preguntas Teorias de TendenciaDocumento3 páginasPreguntas Teorias de TendenciaRogelio GomezAún no hay calificaciones

- Estaditica EmilioDocumento7 páginasEstaditica EmilioycremAún no hay calificaciones

- Investigacion de EstadisticaDocumento30 páginasInvestigacion de EstadisticaGabriel Fernando Nuñez VillalbaAún no hay calificaciones

- Medidas de tendencia central, posición y variación en VenezuelaDocumento8 páginasMedidas de tendencia central, posición y variación en VenezuelagissellAún no hay calificaciones

- Tarea Investigación Aplicada Estadística DescriptivaDocumento10 páginasTarea Investigación Aplicada Estadística DescriptivaElida elizabeth García lumbrerasAún no hay calificaciones

- TAREA # 4 Medidas de Tendencia Central, Localización y DispersiónDocumento10 páginasTAREA # 4 Medidas de Tendencia Central, Localización y DispersiónCarlos HernandezAún no hay calificaciones

- Series Simples Enero 2024Documento17 páginasSeries Simples Enero 2024jo.santiago.herAún no hay calificaciones

- Métodos EstadísticosDocumento27 páginasMétodos EstadísticosalejandraAún no hay calificaciones

- SumatoriaDocumento15 páginasSumatoriaLuigi Milo ElijahAún no hay calificaciones

- MuestreoDocumento6 páginasMuestreoVainafpsAún no hay calificaciones

- Mediadas de Tendencia Central y PosiciónDocumento18 páginasMediadas de Tendencia Central y PosiciónYENY VILLAVICENCIO QUISPEAún no hay calificaciones

- Medidas centrales y dispersiónDocumento16 páginasMedidas centrales y dispersiónMadelyn ReyesAún no hay calificaciones

- Medidas de Tendencia CentralDocumento6 páginasMedidas de Tendencia CentralJavier Alejandro Lozano GuerreroAún no hay calificaciones

- Unidad 1. Estadística Descriptiva.Documento116 páginasUnidad 1. Estadística Descriptiva.carrilloromanosAún no hay calificaciones

- Estadística Descriptiva - 2-1Documento21 páginasEstadística Descriptiva - 2-1Gabriela GutierrezAún no hay calificaciones

- Tema 4 BioestDocumento43 páginasTema 4 BioestKatty BohorquezAún no hay calificaciones

- Exposición de EstadísticaDocumento15 páginasExposición de EstadísticaCarlosRojasAún no hay calificaciones

- Que Son Las Medidas de Tendencia CentralDocumento11 páginasQue Son Las Medidas de Tendencia CentralMarleny SolizAún no hay calificaciones

- Medidas de EstadisticaDocumento7 páginasMedidas de EstadisticaHairlianys RamosAún no hay calificaciones

- Media Mediana y ModaDocumento11 páginasMedia Mediana y ModaAlbert SotonAún no hay calificaciones

- ESTADISTICASDocumento7 páginasESTADISTICASandrea menaAún no hay calificaciones

- Act.2 Investigación DocumentalDocumento12 páginasAct.2 Investigación DocumentalRocío P AscAún no hay calificaciones

- MEDIADocumento7 páginasMEDIAEvelyn GutiérrezAún no hay calificaciones

- Medidas EstadisticaDocumento7 páginasMedidas EstadisticaYesenia ChinchillaAún no hay calificaciones

- Métodos EstadísticosDocumento15 páginasMétodos EstadísticosMIRIAN LICETH MACEDO TERRONESAún no hay calificaciones

- Analisis Biometrico. InvestigacionDocumento3 páginasAnalisis Biometrico. InvestigacionMariale NenaAún no hay calificaciones

- Medidas de tendencia central para datos no agrupados: media, mediana y modaDocumento5 páginasMedidas de tendencia central para datos no agrupados: media, mediana y modaJakelyn lemaAún no hay calificaciones

- Medidas Numéricas para Datos No Agrupados y Datos AgrupadosDocumento64 páginasMedidas Numéricas para Datos No Agrupados y Datos AgrupadosfaroddriguezAún no hay calificaciones

- Medidas estadísticas centrales y dispersiónDocumento12 páginasMedidas estadísticas centrales y dispersiónGinger JimenezpAún no hay calificaciones

- Media EstadisticaDocumento5 páginasMedia EstadisticaFiorella LlanosAún no hay calificaciones

- Presentación Proyecto de Investigación Minimalista Verde y BeigeDocumento26 páginasPresentación Proyecto de Investigación Minimalista Verde y BeigeFran CumbalAún no hay calificaciones

- INVESTIGACIÓn 202Documento9 páginasINVESTIGACIÓn 202Valeria Gutiérrez De La CruzAún no hay calificaciones

- Estadísticas de La VidaDocumento5 páginasEstadísticas de La VidaRIGEL ANTONIO MU�OZ VALDEZAún no hay calificaciones

- Contabilidad 1Documento2 páginasContabilidad 1johana manobandaAún no hay calificaciones

- República Bolivariana de VenezuelaDocumento14 páginasRepública Bolivariana de VenezuelaFabian Dario ZambranoAún no hay calificaciones

- Estadistica DescriptivaDocumento11 páginasEstadistica DescriptivaOscar SaenzAún no hay calificaciones

- Jesús Varela MOD III MEDIDAS DE TENDENCIA CENTRAL Y DISPERCIONDocumento15 páginasJesús Varela MOD III MEDIDAS DE TENDENCIA CENTRAL Y DISPERCIONAlexander 4678Aún no hay calificaciones

- Resumen EstadisticaDocumento9 páginasResumen EstadisticaCaterina KategoraAún no hay calificaciones

- Actividad 6 - Media, Mediana y Moda InvestigacionDocumento11 páginasActividad 6 - Media, Mediana y Moda InvestigacionCINTHYA CAROLYN PEREZ PECHAún no hay calificaciones

- Estadística Descriptiva y Distribución NormalDocumento7 páginasEstadística Descriptiva y Distribución NormalfonoaudiologiaskyAún no hay calificaciones

- Medidas de Tendencia CentralDocumento3 páginasMedidas de Tendencia CentralJulio SanmartAún no hay calificaciones

- Medidas de Tendencia CentralDocumento7 páginasMedidas de Tendencia CentralMarco MarroquínAún no hay calificaciones

- Representación de DatosDocumento10 páginasRepresentación de DatosWinderlis AriannaAún no hay calificaciones

- MedtencentralDocumento7 páginasMedtencentraleyravaughanAún no hay calificaciones

- AnalisisdedatosDocumento7 páginasAnalisisdedatosViridiana NochebuenaAún no hay calificaciones

- Medidas tendencia dispersión control procesosDocumento35 páginasMedidas tendencia dispersión control procesosCamilo De Jesus PipeAún no hay calificaciones

- Tarea 3 EstadisticaDocumento7 páginasTarea 3 EstadisticaTommy Orrala MAún no hay calificaciones

- Y Ese Motor de Dónde Salió?Documento1 páginaY Ese Motor de Dónde Salió?Amaury Comas MontañoAún no hay calificaciones

- Estudios Sobre Las Mujeres, El Genero y El FeminismoDocumento18 páginasEstudios Sobre Las Mujeres, El Genero y El FeminismoAmaury Comas MontañoAún no hay calificaciones

- Analisís Del Mundo de Sofía.Documento9 páginasAnalisís Del Mundo de Sofía.Amaury Comas Montaño0% (1)

- Diario Tejido CDocumento1 páginaDiario Tejido CAmaury Comas MontañoAún no hay calificaciones

- Ensayo Argumentativo Sobre La Violencia de Genero A Los HombresDocumento2 páginasEnsayo Argumentativo Sobre La Violencia de Genero A Los HombresAmaury Comas Montaño100% (4)

- Asignaciones Especiales TEO 209Documento6 páginasAsignaciones Especiales TEO 209Amaury Comas Montaño100% (1)

- Tejido CartilaginosoDocumento3 páginasTejido CartilaginosoAmaury Comas MontañoAún no hay calificaciones

- Tejido OseoDocumento5 páginasTejido OseoAmaury Comas MontañoAún no hay calificaciones

- Analisis Biometrico. Pregunta EDocumento1 páginaAnalisis Biometrico. Pregunta EAmaury Comas MontañoAún no hay calificaciones

- Estadística comercial: distribuciones de frecuencia, medidas de tendencia centralDocumento28 páginasEstadística comercial: distribuciones de frecuencia, medidas de tendencia centralMisael MonzonAún no hay calificaciones

- Ejemplo de Media Ponderada.Documento11 páginasEjemplo de Media Ponderada.Cinthia SalcedoAún no hay calificaciones

- Media Geométrica, Armónica y CuadráticaDocumento12 páginasMedia Geométrica, Armónica y CuadráticaFabricio VeraAún no hay calificaciones

- Promedios y sus tiposDocumento10 páginasPromedios y sus tiposACADEMIA CIRCULO INGENIOAún no hay calificaciones

- Evaluación de Metodología Extraordinario TM23Documento9 páginasEvaluación de Metodología Extraordinario TM23blanca.rodriguezAún no hay calificaciones

- Media GeométricaDocumento5 páginasMedia GeométricaAlexandra Quispe CarrascoAún no hay calificaciones

- 3.1-Medidas de Tendencial CentralDocumento13 páginas3.1-Medidas de Tendencial CentralDariela Ureña diazAún no hay calificaciones

- Stephanie Gomez 609Documento7 páginasStephanie Gomez 609Phanie GomezAún no hay calificaciones

- Apuntes Unidad 1 y 2 ProbabilidadDocumento9 páginasApuntes Unidad 1 y 2 ProbabilidadTrinidad GonzalezAún no hay calificaciones

- Razones aritméticas y geométricas en matemáticasDocumento28 páginasRazones aritméticas y geométricas en matemáticasFranklin Gamboa NajarroAún no hay calificaciones

- Verificación de Intervalos de Referencia en Las Pruebas de Rutina en El Laboratorio de Hemostasia y Establecimiento de Media PoblacionalDocumento3 páginasVerificación de Intervalos de Referencia en Las Pruebas de Rutina en El Laboratorio de Hemostasia y Establecimiento de Media PoblacionalJose Adán Abdala PalmaAún no hay calificaciones

- Media Armónica y Media GeométricaDocumento14 páginasMedia Armónica y Media GeométricaChabeli Cruzado SuárezAún no hay calificaciones

- Tema 5Documento15 páginasTema 5KlisAún no hay calificaciones

- Medidas de tendencia centralDocumento46 páginasMedidas de tendencia centralAngieCardenasAún no hay calificaciones

- Práctica No.4 Est - 111Documento5 páginasPráctica No.4 Est - 111Nataly Nicole PeñaAún no hay calificaciones

- Sesion 3 Medida de Tendencia Central y DispersionDocumento43 páginasSesion 3 Medida de Tendencia Central y DispersionLUUAún no hay calificaciones

- Proporciones geométricasDocumento12 páginasProporciones geométricasAbdy CastilloAún no hay calificaciones

- Promedios aritméticos, geométricos y armónicosDocumento3 páginasPromedios aritméticos, geométricos y armónicosari100% (1)

- Media Armonica y Media GeometricaDocumento7 páginasMedia Armonica y Media GeometricaTIFANY LIZETH CABRERA VALVERDEAún no hay calificaciones

- Estad Descriptivo Tendencia CentraDocumento22 páginasEstad Descriptivo Tendencia CentraoscvpAún no hay calificaciones

- PromediosDocumento5 páginasPromediosJean FrancoAún no hay calificaciones

- Media GeometricaDocumento3 páginasMedia Geometricajavier0322Aún no hay calificaciones

- RM PromediosDocumento15 páginasRM PromediosRai Sebastian TiburcioAún no hay calificaciones

- 3 Medidas de Tendencia Central Clase YSDocumento14 páginas3 Medidas de Tendencia Central Clase YSFayna StefanicAún no hay calificaciones