Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Entropia-Introduccion. Metodologia de La Investigación

Cargado por

Alexis TibanDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Entropia-Introduccion. Metodologia de La Investigación

Cargado por

Alexis TibanCopyright:

Formatos disponibles

UNIVERSIDAD CENTRAL DEL ECUADOR

FACULTAD DE INGENIERÍA QUÍMICA

METODOLOGÍA DE LA INVESTIGACIÓN

Integrantes:

Armas Maribel

Calvopiña Gisela

Constante Yessenia

Reyes Karen

Tibán Alexis

Joseph Venegas

Docente: Dr. Edward Jiménez

INTRODUCCIÓN

El análisis del desorden y complejidad del universo ha sido la problemática de los científicos para

el entendimiento de los sistemas cuánticos y galácticos. Se han formulado diferentes concepciones

y relaciones de la entropía con otras temáticas. En la naturaleza existe una relación entre entropía

y probabilidad cuando se hace referencia a los posibles estados y microestados de un sistema

molecular, esta relación intrínseca nace cuando su fase se analiza como un proceso que se efectúa

espontáneamente y, por lo tanto, como lo anuncia Clausius, su entropía crece, y al estar

constituido de N partículas, la aleatoriedad crece junto con la entropía [1]. En Base a lo expuesto,

el estado de un sistema está sujeto al comportamiento ordenado o desordenado de sus

constituyentes, esto quiere decir que mientras mayor entropía, mayor será la probabilidad que un

sistema cambie entre estados [2].

En 1870 Ludwing Boltzman propuso una definición de entropía, que permite comprender las

leyes de la termodinámica en términos de las probabilidades, de encontrar un sistema físico en

una superposición de estados, para esto introdujo el término de la máxima entropía en la

distribución de probabilidades asociada al equilibrio termodinámico [3].

El mayor aporte que hizo Boltzman a la Física se refleja en la ecuación: S=k*log W. Donde S es

la entropía de un sistema, k es la constante de Boltzman, W el número de microestados posibles

de sus partículas elementales. En esta breve ecuación se encierra la conexión entre el micromundo

y el macromundo. Una cualidad muy sutil de esta ecuación es el hecho de que puede

simultáneamente disminuir la entropía de un sistema y a la vez crearse estructuras ordenadas [4].

La evolución de los sistemas es inherente al paso del tiempo, siempre serán irreversibles, pero a

su vez, siempre buscarán un equilibrio. La entropía alcanzará un máximo cuando el sistema se

acerque al equilibrio. De este modo, toda entidad, sistema u organización está sujeta a la ley de la

entropía. El conjunto de leyes fundamentales como la de la entropía, hacen posible el nacimiento

y desarrollo, de todas las entidades que existen en el universo.

Schröedinger empezó a considerar cómo es que un ser vivo podía mantenerse organizado dentro

de un universo que, de forma global, se desorganiza [5].

En 1974, Stephen Hawking propuso la existencia de la “Radiación de Hawking” que describe la

radiación de un cuerpo negro, debido a los efectos cuánticos cerca del horizonte de sucesos.

Hawking emplea el concepto de entropía como una variable matemática que describe el

comportamiento de cuerpos negros en función de constantes termodinámicas y cuánticas. De igual

forma; Jacob Bekenstein, predijo que los agujeros negros deben tener una entropía finita, pero

máxima [6].

UNIVERSIDAD CENTRAL DEL ECUADOR

FACULTAD DE INGENIERÍA QUÍMICA

METODOLOGÍA DE LA INVESTIGACIÓN

Maxwell propone la existencia de eventos naturales altamente sensibles a las condiciones externas

impuestas por el medio que hace imposible la predicción de los estados futuros del mismo, sin

embargo, plantea que estando alejado del equilibrio termodinámico puede que un sistema por

cuenta propia llegue a una elección para nosotros de manera enigmática [7].

El concepto de entropía también ha sido utilizado en el campo de la informática, el matemático

estadounidense Claude Shannon propuso que la entropía es una magnitud que mide la información

provista por una fuente de datos en forma de números de dígitos binarios, o bits, necesarios para

codificarlo [8].

BIBLIOGRAFÍA

[1] Una Interpretación Estadística de la Entropía. (1988) (1st ed., p. 3). Quito. Retrieved from

http://repositorio.educacionsuperior.gob.ec/bitstream/28000/141/1/Una%20interpretaci%C3%B

3n%20estad%C3%ADstica%20de%20la%20entrop%C3%ADa.pdf

[2] The Statistical Definition of Entropy and Randomness. (2018). Web.mit.edu. Retrieved 1

May2018, from:http://web.mit.edu/16.unified/www/FALL/thermodynamics/notes/node57.html

[3] Tsallis, C., (2015) Complejidad y la Entropía No- Aditiva. Volumen 26, Numero 3, editorial

real sociedad española de física, España. Recuperado el [01 de mayo del 2018] de:

https://bit.ly/2I6GaRC

[4] Angulo, J. (2016). Física. Madrid: Real Sociedad Española de Física.

[5] Guillermo Mattei. La relación entre la ley de la entropía y el origen de la vida Inevitable vida.

Recuperado de http://users.df.uba.ar/gmattei/EXM56_EntropiaVida.pdf

Entropía, de Esteban Calzetta (2009), INET, Ministerio de Educación de la Nación

[6] Black Holes and Thermodynamics. S.W. Hawking (Caltech & Cambridge U.). 1976.

Published in Phys.Rev. D13 (1976) 191-97, DOI: 10.1103/PhysRevD.13.191

[7] Statistical Mechanics. (2015) Neo-Darwinism and the Prefiguration of the Science of

Complexity.

[8] Alcalá J., (2017/02). Information and entropy. Evolution and Environment, Research

Institute on Human Evolution A.C. Recuperado de:

http://www.iieh.com/informacion/articulos/informacion/informacion-informacion-y-

entropia#Nota3

También podría gustarte

- Ley de Hess InvestigacionDocumento3 páginasLey de Hess Investigacioncarlos enrique diaz lunarAún no hay calificaciones

- FOUCAULT. Vigilar y Castigar. (Fragmento Del Capitulo)Documento8 páginasFOUCAULT. Vigilar y Castigar. (Fragmento Del Capitulo)daniela luppoAún no hay calificaciones

- Determinación Del Momento Dipolar Del Tolueno Mediante La Medi-Ción de Su Constante Dieléctrica y Su Índice de Refracción.Documento5 páginasDeterminación Del Momento Dipolar Del Tolueno Mediante La Medi-Ción de Su Constante Dieléctrica y Su Índice de Refracción.Juan Pablo Martínez NavarroAún no hay calificaciones

- Termodinamica 1Documento38 páginasTermodinamica 1Liduvina RodriguezAún no hay calificaciones

- Diagramas de Propiedades para Cambio de FaseDocumento6 páginasDiagramas de Propiedades para Cambio de FaseLourdes Garcia Nuñez100% (1)

- Mapa Conceptual MetodosDocumento10 páginasMapa Conceptual MetodosGregorio HernandezAún no hay calificaciones

- Redes de BravaisDocumento3 páginasRedes de BravaislorenitaAún no hay calificaciones

- Reporte de Practica ManometroDocumento10 páginasReporte de Practica ManometroDaira MujicaAún no hay calificaciones

- Practica Calificada - GRUPO 03Documento10 páginasPractica Calificada - GRUPO 03Jhonatan choqueAún no hay calificaciones

- Proposiciones Simples y Compuestas (Estructuras Discretas)Documento6 páginasProposiciones Simples y Compuestas (Estructuras Discretas)Mateo MatinesAún no hay calificaciones

- Trabajo Metodos Unidad5Documento32 páginasTrabajo Metodos Unidad5Daniel AlmanzaAún no hay calificaciones

- 5.2 Mecanismo Físico de La EbulliciónDocumento22 páginas5.2 Mecanismo Físico de La EbulliciónDaniel Galindo50% (2)

- Guia de Ejercicios 3 Analisis Numerico P2 2017 PDFDocumento3 páginasGuia de Ejercicios 3 Analisis Numerico P2 2017 PDFmar erazoAún no hay calificaciones

- E .13 España Luna VicenteDocumento7 páginasE .13 España Luna VicentevicenteAún no hay calificaciones

- Comportamiento PVT de Las Sustancias RealesDocumento17 páginasComportamiento PVT de Las Sustancias RealesednajmzAún no hay calificaciones

- Resumen Del Capitulo 3 Termodinámica Grupo N°4Documento7 páginasResumen Del Capitulo 3 Termodinámica Grupo N°4RolexAún no hay calificaciones

- Aputes de SolidifaciónDocumento37 páginasAputes de SolidifaciónCaballero RrzAún no hay calificaciones

- Importancia electroquímicaDocumento3 páginasImportancia electroquímicaBryan Garcia0% (1)

- Principio de Le-Chatelier: efectos de cambios en concentración, presión, volumen y temperaturaDocumento1 páginaPrincipio de Le-Chatelier: efectos de cambios en concentración, presión, volumen y temperaturaRoberto Badillo Tivo100% (1)

- Ciclo Stirling termodinámicoDocumento4 páginasCiclo Stirling termodinámicoAlegria Balderas0% (1)

- Termodinámica de gases y vaporesDocumento3 páginasTermodinámica de gases y vaporesJose Antonio Aguilar IbarraAún no hay calificaciones

- Clase IIDocumento17 páginasClase IIDaniel Ricardo DelgadoAún no hay calificaciones

- Investigación de La Unidad 5, Métodos Numéricos (Método de Euler)Documento8 páginasInvestigación de La Unidad 5, Métodos Numéricos (Método de Euler)Jesús Alexander MejíazAún no hay calificaciones

- Colectividad CanónicaDocumento4 páginasColectividad CanónicaJoseAún no hay calificaciones

- 1.2 Ciclo de Carnot.Documento6 páginas1.2 Ciclo de Carnot.Karla roblesAún no hay calificaciones

- K:? V 60 T:1 S - M 2.5: Solución: DatosDocumento3 páginasK:? V 60 T:1 S - M 2.5: Solución: DatosJorge David De Los ReyesAún no hay calificaciones

- Entrega Final Fluidos y TermodinamicaDocumento10 páginasEntrega Final Fluidos y TermodinamicaShermin PerlinAún no hay calificaciones

- Evaluación U-IIDocumento6 páginasEvaluación U-IIAlberto GarcíaAún no hay calificaciones

- Ecuaciones de Estado Del Gas IdealDocumento30 páginasEcuaciones de Estado Del Gas IdealSneider CastañedaAún no hay calificaciones

- Ejercicios EquilibrioDocumento2 páginasEjercicios EquilibrioJoel VillarinoAún no hay calificaciones

- Diseño de Reactores No IsotermicosDocumento5 páginasDiseño de Reactores No IsotermicosAndreéita SaDiAún no hay calificaciones

- Resumen Ecuacion de BernoulliDocumento1 páginaResumen Ecuacion de BernoulliJesúsOrlandoGalindoMedinaAún no hay calificaciones

- CicloPotenciaSEODocumento6 páginasCicloPotenciaSEOPablo Antonio Riveraz HondoyAún no hay calificaciones

- TermodinamicaDocumento13 páginasTermodinamicaRoberto LagunaAún no hay calificaciones

- Problemas de Capacitancia y DielectricosDocumento21 páginasProblemas de Capacitancia y DielectricosKenneth Jack Zegarra Huamán67% (3)

- 4.13 Diagrama T-S y H-SDocumento1 página4.13 Diagrama T-S y H-SJose De Los Santos LopezAún no hay calificaciones

- Problema BalanceDocumento20 páginasProblema BalanceJaqueline Stephanie Ley Martinez100% (1)

- Eficiencia IsentropicaDocumento4 páginasEficiencia Isentropicadamelarchivo12333% (3)

- Selector de Velocidades MagnetismoDocumento8 páginasSelector de Velocidades MagnetismoAnonymous vKQ099100% (3)

- Apuntes TermodinamicaDocumento4 páginasApuntes TermodinamicaJuan CerrudAún no hay calificaciones

- UNIDAD 2 - Segunda ParteDocumento35 páginasUNIDAD 2 - Segunda ParteUlises MaldonadoAún no hay calificaciones

- Práctica de Laboratorio 2 - Determinación Calor Específico de Un Metal y La Entalpía de FusiónDocumento3 páginasPráctica de Laboratorio 2 - Determinación Calor Específico de Un Metal y La Entalpía de Fusiónmafe0101Aún no hay calificaciones

- Linea Del Tiempo MBEDocumento5 páginasLinea Del Tiempo MBEMario Darwin Velazco Tejada100% (1)

- Resumen Camino Al AndarDocumento5 páginasResumen Camino Al AndarCecilio H.M.Aún no hay calificaciones

- Informe Campo ElectricoDocumento8 páginasInforme Campo ElectricoJulio MoralesAún no hay calificaciones

- Análisis de Masa y Energía en Volúmenes de ControlDocumento4 páginasAnálisis de Masa y Energía en Volúmenes de ControlKevin PalmaAún no hay calificaciones

- Problemas TermodinamicaDocumento4 páginasProblemas Termodinamicaharolyn gonzalezAún no hay calificaciones

- NTC 1876: Principio del material máximo en tolerancias geométricasDocumento0 páginasNTC 1876: Principio del material máximo en tolerancias geométricasSebastian MonteroAún no hay calificaciones

- Termofisica y TermoquimicaDocumento2 páginasTermofisica y TermoquimicaYahaira Tuz0% (1)

- Cromatografía de papel: Separación de colorantesDocumento7 páginasCromatografía de papel: Separación de colorantesNathan DrakeAún no hay calificaciones

- Matemáticas III Unidad I Tema IIDocumento26 páginasMatemáticas III Unidad I Tema IIYiann Addid Celaya Solano50% (2)

- 5.5 Financiamiento Mediante ArrendamientoDocumento2 páginas5.5 Financiamiento Mediante ArrendamientoArancha Rincon AlvaradoAún no hay calificaciones

- Apuntes 1er Parcial 2821Documento17 páginasApuntes 1er Parcial 2821freddy lopez gonzalesAún no hay calificaciones

- Problemario Examen Final-Transferencia de Calor .Documento4 páginasProblemario Examen Final-Transferencia de Calor .Luis Vi llamar malvaezAún no hay calificaciones

- Tratamientos TermicosDocumento7 páginasTratamientos TermicosJorgeAntonioNegretMAún no hay calificaciones

- Que Es La CienciaDocumento4 páginasQue Es La CienciaOscar Alexander Curiel50% (2)

- La Evolucion de Los Conceptos de Espacio y Tiempo - J.R. MoronesDocumento9 páginasLa Evolucion de Los Conceptos de Espacio y Tiempo - J.R. MoronesStargateAAún no hay calificaciones

- Objeto Metodo FisicaDocumento5 páginasObjeto Metodo Fisicaliz JimenezAún no hay calificaciones

- Principio de causalidad y mecánica cuánticaDocumento6 páginasPrincipio de causalidad y mecánica cuánticaCesar Manuel Caamal PatAún no hay calificaciones

- Actos de Observación. Todo lo que existe requiere de un observador humanoDe EverandActos de Observación. Todo lo que existe requiere de un observador humanoCalificación: 4 de 5 estrellas4/5 (2)

- Numero de ReynodlsDocumento1 páginaNumero de ReynodlsAlexis TibanAún no hay calificaciones

- 11 EnzimasDocumento11 páginas11 EnzimasyoyiAún no hay calificaciones

- Poropiedades Molares ParcialesDocumento15 páginasPoropiedades Molares ParcialesAlexis TibanAún no hay calificaciones

- VAN y TIR CalculadosDocumento9 páginasVAN y TIR CalculadosAlexis TibanAún no hay calificaciones

- Pirolisis NeumaticosDocumento202 páginasPirolisis NeumaticosAlexis TibanAún no hay calificaciones

- Asme 8Documento168 páginasAsme 8Alexis TibanAún no hay calificaciones

- ZeolitaDocumento1 páginaZeolitaAlexis TibanAún no hay calificaciones

- Pirolisis Neumaticos-Páginas-198Documento1 páginaPirolisis Neumaticos-Páginas-198Alexis TibanAún no hay calificaciones

- Deducción de la Ecuación General de Calor por Conducción en Coordenadas Rectangulares y CurvilíneasDocumento14 páginasDeducción de la Ecuación General de Calor por Conducción en Coordenadas Rectangulares y CurvilíneasanaaAún no hay calificaciones

- Práctica # 6 Tiempo de Residencia en Un Reactor Continuo de Tanque Agitado Usando Técnica de TrazadoresDocumento5 páginasPráctica # 6 Tiempo de Residencia en Un Reactor Continuo de Tanque Agitado Usando Técnica de TrazadoresAlexis TibanAún no hay calificaciones

- Enmienda: Norma Técnica Ecuatoriana Nte Inen 2482:2009Documento10 páginasEnmienda: Norma Técnica Ecuatoriana Nte Inen 2482:2009Fidel VallejoAún no hay calificaciones

- Final Trabajo AlofanesDocumento22 páginasFinal Trabajo AlofanesAlexis TibanAún no hay calificaciones

- Refinación Del PetróleoDocumento4 páginasRefinación Del PetróleoAlexis TibanAún no hay calificaciones

- 11 EnzimasDocumento11 páginas11 EnzimasyoyiAún no hay calificaciones

- Teoría y métodos de decapado de metalesDocumento3 páginasTeoría y métodos de decapado de metalesAlexis TibanAún no hay calificaciones

- Rendimiento Lecho Fijo Pirolisis PETDocumento134 páginasRendimiento Lecho Fijo Pirolisis PETAlexis TibanAún no hay calificaciones

- Secado de SolidosDocumento43 páginasSecado de SolidosVane Posso100% (1)

- Análisis BETDocumento8 páginasAnálisis BETAlexis TibanAún no hay calificaciones

- Cartas AbsorciónDocumento2 páginasCartas AbsorciónAlexis TibanAún no hay calificaciones

- Acidez TricolDocumento2 páginasAcidez TricolAlexis TibanAún no hay calificaciones

- Practica Anaranjado de MetiloDocumento12 páginasPractica Anaranjado de MetiloAlexis TibanAún no hay calificaciones

- Diseño Secador Por Atomizacion TachitaDocumento23 páginasDiseño Secador Por Atomizacion TachitaAlexis TibanAún no hay calificaciones

- Método de Prueba Estándar para El Calor de CombustiónDocumento4 páginasMétodo de Prueba Estándar para El Calor de CombustiónAlexis TibanAún no hay calificaciones

- Preguntas Extracción Sólido-LíquidoDocumento2 páginasPreguntas Extracción Sólido-LíquidoAlexis TibanAún no hay calificaciones

- Hessiana OperativaDocumento3 páginasHessiana OperativaAlexis TibanAún no hay calificaciones

- Astm D 482-03Documento8 páginasAstm D 482-03Susan Li HBAún no hay calificaciones

- La Conversion de Energia ElectromecanicaDocumento7 páginasLa Conversion de Energia ElectromecanicaAlexis TibanAún no hay calificaciones

- Energia de Exitacion SimpleDocumento4 páginasEnergia de Exitacion SimpleAlexis TibanAún no hay calificaciones

- Analisis Numerico Final Sistemas DinamicosDocumento17 páginasAnalisis Numerico Final Sistemas DinamicosAlexis TibanAún no hay calificaciones

- Arbol de Problemas ProyectosDocumento2 páginasArbol de Problemas ProyectosAlexis TibanAún no hay calificaciones

- 2° Retroalimentación Ficha 12Documento2 páginas2° Retroalimentación Ficha 12jesus alburquequeAún no hay calificaciones

- Cuadernillo de Segundo Grado de Matematicas SecundariaDocumento47 páginasCuadernillo de Segundo Grado de Matematicas SecundariaEdmundo Alvarez80% (245)

- Laboratorio de DensidadDocumento2 páginasLaboratorio de Densidadaula137 carson0% (1)

- Clase 2 Maquinas de Corriente ContinuaDocumento81 páginasClase 2 Maquinas de Corriente ContinuaDocente 561 UMECITAún no hay calificaciones

- Q.A.I.I Informe 1 FINALDocumento13 páginasQ.A.I.I Informe 1 FINALJoyce PazmiñoAún no hay calificaciones

- Capítulo 3 - Sustancias Puras.Documento3 páginasCapítulo 3 - Sustancias Puras.Kaaren VillannuevaAún no hay calificaciones

- Principios de Física para la resolución de problemas ingenierilesDocumento2 páginasPrincipios de Física para la resolución de problemas ingenierilesMiguel PalmerosAún no hay calificaciones

- Turbocompresor A Pruebas A Silletas Con ArrancadorDocumento4 páginasTurbocompresor A Pruebas A Silletas Con Arrancadorjosue muñoz perezAún no hay calificaciones

- 1pcs Física 1Documento2 páginas1pcs Física 1Alejandro SolisAún no hay calificaciones

- TP No 2 PDFDocumento2 páginasTP No 2 PDFFranciscoCantilloAún no hay calificaciones

- Ejercicios resueltos de corriente eléctrica y ley de OhmDocumento14 páginasEjercicios resueltos de corriente eléctrica y ley de Ohmjuzmila100% (1)

- Maquinas ElectricasDocumento83 páginasMaquinas ElectricasRoger FeraAún no hay calificaciones

- Examen Final - Hoja de RespuestaDocumento2 páginasExamen Final - Hoja de RespuestajuanAún no hay calificaciones

- Resumen MegóhmetroDocumento6 páginasResumen MegóhmetroEDINSON EDUARDO ARRIBASPLATA CERNAAún no hay calificaciones

- Diapositivas Acustica AndalucíaDocumento28 páginasDiapositivas Acustica AndalucíaAlfonsoAún no hay calificaciones

- Masa ResorteDocumento3 páginasMasa ResorteAlejandro OrcanAún no hay calificaciones

- Ejercicio SAE ResueltoDocumento4 páginasEjercicio SAE ResueltoAlexis AriasAún no hay calificaciones

- Sílabo Física I UNI CienciasDocumento3 páginasSílabo Física I UNI CienciasAlvaroRamosArandaAún no hay calificaciones

- Anizo RoseroDocumento49 páginasAnizo RoseroGabriel GranizoAún no hay calificaciones

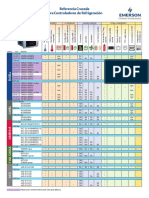

- Cross Reference Dixell 2012 HR PDFDocumento2 páginasCross Reference Dixell 2012 HR PDFfgbcnmt100% (1)

- Proteccion de Distancia FinalDocumento41 páginasProteccion de Distancia FinalOrlando Ramos LópezAún no hay calificaciones

- Circuitos RC y RLC para filtrar señalesDocumento2 páginasCircuitos RC y RLC para filtrar señalesWilson MartinezAún no hay calificaciones

- II PARTE PRACTICA - FisicaDocumento3 páginasII PARTE PRACTICA - FisicaSIMON MARTINEZ MARTINEZAún no hay calificaciones

- Disibeint Snza CDocumento5 páginasDisibeint Snza CjlarrutiAún no hay calificaciones

- Circuitos BasicosDocumento5 páginasCircuitos BasicosKaren Sofia Sanchez MosqueraAún no hay calificaciones

- Ficha SDR-41 AlDocumento4 páginasFicha SDR-41 AlNelson JuniorAún no hay calificaciones

- Trabajo IntegradorDocumento2 páginasTrabajo IntegradorNora BenitezAún no hay calificaciones

- Manual Planta Electrica KARSON GG950Documento12 páginasManual Planta Electrica KARSON GG950edward100% (4)

- Evaluacion Final - Escenario 8 - SEGUNDO BLOQUE-CIENCIAS BASICAS - FUNDAMENTOS DE QUIMICADocumento3 páginasEvaluacion Final - Escenario 8 - SEGUNDO BLOQUE-CIENCIAS BASICAS - FUNDAMENTOS DE QUIMICAAba H0% (1)