Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Bagua Grande - 2018: Ingeniería de Sistemas y Telemática

Cargado por

ana leydiTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Bagua Grande - 2018: Ingeniería de Sistemas y Telemática

Cargado por

ana leydiCopyright:

Formatos disponibles

Ingeniería de Sistemas y Telemática

TEMA : ETL - Extraer, Transformar y Cargar

ASIGNATURA : Base de Datos II

PROFESOR : Ing. Marco Aurelio Porro Chulli

CICLO : VIII

SECCIÓN : “A”

INTEGRANTES :

Ana Leydi Linares Serrano.

Delsi Yakelin Huamán Villanueva.

Patricia Reyna Reynaga.

Bagua Grande – 2018

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

INDICE

1. CONTENIDO ........................................................................................................................... 3

Introducción .............................................................................................................................. 3

Principios, reglas y calidad de datos ETL ................................................................................... 4

Fases de ETL .............................................................................................................................. 5

FASE DE EXTRACCIÓN ............................................................................................................ 5

FASE DE TRANSFORMACIÓN ................................................................................................. 9

FASE DE CARGA ................................................................................................................... 11

Aplicaciones de los procesos ETL ............................................................................................ 12

¿Qué sistemas se pueden integrar en un proceso ETL?.......................................................... 13

Beneficios de los procesos ETL ................................................................................................ 13

Proceso ETL: un sistema efectivo, pero con retos y cuestiones a resolver ............................. 14

2. RESUMEN ............................................................................................................................ 15

3. SUMMARY ........................................................................................................................... 16

4. RECOMENDACIONES ........................................................................................................... 17

5. CONCLUSIONES ................................................................................................................... 18

6. APRECIACIÓN DEL EQUIPO .................................................................................................. 20

7. GLOSARIO DE TÉRMINOS .................................................................................................... 22

8. BIBLIOGRAFÍA Y LINKOGRAFÍA ............................................................................................ 25

ING. MARCO AURELIO PORRO CHULLI 2

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

ETL - EXTRAER, TRANSFORMAR Y CARGAR

1. CONTENIDO

Introducción

ETL, esencialmente, es el proceso que permite a las empresas manejar y

movilizar datos desde distintos tipos de fuentes, para transformarlos, limpiarlos

y cargarlos en otra base de datos, Data Mart, o Data Warehose para analizarlos,

o en otro sistema operativo para apoyar un proceso de negocio. Asimismo el ETL

se lo puede utilizar para integrar sistemas heredados a los nuevos sistemas

emergentes en las empresas.

El principal propósito de ETL es transportar la información de la empresa desde

las aplicaciones de producción a los sistemas de Inteligencia de Negocio (BI),

este proceso consta de tres etapas:

Extracción de datos

Transformación de datos

Carga de datos

Extraer.- La primera parte del proceso ETL consiste en extraer los datos desde

los sistemas de origen. La mayoría de los proyectos de almacenamiento de datos

fusionan datos provenientes de diferentes sistemas de origen. Cada sistema

separado puede usar una organización diferente de los datos o formatos

distintos. Los formatos de las fuentes normalmente se encuentran en bases de

datos relacionales o ficheros planos, pero pueden incluir bases de datos no

relacionales u otras estructuras diferentes. La extracción convierte los datos a un

formato preparado para iniciar el proceso de transformación.

Un requerimiento importante que se debe exigir a la tarea de extracción es que

ésta cause un impacto mínimo en el sistema origen. Si los datos a extraer son

muchos, el sistema de origen se podría ralentizar e incluso colapsar, provocando

que éste no pueda utilizarse con normalidad para su uso cotidiano. Por esta

razón, en sistemas grandes las operaciones de extracción suelen programarse

en horarios o días donde este impacto sea nulo o mínimo.

Transformar.- La fase de transformación aplica una serie de reglas de negocio o

funciones sobre los datos extraídos para convertirlos en datos que serán

ING. MARCO AURELIO PORRO CHULLI 3

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

cargados. Algunas fuentes de datos requerirán alguna pequeña manipulación de

los datos. No obstante en otros casos pueden ser necesarias aplicar algunas

transformaciones.

Cargar.- La fase de carga es el momento en el cual los datos de la fase anterior

(transformación) son cargados en el sistema de destino. Dependiendo de los

requerimientos de la organización, este proceso puede abarcar una amplia

variedad de acciones diferentes.

Los Data Warehose es un repositorio de datos que mantienen un historial de los

registros de manera que se pueda hacer una auditoría de los mismos y disponer

de un rastro de toda la historia de un valor a lo largo del tiempo.

Principios, reglas y calidad de datos ETL

Tal y como recomienda Arkady Maydanchik en su libro "Data quality asessment",

las normas son importantes y mucho más en el entorno de la calidad de los datos.

Tal y como él mismo explica en su obra, las reglas aplicables a la calidad de

datos ETL se pueden agrupar en cinco categorías diferenciadas:

1. Limitaciones de atributo de dominio: que restringen los valores

permitidos de los atributos de datos individuales. Son la más básica de

todas las reglas de calidad de datos.

2. Reglas de integridad relacional: son las que se derivan de los modelos

de datos relacionales, obligando a cumplir la identidad y la integridad

referencial para cada dato.

3. Reglas de datos históricos: incluyen restricciones de línea de tiempo y

patrones de valor para pilas de valor dependientes del tiempo y la historia

de cada evento.

4. Reglas para los objetos dependientes del estado: asocian

restricciones al ciclo de vida de los objetos descritos por los modelos de

transiciones de estado.

5. Reglas de dependencia generales: describen las relaciones más

complejas entre atributos, como por ejemplo restricciones en

redundancias, derivadas, parcialmente dependientes y atributos

correlacionados.

ING. MARCO AURELIO PORRO CHULLI 4

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Sin embargo, el fijar ciertos estándares no implica que los problemas de calidad

de datos queden resueltos, ni que se descubran las necesidades en cuanto a

datos por parte de cada usuario. Aunque lo cierto es que resulta útil para llegar

a un acuerdo acerca de valores aceptables y definiciones que puede mejorar los

resultados finales de calidad de datos ETL.

Fases de ETL

FASE DE EXTRACCIÓN

Para llevar a cabo de manera correcta el proceso de extracción, primera fase del

ETL, hay que seguir los siguientes pasos:

ING. MARCO AURELIO PORRO CHULLI 5

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Análisis previo de las necesidades. Normalmente, hay una primera etapa de

análisis donde se evalúan las necesidades concretas de la organización en

cuanto a movimiento y transformación de datos. Por lo general, no se comienza

extrayendo toda la información, sino que se empieza con el tratamiento de unos

datos concretos según una necesidad puntual y luego se realizan ampliaciones

a medida que se van necesitando.

Identificación de archivos. Antes de extraer los datos, se identifica de qué tipo

son y en qué formato se encuentran los sistemas fuente. Por ejemplo, si se trata

de bases de datos relacionales o no relacionales, archivos planos, archivos

complejos, archivos VSAM, WebServices, MainFrame, archivos en Excel, etc. Lo

habitual es que los datos de los sistemas de origen provengan de formatos

distintos, que tendrán que ser fusionados.

Extracción de los datos. En función de las necesidades detectadas, se procede

a la extracción en sí de dichos datos.

ING. MARCO AURELIO PORRO CHULLI 6

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Además, uno de las prevenciones más importantes que se deben tener en

cuenta durante el proceso de extracción sería el exigir siempre que esta tarea

cause un impacto mínimo en el sistema de origen. Este requisito se basa en la

práctica ya que, si los datos a extraer son muchos, el sistema de origen se podría

ralentizar e incluso colapsar, provocando que no pudiera volver a ser utilizado

con normalidad para su uso cotidiano.

Modos de extracción

Básicamente, existen tres modos distintos de extracción. El tipo de necesidad de

la organización es lo que, normalmente, determinará la elección de una u otra

forma.

Full Extract o extracción total

Esta modalidad consiste en extraer la totalidad de datos. En este caso, se barren

tablas completas que pueden llegar a tener millones de registros.

Incremental Extract o extracción incremental

Se va procesando por lotes únicamente lo que fue modificado o agregado.

También puede haber filas que se borren por estar duplicadas, tratarse de datos

erróneos, etc.

Update Notification o notificación de actualizaciones

En este caso, solo se van extrayendo los datos a medida que se produce una

actualización (por ejemplo, un inserto).

Estos tres tipos de extracción son manejados por un módulo denominado

Change Data Capture (CDC).

Claves del proceso extracción

Lo más importantes es que la tarea de extracción cause el mínimo impacto

posible en el sistema de origen:

Que no afecte a su normal funcionamiento. Para ello es aconsejable

programar estas tareas en días y horarios de nula o mínima actividad

laboral.

Se debe evitar que provoque algún problema de seguridad.

ING. MARCO AURELIO PORRO CHULLI 7

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

El proceso de extracción ideal es el que apenas se nota

Cualquier organización, empresa o compañía debe exigir que el proceso de

extracción de datos desde su fuente o fuentes de origen cause el menor impacto

posible. Es decir, que no suponga ningún problema a los empleados que,

diariamente, trabajan con los datos y registros.

Una extracción de un número demasiado grande de datos de una sola vez puede

llegar a ralentizar, e incluso colapsar, el sistema. Por este motivo, es importante

valorar muy bien las necesidades y el alcance de la operación a realizar y, si es

necesario, llevar a cabo la operación de forma escalonada en bloques de menor

tamaño y/o en las fechas y horas más adecuadas para lograr ese mínimo

impacto.

Limpieza

La limpieza de datos se divide en distintas etapas, que vamos a describir a

continuación:

Depurar los valores: Este proceso localiza e identifica los elementos

individuales de información en las fuentes de datos y los aísla en los

ficheros destino. Por ejemplo: separar el nombre completo en nombre,

primer apellido, segundo apellido, o la dirección en: calle, numero, piso,

etcétera.

Corregir: Este proceso corrige los valores individuales de los atributos

usando algoritmos de corrección y fuentes de datos externas. Por

ejemplo: comprueba una dirección y el código postal correspondiente.

Estandarizar: Este proceso aplica rutinas de conversión para transformar

valores en formatos definidos y consistentes aplicando procedimientos de

ING. MARCO AURELIO PORRO CHULLI 8

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

estandarización y definidos por las reglas del negocio. Por ejemplo: trato

de Sr., Sra., etc. o sustituyendo los diminutivos de nombres por los

nombres correspondientes.

Relacionar: Este proceso busca y relaciona los valores de los registros,

corrigiéndolos y estandarizándolos, basándose en reglas de negocio para

eliminar duplicados. Por ejemplo: identificando nombres y direcciones

similares.

Consolidar: Este proceso analiza e identifica relaciones entre registros

relacionados y los junta en una sola representación.

FASE DE TRANSFORMACIÓN

Los datos originarios de repositorios digitales diferentes no suelen coincidir en

formato. Por tanto, para lograr integrarlos resulta indispensable realizar

operaciones de transformación. El objetivo no es otro que evitar duplicidades

innecesarias e impedir la generación de islas de datos inconexas. Las

transformaciones aplican una serie de reglas de negocio o funciones sobre los

datos extraídos para convertirlos en datos destino.

Las reglas de negocios describe las políticas, normas, operaciones, definiciones

y restricciones presentes en una organización y que son de vital importancia para

alcanzar los objetivos.

La transformación de los datos se hace partiendo de los datos una vez “limpios”.

Transformamos los datos de acuerdo con las reglas de negocio y los estándares

que han sido establecidos.

ING. MARCO AURELIO PORRO CHULLI 9

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

La fase de transformación aplica una serie de reglas de negocio o funciones

sobre los datos extraídos para convertirlos en datos que serán cargados.

Algunas fuentes de datos requerirán alguna pequeña manipulación de los datos.

No obstante en otros casos pueden ser necesarias aplicar algunas de las

siguientes transformaciones:

Reformateo de datos.

Conversión de unidades. Por ejemplo, convertir millas en kilómetros por

hora o viceversa. Algo muy habitual cuando se extraen datos de países

con unidades métricas distintas. Otro caso sería la conversión de

diferentes monedas (libras, euros...) en un único valor estándar.

Selección de columnas para su carga posterior. Por ejemplo, hacer que

las columnas con valores nulos no se carguen.

Agregación de columnas. Añadir una columna con la procedencia de

determinados automóviles sería un ejemplo.

Dividir una columna en varias. Esta acción resulta de gran utilidad para,

por ejemplo, separar en tres columnas, una para el nombre y otras dos

para los apellidos, la identificación de una persona que antes estaba en

un solo campo.

Traducir códigos. Por ejemplo, si la fuente de origen almacena una “H”

para hombres y una “M” para mujeres, dar las instrucciones necesarias

para que en destino se guarde un “ 1” para hombres y un” 2” para mujeres.

Obtener nuevos valores calculados.

Unir datos de varias fuentes.

Lookups. Es cuando se toma un dato y se lo compara con otro tipo de

datos, cruzando información. Por ejemplo, capturar un código de cliente

de una base de datos y cruzarlo con otra base de créditos concedidos

para saber si dicho cliente disfruta o no de ese préstamo.

Pivoting. Proceso parecido al lookups pero con un grado mayor de

complejidad, ya que se cruzan datos de distintas fuentes.

¿Quién se encarga de realizar estas transformaciones?

Esta función corresponde al desarrollador o analista del proceso ETL en

cuestión. La definición de las transformaciones a realizar se realiza en función

de un análisis previo y de la fase de limpieza que, como ya hemos señalado y

ING. MARCO AURELIO PORRO CHULLI 10

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

profundizaremos más adelante, se trata de un proceso separado pero

estrechamente ligado al de transformación.

FASE DE CARGA

La fase de carga es el momento en el cual los datos de la fase anterior

(transformación) son cargados en el sistema de destino. Dependiendo de los

requerimientos de la organización, este proceso puede abarcar una amplia

variedad de acciones diferentes. En algunas bases de datos se sobrescribe la

información antigua con nuevos datos. Los data warehouse mantienen un

historial de los registros de manera que se pueda hacer una auditoría de los

mismos y disponer de un rastro de toda la historia de un valor a lo largo del

tiempo.

Existen dos formas básicas de desarrollar el proceso de carga:

Acumulación simple: esta manera de cargar los datos consiste en

realizar un resumen de todas las transacciones comprendidas en el

período de tiempo seleccionado y transportar el resultado como una única

transacción hacia el data warehouse, almacenando un valor calculado

que consistirá típicamente en un sumatorio o un promedio de la magnitud

considerada. Es la forma más sencilla y común de llevar a cabo el proceso

de carga.

ING. MARCO AURELIO PORRO CHULLI 11

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Rolling: este proceso sería el más recomendable en los casos en que se

busque mantener varios niveles de granularidad. Para ello se almacena

información resumida a distintos niveles, correspondientes a distintas

agrupaciones de la unidad de tiempo o diferentes niveles jerárquicos en

alguna o varias de las dimensiones de la magnitud almacenada (por

ejemplo, totales diarios, totales semanales, totales mensuales, etc.).

Sea cual sea la manera elegida de desarrollar este proceso, hay que tener en

cuenta que esta fase interactúa directamente con la base de datos de destino y,

por eso, al realizar esta operación se aplicarán todas las restricciones que se

hayan definido en ésta. Si están bien definidas, la calidad de los datos en el

proceso ETL estará garantizada.

Aplicaciones de los procesos ETL

Gracias a los procesos ETL es posible que cualquier organización:

Mueva datos desde una o múltiples fuentes.

Reformatee esos datos y los limpie, cuando sea necesario.

Los cargue en otro lugar como una base de datos, un data mart o un data

warehouse.

Una vez alojados en destino, esos datos se analicen.

O, cuando ya están cargados en su ubicación definitiva, se empleen en

otro sistema operacional, para apoyar un proceso de negocio.

No obstante, las herramientas ETL no tienen por qué utilizarse sólo en entornos

de Data Warehousing o construcción de un Data Warehouse, sino que pueden

ser útiles para multitud de propósitos, como por ejemplo:

Tareas de Bases de datos: que también se utilizan para consolidar, migrar

y sincronizar bases de datos operativas.

Migración de datos entre diferentes aplicaciones por cambios de versión

o cambio de aplicativos.

Sincronización entre diferentes sistemas operacionales (por ejemplo,

entre nuestro entorno ERP y la web de ventas).

Consolidación de datos: sistemas con grandes volúmenes de datos que

son consolidados en sistemas paralelos, ya sea para mantener históricos

o para llevar a cabo procesos de borrado en los sistemas originales.

ING. MARCO AURELIO PORRO CHULLI 12

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Interfaces de datos con sistemas externos: como el envío de información

a clientes o proveedores. También servirían para la recepción, proceso e

integración de la información recibida.

Interfaces con sistemas Frontoffice: serían interfaces de subida/bajada

con sistemas de venta.

Otros cometidos: como la actualización de usuarios a sistemas paralelos

o la preparación de procesos masivos (tipo mailings o newsletter).

¿Qué sistemas se pueden integrar en un proceso ETL?

Los procesos ETL pueden incluir:

Sistemas legacy. Es decir, legados, heredados o antiguos.

Sistemas nuevos. Basados en Windows, Linux y también en las redes sociales

modernas: Facebook, Twitter, Linkedin, etc.

Los sistemas legacy o heredados se caracterizan, generalmente, por: ser

cerrados, no permitir cambios y tener un difícil acceso (normalmente se necesita

algún tipo de driver especial). Son sistemas que procesan hacia dentro y, por lo

tanto, no permiten la agregación de una computadora que trabaje en paralelo.

Por el contrario, los sistemas nuevos o modernos (basados en Windows o Linux)

son abiertos, amplios e interconectados. Un ejemplo lo constituiría una granja de

servidores Linux, la cual permite la interconexión de los distintos nodos entre sí.

Beneficios de los procesos ETL

A cualquier empresa u organización le beneficia poner en marcha un proceso

ETL para mover y transformar los datos que maneja por los siguientes motivos:

Poder crear una Master Data Management, es decir, un repositorio central

estandarizado de todos los datos de la organización. Por ejemplo, si

tenemos un objeto cliente en una base de datos de créditos y otro objeto

cliente en la base de datos de tarjetas de crédito, lo que haría el Master

sería definir, de forma concreta e inequívoca, un registro cliente único con

su nombre y apellidos para la organización.

ING. MARCO AURELIO PORRO CHULLI 13

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Posibilita a los directivos tomar decisiones estratégicas basadas en el

análisis de los datos cargados en las bases nuevas y actualizadas: la

dama mart o data warehouse.

Sirve para integrar sistemas. Las organizaciones crecen de forma

orgánica y cada vez se van agregando más fuentes de datos. Esto

provoca que comience a surgir nuevas necesidades, como por ejemplo

integrar los datos de un banking on line con los datos antiguos de un

sistema legacy.

Poder tener una visión global de todos los datos consolidados en una data

warehouse. Por ejemplo, crear una estrategia de marketing basándose en

el análisis de los datos anteriores.

Proceso ETL: un sistema efectivo, pero con retos y cuestiones

a resolver

Como hemos visto, los procesos ETL son muy útiles y beneficiosos para las

organizaciones por su capacidad para integrar grandes bases de datos, logrando

así una visión única global que permite, a los analistas y directivos, tomar las

decisiones estratégicas adecuadas.

La implantación de un sistema ETL bien definido supone todo un reto puesto

que, para que sea realmente efectivo, debe permitir integrar los sistemas legacy

(algunos ya muy obsoletos) con los más modernos. Además, el acceso a todos

estos sistemas se debe producir no solo en modo de lectura, sino también como

escritura.

ING. MARCO AURELIO PORRO CHULLI 14

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

2. RESUMEN

Un almacén de datos (DW) es una colección integrada de datos orientados a

temas en apoyo de la toma de decisiones. Es importante destacar que la

integración de las fuentes de datos se logra mediante el uso de procesos ETL

(Extraer, Transformar y Cargar). Por lo tanto, se reconoce ampliamente que el

diseño apropiado de los procesos de ETL es un factor clave en el éxito de los

proyectos de DW.

Evaluamos las propuestas de investigación existentes sobre el modelado de

procesos ETL para almacenamiento de datos con el fin de identificar sus

principales características, notación y actividades. También estudiamos si estos

enfoques de modelado están respaldados por algún tipo de prototipo o

herramienta.

El principal propósito de ETL es transportar la información de la empresa desde

las aplicaciones de producción a los sistemas de Inteligencia de Negocio (BI),

este proceso consta de tres etapas:

Extracción de datos

Transformación de datos

Carga de datos

La primera etapa esencialmente extrae los datos desde los sistemas de origen.

La segunda etapa de transformación aplica una serie de funciones o reglas de

negocio sobre los datos extraídos para convertirlos en datos que serán cargados.

En ocasión existe la posibilidad de que algunas fuentes de datos requieran

alguna manipulación de los datos.

La etapa de carga se refiere al momento en el cual los datos de la fase de

transformación se cargan en el sistema de destino. Dependiendo de los

requisitos de la empresa, este proceso puede contener una extensa diversidad

de acciones. En algunas bases de datos se sobrescribe la información anterior

con nuevos datos.

ING. MARCO AURELIO PORRO CHULLI 15

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

3. SUMMARY

A data warehouse (DW) is an integrated collection of data oriented to issues in

support of decision making. It is important to note that the integration of data

sources is achieved through the use of ETL processes (Extract, Transform and

Load). Therefore, it is widely recognized that the proper design of ETL processes

is a key factor in the success of DW projects.

We evaluate existing research proposals on the modeling of ETL processes for

data storage in order to identify their main characteristics, notation and activities.

We also study whether these modeling approaches are supported by some kind

of prototype or tool.

The main purpose of ETL is to transport the information of the company from the

production applications to the Business Intelligence (BI) systems, this process

has three stages:

Data extraction

Data transformation

Loading data

The first stage essentially extracts the data from the source systems.The second

stage of transformation applies a series of functions or business rules on the

extracted data to convert them into data that will be loaded. On occasion there is

the possibility that some data sources require some manipulation of the data.

The loading stage refers to the moment in which the data of the transformation

phase is loaded into the destination system. Depending on the requirements of

the company, this process can contain a wide variety of actions. In some

databases, the above information is overwritten with new data.

ING. MARCO AURELIO PORRO CHULLI 16

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

4. RECOMENDACIONES

1. Para lograr mantener los niveles deseables de calidad de datos, ETL ha

de planificarse teniendo en cuenta la toma de las siguientes tres acciones:

Medir: para poder mejorar o mantener posiciones es indispensable

conocer el inicio, el punto de partida. Esta información permitirá trazar un

plan, desarrollar una estrategia y satisfacer las necesidades que se vayan

presentando durante el proceso de extracción, transformación y carga.

Analizar: de la interpretación de las métricas se producirá la transición a

la detección de las tendencias. Son éstas y los pequeños detalles las que

marcan el camino a seguir, actuando como directrices de la toma de

decisiones y minimizando el riesgo.

Mejorar: es el propósito de toda empresa y la única forma de mantenerse

en el entorno tan dinámico que vivimos hoy día. El descubrimiento de

desviaciones y su análisis son las claves para poder practicar los ajustes

que sean necesarios y lograr que en el momento de la carga de datos la

calidad no sea cuestionable.

2. En la práctica, una buena solución para simplificar algunas partes del

proceso puede ser, siempre que sea aplicable, el capturar los registros

que contienen datos no válidos en un archivo de rechazos para su

posterior inspección.

El siguiente paso sería analizar todos estos datos anómalos y actuar

sobre ellos. De esta manera, el diseño de procesos ETL será bastante

sencillo y contará con una entrada, una etapa de validación y dos salidas:

registros validados y datos sucios; mientras que la calidad de todo el

proceso quedará preservada.

3. La gestión de datos debe dar respuesta a las consultas estratégicas de la

compañía, las necesidades de información crítica para la toma de

decisiones y al potencial integrador para presentar una visión única de la

realidad. Una de las claves para garantizar el éxito es atender a las

buenas prácticas desde la fase de diseño y modelado. El objetivo debe

ser ganar alineación con el negocio en función a sus necesidades a la vez

que se minimizan riesgos, erradicando errores, discrepancias,

duplicidades y datos incompletos. El automatismo a través de la

ING. MARCO AURELIO PORRO CHULLI 17

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

herramienta adecuada es la única alternativa para alcanzar la visión única

que optimice procesos y reduzca costes.

4. Tener en cuenta para la construcción de un data warehouse, o para la

implantación de un proyecto Business Intelligence, sería sin duda el

principio DRY de no repetirse. “Don’t repeat yourself”, o simplemente

DRY, es un principio que defiende la necesidad de reducir o eliminar todo

tipo de duplicidades.

5. Definir si nos conviene crear un proceso ETL propio o comprar uno ya

existente. Si se trata de una organización grande lo más recomendable y

habitual es adquirir una licencia a nivel corporativo de un sistema ETL ya

desarrollado, así como también valorar los costes y recursos disponibles

puesto que la compra de una licencia supone una inversión importante.

6. Se debe tener en cuenta las expectativas de futuro de la empresa, sus

necesidades actuales, a corto y a medio plazo y su potencial de

crecimiento. Mediante el uso de herramientas optimizadas para los

procesos de manejo de datos, gran variedad de conectores disponibles,

transformaciones pre-construidas, filtros, agregaciones, ordenamientos,

joins, generación de documentación, gobernabilidad de datos, etc. listos

para usar.

5. CONCLUSIONES

1. Como conclusión podemos decir que los ETL son proceso que organizan

los flujos datos entre distintos sistemas en una organización y aporta los

métodos y herramientas necesarias para movilizar los datos desde

múltiples fuentes a un almacén de datos, para transformarlos, limpiarlos y

cargarlos en otra base de datos.

ETL es parte de la Inteligencia de Negocios, también llamado “Gestión de

los Datos” (Data Management).

2. Ejecute ETL más pequeños con mayor frecuencia durante el día en lugar

de ejecutar una extracción grande por la noche. Las extracciones grandes

serán más pesadas, los géneros serán exponencialmente más grandes y

el impacto potencial en la base de datos de reserva u OLTP será mayor.

ING. MARCO AURELIO PORRO CHULLI 18

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

3. El trabajo realizado permitió interiorizarse de las particularidades de un

proceso de carga de Data Warehouse y específicamente en el

correspondiente al Data Warehouse de Enseñanza de la Facultad de

Ingeniería. El proceso de carga de un Data Warehouse puede involucrar

muchas fuentes de datos y/o transformaciones complejas a partir de los

datos fuente, por lo tanto es importante planificar y documentar

cuidadosamente los procesos de ETL.

4. En nuestro trabajo realizado indica una parte importante a explicar qué

son los procesos ETL, y para qué se utilizan, tanto en entornos de Data

Warehouse como en otros entornos donde la integración de datos

también juega un papel muy importante. Después entra en detalle sobre

las actividades a realizar en cada etapa del proceso, en la extracción, en

la transformación y en la carga, e incluye advertencias sobre los aspectos

que se han de tener en cuenta en cada etapa.

5. Con base en lo antes presentado, se puede concluir que se puede ayudar

a optimizar el proceso de toma de decisiones fortaleciendo la operatividad

de las empresas, con el fin de generar operaciones competitivas y

exitosas. Gracias a esto, se contarán con mayor tiempo para el análisis

de resultados lo cual favorecerá a la creación de estrategias, mejorando

la toma de decisiones y facilitando el análisis de las transacciones.

6. En Conclusión Microsoft SQL Server Integration Services es una

plataforma que permite generar soluciones de integración de datos de alto

rendimiento, entre las que se incluyen paquetes de extracción,

transformación y carga de datos (ETL) para el almacenamiento de datos.

Incluye herramientas gráficas y asistentes para generar y depurar

paquetes; tareas para realizar funciones de flujo de datos tales como

operaciones de FTP; ejecución de instrucciones SQL y envío de mensajes

de correo electrónico; orígenes y destinos de datos para extraer y cargar

datos; transformaciones para limpiar, agregar, combinar y copiar datos.

ING. MARCO AURELIO PORRO CHULLI 19

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

6. APRECIACIÓN DEL EQUIPO

1. Según (Ana Leydi Linares Serrano) y de acuerdo con las investigaciones

describe que el proceso ETL se divide en 5 subprocesos a parte de los

tres que explicamos, estos son:

Extracción, Limpieza, Transformación, Integración, Actualización.

Pero aunque la Limpieza podría entenderse como una acción integrada

en la fase de transformación de datos, en la actualidad la tendencia es

considerar la limpieza de datos como una fase separada del proceso ETL.

La limpieza se realiza, si es posible, en cada fuente de datos de origen. Si

no en la tarea de transformación, se efectúa en los datos incompletos,

atributos sin valor, falta de atributos interesantes para el contexto o el valor

del atributo.

Las herramientas ETL tienen funcionalidades de limpieza de datos,

aunque existen herramientas especializadas para ello. En proyectos de

CRM, la limpieza de los datos es clave: los nombres y las direcciones de

los clientes siempre necesitan ser limpiados, eliminar duplicados, etc.

Por último el proceso de Actualización determina la periodicidad con el

que haremos nuevas cargas de datos, es decir este proceso es el que nos

permite añadir los nuevos datos al datawarehouse o base de datos de

destino.

2. Según (Yakelin Huamán Villanueva), un proceso ETL se utiliza con el fin

de obtener una perfecta integración entre las diferentes fuentes de

datos de los diferentes departamentos de una organización.

El proceso ETL funciona como integrador, extrayendo datos de las

diferentes fuentes, transformándolos en el formato preferido, basado en

las reglas de transformación del negocio, y cargándolos en una base de

datos unificada, conocida como Data Warehouse. Además las

herramientas ETL automatizan, organizan y optimizan esos procesos,

facilitando especialmente la gestión, el mantenimiento y la escalabilidad

ING. MARCO AURELIO PORRO CHULLI 20

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

de todo el entorno de 'alimentación' del Data Warehouse, y también de

otros entornos.

La fase final de la canalización de ETL generalmente consiste en

transformar los datos de origen en un formato final que sea más eficiente

para los tipos de consultas que necesitan soporte. Por ejemplo, los datos

pueden estar particionados. Además, ETL podría usar formatos de

almacenamiento optimizados como Parquet, que almacena datos

orientados a filas de forma columnar y proporciona una indexación

optimizada.

3. Según (Patricia Reyna Reynaga) dice ETL es una parte de un sistema

que ayuda a la toma de decisiones, contando con procesos de extracción,

transformación, limpieza y carga, que permitan obtener una vista unificada

con la mayor calidad posible en forma de Almacén de Datos, a partir de

fuentes que pueden ser heterogéneas, para dar respuesta a solicitudes

de decisiones.

Así como también se refiere al proceso de extraer datos de diferentes

fuentes u orígenes para posteriormente trasladarlos a una etapa donde

ocurrirá una transformación, en esta etapa la información puede sufrir

diferentes cambios tales como: Cálculos, Reglas, Limpieza, Integración

de datos, esto se da con la finalidad de que la información sea

provisionada o cargada en un destino final, los cuales suelen ser bases

de datos, almacenes de datos(Data Werehouse), Datamarts o archivo y

en este momento la información se encontrara disponible para ser

aprovechada al máximo.

ING. MARCO AURELIO PORRO CHULLI 21

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

7. GLOSARIO DE TÉRMINOS

Entorno ERP: (Enterprise Resource Planning – Planificación de Recursos

Empresariales) es un conjunto de sistemas de información que permite la

integración de ciertas operaciones de una empresa, especialmente las que

tienen que ver con la producción, la logística, el inventario, los envíos y la

contabilidad.

Data mart: Un data mart es una versión especial de almacén de datos (data

warehouse). Son subconjuntos de datos con el propósito de ayudar a que un

área específica dentro del negocio pueda tomar mejores decisiones. Los datos

existentes en este contexto pueden ser agrupados, explorados y propagados de

múltiples formas para que diversos grupos de usuarios realicen la explotación de

los mismos de la forma más conveniente según sus necesidades.

Datawarehose: Un Datawarehouse es una base de datos corporativa que se

caracteriza por integrar y depurar información de una o más fuentes distintas,

para luego procesarla permitiendo su análisis desde infinidad de perspectivas y

con grandes velocidades de respuesta.

Sistemas de inteligencia de negocio (BI): La inteligencia de negocios es la

parte de la gestión empresarial encargada de la recogida, procesamiento y

presentación de información relevante que facilite la toma de decisiones.

Ficheros planos: Al hablar de un fichero plano, también podemos hablar de

archivo de texto simple, texto sencillo, texto sin formato o texto simple. El

principal exponente de este tipo de datos es el archivo de texto con extensión

.txt, los cuales podemos crear con la aplicación Notepad.exe o el Bloc de notas

de Windows.

Sistema de destino: Es un área intermedia de almacenamiento de datos

utilizada para el procesamiento de los mismos durante procesos de extracción,

transformación y carga (ETL). Esta área se encuentra entre la fuente de los datos

y su destino, que a menudo son almacenes de datos, data marts u otros

repositorios de datos.

ING. MARCO AURELIO PORRO CHULLI 22

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Archivos VSAM: Método de acceso de almacenamiento virtual Los registros de

un VSAM pueden ser de una longitud fija o variable. Están organizados en

bloques de tamaño fijo llamados Intervalos de Control (IC) y a su vez en

divisiones más grandes llamadas Áreas de Control (AC). El tamaño de los

Intervalos de Control se mide en bytes.

Webservices: Un servicio web (en inglés, web service o web services) es una

tecnología que utiliza un conjunto de protocolos y estándares que sirven para

intercambiar datos entre aplicaciones. Distintas aplicaciones de software

desarrolladas en lenguajes de programación diferentes, y ejecutadas sobre

cualquier plataforma.

Mainframe: Una computadora central es una computadora grande, potente y

costosa, usada principalmente por una gran compañía para el procesamiento de

una gran cantidad de datos.

Change data capture: En las bases de datos, la captura de datos modificados

(CDC) es un conjunto de patrones de diseño de software utilizados para

determinar (y rastrear) los datos que han cambiado, de modo que se puedan

tomar medidas utilizando los datos modificados.

Sistemas emergentes: Son sistemas complejos de adaptación que despliegan

comportamientos emergentes. Se caracterizan por resolver problemas, al menos

en apariencia, espontáneamente; es decir, sin recurrir a una inteligencia de tipo

centralizado o jerarquizado (descendente), sino de forma ascendente, desde la

base, a partir de masas de elementos relativamente no inteligentes.

Bases de datos relacionales: Es una base de datos que se trata como un

conjunto de tablas y se manipula de acuerdo con el modelo de datos relacional.

Reglas de negocio: Descripción de las operaciones, definiciones y restricciones

aplicables a una organización para lograr sus metas.

Almacenamiento de datos: Es la retención de información mediante el uso de

tecnología desarrollada especialmente para guardar esos datos y mantenerlos

lo más accesibles posible.

Manipulación de los datos: Es el proceso de obtención y manipulación (cambio

de formato) de los datos para facilitar su lectura o mejorar su organización. Por

ING. MARCO AURELIO PORRO CHULLI 23

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

ejemplo, una lista de entradas de datos se puede organizar por orden alfabético,

lo que facilita la visualización y la búsqueda de información.

Sistema Fuente: Es la definición de un sistema que provee de datos a BW.

Todos los sistemas que proveen datos al Data Warehouse (BW) están descritos

a través de Sistemas Fuentes y los mismos son definidos dentro del Workbench

en el árbol de sistemas fuentes.

Fuente de Datos: Se incluyen en la definición del modelo, O3 obtiene los datos

necesarios para la creación del datamart correspondiente al modelo. La

información se usa para crear las Dimensiones y las jerarquías así como también

para calcular las Medidas.

Proyectos CRM: Sistemas de gestión de la relación con el cliente/consumidor.

Algoritmos de Detección y corrección de errores: Es una importante práctica

para el mantenimiento e integridad de los datos a través de diferentes

procedimientos y dispositivos como medios de almacenamiento confiables.

Sistemas legacy: Es un sistema informático (equipos informáticos o

aplicaciones) que ha quedado anticuado pero que sigue siendo utilizado por el

usuario (generalmente, una organización o empresa) y no se quiere o no se

puede reemplazar o actualizar de forma sencilla.

Fusionar.- se trata de producir, hacer, originar y realizar algo como la unión o

articulación de intereses, cosas, ideas y colectividades, también en agrupar

empresas y entidades en uno solo.

Ficheros.- significado o alcance La memoria es la capacidad de la mente y del

cerebro o de algún dispositivo electrónico de almacenar, retener y recordar.

Proceso.- Se define a la acción o el acto de ir hacia adelante. El transcurso,

lapso, duración o intervalo de tiempo. Grupo de fases sucesivas

Archivos planos.- Son aquellos que leen datos de un archivo de texto. El

archivo de texto puede tener formato delimitado, de ancho fijo o mixto. El formato

delimitado utiliza columna y delimitadores de filas para definir columnas y filas.

ING. MARCO AURELIO PORRO CHULLI 24

UNIVERSIDAD POLITÉCNICA AMAZÓNICA

Archivos complejos.- Son una extensión de archivos que están formados por

múltiples textos. Algunos ejemplos de tipos de archivo son, por ejemplo, archivos

de programa ejecutables, documentos de Microsoft Word o archivos MP3.

Ralentizar.- hacer más lento un proceso cualquiera.

Colapsar.- producir una paralización o interrupción en alguna cosa.

Registros.- Es un conjunto de campos que contienen los datos que pertenecen

a una misma repetición de entidad.

Estándar.- Que es lo más habitual o corriente, o que reúne las características

comunes a la mayoría. Sirve de patrón, modelo o punto de referencia para medir

o valorar cosas de la misma especie.

Consolidar.- Se trata en dar la mayor firmeza, estabilidad, resistencia, dureza,

solidez y consistencia de algo, en las cosas y los elementos.

Sincronizar.- hacer que dos o más acontecimientos ocurran en exactamente el

mismo tiempo, o en a la misma velocidad.

8. BIBLIOGRAFÍA Y LINKOGRAFÍA

https://es.wikipedia.org/wiki/Extract,_transform_and_load

https://blog.powerdata.es/el-valor-de-la-gestion-de-datos/bid/312587/Procesos-

ETL-Extracci-n-En-qu-consiste

https://blog.powerdata.es/el-valor-de-la-gestion-de-datos/bid/312584/procesos-

etl-definici-n-caracter-sticas-beneficios-y-retos

http://blog.bi-geek.com/que-es-una-etl/

http://www.evaluandosoftware.com/etl-extraccion-transformacion-carga-datos/

ING. MARCO AURELIO PORRO CHULLI 25

También podría gustarte

- Normalizacion de Base de Datos V3Documento22 páginasNormalizacion de Base de Datos V3Jose VelasquezAún no hay calificaciones

- Ejercicio 4 - Tienda Informatica SQLDocumento8 páginasEjercicio 4 - Tienda Informatica SQLThomas WrightAún no hay calificaciones

- Actividades - Conecta EmpleoDocumento3 páginasActividades - Conecta EmpleoEdwynAún no hay calificaciones

- AP10-AA11-EV03. Foro-Estrategias para Validar El Proceso de ImplantaciónDocumento3 páginasAP10-AA11-EV03. Foro-Estrategias para Validar El Proceso de Implantaciónmilton martinez batista100% (1)

- Prevencion de SuicidioDocumento14 páginasPrevencion de Suicidioana leydiAún no hay calificaciones

- Me Protego de Todo Tipo de ViolenciaDocumento28 páginasMe Protego de Todo Tipo de Violenciaana leydiAún no hay calificaciones

- Cuaderno de Campo para El EPRVVVDocumento3 páginasCuaderno de Campo para El EPRVVVana leydiAún no hay calificaciones

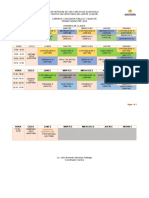

- Modelo Calendarizacion 2020Documento11 páginasModelo Calendarizacion 2020ana leydiAún no hay calificaciones

- Fortalezco Mi AutoestimaDocumento7 páginasFortalezco Mi Autoestimaana leydiAún no hay calificaciones

- Instrucciones para El Uso Correcto de Las Mascarillas ReutilizablesDocumento1 páginaInstrucciones para El Uso Correcto de Las Mascarillas Reutilizablesana leydiAún no hay calificaciones

- ProyectosDocumento12 páginasProyectosana leydiAún no hay calificaciones

- KanbanDocumento10 páginasKanbanana leydi100% (1)

- Fortalezco Mi AutoestimaDocumento7 páginasFortalezco Mi Autoestimaana leydiAún no hay calificaciones

- Lenguaje Transact SQLDocumento14 páginasLenguaje Transact SQLana leydiAún no hay calificaciones

- Planeación OperativaDocumento14 páginasPlaneación Operativaana leydi100% (1)

- Lenguaje Transact SQLDocumento14 páginasLenguaje Transact SQLana leydiAún no hay calificaciones

- Actividad1 - BD Avanzadas 54427 PDFDocumento7 páginasActividad1 - BD Avanzadas 54427 PDFjhon carvajalAún no hay calificaciones

- UML OriginalDocumento13 páginasUML OriginalRut RodriguezAún no hay calificaciones

- Horario de clases Contador Público y Auditor CUNOR 2023Documento2 páginasHorario de clases Contador Público y Auditor CUNOR 2023Genry MucuAún no hay calificaciones

- SQLCMDDocumento14 páginasSQLCMDDikxon LuqueAún no hay calificaciones

- La Ingenieria de Requisitos en El Entorno AgilDocumento9 páginasLa Ingenieria de Requisitos en El Entorno AgilDaniel RosalesAún no hay calificaciones

- ArquitecturaDeLaAplicación MVC ExtJSYSencha PDFDocumento14 páginasArquitecturaDeLaAplicación MVC ExtJSYSencha PDFAnonimo Sin NombreAún no hay calificaciones

- Clase-Conectar SQL Server Con El Controlador JDBCDocumento3 páginasClase-Conectar SQL Server Con El Controlador JDBCAlex ZapataAún no hay calificaciones

- El Servidor Proxy Squid SistemasDocumento6 páginasEl Servidor Proxy Squid Sistemasarchierick5373Aún no hay calificaciones

- Gerson Soto Control3Documento9 páginasGerson Soto Control3Gerson SotoAún no hay calificaciones

- Manual Cloudfleet ConductoresDocumento8 páginasManual Cloudfleet ConductoresAlexander MuñózAún no hay calificaciones

- SIC2 Unidad 04c Global Bike (Navegación)Documento23 páginasSIC2 Unidad 04c Global Bike (Navegación)Carla AlexandraAún no hay calificaciones

- C1 - Comandos ADB & FastbootDocumento6 páginasC1 - Comandos ADB & FastbootTairo BonillaAún no hay calificaciones

- Reingeniería de Un Compilador EducativoDocumento9 páginasReingeniería de Un Compilador EducativoMichel Ruiz TejeidaAún no hay calificaciones

- Contenido - 978 2 409 00706 4Documento17 páginasContenido - 978 2 409 00706 4LucasAún no hay calificaciones

- Actividad 2 - Programación EstructuradaDocumento6 páginasActividad 2 - Programación EstructuradaDaniel BucioAún no hay calificaciones

- Algoritmos fundamentales y tipos de datosDocumento32 páginasAlgoritmos fundamentales y tipos de datosbeatriz guzmanAún no hay calificaciones

- TogafDocumento29 páginasTogafAriel HernandezAún no hay calificaciones

- 06 Coexistencia Del ERP Con Los EAM Clase MundialDocumento16 páginas06 Coexistencia Del ERP Con Los EAM Clase MundialLuis MejiaAún no hay calificaciones

- Arreglos Bidimencionales y MultidimensionalesDocumento7 páginasArreglos Bidimencionales y MultidimensionalesJUAN CARLOS MARTINEZAún no hay calificaciones

- Tema 04. Codificación Segura de Aplicaciones IDocumento46 páginasTema 04. Codificación Segura de Aplicaciones IJacobo Nuñez LopezAún no hay calificaciones

- FuncionalidadDocumento3 páginasFuncionalidadFabian GomezAún no hay calificaciones

- Actividad 3.2 - Depuración (Caja Blanca) Ejercicio en Horario de Clase PDFDocumento6 páginasActividad 3.2 - Depuración (Caja Blanca) Ejercicio en Horario de Clase PDFAlbertoAún no hay calificaciones

- MODELO CONCEPTUAL de Bases de DatosDocumento12 páginasMODELO CONCEPTUAL de Bases de DatospericoAún no hay calificaciones

- Arreglos UnidimensionalesDocumento23 páginasArreglos UnidimensionalesNelson Mamani RamosAún no hay calificaciones

- Vision PDFDocumento78 páginasVision PDFWalter Pena AAún no hay calificaciones

- Seguridad SO y SQL ServerDocumento51 páginasSeguridad SO y SQL ServerpilladaAún no hay calificaciones