Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Index PHP

Cargado por

olgerbeliTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Index PHP

Cargado por

olgerbeliCopyright:

Formatos disponibles

Mquinas de vectores de soporte

1

Mquinas de vectores de soporte

Las mquinas de soporte vectorial o mquinas de vectores de soporte (Support Vector Machines, SVMs) son

un conjunto de algoritmos de aprendizaje supervisado desarrollados por Vladimir Vapnik y su equipo en los

laboratorios AT&T.

Estos mtodos estn propiamente relacionados con problemas de clasificacin y regresin. Dado un conjunto de

ejemplos de entrenamiento (de muestras) podemos etiquetar las clases y entrenar una SVM para construir un modelo

que prediga la clase de una nueva muestra. Intuitivamente, una SVM es un modelo que representa a los puntos de

muestra en el espacio, separando las clases por un espacio lo ms amplio posible. Cuando las nuevas muestras se

ponen en correspondencia con dicho modelo, en funcin de su proximidad pueden ser clasificadas a una u otra clase.

Ms formalmente, una SVM construye un hiperplano o conjunto de hiperplanos en un espacio de dimensionalidad

muy alta (o incluso infinita) que puede ser utilizado en problemas de clasificacin o regresin. Una buena separacin

entre las clases permitir un clasificacin correcta.

Idea bsica

Dado un conjunto de puntos, subconjunto de un conjunto mayor (espacio), en el que cada uno de ellos pertenece a

una de dos posibles categoras, un algoritmo basado en SVM construye un modelo capaz de predecir si un punto

nuevo (cuya categora desconocemos) pertenece a una categora o a la otra.

Como en la mayora de los mtodos de clasificacin supervisada, los datos de entrada (los puntos) son vistos como

un vector p-dimensional (una lista de p nmeros).

La SVM busca un hiperplano que separe de forma ptima a los puntos de una clase de la de otra, que eventualmente

han podido ser previamente proyectados a un espacio de dimensionalidad superior.

En ese concepto de "separacin ptima" es donde reside la caracterstica fundamental de las SVM: este tipo de

algoritmos buscan el hiperplano que tenga la mxima distancia (margen) con los puntos que estn ms cerca de l

mismo. Por eso tambin a veces se les conoce a las SVM como clasificadores de margen mximo. De esta forma, los

puntos del vector que se etiquetados con una categora estarn a un lado del hiperplano y los casos que se encuentren

en la otra categora estarn al otro lado.

Los algoritmos SVM pertenecen a la familia de los clasificadores lineales. Tambin pueden ser considerados un caso

especial de la regularizacin de Tikhonov.

En la literatura de los SVMs, se llama atributo a la variable predictora y caracterstica a un atributo transformado

que es usado para definir el hiperplano. La eleccin de la representacin ms adecuada del universo estudiado, se

realiza mediante un proceso denominado seleccin de caractersticas.

Al vector formado por los puntos ms cercanos al hiperplano se le llama vector de soporte.

Los modelos basados en SVMs estn estrechamente relacionados con las redes neuronales. Usando una funcin

kernel, resultan un mtodo de entrenamiento alternativo para clasificadores polinomiales, funciones de base radial y

perceptrn multicapa.

Mquinas de vectores de soporte

2

Ejemplo en 2dimensiones

En el siguiente ejemplo idealizado para 2-dimensiones, la representacin de los datos a clasificar se realiza en el

plano x-y. El algoritmo SVM trata de encontrar un hiperplano 1-dimensional (en el ejemplo que nos ocupa es una

lnea) que une a las variables predictoras y constituye el lmite que define si un elemento de entrada pertenece a una

categora o a la otra.

Existe un nmero infinito de posibles hiperplanos (lneas) que realicen la clasificacin pero, cul es la mejor y

cmo la definimos?

La mejor solucin es aquella que permita un margen mximo entre los elementos de las dos categoras.

Se denominan vectores de soporte a los puntos que conforman las dos lneas paralelas al hiperplano, siendo la

distancia entre ellas (margen) la mayor posible.

Soft margin: Errores de entrenamiento

Idealmente, el modelo basado en SVM debera producir un hiperplano que separe completamente los datos del

universo estudiado en dos categoras. Sin embargo, una separacin perfecta no siempre es posible y, si lo es, el

resultado del modelo no puede ser generalizado para otros datos. Esto se conoce como sobreajuste (overfitting).

Con el fin de permitir cierta flexibilidad, los SVM manejan un parmetro C que controla la compensacin entre

errores de entrenamiento y los mrgenes rgidos, creando as un margen blando (soft margin) que permita algunos

errores en la clasificacin a la vez que los penaliza.

Funcin Kernel

La manera ms simple de realizar la separacin es mediante una lnea recta, un plano recto o un hiperplano

N-dimensional.

Desafortunadamente los universos a estudiar no se suelen presentar en casos idlicos de dos dimensiones como en el

ejemplo anterior, sino que un algoritmo SVM debe tratar con a) ms de dos variables predictoras, b) curvas no

lineales de separacin, c) casos donde los conjuntos de datos no pueden ser completamente separados, d)

clasificaciones en ms de dos categoras.

Debido a las limitaciones computacionales de las mquinas de aprendizaje lineal, stas no pueden ser utilizadas en la

mayora de las aplicaciones del mundo real. La representacin por medio de funciones Kernel ofrece una solucin a

este problema, proyectando la informacin a un espacio de caractersticas de mayor dimensin el cual aumenta la

capacidad computacional de la mquinas de aprendizaje lineal. Es decir, mapearemos el espacio de entradas X a un

nuevo espacio de caractersticas de mayor dimensionalidad (Hilbert):

F = {(x)|x X}

Mquinas de vectores de soporte

3

x = {x1, x2, , xn} (x) = {(x)1, (x)2, , (x)n}

Tipos de funciones Kernel (Ncleo)

Polinomial-homognea: K(x

i

, x

j

) = (x

i

x

j

)

n

Perceptron: K(x

i

, x

j

)= || x

i

-x

j

||

Funcin de base radial Gaussiana: separado por un hiperplano en el espacio transformado.

K(x

i

, x

j

)=exp(-(x

i

-x

j

)

2

/2(sigma)

2

)

Sigmoid: K(x

i

, x

j

)=tanh(x

i

x

j

)

Mquinas de vectores de soporte

4

SVR. Regresin

Una nueva versin de SVM para regresin fue propuesta en 1996 por Vladimir Vapnik, Harris Drucker, Chris

Burges, Linda Kaufman y Alex Smola.[nota].

La idea bsica de SVR consiste en realizar un mapeo de los datos de entrenamiento x X, a un espacio de mayor

dimensin F a travs de un mapeo no lineal : X F , donde podemos realizar una regresin lineal.

SVM Multiclase

Hay dos filosofas bsicas para resolver el problema de querer clasificar los datos en ms de dos categoras:

a) cada categora es dividida en otras y todas son combinadas.

b) se contruyen k(k-1) / 2 modelos donde k es el nmero de categoras.

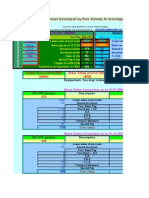

Comparativa SVM vs ANN

La siguiente tabla muestra una comparativa entre las redes neuronales artificales y los algoritmos SVM.

Mquinas de vectores de soporte

5

Enlaces externos

(en ingls) [1], DTREG, Software For Predictive Modeling and Forecasting

(en ingls) [2], Electronic Statistics Textbook

(pdf) [3], curso sobre decisin, estamacin y clasificacin.

(en ingls) www.kernel-machines.org

[4]

, informacin general y material de investigacin.

(en ingls) www.support-vector.net

[5]

, novedades, enlace y cdigos relacionados con las mquinas de soporte

vectorial.

(en ingls) SVM light

[6]

, implementacin de SVM, con variantes para aprendizaje supervisado, y para

semisupervisado transductivo. Liberado para investigacin.

(en ingls) SVMlin

[7]

, otra implementacin de SVM. Liberado bajo licencia GPL.

Referencias

[1] http:/ / www. dtreg. com/ svm. htm

[2] http:/ / www. statsoft. com/ textbook/ support-vector-machines

[3] http:/ / www. gts.tsc. uvigo.es/ ~jalba/ doctorado/ SVM. pdf

[4] http:/ / www. kernel-machines.org

[5] http:/ / www. support-vector.net

[6] http:/ / svmlight. joachims.org/

[7] http:/ / people. cs. uchicago. edu/ ~vikass/ svmlin.html

Fuentes y contribuyentes del artculo

6

Fuentes y contribuyentes del artculo

Mquinas de vectores de soporte Fuente: http://es.wikipedia.org/w/index.php?oldid=41704475 Contribuyentes: AlfonsoERomero, Bogorchu, CommonsDelinker, Digigalos, Elisfm,

Gdiazvaldes, Gdiazvaldes2, Juangpc, Lebidario, Matdrodes, Pinar, Pintaio, Rosarinagazo, TXiKi, Tano4595, 6 ediciones annimas

Fuentes de imagen, Licencias y contribuyentes

Archivo:Svm 4.JPG Fuente: http://es.wikipedia.org/w/index.php?title=Archivo:Svm_4.JPG Licencia: Public Domain Contribuyentes: User:Elisfm

Archivo:Svm 8 polinomial.JPG Fuente: http://es.wikipedia.org/w/index.php?title=Archivo:Svm_8_polinomial.JPG Licencia: Public Domain Contribuyentes: User:Elisfm

Archivo:Svm 10 perceptron.JPG Fuente: http://es.wikipedia.org/w/index.php?title=Archivo:Svm_10_perceptron.JPG Licencia: Public Domain Contribuyentes: User:Elisfm

Archivo:Svm 9 gaussiano sigma.JPG Fuente: http://es.wikipedia.org/w/index.php?title=Archivo:Svm_9_gaussiano_sigma.JPG Licencia: Public Domain Contribuyentes: User:Elisfm

Archivo:Svm 11 comparativa.JPG Fuente: http://es.wikipedia.org/w/index.php?title=Archivo:Svm_11_comparativa.JPG Licencia: Public Domain Contribuyentes: User:Elisfm

Licencia

Creative Commons Attribution-Share Alike 3.0 Unported

http:/ / creativecommons. org/ licenses/ by-sa/ 3. 0/

También podría gustarte

- Manual Sublime TextDocumento50 páginasManual Sublime TextolgerbeliAún no hay calificaciones

- Examen Certificacion CCNA Securit Por ResolverDocumento17 páginasExamen Certificacion CCNA Securit Por ResolverolgerbeliAún no hay calificaciones

- Parcial Redes Reuronales 2021-2Documento7 páginasParcial Redes Reuronales 2021-2ISABELLA SUSANA CABALLERO MORENOAún no hay calificaciones

- PythonDL Parte4 PDFDocumento161 páginasPythonDL Parte4 PDFMariaOtiliaCañonAún no hay calificaciones

- Redes de Neuronas Artificiales Isasi-Galvan PDFDocumento240 páginasRedes de Neuronas Artificiales Isasi-Galvan PDFEmmanuel VulfersthawiskyAún no hay calificaciones

- 6th Central Pay Commission Salary CalculatorDocumento15 páginas6th Central Pay Commission Salary Calculatorrakhonde100% (436)

- Configurar El Scanner para Tamaño A4 Ó Carta en Canon Prixma E400 SeriesDocumento1 páginaConfigurar El Scanner para Tamaño A4 Ó Carta en Canon Prixma E400 SeriesolgerbeliAún no hay calificaciones

- Generar Diagrama Entidad Relación de Una Base de Datos MySQL WorkbenchDocumento9 páginasGenerar Diagrama Entidad Relación de Una Base de Datos MySQL WorkbencholgerbeliAún no hay calificaciones

- Generar Diagrama Entidad Relación de Una Base de Datos MySQL WorkbenchDocumento9 páginasGenerar Diagrama Entidad Relación de Una Base de Datos MySQL WorkbencholgerbeliAún no hay calificaciones

- Generar Diagrama Entidad Relación de Una Base de Datos MySQL WorkbenchDocumento9 páginasGenerar Diagrama Entidad Relación de Una Base de Datos MySQL WorkbencholgerbeliAún no hay calificaciones

- Caso de Estudio en ChinaDocumento1 páginaCaso de Estudio en ChinaolgerbeliAún no hay calificaciones

- Muestra Del Comando Rand en Word 2013Documento25 páginasMuestra Del Comando Rand en Word 2013gaithiacAún no hay calificaciones

- Configurar El Scanner para Tamaño A4 Ó Carta en Canon Prixma E400 SeriesDocumento1 páginaConfigurar El Scanner para Tamaño A4 Ó Carta en Canon Prixma E400 SeriesolgerbeliAún no hay calificaciones

- CCNA Security CorregirDocumento20 páginasCCNA Security CorregirolgerbeliAún no hay calificaciones

- CCNA SecuriDocumento18 páginasCCNA SecuriolgerbeliAún no hay calificaciones

- Configuración Modem ZyXEL P660HWDocumento6 páginasConfiguración Modem ZyXEL P660HWolgerbeliAún no hay calificaciones

- Configurar El Scanner para Tamaño A4 Ó Carta en Canon Prixma E400 SeriesDocumento1 páginaConfigurar El Scanner para Tamaño A4 Ó Carta en Canon Prixma E400 SeriesolgerbeliAún no hay calificaciones

- Pasos de Instalacion Del Plugin para Los ArchivosDocumento3 páginasPasos de Instalacion Del Plugin para Los ArchivosolgerbeliAún no hay calificaciones

- Algoritmo Máquina de Vectores de SoporteDocumento6 páginasAlgoritmo Máquina de Vectores de SoporteolgerbeliAún no hay calificaciones

- Configuracion Router CiscoDocumento3 páginasConfiguracion Router CiscoJonathan Huera ParedesAún no hay calificaciones

- InstaLacion Usb s10Documento4 páginasInstaLacion Usb s10olgerbeliAún no hay calificaciones

- 1.0.1.2 Network by Design InstructionsDocumento1 página1.0.1.2 Network by Design InstructionsDiego AlejandroAún no hay calificaciones

- 1.2.1.7 Packet Tracer - Comparing 2960 and 3560 Switches InstructionsDocumento3 páginas1.2.1.7 Packet Tracer - Comparing 2960 and 3560 Switches InstructionsCarlosAún no hay calificaciones

- Convenciones de Codigo para Java PDFDocumento28 páginasConvenciones de Codigo para Java PDFOmar OrdóñezAún no hay calificaciones

- Convenciones de Codigo para Java PDFDocumento28 páginasConvenciones de Codigo para Java PDFOmar OrdóñezAún no hay calificaciones

- 1.3.1.3 Packet Tracer - Skills Integration Challenge InstructionsDocumento1 página1.3.1.3 Packet Tracer - Skills Integration Challenge Instructionsrieracar79Aún no hay calificaciones

- 1.2.1.7 Packet Tracer - Comparación Entre Los Switches 2960 y 3560Documento3 páginas1.2.1.7 Packet Tracer - Comparación Entre Los Switches 2960 y 3560Zaskya Yissellmitth Cordoba DelisserAún no hay calificaciones

- Crear Un CDDVD, BootableAutoarrancable Con UltraISODocumento18 páginasCrear Un CDDVD, BootableAutoarrancable Con UltraISOolgerbeliAún no hay calificaciones

- Proyecto de Mineria de Datos Con Analysis Services V 3Documento73 páginasProyecto de Mineria de Datos Con Analysis Services V 3olgerbeliAún no hay calificaciones

- Capítulo 1 Módulo 2 CCNA CiscoDocumento7 páginasCapítulo 1 Módulo 2 CCNA CiscoRoberto Vargas BrachoAún no hay calificaciones

- Practica IIDocumento1 páginaPractica IIolgerbeliAún no hay calificaciones

- Lenguajes de ProgramacionDocumento7 páginasLenguajes de ProgramacionolgerbeliAún no hay calificaciones

- NN3 BackpropagationDocumento25 páginasNN3 BackpropagationLeonardo MatteraAún no hay calificaciones

- Gustavo 07 - Redes Neuronales MatlabDocumento4 páginasGustavo 07 - Redes Neuronales MatlabscribdjjlcAún no hay calificaciones

- Tutorial de Redes Neuronales Aplicadas A La Ingeniería EléctricaDocumento19 páginasTutorial de Redes Neuronales Aplicadas A La Ingeniería EléctricasaraAún no hay calificaciones

- PythonDL Parte3 PDFDocumento121 páginasPythonDL Parte3 PDFMariaOtiliaCañonAún no hay calificaciones

- Preguntas SVM MESAPDocumento59 páginasPreguntas SVM MESAPmarcoruiztorresAún no hay calificaciones

- ADABOOSTDocumento48 páginasADABOOSTMaria LopezAún no hay calificaciones

- 1er Challenge ResueltoDocumento12 páginas1er Challenge ResueltoGiancarlo Aguado100% (1)

- Perceptron Separador LinealDocumento11 páginasPerceptron Separador LinealJonathan Arana MoraAún no hay calificaciones

- Big Data Con Python 2 9Documento1 páginaBig Data Con Python 2 9PoeAún no hay calificaciones

- 9 15RN Con Sklearn 1Documento18 páginas9 15RN Con Sklearn 1Britney MacedoAún no hay calificaciones

- Algoritmo Id3Documento4 páginasAlgoritmo Id3francly11Aún no hay calificaciones

- C6 Perceptron Multicapa Parte 3Documento61 páginasC6 Perceptron Multicapa Parte 3Cinthia CrucesAún no hay calificaciones

- YOLO CheckpointDocumento9 páginasYOLO CheckpointLauraCamilaDuqueAún no hay calificaciones

- Redes NeuronalesDocumento4 páginasRedes Neuronalesuaeh_blogAún no hay calificaciones

- Redes Neuronales Con MatlabDocumento4 páginasRedes Neuronales Con MatlabalbocoAún no hay calificaciones

- 02 K Vecinos Mas Cercanos Ejercicio Propuesto - Jupyter NotebookDocumento8 páginas02 K Vecinos Mas Cercanos Ejercicio Propuesto - Jupyter NotebookJIMMY CRISTHIAN CJURO APAZAAún no hay calificaciones

- Y Redes Neuronales 6Documento31 páginasY Redes Neuronales 6Carolina Flores VillalbaAún no hay calificaciones

- 6RN Con Sklearn 3Documento38 páginas6RN Con Sklearn 3VictorAún no hay calificaciones

- PerceptronDocumento12 páginasPerceptronKandel YandarAún no hay calificaciones

- Código Java - Perceptrón Multicapa. Propagación Hacia AtrásDocumento3 páginasCódigo Java - Perceptrón Multicapa. Propagación Hacia AtrásIván PeraltaAún no hay calificaciones

- Capitulo2 BackpropagationDocumento39 páginasCapitulo2 BackpropagationArmando Miguel Brito CriadoAún no hay calificaciones

- Modelo de RegresiónDocumento8 páginasModelo de RegresiónOmar Fernando Granados VergaraAún no hay calificaciones

- Mapa MentalDocumento1 páginaMapa MentalCarlos David Reales CardilesAún no hay calificaciones

- 03 Clustering DBSCANDocumento52 páginas03 Clustering DBSCANJuan OrtegaAún no hay calificaciones

- AdaBoost For Feature Selection - Presentacion Lucas LangwagenDocumento20 páginasAdaBoost For Feature Selection - Presentacion Lucas Langwagennoe lopezAún no hay calificaciones

- Red Neuronal Perceptron MulticapaDocumento21 páginasRed Neuronal Perceptron MulticapaJair Vázquez PalmaAún no hay calificaciones

- Examen SolucionesDocumento8 páginasExamen SolucionesJesus Romero MirandaAún no hay calificaciones