Documentos de Académico

Documentos de Profesional

Documentos de Cultura

2º Asignacion Redes Neuronales

Cargado por

Alfredo Martinez VelardeTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

2º Asignacion Redes Neuronales

Cargado por

Alfredo Martinez VelardeCopyright:

Formatos disponibles

INTRODUCCIN A LA INVESTIGACION DE OPERACIONES

A2 - G4

Tema: REDES NEURONALES Y SU APLICACIN EN LA MINERIA Ph.D. AGREDA TURRIATE, Carlos

Facultad: F.I.G.M.M.

INTEGRANTES: - MARTINEZ VELARDE,Alfredo - MELENDEZ HUAMAN, Omar - DE LA CRUZ ORDOEZ, David - PANEZ DELGADO, Wilder - ROJAS CRISTOBAL, Oscar

2014

REDES NEURONALES ARTIFICIALES YSUS APLICACIONES A LA MINERIA SUPERFICIAL

Tabla de Contenidos

TEMA 1.- INTRODUCCIN A LA COMPUTACIN NEURONAL

TEMA 2.- FUNDAMENTOS DE LAS REDES NEURONALES ARTIFICIALES

TEMA 3.- SELECCIN DE LAS REDES NEURONALES ARTIFICIALES

TEMA 4: RED NEURONAL

TEMA 5: APRENDIZAJE

TEMA 6: APLICACIN DE LAS REDES NEURONALES

ANEXO

ANALISIS DE RESULTADOS

CONCLUSIONES

BIBLIOGRAFIA

TEMA 1: INTRODUCCIN A LA COMPUTACIN NEURONAL INTRODUCCIN El cerebro humano es el sistema de clculo ms complejo que conoce el hombre. Elordenador y el hombre realizan bien diferentes clases de tareas; as la operacin dereconocer el rostro de una persona resulta una tarea relativamente sencilla para elhombre y difcil para el ordenador, mientras que la contabilidad de una empresa es tareacostosa para un experto contable y una sencilla rutina para un ordenador bsico. La capacidad del cerebro humano de pensar, recordar y resolver problemas ha inspiradoa muchos cientficos intentar o procurar modelar en el ordenador el funcionamiento delcerebro humano. Los profesionales de diferentes campos como la ingeniera, filosofa, fisiologa ypsicologa han unido sus esfuerzos debido al potencial que ofrece esta tecnologa yestn encontrando diferentes aplicaciones en sus respectivas profesiones. Un grupo de investigadores ha perseguido la creacin de un modelo en el ordenador queiguale o adopte las distintas funciones bsicas del cerebro. El resultado ha sido unanueva tecnologa llamada Computacin Neuronal o tambin Redes NeuronalesArtificiales. El resurgimiento del inters en esta nueva forma de realizar los clculos tras dosdcadas de olvido se debe al extraordinario avance y xito tanto en el aspecto tericocomo de aplicacin que se est obteniendo estos ltimos aos. Las Redes Neuronales (NN: Neural Networks) fueron originalmente una simulacin abstracta de los sistemas nerviosos biolgicos, constituidos por un conjunto de unidades llamadas neuronas o nodos conectados unos con otros. El primer modelo de red neuronal fue propuesto en 1943 por McCulloch y Pitts en trminos de un modelo computacional de actividad nerviosa. Este modelo era un modelo binario, donde cada neurona tena un escaln o umbral prefijado, y sirvi de base para los modelos posteriores. Una primera clasificacin de los modelos de NN es: 1. Modelos inspirados en la Biologa: Estos comprenden las redes que tratan de simular los sistemas neuronales biolgicos, as como ciertas funciones como las auditivas o de visin. 2. Modelos artificiales aplicados: Estos modelos no tienen por qu guardar similitud estricta con los sistemas biolgicos. Sus arquitecturas estn bastante ligadas a las necesidades de las aplicaciones para las que son diseados. CARACTERSTICAS DE LAS REDES NEURONALES ARTIFICIALES Las Redes Neuronales Artificiales, ANN (Artificial Neural Networks) estn inspiradasen las redes neuronales biolgicas del cerebro humano. Estn constituidas porelementos que se comportan de forma similar a la neurona biolgica en sus funcionesms comunes. Estos elementos estn organizados de una forma parecida a la quepresenta el cerebro humano. Las ANN al margen de "parecerse" al cerebro presentan una serie de caractersticaspropias del cerebro. Por ejemplo las ANN aprenden de la experiencia, generalizan deejemplos previos a ejemplos nuevos y abstraen las caractersticas principales de unaserie de datos. Aprender: adquirir el conocimiento de una cosa por medio del estudio, ejercicioo experiencia. Las ANN pueden cambiar su comportamiento en funcin del entorno. Seles muestra un conjunto de entradas y ellas mismas se ajustan para producir unas salidasconsistentes. Generalizar: extender o ampliar una cosa. Las ANN generalizanautomticamente debido a su propia estructura y naturaleza. Estas redes pueden ofrecer,dentro de un margen, respuestas

correctas a entradas que presentan pequeasvariaciones debido a los efectos de ruido o distorsin. Abstraer: aislar mentalmente o considerar por separado las cualidades de unobjeto. Algunas ANN son capaces de abstraer la esencia de un conjunto de entradas queaparentemente no presentan aspectos comunes o relativos. ESTRUCTURA BSICA DE UNA RED NEURONAL Analoga con el cerebro.La neurona es la unidad fundamental del sistema nervioso y en particular del cerebro.Cada neurona es una simple unidad procesadora que recibe y combina seales desde yhacia otras neuronas. Si la combinacin de entradas es suficientemente fuerte la salidade la neurona se activa. La Figura muestra las partes que constituyen una neurona.

Figura - Componentes de una Neurona. El cerebro consiste en uno o varios billones de neuronas densamente interconectadas.El axn (salida) de la neurona se ramifica y est conectada a las dendritas (entradas) deotras neuronas a travs de uniones llamadas sinapsis. La eficacia de la sinapsis esmodificable durante el proceso de aprendizaje de la red. Redes Neuronales Artificiales.En las Redes Neuronales Artificiales, ANN, la unidad anloga a la neurona biolgica es el elemento procesador, PE (process element). Un elemento procesador tiene variasentradas y las combina, normalmente con una suma bsica. La suma de las entradas esmodificada por una funcin de transferencia y el valor de la salida de esta funcin detransferencia se pasa directamente a la salida del elemento procesador. La salida del PE se puede conectar a las entradas de otras neuronas artificiales (PE)mediante conexiones ponderadas correspondientes a la eficacia de la sinapsis de lasconexiones neuronales. La Figura representa un elemento procesador de una red neuronal artificialimplementada en un ordenador.

Figura - Diagrama de una Neurona Artificial (PE). Una red neuronal consiste en un conjunto de unidades elementales PE conectadas deuna forma concreta. El inters de las ANN no reside solamente en el modelo delelemento PE sino en las formas en que se conectan estos elementos procesadores.Generalmente los elementos PE estn organizados en grupos llamados niveles o capas.Una red tpica consiste en una secuencia de capas con conexiones entre capasadyacentes consecutivas. Existen dos capas con conexiones con el mundo exterior. Una capa de entrada, buffer deentrada, donde se presentan los datos a la red, y una capa buffer de salida que mantienela respuesta de la red a una entrada. El resto de las capas reciben el nombre de capasocultas. La Figura (1.3) muestra el aspecto de una Red Neuronal Artificial.

Figura - Arquitectura de una Red Neuronal Simple. COMPUTACIN TRADICIONAL Y COMPUTACINNEURONAL Programacin/Entrenamiento.Las tcnicas tradicionales de programacin utilizadas para la solucin de un problemarequieren la creacin de un algoritmo. Un algoritmo consiste en una secuencia deinstrucciones que indica el modo en el que debe proceder el sistema basado en unordenador para lograr el fin perseguido que es la resolucin del problema. El diseo de una secuencia de instrucciones para resolver un problema de contabilidades relativamente sencillo, mientras que existen muchos problemas del mundo real en losque resulta difcil realizar un algoritmo que resuelva dichos problemas. Por ejemploimaginemos desarrollar un programa para cualquiera de los problemas dereconocimiento de imgenes como el rostro de una persona. Hay muchas variaciones dela imagen de una persona, como que presente un rostro serio o un rostro alegre,variaciones en general que deben tenerse en cuenta a la hora de disear el algoritmo.

Las ANN, a diferencia de los algoritmos que son instrucciones previamenteprogramadas, deben ser previamente entrenadas. Esto significa que a la red se lemuestra en su capa de entrada unos ejemplos y ella misma se ajusta en funcin dealguna regla de aprendizaje. Arquitectura.Las ANN presentan una arquitectura totalmente diferente de los ordenadorestradicionales de un nico procesador. Las mquinas tradicionales basadas en el modelode Von Neuman tienen un nico elemento procesador, la CPU (Control Process Unit) que realiza todos los clculos ejecutando todas las instrucciones de la secuenciaprogramada en el algoritmo. Cualquier CPU realiza ms de cien comandos bsicos,incluyendo sumas, restas, y desplazamientos entre otros. Los comandos o instrucciones se ejecutan secuencialmente y sincronizadas con el relojdel sistema. Sin embargo en los sistemas de computacin neuronal cada elemento PEslo puede realizar uno, o como mucho, varios clculos. La potencia del procesado delas ANN se mide principalmente por el nmero de interconexiones actualizadas porsegundo durante el proceso de entrenamiento o aprendizaje. Sin embargo las mquinasde Von Neuman se miden por el nmero de instrucciones que ejecuta por segundo elprocesador central CPU. La arquitectura de las ANN parte de la organizacin de los sistemas de procesado enparalelo, es decir, sistemas en los que distintos procesadores estn interconectados. Noobstante los procesadores son unidades procesadoras simples, diseadas para la suma demuchas entradas y con un ajuste automtico de las conexiones ponderadas. Sistemas Expertos.Los sistemas expertos difieren de la programacin tradicional en que la base delconocimiento est separada del motor de inferencia (el mtodo del procesado delconocimiento). Esta caracterstica permite que todo el conocimiento adicional pueda seraadido al sistema sin necesidad de tener que ser reprogramado todo el sistema. Estatcnica requiere que exista una persona experta en un rea y que se puedan crear reglasque codifiquen el conocimiento. En el desarrollo de una red neuronal no hay que programar ni el conocimiento ni lasreglas del procesamiento del conocimiento. La red neuronal aprende las reglas delprocesamiento del conocimiento mediante el ajuste de las conexiones ponderadas entrelas neuronas de distintas capas de la red. Mientras que en los Sistemas Expertos el conocimiento se hace explcito en forma dereglas, en la computacin neuronal las ANN generan sus propias reglas aprendiendo delos ejemplos que se les muestran en la fase de entrenamiento. El aprendizaje se consiguea travs de una regla de aprendizaje que adapta o cambia los pesos de las conexiones enrespuesta a los ejemplos de entrada, y opcionalmente tambin en respuesta a las salidasdeseadas. Esta caracterstica de las ANN es lo que permite decir que las redesneuronales aprenden de la experiencia. Una caracterstica importante de las ANN es la forma o el modo en que se almacena lainformacin. La memoria o el conocimiento de estas redes estndistribuidos a lo largo detodas las conexiones ponderadas de la red. Algunas ANN presentan la caracterstica de ser "asociativas" que significa que para unaentrada parcial la red elegir la entrada ms parecida en memoria y generar una salidaque corresponda a la entrada completa. La naturaleza de la memoria de las ANN permite que la red responda adecuadamentecuando se le presenta una entrada incompleta o con ruido. Esta propiedad suele serreferida como la capacidad de "generalizacin". Otra caracterstica de las ANN es la tolerancia a la falta (Fault Tolerance). Tolerancia ala falta se refiere al hecho de que en muchas ANN si resultaran destruidos varioselementos

procesadores PE, o se alteraran las conexiones el comportamiento de la redsera mnimamente modificado. El comportamiento vara pero el sistema no sedescompone o deja de funcionar. Esta caracterstica se debe a que las ANN tienen la informacin distribuida a lo largo detoda la red y no est contenida en un nico lugar.

HISTORIA DE LA COMPUTACIN NEURONAL En 1943, el neurobilogo Warren McCulloch, y el estadstico Walter Pitss, publicaron el artculo "A logical calculus of Ideas Imminent in Nervous Activity". Este artculoconstituy la base y el inicio del desarrollo en diferentes campos como son losOrdenadores Digitales (John Von Neuman), la Inteligencia Artificial (Marvin Minskycon los Sistemas Expertos) y el funcionamiento del ojo (Frank Rosenblatt con la famosa red llamada Perceptron). En 1956, los pioneros de la Inteligencia Artificial, Minsky, McCarthy, Rochester,Shanon, organizaron la primera conferencia de Inteligencia Artificial que fuepatrocinada por la Fundacin Rochester. Esta conferencia se celebr en el verano de1956 en la localidad inglesa de Darmouth y en muchos libros se hace referencia alverano de este ao como la primera toma de contacto seria con las redes neuronalesartificiales. Nathaural Rochester del equipo de investigacin de IBM present el modelo de una redneuronal que l mismo realiz y puede considerarse como el primer software desimulacin de redes neuronales artificiales. En 1957, Frank Rosenblatt public el mayor trabajo de investigacin en computacinneuronal realizado hasta esas fechas. Su trabajo consista en el desarrollo de unelemento llamado "Perceptron". El perceptron es un sistema clasificador de patrones que puede identificar patronesgeomtricos y abstractos. El primer perceptron era capaz de aprender algo y era robusto,de forma que su comportamiento variaba slo si resultaban daados los componentesdel sistema. Adems presentaba la caracterstica de ser flexible y comportarsecorrectamente despus de que algunas celdas fueran destruidas. El perceptron fue originalmente diseado para el reconocimiento ptico de patrones.Una rejilla de 400 fotoclulas, correspondientes a las neuronas de la retina sensibles a la luz, recibe el estmulo ptico. Estas fotoclulas estn conectadas a elementosasociativos que recogen los impulsos elctricos emitidos desde las fotoclulas. Lasconexiones entre los elementos asociativos y las fotoclulas se realizan de forma aleatoria. Si las clulas presentan un valor de entrada superior a un umbral predeterminadoentonces el elemento asociativo produce una salida. La Figura (1.4) presenta laestructura de la red perceptron.

Figura - Aplicacin de la Red Perceptron.

El perceptron presenta algunas limitaciones debido a que se trataba de un dispositivo en desarrollo. La mayor limitacin la reflejaron Minsky y Papert aos ms tarde, y ponande manifiesto la incapacidad del perceptron en resolver algunas tareas o problemas sencillos como por ejemplo la funcin lgica OR exclusivo. Uno de los mayores cambios realizados en el perceptron de Rossenblatt a lo largo de ladcada de los 60 ha sido el desarrollo de sistemas multicapa que pueden aprender ycategorizar datos complejos. En 1959, Bernard Widrow en Stanford desarroll un elemento adaptativo lineal llamado "Adaline" (Adaptive Linear Neuron). La Adaline y una versin de dos capas, llamada "Madaline", fueron utilizadas en distintas aplicaciones como reconocimiento de voz ycaracteres, prediccin del tiempo, control adaptativo y sobre todo en el desarrollo defiltros adaptativos que eliminen los ecos de las lneas telefnicas. A mediados de los aos 60, Minsky y Papert pertenecientes al Laboratorio deInvestigacin de Electrnica del MIT (Massachussets Institute Technology) comenzaron un trabajo profundo de crtica al perceptron. El resultado de este trabajo, el libro Perceptrons, era un anlisis matemtico del concepto del perceptron. La conclusin deeste trabajo, que se transmiti a la comunidad cientfica del mundo entero, es que elPerceptron y la Computacin Neuronal no eran temas interesantes que estudiar ydesarrollar. A partir de este momento descendieron drsticamente las inversiones en lainvestigacin de la computacin neuronal. Uno de los pocos investigadores que continuaron con su trabajo en la computacinneuronal tras la publicacin del libro Perceptrons fue James Anderson. Su trabajo sebas en el desarrollo de un modelo lineal que consiste en un modelo asociativodistribuido basado en el principio de Hebb (las conexiones son reforzadas cada vez queson activadas las neuronas). Una versin extendida de este modelo lineal es el llamado modelo Brain-State-in- a Box (BSB). Teuvo Kohonen, de la Universidad de Helsinki, es uno de los mayores impulsores de lacomputacin neuronal de la dcada de los 70. De su trabajo de investigacin destacandos aportaciones: la primera es la descripcin y anlisis de una clase grande de reglasadaptativas, reglas en las que las conexiones ponderadas se modifican de una formadependiente de los valores anteriores y posteriores de las sinapsis. Y la segundaaportacin es el principio de aprendizaje competitivo en el que los elementos compitenpor responder a un estmulo de entrada, y el ganador se adapta l mismo para responderOtro investigador que continu con su trabajo de investigacin en el mundo de lacomputacin neuronal a pesar del mal presagio que indicaron Minsky y Papert fue Stephen Grossberg. Grossberg estaba especialmente interesado en la utilizacin de datosde la neurologa para construir modelos de computacin neuronal. La mayora de susreglas y postulados derivaron de estudios fisiolgicos. Su trabajo ha constituido un granimpulso en la investigacin del diseo y construccin de modelos neuronales. Una deestas clases de redes es la Adaptive Resonance Theory(ART). En 1982 John Hopfield con la publicacin del artculo Hopfield Modelo Crossbar Associative Network, junto con la invencin del algoritmo Back propagation se consigui devolver el inters y la confianza en el fascinante campo de la computacinneuronal tras dos dcadas de casi absoluta inactividad y desinters. Hopfield presenta un sistema de computacin neuronal consistente en elementosprocesadores interconectados que buscan y tienden a un mnimo de energa. Esta redcon este tipo de funcin de energa y mecanismo de respuesta no es ms que un caso dela clase genrica de redes que consider Grossberg. Investigacin de hoy en da.Existen muchos grupos con sede en diferentes universidades de todo el mundo que estnrealizando trabajos de investigacin en el rea de las redes neuronales artificiales. Cada grupo tiene diferente nfasis y motivacin con los neurlogos, psiclogos delconocimiento,

fsicos, programadores y matemticos. Todos ellos ofrecen nuevospuntos de vista e intuiciones en esta rea de la tcnica. Grossberg continua trabajando en compaa de Carpenter en la Universidad de Boston, mientras Teuvo Kohonen est en la Universidad de Helsinki. Uno de los mayoresgrupos de investigacin de los ltimos aos ha sido el grupo PDP (Parallel Distributed Processing) formado por Rumelhart, McClelland y Hinton. Rumelhart de la Universidad de Stanford es uno de los principales impulsores de la redms utilizada en la mayora de las aplicaciones actuales, la famosa red neuronal Backpropagation. En la Universidad de Carnegie-Mellon, el grupo de investigacin a la cabeza con McClelland destaca por el estudio de las posibles aplicaciones de la Backpropagation. Y en la Universidad de Toronto, Hinton y Sejnowski han desarrollado una mquina llamada Boltzman que consiste en la red de Hopfield con dos modificaciones significativas. Bart Kosko ha diseado una red llamada BAM (Bidirectional Associate Memory) basado en la red de Grossberg. Por ltimo indicar la existencia de grandes grupos deinvestigacin como los de California Institute of Technology, MassachussetsInstitute of Technology, University of California Berkeley y University of California San Diego. Conviene no olvidar el esfuerzo econmico y tcnico que estn realizando las empresasprivadas tanto en USA como en Japn y en la Comunidad Econmica Europea. Comobotn de muestra de las inversiones en estos pases baste conocer que slo en USA segasta ms de 100 millones de dlares al ao.

TEMA 2: FUNDAMENTOS DE LAS REDESNEURONALES ARTIFICIALES EL PROTOTIPO BIOLGICO Se estima que el cerebro humano contiene ms de cien mil millones ( ) de neuronas y sinapsis en el sistema nervioso. Los estudios realizados sobre la anatoma del cerebrohumano concluyen que hay, en general, ms de 1000 sinapsis por trmino medio a la entrada y a la salida de cada neurona. Se define neurona como un tipo de clulas del sistema nervioso cuya principal funcin es la excitabilidad elctrica de su membrana plasmtica; estn especializadas en la recepcin de estmulos y conduccin del impulso nervioso (en forma de potencial de accin) entre ellas o con otros tipos celulares, como por ejemplo las fibras musculares de la placa motora. Altamente diferenciadas, la mayora de las neuronas no se dividen una vez alcanzada su madurez; no obstante, una minora s lo hace. Las neuronas presentan una caractersticas morfolgicas tpicas que sustentan sus funciones: un cuerpo celular llamado soma central; una o varias prolongaciones cortas que generalmente transmiten impulsos hacia el soma celular, denominadas dendritas; y una prolongacin larga, denominada axn que conduce los impulsos desde el soma hacia otra neurona u rgano diana Se define a sinapsis como una unin (funcional) intercelular especializada entre neuronas o entre una neurona y una clula efectora. En estos contactos se lleva a cabo la transmisin del impulso nervioso. ste se inicia con una descarga qumica que origina una corriente elctrica en la membrana de la clula presinptica (clula emisora); una vez que este impulso nervioso alcanza el extremo del axn (la conexin con la otra clula), la propia neurona segrega un tipo de compuestos qumicos que se depositan en el espacio sinptico (espacio intermedio entre esta neurona transmisora y la neurona postsinptica o receptora). Estas sustancias segregadas o neurotransmisoras son los encargados de excitar o inhibir la accin de la otra clula llamada clula post sinptica. Aunque el tiempo de conmutacin de las neuronas biolgicas (unos pocos milisegundos) es casi un milln de veces mayor que en las actuales componentes de las computadoras, lasneuronas naturales tienen una conectividad miles de veces superior a la de las artificiales.

El objetivo principal de las redes neuronales de tipo biolgico es desarrollar operaciones de sntesis y procesamiento de informacin, relacionadas con los sistemas biolgicos.

Figura - Componentes de una Neurona. Las neuronas y las conexiones entre ellas (sinapsis) constituyen la clave para el procesado de la informacin. La mayor parte de las neuronas poseen una estructura de rbol, llamada dendritas, que reciben las seales de entrada procedentes de otras neuronas a travs de las sinapsis. Una neurona consta de tres partes: 1. El cuerpo de la neurona, 2. Las dendritas, que reciben las entradas, 3. El axn, que lleva la salida de la neurona a las dendritas de otras neuronas. La forma completa en la que dos neuronas se relacionan no es totalmente conocida, y depende adems del tipo particular de cada neurona. En general, una neurona enva su salida a otras por su axn, y ste lleva la informacin por medio de diferencias de potencial elctrico.

LA NEURONA ARTIFICIAL La neurona artificial fue diseada para "emular" las caractersticas del funcionamientobsico de la neurona biolgica. En esencia, se aplica un conjunto de entradas a laneurona, cada una de las cuales representa una salida de otra neurona. Cada entrada semultiplica por su "peso" o ponderacin correspondiente anloga al grado de conexinde la sinapsis. Todas las entradas ponderadas se suman y se determina el nivel deexcitacin o activacin de la neurona. Una representacin vectorial del funcionamientobsico de una neurona artificial se indica segn la siguiente expresin de la ecuacin.

10

NET = X*W Siendo NET la salida, X el vector de entrada y W el vector de pesos. Normalmente la seal de salida NET suele ser procesada por una funcin de activacinF para producir la seal de salida de la neurona OUT. La funcin F puede ser unafuncin lineal, o una funcin umbral o una funcin no lineal que simula con mayorexactitud las caractersticas de transferencia no lineales de las neuronas biolgicas.

Figura - Representa una neurona artificial con una funcin de activacin F. Las funciones F ms utilizadas son la funcin Sigmoid y Tangente hiperblicaexpresadas en la Tabla. Sigmoid OUT = 1 / (1+e^-NET) Tangente hiperblica OUT = tanh (NET) Tabla - Funciones de Activacin Este tipo de modelo de neurona artificial ignora muchas de las caractersticas de lasneuronas biolgicas. Entre ellas destaca la omisin de retardos y de sincronismo en lageneracin de la salida. No obstante, a pesar de estas limitaciones las redes construidascon este tipo de neurona artificial presentan cualidades y atributos con cierta similitud ala de los sistemas biolgicos. REDES NEURONALES ARTIFICIALES DE UNA CAPA YMULTICAPA La capacidad de clculo y potencia de la computacin neuronal proviene de lasmltiples conexiones de las neuronas artificiales que constituyen las redes ANN.La red ms simple es un grupo de neuronas ordenadas en una capa como se muestra enla Figura. Los nodos circulares slo son distribuidores de las entradas y no seconsideran constituyentes de una capa.

Figura- Red Neuronal de una Capa. Cada una de las entradas est conectada a travs de su peso correspondiente a cadaneurona artificial. En la prctica existen conexiones eliminadas e incluso conexionesentre las salidas y entradas de las neuronas de una capa. No obstante la figura muestrauna conectividad total por razones de generalizacin.

11

Normalmente las redes ms complejas y ms grandes ofrecen mejores prestaciones en elclculo computacional que las redes simples. Las configuraciones de las redesconstruidas presentan aspectos muy diferentes pero tienen un aspecto comn, elordenamiento de las neuronas en capas o niveles imitando la estructura de capas quepresenta el cerebro en algunas partes. Las redes multicapa se forman con un grupo de capas simples en cascada. La salida deuna capa es la entrada de la siguiente capa. Se ha demostrado que las redes multicapapresentan cualidades y aspectos por encima de las redes de una capa simple. La Figuramuestra una red de dos capas.

Figura- Red Neuronal de dos Capas. Conviene destacar que la mejora de las redes multicapa estriba en la funcin deactivacin no lineal entre capas, pudindose llegar al caso de disear una red de unacapa simple equivalente a una red multicapa si no se utiliza la funcin no lineal deactivacin entre capas. ENTRENAMIENTO DE LAS REDES NEURONALES ARTIFICIALES Una de las principales caractersticas de las ANN es su capacidad de aprendizaje. Elentrenamiento de las ANN muestra algunos paralelismos con el desarrollo intelectual delos seres humanos. No obstante aun cuando parece que se ha conseguido entender elproceso de aprendizaje conviene ser moderado porque el aprendizaje de las ANN estlimitado. El objetivo del entrenamiento de una ANN es conseguir que una aplicacindeterminada, para un conjunto de entradas produzca el conjunto de salidas deseadas omnimamente consistentes. El proceso de entrenamiento consiste en la aplicacinsecuencial de diferentes conjuntos o vectores de entrada para que se ajusten los pesos delas interconexiones segn un procedimiento predeterminado. Durante la sesin deentrenamiento los pesos convergen gradualmente hacia los valores que hacen que cadaentrada produzca el vector de salida deseado.

TEMA 3: SELECCIN DE LAS REDES NEURONALES ARTIFICIALES La clasificacin de las redes neuronales artificiales que se presenta en este captulo esuna simple descripcin de las diferentes ANN ms comunes y frecuentes en la mayorade los simuladores software de sistemas de computacin neuronal. La seleccin de unared se realiza en funcin de las caractersticas del problema a resolver. La mayora destos se pueden clasificar en aplicaciones de Prediccin, Clasificacin, Asociacin, Conceptualizacin, Filtrado y Optimizacin. Adaline y MadalineAO TIPO Diseador: Bernard Widrow 1960 Prediccin Caractersticas: Tcnicas de Adaptacin para el Reconocimiento de Patrones.

12

Back-Propagation Diseador: Rumelhart y Parker 1985 Clasificacin Caractersticas: Solucin a las limitaciones de su red predecesora el Perceptron. Self-OrganizingMaps (SOM) Diseador: Kohonen 1979-82 Conceptualizacin Caractersticas: Aprendizaje sin supervisin. Hopfield Networks Diseador: Hopfield 1982 Optimizacin Caractersticas: Concepto de la red en trminos de energa. Adaptive Resonance Theory Networks (ART) Diseador: Carpenter, Grossberg 1960-86 Conceptualizacin Caractersticas: Reconocimiento de Patrones y Modelo del Sistema Neuronal. Concepto de Resonancia Adaptativa.

TEMA 4: RED NEURONAL DEFINICION Una RED NEURONAL es un proceso slido y paralelamente distribuido con la propensin natural a acumular procedimientos experimentales y hacerlos disponibles para su uso. Se parece al cerebro en dos aspectos, por una parte la red adquiere conocimientos a travs de un proceso de aprendizaje, y por otra las conexiones interneuronales, conocidas como cargas sinpticas presentan una gran solidez que se encargan de almacenar los conocimientos. El funcionamiento de una red sera el siguiente. Se dispone de una serie de datos (situaciones del pasado) y asociados a ellos la respuesta deseable de la red (training set). La red de algn modo observa estos hechos y aprende de ellos (entrenamiento o aprendizaje), de modo que cuando se encuentre en una nueva situacin acte de modo coherente con lo aprendido. Para evaluar el comportamiento de la red ante nuevas situaciones se considerar un nuevo subconjunto de datos (validation set), independiente del conjunto de entrenamiento. Terminologa y Notacin Del mismo modo que el cerebro est constituido por neuronas, la unidad bsica constituyente de la red neuronal es el nodo, (neurona o elemento de procesado) Un nodo es un elemento de clculo interconectado con otros muchos elementos, imitando las sinapsis nerviosas. La idea era que, tal vez, conectando un nmero suficientemente alto de neuronas o nodos la inteligencia naciese de modo natural del aprendizaje. A un nodo llegan conexiones desde muchas otras neuronas, y en general proporciona una nica salida, como muestra la Figura 1.1.

A un nodo pueden llegar muchas entradas, si, proporcionando gran cantidad de informacin. El nodo condensar esta informacin de algn modo, por ejemplo a travs de una combinacin

13

lineal con cierto sesgo, (entrada ponderada); a continuacin se aplica cierta funcin, obtenindose de este modo la salida del nodo, que a su vez podr ser la entrada de algn otro nodo.

i reciben el nombre de pesos, y reflejan la conexin entre las neuronas y cun fuerte es. Por su parte la funcin f recibe el nombre de funcin de transferencia o link; la

Los parmetros adecuada eleccin de esta funcin es en parte responsable de la bondad del comportamiento de la red neuronal. Algunas de las funciones de transferencia ms usuales son: Umbral Lineal o Identidad Tangente hiperblica Logstica Gaussiana

Algunas de estas funciones tienen la particularidad de que llevan al conjunto de entradas a un espacio acotado, donde las funciones presentan cualidades que pueden resultarnos de inters en determinados contextos. Cada nodo puede tener una funcin de transferencia propia, distinta a la de los dems nodos, aunque en la mayora de los casos los nodos situados de un mismo nivel presentan todos la misma funcin de transferencia. En las redes neuronales con conexiones hacia adelante los nodos suelen estar distribuidos en distintas capas, de modo que los de una capa estn conectados slo con los de la capa inmediatamente superior. As la capa de entrada es aquella en que los datos, se presentan a la red; las variables que conforman estos datos de entrada reciben el nombre de inputs; por otra parte, la capa de salida es aquella en que la red nos devuelve su respuesta o respuestas, que reciben el nombre de outputs. Finalmente las capas intermedias reciben el nombre de capas ocultas. En general fijamos la restriccin de que desde la capa de salida no puede surgir ninguna conexin a otro nodo, para evitar bucles continuos en la red. La mayor parte de los modelos de redes neuronales, pueden ser expuestos como diagramas de red, lo que facilita la comprensin y el anlisis de su estructura. A continuacin se expone cmo se representan grficamente los distintos elementos que conforman la red. Neuronas. Cada neurona o nodo se representa mediante crculos y/o cajas. CRCULOS: son variables observadas o salidas de nodos, identificadas con su nombre.

14

CAJAS: son otro modo de representar los valores calculados como funcin de uno o ms argumentos. Dentro tendrn un smbolo indicador del tipo de funcin de transferencia empleada. Las cajas tienen adems un parmetro asociado llamado sesgo.

Las operaciones representadas en las Figura 1.3 son, de izquierda a derecha, suma, potencia, combinacin lineal, funcin logstica, funcin umbral, funcin de base radial y un valor arbitrario. CONEXIONES y AJUSTES. Las conexiones entre neuronas se representan por flechas. FLECHAS: indican que el origen de la flecha es un argumento de la funcin que se calcula en el destino de la flecha. DOS LNEAS PARALELAS: indican que los valores de cada final han de ser ajustados, por mnimos cuadrados, mxima verosimilitud, o algn otro criterio de estimacin. Los usos de las Redes Neuronales Las RNA se usan principalmente con tres objetivos diferenciados: Como modelos nerviosos biolgicos, e " inteligencia". Parte de las motivaciones biolgicas que dieron lugar a las redes neuronales se han conservado, por ello y se siguen empleando como instrumentos que nos ayuden a entender y duplicar el funcionamiento de los sistemas nerviosos de los seres vivos. Como procesadores adaptativos de seal en tiempo real, o controladores, implementados en hardware para aplicaciones como robots. Esta es el rea del Reconocimiento de Patrones. La tecnologa, la ciencia y los negocios han aportado nuevas tareas de inters (diagnstico de enfermedades, leer cdigos ZIP...), que en algunos casos son eminentemente tecnolgicas, como la lectura de cdigos de barras, y en otros muchos las llevan a cabo expertos humanos. El objetivo es construir mquinas que realicen estas labores de un modo ms rpido, ms barato, y ms exacto que los hombres. Cada vez es ms factible idear sistemas autom ticos que sustituyan y mejoren al especialista (como la cuenta de crdito de un cliente), o clonar al experto (ayuda al diagnstico mdico) Como mtodos de anlisis de datos. Principalmente este trabajo se centrar en esta ltima faceta de las redes. De hecho en multitud de ocasiones si se analiza detalladamente lo que est haciendo una red se descubrir que se dedica a rescribir mtodos estadsticos clsicos, como se detallar en secciones posteriores. As mismo cualquier red, an cuando su objetivo final sea algo muy concreto y a simple vista alejado de la estadstica, como la voz del desfibrilador que nos dice que el paciente tiene pulso y no puede recibir la descarga, fue diseada, y por lo tanto puede ser analizada desde un punto de vista meramente estadstico. Esta faceta de las redes fue estudiada con detenimiento por Sarle (1994). Se continua buscando el modelo que nos permita crear inteligencia, en el sentido humano del trmino, la llamada inteligencia artificial; una mquina capaz de aprender realmente, de tomar sus propias decisiones, de modificar y reinventar sus reglas de aprendizaje.

15

CLASIFICACIN DE LAS REDES NEURONALES La principal clasificacin de las redes se basa en las conexiones que presentan. En esta tesis se trabajara con redes que presentan conexiones hacia adelante o feedforward. Estas redes as mismo pueden ser clasificadas segn dos criterios principales: la arquitectura o topologa de la red, y el mtodo de aprendizaje empleado para su entrenamiento. Segn sus Conexiones Un criterio fundamental para clasificar las redes es aquel que se basa en las conexiones o nodos que presentan. A pesar de que en la mayora de los casos se tratar con redes con conexiones hacia delante, (feedforward), en particular aquellas que solo presentan conexiones entre capas consecutivas, existen redes que no limitan de esa manera sus conexiones. Redes con conexiones hacia adelante (feed forward)

En este tipo de redes la informacin se propaga hacia adelante por las distintas capas a travs de los pesos. No existen conexiones hacia atrs, ni laterales (salvo en dos casos particulares propuestos por Kohonen, que presentan conexiones implcitas entre las salidas, que son el Learning Vector Quantizer (LVQ), y el Topology Preserving Map (TRM)) (Hilera Gonzlez y Martnez Hernando, 1995). Redes de este tipo sern las que se consideren de ahora en adelante. Redes con conexiones hacia adelante y hacia atrs (feed forward / feedback)

Son redes donde la informacin circula tanto hacia adelante como hacia atrs, pues existen conexiones, i.e. pesos, en ambos sentidos. Entre dos neuronas conectadas hay dos pesos, uno en cada sentido, que en la mayora de los casos son diferentes. Generalmente son redes bicapa. Muchas de estas redes basan su comportamiento en la resonancia, esto es, en la interaccin de las informaciones de la primera y la segunda capa, hasta alcanzar un estado estable. En ocasiones se dan conexiones laterales entre neuronas de una misma capa. A este tipo de redes pertenecen la red Adaptative Resonance Theory (ART), y la red Bidirectional Associative Memory (BAM) (Hilera Gonzlez y Martnez Hernando, 1995). Segn su Topologa Las dos arquitecturas de redes neuronales ms usada son los Perceptrones Multicapa, denominados habitualmente MLP debido a las siglas de su denominacin anglosajona, Multilayer Perceptron, y las Funciones de Base Radial, que se asocian a sus siglas en ingls, Radial Basis Functions Bsicas. EL PERCEPTRN El primer modelo de red que se dise fue el perceptrn. Fue inventado por F. Rosenblatt en 1958. Con l pretenda ilustrar algunas de las propiedades de los sistemas inteligentes. Posteriormente se desarrollaron adems diversas variantes del perceptrn, en particular el perceptrn simple, esto es, sin capa oculta, entrenado segn una regla delta (con supervisin) La gran flexibilidad de este primer esquema influy enormemente en el gran desarrollo posterior de lo que acab desembocando en las redes neuronales. Los perceptrones se clasifican por el nmero de capas que presentan. As aquellos con dos capas, esto es, sin capa oculta, son perceptrones simples, y los de una o ms capas ocultas se llaman perceptrones multicapa. A continuacin se ilustra el ejemplo ms sencillo: el perceptrn simple. Un perceptrn simple calcula la combinacin lineal de las entradas (con un trmino de sesgo) lo que se llama entrada de red; a esa combinacin lineal se aplica una funcin de activacin, por regla general la funcin signo, o la funcin umbral, dando lugar a la salida de la red. La figura 1.4 muestra el diseo de un perceptrn simple.

16

Las ecuaciones del proceso son las siguientes

Est constituido por N I nodos de entrada y una nica neurona de salida, encargada de decidir a cul de las dos clases posibles pertenece la observacin. La regla de decisin ser 1 si la observacin pertenece a la clase A, y 0 si pertenece a la clase B. La salida depender de los pesos

ia10

y del sesgo

a0 01 , que en este caso cumple el papel

de valor umbral. Para que el clasificador pueda clasificar correctamente cualquier muestra es necesario que las dos clases sean linealmente separables.

17

Las redes de este tipo, con slo dos capas se limitan a la resolucin de problemas con observaciones separables geomtricamente (por hiperplanos). Ante estos inconvenientes surgieron dos modelos nuevos, el ADALINE (elemento lineal adaptable) y el MADALINE (elemento lineal adaptable mltiple). La estructura del ADALINE es la del perceptrn simple, pero la funcin que aplica el nodo es la identidad; de este modo se permite ms flexibilidad en la estructura de la red. Un modelo ms verstil y complejo es el Perceptrn Multicapa (MLP), que consiste en cierta cantidad de nodos organizados por capas (en al menos 3 capas), de modo que una neurona reciba entradas slo de las neuronas situadas en la capa inmediatamente inferior. En general, en un Perceptrn Multicapa cada uno de los nodos calcula una combinacin lineal de las entradas que llegan a l, le aade un sesgo, y finalmente le aplica una funcin de activacin, tambin llamada de transferencia, que por regla general traslada cualquier entrada real a un rango generalmente acotado, dando lugar as a la salida del nodo, que puede ser una de las entradas de un nuevo nodo. Un perceptrn multicapa, al igual que uno simple puede tener una o ms salidas, cada una de ellas con un conjunto de pesos y un sesgo asociados. A menudo se usa la misma funcin de activacin para cada nodo de la misma capa, aunque es posible usar diferentes funciones de activacin para cada neurona.

Las ecuaciones asociadas a un perceptron multicapa son las siguientes:

En esta notacin se supone que todos los nodos de una misma capa emplean la misma funcin de activacin, aunque podra perfectamente no ser as.

18

TEMA 5: APRENDIZAJE La caracterstica distintiva y original de las redes neuronales es el aprendizaje. A diferencia de otros sistemas tradicionales, para los que el conocimiento se expresa en forma de reglas explcitas, las redes neuronales generan sus propias reglas en el aprendizaje. Las redes neuronales aprenden de los datos, sin que sea preciso determinar una estructura para el sistema que deseamos reproducir, ni situar la distribucin de probabilidad dentro de una familia concreta. El aprendizaje de la red consiste fundamentalmente en la modificacin de los pesos que conectan los nodos. Cmo aprende la red, o lo que es lo mismo, qu es lo que hace que las conexiones interneuronales se modifiquen, qu criterios se siguen, y cundo las modificaciones son aceptadas y cundo no, ser vital a la hora de obtener buenos predictores neuronales. El proceso por el cual una red aprende se llama entrenamiento. Hay diversas clasificaciones del aprendizaje y por consiguiente de las redes, segn diferentes criterios Redes On-Line frente a Redes Off-Line Una primera divisin distingue entre redes off line y redes on line. Las redes off line se caracterizan porque para realizar su aprendizaje ha de detenerse el funcionamiento de la red. Se distinguen en este tipo de redes dos etapas: una de entrenamiento y otra en que la red se dedica a predecir. Cuando la red proporciona predicciones, no se encuentra entrenando, y mientras entrena est inhabilitada para dar respuesta a nuevos datos. Por su parte las redes on line tienen la caracterstica de que entrenan con cada nuevo dato que recibe el sistema, sin necesidad de detener su funcionamiento. Los datos se modifican dinmicamente con cada nueva informacin. Las primeras redes necesitarn actualizaciones peridicas, sobre todo si el proceso que se desea estudiar evoluciona con el tiempo. Pero a cambio su carcter esttico durante los perodos de prediccin hace ms estable al sistema. Si la red se modifica constantemente con cada nuevo dato sera necesario un exhaustivo estudio para analizar la inestabilidad del sistema. Redes con Aprendizaje Supervisado versus No Supervisado La clasificacin ms usual es aquella que distingue entre redes con Aprendizaje Supervisado y con Aprendizaje no Supervisado. La diferencia principal radica en la existencia de un "supervisor que controla el aprendizaje, indicando, bien hacia dnde han de modificarse los pesos, o bien si la modificacin es correcta o no. A continuacin se estudian con ms detalle las diferencias entre los distintos tipos de aprendizaje, para que facilitar el discernimiento entre este tipo de redes, y por tanto la clasificacin. Aprendizaje Supervisado Se caracteriza por la existencia de una agente externo que conoce la respuesta que debera generar la red a partir de una determinada entrada. La salida de la red es comparada con la respuesta deseada, y si no coinciden los pesos de las conexiones sern modificados de modo que la salida obtenida se aproxime a la deseada. La informacin que maneja el supervisor no es siempre la misma. Segn la naturaleza de los conocimientos de los que disponga, aparecern tres grandes clases de aprendizaje supervisado. Aprendizaje por correccin de error.

Es el modo ms comn de aprendizaje. Cada caso del conjunto de entrenamiento est constituido por las variables de entrada (que caracterizan la situacin en que se encuentra el sistema) y la salida o salidas que se desean de la red (variables objetivo). El ajuste de los

19

pesos se realizar en funcin de la diferencia entre los valores deseados y los que se obtuvieron en la salida de la red. La Regla de Aprendizaje del Perceptrn, fue desarrollada por Rosenblatt (1958), y constituye el primer ejemplo de aprendizaje supervisado. Presenta el problema de que no considera de modo global el error cometido por la red al estimar el conjunto de entrenamiento. Ms adelante Widrow y Hoff (1960) desarrollaron la Regla Delta, que permite conocer el error global cometido durante el entrenamiento. Estos autores aplicaron este mtodo de entrenamiento a muchas de las redes que desarrollaron, como el ADALINE y el MADALINE. La Regla delta estaba pensada para redes constituidas nicamente por una capa de entrada y una de salida. Cuando se empezaron a disear redes ms complejas, con una o varias capas ocultas (siempre con conexiones hacia delante) se hizo necesaria una generalizacin de ese algoritmo que tan buenos resultados haba proporcionado. Surgi entonces la Regla Delta Generalizada. Esa regla modifica los nodos cada vez que una observacin, que ser elegida de modo aleatorio, es presentada a la red, y lo hace siguiendo un orden determinado, empezando por los nodos que conectan la ltima capa oculta con la capa de salida, y finalizando en los que unen la capa de entrada con la primera capa oculta. La Figura 1.8 detalla el esquema general del proceso de aprendizaje. La modificacin de los pesos busca disminuir la funcin de error hasta hallar un mnimo de esa funcin. Si el error es una funcin lo suficientemente suave, basta con buscar un mnimo local, esto es, un punto donde la derivada sea nula. Se modifican los pesos en funcin de la derivada del error con respecto a al peso que se desea actualizar. La amplitud de la modificacin viene determinada por un paso, en general fijo durante todo el entrenamiento. Escoger adecuadamente el valor de ese paso ser determinante en el xito del entrenamiento. Los pesos se modifican en orden inverso a su actuacin en la red, pues la derivada de la funcin de error de los pesos de una capa depender de los pesos de las siguientes capas. La modificacin en la iteracin k-sima ser

En general,

La idea para su implementacin se conoce como back propagation. Fue desarrollada por Rumelhart, Hinton y Williams (1986) basndose en las ideas de Rosemblatt (1962) Backpropagation Consiste en tratar de minimizar una cierta funcin del error que comete la salida proporcionada por la red con respecto al valor deseado de la variable objetivo, por regla general proporcional al error cuadrtico medio. Para ello se busca un extremo relativo de esa funcin, considerada como funcin de los pesos, esto es, un punto donde todas las derivadas parciales de la funcin de error respecto a los pesos se anulan.

20

El algoritmo de Back propagation es un mtodo clsico de entrenamiento de redes cuando se trata de en un caso de aprendizaje con supervisin. El error cuadrtico medio se considera como funcin de los pesos, y por ello se calculan las derivadas de la funcin de error (fuese cual fuese) con respecto a ellos. Consiste, por tanto, en la aplicacin del algoritmo de paso descendiente teniendo en cuenta el orden adecuado de clculo de las derivadas. Si se considera como funcin de error el error cuadrtico medio, se aprecia que para el clculo la derivada se necesita manejar simultneamente todos los datos. Cuando sea necesario trabajar con todos los datos a la vez se dice que el mtodo es batch. En la mayora de los casos resultan mucho ms interesantes los mtodos on-line, puesto que los pesos se modifican con cada dato, de modo que se puede considerar la evolucin del sistema. En muchas ocasiones si es necesario manejar al tiempo todos los casos del conjunto de entrenamiento, es posible obtener mejores resultados hallando el mnimo de la funcin de modo analtico El entrenamiento es un algoritmo iterativo, y por lo tanto requiere de un punto de partida y una regla de parada. Generalmente se parte de un conjunto aleatorio de pesos, prestando especial atencin al espacio en el que se eligen, con el fin de evitar la saturacin numrica de las unidades ocultas. La eleccin de regla de parada resulta tambin importante. Inicialmente se suele seleccionar como regla el detener el proceso cuando (si) el error, E, es pequeo. No siempre este es un criterio adecuado. Se han propuesto muchos mtodos de parada, entre los que destacan aquellos que consisten en considerar un conjunto de validacin simultneamente al entrenamiento para el que se evalen los resultados de la red en paralelo, de modo que se detenga el entrenamiento cuando la medida del error en el conjunto de validacin empiece a crecer. Esto es peligroso, pues en muchos casos, tras un valle, el error en el conjunto de validacin crece lentamente durante un nmero grande de iteraciones para luego caer de pronto a una fraccin pequea de su mnimo inicial. Los efectos del momento de parada son importantes. Si se detiene prematuramente los pesos ajustados dependern de los de partida. Esto complica el anlisis de los procesos de parada temprana. Asimismo si te toma demasiado grande podr darse el caso de que en los pasos sucesivos la red se est momento alrededor del punto ptimo (vector de pesos) donde se alcanza el mnimo, pero sin llegar a alcanzarlo. Si por el contrario se opta por un demasiado pequeo la convergencia puede ser muy lenta. De nuevo se tienen diferentes opciones, como tomar constante, pero pequeo (por ejemplo, = 0, 008, = 0, 004 ) , o bien considerar una sucesin decreciente, con lmite cero pero con serie divergente. Por ejemplo,n= 1 n Si se analiza en detalle el comportamiento de la regla de entrenamiento, se obtiene la siguiente descripcin del proceso. Elegir aleatoriamente los pesos iniciales. En general los pesos se eligen de modo aleatorio en (0,1) pero que no estn demasiado cerca de estos extremos para que no se saturen los nodos (i.e. el valor de los pesos permanezca inamovible). Elegir aleatoriamente un caso del conjunto de entrenamiento. Se calcula el valor del nodo final con los pesos actuales., y se modifican, por mnimos cuadrados vamos minimizando el valor de los pesos. Modificar los pesos. Los pesos se modifican en la direccin en la que disminuya ms rpidamente la funcin de error determinada.

21

Para ilustrar el proceso se ilustra a continuacin un caso concreto, el del perceptron multicapa, con una sola capa oculta. En este ejemplo se considera como funcin de error, E, el error cuadrtico en los nodos de la ltima capa (1.25).Los pesos se modifican comenzando por la capa final y retrocediendo capa a capa hasta llegar a la primera. La regla de modificacin de pesos, o regla de aprendizaje se describe a continuacin. Durante la iteracin m-sima, en la ltima capa (capa que une los nodos de la capa oculta con los nodos de salida) los pesos se modifican segn (1.26).

Desarrollando el clculo de la derivada se obtienen las siguientes ecuaciones:

En la primera capa, (capa que une los nodos de la capa de entrada con los nodos de la capa oculta) los pesos se modifican segn (1.32); las ecuaciones posteriores detallan el proceso en ms detalle

22

Aprendizaje por refuerzo.

En este caso el supervisor no conoce la respuesta adecuada que debera presentar la red, pero dispone de algn mecanismo que indica si la respuesta es buena o no. Si la respuesta era adecuada se reforzarn las conexiones que actuaron para obtener esa respuesta, y si no lo era, esas mismas conexiones se inhibirn. Hay un rea de estudio llamada Aprendizaje De Mquinas, nacida en las comunidades de inteligencia artificial y ciencia computacional, en el tambin el objetivo radica en establecer la estructura del comportamiento a partir de los ejemplos, y las respuestas que se proporcionan para el aprendizaje son verdadero o falso. Aprendizaje estocstico.

En esta red los cambios de los pesos no se hacen siguiendo un crit erio de error, o de buen camino, sino de modo aleatorio. El cambio de aceptar segn las consecuencias que tengan

23

los nuevos pesos en el comportamiento de la red, y en funcin de ciertas distribuciones de probabilidad. A cada red, de las infinitas posibles al variar los pesos, se le asignar el valor de una funcin potencial, como si se tratase de un cuerpo con cierta energa. Se busca el estado de mxima estabilidad, esto es, de energa mnima. Los cambios de los pesos se harn de modo aleatorio, y si el nuevo estado energtico resulta ser ms estable, se aceptarn los cambios. En caso de que los nuevos pesos aumenten la inestabilidad del sistema, no sern rechazados de modo inmediato, sino que se aceptarn los cambios en funcin de cierta distribucin de probabilidades, que habr sido determinada de antemano. Dentro de las redes con aprendizaje supervisado tambin se puede establecer otro tipo de clasificacin, segn las variables objetivo que se consideren. De ese modo las Redes Heteroasociativas son aquellas que presentan variables objetivos diferentes de las variables de entrada, mientras que las Redes Autoasociativas tienen variables objetivo iguales a las variables de entrada. Aprendizaje No Supervisado No se dispone en este caso del supervisor que indique cmo actuar, y cundo los cambios han de ser aceptados. Las redes con este tipo de aprendizaje no reciben ninguna seal del exterior que les indique si su salida es o no la adecuada. Las redes con aprendizaje no supervisado debern auto organizarse, en funcin de las similitudes y diferencias que presenten los datos de entrada. Diversas son las tareas que pueden realizar las redes con aprendizaje no supervisado. La ms conocida es el Anlisis Cluster. Este tipo de redes lo que realizar agrupaciones de aquellos datos que presenten caractersticas comunes, esto es que estn, de algn modo, cercanos fsicamente. Esta bsqueda de similitudes puede proporcionar diferentes salidas de red. Por una parte puede analizar el grado de similitud entre una nueva observacin, y las presentadas anteriormente, o bien realizar un anlisis cluster, estableciendo grupos o categoras, y proporcionando la categora a la que pertenece un elemento, tambin puede proporcionar una salida que sea una funcin del espacio de caractersticas, de tal forma que las salidas de dos observaciones prximas estn cercanas entre s. TEMA 6: APLICACIN DE LAS REDES NEURONALES Las redes neuronales, siendo una de tantas definiciones enmarcada en la inteligencia artificial, su desarrollo se basa fundamentalmente en los ltimos aos, teniendo altas y bajas en su estudio, sus aplicaciones en la industria como una forma de reducir costos en laboratorios debido a su gran eficiencia en pronosticar propiedades por ejemplo, nos obliga a estudiarlo para una eficiencia empresarial

24

Las principales aplicaciones de la inteligencia artificial est constituido por sistemas expertos, algoritmos genticos, redes neuronales, etc, sabiendo que la industria minera trabaja con una gran cantidad de datos, que matemticamente su solucin se vuelve compleja complicndose encontrar una correspondencia de la variables, las redes neuronales destierran completamente a las tcnicas convencionales matemticas. Algunas de las aplicaciones ms resaltantes de estas tcnicas de inteligencia artificial a la industria minera son las siguientes, siendo muchas de ellas actualmente propuestas en estudio: Sistemas de aprendizaje inteligente y redes neuronales para predecir la continuidad geo estadstica en la mineralizacin a partir de la informacin de los modelos de bloques (block model) bajo caractersticas y patrones de los yacimientos mineralizados con mayor precisin que las tcnicas geo estadsticas convencionales.

Algoritmos genticos y redes neuronales artificiales para la programacin de vehculos inteligentes no tripulados para la operacin en la mina con la finalidad de acceder a espacios confinados, detonar tiros cortados o superar condiciones de alto riesgo evitando la presencia y exposicin de colaboradores humanos en dichas tareas.

Redes neuronales artificiales para dosificar el flujo de aire en la ventilacin minera subterrnea de manera que se optimice las descargas en funcin a la necesidad de aire, reduciendo los costos. Redes bayesianas para la clasificacin de documentos de logueo de depsitos minerales, bsqueda semntica y procesamiento de imgenes de prospeccin geolgica en la exploracin minera. Algoritmos genticos para optimizar la programacin de operaciones y el ciclo de minado asegurando la ms eficiente combinacin extractiva de tonelaje y ley con programacin evolutiva que aprende en funcin a las condiciones cambiantes de mina. Prospeccin geolgica remota satelital con el uso de algoritmos de aprendizaje y sistemas expertos para reconocimiento de patrones de presencia mineral, litologas, fracturas y leyes para la exploracin minera. Redes neuronales para sistemas de acceso a bodegas, compuertas, canales, cortadas y sistemas de iluminacin inteligente para dosificar los flujos de recursos en funcin a la demanda especfica en el ciclo de minado en las operaciones. Algoritmos genticos para la seleccin de componentes activos en la concentracin y biolixiviacin de minerales para reducir el consumo de agua en proporciones significativas en la operacin de beneficio de minerales.

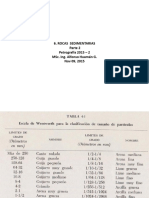

ESTIMACION DE PROPIEDADES MECANICAS DE LA ROCA CON REDES NEURONALES. La industria minera para el desarrollo de proyectos, necesita del estudio geolgico de las condiciones dadas naturalmente, siendo necesario acudir a laboratorios que nos proporcionan informacin relevante de las propiedades de la roca constituyente, inversin que tiene en cuenta la empresa, estos laboratorios estaran siendo desterrados con las tcnicas predictores de las redes neuronales, en conjunto con tcnicas computacionales como por ejemplo el algoritmo gentico.

25

Introduccin La estimacin de propiedades o parmetros en diversas reas de estudio es de inters para los investigadores que trabajan en lograr que sus modelos predigan estos parmetros con un alto grado de certeza y confiabilidad. La tcnica ms utilizada para obtener estimaciones de parmetros es el clsico anlisis de regresin; sin embargo, la calidad de las estimaciones por medio de esta tcnica se ven limitadas cuando se presenta un problema no lineal. Las redes neuronales artificiales constituyen un enfoque fundamentalmente distinto que consiste en aprender y generalizar las interacciones entre las variables de entrada y salida de un conjunto de datos. Debido a esta capacidad de aprender, las redes neuronales presentan un gran potencial en el modelado de comportamientos de rocas a partir de datos experimentales. Sin embargo, el principal obstculo al utilizar esta tcnica, es la determinacin de la configuracin de las partes de la red neuronal artificial, las cuales pueden ser ordenadas de mltiples formas. Por otro lado, un algoritmo gentico es un algoritmo matemtico que transforma un conjunto de individuos o poblacin (coleccin de objetos matemticos representando un individuo), cada uno de los cuales tiene asociado un valor de adaptacin, en una nueva poblacin utilizando una serie de operadores basados en los principios darwinianos de supervivencia del ms adaptado. Este algoritmo nos muestra una gran ayuda, pero su funcionamiento se vasa en un principio del menor error obtenido, para cuestiones generales se trabajara con el modelo del perceptron amplificado siendo recomendado para todo tipo de problemas complejos de este trabajo para dar solucin al problema de la determinacin de la configuracin de la red. Las redes neuronales han sido aplicadas satisfactoriamente en la estimacin de propiedades mecnicas como la resistencia a la tensin y la resistencia a la compresin. En estudios predecesores se aplicaron redes neuronales artificiales para la prediccin de resistencia a la compresin sin confinamiento (UCS) en muestras de roca como areniscas y rocas gneas a partir de propiedades como dureza, porosidad, densidad, tamao de grano e informacin sobre el tipo de roca, otros utilizaron las RN para predecir tanto resistencia a la compresin sin confinamiento (UCS) como resistencia a la tensin (To) de esquistos o rocas metamrficas, utilizando la composicin mineral y propiedades de textura y, otro enfoque utilizaron las RN para predecir la resistencia a la compresin uniaxial (UCS) y la resistencia a la tensin a partir de velocidades de pulso ultrasnico, densidad, absorcin de agua, densidad seca, densidad saturada y densidad aparente. Por lo tanto se busca la estimacin de resistencias a partir de propiedades petrofsicas como la porosidad y la permeabilidad, desarrollando la herramienta para la estimacin de propiedades mecnicas en areniscas (resistencias a la compresin) a partir de propiedades petrofsicas utilizando redes neuronales. Redes neuronales artificiales Los problemas a resolver cuando se entrenan redes neuronales en consideracin de los resultados que deseamos obtener se modifican los pesos que permitirn el ajuste adecuado a los datos de entrenamiento y a valores fuera de este conjunto; y, la determinacin de la configuracin de red (nmero de capas, nmero de neuronas y funciones de activacin ptimos para resolver un problema en particular). Propiedades petrofsicas Mediante el estudio de la petrofsica, que es el estudio de las propiedades fsicas y qumicas que describen la incidencia y el comportamiento de las rocas, los slidos y los fluidos, es posible caracterizar por ejemplo un depsito de minero, petrolero o de gas, para lo que se realizan mediciones tales como resistividad, neutrones y densidad, a partir de las cuales se pueden cuantificar la permeabilidad, las saturaciones y la porosidad efectiva.

26

Porosidad.

Es la fraccin del volumen total de la roca ocupada por su espacio vaco (lleno de agua, aire ) , y representa el porcentaje del espacio total que puede ser ocupado por lquidos o gases. Esta propiedad determina la propiedad de acumulacin de las rocas y, generalmente, se expresa como porcentaje o fraccin de la unidad.

Permeabilidad (k)

Es la capacidad de una roca para permitir el paso de fluidos a travs de ellos sin modificar su estructura interna, por lo quedetermina la velocidad a la que se desplaza el fluido que contiene por unidadde tiempo. Se dice que un material es permeable si deja pasar a travs de el unacantidad apreciable de fluido en un tiempo dado, e impermeable si la cantidadde fluido es despreciable. Para ser permeable un material debe ser poroso, es decir, debe contenerespacios vacos o poros que le permitan absorber fluido. A su vez estos porosdeben estar interconectados para que el fluido disponga de caminos a travsdel material, por lo tanto, hay una relacin general entre la porosidad y lapermeabilidad.

27

Propiedades Mecnicas Cuando una muestra de roca slida es sometida a grandes esfuerzos lo ms seguro es que la roca sea fallada; estas fallas dependern del estado de esfuerzos, del tipo del material y de la geometra de la muestra. Tambin, la historia de los esfuerzos del espcimen puede ser de gran importancia. Las tcnicas sugeridas para determinar la deformabilidad, resistencia y las constantes elsticas son dadas por la ISRM (Sociedad Internacional de Mecnica de Rocas) Los datos que se obtienen de ncleos de roca son aplicados para evaluar el comportamiento mecnico de una roca in-situ. Estos ncleos permiten las mediciones directas de los parmetros de resistencia y de las propiedades elsticas estticas. Diversas pruebas de laboratorio han sido desarrolladas para determinar la resistencia de las formaciones de rocas. El tipo de prueba seleccionada para medir una caracterstica particular de la roca deber simular lo ms cerca posible las condiciones encontradas en el yacimiento. Sin embargo, la manipulacin de los diferentes factores que inuyen en el valor final de resistencia experimental y la experiencia en su manipulacin conlleva a que el laboratorio maneje una tolerancia de error de 20 %. Se ha demostrado que ninguna tcnica actual es capaz de medir in-situ la resistencia de una roca. Por lo tanto se requiere de pruebas de laboratorio estndar, basadas en corazones, que pueden proporcionar esos datos. Sin embargo se debe tener en cuenta que dichos datos no reproducen exactamente las propiedades in situ a gran escala, porque estas propiedades son inuenciadas por diaclasas, fallas, heterogeneidades, planos de debilidad y otros factores. Las pruebas de laboratorio usualmente consisten en experimentos apropiados para la naturaleza de la roca y con estas pruebas se determina informacin importante como esfuerzos y deformaciones. El hecho de tener que realizar una prueba para obtener el valor de resistencia de una muestra de roca implica contar con la muestra, llevar a cabo la prueba e interpretar los resultados, lo que finalmente conlleva a gastos que se buscan reducir al contar con una nueva forma de estimar estos valores, de aqu la importancia que se le da al trabajo obtenido y al aporte que brinda en el rea. Las siguientes son las propiedades mecnicas a estimar a travs del trabajo desarrollado: Resistencia a la compresin sin confinamiento (UCS)

Comnmente llamada resistencia a la compresin uniaxial, es el valor del esfuerzo en el momento en que ocurre la falla en una roca; es decir el mximo esfuerzo que soporta la roca sometida a compresin uniaxial. Uno de los mtodos de determinacin de esta propiedad es el ensayo de compresin uniaxial que consiste en someter a carga un cilindro recto de muestra de roca con una presin de confinamiento igual a cero hasta que esta falle. En este ensayo se deben cumplir las siguientes condiciones: Razn Largo/Ancho de la probeta debe ser 2.5 a 3.0:1 Extremos deben ser paralelos y pulidos, sin grietas. Ancho de muestra debe ser >10 veces el tamao medio del grano.

28

Resistencia a la compresin con confinamiento (CCS)

Comnmente llamada resistencia a la compresin triaxial, es el mximo esfuerzo que soporta la roca sometida a compresin con confinamiento. Uno de los mtodos de determinacin de esta propiedad es la prueba triaxial, usualmente realizada en el laboratorio incrementando la carga axial y de confinamiento simultneamente hasta alcanzar el esfuerzo hidrosttico recomendado, luego, la presin de confinamiento es mantenida constante mientras la carga axial se va incrementando hasta que la falla ocurra. Las condiciones son las mismas que la compresin sin confinamiento. Para el caso especial de la estimacin de resistencia a la compresin con confinamiento, es importante tener en cuenta la presin de confinamiento como factor inuyente en el valor de la resistencia, por tal razn esta propiedad forma parte de las variables de entrada de la red neuronal y es definida a continuacin.

29

Presin de Confinamiento (Pc) Suma de la presin litosttica (o de carga de todos los materiales que se encuentran situados por todos los lados de la roca) ms la presin de uidos (en poros y rocas), que tiene lugar en rocas permeables que permiten el ujo de uidos a travs de sus poros, grietas o fisuras. En el caso prctico de los ensayos de laboratorio la cantidad de presin de confinamiento corresponde al valor de carga radial aplicado hidrulica neumticamente sobre la roca. Desarrollo de la herramienta Para el desarrollo de la herramienta se trabaj con el mtodo computacional mencionado anteriormente, mtodo conexionista (Redes Neuronales). El Algoritmo Gentico fue desarrollado en la herramienta de simulacin MATLAB 7.12, este se encarga de permutar las partes de la red en un proceso evolutivo, generando diferentes configuraciones, que son evaluadas cada vez, esta evaluacin gua el proceso de evolucin, que finalmente retorna una configuracin de red neuronal que presenta un muy buen ajuste y generalizacin. Las redes neuronales artificiales, usando la configuracin seleccionada mediante el algoritmo gentico estiman los valores de resistencia para los cuales fue desarrollado este trabajo. Aplicacin La aplicacin para la que se desarrolla este trabajo es la estimacin de resistencias de datos tomados del laboratorio de mecnica de rocas, que corresponden a arenas limpias de cuencas sedimentarias; para hacerlo se desarroll las redes neuronales artificiales y haciendo uso de la configuracin seleccionada, el usuario pudiese ingresar los datos y obtener de esta manera resultados.

Para la estimacin de resultados de pruebas de laboratorio (resistencias), se hace necesaria la definicin de las entradas y las salidas de la red neuronal de manera que entre stas se encuentre una relacin que permita generalizar el proceso de obtencin de estos valores y para esto se han definido las siguientes entradas y salidas: Parmetros de entrada Como la petrofsica puede describir el comportamiento de las rocas, las variables de entrada que se han definido son propiedades de este tipo: Porosidad (expresada en % y representada por ) Permeabilidad (expresada en md y representada por k)

30

Para el caso de la resistencia a la compresin triaxial, adems de las dos propiedades anteriores, se usa: Presin de confinamiento (expresada en PSI y representada por Pc) Datos de salida Las caractersticas geomecnicas a obtener mediante la simulacin de las pruebas son las siguientes respectivamente por tipo de prueba. DATOS DE LABORATORIO Porosidad % 20 18,8 17,9 17,4 16,8 15 15,7 12 10 8 Prueba de Compresin Uniaxial Resistencia a la compresin sin confinamiento (expresada en PSI y representada por UCS) Prueba de Compresin Triaxial Resistencia a la compresin con confinamiento (expresada en PSI y representada por CCS) Para cada una de estas caractersticas o propiedades mecnicas, las entradas varan de acuerdo a los factores que inuyen en su estimacin tal como se mencion en la descripcin de los datos de entrada, la tabla muestra claramente las entradas y salidas para cada propiedad. Permeabilidad (mD) 12 40 62 69 80 96 91 183 198 307 Resistencia (PSI) 1200 3800 4700 5000 7000 8970 8300 15000 17000 25000

Resultados Los resultados son presentados en esta seccin para demostrar el rendimiento de las redes y de la herramienta para su utilizacin.

31

Aunque son posibles diferentes configuraciones, utilizando el algoritmo gentico se seleccionaron las configuraciones que mostraron el mejor rendimiento entre todas las probadas para hallar la resistencia en cada una de las pruebas de laboratorio. La figura muestra la representacin grfica de las configuraciones seleccionadas por el algoritmo gentico teniendo la porosidad y la permeabilidad como datos de entrada. Como dato de salida se obtiene la resistencia a la compresin sin confinamiento (UCS). Tambin se presenta en la configuracin de red neuronal una tabla resumen en la que se puede observar el nmero de capas, el nmero de neuronas por capa y las funciones de transferencia.

La figura muestra la configuracin de red neuronal para la obtencin de la resistencia a la compresin con confinamiento (CCS) a partir de la porosidad, la permeabilidad y la presin de confinamiento y su respectiva tabla resumen en la que se observan el nmero de capas, el nmero de neuronas por capa y las funciones de transferencia.

Para el caso de la resistencia a la compresin uniaxial, la figura muestra la comparacin entre valores reales y estimados por la red neuronal.

32

Se puede observar que los valores estimados por la red neuronal son satisfactorios y adems los datos de prueba se ajustan a los valores reales. El error promedio obtenido y el mximo error demuestran estos resultados. El error promedio obtenido dado por la ecuacin y el mximo error que se present en alguno de los datos disponibles para este tipo de resistencia.

Ecuacin:

Donde n es el nmero total de datos disponibles para esta prueba. En el caso de la resistencia a la compresin triaxial, en la figura se puede observar que los datos de prueba, estimados mediante la red neuronal, logran seguir el comportamiento de los valores de resistencia real con lo que se demuestra el buen desempeo de la red para esta prueba. Nuevamente el error promedio obtenido y el mximo error obtenido confirman estos resultados.

33

34

ANEXO

Creacin y Entrenamiento de la Red Neuronal

Simulacin de la Red Neuronal ya entrenada

35

Parametros de interes durante el entrenamiento

10

Performance is 9.99819e-005, Goal is 0.0001

10

-1

Training-Blue Goal-Black

10

-2

10

-3

10

-4

500 1581 Epochs

1000

1500

Error vs Numero de Entrenamientos (Epochs)

36

Utilizacin de la Red con datos de 14% de porosidad y 140 mD permeabilidad

37

ANLISIS DE RESULTADOS Se probaron diferentes configuraciones de red neuronal por tipo de prueba, buscando las que ms se ajustaran al conjunto de datos y, las seleccionadas presentaron errores promedio de 2.2058 % y 2.4422 % respectivamente para cada una de las pruebas. Estos resultados se encuentran dentro de los mrgenes de tolerancia de error del laboratorio, por lo que los resultados cumplen con las expectativas. Los rangos en los que los resultados de la red neuronal son vlidos son considerablemente pequeos comparados con el dominio de los valores que se pueden encontrar en estas rocas, esto es debido al escaso nmero de datos que se lograron recopilar en el Laboratorio de Mecnica de Rocas. Con las pruebas que se presentaron para diversos conjuntos de datos de entrenamiento, se demuestra cmo realmente se logra una generalizacin con el modelo propuesto y se facilita con su anlisis determinar el nmero de datos que se hacen necesarios para obtener resultados confiables.

38

CONCLUSIONES Se calcularon propiedades mecnicas de roca (resistencia a la compresin sin confinamiento y resistencia a la compresin con confinamiento) utilizando mtodos propios de la inteligencia artificial, con porcentajes de error permitidos dentro de los lmites aceptados por el laboratorio de Mecnica de rocas.

Se logr obtener un buen ajuste en la estimacin de resistencias para los dos tipos de pruebas a pesar del escaso volumen de datos que se utiliz.

El modelo de redes neuronales descrito muestra que este puede ser un modelo de confianza para la determinacin de las propiedades mecnicas utilizando informacin de petrofsica y requiriendo un conjunto de datos experimentales obtenidos previamente.

Los resultados obtenidos con este trabajo no pueden ser comparados con los obtenidos por otros autores debido a que el tipo de roca, las caractersticas o parmetros de roca utilizados y los rangos en que estos parmetros se encuentran difieren, por esto el rendimiento se mide con los resultados experimentales obtenidos de las pruebas de laboratorio.

39

BIBLIOGRAFIA

http://oa.upm.es/14183/1/MECANICA_DE_ROCAS_1.pdf

http://webcache.googleusercontent.com/search?q=cache:JbAH0u2gAWoJ:https://www. ucursos.cl/ingenieria/2011/2/GL5201/1/material_docente/objeto/384079+&cd=1&hl=es&c t=clnk&gl=pe

http://ocw.uis.edu.co/ingenieria-civil/estabilidad-detaludes/clase11/ensayos_geotecnicos_de_rocas.pdf

Ttulo: REDES NEURONALES ARTIFICIALES Y SUS APLICACIONES Autor: Xavier BasogainOlave Escuela superior de ingeniera Bilbao

Ttulo: NEURAL NETWORKS. Autor: Simon HayLin McMaster University. Hamilton,Ontorio, Canada

Ttulo: MODELIZACION ESTADISTICA CON REDES NEURONALES. Autor: Maria Castellano Mendez. Diciembre 2009.

40

También podría gustarte

- Depósitos Epitermales de Alta y Baja SulfuraciónDocumento9 páginasDepósitos Epitermales de Alta y Baja SulfuraciónMilo Segovia100% (1)

- 2da Asignacion 2014 I FINDocumento25 páginas2da Asignacion 2014 I FINAlfredo Martinez VelardeAún no hay calificaciones

- Criterio de LaneDocumento29 páginasCriterio de LaneJuan Leiva Fuentes50% (2)

- Clasificación de reservas de mineral alternativaDocumento10 páginasClasificación de reservas de mineral alternativacoaquirarAún no hay calificaciones

- Presentación 1Documento139 páginasPresentación 1Alfredo Martinez VelardeAún no hay calificaciones

- Presentación 6 PETRO Rocas Sedimentarias. Paarte 2. EPIG 2015 - 2. AHG. Nov 09, 2015.Documento49 páginasPresentación 6 PETRO Rocas Sedimentarias. Paarte 2. EPIG 2015 - 2. AHG. Nov 09, 2015.Alfredo Martinez VelardeAún no hay calificaciones

- Testigos OrientadosDocumento28 páginasTestigos OrientadosAlfredo Martinez Velarde100% (2)

- Monitoreo SBT y SPF PDFDocumento43 páginasMonitoreo SBT y SPF PDFAlfredo Martinez VelardeAún no hay calificaciones

- Estimado del costo de inversión en proyectos industrialesDocumento44 páginasEstimado del costo de inversión en proyectos industrialesAlfredo Martinez VelardeAún no hay calificaciones

- Integrales Tabla CompletaDocumento6 páginasIntegrales Tabla CompletaArias Miguel100% (2)

- Problemas de Algoritmos de OrdenamientoDocumento4 páginasProblemas de Algoritmos de OrdenamientoAlfredo Martinez Velarde0% (1)

- 2º Asignacion Redes NeuronalesDocumento55 páginas2º Asignacion Redes Neuronaleslazarosuarez001Aún no hay calificaciones

- Estimado del costo de inversión en proyectos industrialesDocumento44 páginasEstimado del costo de inversión en proyectos industrialesAlfredo Martinez VelardeAún no hay calificaciones

- Informe Visita Cuajone Amautas Uni 1Documento13 páginasInforme Visita Cuajone Amautas Uni 1Alfredo Martinez Velarde0% (1)

- Plan Estratégico para La Feria Minera para Escolares y Feria LaboralDocumento13 páginasPlan Estratégico para La Feria Minera para Escolares y Feria LaboralAlfredo Martinez VelardeAún no hay calificaciones

- La Compañía Minera de Tajo Abierto ARUNTANIDocumento5 páginasLa Compañía Minera de Tajo Abierto ARUNTANIAlfredo Martinez VelardeAún no hay calificaciones

- GEOUNIDocumento5 páginasGEOUNIAlfredo Martinez VelardeAún no hay calificaciones

- Pierina FinalDocumento22 páginasPierina FinalAlfredo Martinez Velarde100% (1)

- Petrofisica y Registro de Pozos (Recuperado)Documento30 páginasPetrofisica y Registro de Pozos (Recuperado)victor JavierAún no hay calificaciones

- RM Avanzado 3BDocumento36 páginasRM Avanzado 3BMerly_20800% (1)

- Ecuaciones DiferencialesDocumento10 páginasEcuaciones DiferencialesKelly AstochadoAún no hay calificaciones

- Tarea 3 - Fundamentos de Induccion ElectromagneticaDocumento20 páginasTarea 3 - Fundamentos de Induccion ElectromagneticaRamos JuanAún no hay calificaciones

- RES. #045-2021-Mecánica Eléctrica REsDocumento5 páginasRES. #045-2021-Mecánica Eléctrica REsANTONIO MARTIN ASTO SANCHEZAún no hay calificaciones

- 30 Problemas de Grupos ResueltosDocumento16 páginas30 Problemas de Grupos Resueltosler1022367% (12)

- Gomez Torrente Mario Forma y ModalidadDocumento56 páginasGomez Torrente Mario Forma y ModalidadSergioAún no hay calificaciones

- Guía 09 Movimiento Oscilatorio (Enunciados) PDFDocumento5 páginasGuía 09 Movimiento Oscilatorio (Enunciados) PDFanon_537237737Aún no hay calificaciones