Documentos de Académico

Documentos de Profesional

Documentos de Cultura

Metodo de Minimos Cuadrados

Cargado por

Yajitaz LOve ChanDerechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

Metodo de Minimos Cuadrados

Cargado por

Yajitaz LOve ChanCopyright:

Formatos disponibles

El Mtodo de

Mnimos Cuadrados

Sergio A. Cruces lvarez

UNIVERSIDAD DE SEVILLA

1

En esta segunda prueba se pretenden esbozar algunos de los

puntos ms importantes del mtodo de Mnimos Cuadrados junto

con ejemplos de su aplicacin prctica.

Este tema se circunscribe en uno de los captulos iniciales de un

curso de doctorado sobre Teora de la Estimacin Paramtrica y su

duracin real equivaldra a unas 5 horas lectivas.

Se presuponen en el alumno unos conocimientos bsicos de

lgebra, clculo vectorial y teora de probabilidad.

1

Puntos a Tratar

1. Introduccin.

2. Mnimos cuadrados determinista.

3. Mnimos cuadrados estocstico.

4. Conclusiones.

5. Referencias.

2

Los puntos que vamos a tratar en la exposicin son:

1. La introduccin al mtodo de Mnimos Cuadrados trata de

motivar al alumno presentando la particular historia que propici

su descubrimiento por parte de Gauss.

2. La versin determinista del mtodo que responde a un problema

de aproximacin. Una gran parte de la exposicin se dedica a este

punto pues la simplicidad en la formulacin del mtodo

determinista de mnimos cuadrados lo hace ideal para presentar de

una forma coherente y concisa muchos conceptos y sus inter-

relaciones.

3. El mtodo de Mnimos Cuadrados Estocstico responde a un

problema de estimacin. Como este mtodo posee una

complejidad ligeramente superior al anterior. Aqu no se presentan

conceptos nuevos slo examinan unos pocos aunque, eso si, con

una mayor profundidad.

4. Se repasan las principales conclusiones

5. Se comentan algunas referencias tiles para estudiar y

profundizar en el tema.

2

Introduccin

El mtodo de Mnimos Cuadrados tiene

una larga historia que se remonta a

principios del siglo XIX.

Ceres

Carl Friedrich Gauss

[1777- 1855]

Sol

Tierra

3

El mtodo de mnimos cuadrados tiene una larga historia que se

remonta a los principios del siglo XIX. En Junio de 1801, Zach, un

astrnomo que Gauss haba conocido dos aos antes, publicaba las

posiciones orbitales del cuerpo celeste Ceres, un nuevo pequeo

planeta descubierto por el astrnomo italiano G. Piazzi en ese

mismo ao. Desafortunadamente, Piazzi slo haba podido

observar 9 grados de su rbita antes de que este cuerpo

desapareciese tras de el sol. Zach public varias predicciones de su

posicin incluyendo una de Gauss que difera notablemente de las

dems. Cuando Ceres fue redescubierto por Zach en Diciembre de

1801 estaba casi exactamente en donde Gauss haba predicho.

Aunque todava no haba revelado su mtodo, Gauss haba

descubierto el mtodo de mnimos cuadrados. En un trabajo

brillante logr calcular la rbita de Ceres a partir de un nmero

reducido de observaciones, de hecho, el mtodo de Gauss requiere

slo un mnimo de 3 observaciones y todava es, en esencia, el

utilizado en la actualidad para calcular las rbitas.

3

Puntos a Tratar

1. Introduccin.

2. Mnimos cuadrados determinista.

2.1. Interpretacin geomtrica.

2.2. Aumentando el orden de la aproximacin.

2.3. Aumentando el nmero de observaciones.

2.4. Mnimos cuadrados con restricciones.

2.5. Dependencia no lineal.

3. Mnimos cuadrados estocstico.

3.1. Teorema de Gauss-Markov.

3.2. Interpretacin Geomtrica.

3.3. Teorema de Aitken.

4. Conclusiones.

5. Referencias.

4

En este punto se describe la versin determinista del mtodo de

Mnimos Cuadrados. El orden de presentacin es el siguiente.

En primer lugar, se presentan los personajes de la pelcula, es

decir, el modelo de generacin de los datos junto con las seales y

variables implicadas.

A continuacin, se describe el criterio propuesto, su solucin para

el caso de dependencia lineal con los parmetros y, una

interpretacin geomtrica de sta que sirve para establecer el

fundamental principio de ortogonalidad.

Las soluciones recursivas del mtodo se describen en base al

concepto de innovacin (nueva informacin) para los casos de

aumentar el nmero de parmetros o el nmero de datos.

Se obtiene una solucin compacta para una situacin en la que se

consideren restricciones lineales y, finalmente, se trata el caso de

que exista una dependencia no lineal de la seal con los

parmetros que se desean estimar.

4

Mnimos Cuadrados Determinista

u e[n]

Modelo de

Seal

s[n] x[n] = s[n] + e[n]

n = 0,, N-1.

Fig.1: Modelo de las observaciones

u Vector con los p parmetros de inters.

s[n] Seal determinista dependiente de u.

e[n] Ruido y desajustes del modelo.

x[n] Observaciones.

Notacin Vectorial.

u = [u

1

,, u

p

]

T

s(u) = [s[0],, s[N-1] ]

T

e(u) = [e[0],, e[N-1] ]

T

x = [x[0],, x[N-1] ]

T

5

En el mtodo de Mnimos Cuadrados deseamos minimizar la

discrepancia entre los datos observados x[n] y la seal original s[n].

Esta seal se genera a travs de un modelo que depende un conjunto

de parmetros de inters agrupados en el vector u. Aunque s[n] es

completamente determinista la presencia de inexactitudes en el

modelo o ruido en los sensores hace que las observemos una versin

perturbada de sta que denotamos por x[n].

A lo largo del tema preferiremos utilizar la notacin vectorial por su

mayor simplicidad y claridad a la hora de permitir visualizar los

resultados.

5

Mnimos Cuadrados Determinista

Objetivo:

Buscar la mejor aproximacin

del sistema sobredeterminado

x ~ s( )

Minimizar

Soluc. MCD

J (u) = ||e(u)||

2

= arg(min J ( ))

*

Mtodo de aproximacin: no utiliza hiptesis probabilsticas

sobre los datos, slo su modelo de generacin (Fig.1).

Dependencia lineal

s( )= H

H = [h

1

, , h

p

] matriz de observacin ( N p)

6

El objetivo del mtodo de Mnimos Cuadrados Determinista

(MCD) es el de elegir el parmetro u que mejor aproxima la seal

original s[n] a los datos observados x[n].

El criterio de proximidad que se aplica en este caso es el que

resulta de considerar una funcin de coste o discrepancia J(u) que

se forma con la norma al cuadrado del error. As, el estimador de

mnimos cuadrados es aquel que minimiza esta funcin de coste.

Es importante destacar que MCD es un mtodo de aproximacin

pues no utiliza hiptesis probabilsticas sobre los datos, slo su

modelo de generacin.

El caso ms sencillo se da cuando asumimos que la dependencia

de la seal con los parmetros es lineal. La matriz por la que se

multiplican los parmetros para generar la seal recibe el nombre

de matriz de observacin y sus columnas jugarn un importante

papel en este mtodo.

6

2

T

Dependencia Lineal

Solucin ( si

rango(H

T

H) = p )

J(u)

cJ ( )

= 2(x H ) H = 0

c

T

T

J(u ) estrict.

c

|

cJ

|

convexa.

( )|

= 2H

T

H > 0 (def +)

c

T

\

c

T

.

nico mnimo global

= (H

T

H)

1

H

T

x

2

1

Seal estimada a partir de la mejor aproximacin?

s = H

= HH

+

x

-1

-2

1

donde

+

= (H

T

H)

1

H

T

Pseudoinversa de H

-2 0 2

7

Encontrar los parmetros que dan la solucin al problema, cuando

las columnas de la matriz de observacin son linealmente

independientes, es muy simple. Basta con calcular la derivada y la

matriz Hessiana para observar que sta ltima es siempre

estrictamente definida positiva, lo cual, garantiza que la funcin de

coste J(u) es estrictamente convexa y, por tanto, existe un nico

mnimo. Este se obtiene simplemente buscando el nico punto

crtico de la funcin.

Un razonamiento cualitativo conduce al mismo resultado. Basta

observar que J(u) es una funcin positiva con una dependencia

cuadrtica sobre los parmetros, por tanto, su grafo traza un hiper-

paraboloide p-dimensional que tiene un nico mnimo y cuyas

curvas de nivel son, en el caso ms general, hiper-elipsoides.

Una vez obtenidos los parmetros que dan la mejor aproximacin,

cmo podemos obtener nuestra mejor estima para la seal?

Slo hace falta sustituir stos en el modelo de seal para encontrar

la respuesta.

7

.

Dependencia Lineal

Solucin ( si

rango(H

T

H) < p )

c | cJ ( )|

T

= 2

> 0 (semidef +)

c

T

\

c

T

|

H

T

H

J(u) convexa (no estrictamente)

Subespacio de mnimos globales.

J(u)

Inf. Soluciones q e 9

n

= H

+

x + (I H

+

H)q

Soluc. particular Soluc. homognea

u no es identificable, aunque la seal estimada a

partir de la mejor aproximacin sigue siendo nica

s = H

= HH

+

x

8

Cuando las columnas de la matriz de observacin son linealmente

dependientes la solucin no es tan sencilla.

El Hessiano es semidefinido positivo, lo cual implica que J(u)

sigue siendo una funcin convexa aunque no de forma estricta.

Todos los puntos crticos de la funcin son, por tanto, mnimos. La

expresin analtica de estos mnimos se determina igualando la

derivada de la funcin a cero y resolviendo el sistema

indeterminado resultante.

En este caso los parmetros originales no son identificables puesto

que la solucin de MCD no es nica. Lo que s es identificable es

la estima de la seal que proporciona el mtodo, pues sta resulta

ser comn para todos los parmetros solucin.

8

10

8

6

4

2

0

-2

-4

0 20 40 60 80 100 n

x[n]

10

^

s [n] 8

6

4

2

0

N

.

n

Ejemplo

Seal cuadrtica en ruido: x[n] = u

1

+ u

2

n + u

3

n

2

+e[n]

|1 0

1 1

H =

1 2

0 |

|

1

|

2

2 |

|

|

\

1 N

2 |

| 10 |

|

*

=

0.3

|

|

\

0.002

.

| 10.076 |

-2

|

-4

0 20 40 60 80 100

=

0.299

|

0.0020

|

\ .

s = H

9

En este ejemplo se obtienen los tres parmetros que mejor ajustan

una seal cuadrtica a las observaciones y se visualiza

grficamente la seal que proporciona el mejor ajuste segn el

mtodo de mnimos cuadrados.

9

Interpretacin Geomtrica

Principio de Ortogonalidad:

< e, h

i

>= 0

i = 1, , p.

El error mnimo

e es ortogonal al subespacio (H) = {y : y = Hz z e 9

p

}

generado por las columnas de H.

x

e

h

2

0

h

1

s

M (H)

e

e

x

e

h

1

h

2 s

s es la proyeccin ortogonal de x sobre (H)

10

La interpretacin geomtrica de los resultados nos lleva a un

principio fundamental: el principio de ortogonalidad o teorema

de la proyeccin, que es vlido para cualquier espacio vectorial

de Hilbert y que enunciamos a continuacin:

Sea M(H) el subespacio generado por las columnas de H, la

norma del error entre un vector x arbitrario y cualquier punto de

este subespacio es mnima, si y slo si, el error es ortogonal al

subespacio. Adems, el punto del subespacio que minimiza la

norma del error (la mejor aproximacin de la seal) es nico.

El principio de ortogonalidad est ntimamente ligado a la

geometra de los espacios de Hilbert. Una de las consecuencias de

este principio es que el teorema de Pitgoras se debe cumplir en

los espacios de Hilbert.

La utilidad del principio de ortogonalidad tiene dos vertientes: por

una parte nos permite obtener la solucin del problema de una

forma muy elegante sin recurrir a calcular gradientes y derivadas,

por otra, nos proporciona una interpretacin geomtrica de los

resultados que facilita nuestra comprensin del problema y

capacidad de intuicin.

10

e

*Interpretacin Geomtrica

Demostracin del principio de ortogonalidad:

cJ ( )

c

T

= 2e

T

H = 0

T

|h

1

, , h

N

|

T

= |0, ,0|

=

< e, h

i

>= 0

i = 1, , p.

Demostracin del corolario al principio de ortogonalidad:

s = H

e M (H)

< e, s >= 0 .

11

Una vez definido el espacio vectorial de Hilbert y el producto

interno entre dos vectores, la demostracin del principio de

ortogonalidad se obtiene directamente de la ecuacin que nos

facilita los puntos crticos.

11

H

Matrices de Proyeccin

Cmo es el operador que proyecta x sobre M(H)? y sobre M (H

) ?

s = HH

+

x

e = x s = (I HH

+

)x

0

M (H)

x

s = P

H

x

0

M (H)

M (H

)

x

e = P

x

Se define P

= HH

+

como la matriz

Se define P

= I P

como la matriz

H H H

que proyecta ortogonalmente un

vector sobre M (H) .

que proyecta sobre el complemento

ortogonal de M (H) .

12

Llegado este punto nos podemos preguntar cmo es el operador

que proyecta ortogonalmente las observaciones x sobre el

subespacio generado por las columnas de H?

Como est claro que la seal estimada es el resultado de esta

proyeccin ortogonal, la respuesta a esta pregunta se obtiene

directamente identificando este operador en la expresin que nos

da la seal estimada como mejor aproximacin. As,

comprobamos que el operador buscado es un operador lineal

denominado matriz de proyeccin ortogonal.

Otra posible cuestin podra ser cmo encontrar el operador que

proyecta las observaciones sobre el complemento ortogonal del

subespacio generado por las columnas de H?

Por la estructura del problema, las componente de las

observaciones que no se puede expresar sobre M(H) es el error

mnimo. Observando la expresin del error en trminos de x

resulta fcil identificar el operador de proyeccin sobre el

complemento ortogonal al subespacio.

12

H H

=

1

H

Matrices de Proyeccin

Propiedades de las matrices de proyeccin ortogonal:

1. Son simtricas

2. Son idempotentes

3. Sus autovalores

4. Son nicas para cada subespacio

P = P

T

P

H

P

H

= P

H

0 si el autovector asociado q

i

e M (H)

i

1 si el autovector asociado q

i

e M (H)

M (H) M (H' ) P

H

= P

H '

5. Sobre subespacios ortogonales la proyeccin se desacopla

Si H = (H

1

| H

2

) donde H

1

H

2

P

H

= P

H

+ P

2

s = P

H

x + P

H

x

1 2

13

Las propiedades de las matrices de proyeccin ortogonal nos

permiten encontrar soluciones simples a problemas, en principio,

complicados.

Estas propiedades se obtienen directamente de la descomposicin

en valores singulares de H y de la definicin de matriz de

proyeccin ortogonal.

De entre todas ellas las propiedades 4 y 5 son las ms interesantes:

4. Las matrices de proyeccin ortogonal son nicas para cada

subespacio, es decir, que columnas de H que generen el mismo

subespacio tienen la misma matriz de proyeccin.

5. Si somos capaces de expresar el espacio generado por las

columnas de H sobre dos subespacios ortogonales el problema de

la proyeccin se desacopla de forma independiente sobre cada uno

de ellos, de forma que, la proyeccin conjunta resulta ser la suma

de las proyecciones marginales.

13

= (H ) H

k k k

H x

k =

Aumentando el Orden

Sea

k 1

T

k 1

k 1

1 T

k 1

el estimador que nos da la mejor aproximacin

con k-1 parmetros. Cuando aadimos un nuevo parmetro tendremos

T 1 T

= (H H ) H

k

x donde H

k

= [H

k 1

, h

k

]

Es necesario recalcular la solucin cada vez?

Existe un mtodo ms eficiente?

Existe una solucin recursiva que aprovecha

1

para calcular

.

k k

H

+

h

(

h

T

P

x

=

k 1

k 1 k

(

con

k k 1

T

h

k

P

k 1

h

k

14

En muchas situaciones el modelo de las observaciones nos es

desconocido. En esos casos uno puede plantearse el aadir ms

parmetros para mejorar la estima. Para ello, bastara volver a

resolver el problema tras ampliar la matriz de observacin con una

nueva columna por cada parmetro aadido a la estima.

Pero, existe un mtodo mejor que recalcular la solucin cada

vez?

La respuesta a esta pregunta es s. Es posible encontrar una

solucin recursiva que aprovecha la estima hecha considerando

k-1 parmetros para obtener la solucin que tiene en cuenta un

parmetro ms. Esta solucin recursiva conlleva, a medida que se

incrementa el nmero de parmetros, una reduccin en la carga

computacional total, a la vez que evita, mediante la utilizacin del

lema de inversin, la inversin explcita de matrices (operacin

que resulta muy costosa en cuanto a carga computacional).

14

h +

Aumentando el Orden

Deduccin geomtrica:

La innovacin es la componente

de h

k

ortogonal a M (H

k 1

) .

x

h

k

~

h

k

M (H

k 1

)

0

~

h

k

0

s

k 1

s

k

M (H

k

)

M (H

k 1

)

Por qu es preferible

trabajar con la innovacin?

s

k

= s

k 1

~

k

De ambas ec. se despeja la

s = H

soluc. recursiva para

k

k k k

15

Mediante manipulaciones algebraicas de la solucin de orden k es

posible obtener directamente la solucin recursiva. No obstante, su

deduccin geomtrica resulta mucho ms ilustrativa e intuitiva.

La clave de todo est en descomponer la nueva columna de la

matriz de observacin en dos componentes. Una que contiene

informacin redundante (que ya exista en la aproximacin basada

en k-1 parmetros) y otra componente basada en la nueva

informacin que aparece al aadir un parmetro ms al modelo.

Esta ltima componente recibe el nombre de innovacin y es, por

definicin, ortogonal al subespacio generado por el resto de

columnas.

Dado que M([H

k-1

, innovacin]) M(H

k

) y H

k-1

es ortogonal a la

innovacin, la proyeccin total se desacopla sobre estos dos

subespacios de forma que la solucin es simplemente la suma de

las proyecciones de los datos sobre cada uno de ellos. De esta

forma, re-escribiendo las matrices de proyeccin en trminos de

las variables conocidas se llega a la solucin recursiva buscada.

15

16

k H k

, ])

h = P h = H

~

=

H +

1

~

h

k

*Aumentando el Orden

Deduccin detallada:

~

h

k

h = P h

k 1

como

M ([H

k 1

, h

k

]) M ([H

~

k 1

h

k

M (H

k 1

)

.

k H

k 1

k k 1

s = P

~ x = P

x + P~ x

~ ~

h

k

x,

h

k

~

k

[ H

k 1

,h

k

]

H

k 1 h

k

h

k

h

k

s

k

=

k 1 k 1

(h

k

H

k

)

|

|

= (H

k 1

, h

k

)

\

k 1

|

|

.

H

k

k 16

Esta transparencia facilita un anlisis ms pormenorizado de los

pasos que llevan a la solucin.

17

R

E

G

R

E

S

I

N

S

E

G

N

"

K

"

Ejemplo

12

10

k=1

k=2

6

k=3,..,10

4

2

0

-2

-4

0 20 40 60 80 100

Aumentamos poco a poco el nmero de parmetros hasta 10.

17

Como ejemplo de este mtodo hemos obtenido de forma recursiva la

solucin al problema de regresin polinmica de una seal inmersa

en ruido. Para ello, utilizamos 100 observaciones y consideramos

desde uno hasta un total de diez coeficientes (parmetros), pasando

por todos los casos intermedios.

Las observaciones se denotan por puntos azules en la figura, mientras

que la componente de seal estimada se representa en trazo continuo

con colores que varan segn el nmero de parmetros considerados.

18

Constante

arbola

Lnea

P

C

O

S

T

E

M

N

I

M

O

J

m

i

n

[

p

]

Ejemplo (continuacin)

40

35

30

25

20

15

10

5

0

0 2 4 6 8 10

N. DE PARMETROS

El coste mnimo indica que basta con utilizar 3 parmetros.

18

El coste mnimo nos facilita una idea del nmero mnimo de

parmetros necesarios para representar las observaciones.

En nuestro caso, comprobamos que basta con utilizar 3 parmetros

(nuestra seal es aproximadamente cuadrtica). Aumentando ms el

nmero de parmetros ya no disminuye significativamente el error de

representacin, ms aun, las pequeas disminuciones en coste se

pueden deber a que utilicemos los nuevos grados de libertad que nos

proporcionan los parmetros intentar ajustar o modelar el ruido. Esto

ltimo no siempre es deseable pues, en la prctica, el modelo ms

simple que describe de forma adecuada los datos suele resultar

preferible.

19

Aumentando Observaciones

Sea

[n 1] la estimacin a partir de los datos x[0], , x[n-1]. Si aadimos

un dato ms (x[n]), el nuevo estimador ser

T 1 T

x

| x

n 1

|

|

H[n 1]

|

[n] = (H [n]H[n]) H [n]x

n

con

n

=

x[n]

| H[n] = |

h

T

[n]

\ . \ .

Es necesario recalcular la solucin cada vez?

Existe un mtodo ms eficiente?

Existe una solucin secuencial que ofrece una carga computacional de

O(np

2

) operaciones frente a las O(n

3

) de la solucin directa.

[n] =

[n 1] + K[n] ( x[n] h

T

[n]

[n 1])

donde

K[n] =

(H

T

[n 1]H[n 1])

1

h[n]

1 + h

T

[n](H

T

[n 1]H[n 1])

1

h[n]

19

En otras situaciones, el nmero de parmetros de nuestro modelo es

constante pero los datos de los que disponemos se incrementan de

forma dinmica con el tiempo, cosa que ocurre, por ejemplo, con el

ndice de la Bolsa. Como cada vez que nos llega un dato ms, resulta

deseable aprovechar su informacin para mejorar nuestra estima

actual, se nos plantea de nuevo la pregunta: es necesario re-calcular

toda la solucin cada vez que esto ocurre?

Al igual que en el caso precedente, la respuesta es afirmativa. Existe

un mtodo secuencial que permite calcular la nueva solucin en

funcin de la que se obtuvo sin conocer ese dato adicional. De esta

forma no slo se obtienen ventajas computacionales importantes sino

que tambin se obtiene una visin clara de cul es la informacin con

la que contribuye cada nuevo dato al modelo de las observaciones.

A esta solucin secuencial se llegar mediante manipulaciones

algebraicas entre las que se utiliza el lema de inversin.

Aumentando Observaciones

Interpretacin de la solucin:

[n] =

[n 1] + K[n] ( x[n] x[n])

Nuevo dato

Innovacin Correccin basada en

la nueva informacin.

+ +

-

+

z

-1

[n]

los datos anteriores

x[n]

h

T

[n]

[n 1]

20

La interpretacin de la solucin secuencial resulta muy ilustrativa.

A cada nuevo dato se le sustrae la prediccin de su valor en base a

los datos precedentes, de esta forma se construye la innovacin que

representa la nueva informacin aportada por el dato actual. sta se

multiplica por un factor K[n] que hace las funciones de ganancia y

que refleja nuestra confianza en esta informacin frente a la aportada

por los datos precedentes. El resultado de este producto es finalmente

la correccin de la estima previa para obtener el estima actual.

20

M

E

D

I

A

Ejemplo

Media de una seal en ruido: x[n] = u + e[n]

[n] =

1

n

x[k ]

[n] =

[n 1] +

1

( x[n]

[n 1])

n + 1

k =0 n + 1

1.1

1.05

1

0.95

0.9

0.85

0.8

0.75

0.7

0 10 20 30 40 50 60 70 80 90 100

M U ES TR AS

21

Como ejemplo de aplicacin de la estimacin secuencial

consideramos un caso muy sencillo: el de estimacin de la media de

una seal en ruido. El estimador ptimo, que se obtiene por

resolucin directa de las ecuaciones normales, resulta coincidir para

cada conjunto de datos con su media muestral. Por otra parte, su

estimacin secuencial responde a una ecuacin equivalente en la que

se desacopla la informacin pasada y la aportada por el dato actual.

Los resultados se pueden observar en la figura. La media terica de

esta seal es la unidad. Aunque la estima aparece inicialmente muy

ruidosa por el escaso nmero de datos iniciales, la media estimada se

acerca progresivamente a la media terica a medida que el nmero de

datos aumenta.

21

ii

1

1

Ponderacin del Error

A veces nos interesa ponderar cada error por separado:

J ( ) =

n

i =0

W e|i|

2

= (x H )

T

W(x H )

donde W diagonal def +

Solucin: cambio de variable

x = W

2

x

H = W

2

H

J ( ) = x H

2

= H

+

x = (H

T

WH)

1

H

T

Wx

22

Resulta fcil imaginar situaciones en las que nuestra confianza en

todos las observaciones no sea la misma. En estos casos parece

natural ponderar por separado los distintos errores para enfatizar

aquellos datos ms precisos o fiables.

La solucin matemtica de este problema es similar a la del problema

de mnimos cuadrados determinista ya estudiado, como se

comprueba realizando el cambio de variable adecuado.

22

c

Restricciones Lineales

Otras veces, la aproximacin debe cumplir ciertas restricciones:

min J ( ) sujeto a A = b

Solucin: multiplicadores de Lagrange

L( ) = (x H )

T

(x H ) +

T

(A b)

cL( )

= 0

c

A b = 0

=

(H

T

H)

1

A

T

(A(H

T

H)

1

A

T

) ( A

b)

23

Otro planteamiento distinto consiste en imponer a la aproximacin

ptima restricciones lineales que, en muchos casos, representan

cierta informacin a priori de la que se dispone sobre el verdadero

parmetro de inters, mejorando as la estima.

La solucin a este problema con restricciones pasa primero por

derivar la funcin Lagrangiana e igualarla a cero y, en segundo lugar,

utilizar las restricciones para hallar los multiplicadores adecuados y

as encontrar la solucin.

23

Dependencia No Lineal

Qu podemos hacer cuando s( ) depende no linealmente con ?

Posibilidades:

A. Casos simples:

1. Transformacin de los parmetros.

2. Separabilidad de los parmetros.

B. Casos difciles:

3. Otros mtodos de minimizacin: NR, GN, etc.

24

Hasta ahora se ha considerado una dependencia lineal de la seal

sobre los parmetros, lo cual, nos permiti encontrar soluciones

cerradas para el estimador. En general, cuando la dependencia de la

seal sobre los parmetros es no lineal, la determinacin de

soluciones cerradas es muy difcil o imposible. Por ello, se suele

recurrir a mtodos de bsqueda en rejilla si la dimensionalidad de los

parmetros es pequea, o a mtodos iterativos de minimizacin como

el mtodo de Newton-Raphson o el mtodo de Gauss-Newton.

Una de las pocas excepciones a esta regla la constituyen los casos en

los que la transformacin de parmetros o la separacin de

parmetros es viable.

24

Transformacin de Parmetros

Univ

oca

. = g ( )

Si - g :

s[n] lineal en .

. = (H

T

H )

1

H

T

x

= g

1

(. )

25

El mtodo de transformacin de parmetros consiste en buscar una

transformacin unvoca de stos que haga lineal el modelo de la

seal en el nuevo espacio.

Si es posible encontrar dicha transformacin, se puede resolver el

problema de Mnimos Cuadrados directamente sobre el dominio

transformado y luego realizar la transformacin inversa para obtener

el parmetro estimado.

El problema de este mtodo radica en que, en general, la

determinacin de dicha transformacin unvoca suele ser muy difcil.

25

1 0 2 0

.

Ejemplo

Estimacin de la amplitud y fase de un coseno en ruido.

| A cos 3 |

. = |

A sin 3

x[n] = A cos(2I

0

n + 3) + e[n]

\ .

= . cos 2I n + . sin 2I n + e[n]

|

H =

1

cos 2I

o

0 |

|

sin 2I

o |

|

|

|

\

cos 2I

o

( N 1)

sin 2 I

o

( N 1)

.

1. . = (H

T

H )

1

H

T

x

|

A

|

|

.

2

+ .

2

|

|

1 2

|

2.

3

|

=

arctan(

.

2

)

|

\ .

\

1 .

26

En este ejemplo vamos a ver un caso de dependencia no lineal. Se

trata de estimar la amplitud y fase de un coseno, del que se conoce su

frecuencia y que se encuentra inmerso en ruido, aplicando el mtodo

de transformacin de parmetros.

Si descomponemos el coseno con fase en trminos de senos y

cosenos simples observamos que la transformacin a coordenadas

cartesianas de la amplitud y de la fase (considerando slo el

argumento principal de sta) hace lineal la dependencia de la seal

sobre este nuevo espacio, al tiempo que la transformacin es

unvoca.

De esta forma, el problema se resuelve fcilmente sobre el dominio

transformado y se obtienen los parmetros estimados sin ms que

invertir la transformacin.

26

5

AL

0

SE

-5

0 0. 2 0. 4 0. 6 0. 8 1

TIEM PO

5

S

E

N

O

I

C

A 0

V

R

E

S

O

B

-5

0 0. 2 0. 4 0. 6 0. 8 1

TIEM PO

Ejemplo (continuacin)

5

N = 100

f

0

= 5Hz.

A = 3 V. 0

= 1 rad.

A

|

| 3.09 |

| |

3

|

=

1.04

|

\ . \ . -5

0 0. 2 0. 4 0. 6 0. 8 1

TIE M P O

Seal [negro], observaciones [azul], estima [verde].

27

En esta figura se muestran con los puntos azules 100 observaciones

de un coseno inmerso en ruido. El coseno tiene una frecuencia

conocida de 5 Hz. y una amplitud y fase desconocidas que nos

proponemos estimar. Su componente de seal aparece dibujada en

trazo negro continuo sobre la figura.

La estima del coseno se realiza utilizando el estimador obtenido

mediante el mtodo de transformacin de parmetros y se representa

con puntos claros (verdes) en el grfico.

Sobre la figura se puede comprobar que, a pesar del pequeo tamao

de la poblacin de muestras, la estima resulta tener una gran

precisin coincidiendo prcticamente la seal estimada con la seal

existente.

27

Separabilidad de Parmetros

Sea

= (.

T

,

T

)

T

el problema se dice separable si

s = H(.)

no lineal en o

lineal en |

= (H

T

(.)H(.))

1

H

T

(.)x

y el problema se simplifica a la bsqueda del

que minimiza

J (.,

) = x

T

(I H(.)(H

T

(.)H(.))

1

H

T

(.))x

28

Algunas veces los parmetros no son directamente transformables

aunque s existe un subconjunto de ellos sobre los que la seal

depende linealmente. En estos casos el problema de dice separable.

El problema se simplifica ya que su dimensin se reduce. La

expresin ptima de los parmetros lineales se puede encontrar

aplicando Mnimos Cuadrados en funcin del resto. De esta forma, el

problema se limita a una bsqueda del mnimo sobre los parmetros

que caracterizan la dependencia no lineal de la seal.

28

P

r

o

b

l

e

m

a

s

d

e

c

o

n

v

e

r

g

e

n

c

i

a

T

T T

\ .

Otros mtodos

| cJ |

Iteracin de Newton-Raphson: busca los ceros de

T

|

=

|

c | c

1

|

|

| c |

\ c .

( k +1)

( k )

J

|

|

J

|

c

T

\

c

T

.

|

\

c

T

.

=

( k )

Iteracin de Gauss-Newton: lineariza la dependencia de s(u) sobre u.

[ ; ]

[ ;

( k )

]

cs[n;

( k )

]

(

( k )

)

s n ~ s n +

c

T

=

( k )

H(

( k )

)

( k +1)

=

( k )

+ (H

T

(

( k )

)H(

( k )

))

1

H

T

(

( k )

) (x s(

( k )

))

29

Cuando los mtodos de transformacin de parmetros o de

separabilidad no son aplicables debemos recurrir a algoritmos de

minimizacin no lineal, que suelen consistir en mtodos de bsqueda

iterativa de la solucin. Dos de los algoritmos de este tipo ms

famosos son los mtodos de Newton-Raphson y de Gauss-Newton.

El mtodo de Newton-Rapshon es el conocido mtodo de bsqueda

de los ceros de la funcin derivada. Es un mtodo invariante (que no

depende de la base sobre la que estn expresados los parmetros) y

posee una convergencia cuadrtica cuando sta se da. Uno de sus

principales inconvenientes es que precisa el clculo explcito del

Hessiano de la funcin.

El mtodo de Gauss-Newton es propiamente un algoritmo de

minimizacin que lineariza la dependencia de la seal sobre los

parmetros entorno a su valor nominal en cada iteracin. De esta

forma, cada una de las funciones de coste resultantes de esta

secuencia es cuadrtica y se minimiza en una sla iteracin.

Desafortunadamente, ambos mtodos, pueden evidenciar problemas

de convergencia cuando la inicilizacin se encuentra muy lejos de la

solucin.

29

Puntos a Tratar

1. Introduccin.

2. Mnimos cuadrados determinista.

2.1. Interpretacin geomtrica.

2.2. Aumentando el orden de la aproximacin.

2.3. Aumentando el nmero de observaciones.

2.4. Mnimos cuadrados con restricciones.

2.5. Dependencia no lineal.

3. Mnimos cuadrados estocstico.

3.1. Teorema de Gauss-Markov.

3.2. Interpretacin Geomtrica.

3.3. Teorema de Aitken.

4. Conclusiones.

5. Referencias.

30

Otra variante del mtodo de Mnimos Cuadrados se considera un

mtodo estocstico.

Esta variante presenta similitudes en su formulacin y, a la vez,

claras diferencias de interpretacin con respecto mtodo

determinista.

En este apartado plantearemos una de las variantes del problema de

Mnimos Cuadrados Estocstico en la que los parmetros del modelo

se consideran un vector determinista. Enunciaremos el teorema de

Gauss-Markov y presentaremos una interpretacin geomtrica de

ste. Para terminar exponiendo el caso ms general del teorema

precedente que se conoce bajo el nombre de teorema de Aitken.

30

Mnimos Cuadrados Estocstico

31

Consideremos el modelo lineal de los datos x = H + e

Ahora los elementos de x y e se

consideran v.a. frente a las

realizaciones en el caso determinista.

Mtodo de estimacin: hiptesis prob. sobre la distribucin del error.

caracterizacin parcial

basada en la media y covarianza.

Ventaja frente a ML y

tcnicas Bayesianas.

31

La radical diferencia entre el mtodo determinista y el mtodo

estocstico consiste en que ahora se consideran hiptesis

probabilsticas sobre la funcin de densidad de probabilidad del error

y de las observaciones. Esto hace que el mtodo de Mnimos

Cuadrados Estocstico se considere un mtodo propio de estimacin

frente a la versin determinista que se entenda como un mtodo de

aproximacin.

Ahora los elementos del error y de las observaciones son variables

aleatorias distribuidas de acuerdo con una cierta funcin densidad de

probabilidad.

El mtodo de Mnimos Cuadrados Estocstico es una de las varias

aproximaciones existentes en teora de la estimacin, siendo las

principales alternativas a ste: Mxima Verosimilitud y las tcnicas

Bayesianas. Estas otras tcnicas normalmente requieren una

descripcin estadstica completa de las variables del problema en

trminos de sus funciones de distribucin de probabilidad, mientras

que el mtodo de Mnimos Cuadrados Estocstico slo requiere una

caracterizacin parcial basada en medias y matrices de covarianza.

Mnimos Cuadrados Estocstico

32

i e i

2

Criterio natural del optimalidad:

MSE +

p(

| )

i MSE

=

i

| sesgo

| +

i

i i

v ar

i

E |

|

2

= | E[

] |

2

+

E |

E[

] |

2

i i i i i i

i

Estimador lineal

= a

T

x

e insesgado

E[

] =

a

T

h = /

i i i i i j ij

Objetivo:

MSE = var = a

T

C a

i i

Min var sujeto a

lineal e insesgado i = 1, ,p

i

i

i

Min a

i

C

e

a

i

sujeto a a h

j

= /

ij

i,j = 1, ,p

T T

i

i

32

Un criterio natural de optimalidad en estadstica consisten en

minimizar el error cuadrtico medio (MSE) entre el el estimador real

y su estima (que es una variable aleatoria). La justificacin de este

criterio radica en que trata de agrupar la funcin densidad de

probabilidad del estimador sobre el parmetro verdadero. El trmino

MSE se descompone en otros dos con interpretaciones muy

significativas: por una parte est el sesgo del estimador al cuadrado

mientras que, por la otra, est la varianza del estimador.

En lugar de pretender minimizar el criterio MSE de forma genrica,

el mtodo de mnimos cuadrados estocstico limita esa bsqueda a

una clase especial de estimadores, la de los estimadores lineales e

insesgados.

As, el problema de mnimos cuadrados estocstico se traduce en

minimizar la varianza de cada componente del estimador sujeto a

restricciones que garantizan que ste sea lineal e insesgado. La

formulacin matemtica de este problema resulta ser totalmente

determinista y su solucin se explicita en el siguiente teorema.

33

e e

Teorema de Gauss-Markov

Si los datos siguen el modelo lineal y el error tiene media cero y

matriz de covarianza

C = 1

2

I

el ptimo estimador Lineal e

Insesgado de Mmima Varianza de los parmetros es

C

= 1

e

(H H)

= (H

T

H)

1

H

T

x y

2 T 1

Similar a la soluc. de MCD,

aunque la interpretacin es distinta.

33

El teorema de Gauss-Markov contempla la hiptesis adicional de que

el error sea de media cero y que la matriz de covarianzas del error

tenga la estructura de la matriz identidad escalada por la varianza del

error. Bajo estas condiciones, el teorema nos proporciona la

expresin del estimador ptimo lineal e insesgado de mnima

varianza, as como tambin, la matriz de covarianza de este

estimador.

El sorprendente el hecho de que la solucin a este problema sea la

misma que la del mtodo determinista puede conducir en muchos

casos a una interpretacin errnea de este estimador.

i

Interpretacin Geomtrica

Proyeccin

x

-

H

Proyeccin

Oblcua.

s = HA x

(H)

La proyeccin min C

s

min C

i

i

34

La interpretacin geomtrica del teorema de Gauss-Markov se

presenta en la siguiente figura. El plano denota el subespacio

generado por las columnas de la matriz de observacin. En el centro

de ste hay un punto que denota la componente de seal. Sobre la

seal se superpone la v.a. ruido que (al ser de varianza constante para

cada componente) se representa como una esfera centrada en la

componente de seal y con el radio de la desviacin tpica. La v.a.

observaciones es pues la resultante de sumar la seal ms la v.a.

ruido.

La proyeccin de la v.a. observacin sobre el plano conduce, en

general, a una superficie elptica centrada en el valor verdadero de la

seal y que representa la v.a. que estima la componente de seal. La

parte comn a todas las posibles proyecciones est dada por el rea

que proporciona la proyeccin ortogonal. Esta es, pues, la proyeccin

que garantiza una menor varianza en cada una de las componentes

del estimador lineal insesgado.

34

1

2

Teorema de Aitken

Si los datos siguen el modelo lineal y el error tiene media cero y

matriz de covarianza C

e

el ptimo estimador Lineal e Insesgado de

Mmima Varianza de los parmetros es

= (H

T

C

1

H)

1

H

T

C

1

x y

T 1 1

e e

C

= (H C

e

H)

Similar a MCD con

ponderacin del error.

Demonstracin: cambio de variable

x = C

2

x

1

C

e

= I

= H x = (H C

e

H) H C

e

x

e

H = C

e

H

+ T 1 1 T 1

35

La versin general del estimador de mnimos cuadrados estocstico

la proporciona el teorema de Aitken. En este caso se permite al error

tener una matriz de covarianzas arbitraria salvo por el hecho de que

esta debe ser de rango completo y definida positiva.

La solucin general del problema es similar a la del mtodo

determinista con ponderacin del error cuando se utiliza como matriz

de ponderacin la inversa de la matriz de covarianzas del error.

La demostracin de este teorema se logra a travs de un sencillo

cambio de variable que haga que la nueva variable aleatoria error

cumpla las condiciones del teorema de Gauss-Markov.

35

Puntos a Tratar

1. Introduccin.

2. Mnimos cuadrados determinista.

2.1. Interpretacin geomtrica.

2.2. Aumentando el orden de la aproximacin.

2.3. Aumentando el nmero de observaciones.

2.4. Mnimos cuadrados con restricciones.

2.5. Dependencia no lineal.

3. Mnimos cuadrados estocstico.

3.1. Teorema de Gauss-Markov.

3.2. Interpretacin Geomtrica.

3.3. Teorema de Aitken.

4. Conclusiones.

5. Referencias.

36

En este punto nos disponemos a presentar las conclusiones ms

importantes y algunas referencias tiles sobre el tema.

36

Conclusiones Importantes

; MC determinista mtodo de aproximacin.

+ Interpretacin geomtrica y principio de ortogonalidad.

+ Innovacin soluc. recursivas.

Dependencia no lineal tcnicas de minimizacin.

; MC estocstico mtodo de estimacin.

+ Caracterizacin parcial.

+ Equivalencia matemtica entre las soluc MCD y el MCE.

Interpretacin diferente de MCD!

; Ambos mtodos:

+ Simplicidad en las hiptesis estimador muy utilizado.

37

El mtodo de Mnimos Cuadrados Determinista es propiamente un

mtodo de aproximacin. Su interpretacin geomtrica nos

conduce a un importante principio: el principio de ortogonalidad

cuya validez es extensible a cualquier espacio de Hilbert.

Otro concepto clave es el de innovacin que nos conduce a una

interpretacin sencilla de las soluciones recursivas.

El caso ms complicado es el de dependencia no lineal en la que la

solucin al problema pocas veces adopta la forma de una

expresin cerrada.

El mtodo de Mnimos Cuadrados Estocstico es propiamente un

mtodo de estimacin. Frente a otros mtodos estadsticos ste

slo requiere una caracterizacin parcial del error.

Existe una equivalencia matemtica entre las soluciones al

problema determinista y estocstico aunque la interpretacin de

ambos difiere.

En ambos mtodos la simplicidad de sus hiptesis y formulacin

hacen que estos sean muy utilizados en la prctica para la

estimacin de los parmetros de inters.

37

Conclusiones Futuras

+ Otra versin estocstica del mtodo

de MC considera a u como una v.a.

Estimacin Lineal Bayesiana

MC no posee consideraciones de optimalidad (salvo si e ~ Gauss.).

38

Algunas de las conclusiones que todava no hemos podido obtener

pero que examinaremos ms adelante en el curso, y que aparecen

directamente relacionadas con este tema, son las siguientes:

Existe otra versin estocstica del mtodo de Mnimos Cuadrados

que considera al vector de parmetros como un vector de variables

aleatorias. Esta aproximacin recibe el nombre de estimacin

Bayesiana y se suele utilizar para aadir informacin conocida a

priori sobre el vector de parmetros para, as, intentar mejorar la

estima.

El mtodo de Mnimos Cuadrados Estocstico es un mtodo de

estimacin que, en general, no posee propiedades de optimalidad

estadstica, salvo cuando el error se distribuye de acuerdo con una

funcin de probabilidad Gaussiana, puesto que, en este caso, el

estimador ptimo es una funcin lineal de las observaciones.

38

Referencias

[Kay,93] Kay, Steven M., Fundamentals of Statistical Signal Processing:

Estimation Theory, Prentice Hall, 1993. ISBN: 0-13-345711-7.

Captulos 4,6 y 8.

[Luenberger,69] Luenberger, David G., Optimization by Vector Space Methods, John

Willey & Sons, 1969. SBN: 47155359x. Captulos 3 y 4.

[Kailath,00] Kaylath, T., Sayed, A.H., Hassibi, B., Linear Estimation,

Prentice Hall, 2000. ISBN: 0-13-022464-2. Captulos 1 y 2.

[Haykin,96] Haykin, Simon, Adaptive Filter Theory, Tercera edicin, Prentice

Hall, ISBN: 0-13-397985-7. Captulos 11, 12 y 13.

[Mendel, 95] Mendel, Jerry M., Lessons in Estimation Theory for Signal Processing,

Communications and Control, Prentice Hall, 1995.

ISBN: 0-13-120981-7. Captulos 1 al 8.

[Stuard,91] Stuard, A., Ord, J.K. Kelldalls Advanced Theory of Statistics,

Quinta edicin, Volumen 2: Classical Inference and Relationship,

editorial Edward Arnold, ISBN: 0-340-52923-7. Captulos 17, 19 y 28.

39

De entre la bibliografa recomendada sobre el tema de Mnimos

Cuadrados destacamos algunos libros en especial:

Las referencias preferidas sobre el tema son [Kay,93] y

[Luemberger,69]. La primera por su claridad de exposicin y

abundante provisin de ejemplos, la segunda referencia por su

enfoque geomtrico del problema de Mnimos Cuadrados sobre

espacios vectoriales de Hilbert.

Otros libros interesantes son [Haykin,96] y [Mendel,95] que estn

pensados como libros de texto para los ltimos cursos de la carrera y,

en especial, para cursos de doctorado.

Por ltimo, dos libros para profundizar en el tema son [Kailath,00]

(que acaba de aparecer recientemente) y [Stuard,91]. Ambos tratan

de una forma mucho ms exhaustiva y detallada el problema de

estimacin lineal en sus distintas variantes.

39

También podría gustarte

- Solemne 2 Parte 1Documento3 páginasSolemne 2 Parte 1Mauricio Baeza100% (1)

- Tarea UNIDAD 1 2 MATEMATICASDocumento9 páginasTarea UNIDAD 1 2 MATEMATICASIrina Vanessa Moreira PalaciosAún no hay calificaciones

- Series de Potencias (Ejercicios Resueltos)Documento5 páginasSeries de Potencias (Ejercicios Resueltos)Pia Saab ChemesAún no hay calificaciones

- INFORME Metodo GaussDocumento12 páginasINFORME Metodo GaussCARLA ANAHI100% (1)

- Inv. T2Documento26 páginasInv. T2fabian0% (1)

- Ternas PitagóricasDocumento7 páginasTernas PitagóricasxD_RnGado100% (1)

- El Metodo de Minimos CuadradosDocumento39 páginasEl Metodo de Minimos CuadradosAldo Jesús Casanova LinaresAún no hay calificaciones

- Actividad Complementaria Análisis NuméricoDocumento15 páginasActividad Complementaria Análisis NuméricoLeidy Daniela Chinchilla AgamezAún no hay calificaciones

- Minimos CuadradosDocumento6 páginasMinimos CuadradosDiego Orozco RodriguezAún no hay calificaciones

- Unidad 2Documento10 páginasUnidad 2Brian CastilloAún no hay calificaciones

- Tarea 2Documento8 páginasTarea 2yaneth sandoval rangelAún no hay calificaciones

- Metodo de La SecanteDocumento12 páginasMetodo de La SecanteAlondraAún no hay calificaciones

- Analisis de GraficasDocumento13 páginasAnalisis de GraficasFernando Zarate MuñozAún no hay calificaciones

- Act.4 - REGRESION LINEAL POR MINIMOS CUADRADOSDocumento5 páginasAct.4 - REGRESION LINEAL POR MINIMOS CUADRADOSmeyviss armgAún no hay calificaciones

- Calculo Numerico Trabajo Nº1Documento13 páginasCalculo Numerico Trabajo Nº1Joel RodriguezAún no hay calificaciones

- Tarea 1 Minimos CuadradosDocumento5 páginasTarea 1 Minimos CuadradosMaybelline HuertasAún no hay calificaciones

- M To Do Spar Aob Tenere Stim AdoresDocumento43 páginasM To Do Spar Aob Tenere Stim AdoresGerman Galdamez OvandoAún no hay calificaciones

- Unidad 2Documento12 páginasUnidad 2Gabriel Colli CabAún no hay calificaciones

- Informe NuméricaDocumento17 páginasInforme NuméricaAida Calvo FleitesAún no hay calificaciones

- Camino MinimoDocumento12 páginasCamino MinimoJuan PeraltaAún no hay calificaciones

- Minimos CuadradosDocumento7 páginasMinimos CuadradosAaron HernandezAún no hay calificaciones

- Cuaderno MétodosDocumento31 páginasCuaderno MétodosOSCAR ANDRES VASQUEZ GARZONAún no hay calificaciones

- Trabajo de Primer Parcial Metodos NumericosDocumento11 páginasTrabajo de Primer Parcial Metodos NumericosDiego Manchay100% (2)

- Proyecto Metodos NumericosDocumento27 páginasProyecto Metodos NumericosRafa MaldonadoAún no hay calificaciones

- Capitulo I - ENL 2Documento26 páginasCapitulo I - ENL 2Ronald Rupay YauriAún no hay calificaciones

- Metodo de Punto FijoDocumento16 páginasMetodo de Punto FijoequispeveAún no hay calificaciones

- Métodos NuméricosDocumento43 páginasMétodos NuméricosmetabarbonAún no hay calificaciones

- Minimos CuadradosDocumento10 páginasMinimos CuadradosMichu OviedoAún no hay calificaciones

- Método de la Secante en Ingeniería IndustrialDocumento9 páginasMétodo de la Secante en Ingeniería IndustrialJOSE ANDRESAún no hay calificaciones

- Mínimos CuadradosDocumento11 páginasMínimos Cuadradospabloaguilar3100% (2)

- Investigacion Ec - Nolineales Por P.jefferson TucupiDocumento9 páginasInvestigacion Ec - Nolineales Por P.jefferson TucupiTucupi jimmyAún no hay calificaciones

- Guerrero José - PRACTICA 3Documento7 páginasGuerrero José - PRACTICA 3José TapiaAún no hay calificaciones

- Tesis Learning MachineDocumento52 páginasTesis Learning MachinedamianquijanoAún no hay calificaciones

- Mínimos cuadrados ajuste curvasDocumento8 páginasMínimos cuadrados ajuste curvasJuan BautistaAún no hay calificaciones

- Proyecto de MetodosDocumento6 páginasProyecto de MetodosAndres Felipe GongoraAún no hay calificaciones

- Analisis Numerico Tema 2Documento16 páginasAnalisis Numerico Tema 2Nicolás MéndezAún no hay calificaciones

- Proyecto1 (Reporte)Documento26 páginasProyecto1 (Reporte)Adrian RodriguezAún no hay calificaciones

- Informe Laboratorio 4Documento18 páginasInforme Laboratorio 4Jhonatan AlanocaAún no hay calificaciones

- INVESTIGACION Metodos ECUACIONES NOLINEALES POR P.JEFFERSON TUCUPIDocumento9 páginasINVESTIGACION Metodos ECUACIONES NOLINEALES POR P.JEFFERSON TUCUPITucupi jimmyAún no hay calificaciones

- AJUSTE DE CURVAS PresentacionDocumento20 páginasAJUSTE DE CURVAS PresentacionMateo RiañoAún no hay calificaciones

- Ajustes Por Minimo CuadradosDocumento16 páginasAjustes Por Minimo CuadradosMikhail LópezAún no hay calificaciones

- Unidad 2Documento28 páginasUnidad 2Ivan Alejandro QuirOz78% (9)

- Solución numérica de ecuaciones algebraicasDocumento23 páginasSolución numérica de ecuaciones algebraicasValeria VelazquezAún no hay calificaciones

- Introducción A La Teoría de ErroresDocumento6 páginasIntroducción A La Teoría de ErroresFrancisco Gabriel Puga LojoAún no hay calificaciones

- Minimos CuadradosDocumento9 páginasMinimos CuadradosErick Alonzo JimenezAún no hay calificaciones

- ANALISISDocumento58 páginasANALISISAbby AvendañoAún no hay calificaciones

- Investigación de La Unidad 5, Métodos Numéricos (Método de Euler)Documento8 páginasInvestigación de La Unidad 5, Métodos Numéricos (Método de Euler)Jesús Alexander MejíazAún no hay calificaciones

- Iciv MN U2 It E1Documento35 páginasIciv MN U2 It E1EDER ALBERTO MALDONADO PIMENTELAún no hay calificaciones

- Investigación U23-Metodos NumericosDocumento40 páginasInvestigación U23-Metodos NumericosZury MartinezAún no hay calificaciones

- Minimos Cuadrados-Pc2Documento13 páginasMinimos Cuadrados-Pc2SANDY LUZ LAVERIANO NAVARRO100% (1)

- Análisis Del Método de Regresión Lineal Simple.Documento12 páginasAnálisis Del Método de Regresión Lineal Simple.alberto100% (1)

- Mínimos cuadrados línea regresiónDocumento3 páginasMínimos cuadrados línea regresiónYeimy RincònAún no hay calificaciones

- Evaluacion de Recursos Mineros.v.3Documento125 páginasEvaluacion de Recursos Mineros.v.3Boris Alarcón HasanAún no hay calificaciones

- Métodos NuméricosDocumento16 páginasMétodos NuméricosAbidan MedinaAún no hay calificaciones

- Metodo de La SecanteDocumento6 páginasMetodo de La SecanteWeslyVillamilAún no hay calificaciones

- Análisis de métodos numéricos de interpolación para determinar coordenadas de cables en una estructura de teleféricoDocumento56 páginasAnálisis de métodos numéricos de interpolación para determinar coordenadas de cables en una estructura de teleféricoMiguel Ramos SotoAún no hay calificaciones

- Método de La SecanteDocumento8 páginasMétodo de La Secante_lok_Aún no hay calificaciones

- UNIDAD N°4. Matemática PI - Tercera ParteDocumento38 páginasUNIDAD N°4. Matemática PI - Tercera ParteMartinAún no hay calificaciones

- Monografía Ecuaciones No Lineales PDFDocumento12 páginasMonografía Ecuaciones No Lineales PDFAlfredo EscamillaAún no hay calificaciones

- Metodo de Minimos Cuadrados OrdinariosDocumento6 páginasMetodo de Minimos Cuadrados OrdinariosAlejandro CoronaAún no hay calificaciones

- Análisis estadístico de datos experimentales mediante histogramas y desviación estándarDocumento14 páginasAnálisis estadístico de datos experimentales mediante histogramas y desviación estándarRichard GalvesAún no hay calificaciones

- Sistema de Ecuaciones Lineales Metodos NumericosDocumento49 páginasSistema de Ecuaciones Lineales Metodos NumericosHéctor Quispe ChancasAún no hay calificaciones

- Semana 1 AritmeticaDocumento8 páginasSemana 1 AritmeticaChristian InfanteAún no hay calificaciones

- Ecuacion Diferencial Orden Grado LinealidadDocumento5 páginasEcuacion Diferencial Orden Grado LinealidadKandro King Aguilar Andrade100% (5)

- libroED PDFDocumento407 páginaslibroED PDFMax Giver Michael Avila HanccoAún no hay calificaciones

- Examen Parcial Semana 4Documento9 páginasExamen Parcial Semana 4mauricio67% (3)

- Calculo DiferencialDocumento3 páginasCalculo Diferencialcarlos castillaAún no hay calificaciones

- Funciones infinitas y sucesiones en números realesDocumento5 páginasFunciones infinitas y sucesiones en números realesleoAún no hay calificaciones

- Ejercicios Eje 3 de 1Documento20 páginasEjercicios Eje 3 de 1Marelin FontalvoAún no hay calificaciones

- Notas de Topología General: Introducción a las Bases TopológicasDocumento55 páginasNotas de Topología General: Introducción a las Bases TopológicasYordan FloresAún no hay calificaciones

- TPG 1 - 2009 - Turno Mañana - ResolucionesDocumento11 páginasTPG 1 - 2009 - Turno Mañana - ResolucionesAleComasAún no hay calificaciones

- Operaciones Exponenciales y LogaritmicasDocumento6 páginasOperaciones Exponenciales y LogaritmicasWanda DavidAún no hay calificaciones

- Logaritmos y Sus PropiedadesDocumento5 páginasLogaritmos y Sus PropiedadesVoro SouanAún no hay calificaciones

- Conceptos Básicos de Geometría PDFDocumento3 páginasConceptos Básicos de Geometría PDFGongo07100% (1)

- MD Sesion05bDocumento8 páginasMD Sesion05bConny AndreaAún no hay calificaciones

- Algebra Superior - Tarea 2 - Números ComplejosDocumento5 páginasAlgebra Superior - Tarea 2 - Números ComplejosPamela Carolina GilAún no hay calificaciones

- Currículo Matemática Bachillerato SB GuayaquilDocumento259 páginasCurrículo Matemática Bachillerato SB GuayaquilCarlos CherrezAún no hay calificaciones

- Tarea 3 PyEDocumento3 páginasTarea 3 PyEjesus martinezAún no hay calificaciones

- Ejer CalculoDocumento7 páginasEjer CalculoJuan Manuel Ortiz LeonAún no hay calificaciones

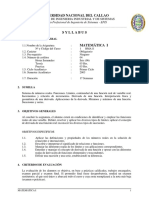

- Matemática I Syllabus UN CallaoDocumento4 páginasMatemática I Syllabus UN CallaodanielAún no hay calificaciones

- Calculo Vectorial 2 Ciencias UniDocumento2 páginasCalculo Vectorial 2 Ciencias Unicindy_a_18209Aún no hay calificaciones

- Sistema de Ecuaciones LinealesDocumento4 páginasSistema de Ecuaciones LinealesAlina MichelAún no hay calificaciones

- Practica 6Documento12 páginasPractica 6Kelley HernandezAún no hay calificaciones

- 02ecuaciones Empiricas - Movimiento Rectilineo Uniformemente VariadoDocumento10 páginas02ecuaciones Empiricas - Movimiento Rectilineo Uniformemente VariadoTana AllysonAún no hay calificaciones

- Números naturales, enteros y fraccionariosDocumento47 páginasNúmeros naturales, enteros y fraccionariosSanti MayaAún no hay calificaciones

- 3.1sistema de Ecuaciones LinealesDocumento5 páginas3.1sistema de Ecuaciones LinealesCARLOS ALBERTO HERRERA PEREZAún no hay calificaciones

- Series de Fourier InformeDocumento4 páginasSeries de Fourier InformeAlvaro YucázAún no hay calificaciones

- Clase 05 - Propiedades de Los Números ComplejosDocumento18 páginasClase 05 - Propiedades de Los Números ComplejosBelén FlorentinaAún no hay calificaciones