Documentos de Académico

Documentos de Profesional

Documentos de Cultura

17 Redes Difusas Dinamicas para Identificacion...

17 Redes Difusas Dinamicas para Identificacion...

Cargado por

Alicia CuestaTítulo original

Derechos de autor

Formatos disponibles

Compartir este documento

Compartir o incrustar documentos

¿Le pareció útil este documento?

¿Este contenido es inapropiado?

Denunciar este documentoCopyright:

Formatos disponibles

17 Redes Difusas Dinamicas para Identificacion...

17 Redes Difusas Dinamicas para Identificacion...

Cargado por

Alicia CuestaCopyright:

Formatos disponibles

CENTRO DE INVESTIGACIN Y DE ESTUDIOS AVANZADOS

DEL

INSTITUTO POLITCNICO NACIONAL

DEPARTAMENTO DE CONTROL AUTOMTICO

Redes neuronales difusas dinmicas para

identificacin y control adaptable

TESIS QUE PRESENTA

Rigoberto Toxqui Toxqui

PARA OBTENER EL GRADO DE

MAESTRO EN CIENCIAS

EN LA ESPECIALIDAD DE

CONTROL AUTOMTICO

DIRECTORES DE TESIS:

Dr. Wen Yu Liu

Mxico, D.F., abril del 2003.

ndice general

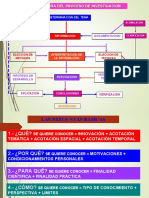

1. Introduccin 1

1.1. Motivacin . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.2. Objetivos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.3. Publicaciones . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

1.4. Estructura de la tesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2. Neuro difuso identicacin y control 7

2.1. Redes neuronales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

2.1.1. La neurona . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

2.1.2. Topologa de la red neuronal (RN) . . . . . . . . . . . . . . . . . . . 12

2.2. Lgica difusa . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

2.2.1. Conjuntos difusos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

2.2.2. Borrosicador (Fuzzier) . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.2.3. Desborrosicador (Defuzzier) . . . . . . . . . . . . . . . . . . . . . . 17

2.3. Neuro difuso (Neurofuzzy) . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.3.1. Esttica y dinmica en sistemas difusos . . . . . . . . . . . . . . . . . 20

2.3.2. Comparaciones generales de sistemas difuso y redes neuronales . . . . 21

2.4. La estabilidad de la entrada a estado (ISS) y funciones de Lyapunov ISS . . 22

3. Esttica neuro difuso para identicacin 25

3.1. Esttica difusa redes neuronales . . . . . . . . . . . . . . . . . . . . . . . . . 25

ii NDICE GENERAL

3.1.1. Estructura tipos mamdani esttica difusa redes neuronales . . . . . . 29

3.1.2. Estructura tipos takagi sugeno kang esttica difusa redes neuronales . 31

3.2. Sistemas de identicacin difusa . . . . . . . . . . . . . . . . . . . . . . . . . 32

3.3. Sistemas de identicacin difusa neuronal . . . . . . . . . . . . . . . . . . . . 35

3.3.1. Funciones pertenencia conocidas . . . . . . . . . . . . . . . . . . . . . 35

3.3.2. Funciones pertenencia desconocidas . . . . . . . . . . . . . . . . . . . 37

3.4. Simulacin . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

4. Dinmica neuro difuso para identicacin 49

4.1. Dinmica difusa redes neuronales . . . . . . . . . . . . . . . . . . . . . . . . 49

4.1.1. Estructura tipo mamdani dinmica difusa redes neuronales . . . . . . 49

4.1.2. Estructura tipo takagi sugeno dinmica difusa redes neuronales . . . 52

4.2. Sistemas de identicacin con dinmica neuro difuso . . . . . . . . . . . . . 53

4.2.1. Funciones pertenencia conocidas . . . . . . . . . . . . . . . . . . . . . 53

4.2.2. Funciones pertenencia desconocidas . . . . . . . . . . . . . . . . . . . 55

4.3. Simulacin . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

5. Redes neuronales difusas dinmicas para sistemas no lineales de control

adaptable 67

5.1. Estructura difusa neuro control . . . . . . . . . . . . . . . . . . . . . . . . . 67

5.2. Difusa neuro control con algoritmo estable . . . . . . . . . . . . . . . . . . . 71

5.2.1. Aprendizaje sin funciones pertenencia . . . . . . . . . . . . . . . . . . 71

5.2.2. Aprendizaje con funciones pertenencia . . . . . . . . . . . . . . . . . 73

5.3. Simulacin . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

6. Conclusiones 83

ndice de guras

2.1. Modelo de una neurona . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

2.2. a) Escaln, b) Saturacin c) Sigmoide d) Tangente hiperblica . . . . . . . 13

2.3. Arquitectura bsica de un controlador de lgica difusa (FLC) . . . . . . . . . 16

2.4. Estructura se un sistema de lgica difusa . . . . . . . . . . . . . . . . . . . . 18

2.5. Representacin de la red de un sistema difuso con una red neuronal de tres

capas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

3.1. Arquitectura de un sistema neuronal difuso . . . . . . . . . . . . . . . . . . . 31

3.2. Seleccin de variables de proposicin . . . . . . . . . . . . . . . . . . . . . . 35

3.3. Sistema . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

3.4. Datos de consecuencia y ruido . . . . . . . . . . . . . . . . . . . . . . . . . . 41

3.5. Funcin gausiana . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

3.6. Aproximacin de la funcin . . . . . . . . . . . . . . . . . . . . . . . . . . . 42

3.7. Aprendizaje inestable . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43

3.8. Error medio cuadratico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

3.9. Modelado de un sistema no lineal . . . . . . . . . . . . . . . . . . . . . . . . 46

3.10. Error cuadratico medio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

4.1. La estructura del sistema de la dinmica neuronal difuso . . . . . . . . . . . 51

4.2. Sistema dinmico catico de Lorenz . . . . . . . . . . . . . . . . . . . . . . 64

4.3. Sistema dinmico catico de Lorenz . . . . . . . . . . . . . . . . . . . . . . 65

4.4. Sistema dinmico catico de Lorenz . . . . . . . . . . . . . . . . . . . . . . 66

iv NDICE DE FIGURAS

5.1. Identicacin del sistema no lineal para el modelo Chen . . . . . . . . . . . . 79

5.2. Identicacin del sistema no lineal para el modelo Narendra . . . . . . . . . 80

5.3. Identicacin del sistema no lineal para el modelo Wen . . . . . . . . . . . . 81

Captulo 1

Introduccin

Las redes neuronales han sido populares modelos en una extensa variedad en modelado

y control, sin embargo las redes neuronales no pueden incluir descripciones en sistemas

lingsticos, por que estos mtodos se dicultan para obtener el conocimiento en una manera

comprensiva. Por otro lado, la deduccin de los sistemas difusos representan el conocimiento

usando etiquetas lingsticas y quizs sea ms fcil de interpretar. Pero los sistemas difusos

no tienen mucha capacidad de aprendizaje, es difcil para un operador humano poner a punto

las reglas difusas y las funciones de pertenencia de un conjunto de datos de entrenamiento.

Entonces prometiendo aproximar para combinar dentro de un sistema integrado, tal que

podemos obtener resultados de ambos sistemas difusos y redes neuronales.

La aproximacin del sistema neuro difuso tiene puestos muchas atenciones recientemente.

La fusin de las dos diferentres tecnologas pueden realizarse en tres direcciones [14].

1. Los sistemas neuronales difusos (redes neuronales basados en sistemas difusos), usan

redes neuronales como herramienta para los modelos difusos.

2. Las redes neuronales difusas (modelos de redes neuronales basados en lgica difusa),

se utilizan para borrosicadores de los modelos de redes neuronales convencionales.

3. Los sistemas hbridos neuronales difusos, unin de tecnologa de lgica difusa y redes

neuronales dentro de sistemas hbridos.

2 Introduccin

Los primeros dos sistemas representan a favor combinaciones, donde una tecnologa esta

presente en la otra. La tercera muestra contribuciones de combinaciones, donde las dos

tecnologas son incluidos para realizar una comn tarea.

Estos modelos libres se aproximan usando una caracterstica de las redes neuronales

y sistemas difusos, pero la falta del modelo hace difcil obtener resultados tericos en la

estabilidad de sistemas neuro difusos. Para el diseo es muy importante asegurar la teora

de estabilidad antes de que estos sistemas quieran aplicarse a controladores neuro difuso

a sistemas reales. A pesar de sus aplicaciones exitosas, no hay muchos resultados en el

anlisis de estabilidad para sistemas neuro difusos ah aparecen un nmero de anlisis de

estabilidad y sntesis de resultados en control difuso. La idea bsica de estos mtodos es

disear un controlador de retroalimentacin o retropropagacin (BP) de cada modelo local y

la construccin de un controlador global del controlador local de tal manera que la estabilidad

global de un sistema de control difuso en lazo cerrado sea garantizado. La existencia de un

controlador difuso para el sistema no lineal puede ser estabilizado con la teora de lgica

difusa.

Las redes neuronales recurrentes han sido estudiados durante las ltimas dcadas. El

anlisis de Lyapunov es apropiado para redes neuronales dinmicas, las redes neuronales de

capa simple fueron discutidos en [36], [39]. Las redes de alto orden y las redes multicapas se

encuentran en [37], [38]. La estabilidad de algoritmos de aprendizaje pueden ser derivados

por el anlisis de la identicacin o error de seguimiento de las redes neuronales.

Desde que las redes neuronales no pueden igualar a los sistemas desconocidos no lineales

exactamente, algunas modicaciones robustas [21] deberan ser aplicados en el gradiente nor-

mal o en los algoritmos de retroalimentacin [36], [39]. La estabilidad de entrada a estado

(ISS) y la aproximacin de pasividad son herramientas alternativas efectivas para redes neu-

ronales dinmicas. Las propiedades de pasividad de redes neuronales dinmicas se describen

en [40].

1.1 Motivacin 3

1.1. Motivacin

Bsicamente la tarea a realizar es un modelo neuronal difuso para sistemas dinmicos de

identicacin y control utilizando un algoritmo de aprendizaje. En artculos publicados por

[6], se analiza el modelado difuso para identicacin de sistemas dinmicos en particular se

describe un nuevo modelo difuso de una red neuronal difusa dinmica (DFNN), consta de

reglas recurrentes Takagi Sugeno Kang (TSK). El objetivo principal parte del borrosicador

esttico, mientras las siguientes partes de la reglas difusas son redes neuronales recurrentes

con la retroalimentacin interior y la sinapsis de retraso de tiempo. La red est entrenada

por medio de un nuevo algoritmo de aprendizaje, el mtodo de optimizacin restringiendo la

dinmica neuronal difuso (D-FUNCOM), basado en el concepto de restringir la optimizacin.

La propuesta del modelo dinmico, provee con el algoritmo de aprendizaje, se aplican a

varios problemas temporales, mientras se incluyen procesos de modelado tipo NARMA y

el problema de la cancelacin de ruido. Comparando con la funcin, estas llevan a series

estticos, sistemas dinmicos y algunos modelos difusos existentes recurrentes.

En general las redes neuronales difusas no pueden igualar a los sistemas no lineales. La

dinmica del no modelado lleva la tendencia de los parmetros al igual que el problema de

estabilidad. Algunas modicaciones robustas han sido incluidos en orden para garantizar

la estabilidad de Lyapunov. En esta tesis se aproxima la estabilidad entrada a estado, es

aplicado a acceso de algoritmos de entrenamiento robusto en redes neuronales difusas. Se

propone el anlisis del modelado neuronal difuso en esta tesis no necesitan una modicacin

robusta y esta robustes en alguna inestabilidad acotada.

1.2. Objetivos

1. El objetivo de esta tesis es abordar el modelo neuronal difuso para identicacin y

control, para sistemas dinmicos y estticos con funciones de pertenencia conocidas y

funciones de pertenencia desconocidas, as como el anlisis de redes neuronales recur-

rentes difusas para sistemas no lineales de control.

4 Introduccin

Modelo neuronal difuso recurrente de tipo takagi sugeno kang (TSK).

Modelo neuronal difuso recurrente de tipo mandani.

2. Algoritmos de aprendizaje estables para dos modelos.

3. Control estable adaptable usando sistemas recurrentes neuro difuso.

1.3. Publicaciones

Parte de esta tesis se present como el artculo titulado "Stable Fuzzy Identication Using

Recurrent Fuzzy Neural Networks"en el IASTED International Conference Neural Networks

and Computational Intelligence, 2003, Cancun, Mxico

1.4. Estructura de la tesis

El presente trabajo consta de seis captulos donde se expone la importancia del trabajo.

En el captulo dos se presenta la estrategia de identicacin para un sistema neuro difuso

de identicacin y control, deniendo redes neuronales, lgica difusa nalmente neuro difuso.

En el captulo tres se describe el sistema esttica neuro difuso para la identicacin,

describiendo la esttica en redes neuronales para una red neuronal de capa simple y multicapa

as como la esttica difusa en redes neuronales describiendo el sistema para la estructura de

las redes neuronales del tipo mandani y takagi sugeno kang. El aprendizaje de funciones de

pertenencia conocidas y funciones de pertenencia desconocidas, posteriormente se presenta

la parte de simulacin.

En el captulo cuatro se dene la dinmica de identicacin neuro difuso, primero redes

neuronales dinmicas para sistemas de capa simple y multicapa en redes neuronales recur-

rentes, como segundo punto se describe la dinmica difusa de redes neuronales, estructura

tipo mandani, takagi sugeno para funciones pertenencia conocidas y funciones pertenencia

desconocidas nalmente se presenta la simulacin.

1.4 Estructura de la tesis 5

En el captulo cinco se hace el anlisis del sistema de redes neuronales difusas dinmicas

para sistemas no lineales de control adaptable, analizando su estructura difusa neuro control,

anlisis de estabilidad difusa neuro control con y sin funciones pertenencia de aprendizaje,

tambin se tiene la parte de la simulacin en donde se comparan tres mtodos diferentes

Chen, Narendra y Wen.

Finalmente en el capitulo seis se presentan las conclusiones generales del trabajo, as

mismo se presentan propuestas para futuros trabajos.

6 Introduccin

Captulo 2

Neuro difuso identicacin y control

2.1. Redes neuronales

La creciente demanda en tecnologa de nuestra sociedad requiere nuevos enfoques para

los problemas actuales de control. Las Redes Neuronales (RN) con su masivo paralelismo y

su capacidad para aprender prometen mejores soluciones, al menos para algunos problemas.

En este momento, la comunidad de control ha puesto su atencin en las RN y se pregunta si

pueden ser usadas para obtener mejores soluciones para viejos problemas o quiz soluciones

a problemas que se han resistido a nuestros mejores esfuerzos.

El uso de las RN en control puede verse como un paso natural en la evolucin de la teora

de control. Viendo hacia atrs la evolucin del control se ha visto motivada por tres aspectos

fundamentales: la necesidad de tratar con sistemas complejos; la necesidad de cumplir con la

creciente demanda de nuevos modelos de control y la necesidad de obtener esos modelos con el

menor conocimiento de la planta y el medio ambiente, es decir la necesidad de controlar bajo

incertidumbre. La necesidad de controlar sistemas dinmicos complejos bajo incertidumbre

ha conducido a la revaluacin de los mtodos convencionales de control, y por lo tanto la

necesidad de nuevos mtodos es obvia. Esto tambin ha conducido a un concepto mas general

de control, uno que incluye decisin, planeacin y aprendizaje, los cuales son cualidades

necesarias cuando se desea un sistema con autonoma. En vista a esto, no es de sorprender

8 Neuro difuso identicacin y control

que la comunidad de control este muy activa buscando nuevas ideas para resolver de forma

efectiva los problemas de control de la sociedad moderna. La necesidad es la madre de la

invencin, y en control no ha sido la excepcin, y por ejemplo en el siglo III se diseo un reloj

de agua con un mecanismo de retroalimentacin, el primer artefacto con retroalimentacin

en la historia. As el uso de las RN en control es un paso bastante natural en su evolucin. Las

RN parecen ofrecer un mejor entendimiento y quizs la solucin de algunos de los problemas

de control mas difciles. Es claro que las RN pueden ser aceptadas y usadas si ellas resuelven

problemas que han sido previamente imposible o muy difcil de resolver. Las RN pueden ser

rechazadas y ser solo producto de la moda, como lo han sido inventos tales como la mquina

de escribir elctrica entre otros, si no promueven su utilidad. El reto es entonces encontrar

el mejor camino para utilizar completamente esta nueva poderosa herramienta en control.

Al referirnos a RN en control es importante dar las caractersticas y propiedades ms

signicativas de las RN:

Las RN poseen una gran habilidad para la aproximacin de funciones.

Los elementos bsicos de procesamiento en una RN tienen una estructura simple. Esto

en conjuncin con una implementacin en paralelo resulta en un procesamiento muy

rpido.

La capacidad de aprendizaje y de generalizacin de las RN las convierte en una her-

ramienta poderosa principalmente en sistemas variantes adems de su capacidad de

adaptacin en lnea.

Las RN pueden operar con datos de forma cuantitativa as como de forma cualitativa.

Las RN pueden procesar muchas entradas y tambin muchas salidas, por lo tanto son

altamente aplicables en sistemas multivariables.

Desde el punto de vista de control la habilidad de las RN para tratar con sistemas no

lineales es un punto muy signicativo. Respecto a este tema mtodos para el diseo de

2.1 Redes neuronales 9

controles no lineales que incluyen mtodos terico-prcticos y optimizacin juegan un rol

importante y una posibilidad es el uso de RN para obtener sistemas de control no lineales.

Otra rea en control es la teora de control adaptable. Esta rea ha producido muchos

resultados tericos en los ltimos 20 aos, sin embargo es solo relativo a la teora de sistemas

lineales, por lo tanto cuando estamos tratando con sistemas no lineales variantes en el tiempo

los cuales son bastante mas complejos las RN son una buena opcin.

Autores como Widrow (et. al.) [7] denen una red neuronal como un sistema con entradas

y salidas que est compuesta de muchos elementos de procesamiento similares. Cada elemento

de procesamiento tiene un nmero de pesos sinpticos o simplemente pesos. Ajustando los

pesos de un elemento se puede cambiar el comportamiento del mismo y, por lo tanto, puede

tambin alterar el comportamiento de total de la red para alcanzar la relacin de entrada

salida deseada. Este ltimo proceso es conocido como entrenamiento de la red.

Para nuestro propsito una Red Neuronal (RN) la denimos como un aproximador no

lineal de funciones compuesto como dijimos anteriormente de neuronas, organizadas en una

topologa especca que utiliza una ley de aprendizaje para mejorar su desempeo.

2.1.1. La neurona

La neurona o elemento de procesamiento a su vez estn constituidas de: vector de entrada,

pesos, umbral, un operador matemtico de suma y funcin de activacin, Figura (2.1).

El primer modelo matemtico de una neurona biolgica fue dado por Mc Culloch y Pitt

[8] y es el siguiente:

y = (

n

X

i=0

w

i

u

i

) (2.1)

donde: u

i

, i = 1, 2, ..., n son las entradas a la neurona, u

0

es la entrada al umbral e y es la

salida de la neurona, los pesos sinpticos w

i

<, i = 1, 2, ..., n cambian su valor segn se

requiera, (.) es la funcin de activacin. Lapedes Farber mostr, una arquitectura que es

bsicamente la misma que la de Mc Culloch y Pitt, esta es:

y(k) = (v(k)); v(k) =

n

X

i=0

w

i

u

i

(k) (2.2)

10 Neuro difuso identicacin y control

w

i0

u

0

=+1

w

i0

=

i

(bias)

w

i1

u

1

w

i2

u

2

w

im

u

m

(.)

Entradas

Salida

y

i

Funcin de

activacin

Operador

Suma

Pesos

Sinpticos

v

i

Figura 2.1: Modelo de una neurona

donde y, , w y u son denidas como en el prrafo anterior, k es la variable de tiempo. A

continuacin se da una descripcin de cada uno de los elementos

Vector de entrada

Es denotado por U, U = (u

1

, u

2

, ..., u

m

) donde m es el nmero de entradas a la RN y

a su vez la dimensin de U, este vector U son los datos con los que va operar la neurona,

estas pueden ser dadas del medio ambiente o ser salidas de neuronas anteriores. Cabe hacer

notar que si estamos hablando de identicacin de funciones o control de sistemas U = U(k),

donde k K <; es la variable del tiempo, ya sea, segn sea el caso, continuo o discreto,

para esta situacin las entradas generan una matriz E <

nxm

donde m es la dimensin del

vector de entradas y n es la dimensin del subespacio K, esta n generalmente se le conoce

como nmero de iteraciones.

Pesos sinpticos

Al ser capturados los datos de entrada estos son propagados a travs de la red, en el

proceso de propagacin cada componente u

i

del vector de entrada U es multiplicada por una

2.1 Redes neuronales 11

variable w

ij

, la cual aumenta o atena la seal de entrada, a w

ij

se le conoce como peso

sinptico o simplemente peso, estos pesos no tienen el mismo valor siempre sino que se van

modicando segn se requiera para tener un mejor desempeo, posteriormente puede haber

una convergencia y entonces estar jos. Cuando se habla de que una red es capaz de aprender

se reere al hecho de poder modicar sus pesos w

ij

, el conjunto de pesos genera una matriz

W, es decir, w

ij

es la ij-sima componente de la matriz de pesos W.

El umbral

Denotado por

i

es simplemente un peso mas, pero a diferencia de estos el umbral tiene

una entrada ja de (-1). En el contexto en que usaremos las RN, el umbral nos sirve para

trasladar el punto de equilibrio de la RN, del origen x = 0 a un punto x 6= 0.

Operador de suma

Realiza la adicin de los productos u

i

w

ij

, la operacin aqu descrita constituyen una

combinacin lineal generando un campo local inducido (CLI) v

i

, es decir:

v

i

=

X

i

u

i

w

ij

i

(2.3)

La funcin de activacin

Denotada por (), dene la salida de la neurona en trminos del CLI v

i

, en [9] es denida

como una funcin para limitar la amplitud de la salida neuronal. Sin embargo en el sentido

en el que estamos tratando las Redes Neuronales, la razn de ser de la funcin de activacin

es la de proporcionar un comportamiento no lineal a la red y as poder aproximar funciones

de todo tipo, el teorema universal de aproximacin de funciones [9] da condiciones para

determinar si una funcin , es una funcin de activacin.

La funcin Sigmoide, Tangente Hiperblica, Saturacin o Escaln cumplen las condiciones

del teorema y son utilizadas como funciones de activacin. Las tres primeras funciones son

aptas para nuestro propsito, el escaln como veremos mas adelante tiene una gran aplicacin

en reconocimiento de patrones.

Funcin Escaln: Para este tipo de funcin de activacin tenemos que:

(v) =

(

1 si v 0

1 si v < 0

(2.4)

12 Neuro difuso identicacin y control

donde v es el CLI.

Funcin Saturacin (Sat): Esta denida por la siguiente ecuacin:

(v) =

_

_

c si v +1

v si + 1 > v > 1

c si v 1

(2.5)

donde el factor de amplicacin c es generalmente tomado como 1, pero su valor puede variar

segn sea requerido en las tareas de identicacin y control.

Funcin Sigmoide (Sigm): Es de hecho la funcin ms comn en la construccin de

RN. Esta es denida como una funcin estrictamente creciente que exhibe un balance entre

una conducta lineal y no lineal y es denida por:

(v) =

1

1 + exp(av)

(2.6)

donde a es un parmetro que dene la pendiente de la funcin sigmoide.

Funcin Tangente Hiperblica (Tansig): Al igual que la sigmoide es una de las

principales funciones en la construccin de las RN especialmente como es mencionado en

tareas de identicacin y control:

(v) =

1 exp(av)

1 + exp(av)

(2.7)

donde a es como antes, un parmetro. Las funciones escaln, saturacin, sigmoide as como

la tangente hiperblica son mostradas en la Figura (2.2).

2.1.2. Topologa de la red neuronal (RN)

Es la forma en que se organizan las neuronas en una RN y existen dos tipos fundamentales

Redes Estticas (Feed Forward), (RNFF) y Redes Recurrentes (RNR) o Redes Dinmicas.

En las RNFF, todas las seales neuronales se propagan hacia adelante. No existen conex-

iones hacia atrs y normalmente tampoco autorrecurrentes, ni laterales y son especialmente

tiles en tareas de reconocimiento o clasicacin de patrones [10].

2.2 Lgica difusa 13

Figura 2.2: a) Escaln, b) Saturacin c) Sigmoide d) Tangente hiperblica

Las RNR son aquellas donde la informacin circula tanto hacia adelante como hacia

atrs durante el funcionamiento de la red. Para que esto sea posible, existen conexiones

hacia adelante y retroalimentaciones, [10]. En este trabajo de tesis utilizaremos una red

hbrida que posee las dos caractersticas pero asociada principalmente con las RNR.

2.2. Lgica difusa

En los aos 60s fue el comienzo de la teora de la lgica difusa, esto fue debido por Lot

A. Zadeh in 1965 con su publicacin de conjuntos difusos, en los 70s la teora continuo

creciendo, surgieron las aplicaciones reales, es justo decir que la teora difuso establecida

como el campo independiente el gran parte debido a la dedicacin y notablemente al trabajo

de Zadeh, lo ms fundamental de la teora de lgica difusa fue propuesto por Zadeh en los

60s y cerca de los 70s, despus el propuso los algoritmos difusos en 1968, [12].

La lgica difusa se utiliza en un amplio rango de aplicaciones como:

Controladores de lavadoras, sistemas de aire acondicionado, video cmaras, mecanismos

14 Neuro difuso identicacin y control

de control, sistemas de control de mini submarinos, controladores del metro as como horno

de microondas.

La lgica difusa permite tratar informacin imprecisa, en trminos de conjuntos difusos

veremos que estos conjuntos se combinan en reglas para denir acciones, por ejemplo, si la

temperatura es alta entonces enfra mucho. De esta manera, los sistemas de control basados en

lgica difusa combinan una variable de entrada (denidos en trminos de conjuntos difusos),

por grupos que producen uno o varios valores de salida. Hablando ya en trminos ms

rigurosos, la teora de lgica difusa parte de la teora clsica de conjuntos, aadiendo una

funcin de pertenencia al conjunto, denida sta como un nmero real entre 0 y 1, as se

introduce el concepto de lgica difusa determinado a un valor lingstico. Para cada conjunto

o subconjunto difuso se dene una funcin de pertenencia o inclusin

A

(t) , que indica el

grado en el cual la variable t est incluida en el concepto que esta representado por la etiqueta

A.

2.2.1. Conjuntos difusos

Recordando el ejemplo de las personas, esta situacin puede describirse asignando un 1

a todos los elementos incluidos en el conjunto y un 0 a los no incluidos. A la funcin que

asigna estos valores se llama funcin de inclusin o pertenencia (membership funtion).

A los subconjuntos difusos se les puede aplicar determinados operadores, o bien pueden

realizarse operaciones entre ellos. Al aplicar un operador sobre un slo conjunto difuso se

obtiene otro conjunto difuso, de la misma manera al combinar dos o ms subconjuntos

mediante algunas operaciones, se obtendr otro conjunto.

Sean los subconjuntos difusos identicados por las etiquetas A y B, asociados a una

variable linguistica x, entonces se pueden denir tres operaciones bsicas: complemento unin

e interseccin. Estas operaciones pueden expresarse de la siguiente manera en trminos de

funciones de pertenencia de los conjuntos difusos A y B.

Sea U un conjunto cualquiera y M = [0, 1], su conjunto asociado de pertenencia. Si se

considera a un conjunto difuso A U, entonces el complemento de A ser:

2.2 Lgica difusa 15

Complemento

A

(x) = 1

A

(x) x U

Sea U un conjunto cualquiera y M = [0, 1], su conjunto asociado de pertenencia. La

unin difusa de dos conjuntos difusos, A U y B U, se dene como:

Unin

AB

(x) = m ax [

A

(x) ,

B

(x)]

A

(x)

B

(x) x U, donde indica

la operacin mxima.

Sea U un conjunto cualquiera y M = [0, 1], su conjunto asociado de pertenencia. La

interseccin difusa de dos conjuntos difusos, A U y B U, se dene como:

Interseccin

AB

(x) = mn [

A

(x) ,

B

(x)]

A

(x)

B

(x) x U, donde

indica la operacin mnima.

Es importante resaltar que el funcionamiento de estas operaciones bsicas coincide con

los correspondientes a los de la teora clsica de conjuntos.

Operaciones entre conjuntos difusos

Operaci on Rango

Igualdad

A

(x) =

B

(x) x U

Unin

AB

(x) = m ax [

A

(x) ,

B

(x)] x U

Interseccin

AB

(x) = mn [

A

(x) ,

B

(x)] x U

Complemento

A

(x) = 1

A

(x) x U

Norma

Norma(A)

(x) =

A

(x)

max[

A

(x)]

x U

Concentracin

Conc(A)

(x) = (

A

(x))

2

x U

Dilatacin

Dilat(A)

(x) = (

A

(x))

0,5

x U

(2.8)

La arquitectura tpica de un control difuso lgico (FCL) se muestra en la Figura (2.3). El cual

se compone de cuatro principales componentes: un borrosicador, una regla difusa base, una

maquina de inferencia (Inference Engine) y un desborrosicador (defuzzier). En la salida

del desborrosicador no hay una accin de control para una planta, entonces el sistema es

un sistema de decisin de lgica difusa. El borrosicador tiene el efecto de transformar los

datos medidos alterados.

16 Neuro difuso identicacin y control

Fuzzifier Defuzzifier Planta

( ) x ( ) y

y

x x

Motor

Consecuencia

Base

Regla difusa

Fuzzifier Defuzzifier Planta

Estados

o

Salidas

( ) x ( ) y

y

x x

Maquina

de

Inferencia

Base

Regla difusa

Fuzzifier Defuzzifier Planta

( ) x ( ) y

y

x x

Motor

Consecuencia

Base

Regla difusa

Fuzzifier Defuzzifier Planta

Estados

o

Salidas

( ) x ( ) y

y

x x

Maquina

de

Inferencia

Base

Regla difusa

Figura 2.3: Arquitectura bsica de un controlador de lgica difusa (FLC)

2.2.2. Borrosicador (Fuzzier)

A continuacin de enuncian algunas deniciones necesarias:

Inferencia borrosa tambin como en el caso de la lgica clasica, la borrosa se ocu-

pa del razonamiento formal con proposiciones, pero a diferencia de sta, los valores de las

proposiciones pueden tomar valores intermedios entre verdadero y falso. De esta forma, los

conjuntos borrosos tambin representan predicados en la lgica proposicional. El objeto de

la lgica borrosa es proporcionar un soporte formal al razonamiento basado en el lenguaje

natural, que se caracteriza por tratarse de un razonamiento de tipo aproximado, que hace

uso de unas proposiciones que a su vez expresan informacin de carcter impreciso.

Borrosicador esto establece una relacin entre puntos de entrada no borrosos al sis-

tema x = (x

1

, ..., x

n

)

T

, y sus correspondientes conjuntos borrosos A en U. Se pueden utilizar

diversas estrategias de borrosicacin.

Borrosicador singleton. Es el mtodo de borrosicacin ms utilizado, principalmente

en sistemas de control consiste en considerar los valores propios discretos como conjuntos

borrosos. De otra manera para cada valor de entrada x se dene un conjunto A

0

que lo soporta,

con una funcin de pertenencia

A

(x

0

) , de modo que

A

(x) = 1, (x

0

= x) , y

A

(x

0

) = 0,

2.2 Lgica difusa 17

para todos los otros x

0

U en los que x

0

6= x.

Borrosicador no singleton. Este mtodo de borrosicador utiliza una funcin exponencial

del tipo siguiente:

A

0 (x

0

) = a exp[

x

0

x

] (2.9)

Funcin con forma de campana, centrada en el valor x de entrada, de anchura y amplitud

a.

El conjunto de declaraciones consta de una regla base difusa, el cual es una parte vital de

un sistema de lgica difusa (FLS), como se observa en la Figura siguiente (2.4), la base de la

regla difusa (fuzzy inference engine), combina las declaraciones de la regla base, acordndose

de aproximar por razn de la teora a producir un mapeo del conjunto difuso en la entrada del

espacio U a el conjunto difuso en la salida del espacio V . El borrosicador (fuzzier), mapea

en conjunto de entradas difusa en la entrada del espacio y el desborrosicador (defuzzier),

mapea agregando la salida del conjunto difuso una simple punto en la cresta de la salida en

el espacio.

2.2.3. Desborrosicador (Defuzzier)

Se llaman dispositivos de inferencia borrosa a los sistemas que interpretan las reglas de

tipo IF - THEN de una base de reglas, con el n de obtener los valores de salida a partir de

los actuales valores de las variables lingsticas de entrada al sistema.

Desborrosicador es la funcin que transforma un conjunto borroso en V , normalmente

la salida de un dispositivo de inferencia borrosa, en un valor no borroso y V. Para esto se

utilizan diversos mtodos.

Desborrosicador por mximo, esta denido como:

y = arg sup

yV

(

B

0 (y)) (2.10)

es decir, y es el punto de V en que

G

0 (y) alcanza su valor mximo, donde

B

0 (y) est

denido segn la ecuacin

B

0 (y) =

B

1 (y)

+...

+

B

M (y) (2.11)

18 Neuro difuso identicacin y control

FUZZIFIER DEFUZZIFIER

BASE DE LA REGLA DIFUSA

DEDUCCION DIFUSA DEL

PROCESADOR

SALIDA

( EN V )

ENTRADA

EN ( U )

( CONJUNTO DIFUISO EN U ) ( CONJUNTO DIFUISO EN V )

FUZZIFIER DEFUZZIFIER

BASE DE LA REGLA DIFUSA

DEDUCCION DIFUSA DEL

PROCESADOR

SALIDA

( EN V )

ENTRADA

EN ( U )

( CONJUNTO DIFUISO EN U ) ( CONJUNTO DIFUISO EN V )

Figura 2.4: Estructura se un sistema de lgica difusa

Desborrosicador por medida de centros, de la manera siguiente

y =

P

M

l=1

y

1

B

0

y

l

P

M

l=1

(

B

0 ( y

l

))

(2.12)

donde y

1

representa el centro del conjunto fuzzier G

l

( denido como el punto de V en el

que

G

l (y) alcanza su valor mximo ), y

B

0 (y) esta denido como:

B

0 (y) = sup

xU

h

F

l

1

x...F

l

n

G

l (x, y)

A

0 (x)

i

(2.13)

Desborrosicador por centro de rea, denido como, [11].

y =

P

M

l=1

M

l

B

0

y

l

P

M

l=1

A

l

(

B

0 ( y

l

))

=

P

M

l=1

R

l

V

B

0

y

l

2

dyM

l

B

0

y

l

P

M

l=1

R

V

B

0 ( y

l

) dy

(2.14)

donde M

l

es el momento (entorno al eje y del universo de discurso de la salida V ), de la

funcin de inclusin del conjunto borroso G

l

, A

l

es el rea, y

B

0 (y) est denida como la

ecuacin (2.13).

2.3 Neuro difuso (Neurofuzzy) 19

Capa 3

Capa 2

Capa 1

1

y

M

y

f a b =

1

Z

M

Z

f

1

X

n

X

i

X

( ) exp = = L

Capa 3

Capa 2

Capa 1

1

y

M

y

f a b =

1

Z

M

Z

f

1

X

n

X

i

X

( ) exp = = L

Figura 2.5: Representacin de la red de un sistema difuso con una red neuronal de tres capas

La Figura (2.5), representa la salida del sistema difuso, es calculado como f(x) = a/b.

Estas operaciones de tres etapas se muestra como la Figura siguiente con tres capas de la

red de retroalimentacin (feedforward).

2.3. Neuro difuso (Neurofuzzy)

El conjunto difuso o neurofuzzy son sistemas que usan lgica difusa que se comprende de

juegos difusos y las reglas difusas que es combinando los datos numricos y lingsticos.

La lgica difusa usa las condiciones del idioma naturales como: fro, caluroso, caliente,

pequeo, medio, grande. Tales condiciones no son precisas y no pueden representarse en la

teora normal del juego. Los juegos difuso les permiten a los miembros ser bien, la funcin

parcial de pertenencia como el nmero de miembros multijo normal. Este conjunto parcial

habilita; La diferencia primaria entre los sistemas difuso y neurofuzzy, es que los sistemas

difusos son especialistas en la construccin y los sistemas neurofuzzy son entrenados de datos.

Aunque el software permite usar una combinacin de los dos acercamientos interactivamente.

Las reglas de lgica difusa se usan en sistemas difusos y neuro difuso, representndose en

trminos lingsticos la relacin de entradas del sistema a sus salidas.

20 Neuro difuso identicacin y control

2.3.1. Esttica y dinmica en sistemas difusos

Uno de los ms importantes conceptos de propiedades de sistemas dinmicos es la es-

tabilidad, sin embargo es difcil analizar la estabilidad de sistemas no lineales nos gustara

que los sistemas difusos y las RN, como a continuacin se dice que el anlisis de estabilidad

de sistemas de controles difusos, el control difuso ha sido exitosamente aplicado en muchas

aplicaciones industriales practicas, varias metodologas existentes para el anlisis de estabil-

idad para sistemas de control difuso fueron analizados por: [Mamdami, 1976; Kickert and

Mamdami, 1978; Tong, Chen 1989].

R

i

: Si x es A

i

& y es B

i

, entonces z = a

i

0

+a

i

1

x + ... a

i

n

y (2.15)

Donde x, y son variables lingsticas estas representan la distancia y orientacin en relacin

a las cotas de la orientacin, z es el prximo que sigue el ngulo decidido por el ith regla de

control, y a

i

0

, a

i

n

son los parmetros de entrada en el proceso de la identicacin. La identi-

cacin se hace optimizando un mnimo cuadrados desempeando el ndice como un mtodo

de regresin lineal con pesos (Un algoritmo recursivo es el algoritmo de mnimos cuadrados)

[Tong, 1978a; Takagi y Sugeno, 1983, 1985; Sugeno y Kang, 1986,1988]. Sumando el mode-

lado de una accin de operador, este mtodo es tambin usando el modelo (Identicacin)

controlando el proceso recordando sus datos entradas - salidas, el cual incluye parmetros de

aprendizaje como la estructura de aprendizaje [Sugeno y Tanaka, 1991]. Estos son llamados

reglas de control lingsticas aproximndose al modelado difuso o identicacin difusa. El

modelo Takagi y Sugeno tiene la siguiente forma:

L

i

: Si x(k) es A

i

1

& ... & x(k n + 1) es A

i

n

& u(k) es B

i

1

& ... & u(k m + 1) es B

i

m

Entonces x

i

(k + 1) = a

i

0

+a

i

1

x(k) + ... a

i

n

x(k n + 1)

+b

i

1

u(k) + ... b

i

m

u(k m+ 1)

(2.16)

donde x() es la variable de estado, x

i

(k + 1) es la salida de la regla L

i

, u() es la variable

de entrada

2.3 Neuro difuso (Neurofuzzy) 21

2.3.2. Comparaciones generales de sistemas difuso y redes neu-

ronales

Los sistemas Difusos y las RN (Redes Neuronales), ambos son estimados modelos numri-

cos y sistemas dinmicos. Estos comparten la capacidad de mejorar la inteligencia del sistema

trabajando en un indeterminado, impreciso, y el ruido del medio ambiente. Los sistemas di-

fuso y las RN calculan ejemplos de funciones y se comportan tal como memorias asociadas.

Ambos tienen una ventaja en lo tradicional de la estimacin estadstica y en la aproximacin

del control adaptable de una funcin estimacin. Estos estiman una funcin sin necesidad

de una descripcin de la funcin matemtica de donde la salida de la funcionalidad depende

en la entrada; que ellos aprenden de ejemplos numricos, la lgica difusa y la aproximacin

de neuronas son numricamente por naturaleza.

A pesar de que los sistemas difusos y las RN son de forma similar, hay signicantes difer-

encias entre estos. Estos dieren de la manera en que ellos estiman las funciones probadas,

representan y dar un reconocimiento de la estructura, y asociativamente la deduccin o

mapeo de entradas y salidas.

Las RN tienen un grande numero favorablemente de elementos a procesar (nodos), el

cual demuestra la habilidad de aprendizaje y generalizacin de patrones de entrenamiento

[14], los sistemas difusos la base de sus decisiones de su entrada en la forma linguistica las

variables se derivan de funciones el cual son formulas usadas para determinar el conjunto

difuso el cual el valor pertenece y el grado de la funcin esta en el conjunto. Las variables

entonces se igualan con las precondiciones de la regla lingsticas Si Entonces (IF - THEN)

(regla de lgica difusa), la respuesta de cada regla se obtiene a travs de una implicacin

difusa.

Bsicamente los sistemas difuso estiman funciones con conjuntos difusos por ejemplo

(A

i

, B

i

), mientras las RN usan puntos numricos por ejemplo (x

i

, y

i

) , en una RN x

i

quiz

representa los pxeles que hagan una imagen, mientras que y

i

quiz representan una clasi-

cacin de un vector, en una RN x

i

, y

i

dependiendo de sus entradas y salidas pueden aprender

de un mapeo ajustando sus pesos, por otra parte los conjuntos difusos si A

i

se caracteriza

22 Neuro difuso identicacin y control

el estado de un factor y B

i

la posibilidad de la presencia o ausencia de varios rupturas en el

factor, entonces la reglas difusas y la deduccin se usaron para determinar la probabilidad

que uno de estas rupturas quiz se represente por una funcin de A

i

.

Opcin de sistemas difusos o RN. Se entiende que una RN y la lgica difusa se usan

cuando uno o mas variables de estado son continuos y cuando un modelo matemtico del

proceso no existe o existe pero es tan difcil integrar es decir es tan complejo ser evaluado

rpidamente para una operacin en tiempo real. Entonces necesitamos encontrar cual mtodo

es el mejor y cuando debe ser usado, la teora de las RN, conjuntos difusos y lgica difusa

como desarrollando son sistemas abstractos que no hacen extensa demanda con respecto a

biolgicas o psicolgico recomendables.

Introducimos el teorema de estabilidad para sistemas difusos que proveer una condicin

suciente que garantiza la estabilidad de un sistema difuso acordndose de la denicin de

estabilidad en el sentido de Lyapunov.

2.4. La estabilidad de la entrada a estado (ISS) y fun-

ciones de Lyapunov ISS

En esta seccin estudiamos ISS, para sistemas no lineales en tiempo discreto, esto fue

propuesto inicialmente por Sontang (1989, 1990), la estabilidad de la entrada a estado es otra

elegante aproximacin para analizar la estabilidad adems el mtodo de Lyapunov. Puede

llevar a las conclusiones generales en la estabilidad usando la entrada y las caractersticas del

estado, entendiendo las dependencias de las trayectoria de estados en magnitud de entrada

para sistemas del tipo:.

Considere el sistema no lineal de tiempo discreto siguiente:

x(k + 1) = f[x(k), u(k)] (2.17)

y(k) = h[x(k)]

dnde u(k) R

m

es el vector de entrada , x(k) R

n

un vector de estado, y Y (k) R

m

es

2.4 La estabilidad de la entrada a estado (ISS) y funciones de Lyapunov ISS 23

la salida del vector f y h son generalmente funciones suaves no lineales, f, h C

. De las

siguientes deniciones tenemos que.

Denicin 2.1 El sistema (2.17), se dice que es globalmente estable entrada estado ISS

si ah existe una funcin k () ( continuo y estrictamente creciente si (0) = 0 ) y una

funcin k$ () (funcin k y el lim

s

k

(s

k

) = 0), tal que para cada u L

, entonces

el sup {ku(k)k} < , y cada estado inicial x

o

R

n

, esto dice que kx(k, x

o

, u(k))k

(kx

o

, kk) + (u(k)) .

Denicin 2.2 Una funcin continua V : R

n

R 0 se llama una funcin suave de

Lyaponov ISS del sistema (2.17), si: (a) existe un funcin k

(funcin k

y el lim

s

k

i

(s

k

) =

)

1

() y

2

() son tal que:

1

(s) V (s)

2

(s), s R

n

(b) Ah existe una funcin k

3

() y una funcin k

4

() tal que V

k+1

V

k

3

(kx(k)k)+

4

ku(k)k , x(k) R

n

, u(k) R

m

.

Teorema 2.3 Para un sistema no lineal de tiempo discreto ecuacin (2.17), lo siguiente es

equivalente [23].

1. Es la estabilidad de entrada a estado (ISS).

2. Es estable y robusto.

3. Admite una funcin suave de Lyapunov ISS

Si un sistema no lineal es estable entrada a estado, el comportamiento del

sistema, permanece acotado cuando sus entradas son acotadas.

Propiedad 2.4 Si un sistema no lineal es estable entrada a estado, el comportamiento del

sistema, permanece acotado cuando sus entradas son acotadas.

24 Neuro difuso identicacin y control

Captulo 3

Esttica neuro difuso para

identicacin

3.1. Esttica difusa redes neuronales

En general, las redes neuronales difusa no se pueden igualar con precisin a los sistemas

no lineales. El modelo dinmico puede ser el primero en llevar la tendencia de los parmetros

al igual que el problema de inestabilidad. Algunas modicaciones robustas tienen que ser in-

cluidas para garantizar la estabilidad de Lyapunov. En este modelo la estabilidad de entrada

a estado se aproxima y se aplica para acceder al algoritmo de entrenamiento robusto de redes

neuronales difusas. Concluimos que la ley descendiente del gradiente normal dependiente con

una proporcin de aprendizaje de tiempo variante es estable en el sentido L

. El modelado

neuronal difuso se aproxima a lo propuesto en este modelo, no necesita ninguna modicacin

robusta y es robusto en alguna inestabilidad acotada.

Ambas redes neuronales y la lgica difusas son consistentes universales, estos pueden

aproximar cualquier funcin no lineal en alguna exactitud con tal de que las neuronas ocultas

sucientes o reglas difusas que estn disponibles. Recientemente resultados dicen que la fusin

de las dos diferentes tecnologas parece ser muy ecaz para modelar una clase extensamente

de sistemas no lineales complejos cuando nosotros no tengamos la informacin completa de

26 Esttica neuro difuso para identicacin

algn modelo [13],[17],[14]. El algoritmo de retroalimentacin (backpropagation, BP), son

siempre usados para conectar los parmetros de funciones del conjunto difuso (fuzzy sets)

y los pesos del borrosicador (las redes neuronales). La baja velocidad de aprendizaje y

el mnimo local son principales conictos del algoritmo de BP [25]. Algunas modicaciones

de aprendizaje del BP se deducen. [16] propuso un BP robusto que aprende para resistir el

efecto del ruido y rechazar los errores a su totalidad durante la aproximacin. [34] Bspline

para funciones de conjunto difuso a minimizar la funcin del objeto robusto, la velocidad de

convergencia fue mejorado. Las redes neuronales de RBF y la idea dinmica fueron aplicadas

en [29], para determinar la estructura y parmetros del sistema neuronal difuso.

Para los ingenieros es muy importante asegurar la estabilidad en la teora, antes de que

ellos quieran aplicar el modelado a la tcnica neuronal difusa a sistemas reales. Se conoce bien

que los algoritmos normales de identicacin (por ejemplo, gradiente y mnimo cuadrado)

son estable para condiciones ideales.

Sin la seguridad del modelo dinmico, estos procedimientos adaptables pueden ser fcil-

mente inestables. La falta de robustez de identicacin de parmetros se demostr en [18] y

llego a ser un problema directo en 80s. Varias tcnicas de modicacin robustas para identi-

cacin adaptable se propusieron en [21]. La actualizacin de los pesos del modelado neuro

difuso es una clasicacin de identicacin de parmetros, el aprendizaje del gradiente de-

scendiente normal y la retroalimentacin son algoritmos estables, si el modelo neuronal difuso

puede igualar exactamente a la planta no lineal. Generalmente tenemos que hacer algunas

modicaciones de estos algoritmos por eso estos procesos de aprendizajes son estables.

El operador de proyeccin es muy efectivo para asegurar las cotas de los parmetros para

el modelado difuso [33]. La tcnica de la proyeccin tambin se usa por muchos sistemas

difusos neuronales [31].

Otro mtodo generalizado es usando las tcnicas de modicacin robustas de control

adaptable [21], en modelado de redes difusas. Por ejemplo, [35] aplicando un cambio de

modicaciones para prevenir la tendencia de parmetros.

El modelado neuronal difusa esta en el sentido de aproximacin de una de caja negra.

Todas las incertidumbres pueden ser considerando las partes de la caja negra, entonces, sin la

3.1 Esttica difusa redes neuronales 27

dinmica del modelo puede ser considerado dentro del modelo, no como las incertidumbres

estructuradas. Por lo tanto las tcnicas usadas comnmente no son necesarias. En [24],

los autores propusieron un algoritmo estable y un coeciente de aprendizaje ptimo sin

la modicacin robusta. El coeciente ptimo fue difcil ser encontrado, de tal manera

que la bsqueda gentica del algoritmo fue usado. Usando la teora de pasividad, nosotros

demostramos ese descenso del gradiente de los algoritmos sin la modicacin robusta fueron

estables y para algunas inestabilidad acotado para las redes neuronales recurrentes [41] neuro

identicacin [42].

En este modelo nosotros extendemos nuestros resultados anteriores para modelado de

redes neuronales difusos. La estabilidad de la entrada a estado (ISS) la aproximacin se aplica

para obtener nuevas leyes de aprendizaje de modelado neuronal difuso. Para mejorar nuestro

conocimiento, ISS se acercan para el sistema neuronal difuso no se ha establecido todava

en la literatura. Comparado con [24], nosotros tambin usamos el coeciente de aprendizaje

tiempo variante, pero este coeciente de aprendizaje puede calcularse directamente de los

datos de entrada salida. El algoritmo de aprendizaje es ms simple que en [24].

Ambas Redes neuronales y la lgica difusa son los evaluaciones universales, ellos pueden

aproximar cualquier funcin no lineal a alguna correccin, con tal de que las neuronas ocul-

tas sucientes y las reglas difusas estn disponibles. Escribiendo resultados muestra que el

procedimiento de fusin de estas dos tecnologas diferentes parece ser muy ecaz para la

identicacin de sistemas no lineales [13], [17], [14]. El gradiente descendiente y la retroali-

mentacin son siempre usados para ajustar los parmetros de las funciones de pertenencia

(fuzzy sets) y los pesos de los borrosicadores (Redes Neuronales) para redes neuronales

difusas. La lenta convergencia y el mnimo local son principales inconvenientes de estos al-

goritmos [25]. Algunas modicaciones fueron derivados en recientes publicaciones. [16] hacer

pensar que la ley de retroalimentacin robusta para resistir el efecto del ruido y rechazar

los errores durante la tendencia de la aproximacin. [34] usando la funcin de pertenencia

B-spline para minimizar una funcin robusta, sus algoritmos pueden mejorar la velocidad

de convergencia. En [29], las redes neuronales con funciones radiales bsicas (RBF) son

aplicados a sistemas difusos, las redes neuronales se aplicaron a sistemas difusos, un nuevo

28 Esttica neuro difuso para identicacin

acercamiento para determinar la estructura y parmetros de los sistemas neurales difusos

fue propuesto.

El problema de estabilidad de identicacin neural difusa es muy importante en las apli-

caciones. Se conoce bien que los algoritmos de identicacin normal (por ejemplo, gradiente

descendiente de pendiente y mnimos cuadrados) son estable en las condiciones ideales. En

la presencia de la dinmica del no modelado, ellos pueden volverse inestables. La falta de

robustez de la identicacin de los parmetros se demostr en [18] y llego a ser un problema

directo en los 80s, cuando algunas tcnicas de la modicacin robustas fueron sugeridas

[21]. El procedimiento de aprendizaje de las redes neural difusas puede considerarse como un

tipo de identicacin de parmetros. El gradiente descendiente dependiente y algoritmo de

retroalimentacin son estables, si los modelos neuronales difusos pueden igualar a las plantas

no lineales exactamente. Sin embargo, algunas modicaciones robustas deben aplicarse para

asegurar la estabilidad con respecto a las incertidumbres. La proyeccin del operador es una

herramienta ecaz para garantizar la cota del modelado difuso [24]. Es tambin usado por

muchos sistemas neurales difusos [31].

La identicacin neuronal difusa usa datos de entrada salida y estructura del modelo.

Puede considerarse como la aproximacin de una caja negra. Todo las incertidumbres pueden

ser consideradas como partes de la caja negra, es decir, la dinmica del no modelado est

dentro del modelo de la caja negra, no como las incertidumbres estructuradas. Por consigu-

iente las tcnicas de robusticidad comnmente usadas no son necesarias. En [32], los autores

sugirieron estabilidad y la velocidad de aprendizaje ptimo sin la modicacin robusta, un

algoritmo gentico de investigacin fue propuesto para encontrar el porcentaje ptimo. Sin

embargo el algoritmo es complejo, y difcil de comprender. Usando la teora de pasividad,

nosotros demostramos con xito que para tiempo continuo las redes neuronales recurrentes,

los algoritmos de gradiente descendiente sin la modicacin robusta eran estables y robus-

tos en alguna cota [41], y para la identicacin de tiempo continuo estos fueron tambin

robustamente estables [42]. No obstante, hacer en tiempo discreto las redes neuronales di-

fusa tienen caractersticas similares. El mejor conocimiento, ISS se aproxima para el sistema

neural difuso todava no se aplic en la literatura.

3.1 Esttica difusa redes neuronales 29

En esta seccin de estabilidad de entrada a estado (ISS) la aproximacin se aplica a

la identicacin del sistema por redes neuronales difusas. Son considerados dos casos: 1)

la proposicin pertenencia son supuestamente conocidos, predeterminar de algn modo en

progreso y aprendiendo a llevar slo los parmetros a conclusin, y 2) la actualizacin de

peso incluye ambos la proposicin y los parmetros para concluir. Los nuevos algoritmos

estables con las proporciones de aprendizaje de tiempo variantes se aplica a dos tipos de

modelos neuronales difusos, llamados tradicionalmente modelo del tipo Mamdani y modelo

de TSK.

El sistema no lineal para identicacin

y(k) = h[x(k)] = [y (k 1) , y (k 2) , u(k 1) , u(k 2) , ] = [X (k)] (3.1)

donde

X (k) = [y (k 1) , y (k 2) , u(k d) , u(k d 1) , ]

T

(3.2)

3.1.1. Estructura tipos mamdani esttica difusa redes neuronales

Los modelos difusos Mandani y TSK se han usado por mas de dos decadas en el modelado

de sistemas en la teora de control (anlisis y diseo).

El trabajo presenta un inovadora interpretacin de los modelos difusos Mandani y TSK,

estos modelos permiten saber que una mejor representacin para sistemas dinmicos. El mod-

elo Mandani es mejor para sistemas estticos, mientras que el modelo TSk para dinmicos,

El modelo Mandani sera una mejor aproximacin para sistemas dinmico.

El sistema se representa por reglas difusas en la forma siguiente:

Modelo mandani

R

(i

1

,...,in)

: si

x

1

es X

(i

1

)

1

y,..., y

x

n

es X

(in)

n

entonces

x

n+1

es X

(i

1

,...,in)

n+1

(3.3)

R

i

: si x

1

es A

1i

y x

2

es A

2i

y, ..., x

n

es A

ni

entonces y

1

es B

1i

y, ..., y

m

es B

mi

(3.4)

30 Esttica neuro difuso para identicacin

l = (1, 2, ..., n) difuso si entonces las reglas para realizar un vector de un mapeo de entrada

lingstica X = [x

1,...,

x

n

] R

n

a una variable de salida lingstica. A

1i

, ..., B

mi

son conjuntos

difusos estandares [33]. Para la variable de entrada x

i

hay l

conjunto difusos. En el caso

de una conexin completa, l = l

1

l

2

, ..., l

n

de [33] sabemos que, usando la inferencia del

producto, centro promedio y borrosicador singleton, el kth salida del sistema lgica difusa

se expresa como:

y

p

= (

l

X

i=1

w

pi

[

n

Y

j=1

Aji

]/

l

X

i=1

[

n

Y

j=1

Aji

])

=

l

X

i=1

w

pi

i

(3.5)

donde

Aji

, son las funciones de pertenencia del conjunto difuso A

j

y w

pi

es el punto en el

cual

Bpi

= 1. Si denimos

i

=

n

Y

j=1

Aji

/

l

X

i=1

n

Y

j=1

Aji

. (3.6)

La ecuacin (3.5) puede ser expresado como parmetros

Y (k) = W

k

[X (k)] (3.7)

donde

Y (k) = [ y

1

, ..., y

m

]

T

= W

k

=

_

_

w

11

w

1l

.

.

.

w

m1

w

ml

_

_

(3.8)

el vector de datos [X (k)] = [

1

, ...,

l

]

T

.

La arquitectura de una red neuronal difusa FNN ver Figura (3.1), consta de cuatro capas,

los nodos de entradas y los nodos de salidas se encuentran en la capa I y la capa IV, las

capas ocultas se forman de nodos de reglas para reglas difusas.

3.1 Esttica difusa redes neuronales 31

Capa I II III IV

2

x

1

x

n

x

11

A

1l

A

1 n

A

nl

A

1

1

w

ml

w

1

y

m

y

Capa I II III IV

2

x

1

x

n

x

11

A

1l

A

1 n

A

nl

A

1

1

w

ml

w

1

y

m

y

Figura 3.1: Arquitectura de un sistema neuronal difuso

3.1.2. Estructura tipos takagi sugeno kang esttica difusa redes

neuronales

Para el modelo neuronal difuso Takagi Sugeno Kang tenemos

R

i

: si x

1

es A

1i

y x

2

es A

2i

y, ..., x

n

es A

ni

entonces y

j

= p

i

j0

+p

i

j1

x

1

+... + p

i

jn

x

n

(3.9)

donde j = 1, , m. el pth salida del sistema de lgica difusa puede expresarse como

b y

p

=

l

X

i=1

p

i

p0

+p

i

p1

x

1

+ p

i

pn

x

n

i

(3.10)

donde

i

es denido como en la ecuacin (3.6). La ecuacin (3.10) puede ser expresado en

la forma del tipo Mamdani (3.7),

b

Y (k) = W (k) [x(k)]

32 Esttica neuro difuso para identicacin

donde

b

Y (k) = [b y

1

b y

m

]

T

W (k) =

_

_

p

1

10

p

l

10

p

1

11

p

l

11

p

1

1n

p

l

1n

.

.

.

.

.

.

.

.

.

p

1

m0

p

l

m0

p

1

m1

p

l

m1

p

1

mn

p

l

mn

_

_

(3.11)

[x(k)] =

h

1

l

x

1

1

x

1

l

x

n

1

x

n

l

i

T

(3.12)

Estructura Takagi Sugeno

3.2. Sistemas de identicacin difusa

La idea principal es presentar una herramienta matemtica para construir un sistema

modelo difuso, generalmente hablando el modelo de construccin por datos de entrada y

salida es caracterizado por dos cosas; el primero por una herramienta matemtica para

expresar un modelo de sistemas y el otro es un mtodo de identicacin.

Tambin se muestra el mtodo de identicacin de un sistema usando datos de entrada

y salida, como sabemos para la identicacin de sistemas se divide en dos partes: estructura

de identicacin y parmetros de identicacin.

La estructura de implicaciones difusa y algoritmos de razonamientos, denotamos la fun-

cin de pertenencia de un conjunto difuso A como A(x), x X. Todos los conjuntos difusos

son asociados con funciones lineales, entonces la funcin pertenencia es caracterizado por

dos parmetros dando el grado mas alto 1 y el grado menos 0. El valor verdadero de una

proposicin x es A & y es B, se expresa por:

|x es A & y es B| = A(x) B(y) (3.13)

Formas de implicaciones, la implicacin difusa R es de la forma:

R : es f(x

1

es A

1

, ..., x

k

es A

k

) entonces y = g(x

1

, ..., x

k

) (3.14)

3.2 Sistemas de identicacin difusa 33

donde

y es la variable de respuesta cuyo valor es deducido

x

1

x

k

proposicin de variables que muestran en la parte del resultado

A

1

A

k

conjunto difuso con funciones lineales representando un subespacio

difuso en el cual la implicacin R puede ser aplicado

f funcin lgica que conecta la proposicin

g funcin que implica el valor de y cuando x

1

x

k

satisface la proposicin

En la proposicin si A

i

es igual a X

i

para algn i donde X

i

es el universo.

Proposicin de cambio de variables

Se propone un algoritmo para el cambio de variables de las variables de entrada con-

siderables. Como han sido previamente declaradas, todas las variables de las consecuencias

que no siempre aparecen en las proposiciones. Hay dos problemas interesados con el algorit-

mo. Uno es el cambio de variables: para elegir una variable en la proposicin esto implica

que es inciertamente dividido. El otro es el nmero de divisiones. El problema completo es

una combinacin, por eso en general ah al parecer no tericamente hay una aproximacin

disponible.

Aqu justamente se lleva a buscar un mtodo descrito en los siguientes pasos.

Suponemos que construimos un modelo difuso de entrada K esima x

1

, ..., x

k

y un

sistema de salida nica.

El rango de x

1

se divide en dos subespacios difusos grande y pequeo, el rango

de las otras variables x

2

, ..., x

k

no son divididas, se reere que solo x

1

aparece en la

proposicin de la implicacin. Entonces el modelo consiste de dos implicaciones.

Si x

1

es grande

1

entonces ...

Si x

1

es chico

2

entonces ...

Este modelo se llama 1-1. Simultneamente, un modelo en el cual el rango de x

2

se divide

y el rango de las otras variables x

1

, x

3,

..., x

k

no son divididas entonces son el modelo 1-2. De

esta manera tenemos k modelos, en el cual se compone de dos implicaciones. En general, el

modelo 1-i es de la forma

34 Esttica neuro difuso para identicacin

Si x

i

es grande

i

entonces ...

Si x

i

es chico

i

entonces ...

Para cada modelo los parmetros de la proposicin ptima y parmetros de consecuen-

cia son encontrados por el algoritmo que se describe en la seccin previa. El modelo

ptimo con el mnimo ndice de desempeo se aprueba fuera del modelo k. Este paso

se llama estado estable.

Comenzando de un estado estable como el primer paso, se dice que el modelo 1-i,

donde solo la variable x

i

se muestra en la proposicin, toma todas las combinaciones

de x

i

x

j

(j = 1, 2, ..., k) y divide el rango de cada variable en dos subespacios difusos.

Para la combinacin de x

i

x

i

, el rango de x

i

se divide en cuatro subespacios, por

ejemplo grande, medio grande, medio chico y chico. Entonces se obtiene el

modelo k el cual cada modelo se llama 2 j. Entonces cada modelo consiste de 2 2

implicaciones. Encontramos de nuevo un modelo con el mnimo ndice de proposicin

como el paso 2 que tambin se llama un estado estable en este paso.

Repitiendo el paso 3 simultneamente de manera de poner otra variable dentro de la

proposicin.

La bsqueda se detiene si cualquiera de los siguientes criterios se satisfacen.

1) El ndice de la proposicin de estado estable llega a ser menos que el valor predeter-

minado.

2) El nmero de implicaciones de un estado estable excede los nmeros predeterminados.

El cambio de variables en la proposicin se muestra en la Figura (3.2).

3.3 Sistemas de identicacin difusa neuronal 35

1

x

2

x

Inicio

Estable

Estable

Estable

i

x

i j

x x

1 i

x x

1 i j

x x x Estado 3

Estado 2

Estado 1

k

x

i k

x x

1

x

2

x

Inicio

Estable

Estable

Estable

i

x

i j

x x

1 i

x x

1 i j

x x x Estado 3

Estado 2

Estado 1

k

x

i k

x x

Figura 3.2: Seleccin de variables de proposicin

3.3. Sistemas de identicacin difusa neuronal

3.3.1. Funciones pertenencia conocidas

Cuando tenemos alguna informacin anterior de la planta a identicar, podemos construir

reglas difusas como en las ecuaciones (3.4) y (3.9). Suponemos que las funciones pertenencia

A

li

, ..., A

ni

son dados por conocimiento anterior, entonces

i

=

n

Q

j=1

A

ji

/

l

P

i=1

n

Q

j=1

A

ji

se conoce

[16], [29], [35]. El objetivo del modelado de la neurona difusa es encontrar valores del centro

de B

1i

B

mi

( los pesos entre las capas III y IV como se muestran en la Figura (3.1)), tal

que la salida

b

Y (k) de la red neuronal difusa (3.7), sigue la salida Y (k) de la planta no lineal

(3.1).

El error de identicacin se dene como:

e(K) =

Y (K) Y (K) (3.15)

El modelado neuronal difuso discutido en este modelo es un tipo de identicacin en lnea,

entonces usaremos el modelado del error e(k) para entrenar las redes neuronales difusas

la ecuacin (3.7) en lnea tal que

Y (k) puede aproximarse a Y (k). segn las teoras de

36 Esttica neuro difuso para identicacin

aproximacin de la funcin de lgica difusa [24] y las redes neuronales [9], el proceso de

identicacin no lineal la ecuacin (3.1) se puede representar como:

Y (k) = W

[X(k)] (k) (3.16)

donde W

son los pesos desconocidos que pueden minimizar el no modelado dinmico (k).

Teorema 3.1 Si nosotros asumimos que las redes neuronales difusas la ecuacin (3.7), el

modelado de la planta no lineal de la ecuacin (3.1), el siguiente algoritmo de descenso de

gradiente con una proporcin de aprendizaje de tiempo variante se puede hacer la identi-

cacin del error acotado e(k) .

W (k + 1) = W (k)

k

e(k)

T

[X(k)] (3.17)

donde

k

=

1 + k[X(k)k

2

, 0 < 1. El error de identicacin normalizado satisface el

siguiente promedio de desempeo

e

2

N

(k) =

e

2

(k)

1 + m ax

k

(k[X(k)]k

2

)

(3.18)

J = lmsup

T

1

T

T

k=1

e

2

N

(k)

(3.19)

donde = max

k

[

2

(k)].

Demostracin. [43]

Propiedad 3.2 Porque el modelo neuronal difuso no puede igualar los sistemas no lineales

exactamente. As nosotros no podemos hacer que los parmetros de convergencia neuronales

difusas a sus valores ptimos, nosotros solo queremos forzar la salida de las redes neuronales

para seguir la salida de la planta. Aunque los valores de los pesos no pueden converger a sus

valores ptimos, la ecuacin (3.19) las muestras de la identicacin normalizado del error

converger al radio de la bola .

3.3 Sistemas de identicacin difusa neuronal 37

3.3.2. Funciones pertenencia desconocidas

Cuando consideramos la planta como una caja negra, ninguna de las proposiciones ni los

parmetros consecuentes son conocidos (ver [28], [34], [32]). Ahora el objeto del modelado

de la neurona difusa es encontrar valores centrales de B

1i

B

mi

, como seran las funciones

pertenencia A

1i

A

ni

, tal que la red neuronal difusa (3.7), puede seguir la planta no lineal

(3.1).

La funcin gaussiana pertenencia son aprovechados para identicar las reglas difusas en

esta seccin, el cual se dene como

A

ji

= exp

(x

j

c

ji

)

2

2

ji

!

(3.20)

Teorema 3.3 Si nosotros usamos la red neuronal difusa de tipo Mamdani (3.4) para iden-

ticar la planta no lineal (3.1), el siguiente algoritmo de retroalimentacin, hacer que la

identicacin del error e (k) sea acotado.

W

k+1

= W

k

k

e (k) Z (k)

T

c

ji

(k + 1) = c

ji

(k) 2

k

z

i

w

pi

b yp

b

x

j

c

ji

2

ji

(b y

q

y

q

)

ji

(k + 1) =

ji

(k) 2

k

z

i

w

pi

b yp

b

(x

j

c

ji

)

2

3

ji

(b y

q

y

q

)

(3.21)

donde

k

=

1 + kZk

2

+ 2 kD

z

k

2

, 0 < 1. El promedio de la identicacin del error

satisface

J = lmsup

T

1

T

T

X

k=1

e

2

(k)

(3.22)

donde =

(1 +)

2

> 0, = max

k

kZk

2

+ 2 kD

z

k

2

, = max

k

2

(k)

.

Demostracin. [43]

Para el modelo neuronal difuso del tipo Takagi Sugeno Kang ecuacin (3.4) seleccionamos

A

ji

, como funciones gaussiana. La qth salida del sistema lgico difuso puede expresarse como

b y

q

=

l

X

i=1

n

X

k=0

p

i

qk

x

k

!

n

Y

j=1

exp

(x

j

c

ji

)

2

2

ji

!

/

"

l

X

i=1

n

Y

j=1

exp

(x

j

c

ji

)

2

2

ji

!#

(3.23)

38 Esttica neuro difuso para identicacin

donde x

0

= 1. La parte

l

P

i=1

qi

w

qi

z

i

/b

q

es la ecuacin (??) fue cambiado como

l

X

i=1

n

X

k=0

p

i

qk

p

i

qk

x

k

!

z

i

/b (3.24)

El teorema siguiente nos da un algoritmo estable para la red neuronal difusa del tipo TSK.

Teorema 3.4 Si usamos la red neuronal difusa de tipo TSK de la ecuacin (3.23) para

identicar la planta no lineal ecuacin (3.1), el algoritmo siguiente hace la identicacin del

error acotado e (k) .

p

i

qk

(k + 1) = p

i

qk

(k)

k

(b y

q

y

q

)

z

i

b

x

k

c

ji

(k + 1) = c

ji

(k) 2

k

z

i

w

pi

b yp

b

x

j

c

ji

2

ji

(b y

q

y

q

)

ji

(k + 1) =

ji

(k) 2

k

z

i

w

pi

b yp

b

(x

j

c

ji

)

2

3

ji

(b y

q

y

q

)

(3.25)

donde

k

=

1 + kZk

2

+ 2 kD

z

k

2

, 0 < 1.

Demostracin. [43]

Uno puede observar que TSK necesita solo una formulacin diferente comparativo al

tradicional modelo Mamdani y la diferencia entre el teorema (3.3) y teorema (3.4), es contener

de la ley de actualizacin para p

i

qk

(k) .

3.4. Simulacin

Ejemplo 3.5 R si x

1

es chico y x

2

es grande entonces

y = x

1

+x

2

+ 2x

3

(3.26)

La implicacin de estado que si x

1

es chico y x

2

es grande, entonces el valor de y debera ser

igual a la suma de x

1

, x

2

y 2x

3

, donde x

3

no es condicionado de la propuesta.

R : si x

1

es A

1

&...& x

k

es A

k

, entonces y = p

0

+p

1

x

1

+... +p

k

x

k

.

3.4 Simulacin 39